機能の概要と変更履歴

要約データ

|

該当製品または機能エリア |

cnSGW-C |

|

該当するプラットフォーム |

SMI |

|

機能のデフォルト設定 |

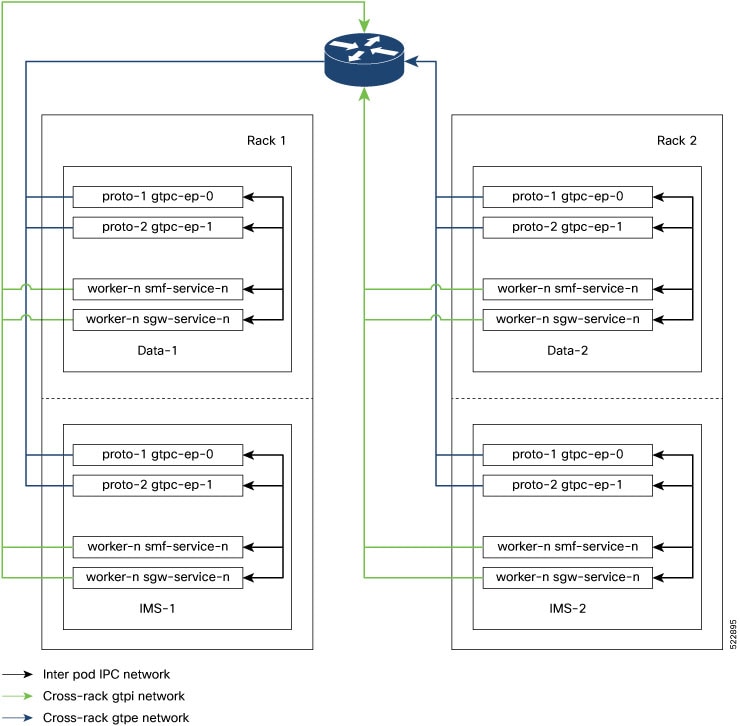

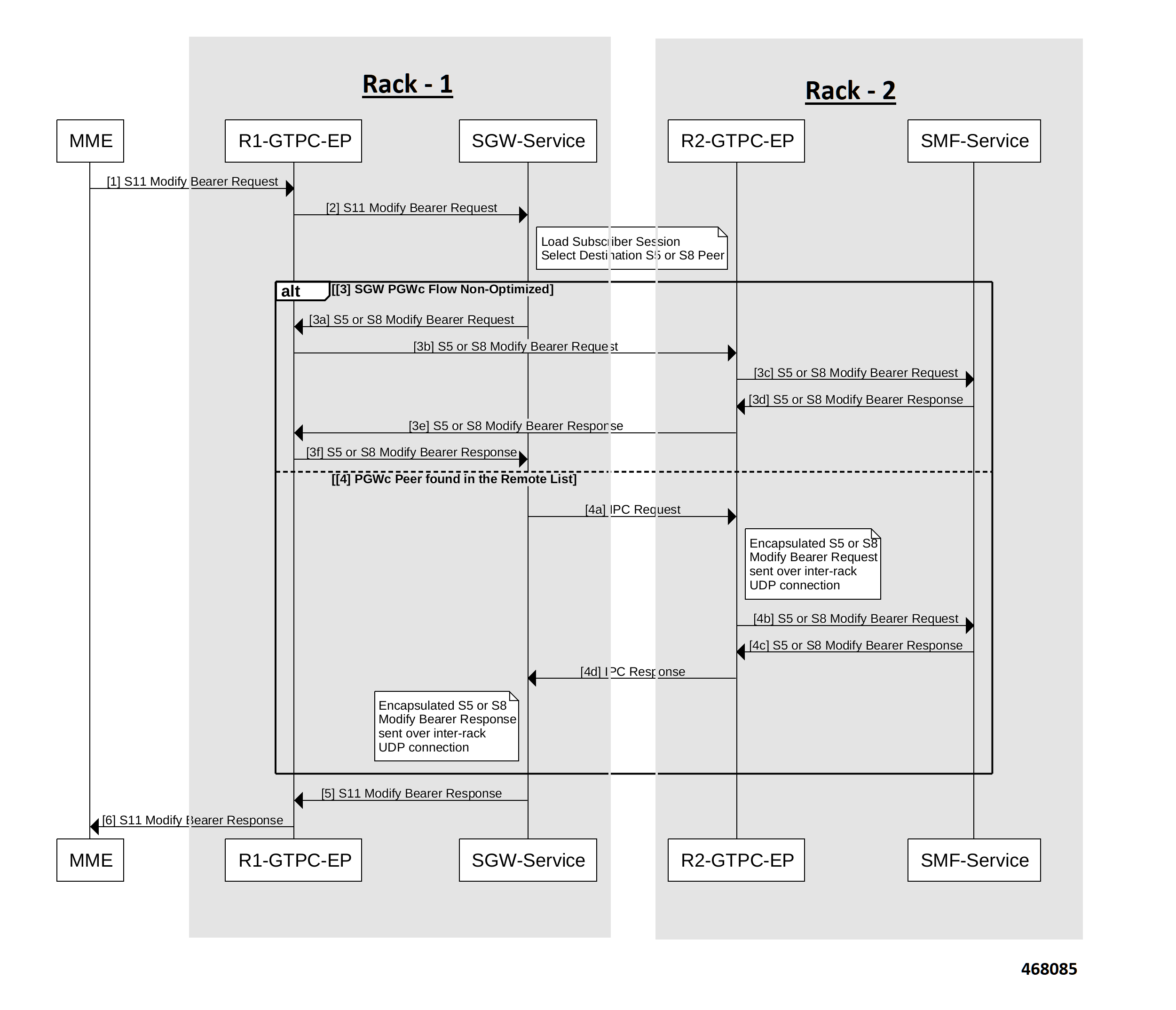

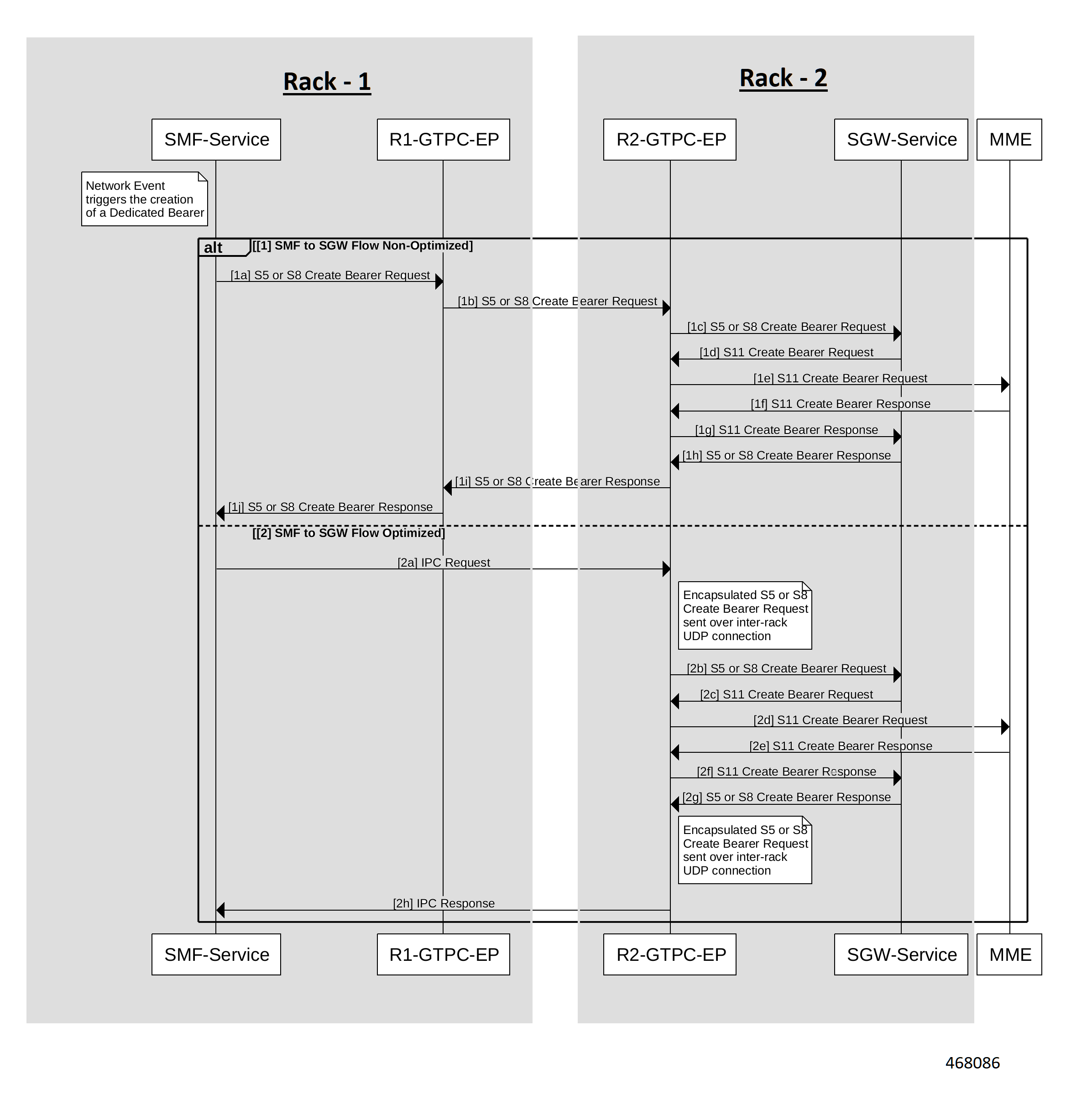

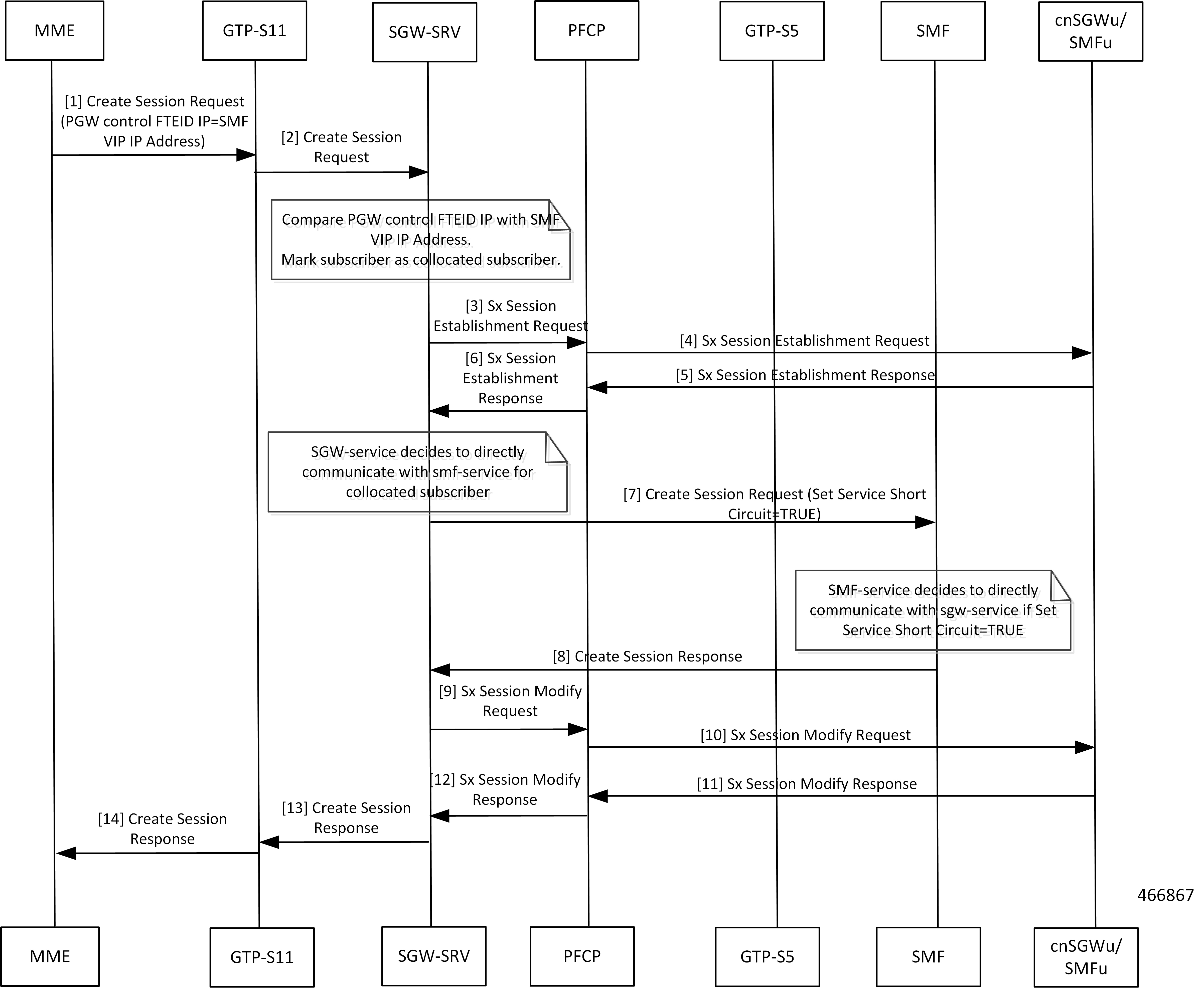

GTPC-EP から SGW サービスへの非同期 BG IPC:有効:常時オン バッチ ID の割り当て、リリース、調整のサポート:無効:有効にするには設定が必要です キャッシュポッドの最適化 CDL フラッシュ間隔およびセッション有効期限のチューニング設定:有効:無効にするには設定が必要です DDN コールフローの最適化:無効:有効にするには設定が必要です DDN タイムアウトの設定:無効:有効にするには設定が必要です エッジエコーの実装:有効:常時オン ETCD ピア最適化のサポート:有効:常時オン DB データベース更新へのフラグの設定:有効:常時オン GTPC インターフェイス分割:無効:有効にするには設定が必要です GTPC IPC クロスラックのサポート:無効:有効にするには設定が必要です サービス間ポッド通信:無効:有効にするには設定が必要です メンテナンスモード:無効:有効にするには設定が必要です MBR コールフローの最適化:無効:有効にするには設定が必要です 最適化された GTPv2 エンコーダおよびデコーダ:有効:常時オン アイドル アクティブ コール フローの部分的な CDL 更新:有効:常時オン DLDR スロットリングのサポートを含む PFCP セッションレポート:無効:有効にするには設定が必要です 復元力の処理:無効:有効にするには設定が必要です ローミングピアパス管理の最適化:無効:有効にするには設定が必要です UDP プロキシ機能のプロトコルマイクロサービスへのマージ:有効:無効にするには設定が必要です |

|

関連資料 |

該当なし |

マニュアルの変更履歴

|

改訂の詳細 |

リリース |

|---|---|

|

次のサブ機能のサポートが導入されました。

|

2023.01.0 |

|

次のサブ機能のサポートが導入されました。

|

2022.04.0 |

|

最初の導入。 |

2021.02.3 |

フィードバック

フィードバック