|

Cache-POD-

Replication-Immediate

-Local

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='CACHE_POD',

ReplicationSyncType='Immediate',ReplicationReceiver='local',

ReplicationRequestType='Response',status='success'}[1m]))/sum by (namespace)

(increase(geo_replication_total{ReplicationNode='CACHE_POD',

ReplicationSyncType='Immediate',ReplicationReceiver='local',

ReplicationRequestType='Request'}[1m])))*100 < 90

説明:このアラートは、CACHE_POD sync type:Immediate および replication receiver:Local の成功率がしきい値未満の場合に生成されます。

|

|

Cache-POD-

Replication-Immediate

-Remote

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='CACHE_POD',

ReplicationSyncType='Immediate',ReplicationReceiver='remote',

ReplicationRequestType='Response',status='success'}[1m]))/sum by (namespace)

(increase(geo_replication_total{ReplicationNode='CACHE_POD',

ReplicationSyncType='Immediate',ReplicationReceiver='remote',

ReplicationRequestType='Request'}[1m])))*100 < 90

説明:このアラートは、CACHE_POD sync type:Immediate および replication receiver:Remote の成功率がしきい値未満の場合に生成されます。

|

|

Cache-POD-

Replication-PULL

-Remote

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='CACHE_POD',

ReplicationSyncType='PULL',ReplicationReceiver='remote',

ReplicationRequestType='Response',status='success'}[1m]))/sum by (namespace)

(increase(geo_replication_total{ReplicationNode='CACHE_POD',

ReplicationSyncType='PULL',ReplicationReceiver='remote',

ReplicationRequestType='Request'}[1m])))*100 < 90

説明:このアラートは、CACHE_POD sync type:PULL および replication receiver:Remote の成功率がしきい値未満の場合に生成されます。

|

|

ETCD-

Replication-Immediate

-Local

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='ETCD',

ReplicationSyncType='Immediate',ReplicationReceiver='local',

ReplicationRequestType='Response',status='success'}[1m]))/sum by (namespace)

(increase(geo_replication_total{ReplicationNode='ETCD',

ReplicationSyncType='Immediate',ReplicationReceiver='local',

ReplicationRequestType='Request'}[1m])))*100 < 90

説明:このアラートは、ETCD sync type:Immediate および replication receiver:Local の成功率がしきい値未満の場合に生成されます。

|

|

ETCD-

Replication-Immediate

-Remote

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='ETCD',

ReplicationSyncType='Immediate',ReplicationReceiver='remote',

ReplicationRequestType='Response',status='success'}[1m]))/sum by (namespace)

(increase(geo_replication_total{ReplicationNode='ETCD',

ReplicationSyncType='Immediate',ReplicationReceiver='remote',

ReplicationRequestType='Request'}[1m])))*100 < 90

説明:このアラートは、ETCD sync type:Immediate および replication receiver:Remote の成功率がしきい値未満の場合に生成されます。

|

|

ETCD-

Replication-PULL

-Remote

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='ETCD',

ReplicationSyncType='PULL',ReplicationReceiver='remote',

ReplicationRequestType='Response',status='success'}[1m]))/

sum by (namespace) (increase(geo_replication_total

{ReplicationNode='ETCD',ReplicationSyncType='PULL',

ReplicationReceiver='remote',ReplicationRequestType=

'Request'}[1m])))*100 < 90

説明:このアラートは、ETCD sync type:PULL および replication receiver:Remote の成功率がしきい値未満の場合に生成されます。

|

|

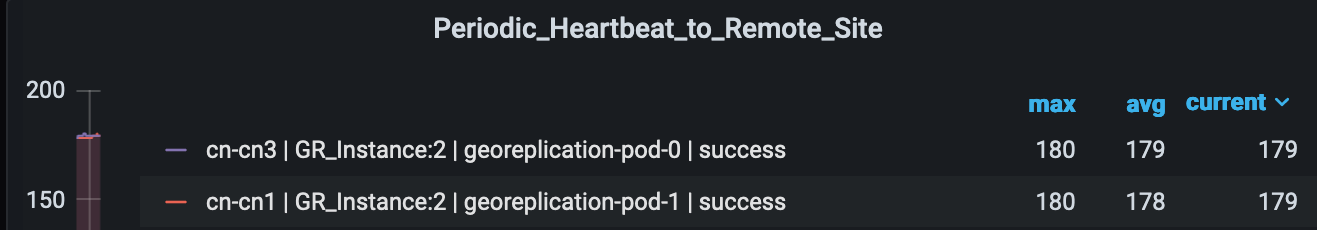

Heartbeat-Remote

-Site

|

critical

|

-

|

通信アラーム

|

|

式:sum by (namespace)

(increase(geo_monitoring_total{ControlActionNameType=

'RemoteMsgHeartbeat',status!='success'}[1m])) > 0

説明:このアラートは、リモートサイトへの定期的なハートビートが失敗するとトリガーされます。

|

|

Local-Site-

POD-Monitoring

|

critical

|

-

|

通信アラーム

|

|

式:sum by (namespace,AdminNode)

(increase(geo_monitoring_total{ControlActionNameType

='MonitorPod'}[1m])) > 0

説明:このアラートは、ローカルサイトのポッドモニタリングに障害が発生した場合、Label:{{$labels.AdminNode}} に記載されているポッドの設定されたしきい値を超えた場合にトリガーされます。

|

|

PEER-Replication-

Immediate-

ローカル

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='PEER',

ReplicationSyncType='Immediate',ReplicationReceiver='local',

ReplicationRequestType='Response',status='success'}

[1m]))/sum by (namespace) (increase(geo_replication_total

{ReplicationNode='PEER',ReplicationSyncType=

'Immediate',ReplicationReceiver='local',

ReplicationRequestType='Request'}[1m])))*100 < 90

説明:このアラートは、PEER sync type:Immediate および replication receiver:Local の成功率がしきい値未満の場合に生成されます。

|

|

PEER-Replication-

Immediate-

リモート

|

critical

|

1

|

通信アラーム

|

|

式:(sum by (namespace)

(increase(geo_replication_total{ReplicationNode='PEER',

ReplicationSyncType='Immediate',ReplicationReceiver='remote',

ReplicationRequestType='Response',status='success'}

[1m]))/sum by (namespace) (increase(geo_replication_total

{ReplicationNode='PEER',ReplicationSyncType='Immediate',

ReplicationReceiver='remote',ReplicationRequestType=

'Request'}[1m])))*100 < 90

説明:このアラートは、PEER sync type:Immediate および replication receiver:Remote の成功率がしきい値未満の場合に生成されます。

|

|

RemoteCluster-

PODFailure

|

critical

|

-

|

通信アラーム

|

|

式:sum by (namespace,AdminNode)

(increase(geo_monitoring_total{ControlActionNameType

='RemoteClusterPodFailure'}[1m])) > 0

説明:このアラートは、Label:{{$labels.AdminNode}} に記載されているポッドのリモートサイトでポッド障害が検出された場合に生成されます。

|

|

RemoteMsg

NotifyFailover

|

critical

|

1

|

通信アラーム

|

|

式:sum by (namespace,status)

(increase(geo_monitoring_total{ControlActionNameType

='RemoteMsgNotifyFailover',status!='success'}[1m])) > 0

説明:このアラートは、Label:{{$labels.status}} に記載されている理由で一時的なロール RemoteMsgNotifyFailover が失敗した場合に生成されます。

|

|

RemoteMsg

NotifyPrepare

フェールオーバー

|

critical

|

1

|

通信アラーム

|

|

式:sum by (namespace,status)

(increase(geo_monitoring_total{ControlActionNameType

='RemoteMsgNotifyPrepareFailover',status!='success'}[1m])) > 0

説明:このアラートは、Label:{{$labels.status}} に記載されている理由で一時的なロール RemoteMsgNotifyPrepareFailover が失敗した場合に生成されます。

|

|

RemoteSite-

RoleMonitoring

|

critical

|

-

|

通信アラーム

|

|

式:sum by (namespace,AdminNode)

(increase(geo_monitoring_total{ControlActionNameType

='RemoteSiteRoleMonitoring'}[1m])) > 0

説明:このアラートは、RemoteSiteRoleMonitoring がパートナーラックのインスタンスのロールの不整合を検出し、その結果、ローカルラックの各インスタンスのロールをプライマリに変更した場合に生成されます。影響を受けるインスタンスは Label:{{$labels.AdminNode}}

にあります。

|

|

ResetRoleApi

-Initiated

|

critical

|

-

|

通信アラーム

|

|

式:sum by (namespace,status)

(increase(geo_monitoring_total{ControlActionNameType

='ResetRoleApi'}[1m])) > 0

説明:このアラートは、Label:{{$labels.status}} に記載されているロールの状態遷移とともに ResetRoleApi が開始されたときに生成されます。

|

|

TriggerGRApi

-Initiated

|

critical

|

-

|

通信アラーム

|

|

式:sum by (namespace,status)

(increase(geo_monitoring_total{ControlActionNameType

='TriggerGRApi'}[1m])) > 0

説明:このアラートは、Label:{{$labels.status}} に記載されている理由で TriggerGRApi が開始されたときに生成されます。

|

|

VIP-Monitoring

-Failures

|

critical

|

-

|

通信アラーム

|

|

式:sum by (namespace,AdminNode)

(increase(geo_monitoring_total{ControlActionNameType

='MonitorVip'}[1m])) > 0

説明:このアラートは、Label:{{$labels.AdminNode}} に記載されている VIP とインスタンスの VIP モニタリング障害の検出時に GR が生成されると生成されます。

|

フィードバック

フィードバック