機能の概要と変更履歴

要約データ

|

該当製品または機能エリア |

cnSGW-C |

|

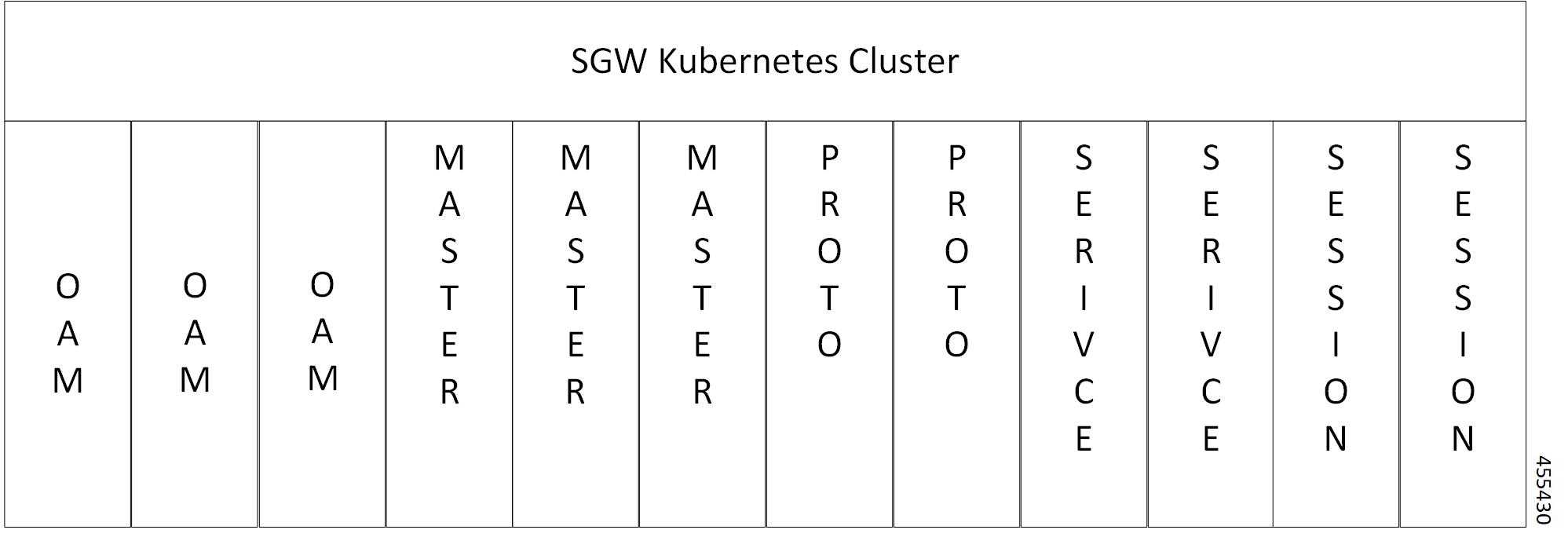

該当プラットフォーム |

SMI |

|

機能のデフォルト設定 |

N/A |

|

関連資料 |

該当なし |

マニュアルの変更履歴

| 改訂の詳細 | リリース |

|---|---|

|

最初の導入。 |

2021.02.0 |

フィードバック

フィードバック