機能の概要と変更履歴

要約データ

|

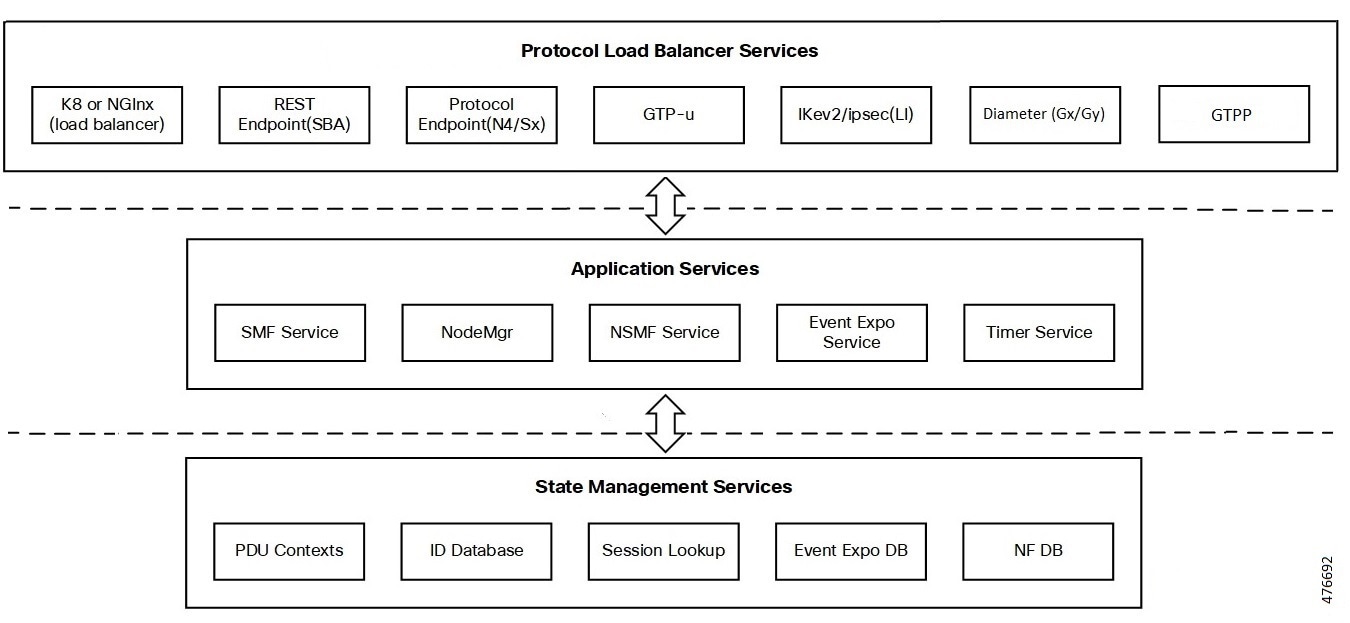

該当製品または機能エリア |

SMF |

|

該当プラットフォーム |

SMI |

|

機能のデフォルト設定 |

N/A |

|

このリリースでの関連する変更点 |

N/A |

|

関連資料 |

該当なし |

更新履歴

| 改訂の詳細 | リリース |

|---|---|

|

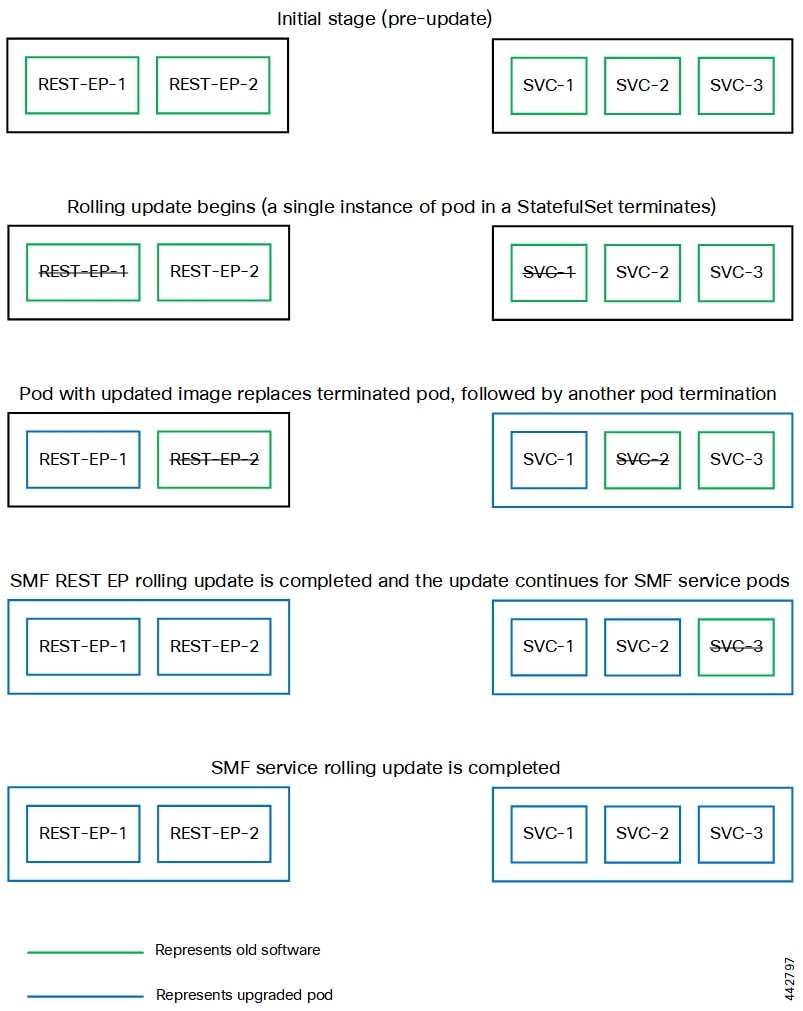

Diameter Gx、Gy、および GZ(GTP-Prime) のサポートを追加 |

2023.02.0 |

|

最初の導入。 |

2020.02.0 より前 |

フィードバック

フィードバック