Lignes directrices et limites relatives à la licence

Le matériel spécifique utilisé pour les déploiements d’ASA virtuel peut varier en fonction du nombre d’instances déployées et des exigences d’utilisation. Chaque appliance virtuelle que vous créez nécessite une allocation minimale de ressources (mémoire, nombre de CPU et espace disque) sur la machine hôte.

Important |

L’ASA virtuel est déployé avec une taille de stockage sur disque de 8 Go. Il est impossible de modifier l’allocation des ressources de l’espace disque. |

Remarque |

À partir de la version 9.16.x d’ASA virtuel, lorsque vous rétrogradez d’ASAv100, dont la configuration de l’appareil est de 16 vCPU et de 32 Go de RAM, à ASAv10, vous devez configurer l’appareil avec 1 vCPU et 4 Go de RAM. |

Passez en revue les lignes directrices et les limites suivantes avant de déployer l’ASA virtuel.

Configuration système requise pour ASA virtuel sur KVM

Assurez-vous de vous conformer aux caractéristiques ci-dessous pour assurer des performances optimales. Les conditions requises par l’ASA virtuel sont les suivantes :

-

Le CPU de l’hôte doit être un processeur Intel ou AMD de classe de serveur x86 avec extension de virtualisation.

Par exemple, les laboratoires de tests de performance d’ASA virtuel utilisent au minimum les éléments suivants : Cisco Unified Computing System (Cisco UCS®), serveur série C M4 avec les processeurs Intel Xeon® E5-2690v4 fonctionnant à 2,6 GHz.

vNIC recommandées

Les vNIC suivantes sont recommandées pour des performances optimales.

-

i40e en mode Transmission directe PCI : dédié à la carte réseau physique du serveur à la machine virtuelle et transfère les données de paquets entre la carte réseau et la machine virtuelle par DMA (accès direct à la mémoire). Aucun cycle de CPU n’est nécessaire pour le déplacement des paquets.

-

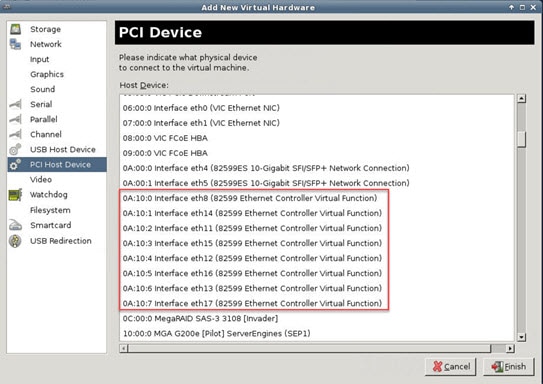

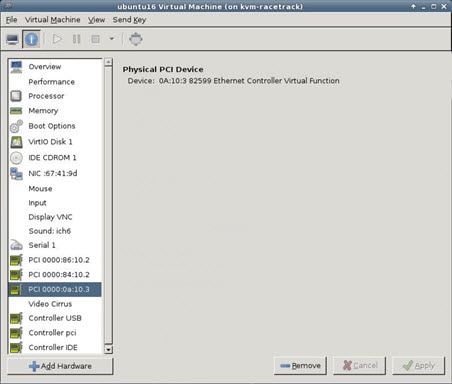

i40evf/ixgbe-vf : en fait, la même chose que ci-dessus (paquets DMA entre la carte réseau et la VM), mais permet de partager la carte réseau sur plusieurs VM. SR-IOV est généralement préféré, car il offre une plus grande souplesse de déploiement. Voir

-

virtio : il s’agit d’un pilote de réseau para-virtualisé qui prend en charge le fonctionnement à 10 Gbit/s, mais nécessite également des cycles du CPU.

Remarque |

L’instance d’ASA virtuel s’exécutant sur le système KVM peut rencontrer des problèmes de connectivité des données avec l’interface SR-IOV en utilisant la version 2.17.4 du pilote vNIC i40e. Nous vous recommandons de mettre à niveau cette version de vNIC vers d’autres versions comme solution de contournement pour résoudre ce problème. |

Optimisation des performances

Pour obtenir les meilleures performances avec ASA virtuel, vous pouvez apporter des ajustements à la machine virtuelle et à l’hôte. Consultez Réglage de la performance pour obtenir de plus amples renseignements.

-

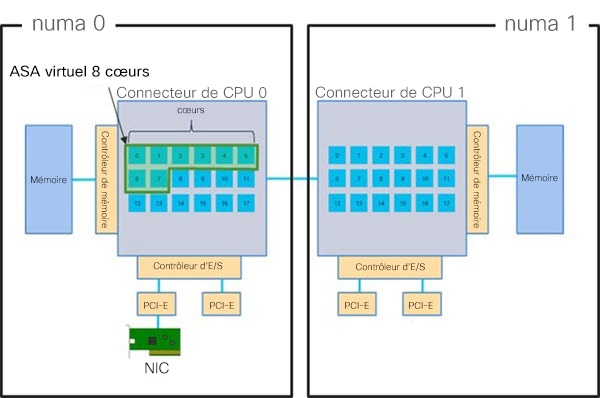

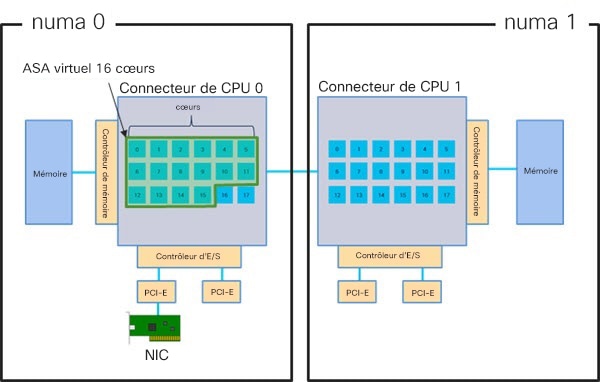

NUMA : vous pouvez améliorer les performances d’ASA virtuel en isolant les ressources du CPU de la machine virtuelle invitée en un seul nœud d‘accès à la mémoire non uniforme (NUMA). Consultez Lignes directrices NUMA pour obtenir de plus amples renseignements.

-

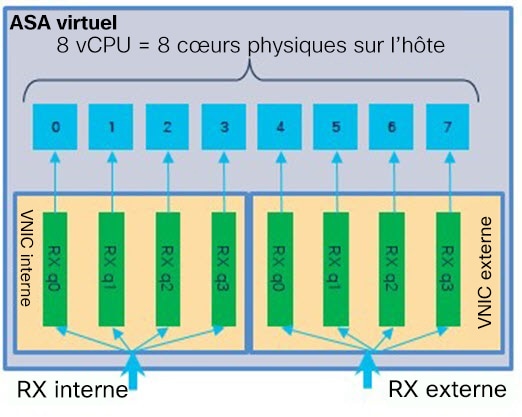

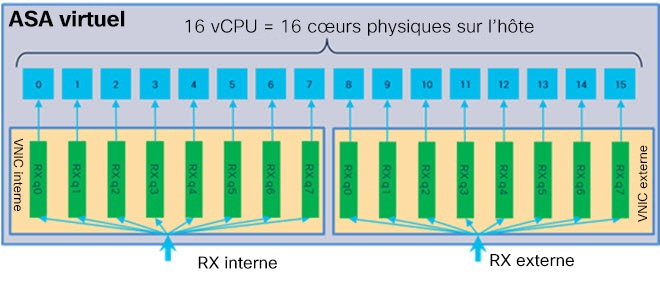

Receive Side Scaling (Dimensionnement côté réception) : l’ASA virtuel prend en charge Receive Côté Scaling (RSS), qui est une technologie utilisée par les adaptateurs réseau pour distribuer le trafic de réception réseau entre plusieurs cœurs de processeur. Consultez Files d’attente RX multiples pour le dimensionnement de la réception (RSS). pour obtenir de plus amples renseignements.

-

VPN Optimization (Optimisation du VPN) : consultez Optimisation du réseau privé virtuel (VPN) pour obtenir des considérations supplémentaires afin d’optimiser les performances du VPN avec l’ASA virtuel.

Mise en grappes

À partir de la version 9.17, la mise en grappe est prise en charge sur les instances d’ASA virtuel déployées sur KVM. Consultez la section Grappe ASA pour l’ASAv pour de plus amples renseignements.

Épinglage de CPU

L’épinglage de CPU est nécessaire pour que l’ASA virtuel fonctionne dans un environnement KVM; voir Activer l’épinglage du processeur (CPU).

Lignes directrices relatives au basculement pour la haute disponibilité

Pour les déploiements de basculement, assurez-vous que l’unité de secours a les mêmes droits de licence; par exemple, les deux unités doivent avoir le droit de 2 Gbit/s.

Important |

Lors de la création d’une paire à haute accessibilité à l’aide d’ASA virtuel, il est nécessaire d’ajouter les interfaces de données à chaque ASA virtuel dans le même ordre. Si exactement les mêmes interfaces sont ajoutées à chaque ASA virtuel, mais dans un ordre différent, des erreurs peuvent s’afficher à la console ASA virtuel. La fonctionnalité de basculement peut également être affectée. |

ASA virtuel sur Proxmox VE

Proxmox Virtual Environment (VE) est une plateforme de virtualisation de serveurs à code source libre qui peut gérer les machines virtuelles KVM. Proxmox VE fournit également une interface de gestion web.

Lorsque vous déployez l’ASA virtuel sur Proxmox VE, vous devez configurer la VM pour qu’elle ait un port série émulé. Sans le port série, l’ASA virtuel entrera en boucle pendant le processus de démarrage. Toutes les tâches de gestion peuvent être effectuées à l’aide de l’interface de gestion web Proxmox VE.

Remarque |

Pour les utilisateurs avancés qui sont habitués au confort de l’interface Shell Unix ou de Windows Powershell, Proxmox VE fournit une interface de ligne de commande pour gérer tous les composants de votre environnement virtuel. Cette interface de ligne de commande dispose d’une fonction intelligente de complétion par tabulation et d’une documentation complète sous forme de pages de manuel UNIX. |

Pour que l’ASA virtuel démarre correctement, la VM doit avoir un périphérique série configuré :

-

Dans le centre de gestion principal, sélectionnez la machine ASA virtuel dans l’arborescence de navigation de gauche.

-

Mettez la machine virtuelle hors tension.

-

Choisissez et ajoutez un port série.

-

Mettez l’ordinateur virtuel sous tension.

-

Accédez à la machine ASA virtuel à l’aide de Xterm.js.

Consultez la page Terminal série de Proxmox pour en savoir plus sur la configuration et l’activation du terminal sur l’invité ou le serveur.

Prise en charge d’IPv6

Pour la création de vNIC avec la configuration de prise en charge IPv6 sur KVM, vous devez créer un fichier XML pour chaque interface composée de paramètres de configuration IPv6. Vous pouvez installer des vNIC avec les configurations de protocole réseau IPV6 en exécutant ces fichiers XML à l’aide de la commande virsh net-create <<interface configuration XML file name>>.

Pour chaque interface, vous pouvez créer le fichier XML suivant :

-

Interface de gestion : mgmt-vnic.xml

-

Interfaces de diagnostic : diag-vnic.xml

-

Interface interne : inside-vnic.xml

-

Interface externe : outside-vnic.xml

Exemple :

<network>

<name>mgmt-vnic</name>

<bridge name='mgmt-vnic' stp='on' delay='0' />

<ip family='ipv6' address='2001:db8::a111:b220:0:abcd' prefix='96'/>

</network>

virsh net-list

brctl show

Commentaires

Commentaires