注意事項と制約事項

ASA 仮想 の導入に使用される特定のハードウェアは、導入されるインスタンスの数や使用要件によって異なります。作成する各仮想アプライアンスには、ホスト マシン上での最小リソース割り当て(メモリ、CPU 数、およびディスク容量)が必要です。

重要 |

ASA 仮想 は、8GB のディスクストレージサイズで導入されます。ディスク容量のリソース割り当てを変更することはできません。 |

(注) |

ASA 仮想 バージョン 9.16.x 以降で、デバイス構成が 16 vCPU および 32GB RAM の ASAv100 から ASAv10 にダウングレードする場合は、デバイス構成を 1 vCPU および 4GB RAM にする必要があります。 |

ASA 仮想 を導入する前に、次のガイドラインと制限事項を確認します。

KVM での ASA 仮想 のシステム要件

最適なパフォーマンスを確保するために、以下の仕様に準拠していることを確認してください。ASA 仮想 には、次の要件があります。

-

ホスト CPU は、仮想化拡張機能を備えたサーバークラスの x86 ベースの Intel または AMD CPU である必要があります。

たとえば、ASA 仮想 パフォーマンステストラボでは、2.6GHz で動作する Intel® Xeon® CPU E5-2690v4 プロセッサを搭載した Cisco Unified Computing System™(Cisco UCS®)C シリーズ M4 サーバーを最低限使用しています。

推奨される vNIC

最適なパフォーマンスを得るためには、次の vNIC を推奨します。

-

PCI パススルーでの i40e:サーバーの物理 NIC を VM に関連付け、DMA(ダイレクトメモリアクセス)を介して NIC と VM の間でパケットデータを転送します。パケットの移動に CPU サイクルは必要ありません。

-

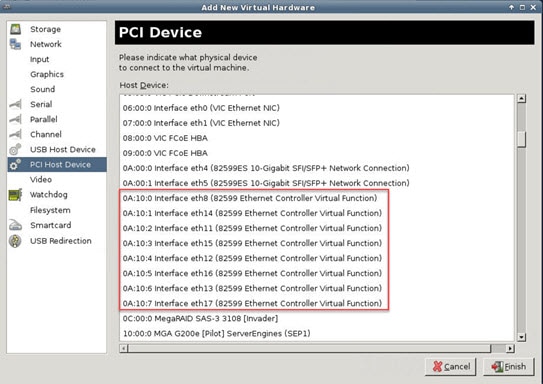

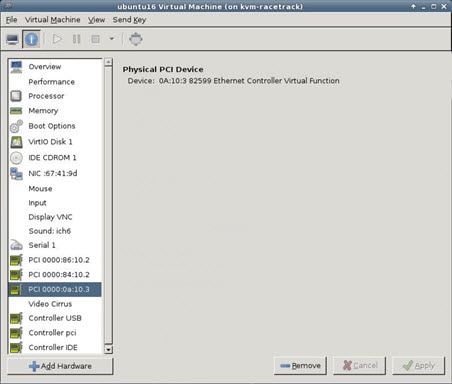

i40evf/ixgbe-vf:実質的に上記と同じですが(NIC と VM 間の DMA パケット)、NIC を複数の VM 間で共有できます。SR-IOV は、導入の柔軟性が高いため、一般的に推奨されます。参照先

-

virtio:10Gbps の動作をサポートしますが、CPU サイクルも必要な準仮想化ネットワークドライバです。

(注) |

KVM システムで実行されている ASA 仮想 インスタンスでは、vNIC ドライバ i40e バージョン 2.17.4 を使用する SR-IOV インターフェイスでデータ接続の問題が発生する場合があります。この問題の回避策として、この vNIC バージョンを他のバージョンにアップグレードすることを推奨します。 |

パフォーマンスの最適化

ASA 仮想 の最高のパフォーマンスを実現するために、VM とホストの両方を調整することができます。詳細については、パフォーマンスの調整を参照してください。

-

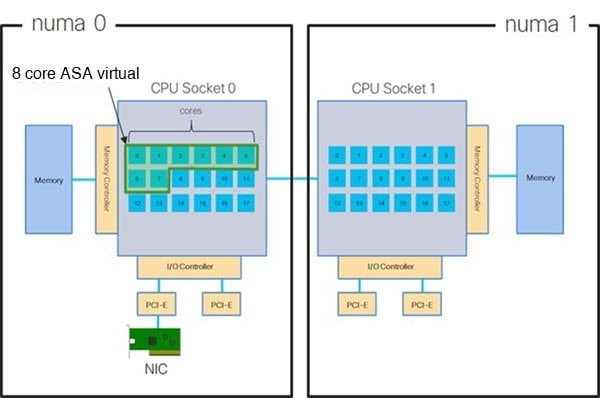

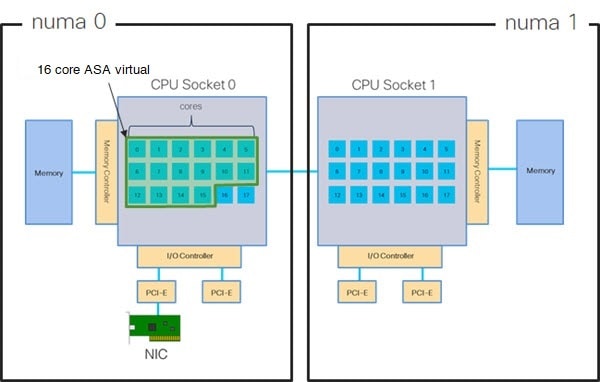

NUMA:ゲスト VM の CPU リソースを単一の Non-Uniform Memory Access(NUMA)ノードに分離することで、ASA 仮想 のパフォーマンスを向上できます。詳細については、NUMA のガイドラインを参照してください。

-

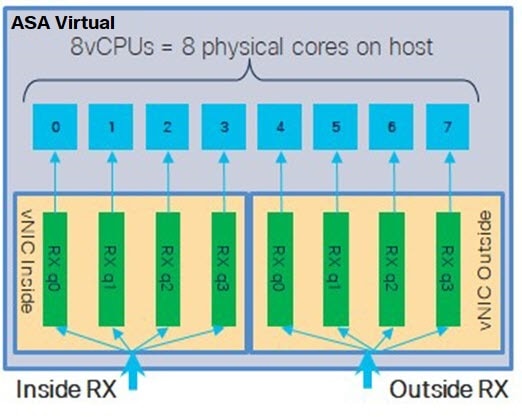

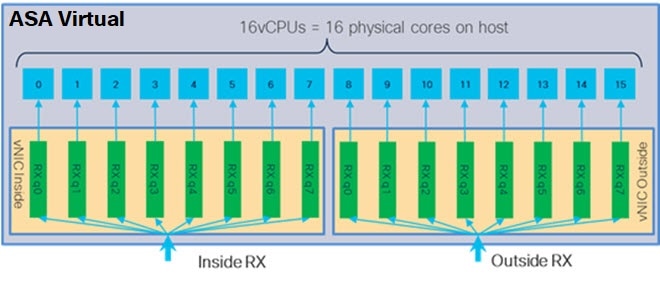

Receive Side Scaling:ASA 仮想 は Receive Side Scaling(RSS)をサポートしています。これは、ネットワークアダプタによって複数のプロセッサコアにネットワーク受信トラフィックを分散するために使用されるテクノロジーです。詳細については、「Receive Side Scaling(RSS)用の複数の RX キュー」を参照してください。

-

VPN の最適化:ASA 仮想 で VPN パフォーマンスを最適化するための追加の考慮事項については、VPN の最適化を参照してください。

クラスタリング

バージョン 9.17 以降、クラスタリングは KVM で展開された ASA 仮想インスタンスでサポートされます。詳細については、「ASA Cluster for the ASAv」を参照してください。

CPU ピニング

KVM 環境で ASA 仮想 を機能させるには、CPU ピニングが必要です。CPU ピンニングの有効化を参照してください。

ハイ アベイラビリティ ガイドラインのためのフェールオーバー

フェールオーバー配置の場合は、スタンバイ装置が同じライセンス権限付与を備えていることを確認してください(たとえば、両方の装置が 2Gbps の権限付与であることなど)。

重要 |

ASA 仮想 を使用して高可用性ペアを作成する場合は、データインターフェイスを各 ASA 仮想 に同じ順序で追加する必要があります。完全に同じインターフェイスが異なる順序で各 ASA 仮想 に追加されると、ASA 仮想 コンソールにエラーが表示されることがあります。また、フェールオーバー機能にも影響が出ることがあります。 |

Proxmox VE 上の ASA 仮想

Proxmox Virtual Environment(VE)は、KVM 仮想マシンを管理できるオープンソースのサーバー仮想化プラットフォームです。Proxmox VE は、Web ベースの管理インターフェイスも提供します。

Proxmox VE に ASA 仮想 を導入する場合は、エミュレートされたシリアルポートを持つように VM を設定する必要があります。シリアルポートがないと、ブートアッププロセス中に ASA 仮想 がループ状態になります。すべての管理タスクは、Proxmox VE Web ベース管理インターフェイスを使用して実行できます。

(注) |

Unix シェルまたは Windows Powershell に慣れている上級ユーザー向けに、Proxmox VE は仮想環境のすべてのコンポーネントを管理するコマンド ライン インターフェイスを提供します。このコマンド ライン インターフェイスには、インテリジェントなタブ補完機能と UNIX の man ページ形式の完全なドキュメントがあります。 |

ASA 仮想 を正しく起動するには、VM にシリアルデバイスを設定する必要があります。

-

メイン Management Center の左側のナビゲーションツリーで ASA 仮想 マシンを選択します。

-

仮想マシンの電源をオフにします。

-

を選択して、シリアルポートを追加します。

-

仮想マシンの電源をオンにします。

-

Xterm.js を使用して ASA 仮想 マシンにアクセスします。

ゲスト/サーバーで端末をセットアップしてアクティブ化する方法については、Proxmox シリアル端末のページを参照してください。

IPv6 のサポート

KVM で IPv6 をサポートする設定の vNIC を作成するには、IPv6 設定パラメータで構成される XML ファイルをインターフェイスごとに作成する必要があります。virsh net-create <<interface configuration XML file name>> コマンドを使用してこれらの XML ファイルを実行することにより、IPv6 ネットワークプロトコルを使用する vNIC をインストールできます。

インターフェイスごとに、次の XML ファイルを作成できます。

-

管理インターフェイス:mgmt-vnic.xml

-

診断インターフェイス:diag-vnic.xml

-

内部インターフェイス:inside-vnic.xml

-

外部インターフェイス:outside-vnic.xml

例:

<network>

<name>mgmt-vnic</name>

<bridge name='mgmt-vnic' stp='on' delay='0' />

<ip family='ipv6' address='2001:db8::a111:b220:0:abcd' prefix='96'/>

</network>

virsh net-list

brctl show

フィードバック

フィードバック