Cisco Application Centric Infrastructure - Cisco ACI マルチサイト アーキテクチャ ホワイト ペーパー

偏向のない言語

この製品のドキュメントセットは、偏向のない言語を使用するように配慮されています。このドキュメントセットでの偏向のない言語とは、年齢、障害、性別、人種的アイデンティティ、民族的アイデンティティ、性的指向、社会経済的地位、およびインターセクショナリティに基づく差別を意味しない言語として定義されています。製品ソフトウェアのユーザインターフェイスにハードコードされている言語、RFP のドキュメントに基づいて使用されている言語、または参照されているサードパーティ製品で使用されている言語によりドキュメントに例外が存在する場合があります。シスコのインクルーシブ ランゲージの取り組みの詳細は、こちらをご覧ください。

翻訳について

このドキュメントは、米国シスコ発行ドキュメントの参考和訳です。リンク情報につきましては、日本語版掲載時点で、英語版にアップデートがあり、リンク先のページが移動/変更されている場合がありますことをご了承ください。あくまでも参考和訳となりますので、正式な内容については米国サイトのドキュメントを参照ください。

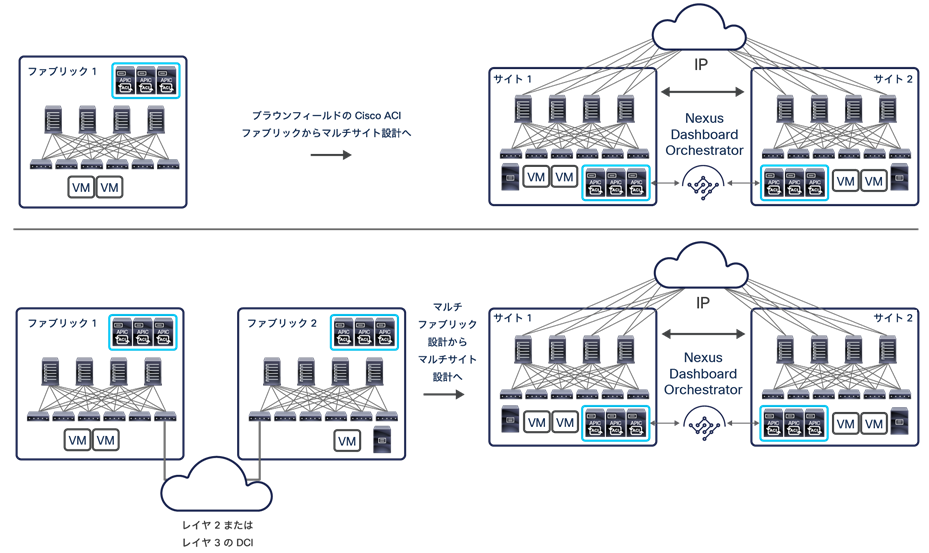

Cisco Application Centric Infrastructure(Cisco ACI)がファブリックテクノロジーとして普及するのに伴い、個別の Cisco ACI ファブリックを相互接続することが企業やサービスプロバイダーの共通の課題となっています。事業の継続や災害の回避といったビジネス要件によってデータセンターファブリックが個別に展開されているため、それらを相互接続する必要が生じています。このドキュメントで説明するように、これらのファブリックは、使用される展開オプションの違いにより、ポッド、ファブリック、サイトと呼ばれます。

注: このドキュメントに示されている設計を十分理解するには、Cisco ACI とその機能、単一のサイトまたは単一のポッドで運用する場合の設計方法について、少なくとも基本的な知識を持っている必要があります。詳細は、https://www.cisco.com/c/ja_jp/solutions/data-center-virtualization/application-centric-infrastructure/white-paper-listing.html にある Cisco ACI のホワイトペーパーを参照してください。

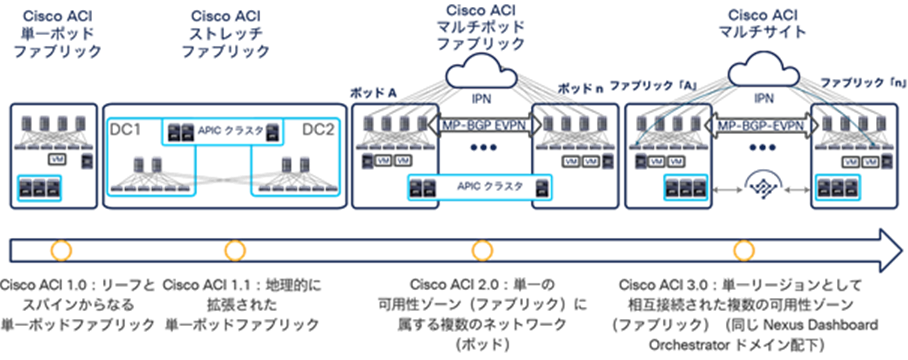

図 1 は、異なる ACI ネットワーク間で接続とポリシー適用を拡張するためのアーキテクチャオプションについて、Cisco ACI の発売から現在までの変遷を示しています。

Cisco ACI の接続オプションとポリシードメインの進化

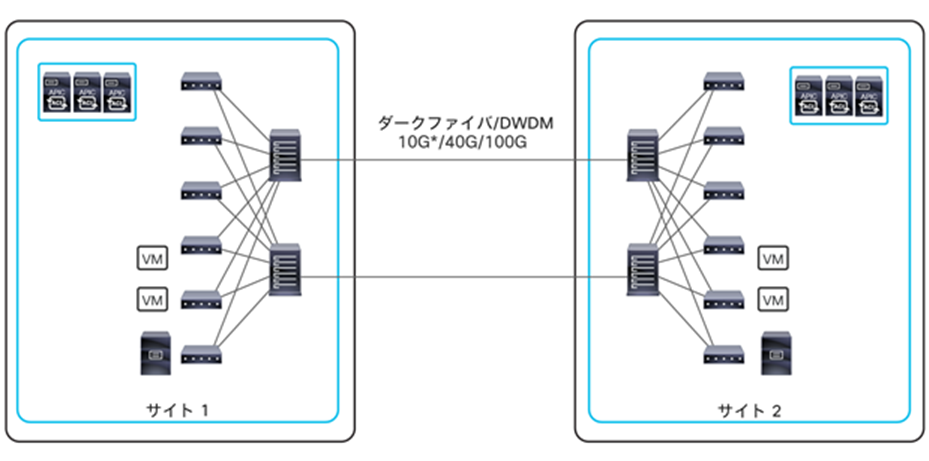

● 最初のオプションは、Cisco ACI リリース 1.0 以降利用可能で、リーフとスパインからなる従来型の 2 階層ファブリック(単一のポッド)から構成されています。この構成では、展開されたすべてのリーフノードと展開されたすべてのスパインノードがフルメッシュで接続されている構造となっています。Cisco ACI コントロール プレーン プロトコルの単一のインスタンスが、ポッド内のすべてのネットワークデバイス間で実行されます。ポッド全体が単一の Cisco Application Policy Infrastructure Controller(APIC)クラスタの管理下にあり、このクラスタがポリシー定義の単一のポイントでもあります。

● Cisco ACI の進化の第 2 段階では、ポッドが複数の物理データセンターのロケーションに地理的に拡張されます(ストレッチファブリック)。ただし、通常は、同一の都市圏に展開されます。これらのロケーション間で十分な光ファイバ接続が確保できない場合、ストレッチファブリックでは部分的なメッシュトポロジが使用されます。このトポロジでは、一部のリーフノード(トランジットリーフノードと呼ばれます)がローカルとリモートの両方のスパインノードに接続され、残りのリーフノードはローカルのスパインノードにのみ接続されます。部分的なメッシュ接続を使用しているにもかかわらず、ストレッチファブリックは機能的には依然として単一のポッド展開となっていて、すべての Cisco ACI コントロール プレーン プロトコルの単一のインスタンスが、相互接続されたすべてのデータセンターサイトで実行されるため、単一の障害ドメインが作成されます。

注:Cisco ACI ストレッチファブリックの展開オプションの詳細は、https://www.cisco.com/c/en/us/td/docs/switches/datacenter/aci/apic/sw/kb/b_kb-aci-stretched-fabric.html を参照してください。

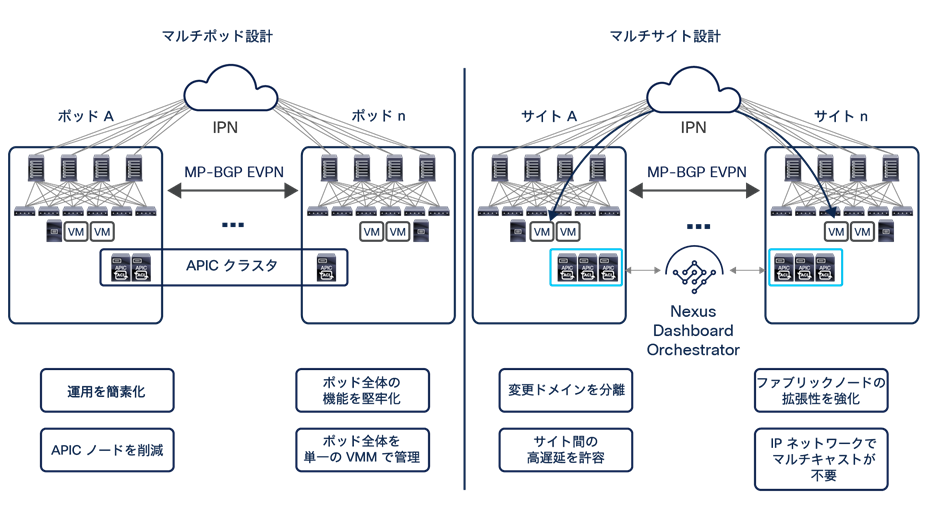

● 単一のネットワーク障害ドメインがストレッチ ファブリック トポロジ全体に拡張されることに対する懸念に対処するために、Cisco ACI リリース 2.0 では、Cisco ACI マルチポッドアーキテクチャが導入されました。このモデルでは、別々の Cisco ACI ポッドを展開する必要があります。各ポッドでは、コントロール プレーン プロトコルの別々のインスタンスが実行され、ポッド同士は、外部 IP ルーテッドネットワーク(またはポッド間ネットワーク(IPN))を介して相互接続されます。Cisco ACI マルチポッド設計では、ポッド全体に展開されたノードは、すべて同じ APIC クラスタの管理下にあり、機能的には単一のファブリックです。それでも、ポッドにまたがるネットワークレベルで完全な復元力が実現します。したがって、各ポッドは別々の可用性ゾーンと見なすことができます。同じ APIC クラスタの管理下にあるすべてのポッドは、同じファブリック(リージョン)に属します。

Cisco ACI マルチポッド設計の主なメリットは、運用が簡単なことです。個別のポッドが複数あっても、論理的に単一のエンティティであるかのように管理されます。このアプローチでは、単一のポッド展開において使用可能なすべての Cisco ACI 機能(ネットワーク サービス チェーン、マイクロセグメンテーション、Virtual Machine Manager(VMM)ドメイン統合など)をポッドにまたがってシームレスに展開できます。これは、このアーキテクチャが実現する固有の価値です。ただし、Cisco ACI マルチポッドアーキテクチャは単一のファブリック(APIC ドメイン)として管理されるため、単一のテナントの変更ドメインとなります。あるテナントのコンテキストで適用された構成やポリシーの変更は、すべてのポットにわたってただちに適用されることに注意が必要です。この動作がマルチポッド設計の運用が簡単であることの理由の 1 つですが、構成エラーが伝播する懸念も引き起こします。

注:変更はすべてのポッドにすぐに適用されますが、所定のテナントのコンテキストのみにとどまります。Cisco ACI ファブリックは暗黙のマルチテナントとなっているため、個別のテナントに展開されたすべてのリソースは完全に分離され、エラーや中断といったイベントから保護されます。Cisco ACI マルチポッド設計の詳細は、https://www.cisco.com/c/en/us/solutions/collateral/data-center-virtualization/application-centric-infrastructure/white-paper-c11-737855.html を参照してください。

さらに、Cisco ACI リリース 2.3(1) 以降では、ポッド間の遅延が最大 50 ミリ秒 RTT まで許容されます。それより前の Cisco ACI リリースでは、10 ミリ秒 RTT が上限です。

● 個別の Cisco ACI ネットワーク間で完全な分離(ネットワークレベルとテナントの変更ドメインレベルの両方)が求められたことから、Cisco ACI マルチサイトアーキテクチャが生まれ、Cisco ACI リリース 3.0(1) で導入されました。このアーキテクチャがこのドキュメントの主なテーマであり、以降のセクションで詳しく説明します。

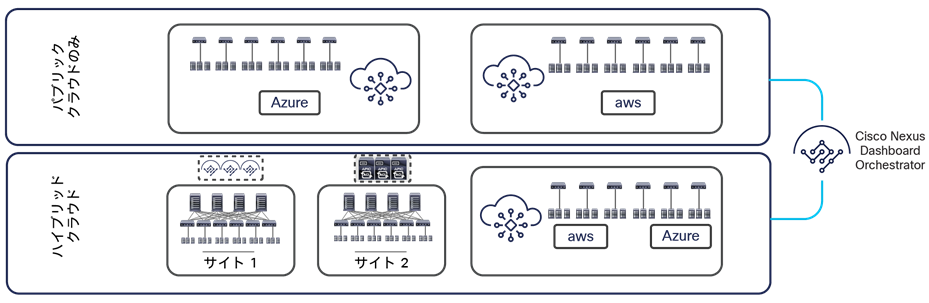

● ACI マルチサイトの同じアーキテクチャアプローチが拡張され、オンプレミスの ACI ファブリックとパブリッククラウドリソースを接続し、ポリシーを拡張することも可能になっています(このドキュメントの執筆時点で、AWS および Azure との統合が可能です)。

ハイブリッドクラウドへの展開とパブリッククラウドのみへの展開のオプションをサポート

上図のように、ハイブリッドクラウド(つまり、パブリッククラウドリソースに接続するオンプレミスの ACI ファブリック)のシナリオとパブリッククラウドのみのシナリオの両方が現在サポートされています。これらの展開オプションについて詳しく説明することは、このホワイトペーパーの範囲外です。詳細は、以下のホワイトペーパーを参照してください。

Cisco ACI マルチサイト設計の詳細に入る前に、シスコがマルチポッドアーキテクチャとマルチサイトアーキテクチャの両方を使用する理由と、それらが相互に補完しあってさまざまなビジネス要件を満たすように配置する方法を理解する必要があります。まず、このドキュメントで使用されている主な用語と、AWS パブリッククラウドの導入で頻繁に使用される命名規則を理解する必要があります。

● ポッド:ポッドとは、共通のコントロールプレーン(Intermediate System–to–Intermediate System(ISIS)プロトコル、Border Gateway Protocol(BGP)、Council of Oracle Protocol(COOP)など)を共有するリーフとスパインからなるネットワークを意味します。したがって、ポッドは AWS でいう可用性ゾーンに相当する単一のネットワーク障害ドメインです。

● ファブリック:ファブリックとは、同じ APIC ドメインの管理下にあるリーフノードとスパインノードのセットを意味します。各ファブリックが、それぞれテナントの変更ドメインになります。APIC で適用されたすべての構成とポリシーの変更は、ファブリック全体に広がる所定のテナントに適用されるためです。したがって、ファブリックは AWS でいうリージョンに相当します。

● マルチポッド:マルチポッド設計とは、リーフとスパインからなるネットワーク(ポッド)が複数相互に接続された単一の APIC ドメインからなるアーキテクチャを意味します。結果的に、マルチポッド設計は機能的にはファブリック(可用性ゾーンの相互接続)になりますが、単一のネットワーク障害ドメインになるわけではありません。各ポッドが、コントロール プレーン プロトコルの別々のインスタンスを実行するためです。したがって、マルチポッドファブリックは、異なる AWS 可用性ゾーンを相互接続する AWS リージョンに相当します。

● マルチサイト:マルチサイト設計とは、複数の APIC クラスタドメインがそれに関連するポッドとともに相互接続されるアーキテクチャを意味します。マルチサイト設計は、それぞれが単一のポッドまたは複数のポッド(マルチポッド設計)として展開された個別のリージョン(ファブリック)を相互接続するため、マルチファブリック設計と呼ぶこともできます。

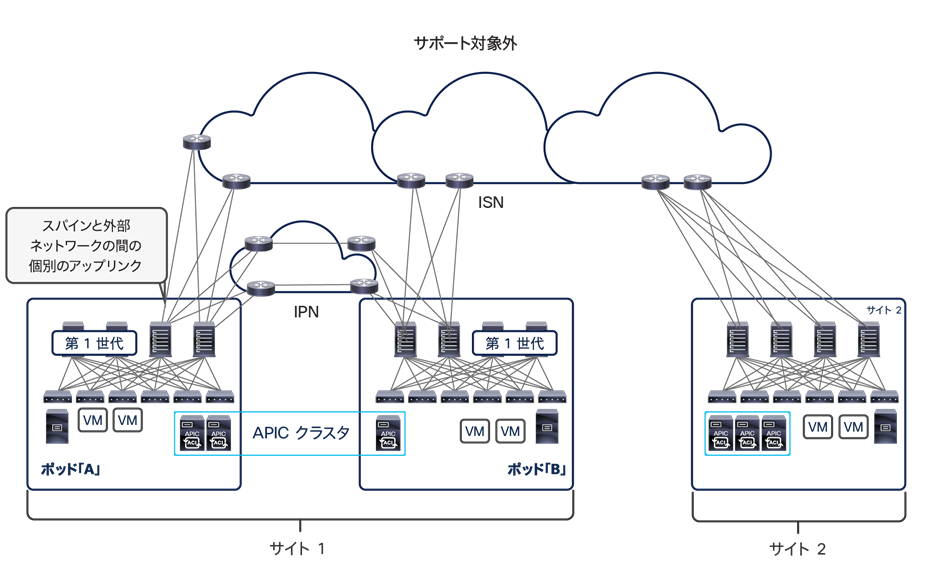

注:「マルチファブリック設計」を「デュアルファブリック設計」と混同しないでください。前者はこのドキュメントで説明しているマルチサイトアーキテクチャを指していて、後者はマルチサイト設計の前身を指しています。複数の ACI ファブリックを運用する場合は、リーフスイッチを介して個々の ACI ファブリックを相互接続する(デュアルファブリック設計)代わりに、マルチサイトを展開することを強くお勧めします。後者の方法は、マルチサイト機能が登場する前には選択の余地がなかったと思われますが、現在は公式にはサポートされていません。特に、個別に導入された、レイヤ 2 ドメインをサイトにまたがって拡張する Data Center Interconnect(DCI)テクノロジー(OTV、VPLS など)とこのトポロジを併用する場合の検証と品質保証検査が実施されていないためです。Cisco ACI には ACI ファブリックを相互接続するための機能として、マルチサイトに先立つ共通パーベイシブゲートウェイと呼ばれる機能があります。しかし、レイヤ 2 を APIC ドメインにまたがって拡張する必要がある場合は、上記の理由からマルチサイトを用いた新しい ACI マルチファブリック展開を設計することを強くお勧めします。

可用性ゾーンやリージョンといった AWS の構造を理解することは、シスコが Cisco ACI マルチポッド設計をすでに提供した後でマルチサイトアーキテクチャへの投資を決定した理由を理解するために不可欠です。通常、組織は、別々のリージョンを構成するデータセンターファブリックにまたがってアプリケーションのさまざまなインスタンスを展開する必要があります。1 つのリージョンで発生するネットワークレベルの障害、構成のエラー、ポリシー定義のエラーが、別のリージョンで実行されているアプリケーションのワークロードに伝播しないようにするためには、このような構成が不可欠です。これによって、災害回避とディザスタリカバリの両方の機能が強化されます。

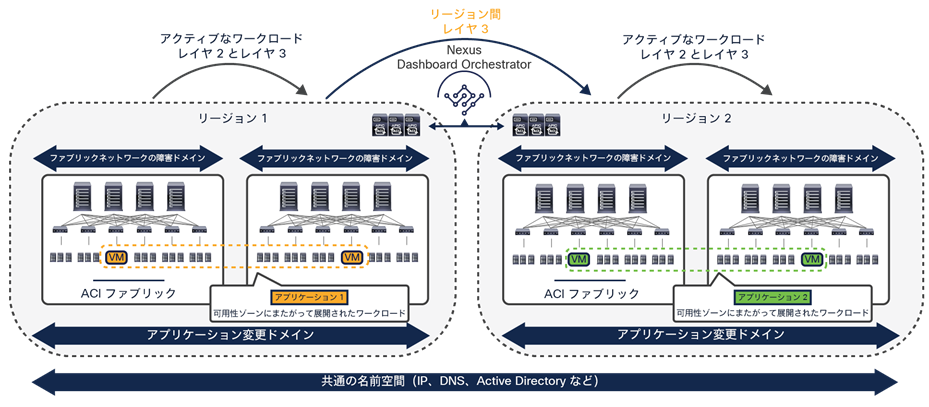

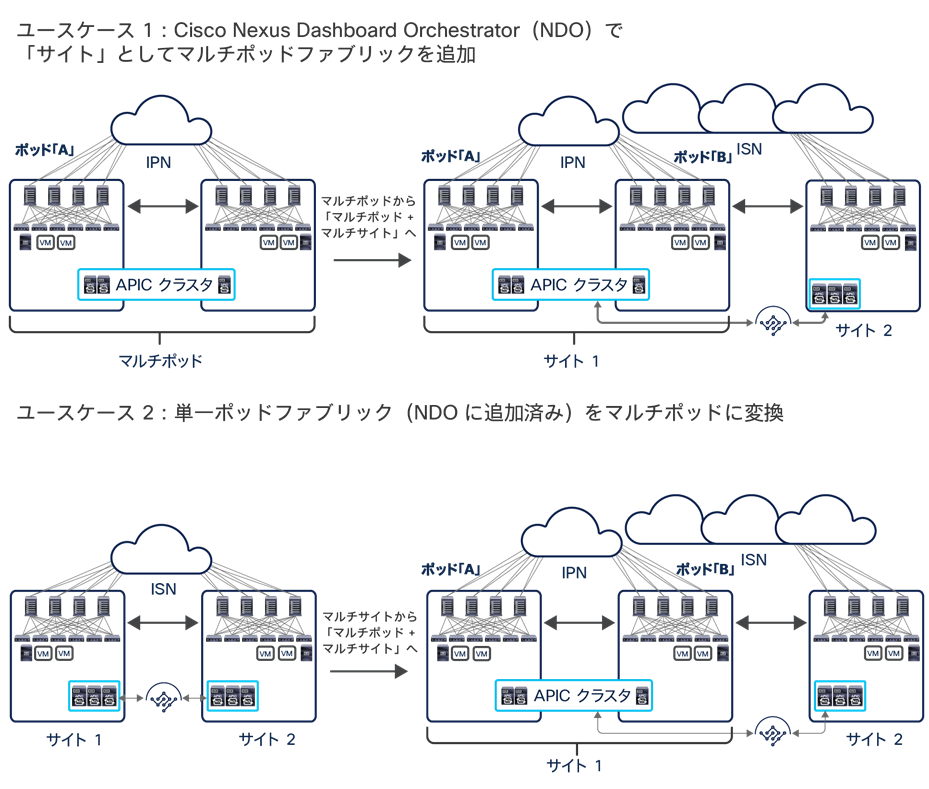

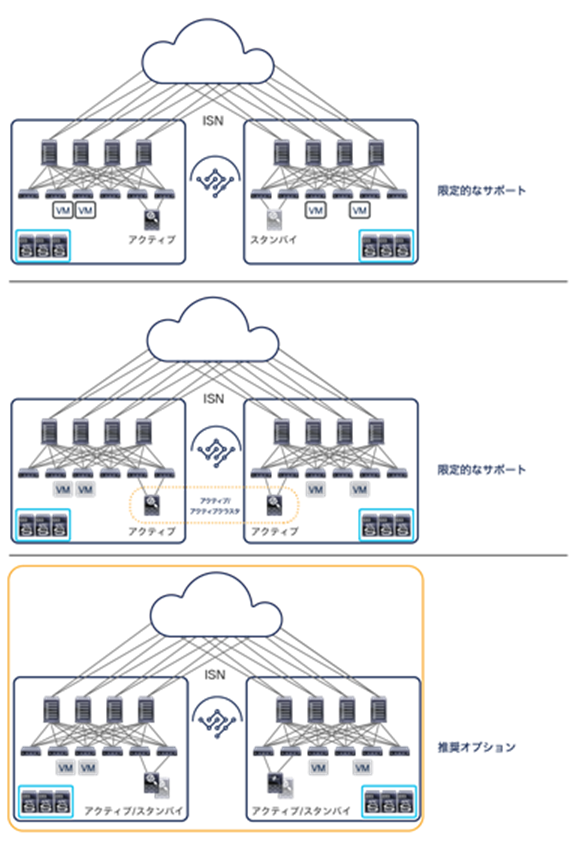

Cisco ACI マルチポッドおよびマルチサイトのアーキテクチャを組み合わせて展開することで、2 つの異なる要件を満たすことができます。柔軟な Cisco ACI の独立したネットワークのグループを作成することができます。これらのネットワークは単一の論理構成体(ファブリックまたはリージョン)として監視と運用が可能で、これを用いてアプリケーションの機能コンポーネントを従来型のアクティブ/アクティブモデルで展開できます(言い換えると、アプリケーション階層を構成する異なるエンドポイントを、同一のファブリックに属する可用性ゾーンにまたがって自由に展開できます。次に、これらのファブリックは信頼性の高い相互接続と拡張が可能なため、異なるアプリケーション インスタンスを別々のリージョンに展開することも、リージョン間で完全なアプリケーションリカバリ機能を実装することもできます。前者は、災害回避の要件を充足するために用いられるアプリケーションごとのアクティブ/アクティブ導入モデルであり、後者はディザスタリカバリのユースケースです。図 3 を参照してください。

注: 上図の Cisco ACI マルチポッドおよびマルチサイトのアーキテクチャを併用した展開は、Cisco ACI リリース 3.2(1) 以降でサポートされています。

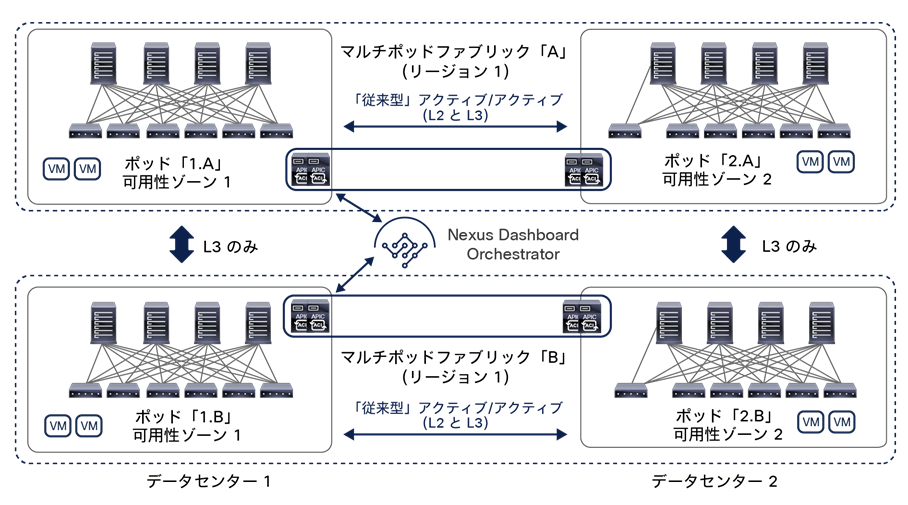

小規模な展開では、データセンターの同じロケーションを 2 つ用意し、この 2 つを災害回避とディザスタリカバリの両方の目的に使用することも非常に一般的です。ACI マルチポッドと ACI マルチサイトを組み合わせると、このような要件にも対処でき、サイトにまたがる従来型のアクティブ/アクティブモデルによるアプリケーションの展開と、ディザスタリカバリのシナリオで必要な一般的なアプリケーション リカバリ メカニズムを同時に実現します(図 4)。

Cisco ACI マルチポッドおよびマルチサイトのアーキテクチャを組み合わせた展開

前の 2 つの図に示した展開では、個別のファブリック(リージョン)を レイヤ 3 で相互接続する手段としてマルチサイトを使用し、レイヤ 2 を拡張するサービスの提供はマルチポッドに委ねています。これが望ましい推奨モデルです。とはいえ、このホワイトペーパーで後述するように、マルチサイトにもネイティブのレイヤ 2 拡張機能があります。通常ならマルチポッドの採用を検討する特定のユースケースに対処するために、このアーキテクチャを適用できます。その際、機能面で制約が生じる可能性があることを考慮に入れることが重要です(FW または SLB クラスタをマルチサイトに統合する場合など)。

このドキュメントの残りの部分では、Cisco ACI マルチサイトアーキテクチャに焦点を当て、初めに機能コンポーネントの概要を説明します。

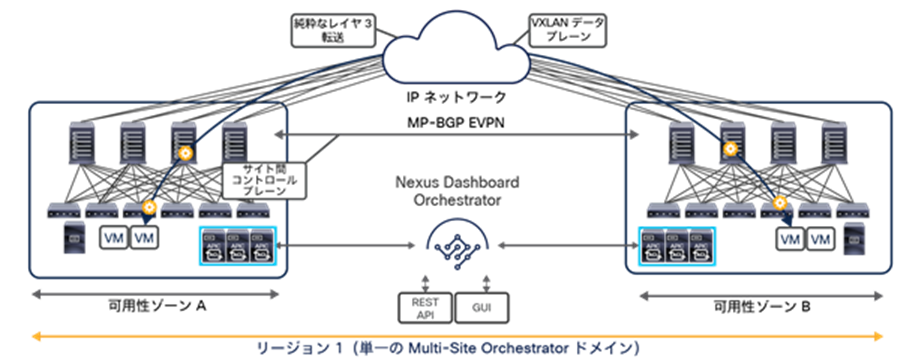

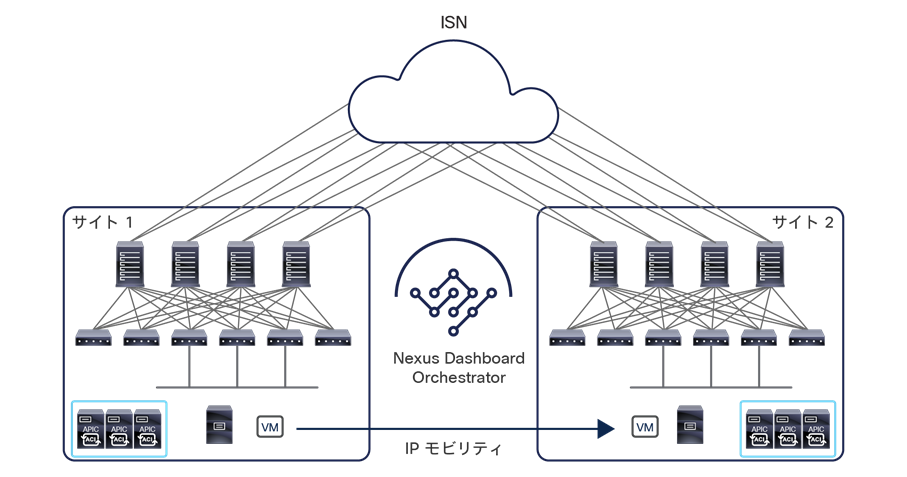

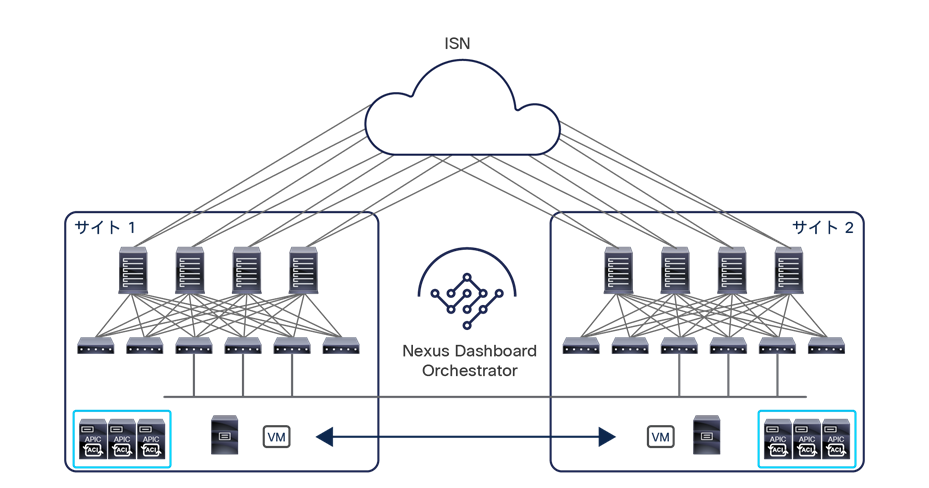

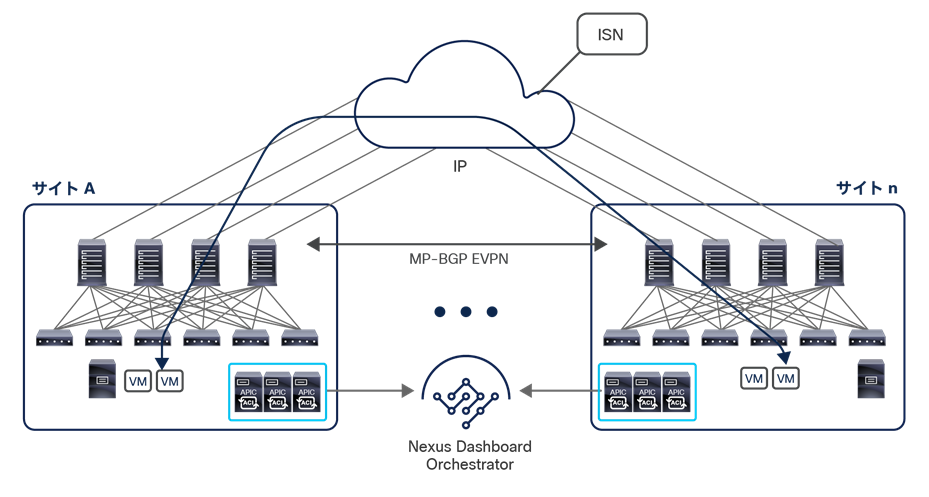

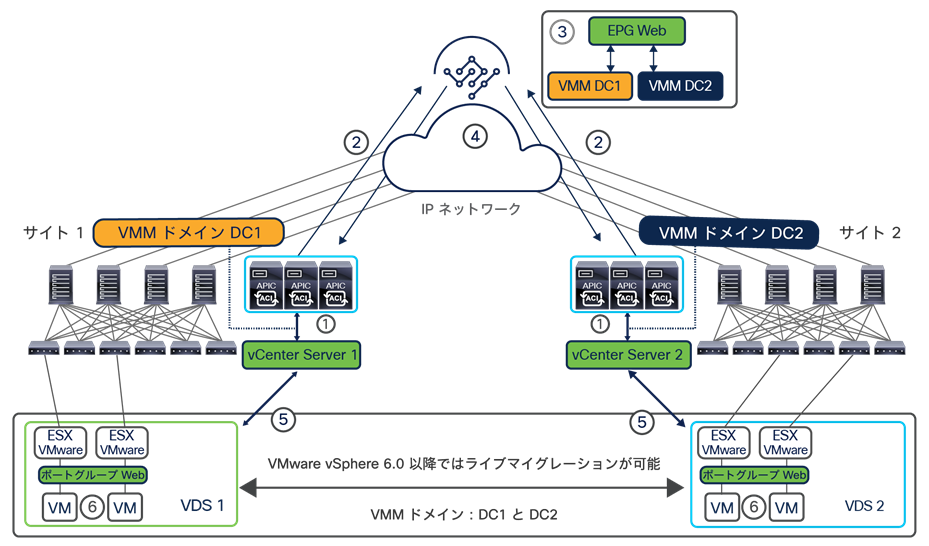

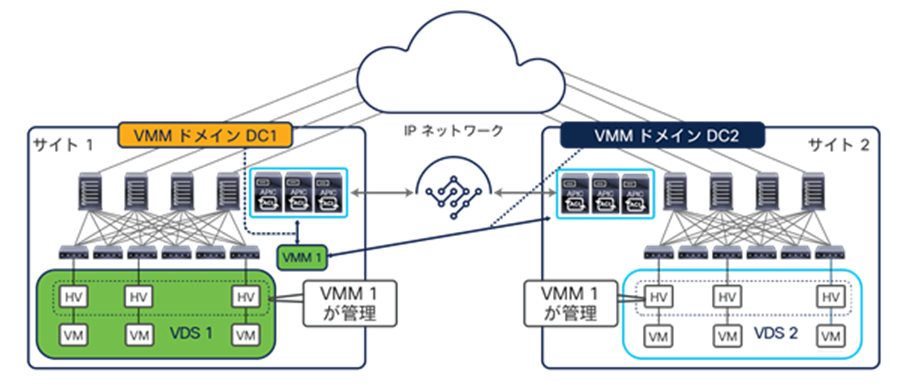

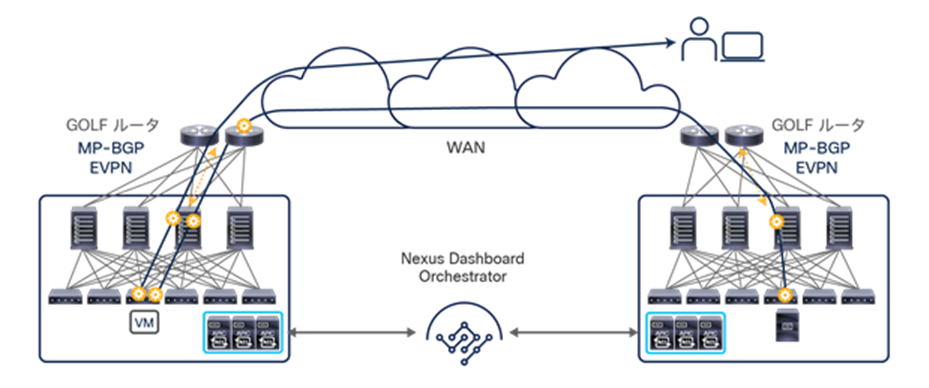

Cisco ACI マルチサイトアーキテクチャの全体図を図 5 に示します。

Cisco ACI マルチサイトアーキテクチャ

Cisco ACI マルチサイトは、個別の Cisco APIC クラスタドメイン(ファブリック)を相互接続できるアーキテクチャです。これによって、異なるリージョンを構成する各ドメインがすべて、同じ Cisco ACI マルチサイトドメインに属することになります。その結果、マルチテナントのレイヤ 2 とレイヤ 3 のネットワークがサイト間で接続され、ポリシードメインがシステム全体にエンドツーエンドで拡張されます。

注:

この設計は、以下の機能コンポーネントによって実現されます。

● Cisco Nexus Dashboard Orchestrator(NDO):このコンポーネントは、サイトにまたがってポリシーを管理します。このコンポーネントが提供する一元的な管理によって、相互接続されたすべてのサイトの正常性スコアをモニタリングできます。また、すべてのサイト間ポリシーを 1 か所で定義した後、異なる APIC ドメインにプッシュして、そのファブリックを構成する物理スイッチにレンダリングできます。これらのポリシーをいつどこにプッシュするかを高度に制御できるため、変更ドメインの分離が可能になります。これは、Cisco ACI マルチサイトアーキテクチャ独自の特徴です。

Orchestrator ソフトウェアリリース 3.2(1) より前は、このコンポーネントは Multi-Site Orchestrator(MSO)という名前でした。新しいリリースでは、Cisco Nexus Dashboard(ND)コンピューティング プラットフォームで実行されるアプリケーションとしてのみサポートされるため、Nexus Dashboard Orchestrator(NDO)に改名されました。ただし、シスコのドキュメントでは、「Multi-Site Orchestrator(MSO)」、「Nexus Dashboard Orchestrator(NDO)」、または単に「Orchestrator サービス」と、区別せずに呼ばれている場合があります。これらの名前はすべて、Cisco Multi-Site アーキテクチャの同じ機能コンポーネントを指します。

Cisco Nexus Dashboard Orchestrator の詳細については、「Cisco Nexus Dashboard Orchestrator」のセクションを参照してください。

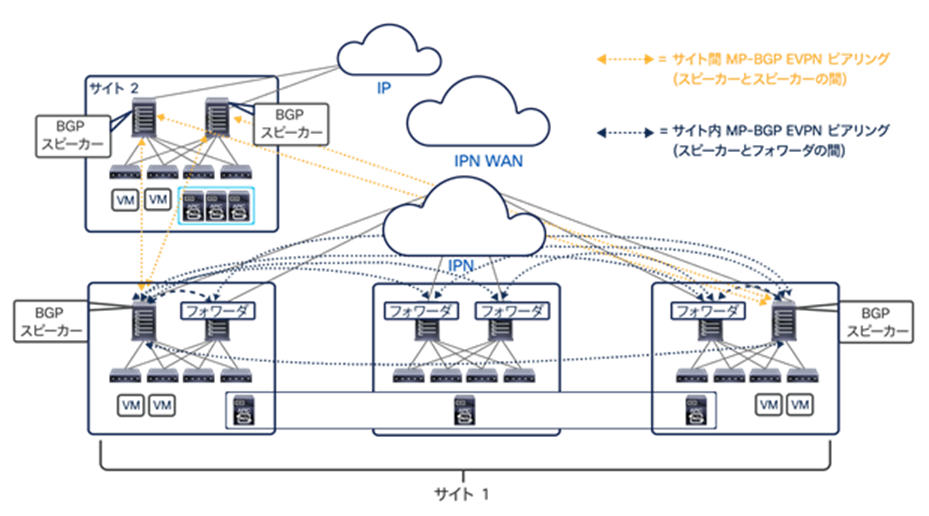

● サイト間コントロールプレーン:エンドポイントの到達可能性情報は、マルチプロトコル BGP(MP-BGP)イーサネット VPN(EVPN)コントロールプレーンを使用してサイト間で交換されます。このアプローチにより、サイト間で通信するエンドポイントの MAC および IP アドレス情報が交換されます。MP-BGP EVPN セッションは、Cisco Nexus Dashboard Orchestrator の同じインスタンスによって管理される別々のファブリックに展開されたスパインノード間で確立されます。詳細については、「Cisco ACI マルチサイトのオーバーレイ コントロール プレーン」セクションを参照してください。

● サイト間データプレーン:異なるサイトに接続されているエンドポイント間のすべての通信(レイヤ 2 またはレイヤ 3)は、さまざまなサイトを相互接続する汎用 IP ネットワークを通過するサイト間仮想拡張 LAN(VXLAN)トンネルを確立することによって実現されます。「サイト間ネットワーク(ISN)の展開に関する考慮事項」セクションで説明するように、この IP ネットワークには、ルーティングのサポートと最大伝送ユニット(MTU)サイズの拡大(VXLAN カプセル化によるオーバーヘッドを考慮)以外に、特定の機能要件はありません。

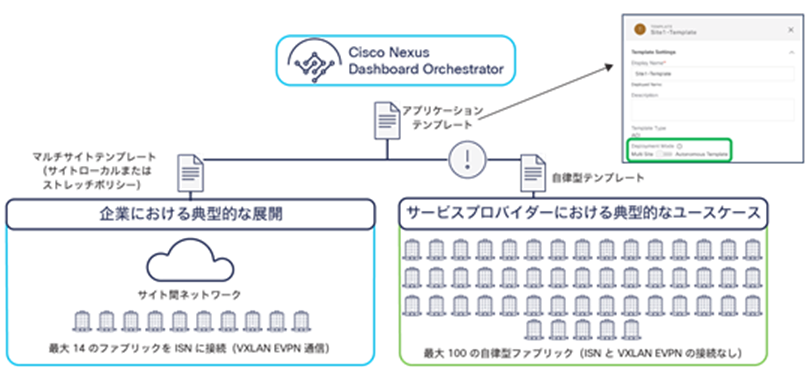

注: Nexus Dashboard Orchestrator ソフトウェアリリース 4.0(1) 以降、新しい導入モデルがサポートされ、NDO を導入して最大 100 の「自律型ファブリック」を管理できます。このようなユースケースでは、マルチサイトドメインに属するファブリック間に VXLAN EVPN によるサイト間接続が存在せず、基本的に Orchestrator がこれらすべてのサイトに構成を一元的にプロビジョニングします。L3Out データパスを利用することで、ファブリック間ではレイヤ 3 のみの通信が可能です。NDO の導入と「自律型ファブリック」の詳細については、「レイヤ 3 のみのサイト間接続」セクションを参照してください。

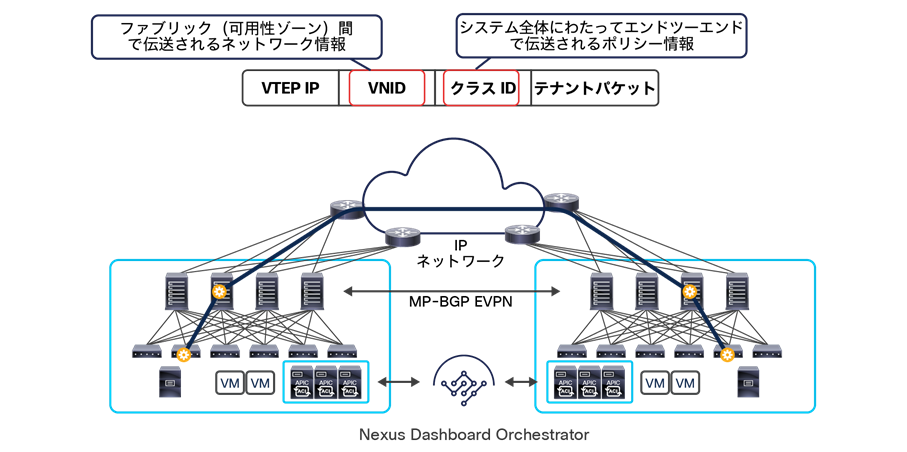

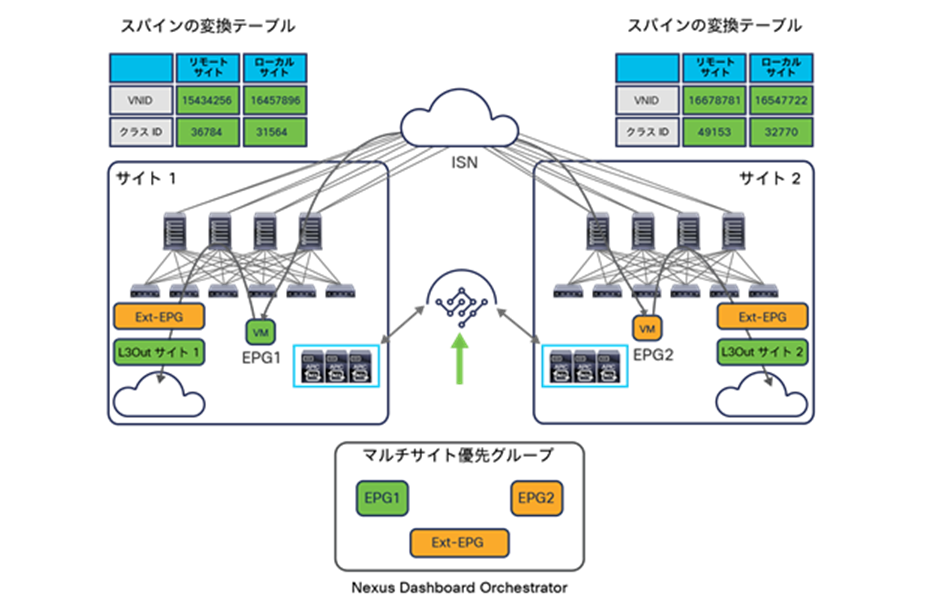

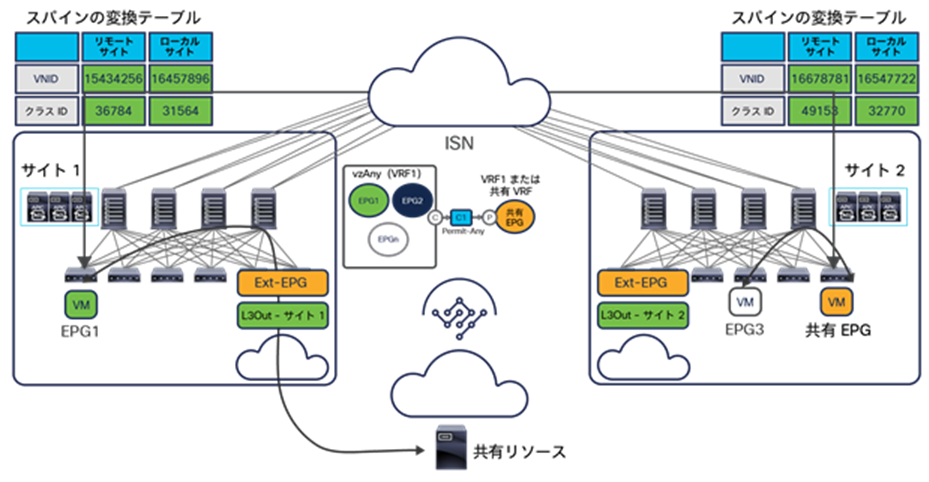

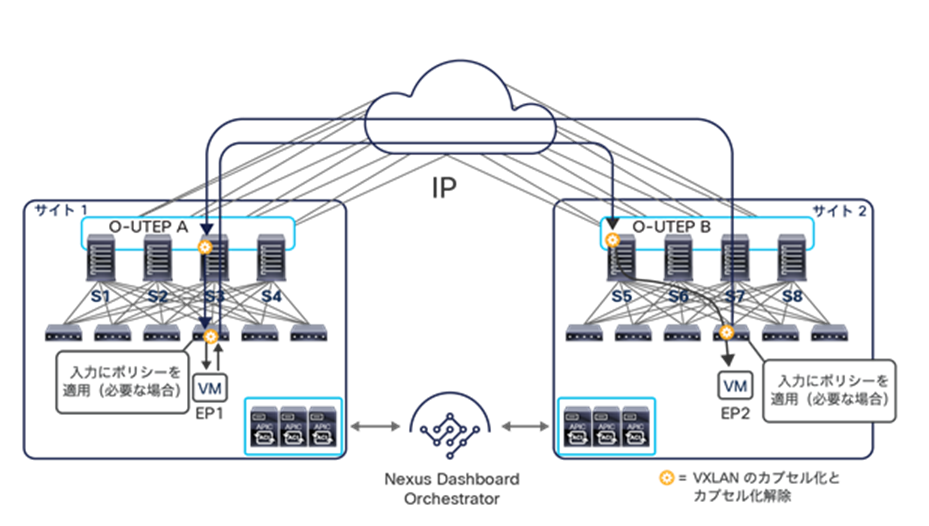

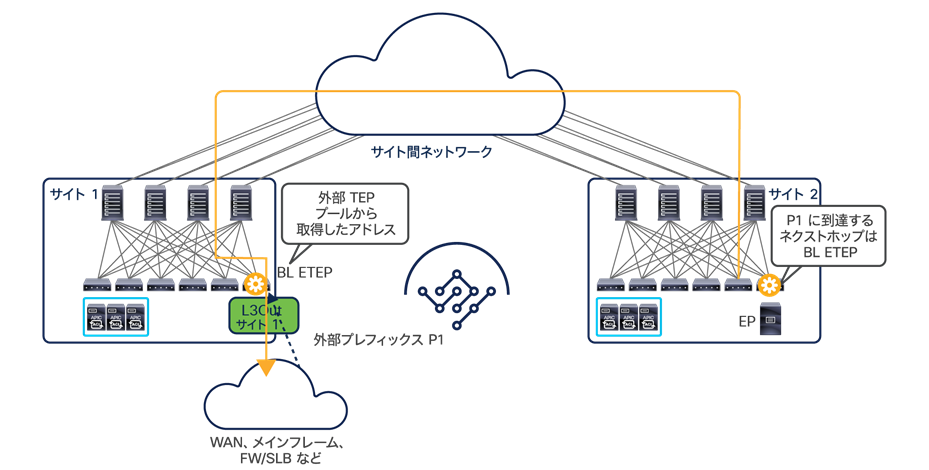

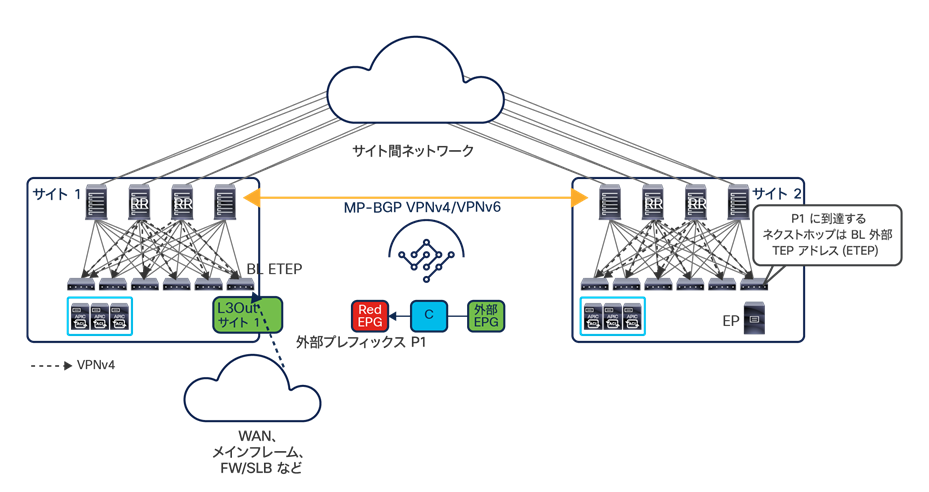

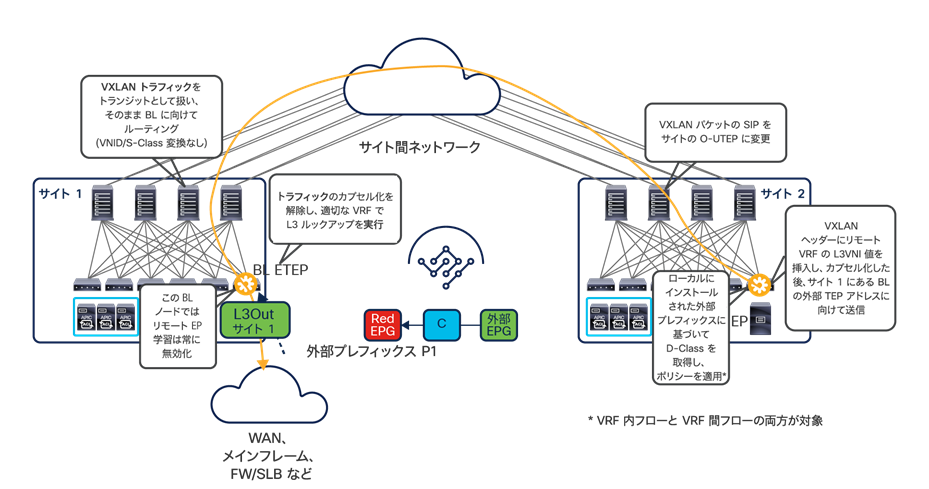

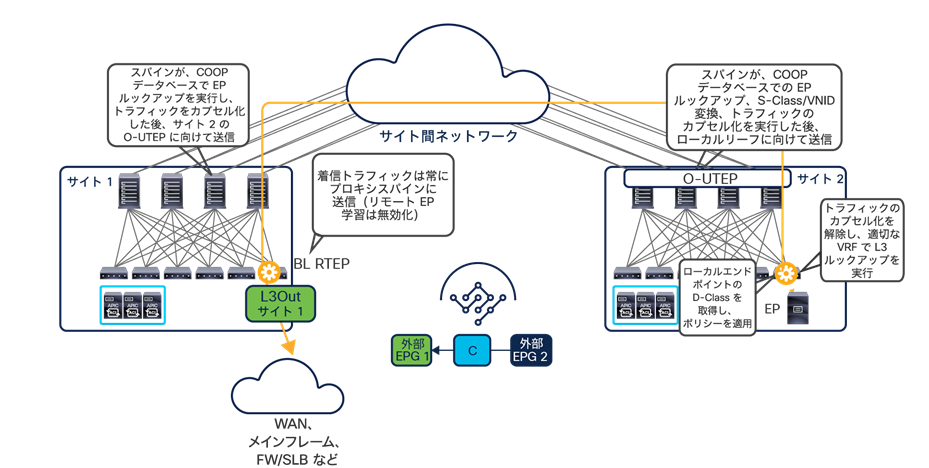

サイト間 VXLAN カプセル化を使用すると、サイト間 IP ネットワークに必要な構成と機能が大幅に簡素化されます。また、ネットワークとポリシーの情報(メタデータ)をサイト間で伝送することもできます(図 6)。

VXLAN ネットワーク識別子(VNID)は、レイヤ 2 の通信の場合、ブリッジ ドメイン(BD)を識別します。レイヤ 3 のトラフィックの場合、仮想ルーティングおよび転送(VRF)内通信のトラフィックを送信するエンドポイントの VRF インスタンスを識別します。クラス ID は、送信元エンドポイントグループ(EPG)の一意の識別子です。ただし、これらの値はファブリック内でのみ有効です。完全に独立した APIC ドメインおよびファブリックが宛先サイトに展開されているため、宛先サイト内でトラフィックを転送する前に、変換機能(「名前空間の正規化」とも呼ばれます)を適用する必要があります。これによって、宛先サイト内で有効で、送信元の EPG、ブリッジドメイン、VRF インスタンスを識別できる値が使用できるようになります。

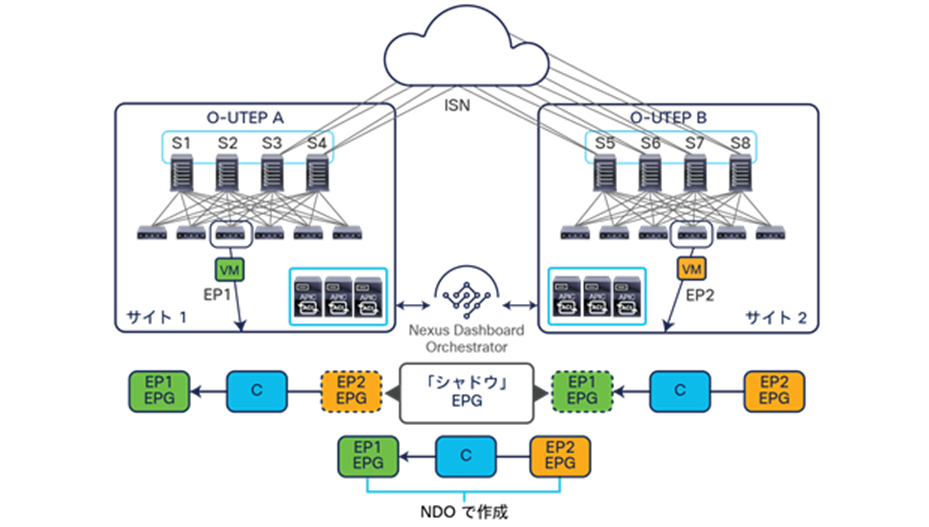

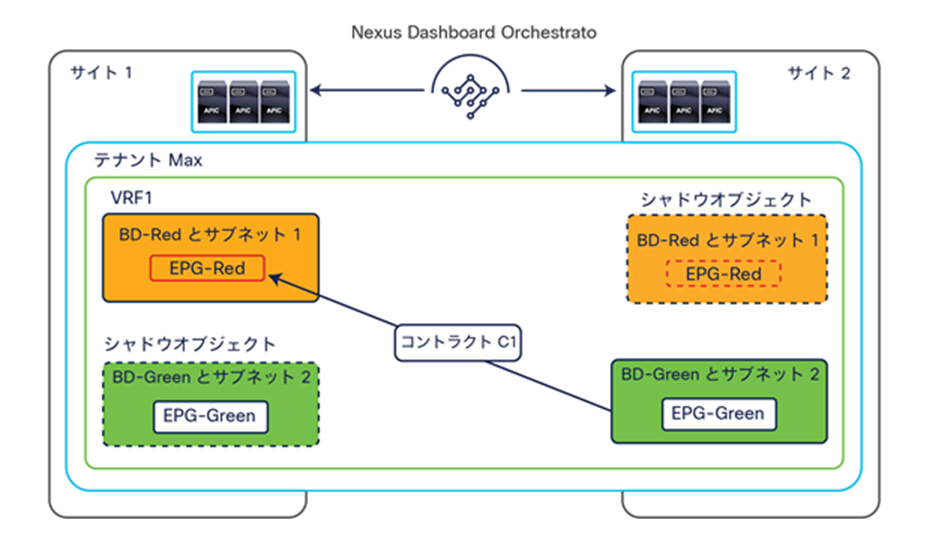

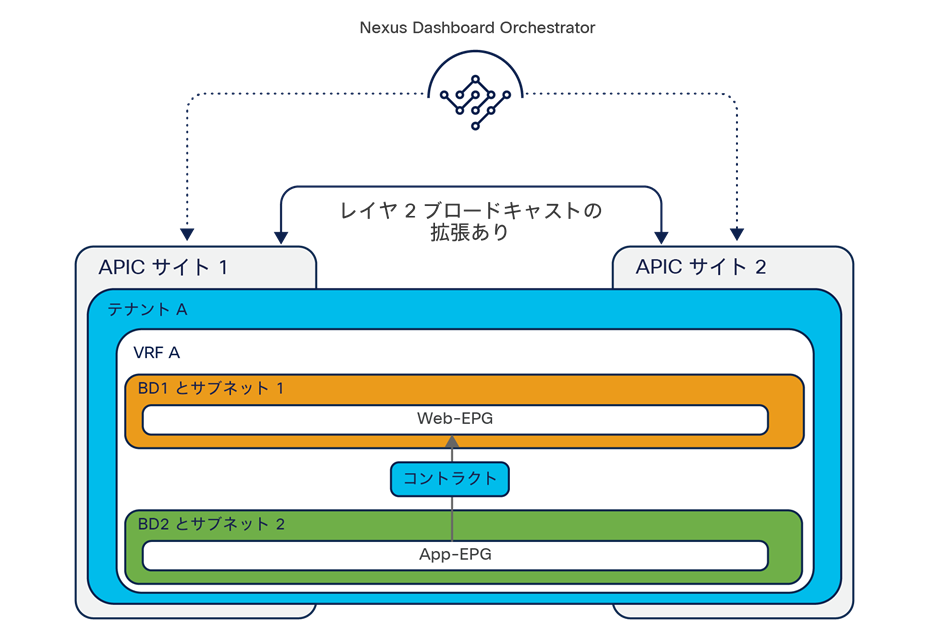

この名前空間の正規化機能の必要性について理解を深めるには、別々のサイトに展開された 2 つの EPG 間でコントラクトが定義されるときの動作を明確にすることが重要です。このコントラクトは、それぞれの EPG に属するエンドポイント間でサイト間通信を行うために必要です。図 7 に示すように、目的の構成(意図)が Cisco Nexus Dashboard Orchestrator で定義され、異なる APIC ドメインにプッシュされると、シャドウ EPG と呼ばれる EPG のコピーが各 APIC ドメインに自動的に作成されます。これにより、NDO で一元的に定義された設定全体を各サイトでローカルにインスタンス化でき、各 EPG がローカルでのみ定義されサイトにまたがって拡張されていない場合でも、セキュリティポリシーが適切に適用されます(特定の VNID とクラス ID が、各 APIC ドメインのシャドウオブジェクトに割り当てられます)。

シャドウ EPG の作成

上図の例では、黄色の EP2 EPG(およびそれに関連付けられた BD)が APIC ドメイン 1 に「シャドウ」EPG として作成され、緑色の EP1 EPG(およびそれに関連付けられた BD)が APIC ドメイン 2 に「シャドウ」EPG として作成されます。Cisco ACI リリース 5.0(1) までは、シャドウ EPG および BD を APIC GUI 上で簡単に区別できないため、それらの存在と役割を認識することが非常に重要です。

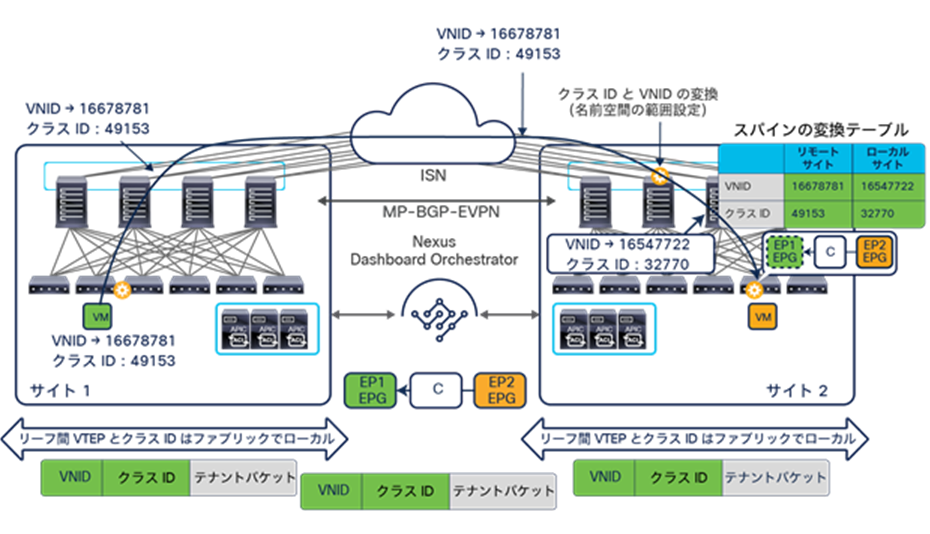

両方の APIC ドメインが互いに完全に独立しているため、サイト全体で見たとき、特定の EPG に異なる VNID とクラス ID の値が割り当てられる(「実際の」コピーと「シャドウ」コピー)と想定されます。そのため、下の図 8 に示すように、ローカルサイトにトラフィックを送る前に、リモートサイトからデータプレーントラフィックを受信するスパインでこれらの値を変換する必要があります。

「EP1 EPG」と「EP2 EPG」の通信が必要となるポリシーが Cisco Nexus Dashboard Orchestrator で作成されると、Nexus Dashboard Orchestrator は各 APIC コントローラから、ローカルオブジェクトとシャドウオブジェクトに割り当てられた識別子(pcTag、L2VNI、L3VNI)を受け取ります。さらに、ローカルスパインで適切な変換ルールをプログラミングするように APIC コントローラに指示します。その結果、トラフィックを宛先エンドポイントに送信する前に、構成されたポリシーがリーフノードに正しく適用されます。さらに、別々のサイトにローカルに展開された EPG 間でコントラクトを作成すると、通常、これらの EPG に関連付けられた BD サブネットもリモートサイトのリーフノード上に構成されます(ローカルスパインノードを介したプロキシパスを有効にするため)。詳細については、「Cisco ACI マルチサイトのオーバーレイデータプレーン」セクションを参照してください。

注: 図 8 の例は、宛先サイトのリーフノードでポリシーが適用される状況を示しています。通常、この状況は、送信元サイトのリーフノードがデータプレーンを介してリモートエンドポイントのロケーション情報を学習するまで続きます。学習が終わると、ポリシーが入力リーフで直接適用できるようになります。ポリシーベースリダイレクト(PBR)でのサービスグラフの使用は、これが常に当てはまるとは限らないことを示すケースです。詳細については、「ネットワークサービスの統合」セクションを参照してください。

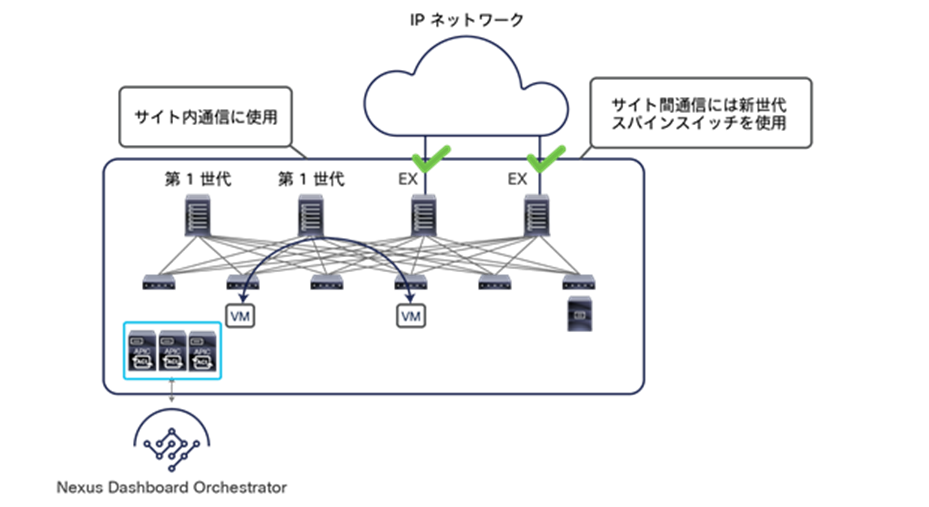

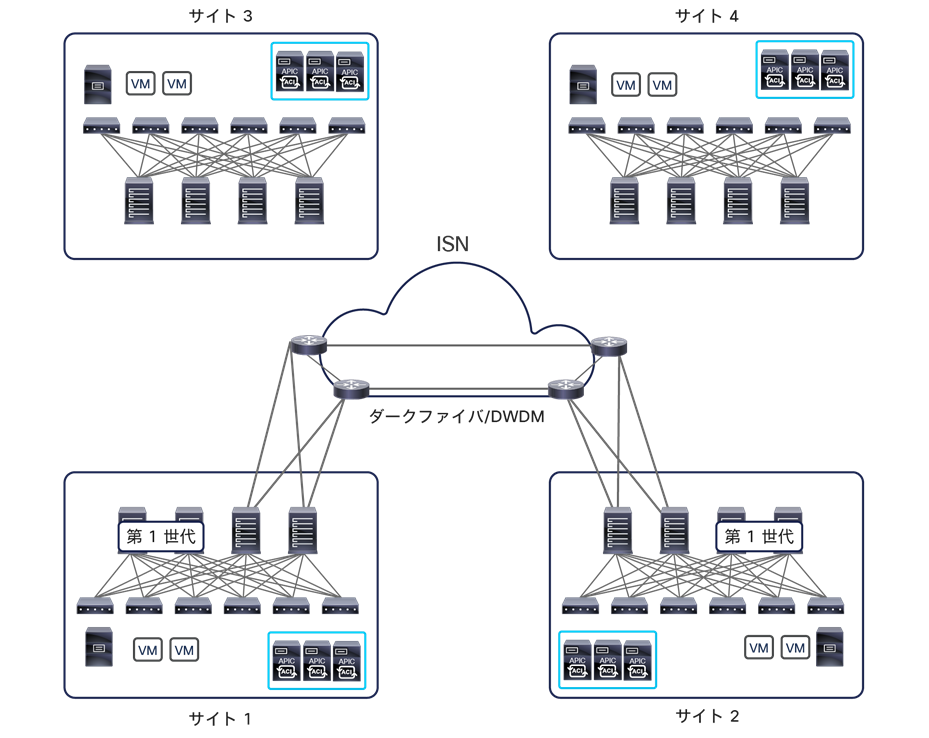

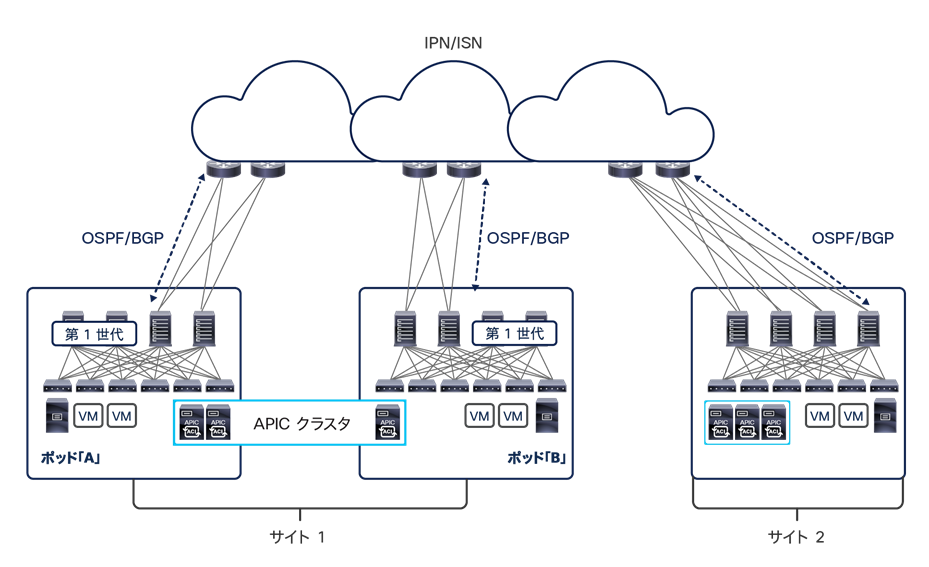

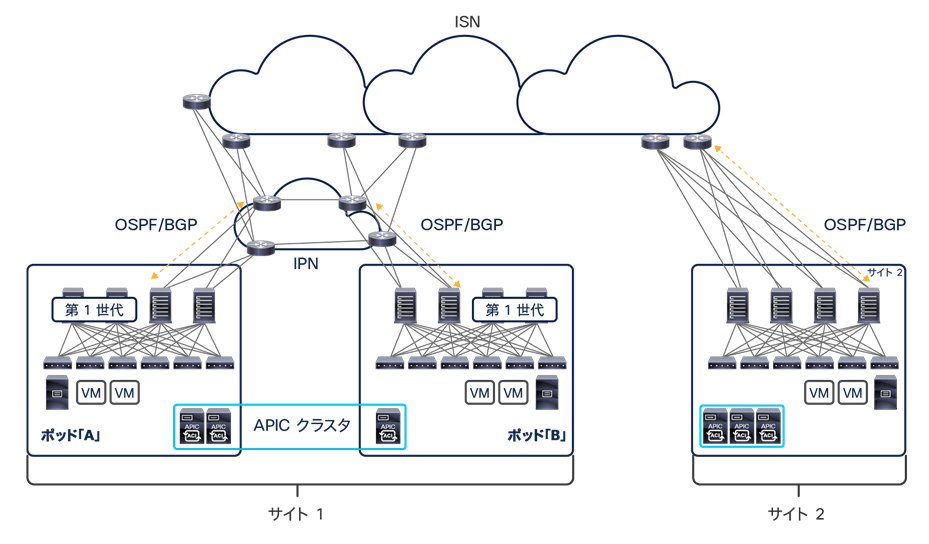

この名前空間の変換機能は、サイト間通信のパフォーマンスに悪影響を与えないようにラインレートで実行する必要があります。これを実現するには、Cisco ACI マルチサイトアーキテクチャに展開されたスパインノードに特定のハードウェアを使用する必要があります。マルチサイト展開では、Cisco Nexus EX プラットフォーム(およびそれ以降)の世代のスパインスイッチのみがサポートされます。第 1 世代のスパインスイッチはスパインスイッチの新しいモデルと共存できることに注意してください。ただし、後者のみが外部 IP ネットワークに接続され、サイト間通信に使用されるようになっている必要があります(図 9)。

第 1 世代スパインスイッチと EX プラットフォーム(およびそれ以降)のスパインスイッチの共存

図 9 の共存シナリオは、展開されたすべてのスパインを外部レイヤ 3 ドメインに接続する必要がないことも示しています。使用できる具体的なハードウェアと、復元力とスループットの要求レベルに基づいて、外部 IP ネットワークへの接続に使用するスパインとリンクの数を決定します。

注: 9332C プラットフォームと 9364C プラットフォームのようなモジュラ型でないスパインモデルの場合、ネイティブ 10G インターフェイス(SFP ベース)を使用してサイト間ネットワーク(ISN)デバイスに接続することもできます。

Cisco ACI マルチサイトアーキテクチャの導入により、相互接続されたファブリック全体に展開されるリーフノードとスパインノードの総数、さらにはエンドポイントの総数を拡大することもできます。これが可能なことが、Cisco ACI マルチサイトおよびマルチポッドの設計の主要な相違点の 1 つです。後者のオプションは、単一のファブリックとしての設計が抱える拡張性の制約に依然として縛られているためです。

注: Cisco ACI の展開を計画するときは、https://www.cisco.com/c/ja_jp/partners/partner-with-cisco/integrator/levels.html で提供されているスケーラビリティガイドを必ず参照してください。たとえば、Cisco ACI リリース 4.0(1) に適用されるスケーラビリティガイドについては、https://www.cisco.com/c/en/us/td/docs/switches/datacenter/aci/apic/sw/4-x/verified-scalability/Cisco-ACI-Verified-Scalability-Guide-401.html を参照してください。

EPG がサイトにまたがって拡張されている場合、スパインノードの変換テーブルにエントリが常に追加されます。これは、デフォルトで許可されている EPG 内通信を可能にするために必要です。一方、別々のサイトでローカルに定義された EPG に属するエンドポイント間でサイト間通信を確立する必要がある場合、それぞれの変換テーブルに正しくエントリを追加するために、EPG 間でコントラクトを定義する必要があります(この例は、上の図 7 と図 8 を参照してください)。したがって、サイト間ネットワーク(VXLAN データパス)を介してサイト間通信を確立する必要がある場合は、コントラクトと EPG を定義し、NDO でコントラクトを EPG 間に直接適用することが必須です。any-to-any 通信を可能にすることが目的である場合、非常にシンプルなコントラクト(「すべて許可」に相当)を作成して、異なるすべての EPG ペアに適用できることに注意してください。

2 つの追加機能(優先グループと vzAny)が Nexus Dashboard Orchestrator で利用できるようになりました。これを用いることで、EPG 間のポリシー定義の簡素化と、サイト間接続に必要なスパイン上の変換テーブルの適切なプログラミングが可能になります。これらの機能については、以下の 2 つのセクションで説明します。

注: 変換テーブルの内容を確認するには、スパインノードに接続して、CLI コマンド「show dcimgr repo {eteps | sclass-maps | vnid-maps}」を実行します。

Cisco ACI マルチサイトと優先グループのサポート

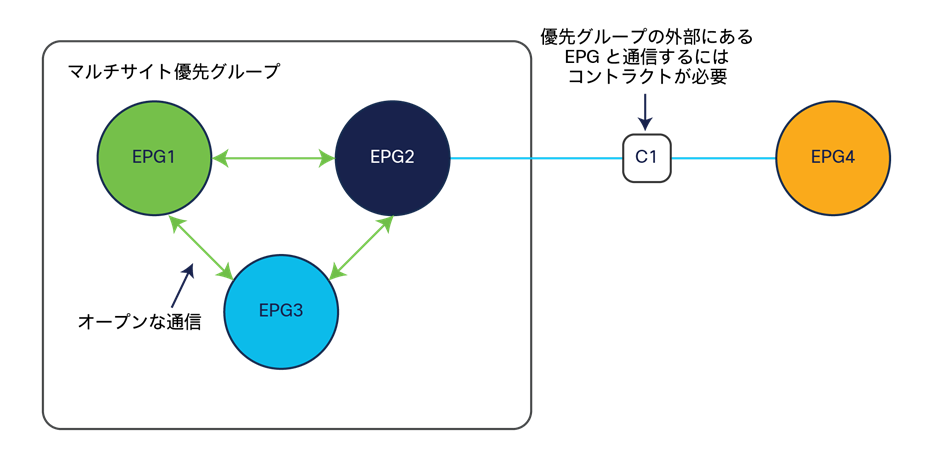

Cisco ACI リリース 4.0(2) では、Cisco ACI マルチサイトで EPG 優先グループが利用できます。優先グループの構造は VRF レベルで有効であり、その VRF で定義されたすべての(または一部の)EPG をグループ化できます。図 10 に示すように、優先グループに属する EPG は、コントラクトを作成しなくても相互に通信できます。優先グループから除外されている EPG が他の除外された EPG や優先グループに含まれる EPG と通信するためには、コントラクトの定義が必要です。

注: 優先グループの外部の EPG と通信するには、優先グループに属する個々の EPG すべてにコントラクトを適用する必要があります。

この Cisco ACI マルチサイトシナリオの場合、直接 NDO で EPG を優先グループに属させる必要があります。そうすることで、スパインに正しい変換エントリが自動的に作成され、これらの EPG に属するエンドポイント間でのサイト間通信、さらには外部ネットワークドメインとの垂直方向通信が可能になります(図 11)。

優先グループを使用した垂直方向と水平方向の通信

そのため、拡張性の全体的な上限値を考慮したうえで、優先グループに入れる EPG の数を決めることが重要です。前述のように、この情報は、Web サイト Cisco.com にある Verified Scalability Guide で入手できます。

もう 1 つの重要な考慮事項は、L3Out に関連付けられた外部 EPG(Ext-EPG)に対する優先グループの設定です。これを行う場合、分類のために Ext-EPG にプレフィックス 0.0.0.0/0 を設定することはできません。これは、トラフィックが L3Out で受信され、このプレフィックスに基づいて分類される場合、Ext-EPG 固有のクラス ID ではなく、VRF のクラス ID が着信パケットに割り当てられるためです。その結果、VRF クラス ID から特定の EPG クラス ID へのトラフィックを許可するセキュリティルールが作成されていないため、その VRF の優先グループに属する他の EPG との通信が許可されません。回避策として、分類のために 2 つの個別のプレフィックス(0.0.0.0/1 と 128.0.0.0/1)を作成して、アドレス空間全体をカバーするようにすることもできます。

最後に、Orchestrator のリリース 3.4(1) と APIC の 5.2(1) では、優先グループを使用して、サイト間 L3Out 接続を有効にすることはできません。サイト間 L3Out の詳細については、「サイト間 L3Out 機能の導入(Cisco ACI リリース 4.2(1)/MSO リリース 2.2(1) 以降)」セクションを参照してください。

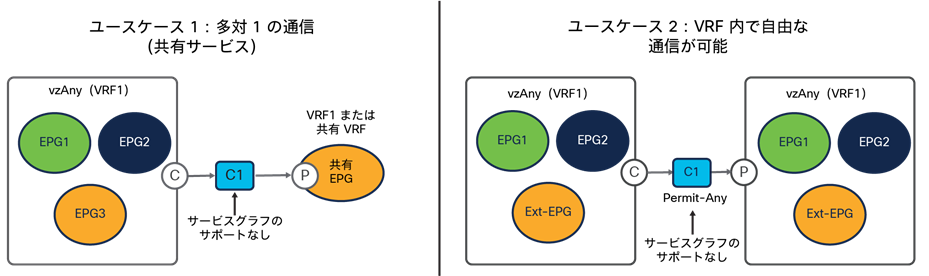

Cisco ACI マルチサイトと vzAny のサポート

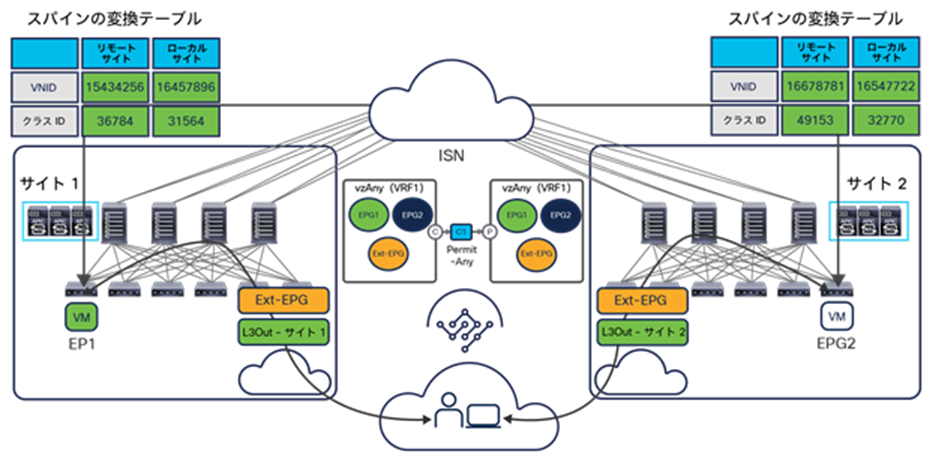

Cisco Multi-Site Orchestrator リリース 2.2(4) では、マルチサイトで vzAny 機能が利用できます。vzAny は、1 つの VRF に属するすべての EPG(内部と外部)を表す論理構造です。これらすべての項目を 1 つのオブジェクトで表せるため、図 12 に示す 2 つの主要なケースで展開が簡素化されます。

vzAny が利用できる主なユースケース

● 最初のユースケースでは、1 つの VRF に属するすべての EPG と、同じ VRF または別の VRF に属する共有リソースの間で「多対 1」の通信を確立しています。個々の EPG と共有 EPG の間にコントラクトを適用する代わりに、共有 EPG によって提供されたコントラクトのコンシューマとして「vzAny」を設定することができます。これにより、各 EPG と共有 EPG の間の通信のみが確保され、同じ VRF に属する EPG 間の VRF 内通信は確保されないことに注意してください。

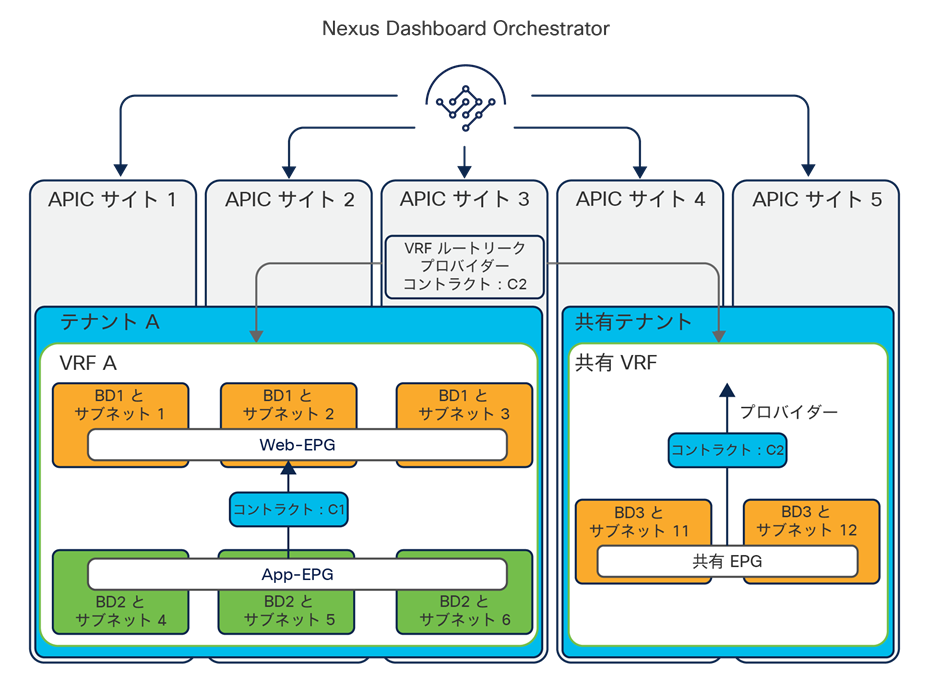

リリース 2.2(4) 以降の Orchestrator で vzAny 構造を公開すると、エンドポイントが同じ ACI ファブリックに属しているか、異なるサイトに展開されているかに関係なく、この「多対 1」の通信パラダイムを展開できます。外部ネットワークドメインの共有リソースへのアクセスも可能になります(図 13)。

サイト間および外部ネットワークとの多対 1 の通信

● 一方、同じ VRF に属するすべての EPG が相互に通信できるようにすることが目的である場合(優先グループの代替となる構成オプション)、「permit any」フィルタルールで定義された単一のコントラクトのコンシューマとプロバイダーとして vzAny を設定できます。これにより、機能的には「VRF unenforced」オプション(NDO ではサポートされません)と同じ目的が達成できます。セキュリティポリシーを式に組み入れる必要がなくなり、ネットワーク接続のためだけに ACI マルチサイト展開を使用できます。図 14 に示すように、この構成オプションを使用すると、水平方向と垂直方向の両方の通信を確立できます。さらに、必要な変換エントリがスパインに適切にプログラミングされます。

VRF 内での any-to-any 通信の確立

このシナリオで vzAny を使用すると、EPG 間のフルメッシュコントラクトを作成する必要がなくなり、構成が簡素化されるだけでなく、TCAM の使用率も大幅に削減されます。

マルチサイトアーキテクチャで vzAny を利用するための要件について指摘しておくことが重要です。Cisco Multi-Site Orchestrator リリース 2.2(4)(または最新の NDO バージョン)を実行することが唯一の条件であり、同じマルチサイトドメインに属する他のファブリックに導入された ACI ソフトウェアのバージョンには依存しません。NDO と APIC のソフトウェアリリース間の依存関係に関するその他の考慮事項は、「バージョン間サポート(Cisco Multi-Site Orchestrator リリース 2.2(1) 以降)」セクションを参照してください。

また、Cisco Nexus Dashboard Orchestrator リリース 4.0(1) では、vzAny によって使用されるコントラクトにサービスグラフを追加することはできません(多対 1 と any-to-any の両方のユースケース)。この機能は、将来のソフトウェアリリースでサポートされる予定です。

Cisco Nexus Dashboard Orchestrator

Cisco Nexus Dashboard Orchestrator(NDO)は、プロビジョニングやヘルスモニタリングを行うだけでなく、世界に展開された Cisco ACI サイト全体で Cisco ACI のネットワーク、ファブリック、テナントポリシーをライフサイクル全体を通じて管理する役割を担った製品です。NDO は基本的に信頼できる唯一の情報源であり、別々の ACI ファブリックに展開されたエンドポイント間でサイト間(つまり、水平方向)通信を確立するために必要なすべてのテナントポリシーを提供します。

最新の実装では、Cisco Nexus Dashboard Orchestrator は、Nexus Dashboard と呼ばれるシスコのコンピューティングクラスタ上でサービスとして実行できるようになっています。以前の実装では、この製品は「Cisco Multi-Site Orchestrator(MSO)」と呼ばれていました。そのため、このドキュメントの以降の記述では、特に旧版の Orchestrator で導入されていた機能について説明する際に「MSO」の名称を使用する場合があります。Multi-Site Orchestrator の以前の実装に関する詳細は、付録 B を参照してください。

Cisco Nexus Dashboard Orchestrator には、いくつかの主要な機能があります。注目すべき点としては、ユーザープロファイルと RBAC ルールの作成と管理がサイトオンボーディングのプロセスとともに Orchestrator から取り除かれ、Nexus Dashboard コンピューティング プラットフォームに追加されたことが挙げられます。これらのサービスが、ND コンピューティングクラスタで実行できるさまざまなアプリケーションすべてに共通したものであるためです。

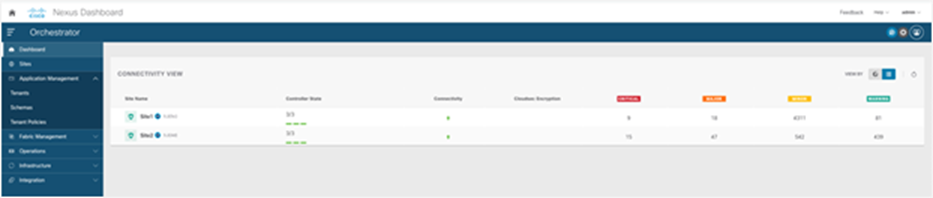

NDO で現在利用できる機能は以下のとおりです。

● ヘルスダッシュボードを使用して、サイト間ポリシーの正常性、障害、ログをモニタリングできます。Cisco Multi-Site ドメインに属するすべての Cisco ACI ファブリックが対象です。正常性スコアに関する情報は各 APIC ドメインから取得され、図 15 に示すように一元化された方法で表示されます。

Cisco Nexus Dashboard Orchestrator のダッシュボード

● Day-0 インフラストラクチャのプロビジョニングによって、すべての Cisco ACI サイトのスパインスイッチを直接接続されたサイト間ネットワーク(ISN)デバイスとピアリングします。マルチサイトドメインに属する各ファブリックで ISN とのピアリングが完了すると、すべてのスパインに対して NDO が MP-BGP EVPN を自動的に構成します。これによって、スパインが相互接続できるようになります。その結果、MP-BGP EVPN コントロールプレーンにおける到達可能性が確立され、サイト間でエンドポイントのホスト情報(MAC および IPv4/IPv6 アドレス)を交換できるようになります。

● 新しいテナントを作成し、接続されているすべてのサイト(またはその一部)に展開します。

● アプリケーション テンプレートを定義します。図 16 に示すように、各アプリケーション テンプレートをファブリックの特定のセットに関連付けて、そのセットにプッシュすることができます。

注:1 つ以上のテンプレートをスキーマの要素としてグループ化できます。スキーマは、ポリシーの「コンテナ」と見なすことができます。ただし、テナントへのポリシーの関連付けは、常にテンプレートレベルで行われます。スキーマレベルではありません。

この機能は、変更管理のために範囲を設定したポリシーを定義してプロビジョニングする機能とともに、Cisco Nexus Dashboard Orchestrator が提供する最も重要な機能の 1 つです。サイト間ポリシーを定義すると、Cisco Nexus Dashboard Orchestrator が、サイト全体にわたって、マルチサイト対応スパインスイッチで必要な名前空間変換ルールも適切にプログラミングします。以前のセクションで述べたように、サイト間通信を行うには、マルチサイトドメインに属する各ファブリックにあるスパインノードに変換エントリを作成する必要があります。これは、サイト間通信を許可するポリシーが Nexus Dashboard Orchestrator で定義され、ファブリックを管理する別の APIC クラスタにプッシュされた場合にのみ実行されます。そのため、すべてのテナントオブジェクト(EPG、BD など)の構成を NDO で直接管理することがベストプラクティスの推奨事項です。これらのオブジェクトが複数のサイトにまたがって拡張されているか、特定のサイトでローカルに定義されているかは関係ありません。NDO スキーマとアプリケーション テンプレートの展開方法の詳細については、このホワイトペーパーの「NDO のスキーマとテンプレートの展開」セクションを参照してください。

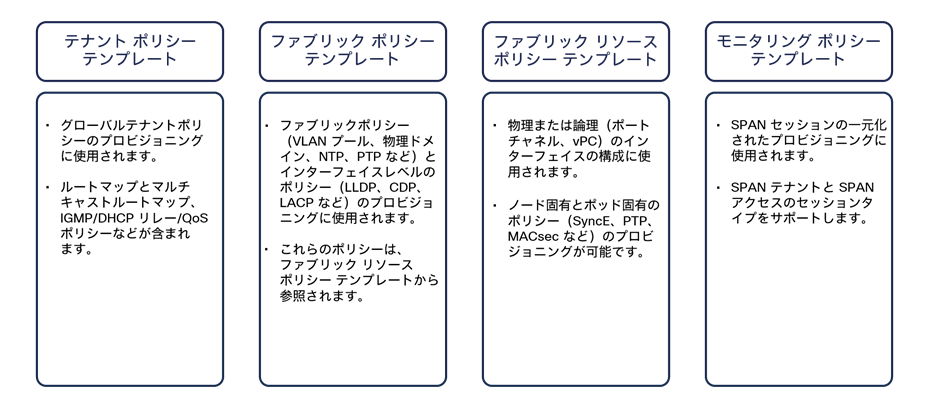

● ソフトウェアリリース 4.0(1) から、上記のアプリケーション テンプレートに加えて、他のタイプのテンプレートが NDO に追加されました。これらを用いて、テンプレートポリシー(テナント ポリシー テンプレート)、ファブリックポリシー(ファブリック ポリシー テンプレートとファブリック リソース ポリシー テンプレート)、SPAN モニタリングポリシー(モニタリング ポリシー テンプレート)をプロビジョニングできます。これらの新しいタイプのテンプレートの詳細については、このホワイトペーパーの「自律型アプリケーション テンプレート(NDO リリース 4.0(1))」セクションを参照してください。

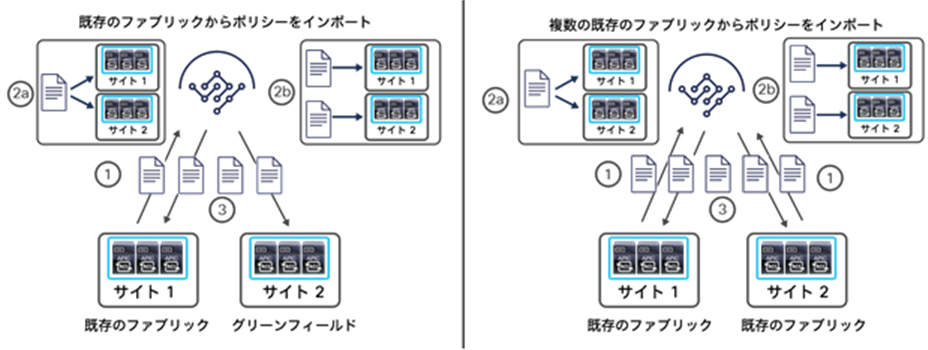

● すでに展開されている Cisco ACI ファブリック(ブラウンフィールド展開)からポリシーをインポートし、それらを別の新しく展開されたサイト(グリーンフィールド展開)に拡張できます。詳細については、「ブラウンフィールド統合シナリオ」セクションを参照してください。

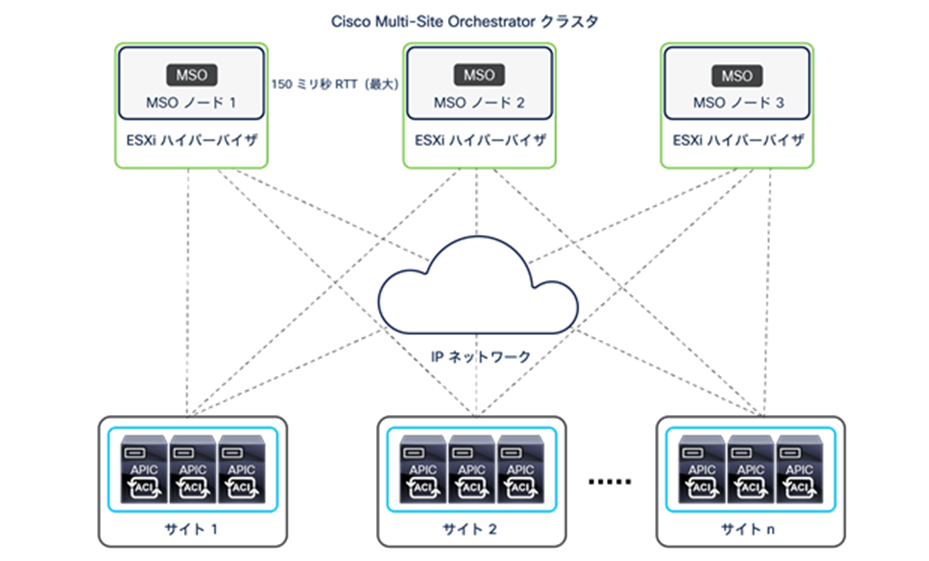

Cisco Nexus Dashboard Orchestrator はマイクロサービス アーキテクチャに基づいて設計されており、NDO サービスはアクティブ/アクティブ方式で連携する Nexus Dashboard のクラスタノードにまたがって導入されます。Cisco Nexus Dashboard Orchestrator サービスは、異なるサイトに展開された各 APIC ノードと通信する必要があります。NDO および APIC クラスタ間の通信は、アウトオブバンド(OOB)インターフェイス、インバンド(IB)インターフェイス、またはその両方に対して確立できます。導入に関するより具体的な情報は、「Cisco Nexus Dashboard の導入に関する考慮事項」セクションを参照してください。Orchestrator は、Representational State Transfer(REST)API または GUI(HTTPS)を介したノースバウンドアクセスも提供します。これによって、サイト全体に展開する必要があるネットワークとテナントのポリシーをライフサイクル全体にわたって管理できます(図 17)。

Nexus Dashboard クラスタで実行されている Cisco Nexus Dashboard Orchestrator

Cisco Nexus Dashboard Orchestrator クラスタには、セキュリティを強化する仕組みが組み込まれています。Cisco Nexus Dashboard Orchestrator のクラスタ設計は、Nessus、WhiteHat、Chaos Corona、Norad など、先進の業界ベンチマークに基づくすべての脆弱性テストに合格し、セキュリティの脆弱性は検出されていません。

さらに、異なる物理(または仮想)ノードで実行されている Orchestrator サービス間のすべてのトラフィックは常に保護されています。Nexus Dashboard クラスタの異なるノードで実行されている NDO サービスの場合、それぞれのサービスがトラフィックの暗号化を担っています。たとえば、Mongo DB の情報を配布するために TLS が使用され、APIC への接続は HTTPS を介して行われます。Kafka も TLS を使用します。したがって、Orchestrator サービスは、サービスの相互接続に利用されるネットワーク インフラストラクチャが何であっても、セキュアに導入することができます。

Cisco Nexus Dashboard Orchestrator の典型的なユースケース

「はじめに」で説明したように、Cisco Nexus Dashboard Orchestrator によって管理される Cisco ACI マルチサイトアーキテクチャの展開には、2 つの一般的なユースケースがあります。

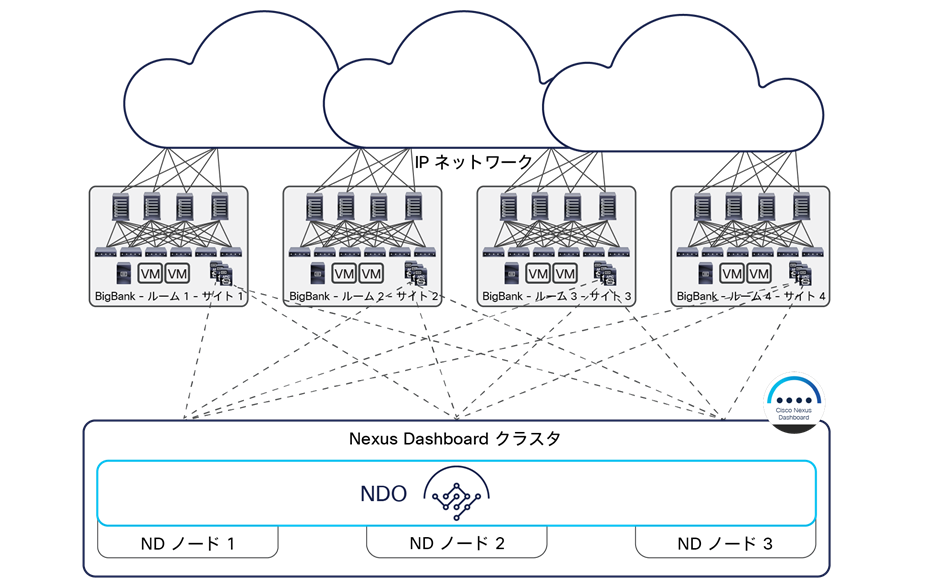

● 集中型(ローカル)データセンター:拡張性の要件または障害ドメイン分離の要件のために、同じ DC のロケーションに別々のファブリックを作成する必要がある場合

● 都市、国、大陸にまたがって地理的に分散したデータセンター:各データセンターを「リージョン」として扱い、リージョンにまたがって拡張されたポリシーを展開するために、プロビジョニング、モニタリング、管理を一元化する必要がある場合

以下の 2 つのセクションでは、これらの導入モデルについてさらに詳しく説明します。以下のセクションで明らかになるように、Orchestrator をホストする ND クラスタをパブリッククラウド(つまり、AWS または Microsoft Azure の特定のリージョン)に導入し、マルチサイトドメインに属するすべての ACI ファブリックをクラウドから管理することもできます。このアプローチは、以下で説明する両方のユースケースに適用できます。

リーフノードの拡張性を高めることを目的としたローカルデータセンターへの Cisco ACI マルチサイト展開

集中型展開のユースケースは、金融部門や政府部門でよく見られ、大規模なサービスプロバイダーでも採用されています。これらのシナリオでは、ベアメタルサーバー、仮想マシン、コンテナを接続するために非常に多くのポート数が必要な建物やローカルキャンパスに Cisco ACI マルチサイト設計が展開されます。多数のリーフノードを別々の Cisco ACI ファブリックに展開することによって、展開をスケールアウトしながら障害ドメインの範囲を制限し、すべてを一元管理できます。

図 18 に示す例では、4 つの Cisco ACI ファブリックが 1 つのホールにある 4 つの部屋ごとに展開され、各 Cisco ACI ファブリックは最大 500 のリーフスイッチで構成されます(マルチポッドファブリックを展開する場合)。Cisco Nexus Dashboard Orchestrator サービスは、Nexus Dashboard クラスタ(この例では 3 つの仮想マシン。3 つの物理ノードも可能)に導入されます。ND の各仮想ノードをそれぞれ別のハイパーバイザ(ESXi または KVM)に導入すれば、シングルポイント障害を避けることができます。Cisco Nexus Dashboard Orchestrator インターフェイスを介して、すべてのテナントポリシーを 4 つの Cisco ACI サイトすべてに拡張できます。追加の ND スタンバイプライマリノードを導入すれば、障害が発生した ND アクティブプライマリノードを置き換えることができます。

データセンター内に導入された Cisco Nexus Dashboard クラスタ

Orchestrator サービスをホストするベアメタルサーバーまたは仮想サーバーを ACI ファブリックに直接接続する必要はありません(通常は推奨されません)。ACI ファブリック接続に問題が発生して NDO が APIC クラスタと通信できなくなる事態を避けるためです。後のセクションで明らかになるように、APIC クラスタの OOB、IB、または両方のインターフェイスとの通信が可能なため(NDO 導入モデルによる)、これらのクラスタをどこに接続するかについては、完全な柔軟性があります。たとえば、データセンターの外部に導入することも可能です。

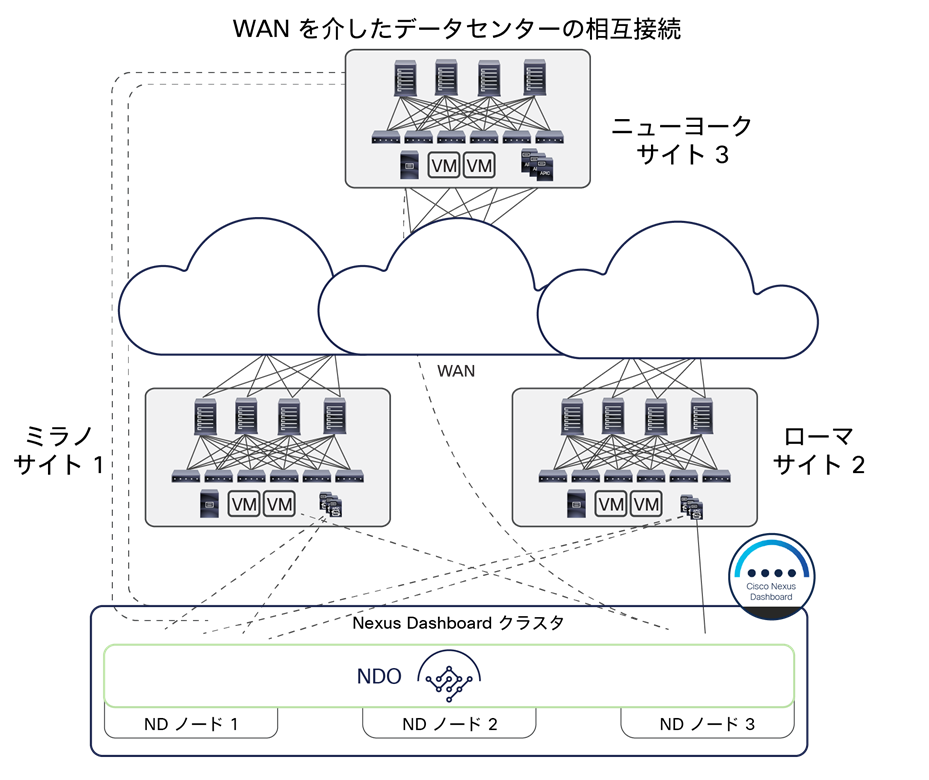

WAN 経由で相互接続されたデータセンターでの Cisco Nexus Dashboard Orchestrator の導入

WAN のユースケースは、企業やサービスプロバイダーで広く採用されています。このシナリオでは、地理的に離れたデータセンターが、異なる国または大陸の都市間で相互接続されます。

図 19 に示す例では、3 つの Cisco ACI ファブリックがそれぞれローマ、ミラノ、ニューヨークに展開されていて、3 つすべてが、ローマとミラノにまたがって拡張された仮想(または物理)ND クラスタで実行されている Cisco Nexus Dashboard Orchestrator サービスから管理されています。注目すべき興味深い点は、イタリアに導入された Nexus Dashboard クラスタで実行されている NDO がニューヨークのサイトをリモートで管理できることです。これは、ND ノードとそれが管理する APIC コントローラクラスタとの間で最大 500 ミリ秒 RTT の遅延が許容されているためです。

WAN 経由で相互接続されたデータセンターにまたがって導入された Cisco Nexus Dashboard クラスタ

世界に広がる Cisco ACI ファブリックを管理する場合でも、Orchestrator をホストする Nexus Dashboard ノードを常に同じ地理的リージョン(米国、ヨーロッパ、アジアなど)に導入することをベストプラクティスとしてお勧めします。これは、同じ ND クラスタに属する ND ノード間の通信で許容される遅延は 150 ミリ秒 RTT であるためです。

Cisco Nexus Dashboard の同じクラスタに属するノードが WAN にまたがって導入されている場合、これらの間に安定したデータプレーン接続が存在する必要があります。Cisco Nexus Dashboard クラスタのノードは TCP 接続を介して相互に通信するため、WAN でドロップが発生すると、ドロップされたパケットが再送信されます。ND クラスタの各ノードには一意の IP アドレスが割り当てられます。ノード間の通信をルーティングできるため、これらの IP アドレスが同じ IP サブネットに属する必要はありません。

Cisco Nexus Dashboard Orchestrator クラスタのノード間の推奨される接続帯域幅は、300 Mbps から 1 Gbps です。この数値は、非常に大規模な構成の追加と削除を頻繁に行った内部ストレステストの結果に基づいています。

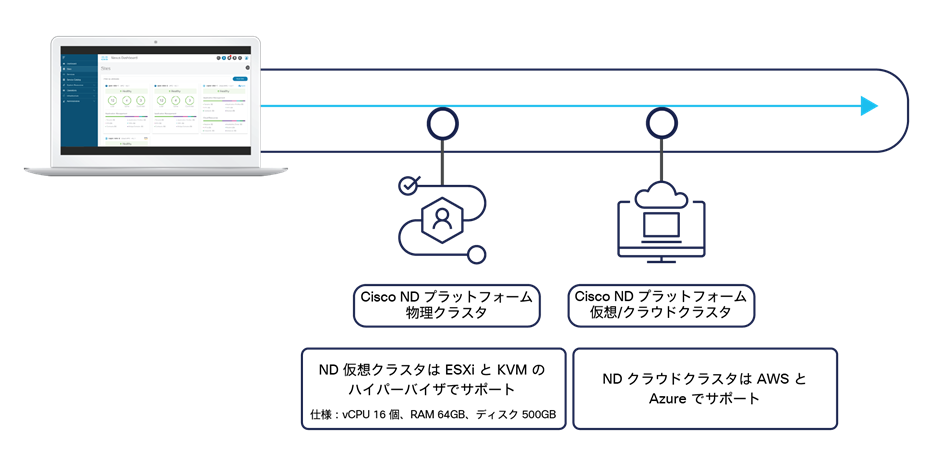

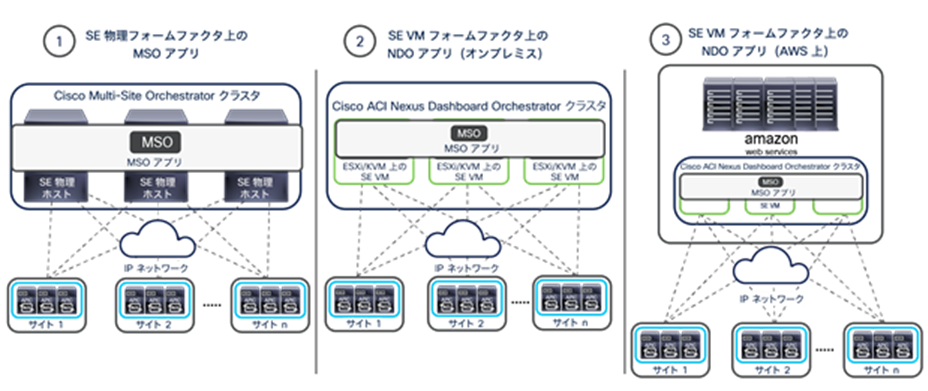

Cisco Nexus Dashboard の導入に関する考慮事項

Orchestrator(NDO)は、Cisco Nexus Dashboard(ND)と呼ばれるコンピューティングリソースのクラスタで実行されるアプリケーションとして導入されます。Nexus Dashboard の最初のリリース 2.0(1) は、3 つの物理 ND コンピューティングノードからなるクラスタのみをサポートしていました。Nexus Dashboard リリース 2.0(2) 以降は、オンプレミスまたはパブリッククラウドに導入する仮想フォームファクタとして使用できます(図 20)。

NDO をサポートする Nexus Dashboard クラスタのフォームファクタ

注: 同じクラスタ内でこれらのフォームファクタを「混在させる」ことはできず、同種の導入モデルのみがサポートされます。言い換えると、すべてが物理ノード、すべてがオンプレミス上で同じハイパーバイザのフレーバに導入された仮想ノード、すべてが同じクラウドサービス プロバイダーのクラウドに導入された仮想ノードのいずれかである必要があります。

付録 B で説明されている以前の MSO 導入モデルと比較すると、Nexus Dashboard で NDO をサービスとして実行する場合、2 つの違いがあります。

● ND ノードと APIC クラスタ間の最大遅延は、500 ミリ秒 RTT に短縮されています(以前 MSO で許容されていた 1 秒 RTT ではありません)。

● ND ノードは、OOB アドレス、IB アドレス、またはその両方を使用して APIC コントローラと通信できます(以前の MSO オプションでは OOB 接続のみがサポートされていました)。

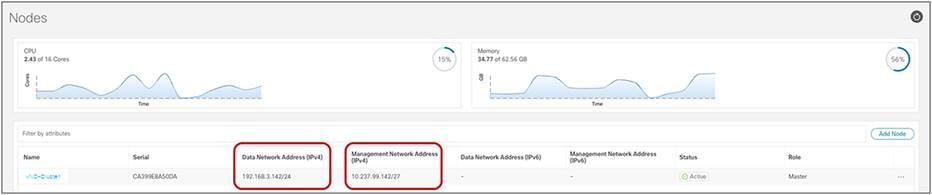

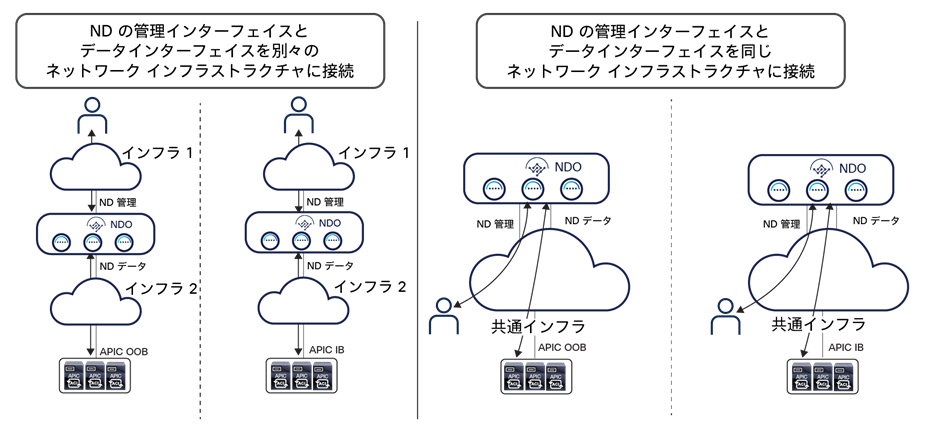

最後の点については、重要な考慮事項があります。Nexus Dashboard の各コンピューティングノードには、フォームファクタにかかわらず、管理インターフェイスとデータインターフェイスの 2 種類のインターフェイスがあります(図 21)。

Nexus Dashboard のコンピューティングノードが持つインターフェイス

注: 上の図は、ラボで使用される単一ノードの仮想 ND クラスタのものです。実際に導入される ND では、同じクラスタに 3 つのノードが属し、それぞれに個別のインターフェイスがあります。

これらのインターフェイスのそれぞれに異なるルーティングテーブルが関連付けられ、ネクストホップデバイスを指すデフォルトルートがそれぞれのテーブルに追加されます。以下のコマンドを使用して、2 つのインターフェイスに関連付けられたルーティングテーブルを表示できます(SSH で Nexus Dashboard ノードに「rescue-user」として接続した後)。

管理インターフェイス(bond1br)

rescue-user@vND-Cluster:~$ ip route show

default via 10.237.99.129 dev bond1br

10.237.99.128/27 dev bond1br proto kernel scope link src 10.237.99.142

100.80.0.0/16 dev bond0br scope link

169.254.0.0/25 dev k8br1 proto kernel scope link src 169.254.0.44

169.254.0.0/16 dev bond0br scope link metric 1006

169.254.0.0/16 dev bond1br scope link metric 1009

172.17.0.0/16 dev k8br0 proto kernel scope link src 172.17.222.0

192.168.3.0/24 dev bond0br proto kernel scope link src 192.168.3.142

データインターフェイス(bond0br)

rescue-user@vND-Cluster:~$ ip route show table 100

default via 192.168.3.150 dev bond0br

10.237.99.128/27 dev bond1br scope link

172.17.0.0/16 dev k8br0 scope link

192.168.3.0/24 dev bond0br scope link

各 ND クラスタノードをネットワーク インフラストラクチャに接続する方法を決定するには、ND で実行されるさまざまな機能とサービスが、(デフォルトで)到達可能性情報を活用するように設計されていることを必ず理解する必要があります。この情報は、さまざまな外部のサービスと通信するために記述された 2 つのルーティングテーブルのいずれかに含まれています。ND がこのように実装されていることから、以下を考慮する必要があります。

たとえば、ND が NTP サーバーまたはプロキシサーバーに接続しようとする場合、その接続先に到達するためのルックアップは第 1 のルーティングテーブルで実行されます。一方、APIC の OOB または IB の IP アドレスを指定することによって、ND で APIC コントローラのオンボーディングを実行しようとする場合、その接続先に到達するためのルックアップは第 2 のルーティングテーブルで実行されます。

● ND 管理インターフェイスは、ND クラスタの管理のみに用いられます。これは、このインターフェイスに関連付けられたルーティングテーブルが ND によって NTP サーバーと DC プロキシサーバー、Cisco Intersight クラスタ、DNS サーバーに接続するために用いられるからです。ND は、この接続を用いて ND(および ND アプリ)への UI アクセスを提供し、ND とそこで実行されているアプリケーションに対してファームウェアのアップグレードを実施します。上記のすべてのサービスが ND 管理インターフェイスに割り当てられたものとは異なる IP サブネットに導入されている場合、そのルーティングテーブルで定義されたデフォルトルートを用いて、それらすべてのサービスと通信します(上記の例では、ネクストホップのデバイス 10.237.99.129 を指しています)。

● ND データインターフェイスは、ND クラスタ(ノード間通信)を稼働させるために使用されます。また、ND で実行されている特定のサービス(NDO、NDI、NDFC など)によって、コントローラおよびスイッチと通信するために使用されます。コントローラとスイッチが ND データインターフェイスに割り当てられたものとは異なる IP サブネットに属している場合、ND データインターフェイスのルーティングテーブルで定義されたデフォルトルートを用いて、それらのデバイスと通信します(上記の例では、ネクストホップのデバイス 192.168.3.150 を指しています)。

● 上記のデフォルトの動作は、ND 管理インターフェイスまたは ND データインターフェイスに、ND が通信する必要のある外部のサービスおよびデバイスと同じ IP サブネットを割り当てることによって変更できます。たとえば、ND 管理インターフェイスが APIC コントローラと同じ IP サブネットに導入されている場合、上の例に示す第 2 のルーティングテーブルにエントリ 10.237.99.128/27 が関連付けられているため、APIC との接続には必ず管理インターフェイスが使用されます。または、特定の ND インターフェイスに関連付けられたスタティックルートを追加することにより、そのインターフェイスの使用を強制することもできます。たとえば、APIC が IP サブネット 192.168.1.0/24 に属している場合、そのスタティックルートを ND 管理インターフェイスに関連付けると、エントリ 192.168.1.0/24 が第 2 のルーティングテーブルにインストールされ、これが ND 管理インターフェイスを指します。

● 上記の箇条書きで説明したように、接続に関して ND プラットフォームには大きな柔軟性がありますが、ND コンピューティングクラスタで NDO を実行する場合のベストプラクティスの推奨事項は以下のとおりです。

◦ ND クラスタで NDO サービスのみを実行している場合は、ND の管理インターフェイスとデータインターフェイスの両方を同じ IP サブネットに割り当てることができます。しかし、同じクラスタで追加のサービス(NDI など)を有効化した際に問題が発生する可能性があるため、これら 2 つのインターフェイスは異なる IP サブネットに割り当てることを強くお勧めします。

◦ また、上記の最初の 2 点で説明した特定のデフォルト通信に 2 つの ND インターフェイスを使い分けるデフォルトの動作を維持することを強くお勧めします。これは、ND の管理インターフェイスとデータインターフェイスを ND が接続する必要のある外部エンティティが使用する IP サブネットとは異なる IP サブネットに割り当てることを意味します。このようにすることで、各ルーティングテーブル(および関連付けられたインターフェイス)のデフォルトルートが、必要な通信に応じて使い分けられます。

◦ 同じ ND クラスタに属するノードの ND 管理インターフェイスを同じ IP サブネットに割り当てることも、異なる IP サブネットに割り当てることもできます。前者は通常、ND クラスタが同じ DC のロケーションに導入されている場合で、後者は ND クラスタが異なる DC のロケーションにまたがって拡張されている場合です。ND クラスタノードの ND データインターフェイスについても同じことが言えます。

図 22 は、NDO が実行されている Nexus Dashboard クラスタの一般的な導入シナリオをいくつか示しています。

Nexus Dashboard のコンピューティングノードが持つインターフェイス

左側の 2 つのシナリオでは、ND の管理インターフェイスとデータインターフェイスが、別々のネットワーク インフラストラクチャに接続されています。これにより、上記で説明した特定の接続に関する各インターフェイスの役割分担が明確になります。

逆に、右側の 2 つのユースケースでは、共通のネットワーク インフラストラクチャを使用して、ND の管理インターフェイスとデータインターフェイスの両方を接続しています。このようなシナリオでは、ネットワーク インフラストラクチャの中で異なる VRF を使用して、さまざまなタイプの必要な通信を分離し続けるのが非常に一般的と思われます。

注: Nexus Dashboard クラスタで NDO のみを実行する場合、図 22 に示すユースケースすべてで、APIC アウトオブバンド(OOB)インターフェイス、インバンド(IB)インターフェイス、またはその両方との接続を制約なく確立することができます。サイトの Nexus Dashboard でのオンボーディング(たとえば、その ACI ファブリックを管理する APIC のオンボーディング)は、いずれかの APIC ノードの IP アドレスから 1 つ(OOB または IB)を指定することで実行できます。ND が、指定されたアドレスに接続できれば(前述のベストプラクティスの推奨事項に従う場合、データインターフェイスを使用)、同じクラスタに属する他の APIC ノードすべての IP アドレスも自動的に検出されます。

Cisco Nexus Dashboard と、そのアプリケーションをホストする機能の詳細は、以下のリンクにあるドキュメントを参照してください。

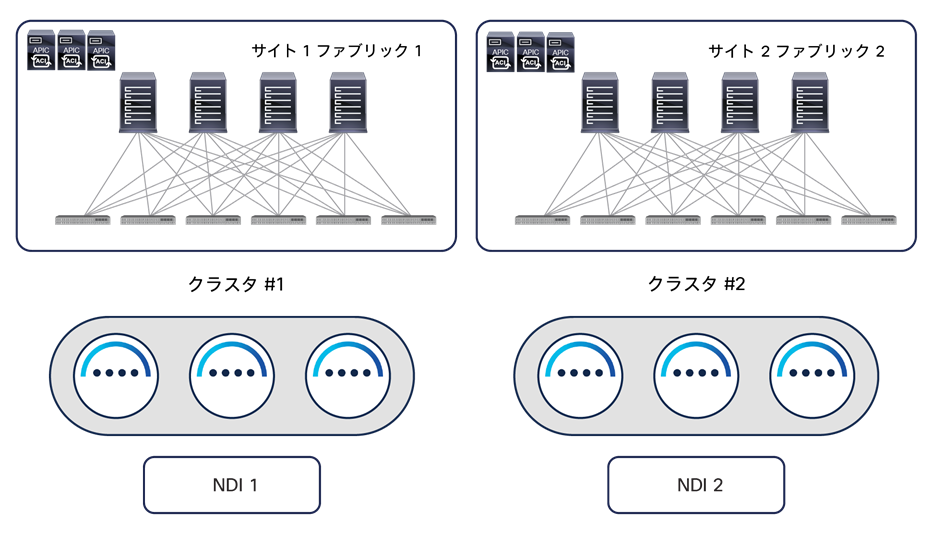

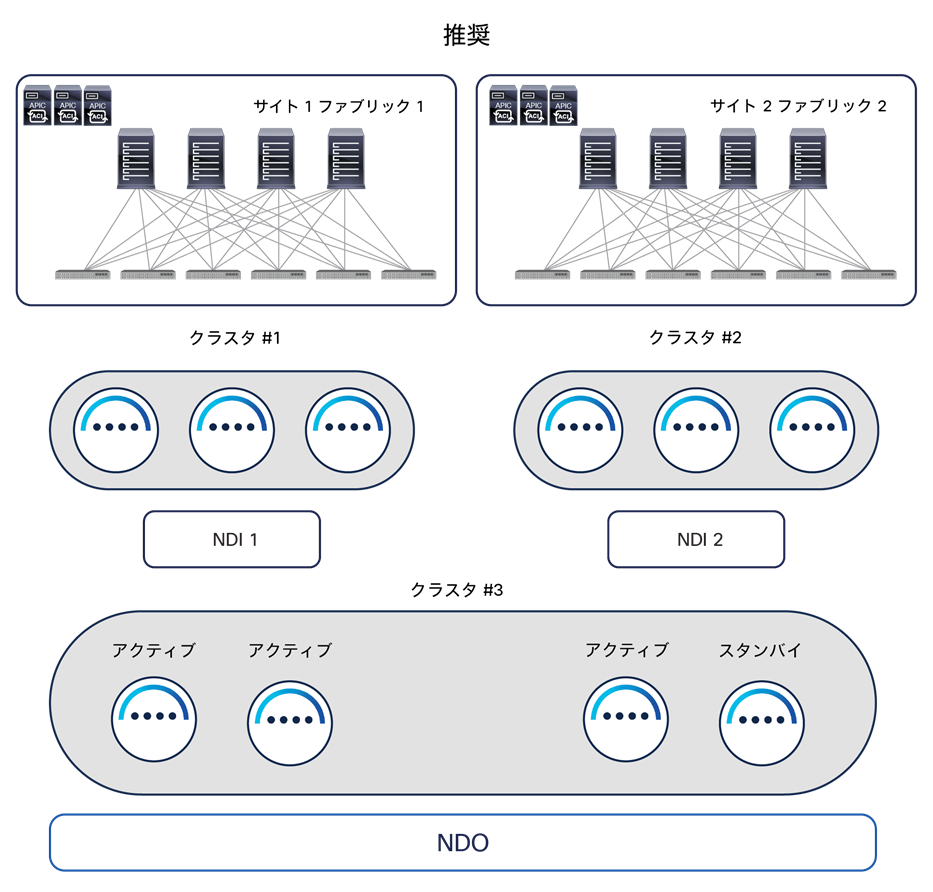

Nexus Dashboard の物理的なコンピューティングクラスタは複数のアプリケーションとサービスをホストできますが、現時点では、単一の NDO インスタンスに関連付けられたサービスを別々の Nexus Dashboard クラスタにインストールすることはできません。同じ Nexus Dashboard クラスタのノードにまたがってインストールすることだけが可能です。Nexus Dashboard Insights(NDI)と Nexus Dashboard Orchestrator の両方のサービスを活用しようと考えた場合、この制約は興味深い留意点です。NDI の導入にかかわる考慮事項はこのホワイトペーパーの範囲外ですが、NDI をホストする ND クラスタを地理的に離れた場所に分散させないようにすることが、常に基本的な原則となります(主に NDI のテレメトリデータの取り込みに関する要件のため)。そのため、たとえば、2 サイトに導入するシナリオの場合、NDI をホストする別の物理 ND クラスタをそれぞれの DC のロケーションに導入する必要があります(図 23)。

地理的に分散したデータセンターにおける NDI の一般的な導入方法

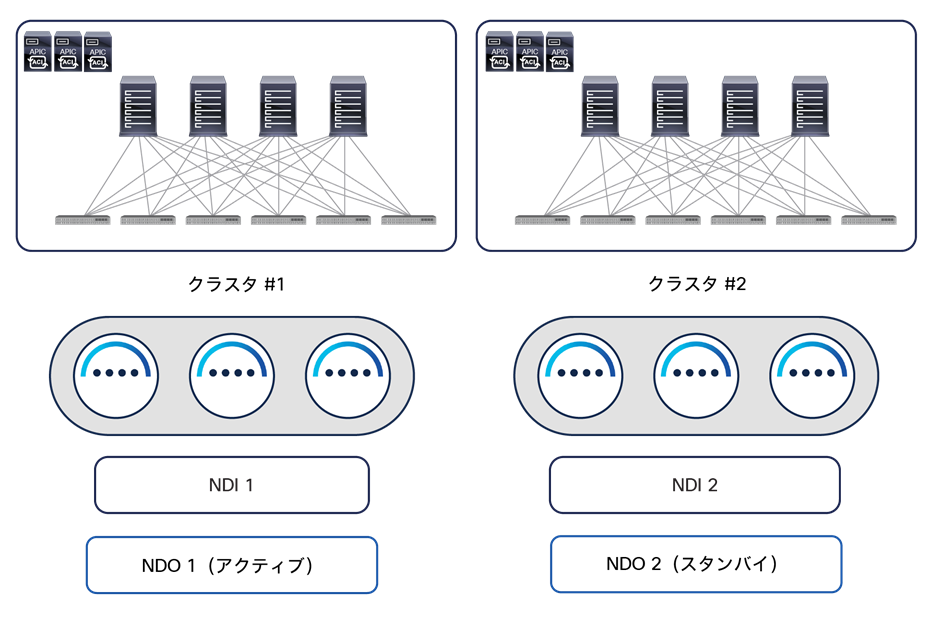

このようなシナリオで NDO も導入する必要がある場合、現状では、単一の NDO インスタンスを異なる ND コンピューティングクラスタに導入できないため、NDO の他の導入オプションがいくつか考えられます。

1. DC の複数のロケーションに分散できる専用の仮想 ND(vND)クラスタに Orchestrator サービスを導入します。図 24 に示すように、この導入の推奨モデルでは、オンプレミスでホストされ異なるサイトに導入された 3 つの仮想マシン(ND プライマリノード)を使用して、NDO 専用の vND クラスタを構築できます。4 つ目の仮想 ND プライマリノードをスタンバイとして導入すれば、障害が発生したアクティブなプライマリノードを代替できます。

地理的に分散したデータセンターに推奨される NDO と NDI の導入オプション

専用の仮想 ND クラスタで Orchestrator サービスを実行する主な優位性は以下のとおりです。

● 最も柔軟性の高い導入オプションです。Orchestrator サービスをホストする vND ノードは、遅延が最大 150 ミリ秒 RTT までであれば地理的に分散できます。地理的に分散したファブリックが同じマルチサイトドメインに属しているシナリオでは、このオプションが理想的です。これらの分散したデータセンターのロケーションに vND ノードを導入できるためです(同時に複数の vND ノードが失われる可能性が低くなります)。図 24 に示すシナリオでは、DC1 の機能が完全に失われた場合、DC2 の vND スタンバイノードをアクティブに昇格させ、この vND クラスタをマジョリティの状態にします。これによって、機能しているデータセンターへのポリシーのプロビジョニングが可能になります。

● このシナリオでは、APIC クラスタとの通信方法を選択できます。これは、vND ノードと APIC の間で Orchestration サービスに必要な通信チャネルとして、IB、OOB、または両方が利用できるためです(他のサービスが ND クラスタでともにホストされている場合は、できない可能性があります)。

● サイトの数とサイトあたりのリーフノードの数(サポートされる最大値あり)に関係なく、わずか 3 つの vND プライマリノードで実行できます。他のサービスをホストする ND クラスタでは、サイトやリーフの拡張性要件によって、追加の「ワーカー」ノードの導入が必要になる場合があります。サービスのさまざまな組み合わせをサポートするために必要な ND リソースの詳細は、https://www.cisco.com/c/dam/en/us/td/docs/dcn/tools/nd-sizing/index.html にある Nexus Dashboard Capacity Planning ツールを参照してください。

● vND クラスタは AWS や Azure のパブリッククラウドで直接ホストすることが可能で、そのうえで Orchestrator サービスを実行できます。

2. 図 25 に示すように、各データセンターに導入され NDI インスタンスをホストしている 2 つの ND クラスタに、2 つの別々の NDO インスタンスをインストールします。

地理的に分散したデータセンターに適用できる NDO と NDI の他の導入オプション

1 つ目の NDO インスタンスが「アクティブ」として実行され、マルチサイトドメインに属するすべてのファブリック(上図の例では、DC1 と DC2 の 2 つのファブリック)を管理します。2 つ目の NDO インスタンスはインストールされていますが、「アクティブ」としては使用されていません(一種の「スタンバイ」モード)。NDO 構成の定期的なバックアップを NDO のアクティブインスタンスで取得し、安全なリモートロケーションに保存できます。DC1 で大規模な災害が発生し、ローカルリソース(ND クラスタを含む)が失われた場合、DR 手順の 1 つのステップとして、DC2 で実行されている 2 つ目の NDO インスタンスに利用可能な最新のバックアップをインポートし、その構成にロールバックできます。その時点で、2 つ目の NDO インスタンスは実質的に「アクティブ」になり、これを用いて、マルチサイトドメインに属する残りすべてのファブリックの管理を開始できます。

注: アクティブな NDO インスタンスから頻繁にバックアップを取得すると、ディザスタリカバリのシナリオでの目標復旧時点(RPO)を最短にすることができます。

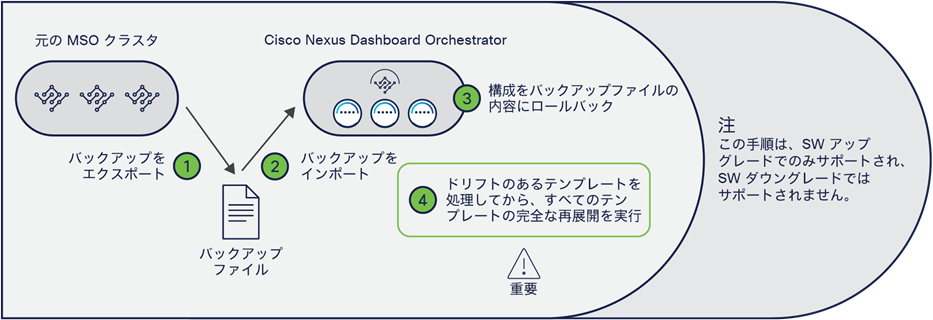

さらに、利用可能な NDO ソフトウェアの最新バージョンを常に導入することを強くお勧めします。異なる NDO ソフトウェアリリース間のアップグレードは非常に簡単なプロセスであり、Nexus Dashboard UI から直接処理できます。VM ベースまたは CASE ベースで導入された MSO クラスタと NDO の間の移行手順に関しては、異なる考慮事項があります。このケースでは、図 26 に示す手順を実行できます。

MSO と NDO の間でアップグレードや移行を行う手順

注: 以下で説明する手順は、3.x NDO リリースへの移行に適用されます。NDO 4.0(1) への移行手順には、異なる考慮事項があります。詳細は、https://www.cisco.com/c/ja_jp/td/docs/dcn/ndo/4x/deployment/cisco-nexus-dashboard-orchestrator-deployment-guide-401/ndo-deploy-migrate-40x.html にあるドキュメントを参照してください。

● NDO アプリケーションを新しい ND クラスタにインストールします。この時点で、または以下の手順の後に、このクラスタをネットワークに接続できます。このとき、古い MSO クラスタを切断します(新旧クラスタで同じ IP アドレスを使用したい場合は、これが必要な可能性があります)。

● 古い VM ベースの MSO クラスタで構成ファイルのバックアップを作成し、そのファイルを簡単に見つけられる場所にダウンロードします。

● 古い VM ベースの MSO クラスタをシャットダウン(または単に切断)します。

● このファイルを ND クラスタで実行されている新しい NDO アプリケーションにインポートします(最初のステップでネットワークに接続していない場合は、接続してから実行します)。

● ND クラスタで実行されている新しい NDO アプリケーションの構成を、先ほどインポートした構成ファイルに含まれている構成にロールバックします。これにより、NDO インフラストラクチャの構成とテナント固有のポリシーの両方が新しいクラスタにインポートされます。

注: ACI サイトのオンボーディングは Nexus Dashboard で直接管理されるため、NDO の構成を正常にロールバックできるようにするためには、ND にオンボーディングされた ACI ファブリックに割り当てられた名前を、元々 MSO クラスタにオンボーディングされていた ACI ファブリックの名前と確実に一致させる必要があります。

● 構成のロールバックが完了すると、一部のテンプレートにドリフトが発生する場合があります。ドリフトとは、1 つ(または複数)のオブジェクトの APIC 構成と NDO 構成の間に不一致があることを意味します。管理できる ACI オブジェクト(またはオブジェクトのプロパティ)が異なる、2 つの Orchestrator リリース間で構成をロールバックした後、ドリフトが発生することがあります。これは、たとえば、MSO 2.2 から NDO 3.7 に移行する場合に当てはまります。NDO 3.7 は MSO 2.2 よりも多くのオブジェクトを管理できるためです。そのため、ロールバックが完了すると、これまで MSO 2.2 によって管理されていなかったオブジェクトすべてに、NDO 3.7 がデフォルト値を割り当てます。マルチサイトドメインに属するファブリックを管理する APIC でそれらのオブジェクトが持つ実際の値と、割り当てられたデフォルト値が異なることがあります。MSO 2.2 がオブジェクトを管理できなかったために、そのオブジェクトの値を APIC 上で直接変更した場合などに、このような差異が生じます。このようなドリフトは、NDO ソフトウェアリリース 3.4(1) 以降に導入されたドリフト調整ワークフローを利用して解決できます。詳細は、「NDO の運用面での機能強化」セクションを参照してください。

● 3.8(1) より前の NDO リリースに移行する場合は、すべてのドリフトを解決した後に、もう 1 つ手順を実行する必要があります。この手順では、定義されたすべてのアプリケーション テンプレートを再展開します。これは、すべてのテンプレートの構成情報が NDO データベースに正しく保存されるようにするために必要な手順です(このデータベースの、NDO で実装されたフォーマットが、MSO で使われたフォーマットから更新されているため)。NDO リリース 3.8(1) 以降、この「再展開」は移行手順の一部として自動的に処理されます。したがって、ロールバック後に対処する必要があるのは、構成のドリフトがあった場合にこれを解決することだけです。

注: この MSO から NDO への移行手順に関する詳細は、https://www.cisco.com/c/ja_jp/td/docs/dcn/ndo/3x/deployment/cisco-nexus-dashboard-orchestrator-deployment-guide-371/ndo-deploy-migrate-37x.html にあるドキュメントを参照してください。

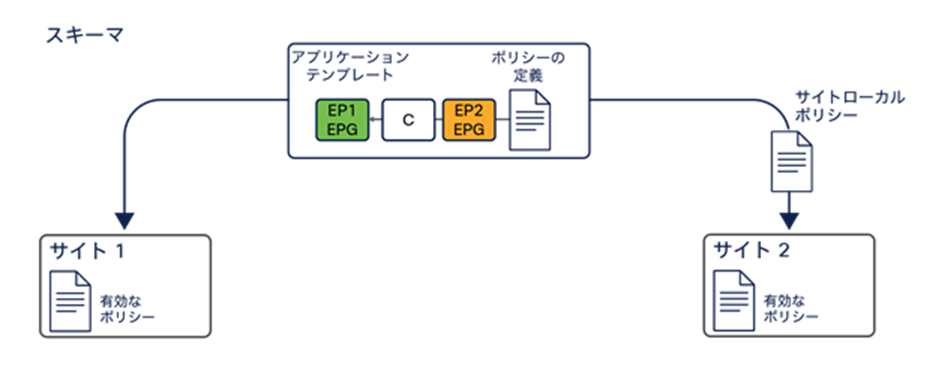

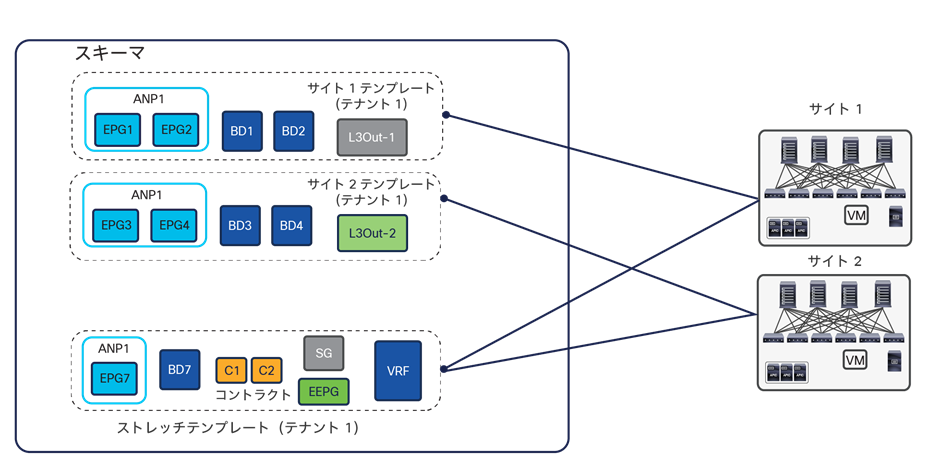

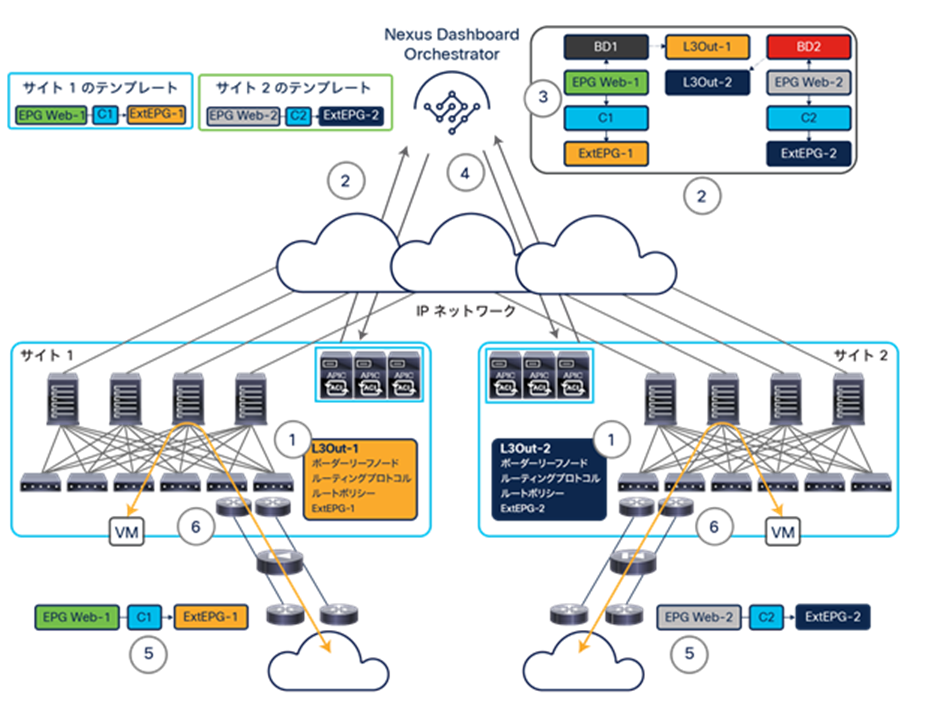

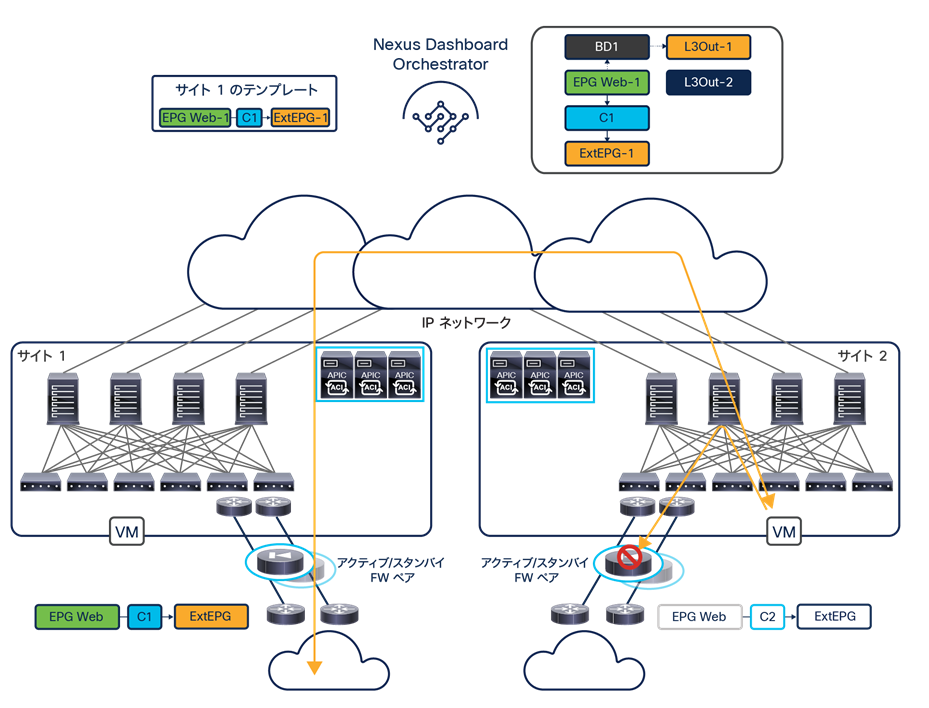

マルチサイトのアプリケーション テンプレート

テナント固有のポリシー(EPG、BD、VRF、コントラクトなど)は、NDO において 1 つのアプリケーション テンプレートの中に作成されます。これは、それぞれのテンプレートが常に 1 つの(唯一の)テナントに関連付けられているためです。複数のアプリケーション テンプレートをスキーマに入れてグループ化することができます。スキーマは、基本的にアプリケーション テンプレートのコンテナになります。

スキーマは、特定のテナントに直接関連付けられることはありません。それでも、特定のテナントに関連付けられたすべてのアプリケーション テンプレートをスキーマに入れてグループ化することは、展開オプションとして非常に一般的であり、ベストプラクティスでもあります。このグループ化の目的は、NDO GUI からテナントポリシーの可視化と変更を容易に行えるようにすることです。

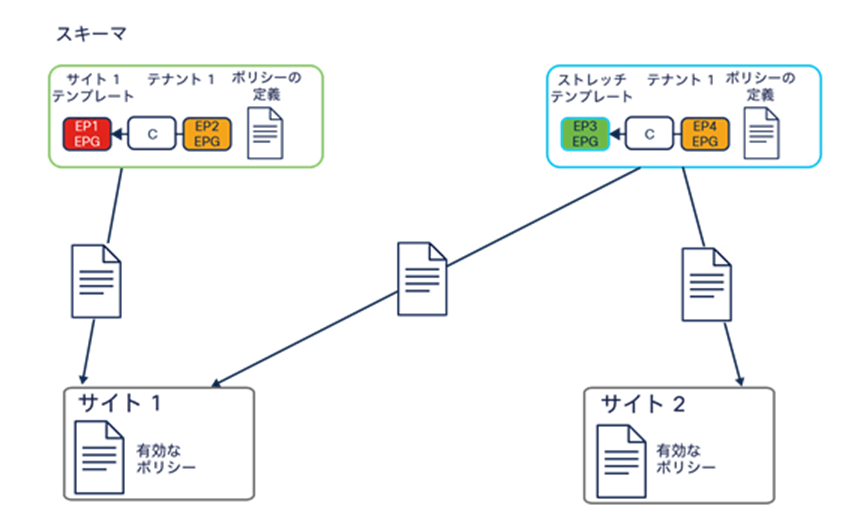

次に、定義された各アプリケーション テンプレートを、同じマルチサイトドメインに属する 1 つ(または複数)のサイトにマッピングする必要があります。

アプリケーション テンプレートの ACI サイトへのマッピング

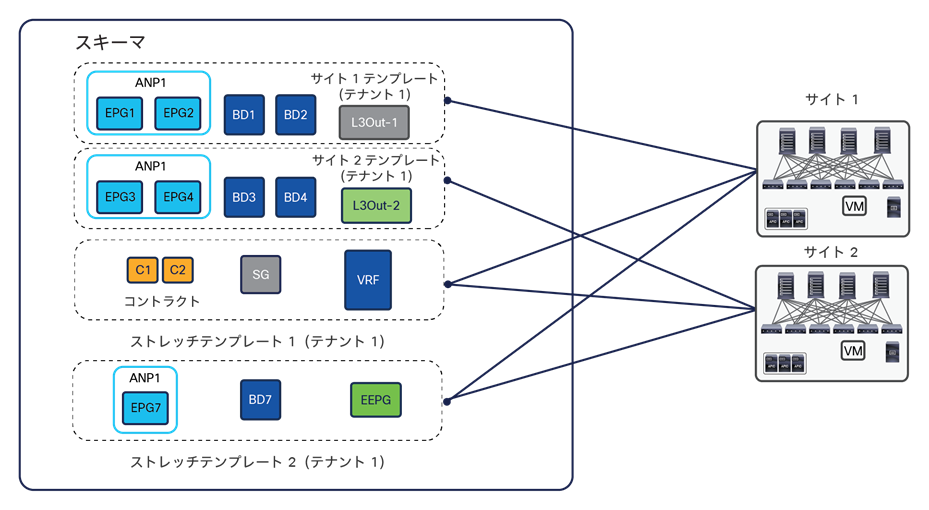

図 27 では、アプリケーション テンプレートを 2 つ作成し、同じ Tenant-1 に関連付けています。

● 「サイト 1 テンプレート」は ACI サイト 1 にマッピングされています。これによって、このアプリケーション テンプレートで作成されたすべてのテナントポリシーが、この ACI ファブリックを管理する APIC クラスタにのみプッシュされ、展開(「レンダリング」)できるようになります。

● 「ストレッチテンプレート」は ACI サイト 1 と 2 の両方にマッピングされています。これによって、テンプレートで定義されたすべてのテナントポリシーが両方のサイトに展開され、「ストレッチ」オブジェクト(複数のサイトでレンダリングされるオブジェクト)が作成されます。たとえば、BD をサイトにまたがって拡張できるようにするには、ストレッチ アプリケーション テンプレートを使用する必要があります(「ACI マルチサイトのユースケース」で説明します)。

現在の NDO の実装では、アプリケーション テンプレートがポリシー変更の最小単位になります。つまり、そのテンプレートに適用されたすべての変更が、テンプレートにマッピングされたすべてのサイトに常にただちにプッシュされます。特定のサイトにのみマッピングされたアプリケーション テンプレートを変更した場合、その変更はそのサイトにのみプッシュされます。

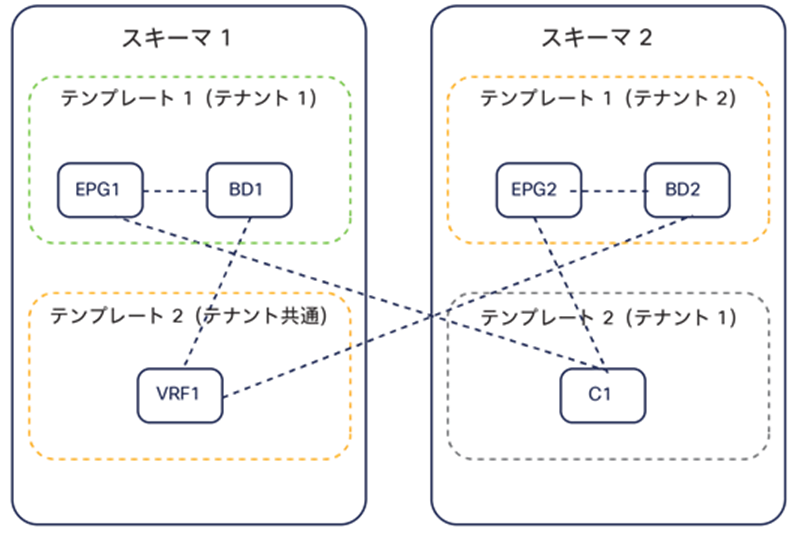

ポリシーオブジェクトは、アプリケーション テンプレートとスキーマで非常に柔軟に編成することができます。ネットワーク固有のオブジェクト(BD、VRF)とポリシー固有のオブジェクト(EPG、コントラクトなど)を別々のアプリケーション テンプレートまたはスキーマに入れると、便利な場合があります。ポリシー固有のオブジェクトはネットワーク固有のオブジェクトよりも頻繁に変更されると想定されるからです。

図 28 は、オブジェクトが、同じアプリケーション テンプレート、同じスキーマに属する他のプリケーション テンプレート、他のスキーマに属するアプリケーション テンプレートのいずれで定義されていても、容易に参照関係を作成できることを示しています。このような参照関係はいずれも、アプリケーション テンプレートが、同じテナントに関連付けられていても、別々のテナントに関連付けられていても作成できます(「共通」テナントにネットワーク固有のオブジェクトを定義する場合が典型例です)。

アプリケーション テンプレート間とスキーマ間でのオブジェクトの参照

技術的には、同じアプリケーション テナントの構成オブジェクトを複数のテンプレートとスキーマに分散させることが可能です。しかし、図 29 に示すように、同じテナントに関連付けられたアプリケーション テンプレートはすべて特定のスキーマ(「テナントスキーマ」)に集約することを強くお勧めします。

NDO 3.x リリースでスキーマ内にアプリケーション テンプレートを定義する場合のベストプラクティス

専用アプリケーション テンプレートとは、マルチサイトドメインの各サイトに 1 対 1 でマッピングされたテンプレートを指します。ストレッチ アプリケーション テンプレートとは、すべてのサイトにマッピングされたテンプレートを指します。VRF とコントラクトは、通常、すべてのサイトで使用できる必要があるため、ストレッチ アプリケーション テンプレートで定義されます。BD や EPG は、ローカルであるか、サイトにまたがって拡張されているかに応じて、サイトの専用アプリケーション テンプレートまたはストレッチ アプリケーション テンプレートで定義されます。

このアプローチに従う場合、スキーマでサポートされるアプリケーション テンプレートの数とオブジェクトの総数の上限について、導入しているソフトウェアリリースの ACI Verified Scalability Guide(VSG)を確認することが重要です。大規模な展開では、各スキーマの検証済みでサポートの対象となる拡張範囲に収めるため、同じテナントに関連付けられたテンプレートを複数のスキーマに分けて展開することが必要になる場合があります。

図 29 に示すアプローチは、NDO 3.x ソフトウェアリリースのベストプラクティスの導入モデルを表しています。リリース 4.0(1) 以降の Nexus Dashboard Orchestrator では、テンプレートの設計と展開の際に、以下のようないくつかのベストプラクティスについて検証が行われ、これに従う必要があります。

● すべてのポリシーオブジェクトは、依存関係に従って正しい順序で展開する必要があります。

たとえば、ブリッジドメイン(BD)を作成するときは、それを VRF に関連付ける必要があります。この場合、BD が VRF に依存するため、VRF を BD より前または一緒にファブリックに展開する必要があります。これらの 2 つのオブジェクトが同じテンプレートで定義されていれば、展開時に Orchestrator が VRF を最初に作成し、ブリッジドメインをそれに関連付けます。しかし、この 2 つのオブジェクトを別々のテンプレートで定義し、BD を定義するテンプレートを先に展開しようとすると、関連する VRF がまだ展開されていないため、Orchestrator が検証エラーを返します。この場合、最初に VRF を定義するテンプレートを展開してから、BD を定義するテンプレートを展開する必要があります。

● すべてのポリシーオブジェクトは、依存関係に従って正しい順序で展開を解除する必要があります。言い換えると、展開された順序と逆の順序で展開を解除する必要があります。

同じ理由で、テンプレートの展開を解除するときは、他のオブジェクトが依存しているオブジェクトの展開を解除することはできません。たとえば、VRF に関連付けられている BD の展開を解除する前に、VRF の展開を解除することはできません。

● 複数のテンプレートの間で循環的な依存関係を作ることはできません。

ブリッジドメイン BD1 が VRF1 に関連付けられ、EPG1 が BD1 に関連付けられている場合を考えてみます。VRF1 をテンプレート 1 に作成してこのテンプレートを展開し、次に BD1 をテンプレート 2 に作成してこのテンプレートを展開した場合、正しい順序でオブジェクトが展開されるため、検証エラーは発生しません。

しかし、その後 EPG1 をテンプレート 1 に作成しようとすると、2 つのテンプレートの間に循環的な依存関係が作成されるため、EPG が新しく追加されたテンプレート 1 の保存を Orchestrator が許可しません。

このような追加のルールと要件を導入したことによる主な影響は以下の 2 つです。

1. NDO 4.0(1) で直接作成されたグリーンフィールド構成の場合、上の図 29 に示したベストプラクティスの推奨事項が、図 30 に示すようにわずかに変更されています。

NDO 4.x 以降のリリースでスキーマ内にアプリケーション テンプレートを定義する場合のベストプラクティス

主な違いは、NDO 4.0(x) 以降では、ストレッチテンプレートが 2 つ必要になる点です。このようにすると、たとえば、VRF と外部 EPG(その VRF を参照)を 2 つの別々のテンプレートで定義でき、これらのオブジェクト間の循環的な依存関係を回避できます。この場合、以前使っていた単一のストレッチテンプレートを展開しようとすると、エラーが発生します。

2. 以前のリリース 3.x からリリース 4.0(1) 以降にアップグレードするには、既存のすべてのテンプレートを分析し、上で説明した新しい要件を満たさないテンプレートを変換する必要があります。この分析は移行プロセス中に自動的に実行され、新しいベストプラクティスに準拠させるために既存のテンプレートを変更する必要がある場合、必要なすべての変更について詳細なレポートが出力されます。図 29 に示すベストプラクティスの導入モデルから始める場合、システムがオブジェクトを自動的に再編成して、図 30 に示す新しいベストプラクティスの導入モデルを再現します。

注: NDO 3.x リリースから NDO 4.x リリースにアップグレードするために必要な手順の詳細は、https://www.cisco.com/c/ja_jp/td/docs/dcn/ndo/4x/deployment/cisco-nexus-dashboard-orchestrator-deployment-guide-401/ndo-deploy-migrate-40x.html にあるドキュメントを参照してください。

ポリシーオブジェクトを編成する際の柔軟性をさらに高めるために、Cisco Nexus Dashboard Orchestrator では、同じテナントに関連付けられているアプリケーション テンプレートの間(同じスキーマ内またはスキーマ間)で EPG と BD を移行できるようにしています。この機能の一般的なユースケースは、サイト内でローカルに定義されていた EPG/BD ペアのサイトにまたがった拡張やその逆を開始できるようにする場合です。

自律型アプリケーション テンプレート(NDO リリース 4.0(1))

NDO ソフトウェアリリース 4.0(1) では、「自律型テンプレート」と呼ばれる新しいタイプのアプリケーション テンプレートが導入されています。このタイプのアプリケーション テンプレートを使用すると、従来のアプリケーション テンプレート(「マルチサイトテンプレート」という名前に変更)と同じオブジェクト(EPG、BD、VRF など)をプロビジョニングできます。このテンプレートを単一のサイトまたは複数のサイトに関連付けることもできます。ただし、両タイプのアプリケーション テンプレートの基本的な違いは、「自律型テンプレート」を複数のサイトに展開しても、「ストレッチ」オブジェクト(およびそれに関連付けられた変換エントリ)が作成されないことです。変換エントリの使用については、このドキュメントの後のセクションで説明します。

図 31 に示すように、「自律型アプリケーション テンプレート」の展開のユースケースは、互いに独立して展開され運用される(言い換えると、異なる ACI ファブリックのスパインを接続する ISN インフラストラクチャがない)複数のファブリック間で同じ構成を複製する必要がある場合です。

マルチサイトテンプレートと自律型アプリケーション テンプレート

重要なので繰り返しますが、自律型テンプレートを複数のサイトに関連付けると、最終的に「ストレッチオブジェクト」が作成されるのではなく、単に同じ名前が付いた独立したオブジェクトが作成されます。たとえば、サイト 1 とサイト 2 に関連付けられた自律型アプリケーション テンプレートで VRF1 を定義した場合、両方の APIC ドメインで同じ VRF1 という名のオブジェクトが作成されます。ただし、機能の点では、L3Out データパスを介してのみ相互接続できる 2 つの完全に独立した VRF です。同じ名前で作成される EPG についても同様です。

これらのことを考慮すると、マルチサイトテンプレートと自律型アプリケーション テンプレートの展開にあたっては、具体的なガイドラインに従うことが重要です。

● マルチサイトテンプレートは、「マルチサイトが有効になっている」複数のサイトにのみ関連付ける必要があります。「マルチサイトが有効になっている」とは、各サイトに関連付けられた「マルチサイト」ノブがオンになっているだけでなく、各サイトのインフラストラクチャ構成が完全にプロビジョニングされ、サイト間ネットワーク(ISN)に接続できるようになっていることを意味します。すでに述べたように、マルチサイトテンプレートを展開すると、ストレッチオブジェクトのプロビジョニングが開始されますが、これには ISN を介した VXLAN サイト間通信が必要なためです。

注: NDO リリース 4.0(3) 以降では、Orchestrator がこのガイドラインを適用し、マルチサイトテンプレートが複数の「自律」サイトに関連付けられることを防止します。

● 自律型テンプレートは、マルチサイトが有効になっていて(すなわち、対応する「マルチサイト」フラグがそれらのサイトに対してチェックされていて)ISN を介して相互接続されているサイトにも関連付けることもできます。そのようにしても、サイトにまたがるストレッチオブジェクトが作成されないことを理解することが重要です。

NDO リリース 4.0(1) で導入された新しいテンプレートタイプ

NDO ソフトウェアリリース 4.0(1) 以降、Nexus Dashboard Orchestrator のプロビジョニング機能を拡張するために、新しいテンプレートタイプが導入されました。これらの新しいテンプレートを図 32 に示し、以下で簡単に説明します。

NDO 4.0(1) で導入されたテンプレートタイプ

● テナント ポリシー テンプレート:このテンプレートは、テナントにポリシーをプロビジョニングするためのもので、さまざまな目的に使用することができます。たとえば、テナント ルーテッド マルチキャスト設定に使用されるルートマップ、または SR-MPLS L3Out やカスタム QoS ポリシーなどでアドバタイズされるルートを制御するルートマップが挙げられます。定義されたそれぞれのテナント ポリシー テンプレートは、1 つまたは複数のサイトに関連付けることができます。これば、ポリシーをサイトごとに固有にするか、サイトのグループに共通的に適用するかに依存します。

● ファブリック ポリシー テンプレートとファブリック リソース ポリシー テンプレート:これら 2 種類のテンプレートは、「ファブリック管理」テンプレートの例であり、ファブリック固有のポリシー(インターフェイスとインターフェイスのプロパティ、物理ドメインおよび関連する VLAN プールなど)のプロビジョニングに使用できます。NDO 4.0(1) より前は、このような構成は、APIC レベルごとに個別にプロビジョニングのみする必要がありました。テナント ポリシー テンプレートの場合と同様に、これらのファブリック管理テンプレートは 1 つまたは複数のサイトに関連付けることができます。これば、ポリシーをサイトごとに固有にするか、サイトのグループに共通的に適用するかに依存します。

● モニタリング ポリシー テンプレート:このタイプのテンプレートは、SPAN セッションをプロビジョニングするために使用できます。このセッションは、モニタリング用にトラフィックを複製して外部コレクタに送ります。テナント SPAN とアクセス SPAN の 2 種類の SPAN 設定がサポートされています。

注: これらの新しいテンプレートの構成に関する詳細な説明は、このホワイトペーパーの範囲外です。詳細なプロビジョニング情報は、https://www.cisco.com/c/en/us/td/docs/dcn/ndo/4x/configuration/cisco-nexus-dashboard-orchestrator-configuration-guide-aci-401/ndo-configuration-aci-fabric-management-40x.html にあるドキュメントを参照してください。

NDO の運用面での機能強化

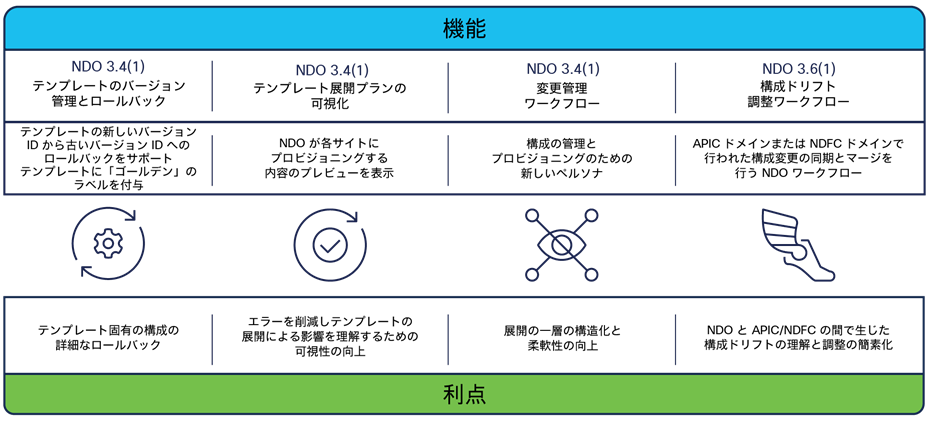

NDO のソフトウェアリリースごとに、Cisco ACI マルチサイトアーキテクチャの運用面での簡素化と改善を目的とするいくつかの重要な機能強化が行われました。図 33 は、これらのテンプレートレベルの拡張機能を示しています。

NDO の運用面での機能強化

注: これらの機能を網羅した具体的な設定情報は、NDO 設定ガイド https://www.cisco.com/c/ja_jp/td/docs/dcn/ndo/3x/configuration/cisco-nexus-dashboard-orchestrator-configuration-guide-aci-371/ndo-configuration-aci-managing-schemas-37x.html?bookSearch=true にあります。

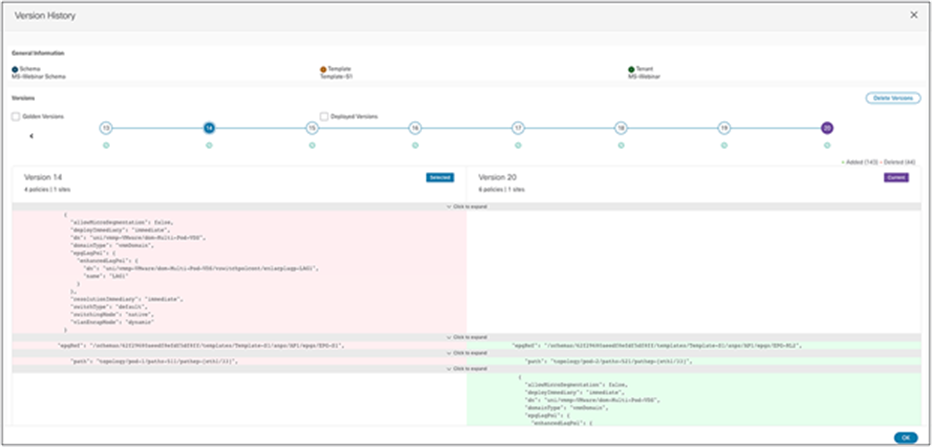

● テンプレートのバージョン管理とロールバック:Orchestrator の以前のリリースでは、構成のバックアップとロールバックはグローバルシステムレベルに限られていました。この機能は非常に便利で、ソフトウェアの最新バージョンでも引き続き使用できますが、より細かいレベルのアプローチが求められていました。NDO からのプロビジョニングの最小単位はテンプレート(タイプによらず)であるため、この要件に応えるためにテンプレートレベルでのバックアップとロールバックの機能が導入されました。

NDO は、テンプレートの異なるバージョンを最大 20 まで追跡できます。また、特定のバージョンを「ゴールデン」として設定し、システムから自動的に削除されないようにすることもできます。古いバージョンのテンプレートを選択して最新のバージョンとの詳細な違いをグラフィック表示し(図 34 を参照)、選択した古いバージョンにテンプレートの構成をいつでもロールバックできます。

テンプレートの改訂履歴

この最新の機能が特に興味深いのは、いわゆる「元に戻す」機能がシステムに組み込まれているためです。テンプレートを展開したタイミングで機能や接続に何らかの問題が発生した場合、正常に動作していたことがわかっている以前の展開に構成を速やかにロールバックできます。

テンプレートのバージョン管理とロールバックの詳細とライブデモについては、https://video.cisco.com/video/6277140235001 を参照してください。

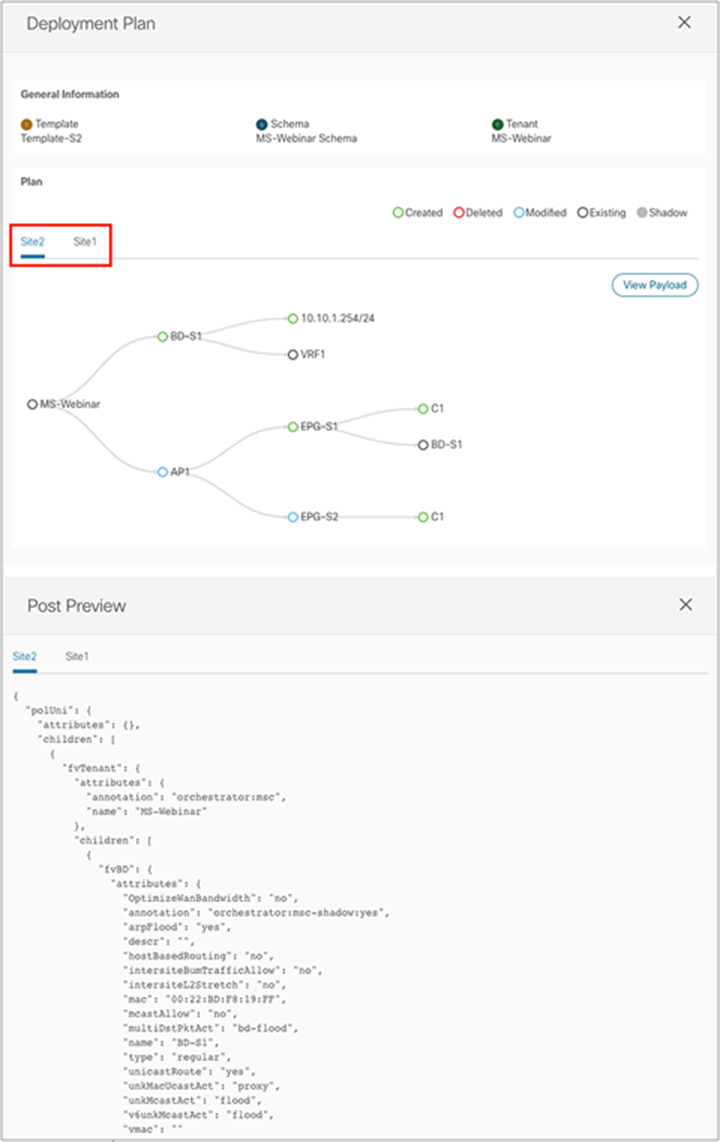

● テンプレート展開プランの可視化:NDO を活用しているお客様が日々直面している主な課題の 1 つは、可視化の向上によって、テンプレートを展開するときに NDO がどの構成をどこ(APIC ドメイン)にプッシュしているかを把握できるようにすることです。テンプレートに作成された構成によっては、展開の際にテンプレートが関連付けられているサイトとは異なるサイトにオブジェクトがプロビジョニングされることが実際にあります。サイト間の VXLAN データパスを有効にするために作成されるシャドウオブジェクトがその一例です(シャドウオブジェクトの使用については、このドキュメントで詳しく後述します)。テンプレート展開プランの可視化が導入された目的は、テンプレートの展開によって、どのような変更がどのサイトに適用されるかをグラフ形式と XML 形式の両方でユーザーに明確に示すことです。これにより、ユーザーは予期しない動作(設定不備、またはシステムのバグによる)を事前に把握することで、テンプレートの展開を中断して機能停止の可能性を防ぐことができます。図 35 は、テンプレート展開プランのグラフと XML による出力を示しています。

テンプレート展開プランのグラフィカルビューと XML ビュー

テンプレート展開プランの可視化に関する詳細とライブデモについては、https://video.cisco.com/video/6277137504001 を参照してください。

● 変更管理ワークフロー:組織によって NDO の運用方法が異なります。ほとんどの場合、テンプレートの構成のプロビジョニングにはさまざまなタイプのユーザーが必要で、それぞれが異なる部分を担当します。そのため、遵守すべき具体的で厳格なルールがないと、変更をシステムに適用することができません。変更管理ワークフローが NDO に導入され、3 つの異なるタイプのユーザーロールを定義することが可能になりました。

◦ 設計者:テンプレートの構成の作成または変更を担当します。

◦ 承認者:設計者によって提案された構成変更を確認し、承認または否認を行います。また、テンプレートの展開に複数の承認者からの承認を必要とすることもできます。承認者がテンプレートの展開を否認した場合、否認の理由を説明するメッセージが設計者に送信されます。

◦ 展開者:テンプレートの展開を担当します。展開者は、テンプレートの展開を拒否し、設計者にメッセージを返すこともできます。このとき、設計者は必要な修正アクションを実行できます。

上記のロールは柔軟に定義でき、要件に応じてさまざまなロールを組み合わせることができます。また、この変更管理ワークフローは NDO に組み込まれていますが、当初から拡張可能な設計になっています。将来的には、外部の変更管理システムと統合できるようになる予定です。

変更管理ワークフローの詳細とライブデモについては、https://video.cisco.com/video/6277140011001 を参照してください。

● 構成ドリフト調整ワークフロー:ACI マルチサイト展開では、常に NDO のみから構成をプロビジョニングすることをお勧めします。一方で、NDO によって APIC にプッシュされる(および APIC によって物理ネットワークデバイスにレンダリングされる)オブジェクトはロックされておらず、変更や削除が APIC から直接行われる可能性があります。

● したがって、ユーザーの意図に対する APIC と NDO の「ビュー」が同期しているかどうかを任意の時点で明確に把握できることが重要です。APIC と NDO でオブジェクトの構成が異なると「ドリフト」が発生します。APIC と NDO の間には通知チャネルがあるため、NDO は 2 つのシステムの「ビュー」を常に比較し、検出されたドリフト状態をユーザーに通知できます。これによって、ユーザーは適切な是正措置を講じることができます。

NDO 構成ドリフト調整ワークフローは、以下のようにしてこの問題を解決します。まず、NDO が管理するオブジェクトに対して APIC で変更が適用された場合(またはその逆)、ユーザーにタイムリーに警告します。次に、グラフィカルで直感的なワークフローを通じて、ユーザーにそのドリフトを調整する選択肢を提供します。ユーザーは APIC にある構成を NDO にインポートするか、APIC の構成を NDO の構成で置き換えることができます。

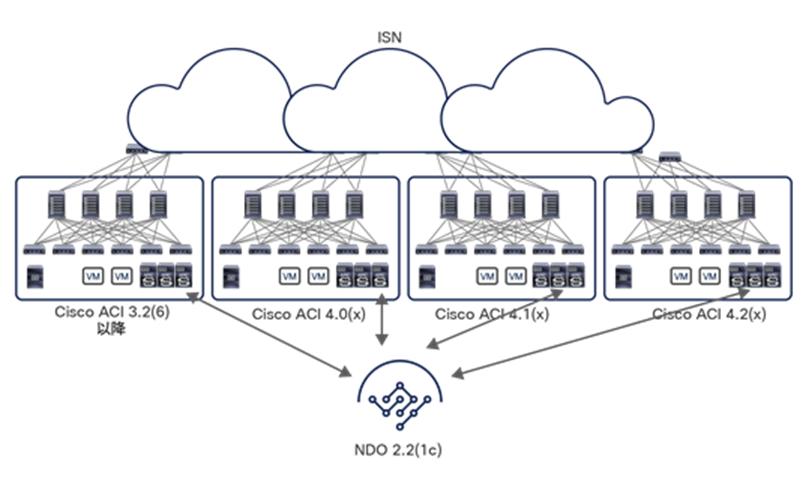

Cisco Multi-Site Orchestrator リリース 2.2(1) 以降、バージョン間サポートが導入され、異なる ACI ソフトウェアリリースを実行している APIC ドメインを MSO が管理できるようになっています(図 36)。

Cisco Multi-Site Orchestrator リリース 2.2(1) 以降のバージョン間サポート

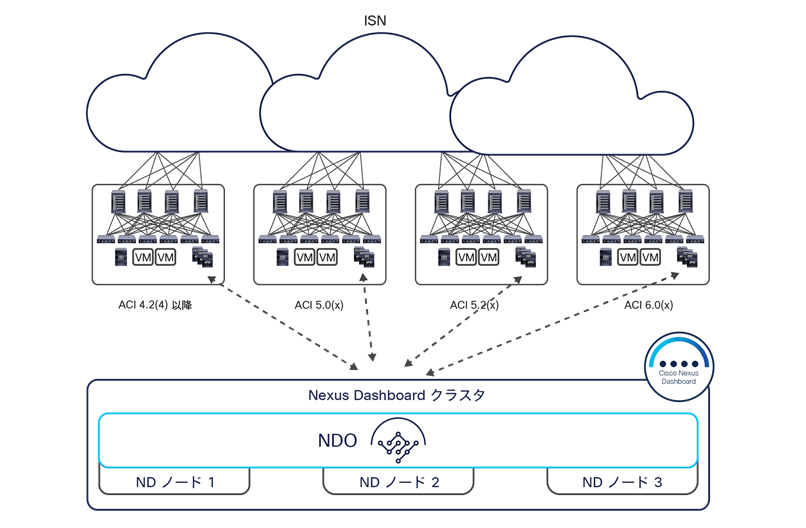

図 37 に示すように、Nexus Dashboard Orchestrator でもすべてのバージョンで同じ機能を使用できます。

Cisco Nexus Dashboard Orchestrator リリースのバージョン間サポート

NDO によって管理されるマルチサイトドメインで利用できる APIC ソフトウェアの最小バージョンは、Cisco ACI リリース 4.2(4) であることに注意してください。これは、Nexus Dashboard のコンピューティング プラットフォームでは、これより古いバージョンを実行しているファブリックのオンボーディングができないことによる制約です。

異なるバージョンにまたがる機能をサポートするために、NDO は接続された APIC ドメインの ACI バージョンを認識する必要があります。そのため、NDO と、NDO によって管理される各 APIC との間を WebSocket で接続し、この情報を取得します。この接続を使用する目的は、APIC がダウンしたときにこれを検出することで、復帰したときに NDO が APIC バージョンを照会できるようにすることです。たとえば、APIC をアップグレードしているときに、これが必要になります。

このようにして、所定のサイトに関連付けられたテンプレート上で構成された機能がそのファブリックで有効にサポートされているかどうかを、NDO が ACI リリースに基づいてチェックできます。下の表 1 では、主な機能とその機能がサポートされる ACI の最小リリースを一覧にしています。

表 1. ACI の機能とその機能がサポートされる APIC の最小バージョン

| 機能 |

APIC の最小バージョン |

| Cisco ACI マルチポッドのサポート |

リリース 4.2(4) |

| サービスグラフ(L4 - L7 のサービス) |

リリース 4.2(4) |

| 外部 EPG |

リリース 4.2(4) |

| Cisco ACI Virtual Edge VMM のサポート |

リリース 4.2(4) |

| DHCP のサポート |

リリース 4.2(4) |

| 整合性チェッカー |

リリース 4.2(4) |

| CloudSec 暗号化 |

リリース 4.2(4) |

| レイヤ 3 マルチキャスト |

リリース 4.2(4) |

| OSPF の MD5 認証 |

リリース 4.2(4) |

| ホストベースのルーティング |

リリース 4.2(4) |

| サイト間 L3Out |

リリース 4.2(4) |

| vzAny |

リリース 4.2(4) |

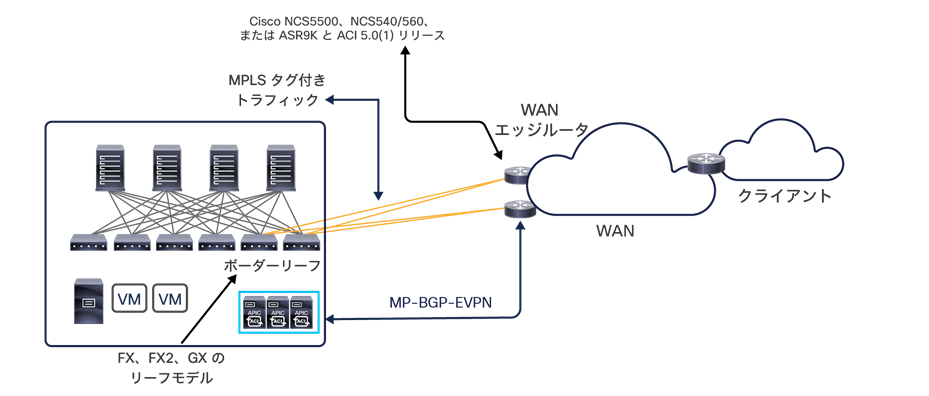

| SR-MPLS ハンドオフ |

リリース 5.0(1) |

NDO では、以下の 2 つの方法で APIC のバージョンがチェックされます。

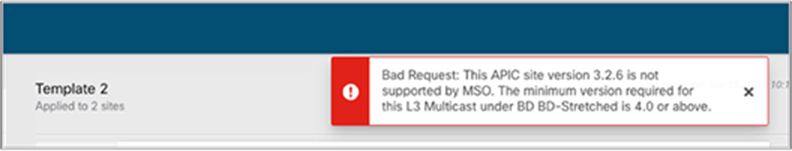

● テンプレートの「保存」操作中:このチェックは、テンプレートの設計者が作成した構成が現在の APIC ソフトウェアリリースでサポートされていないことを早い段階で通知できる点で重要です。

● テンプレートの「展開」操作中:このチェックは、ユーザーが最初にテンプレートを保存せずに展開しようとした場合に必要になります。また、保存操作中のバージョンチェックはすべて通過したものの、実際にそのテンプレートを展開する前に APIC がダウングレードされた場合にも対応できます。

ブリッジドメインでの動作の観点から見た Cisco ACI マルチサイト

Cisco ACI マルチサイトアーキテクチャは、災害回避やディザスタリカバリといったさまざまなビジネス要件を満たすためのものとして位置づけられます。基本的に、それぞれのユースケースごとにブリッジドメインの接続シナリオが異なります。それぞれを以下のセクションで説明します。

注: 各ユースケースでの詳細な構成情報は、以下のリンクにある ACI ファブリック向け Cisco マルチサイト導入ガイドを参照してください。

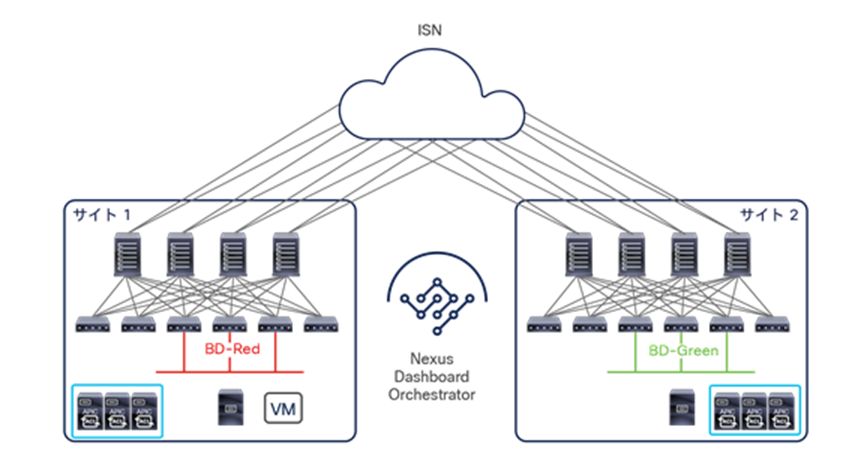

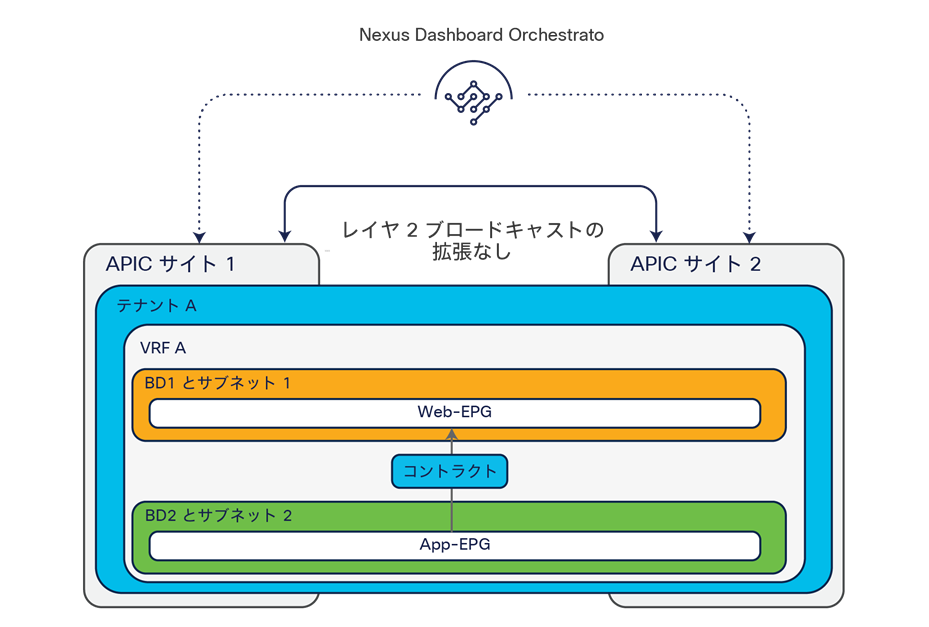

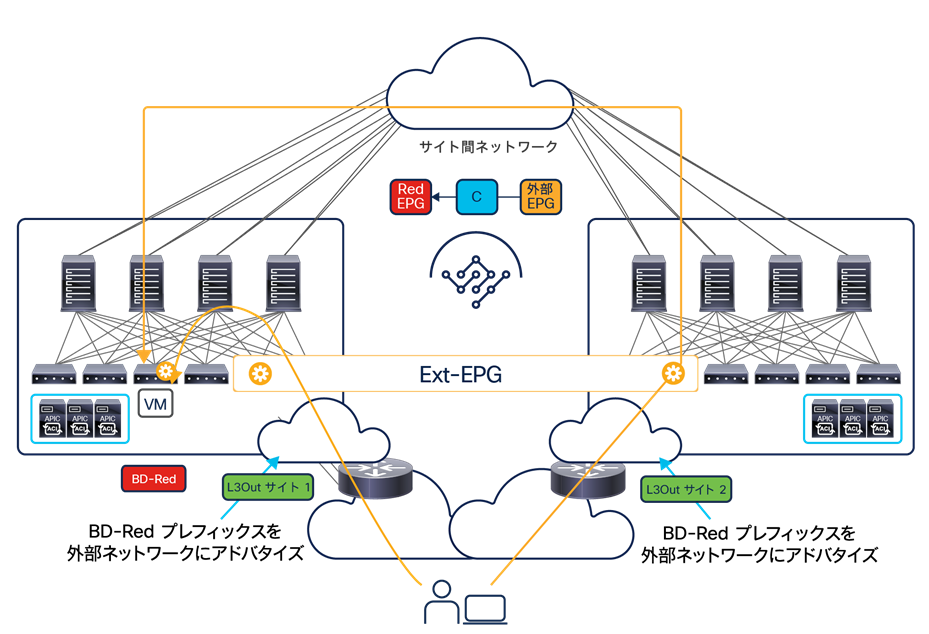

図 40 に示すように、展開シナリオの多くで、サイト間の通信をルーティングされた通信に限定することが基本的要件となっています。

このユースケースでは、レイヤ 2 の拡張やフラッディングは使用できません。また、それぞれのサイトで異なるブリッジドメインと IP サブネットが定義されます。Cisco ACI の原則として、EPG 間の通信は、適切なセキュリティポリシーが両者の間のコントラクトとして適用されない限り、確立されません。ただし、まずは接続することにのみ重点を置くために、ポリシーコンポーネントを削除することは可能です(たとえば、Cisco ACI リリース 4.0(2) 以降利用できる EPG の優先グループ機能、または Cisco Multi-Site Orchestrator リリース 2.2(4) で導入された vzAny の活用)。以下のようにさまざまなタイプのレイヤ 3 接続がサイト間で確立できます。

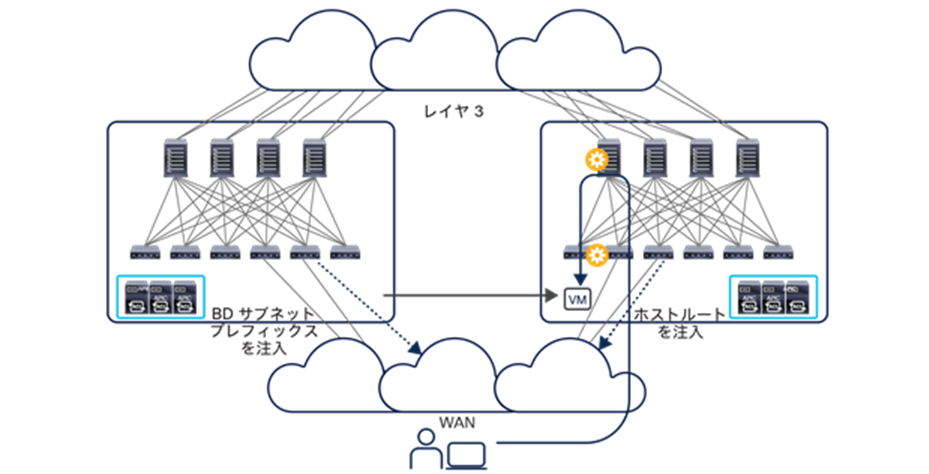

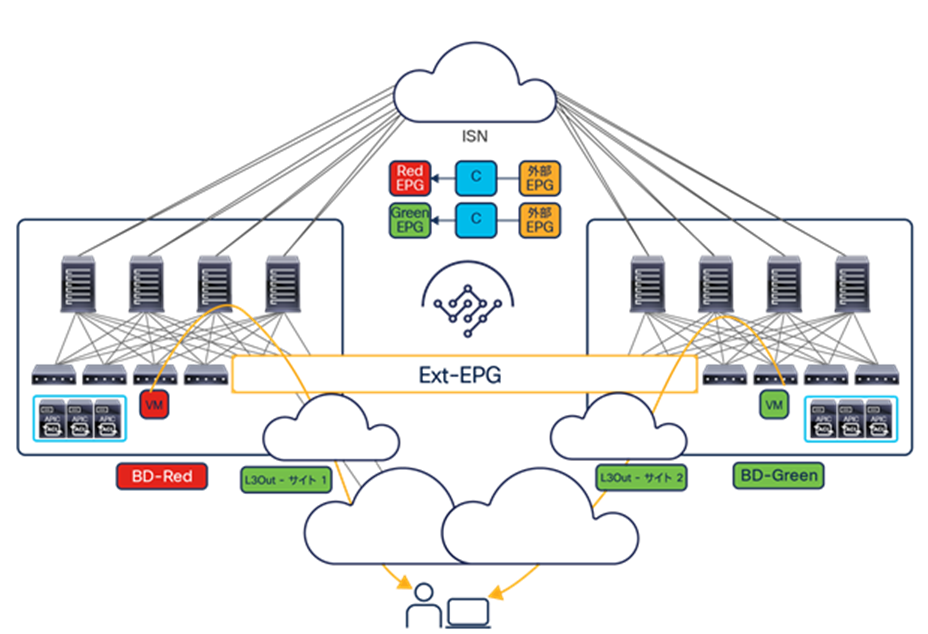

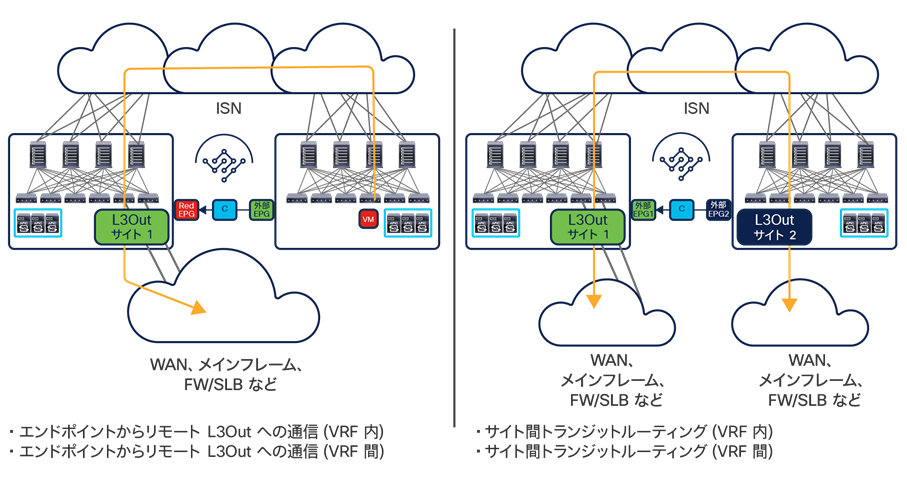

● VRF 内通信:これは、送信元 EPG と宛先 EPG が同じ VRF インスタンス(同じテナント)にマッピングされた異なるブリッジドメインに属している、よくあるケースのシナリオです。テナントと VRF インスタンスはサイト全体に拡張されます。さらに、MP-BGP EVPN を使用してホストルーティング情報が交換されるため、サイト間通信が可能になります(図 41)。

EPG-Red と EPG-Green の間でコントラクトが確立すると、それぞれに対応するシャドウオブジェクトがリモートサイトに作成されます。これが作成されることで、スパインに変換エントリを正しくプログラミングできるようになります。

VRF 内レイヤ 3 通信を使用してサイト間を接続する具体的なユースケースを下の図 42 に示します。

VRF 内レイヤ 3 通信を用いた、拡張された EPG を共有するサイト間接続

このユースケースでは、EPG がサイト間で拡張されていますが、この EPG に関連付けられている BD は、レイヤ 2 ストレッチオブジェクトとして構成されていません。そのため、サイトごとに異なる IP サブネットを BD に割り当てることができます。その結果、この EPG に属するエンドポイント間のサイト間通信がルーティングされます。一方で、EPG 内通信はデフォルトで許可されているため、コントラクトを作成する必要はありません。

注:Orchestrator でこのユースケースを設定するには、サイト 1 とサイト 2 の両方に関連付けられた 1 つのテンプレートで EPG と BD の両方を定義する必要があります。次に、「L2 Stretched」フラグを無効にして BD を構成する必要があります。テンプレートの定義と ACI サイトへの関連付けの詳細は、「NDO のスキーマとテンプレートの展開」セクションを参照してください。

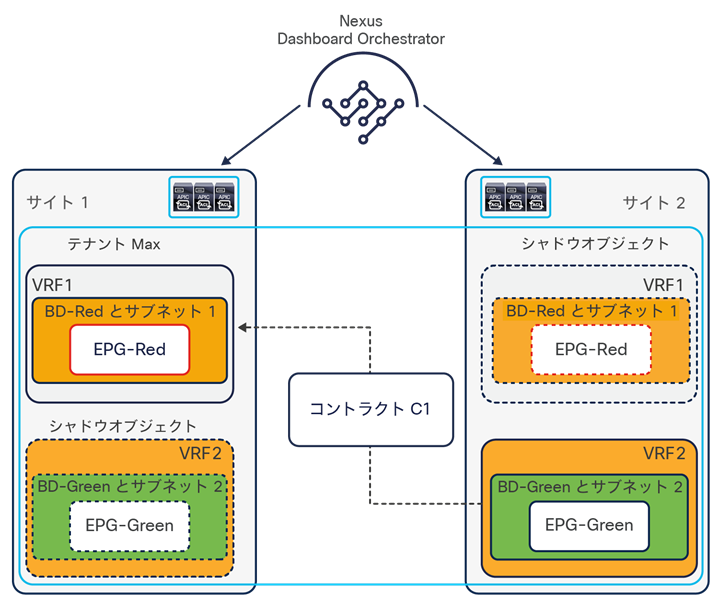

● VRF 間通信:これは、送信元と宛先のブリッジドメインが、異なる VRF インスタンス(同じまたは異なるテナントに属する)に属しているケースのシナリオです。この通信に、必要なルートリーク機能を動作させるには、送信元 EPG と宛先 EPG の間のコントラクトの作成とプロバイダー EPG でのサブネットの構成を行えば十分です。これは、単一サイトを展開するときに APIC で必要になる手順と同一です。図 43 に示すように、EPG 間でコントラクトが確立すると、リモートサイトにシャドウオブジェクトが作成されます。

VRF 間レイヤ 3 通信を用いたサイト間接続

● 共有サービス:上で説明した VRF 間通信のシナリオの一例として、共有サービスが個別の VRF インスタンスまたはテナントで提供され、これにアクセスする必要があるそれぞれの VRF インスタンスまたはテナントに複数の送信元 IP サブネットが設定されるケースがあります(図 44)。多対 1 の接続が必要な典型例ですが、必要なルーティング情報を交換できるようにするには、送信元と宛先の EPG 間で適切なセキュリティポリシーを確立すれば十分です。

注:下の図では、わかりやすくするためにシャドウオブジェクトを省略しています。

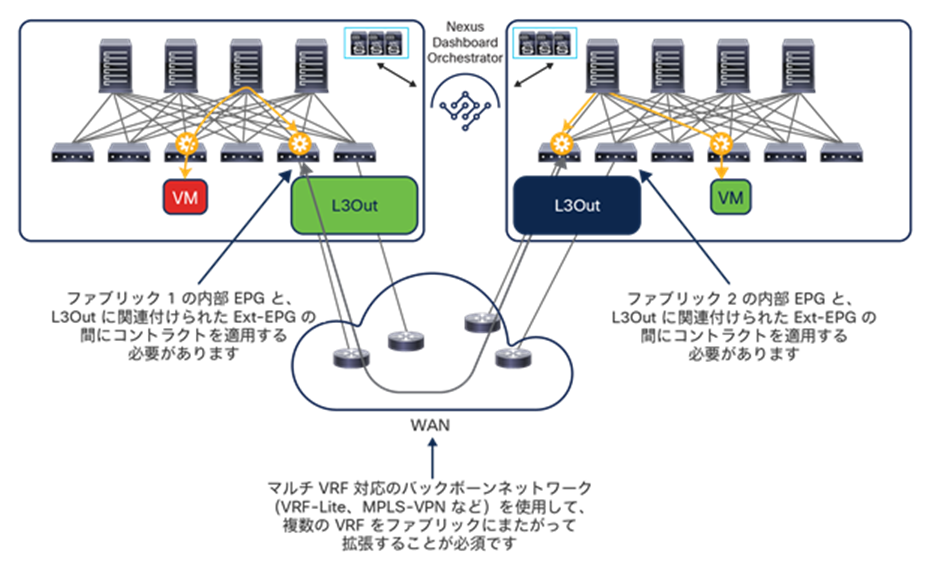

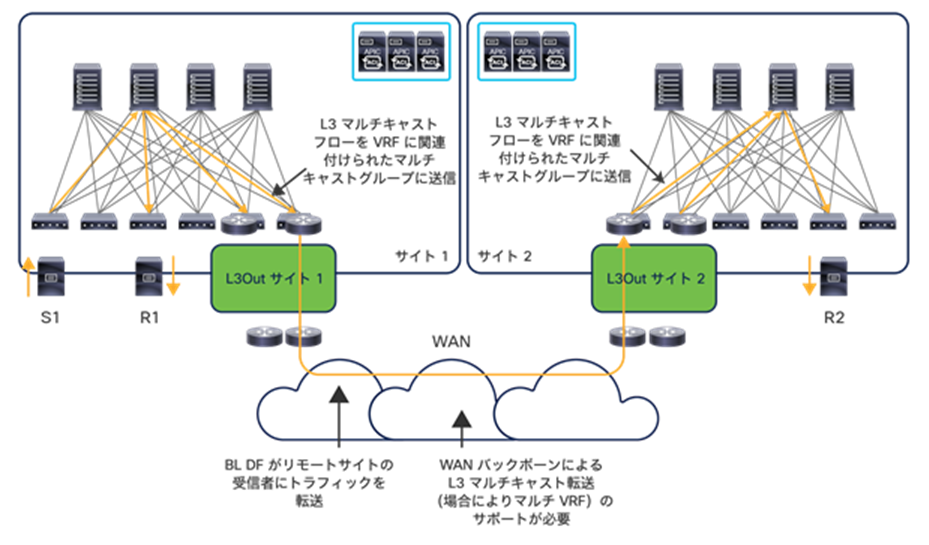

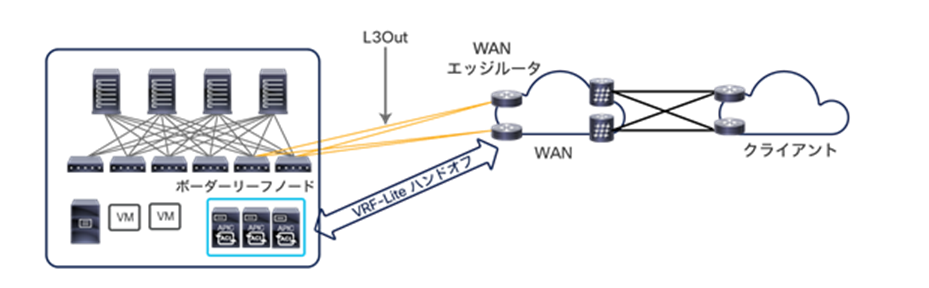

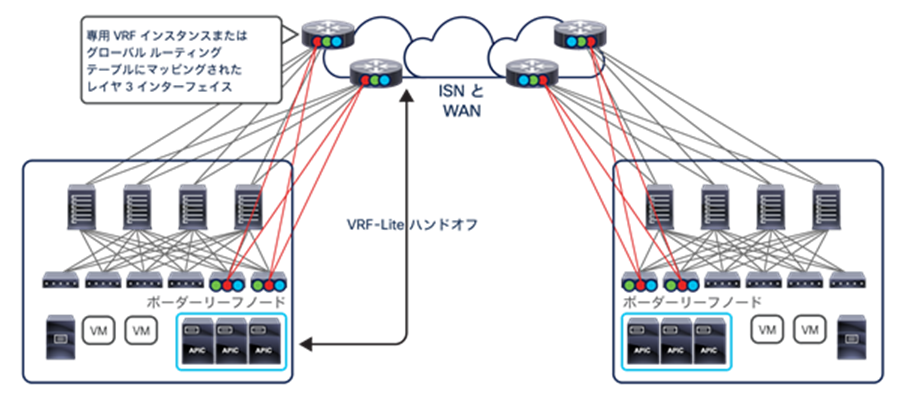

レイヤ 3 のみでサイト間を接続する Cisco ACI マルチサイト展開を検討していると、よく浮かぶ疑問として、このユースケースでサイト間ネットワークを接続するためになぜ VXLAN データパスを使うのだろうか、ボーダーリーフ(BL)ノードから L3Out の論理接続を介してそれぞれの Cisco ACI ファブリックを相互接続するだけではなぜいけないのか、などがあります。

図 45 は、この展開モデルと、これを展開しようとすると考慮しなければならない主な点を表しています。

L3Out を介したレイヤ 3 通信を実現した Cisco ACI ファブリックの相互接続

● 接続の観点から見ると、マルチ VRF 通信(マルチテナント展開)をサポートするには、論理的に分離されたルーテッドドメイン(VRF または L3VPN)を提供できる外部ネットワークを用いて、ファブリックを相互接続する必要があります。そのためには、さらにコストがかかるオプション(たとえば、サービスプロバイダーから複数の L3VPN サービスを購入)またはさらに複雑なオプション(ほんの数例を挙げると、VRF-Lite エンドツーエンドや MPLSoGRE など)を採用する必要があります。一方、「ボーダーリーフノードでの SR-MPLS/MPLS ハンドオフ」セクションで説明するように、サイト間フローを WAN 全体で包括的に可視化することが望まれる場合があります。これが実現すれば、フローを区分して優先順位を付けたり、トランスポートチームが既存のモニタリングツールを使用してデータセンター間フローをモニタリングしたりといったことが可能になります。前述のように、マルチサイトネイティブの VXLAN データパスを使用すると、外部ネットワークはルーティングが可能なインフラストラクチャを提供するだけで済みます。このインフラストラクチャを活用してサイト間 VXLAN トンネルが確立され、マルチテナントのルーティングが可能になります。

● ポリシーの観点から見ると、図 45 に示した相互接続のオプションでは、ポリシードメインが切り離されたままになっています。これは、トラフィックを外部ルータに送る前に VXLAN カプセル化がボーダーリーフノードで終了してしまい、データプレーントラフィックでポリシー情報が配信されないためです。そのため、トラフィックがリモート Cisco ACI ファブリックに入る前に適切に再分類される必要があり、別々のファブリックにある EPG 間で通信するには、ファブリックごとに個別のポリシーを作成することが必須になります。その結果、運用上のエラーによってトラフィックがドロップされる可能性が高まります。ネイティブのマルチサイト機能を使用すれば、単一のポリシードメインがそれぞれの Cisco ACI ファブリックにまたがって拡張されます。Cisco Nexus Dashboard Orchestrator で単一のシンプルなポリシーを定義することで、異なる EPG に属するエンドポイントがサイト間でセキュアに通信できるようになります。

● 最後に、非常に多い例として、レイヤ 3 のみでサイト間を接続するという当初の要件が、さまざまな IP モビリティのユースケースに対応するために IP サブネットを拡張するという要件に発展することがあります。マルチサイトを使用しない場合、これには外部ネットワークに別のレイヤ 2 データセンター相互接続(DCI)テクノロジーを展開する必要があります。この展開オプションは内部で検証されておらず、推奨もされていません。以下の 2 つのセクションで詳しく説明するように、Cisco Nexus Dashboard Orchestrator でシンプルな構成を行うことで、ブリッジドメインをサイトにまたがって拡張できます。

重要:図 45 に示す展開モデルには、サイト間接続にネイティブ VXLAN データパスを使用する場合と比較して欠点がありますが、レイヤ 3 のみでサイト間を接続するという要件を満たす完全にサポートされた実行可能なオプションです。このような設計に Nexus Dashboard Orchestrator を導入した場合でも、そのメリットが変わらず実現します。つまり、各ファブリックでの構成のプロビジョニングや Day-2 運用に関するアクティビティを一元的に行えます。これは特に、このドキュメントで前述した「自律型ファブリック」を管理するために NDO を利用する場合にも当てはまります。ただし、どちらかのオプションのみを選択することを強くお勧めします。「マルチサイト」の別々のサイトに展開された EPG 間の水平方向接続にネイティブ VXLAN データパスと L3Out パスを混在させて使用することは避ける必要があります。その理由を理解するために、下の図 46 に示す例を参照してください。

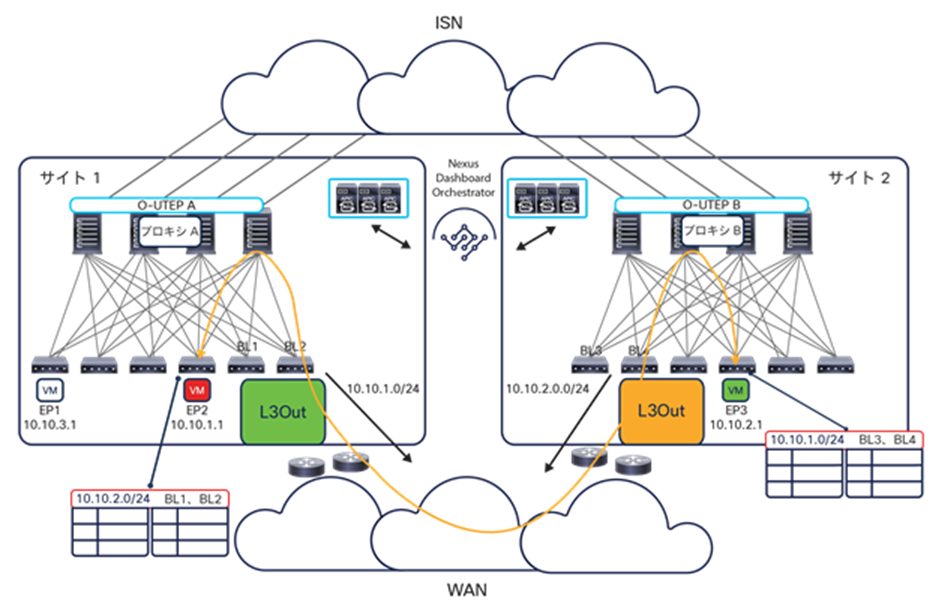

初期状態:L3Out パスを使用したレイヤ 3 のサイト間通信

サイト 1 でローカルに定義された Red EPG/BD に属する EP2 が、サイト 2 でローカルに定義された Green EPG/BD に属する EP3 と通信しています。Green BD(10.10.2.0/24)の IP サブネットがサイト 1 の BL ノードの L3Out に到達し、Red BD(10.10.1.0/24)の IP サブネットについても逆が成立するため、このルーティングされた通信は L3Out パスを介して確立されています。

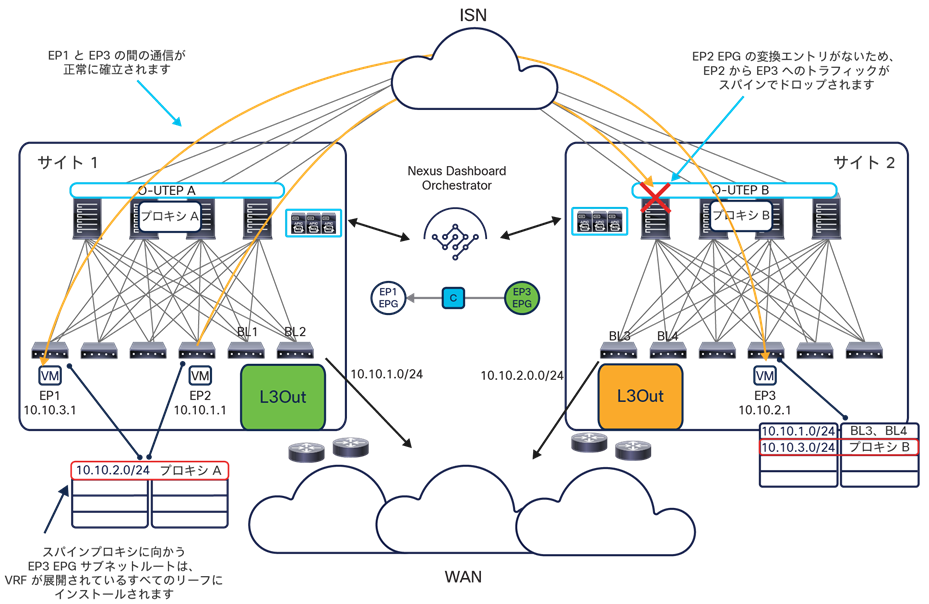

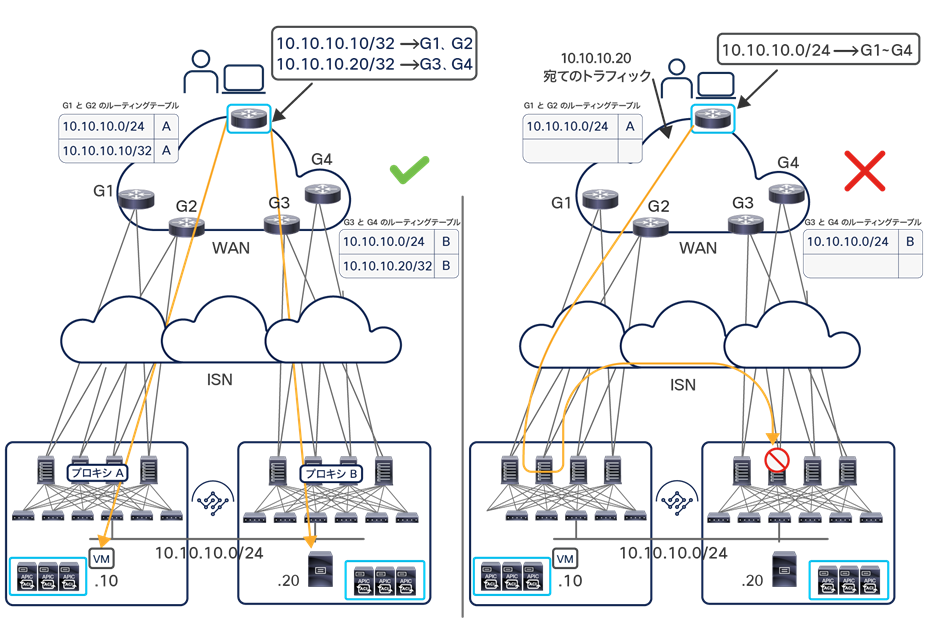

次に、サイト 1 でローカルに定義された Blue EPG/BD に属する EP1 がネットワークに接続されたとします。Blue EPG と Green EPG の間のコントラクトが NDO で作成されると、EP1 は ISN を通過する VXLAN を使用して通信するようになります(図 47)。

VXLAN と L3Out のトラフィックパスを混在させる場合の問題

Blue EPG と Green EPG の間でコントラクトを作成すると、その直接の結果として、両方のサイトにシャドウオブジェクトが作成されます。特に、サイト 1 に Green BD のシャドウオブジェクトが作成されると、対応する VRF がインストールされているすべてのリーフノードのルーティングテーブルに Green BD サブネット(10.10.2.0/24)へのルートもインストールされます。このルートはプロキシスパイン VTEP アドレスを指しているため、ISN を介した通信が行われます。図 47 に示すように、このルート情報は以前に L3Out から学習し、Red EPG と Green EPG の間の通信を確立するために使用していた情報を置き換えます(直接接続されたルートとしてインストールされるため)。

その結果、Red EPG と Green EPG の間のトラフィックも、ISN を通過する VXLAN データパスを介して送信され始めます。しかし、Red EPG と Green EPG 間のコントラクトが NDO で構成されていないため、Red EPG/BD のシャドウオブジェクトがサイト 2 に作成されていません。その結果、サイト 2 のスパインがトラフィックを受信したときに、対応する変換エントリがないため、そのトラフィックがドロップされます。

図 47 に示すのは一例にすぎず、予期しないトラフィックのドロップにつながる唯一のシナリオではありません。したがって、問題を回避するには、レイヤ 3 接続の確立に L3Out データパスを用いるか VXLAN データパスを用いるかを事前に明確に決定することが重要です。

フラッディングを使用しないレイヤ 2 のサイト間接続

Cisco ACI マルチサイトアーキテクチャは、サイト間の IP モビリティのサポートにレイヤ 2 フラッディングを必要としていません。これは、重要で非常に独特な機能です(図 48)。

IP モビリティのサポートが必要とされる主なシナリオには以下の 2 つがあります。

● ディザスタリカバリのシナリオ(コールドマイグレーション)では、当初ファブリック 1 で実行されていたアプリケーションが別のサイトに移動されます。このアプリケーションにアクセスするために使用されていた IP アドレスを変更し、DNS ベースのメカニズムを利用してクライアントをその新しい IP アドレスに向けることでこれを実現できますが、元のサイトで実行されていたときにアプリケーションが持っていた同じ IP アドレスを維持することが望ましい場合も多くあります。

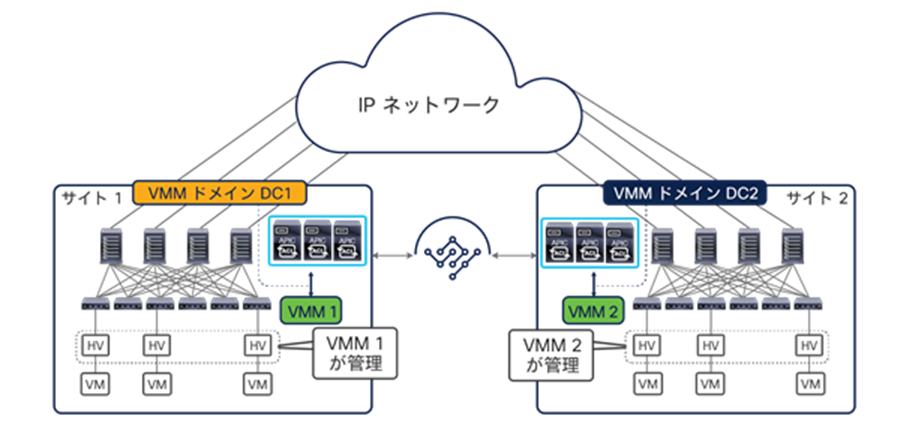

● 事業継続のシナリオ(ライブマイグレーション)では、移行中のサービスへのアクセスを中断させることなく、ワークロードを一時的に他のサイトに再配置することが望まれます。この目的に使用できる機能の典型的な例は、vSphere vMotion です。これについては、「仮想マシンマネージャ統合モデル」セクションの中で詳しく説明します。

注: サイト間のライブマイグレーション(ブロードキャスト、宛先不明のユニキャスト、マルチキャスト(BUM)フラッディングの有効化の状況にかかわらず)は、Cisco ACI リリース 3.2(1) 以降で正式にサポートされています。

図 49 の論理構成図に示すように、このユースケースでは、すべてのオブジェクト(テナント、VRF インスタンス、ブリッジドメイン、EPG)をサイトにまたがって拡張する必要があります。ただし、それぞれのブリッジドメイン構成では、サイトにまたがるブロードキャスト、宛先不明のユニキャスト、マルチキャスト(BUM)のフラッディングが許可されないように指定する必要があります。

フラッディングを使用しないレイヤ 2 のサイト間接続(論理構成図)

BUM フラッディングを使用しない IP モビリティのサポートは、Cisco ACI マルチサイトアーキテクチャによって提供される独自の機能であり、アーキテクチャの全体としての復元力を損なうことなくサイト間を柔軟に接続するために不可欠です。あるサイトのブリッジドメインで発生した問題(ブロードキャストストームなど)は、実際にそのサイト内に限定され、接続された他のファブリックに影響を与えることはありません。

IP モビリティのユースケースをサポートするために、Cisco ACI マルチサイト ソリューションには以下のような重要な機能がいくつか用意されています。

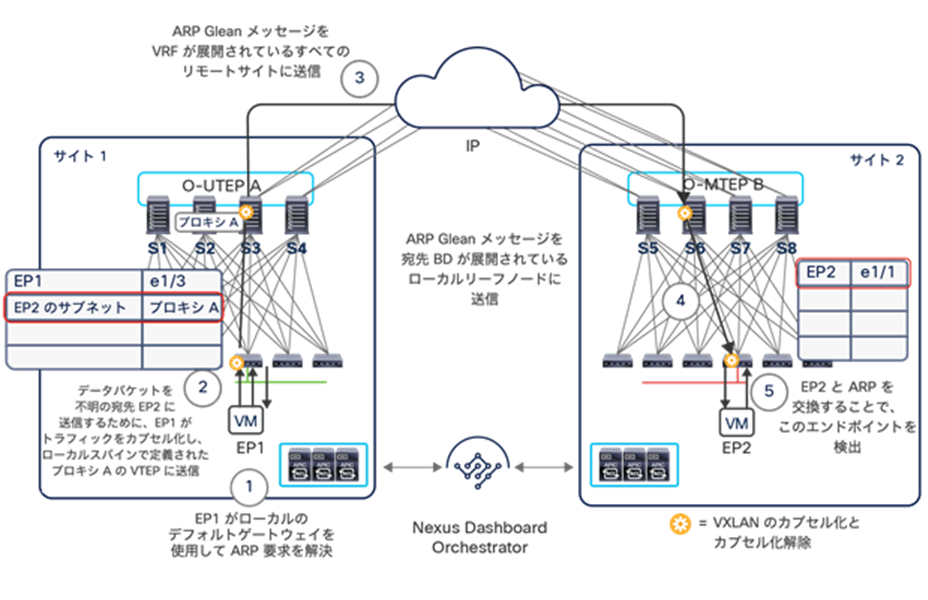

● 再配置されたエンドポイントは、同じ(または異なる)IP サブネットに属する他のエンドポイントと通信できる必要がありますが、このサブネットが依然として元のサイトに接続されている可能性があります。この要件に対処するには、元のサイトから、再配置されたエンドポイントに対して ARP 要求が送信された場合、Cisco ACI マルチサイトアーキテクチャが、その ARP 要求をリモートサイトのエンドポイントに配信する必要があります。移行されたエンドポイントの IP アドレスがファブリックによって検出されていた場合(通常はコールドマイグレーションのシナリオの場合)、ARP 要求をユニキャストモードでサイトにまたがって配信できます(VXLAN カプセル化を行い、宛先エンドポイントが現在接続されている新しいサイトを識別するエニーキャスト TEP アドレスを宛先として、そのスパインに直接配信します)。

移行されたエンドポイントの IP アドレスが最初に検出されない場合(ホットマイグレーションで、移行されたエンドポイントが移動後も「サイレント」のままである場合)、元のサイトのスパインが「ARP Glean」機能を実行してサイレントホストに強制的に ARP 応答を発信させ、このホストを検出します。その時点で、前の段落で説明したように、新しく発信された ARP 要求がユニキャストモードで配信されます。

注:ARP Glean 機能は、1 つ以上の IP アドレスが定義されているブリッジドメインでのみサポートされ、レイヤ 2 のみのブリッジドメインではサポートされません。

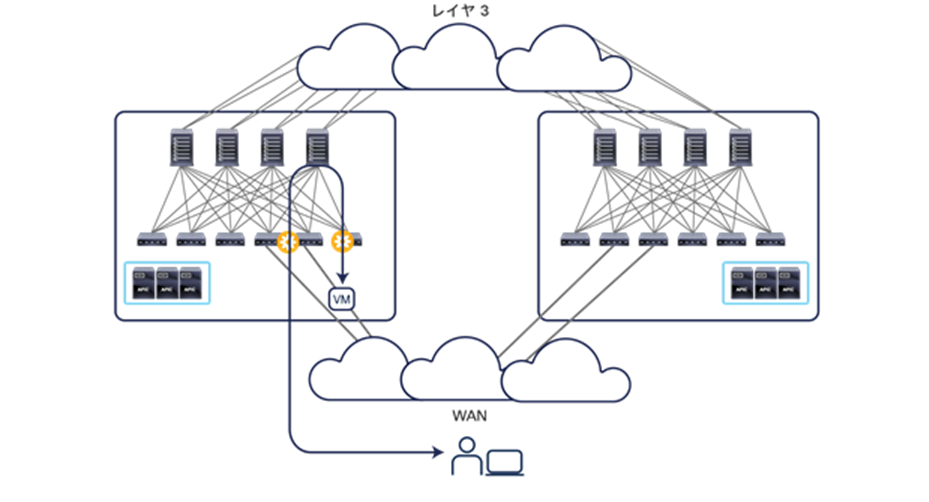

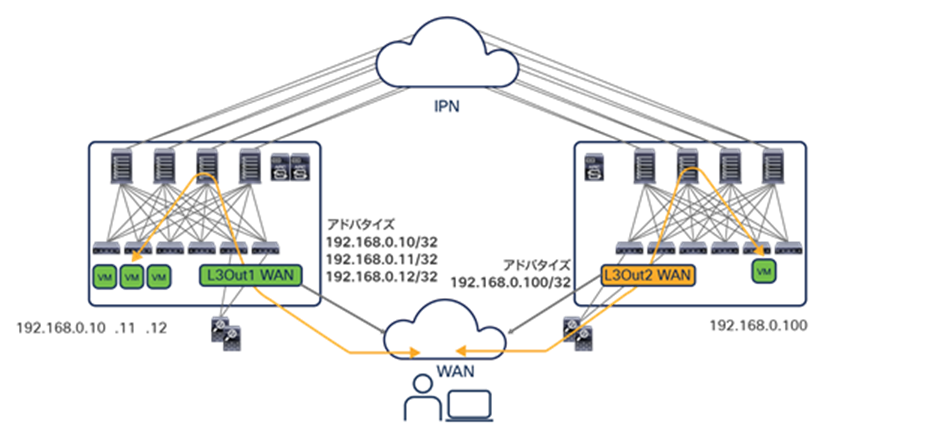

● 外部レイヤ 3 ドメインから発信されたトラフィックを、再配置されたエンドポイントに配信する必要があります。外部ネットワークとの間でレイヤ 3 外部(L3Out)接続が確立される方法に応じて、いくつかの異なるシナリオを考慮する必要があります。

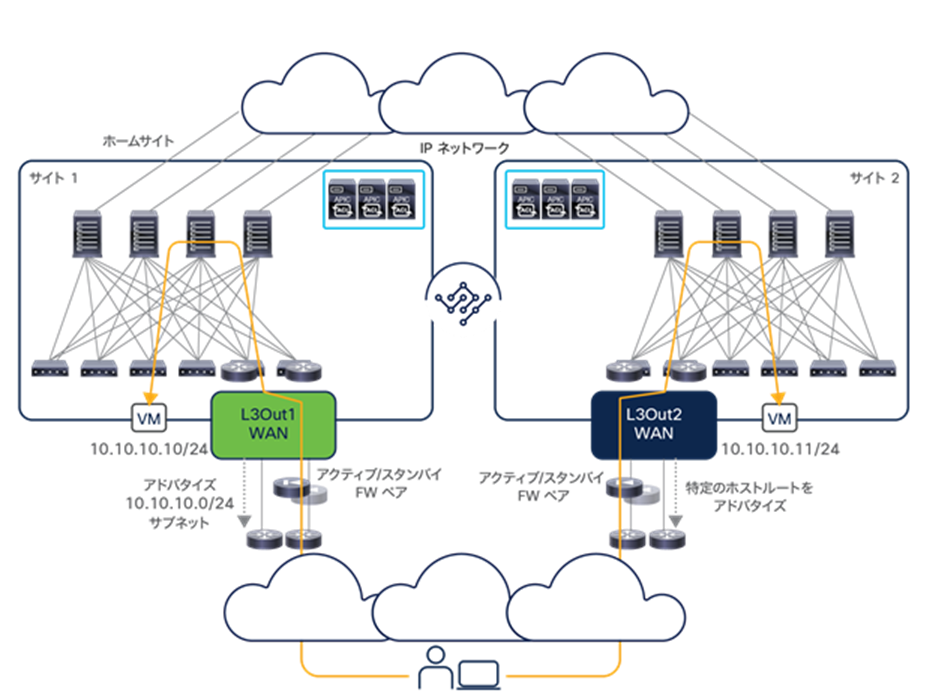

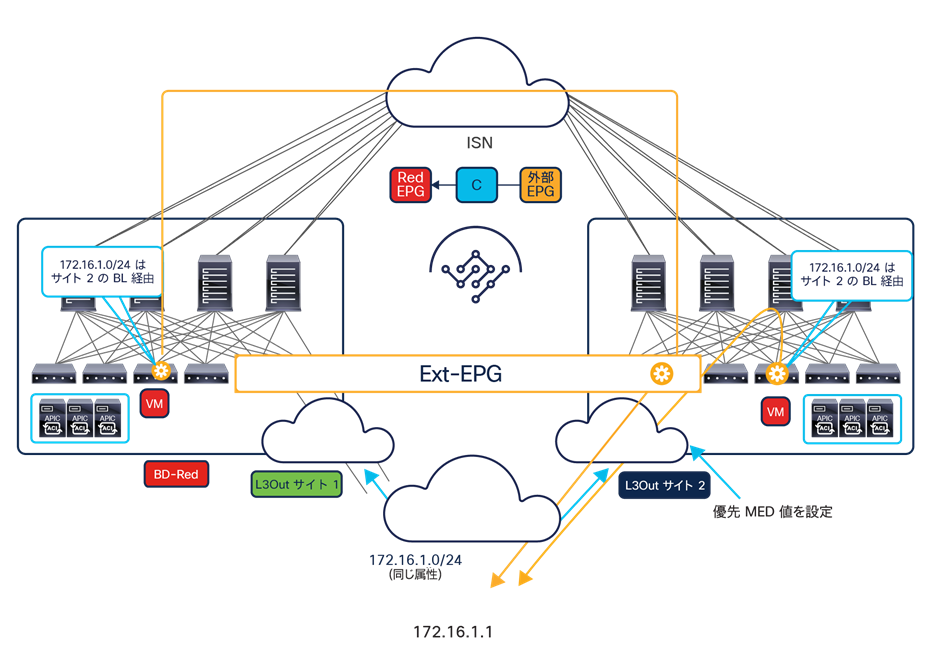

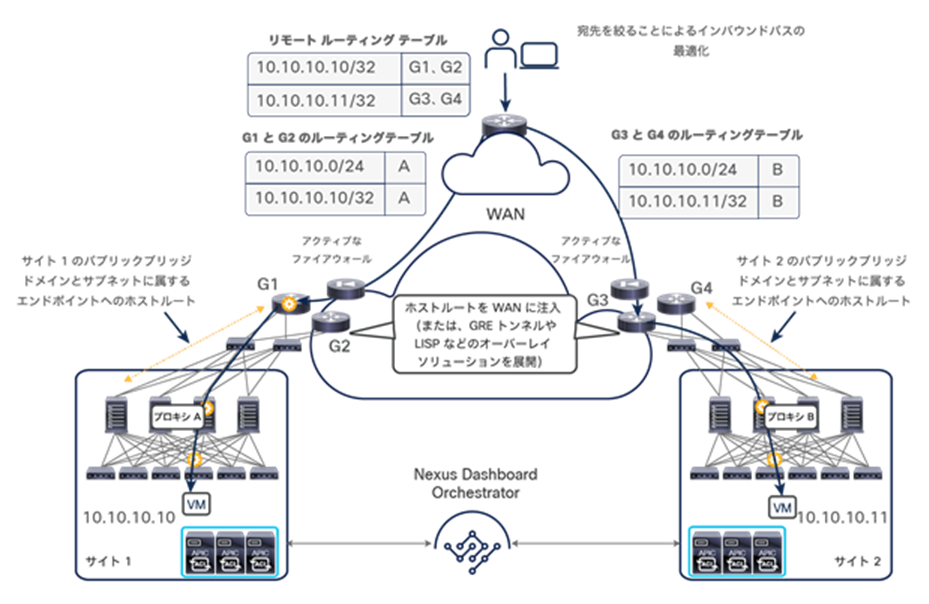

ボーダーリーフ(BL)ノードでの従来型の L3Out 接続:両方のサイトに同じ IP サブネットが展開されているため、通常、同じ IP プレフィックス情報が 2 つのサイトから WAN に送信されます。この動作によって、デフォルトでは、着信トラフィックがサイト 1 またはサイト 2 に無差別に配信される可能性があります。しかし一般的には、2 つのサイトのいずれかをその IP サブネットのホームサイト(定常状態で、そのサブネットのほとんどのエンドポイントが接続されるサイト)に指定します。この場合、WAN に送信されるルート更新を適切に調整することで、図 50 に示すように、すべての着信トラフィックをホームサイトにステアリングすることができます。

注:この「ホームサイト」のユースケースに関する詳細は、このホワイトペーパーの「Cisco ACI マルチサイトとボーダーリーフノードでの L3Out 接続」セクションを参照してください。

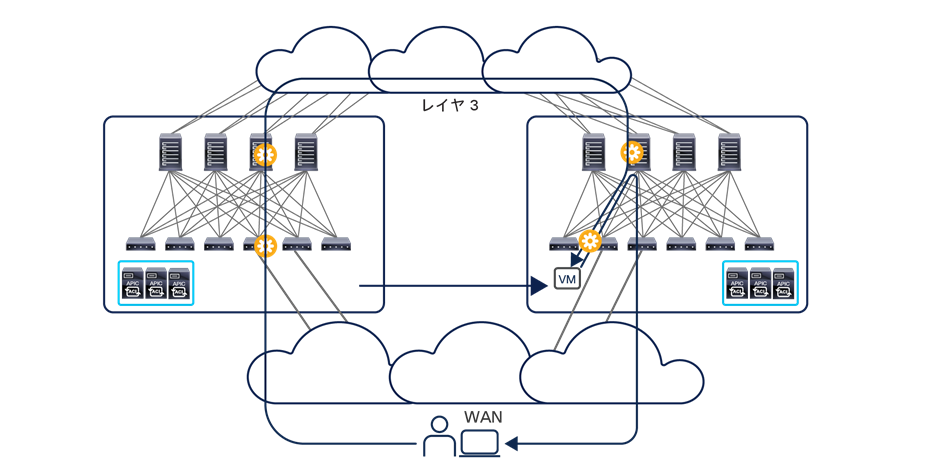

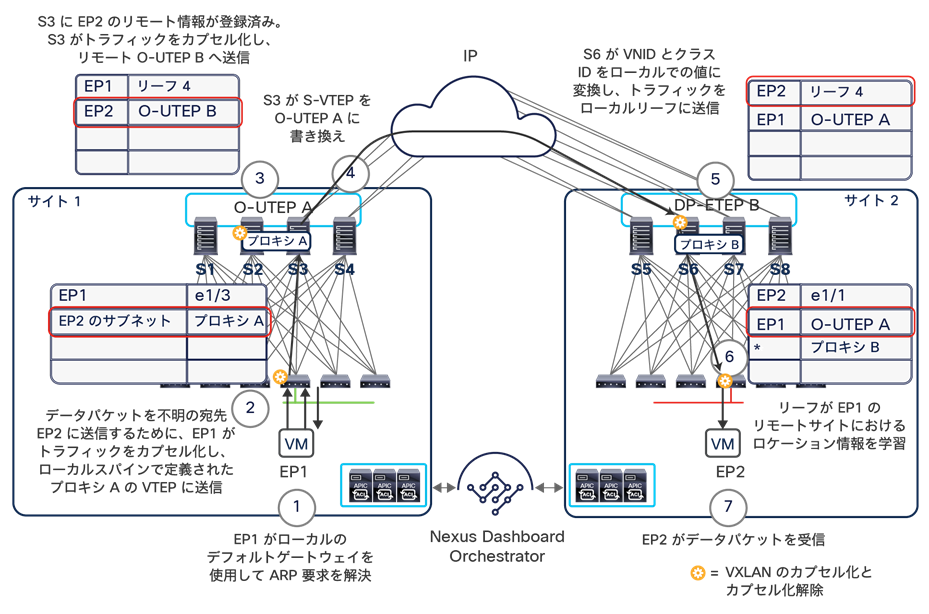

エンドポイントをサイト 2 に移行しても、上記の動作は変更されない可能性が高く、入力トラフィックは引き続きその IP サブネットのホームサイトにステアリングされます。したがって、Cisco ACI マルチサイトアーキテクチャには、図 51 に示すように、トラフィックフローをサイト間 IP ネットワークを通して宛先のエンドポイントに到達させる機能が必要です。

移行されたエンドポイントへ向かうトラフィックのサイト間でのバウンス

繰り返しますが、この動作が可能なのは、移行されたエンドポイントがサイト 2 で動的に検出され、サイト 2 のスパインノードからサイト 1 のスパインノードへの EVPN 更新がトリガーされるためです。この更新の基本的な役割は、検出されたエンドポイントのロケーション情報をサイト 1 に提供することです。図 51 に示すようなトラフィックフローのリダイレクトを行うには、この情報が必要です。

移行後、移行されたエンドポイントからリモートクライアントへのリターントラフィックが発生すると、ファブリック 2 のローカル L3Out 接続の使用が開始されます。これによって、非対称のトラフィックパスが作成されることに注意してください。ファブリックと WAN の間に、独立したステートフル ファイアウォールが展開されている設計では、この動作によってトラフィックがドロップされる可能性があります。この問題は、最も限定性の高いホストルート情報を WAN にアドバタイズする新しい機能を活用することで解決できます。この機能は Cisco ACI リリース 4.0(1) 以降、ボーダーリーフ L3Out でサポートされています。

図 52 は、ホームサイトから移動されたエンドポイントに限ってホストルートのアドバタイズを行う方法を示しています(WAN に注入されるホストルート情報の量を減らすことが目的です)。マルチサイトとボーダーリーフ L3Out の統合に関するその他の考慮事項については、セクション「Cisco ACI マルチサイトとボーダーリーフノードでの L3Out 接続」を参照してください。

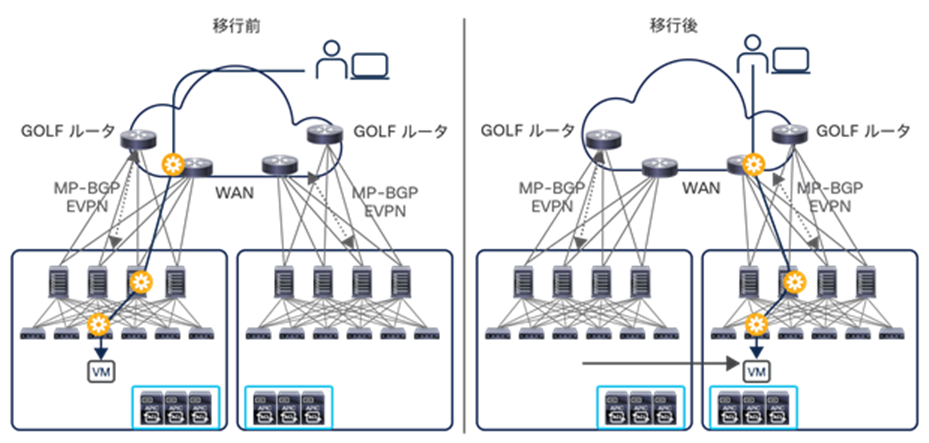

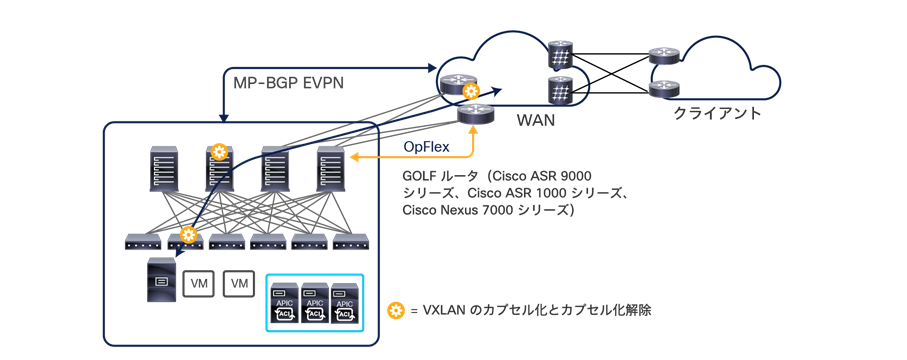

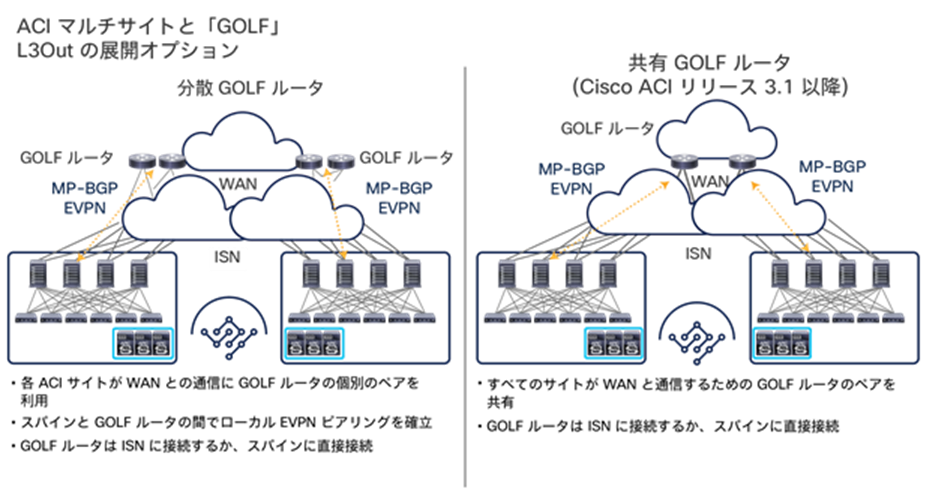

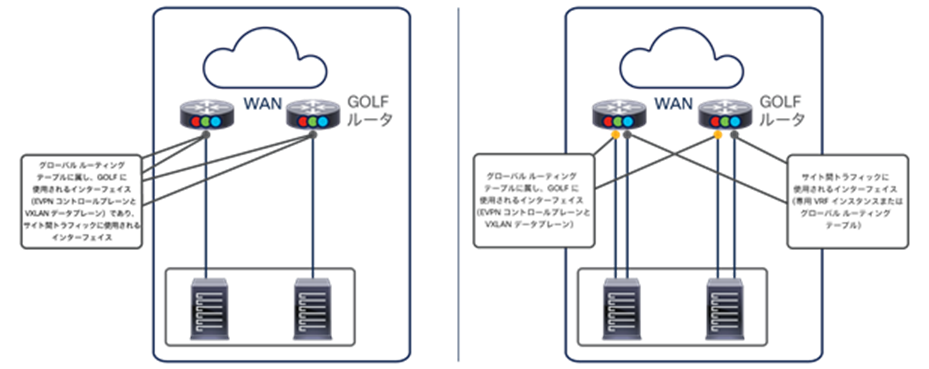

b) GOLF L3Out:Cisco ACI リリース 3.0(1) 以降は、GOLF L3Out 接続の展開が可能です。この機能は、IP サブネットに関する情報に加え、そのサブネットに接続されたエンドポイントのホストルートに関する情報を WAN エッジデバイスに送信することを目的に導入されました。この場合も、入力トラフィックがそのエンドポイントがあるサイトに常にステアリングされるようにすることができます(図 53)。

マルチサイトと GOLF の統合に関するその他の考慮事項については、付録 C を参照してください。

フラッディングを使用したレイヤ 2 のサイト間接続

次のユースケースの Cisco ACI マルチサイト設計では、ブリッジドメインをサイトにまたがって拡張する従来型のレイヤ 2 ストレッチを実現しています。これには、レイヤ 2 BUM フレームをフラッディングする機能が含まれます(図 54)。

特定の要件がある場合に BUM トラフィックのフラッディングが必要になります。その一例がアプリケーション クラスタリングです(この従来型のクラスタリングでは、異なるアプリケーション クラスタ ノードの間でレイヤ 2 マルチキャスト通信が必要です)。

図 55 は、このユースケースの論理構成図を示しています。サイトにまたがる BUM フラッディングが有効になっている点を除いて、以前に図 49 で示したケースとほぼ同じです。

フラッディングを使用したレイヤ 2 のサイト間接続(論理構成図)

Cisco ACI の独立したネットワーク間で完全なレイヤ 2 フラッディングを必要とする展開の場合、通常は Cisco ACI マルチポッドがアーキテクチャの選択肢となります。しかし、この構成のマルチサイト設計から得られるメリットの 1 つは、どのブリッジドメインを拡張し(BUM 転送を有効化するかどうかにかかわらず)、どのドメインをローカルに保持するかを厳密に制御できることです。実際、Cisco Nexus Dashboard Orchestrator を使用すると、ブリッジドメインレベルでフラッディングの動作を差別化できます。実際のシナリオでは、一部のストレッチブリッジドメインでのみフラッディングの動作のサポートが必要となることがあります。差別化はこのような場合に役立ちます。

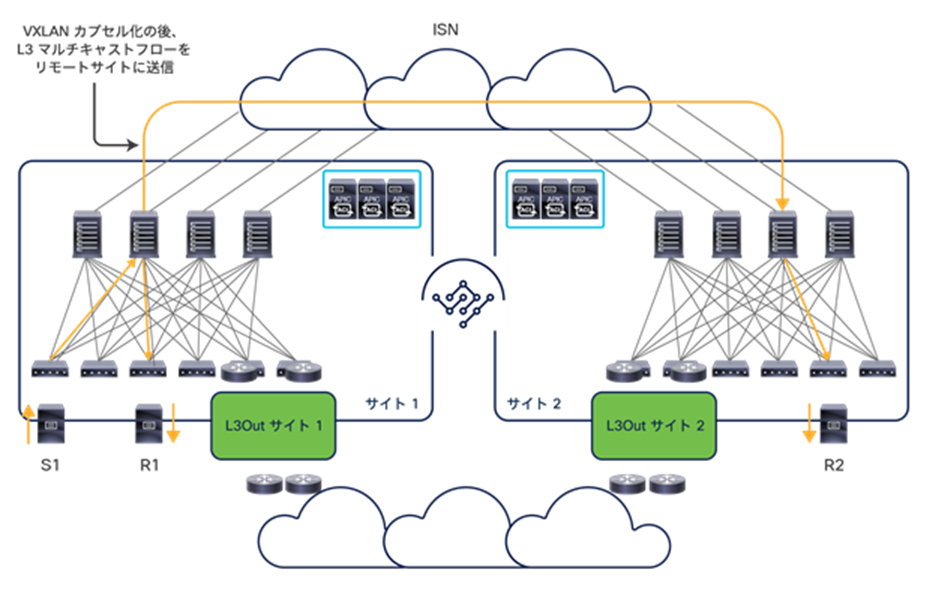

前述のように、一般的にサイト間ネットワーク(ISN)と呼ばれる汎用的なレイヤ 3 インフラストラクチャが、異なる APIC ドメインを相互接続しています。図 56 は、ISN を通して確立されたサイト間 VXLAN トンネルを示しています。

注: このドキュメントの残りの部分では、「ISN」、「IP WAN」、および「IP ネットワーク」という用語を区別なく使用します(図の中でも同様です)。いずれも、同じマルチサイトドメインに属する ACI ファブリック間のネットワーク接続に使用されるルーテッド ネットワーク インフラストラクチャを意味します。

ISN では、プレーンな IP ルーティングがサポートされていれば、サイト間 VXLAN トンネルを確立できます。要件がこれだけのため、単一のシンプルなルータデバイス(冗長性のために 2 つ使用することが常に推奨されます)から、世界中に広がる複雑なネットワーク インフラストラクチャまで、好みの方法で ISN を構築できます。

スパインインターフェイスは、ポイントツーポイントのルーテッドインターフェイスを介して ISN デバイスに接続されます。ただし、スパインインターフェイスから発信されるトラフィックには常に 802.1q VLAN 4 の値がタグ付けされます。そのため、スパインとそれに直接接続された IPN デバイスの両方でレイヤ 3 サブインターフェイスを定義してサポートする必要があります。したがって、同じ VLAN 4 タグを使用しながら別々のポイントツーポイント L3 リンクとして機能する複数のサブインターフェイスを同じデバイス上に定義できる IPN ルータを選択することが重要です。

注: ISN デバイスでサブインターフェイスを使用する必要があるのは、スパインに接続する場合のみです。

ISN にマルチサイト専用のネットワーク インフラストラクチャを使用することも可能ですが、他の接続サービスを併せて提供しているネットワークをこの目的に使用することも、多くの実際のシナリオではきわめて一般的です。この後者の場合、専用の VRF ルーテッドドメインを展開して、マルチサイトのコントロールプレーンとデータプレーンのトラフィックを転送することを強くお勧めします。これを推奨する理由は以下の 2 つです。

● 専用のルーティングドメインを用いると、サイト間接続の問題のトラブルシューティングが必要になったときに運用上のメリットが得られます(ルーティングテーブルが小さくなるなど)。

● 不要なルーティングプレフィックスで ACI「overlay-1」VRF が過負荷になるのを防ぐ必要があります。前述のように、サイト間接続を確立するには同じマルチサイトドメインに属するファブリック間でプレフィックスを交換する必要がありますが、その数はごくわずかです。実際、ACI「overlay-1」ルーティングスペースにはルート数の上限があり、現在のところ、上限は 1,000 プレフィックスです。この基盤となるルーティングドメインに注入されるプレフィックスが増えると、ACI スパインノードの安定性と機能が損なわれる可能性があります。

ISN では、デフォルトの 1500 バイト値を超える MTU のサポートも必要です。VXLAN データプレーントラフィックでは 50 バイトのオーバーヘッドが追加されます(元のフレームの IEEE 802.1q ヘッダーを保持する場合は 54 バイト)。したがって、ISN インフラストラクチャのすべてのレイヤ 3 インターフェイスがこの MTU サイズの増加をサポートできることを確認する必要があります(一般的な推奨事項は、ISN デバイスのすべてのインターフェイスで、エンドツーエンドで必要な MTU の下限より少なくとも 100 バイト多い MTU をサポートすることです)。これは、ACI スパインノードが、フラグメント化された VXLAN フレームをハードウェア内で再構築できないためです。たとえば、送信元サイト 1 のスパインが MTU の大きなパケットを ISN に送信し、ISN デバイスがそのインターフェイスの 1 つからそのパケットを送信する前にフラグメント化せざるを得なかったとします(サポートされる MTU が小さいため)。この場合、宛先サイト 2 でそれを受信したスパインはフラグメントを再構築できず、応答することなくフラグメントを破棄するため、サイト間接続が切断されます。

注: フレームが ISN インフラストラクチャ内でフラグメント化され再構築された場合(たとえば、送信元と宛先の ISN デバイスが相互に IPsec 接続を確立することによって)、宛先スパインがフルサイズのフラグメント化されていないフレームを処理するため、サイト間の正常な接続が維持されます。ただし、このような回避策を採用する場合は、スループットの観点からパフォーマンスへの影響を考慮することが重要です。これは主に、フラグメンテーションと再構築を行う ISN プラットフォームに依存します。

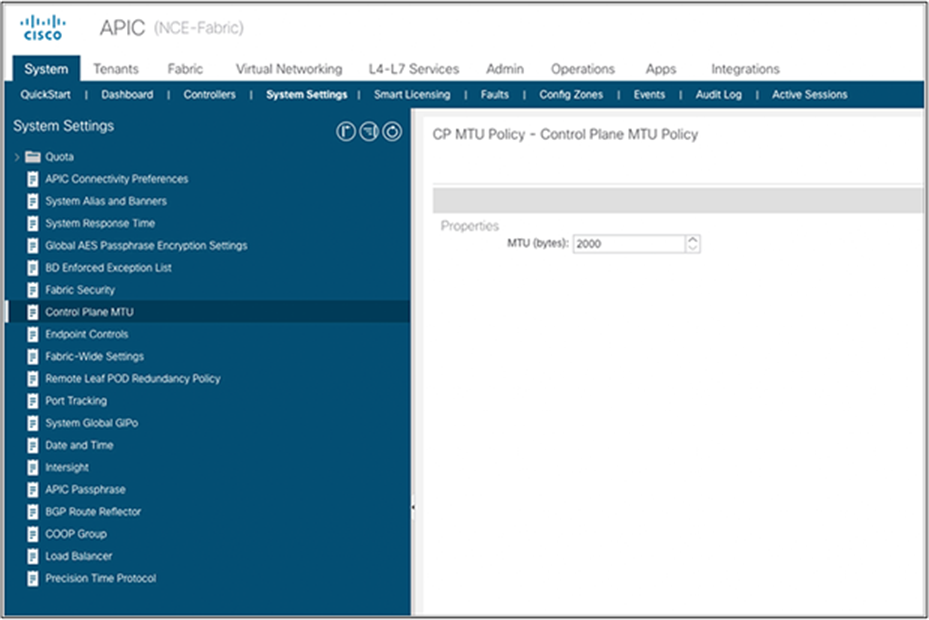

ISN で設定する MTU の最小値は、以下の 2 つの要因によって決まります。

● ファブリックに接続されたエンドポイントによって生成されるフレームの MTU の最大値:エンドポイントがジャンボ フレーム(9,000 バイト)をサポートするように構成されている場合、ISN は少なくとも 9,050 バイトの MTU 値になるよう構成する必要があります。エンドポイントがデフォルトの 1,500 バイト値になるよう構成されている場合は、ISN の MTU サイズを 1,550 バイトに減らすことができます。これは、他のカプセル化のオーバーヘッドが各フレームに追加される場合を除きます。たとえば、IPsec または CloudSec で暗号化する場合が該当します。

● 異なるサイトにあるスパインノード間の MP-BGP コントロールプレーン通信の MTU:デフォルトでは、エンドポイントルーティング情報を交換するためにスパインノードが 9,000 バイトのパケットを生成します。そのデフォルト値が変更されていない場合、ISN は少なくとも 9,000 バイトの MTU サイズをサポートする必要があります。そうでない場合、サイト間でのコントロールプレーン情報の MP-BGP 交換は成功しません(MP-BGP 隣接関係を確立できるにもかかわらず)。デフォルト値は、APIC ドメインごとに、対応するシステム設定を変更することで調整できます(図 57)。

Cisco APIC でのコントロールプレーン MTU の設定

注: 上の図に示されているグローバル MTU 設定は、ACI ファブリック内で使用されるコントロール プレーン プロトコル(IS-IS、COOP、MP-BGP VPNv4)、およびスパインと ISN デバイスの間で使用される OSPF プロトコルにも適用されます。ただし、これらのコントロール プレーン フレームの最大サイズを減らした場合でも、パフォーマンスに対する大きな影響は確認されていません。

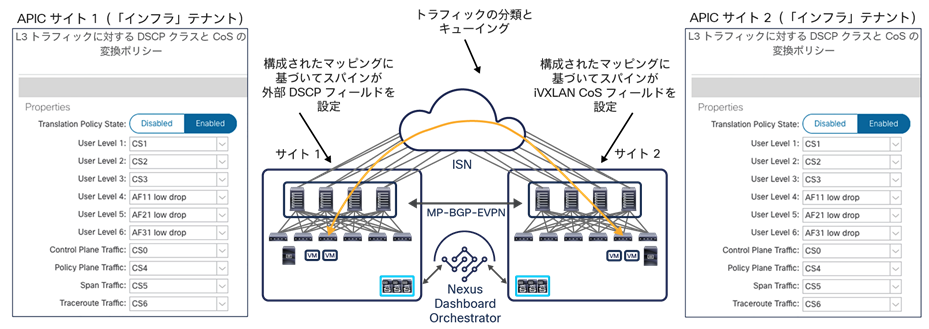

ISN と QoS の展開に関する考慮事項

展開シナリオによっては、サイト間の異なるトラフィックフローで QoS の動作を差別化することが望ましい場合があります。マルチサイト設計でこの観点から提供されている機能を理解するには、ACI ファブリック内での QoS の動作について手短に振り返ることが役立ちます。

ACI ファブリックの QoS クラス

図 58 に示すように、ACI ファブリックは、ファブリック内のトラフィックを処理するために複数のサービスクラスをサポートします。

● ユーザーデータ(テナントなど)トラフィックのためのユーザーが構成可能な 6 つのサービスクラス:外部コネクテッドデバイス(エンドポイント、ルータ、サービスノードなど)からリーフノードが受信するすべてのユーザートラフィックに使用されます。デフォルトでは、これらのデバイスから受信したトラフィックはすべてレベル 3 クラスに割り当てられます。この割り当ては、外部デバイスが属する EPG(または L3Out の場合は Ext-EPG)、または EPG 間のコントラクトによって確立された関係に基づいて変更できます。

ファブリック管理者は、(ファブリック アクセス ポリシー構成の一部として)これらのユーザーレベルの QoS クラスのそれぞれに関連付けられた、最小バッファ、輻輳アルゴリズム、帯域幅割り当て率などのプロパティを調整できます。

注:Cisco ACI リリース 4.0(1) までは、3 つのユーザーデータクラスのみが使用できます。

● 予約済みの 4 つのサービスクラス:APIC コントローラノード間のトラフィック、リーフノードとスパインノードによって生成されるコントロール プレーン トラフィック、SPAN と traceroute のトラフィックに使用されます。

ACI ファブリック内のさまざまなトラフィックフローは、VXLAN カプセル化パケットの 802.1Q ヘッダーに含まれる CoS と DEI のビットに割り当てられた値に基づいて、異なる QoS クラスに区分されます。

VXLAN カプセル化トラフィックが同じマルチサイトドメインに属するファブリック間の通信のためにサイト間ネットワークに送られる場合、この動作に問題が生じます。そもそも 802.1Q ヘッダーが ISN 内で存在するか、あったとしてエンドツーエンドでこれらのビットが保存されるかが保証できないためです。したがって、サイト間のトラフィックフローをそれらが属すると想定される QoS クラスに基づいて差別化できるようにするには、別のメカニズムが必要です。

ACI サイト間のエンドツーエンドで整合性のとれた QoS の動作

図 59 は、マルチサイトアーキテクチャでこの目的を達成する方法を示しています。それぞれの APIC ドメインにマッピングテーブルが構成し、各 QoS クラスを Differentiated Services Code Point(DSCP)の特定の値に一貫性がとれるようにマッピングします。この値は、ISN に注入される VXLAN カプセル化パケットの外部 IP ヘッダーに設定されます。この機能により、以下の 2 つの目的を達成できます。

● パケットで伝送される DSCP 値に基づいて、リモート ACI ファブリックが受信したトラフィックを適切な QoS クラスに関連付けることができます。これにより、同じマルチサイトドメインに属する異なる ACI ファブリックで、一貫した QoS の処理を実現できます。

● ファブリックを相互接続する ISN インフラストラクチャで、トラフィックの分類と優先順位付けができます。たとえば、異なるサイトのスパインノード間の MP-BGP コントロール プレーン トラフィックに常に優先順位を付けて、データトラフィックがマルチサイト展開の全体的な安定性を損なわないようにすることができます。これは基本的かつ一般的な推奨事項です。6 つのユーザーデータクラスを使用すると、同じテナントまたは異なるテナントに属するトラフィックフローに提供されるサービスを差別化することもできます。

注:さまざまなタイプのトラフィックを分類して優先順位を付けるためには ISN デバイスでの構成が必要です。この構成は展開されている特定のハードウェア プラットフォームに依存するため、このホワイトペーパーの範囲外です。それぞれの製品の添付資料を参照してください。

上記の 2 つの目的を達成するための基本的な前提は、ISN 内のデバイスによって DSCP 値が変更されないことです。変更されると、トラフィックがリモートサイトで受信されたときにトラフィックを適切な QoS クラスに関連付けることができなくなるためです。

また、QoS グループと、対応する DSCP 値の間のマッピングは、NDO が直接実行する必要があります。そうすることで、マルチサイトドメインのすべてのサイトに、一貫したマッピングが展開されます。この設定はすべての NDO リリースでサポートされています。また、Cisco Nexus Dashboard Orchestrator リリース 4.0(1) 以降では、ファブリック ポリシー テンプレートの一部になっています。

Cisco ACI マルチサイトのアンダーレイ コントロール プレーン

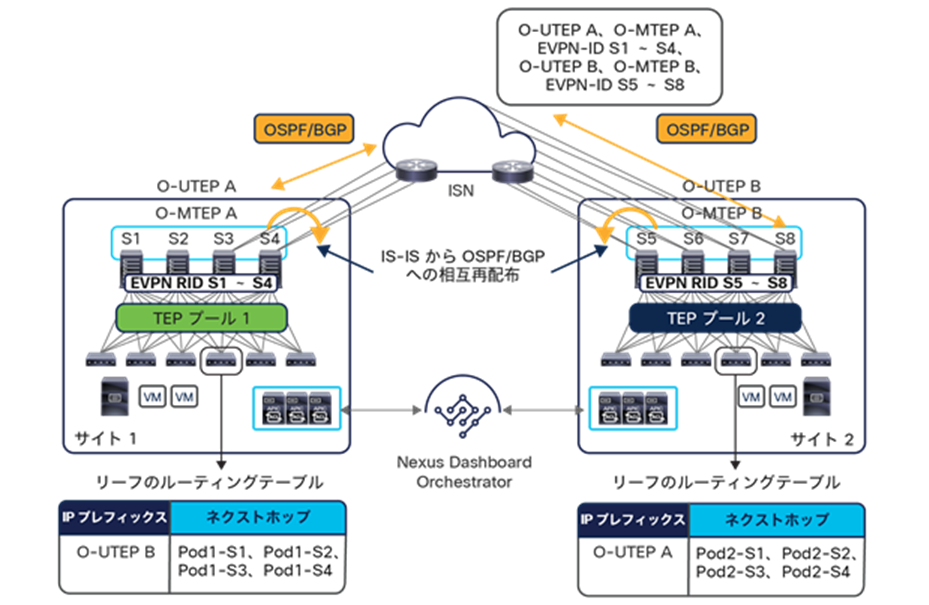

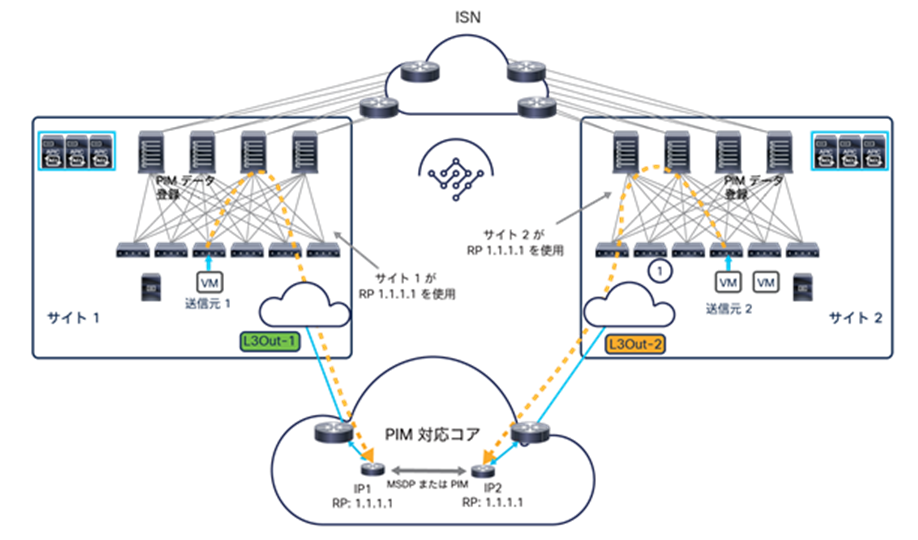

ISN デバイスは、ルーティングプロトコルを使用して、各サイトに展開されたスパインノードとの隣接関係を確立し、サイト間のコントロールプレーンとデータプレーンを確立するために必要なプレフィックスをサイト間で交換できるようにする必要があります(図 60)。

各サイトのスパインノードと ISN の間の OSPF/BGP ピアリング

当初は OSPF が、サポートされる唯一のコントロールプレーンでしたが、NDO リリース 3.5(1) 以降は、BGP も有効なオプションとして追加されました。

注: BGP を使用するには、Cisco ACI リリース 5.2(1) の展開も必要です。

OSPF と BGP は必要に応じて併用でき、スパインノードで定義された以下の IP アドレスのルーティング情報をサイト間で交換するために使用されます。

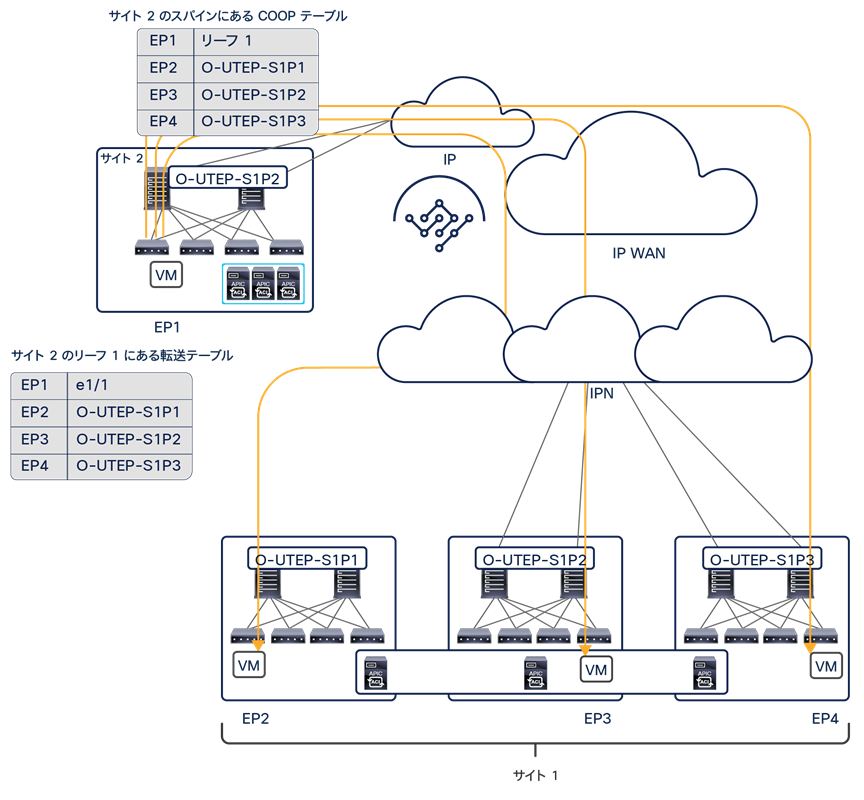

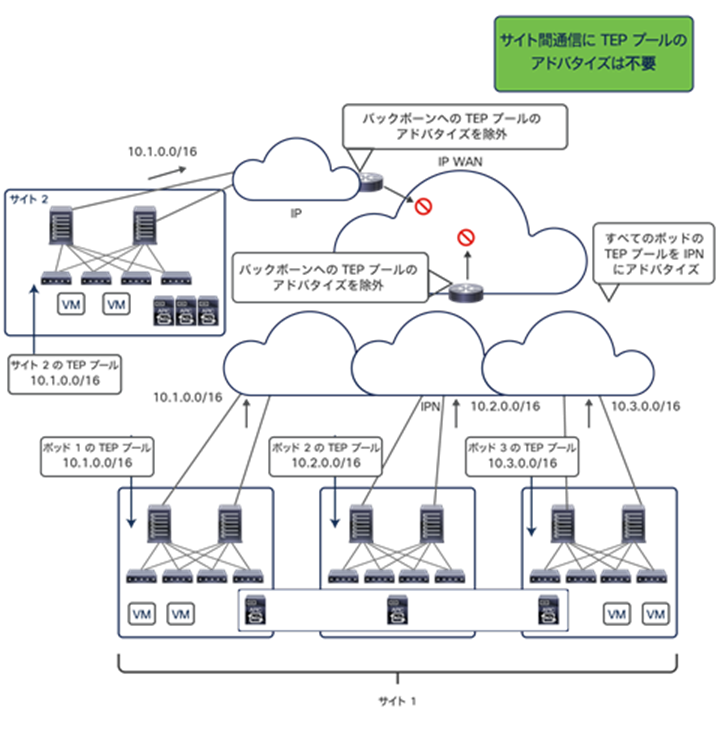

● BGP-EVPN ルータ ID(EVPN-RID):この一意の IP アドレスは、ファブリックに属する各スパインノードで定義され、リモートサイトのスパインノードと MP-BGP EVPN および VPNv4 の隣接関係を確立するために使用されます。

● オーバーレイユニキャスト TEP(O-UTEP):この共通エニーキャストアドレスは、同じポッド内のすべてのスパインノードによって共有され、ユニキャスト VXLAN データプレーントラフィックの送受信に使用されます。各ポッドは、基本的に(単一ポッドファブリックが展開された場合)サイトを一意に識別する O-UTEP アドレスによって特徴付けられます。

注:マルチポッドファブリックを展開すると、各ポッドに一意の O-UTEP アドレスが割り当てられます。詳細は、「Cisco ACI のマルチポッドとマルチサイトの統合」セクションを参照してください。

● オーバーレイマルチキャスト TEP(O-MTEP):この共通エニーキャストアドレスは、同じサイト内のすべてのスパインノードによって共有され、BUM トラフィックのヘッドエンド レプリケーションの実行に使用されます。BUM トラフィックは、ローカルスパインノードで定義された O-UTEP アドレスから発信され、所定のブリッジドメインが拡張されているリモートサイトの O-MTEP に配信されます。

O-UTEP と O-MTEP を定義することで、特定のサイトに接続されているすべてのリソースが、この 2 つの IP アドレスのいずれかを介してリモートサイトから到達可能であると常に見なされるようになります(どちらのアドレスを使うかは、ユニキャストトラフィックか BUM/マルチキャスト通信かによって異なります)。その結果、2 つのサイト間で交換される ISN 内の水平方向 VXLAN トラフィックでは、すべてのパケットが常に送信元サイトを識別する O-UTEP アドレスから送信され、宛先サイトの O-UTEP(まは O-MTEP)に向かうようになります。これは、複数の ECMP リンクを活用して 2 つのサイトを相互接続することを妨げるものではないことに注意してください。VXLAN カプセル化パケットを構築するとき、エンドポイントが生成した元のフレームの L2/L3/L4 ヘッダーをハッシュした結果が外側のヘッダーの UDP 送信元ポートとして使用されます。このようにしてパケットに「エントロピー」が形成されます。同じサイト間であっても(およびエンドポイントの同じペア間であっても)アプリケーションフローが異なれば、生成される UDP 送信元ポートの値が異なります。すなわち、ISN 内のネットワークデバイスが L4 ポート情報を見てトラフィックを転送するリンクを選択する限り、複数のパス間で VXLAN パケットの負荷が分散されます。

図 60 に示すように、EVPN-RID、O-UTEP、O-MTEP の 3 つのアドレスが、サイト間の EVPN コントロールプレーンと VXLAN データプレーンを有効化するためにサイト間で交換する必要があるプレフィックスのすべてです。したがって、ISN ルーティングドメインで学習する必要があるのは、この 3 つのプレフィックスのみです。つまり、この 3 つの IP アドレスは ISN 全体でグローバルにルーティング可能になっている必要がありますが、通常これは問題にならないはずです。この 3 つは各ファブリックに関連付けられた元の TEP プールから独立し、マルチサイトを展開したときに Cisco Nexus Dashboard Orchestrator で個別に割り当てられているためです。

専用の IP の範囲を設けてそこからこの少数の IP アドレスを割り当て、サイトにまたがってこの /32 プレフィックスをすべてアドバタイズできるようにすることが、ベストプラクティスの推奨事項となります。必要に応じて、1 つのサイトで使用されるすべての /32 プレフィックスを集約し、集約ルートのみをマルチサイトドメインに属するリモートファブリックに送信することもできます。その場合、受信した集約ルートをファブリック内部の IS-IS コントロールプレーンに再配布できるようにするには、すべてのリモート APIC ドメインで追加の構成手順が必要になります。

サイト 1 の APIC で定義されたリモートサイト 2 の集約ルート

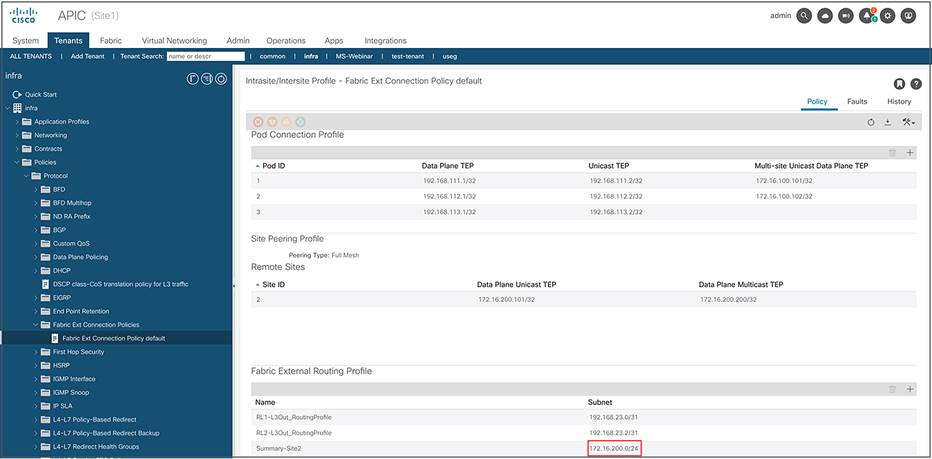

図 61 に示すように、サマリープレフィックスは、[インフラ(infra)] テナントに対して定義された [ファブリック外部ルーティングプロファイル(Fabric External Routing Profile)] ポリシーの一部として APIC で設定する必要があります。

注: 各サイト内で使用され、ファブリックの起動時に割り当てられる内部 TEP プールのプレフィックスは、サイト間通信を可能にするためにサイト間で交換する必要はありません。したがって、これらのプールに対する割り当て方に技術的な制約はなく、重複する内部 TEP プールを使用する ACI ファブリックが同じマルチサイトドメインに属している場合があります。ただし、内部 TEP プールのサマリープレフィックスは常にスパインから ISN に向けて送信されます。これは、Cisco ACI のマルチポッドとマルチサイトのアーキテクチャを統合する場合に必要になるためです。したがって、ペストプラクティスとしては、内部 TEP プールのプレフィックスが最初の ISN デバイスでフィルタリングされ、ISN ネットワークに注入されないようにすることが必要です(ネットワークのバックボーンまたはリモートファブリックにすでに展開されているアドレス空間と重複する可能性があるため)。詳細は、「Cisco ACI のマルチポッドとマルチサイトの統合」セクションを参照してください。

フラッディングが有効なストレッチブリッジドメインのユースケースでは、ポッド間でレイヤ 2 マルチ宛先(BUM)トラフィックを交換できるようにする場合でも、ISN ルーティングドメイン内でマルチキャストをサポートする必要がないことに注意してください。Cisco ACI マルチサイト設計では、送信元サイトのスパインノードの入力レプリケーション機能によって、そのブリッジドメインが拡張されているすべてのリモートサイトに BUM トラフィックが複製されるためです。この機能の詳細は、「サイトにまたがるレイヤ 2 BUM トラフィックの処理」セクションを参照してください。

Cisco ACI マルチサイトスパインのバックツーバック接続

Cisco ACI リリース 3.2(1) 以降、図 62 に示すように、別々のファブリックに属するスパイン間のバックツーバックトポロジもサポートされます。

Cisco ACI マルチサイトスパインのバックツーバック接続(Cisco ACI リリース 3.2 以降)

このトポロジの設計に関する重要な考慮事項は以下のとおりです。

● あるサイトに展開されたスパインすべてがリモートサイトのスパインに接続している必要はありません。スパインの一部のみがサイトにまたがってバックツーバックで接続される場合もあります。

● 使用するスパインやリンクの数は、主にそれらの専用リンクを展開するためのコストと、接続に求められる帯域幅や復元力とのバランスを考慮して決定されます。

● 別々の DC サイト間のすべての通信を暗号化する必要がある場合は、MACsec 暗号化を有効にできます。暗号化をサポートするためのハードウェア要件の詳細は、「Cisco ACI マルチサイトとサイト間トラフィックの暗号化(CloudSec)」セクションを参照してください。

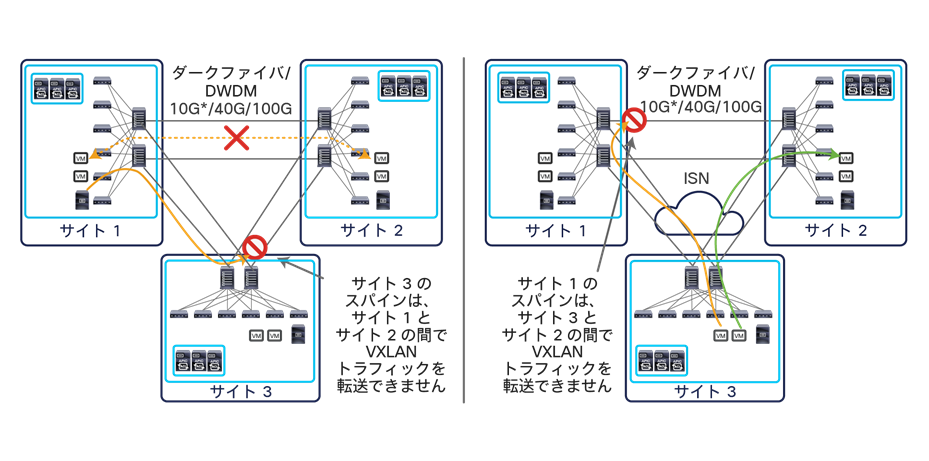

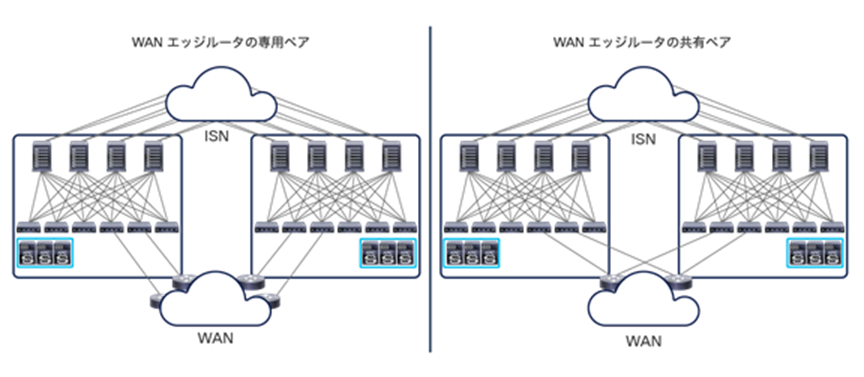

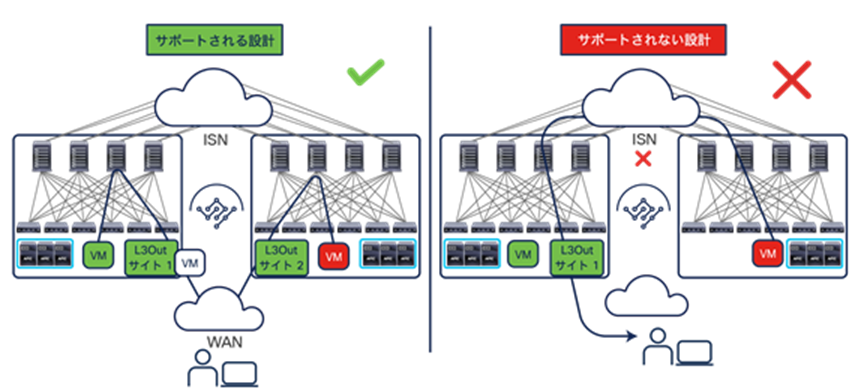

● 現在、バックツーバックで接続できるサイト(ファブリック)は 2 つに制限されています。3 つ以上のサイトがダイレクトリンクで接続されるトポロジはサポートされていません。これは、あるサイトのスパインがそのサイトとは異なるサイトのペア間で行われる VXLAN カプセル化通信を転送できないためです。同じ理由で、2 つのサイトがバックツーバックで接続され、他のリモートサイトとは汎用のサイト間ネットワーク経由で接続される「ハイブリッド」トポロジの展開はサポートされていません(図 63)。

上図の左側のシナリオは、サイト 1 とサイト 2 の間のダイレクトリンクに障害が発生した場合に、VXLAN トラフィックがサイト 3 のスパイン経由にステアリングされる様子を示しています。右側の「ハイブリッド」シナリオは、トラフィックが ISN を介してサイト 2 のスパインに直接配信されるよう適切にステアリングされ、サイト 3 とサイト 2 の間で通信が成功している様子を示しています。ただし、同じフローがサイト 1 のスパインを経由するようステアリングされた場合(たとえば、ISN での再ルーティングが原因で)、サイト 3 とサイト 2 の間の通信は失敗します。

サイトのペア間でより高い帯域幅の接続が利用できるために「ハイブリッド」シナリオを採用する場合、図 64 に示すように、この接続を使用してサイト間ネットワークのファーストホップのデバイス間でダイレクトリンクを確立することをお勧めします(スパインノード間ではダイレクトリンクを使用しません)。

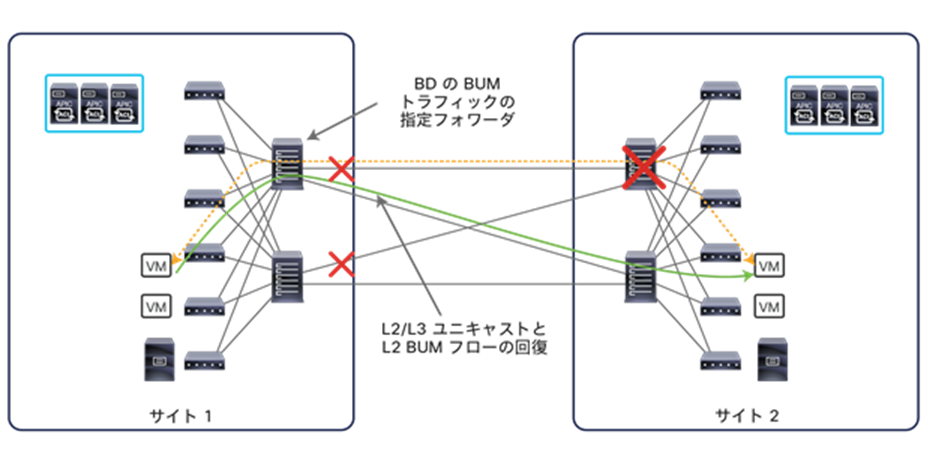

● 上の図 62 に示すように、スパインはスクエアトポロジで接続できます。このトポロジでも、スパインはリモートサイトのスパインとフルメッシュの BGP ピアリングを確立しますが(ルートリフレクタは構成されていないと仮定します)、各スパインから発信されるデータプレーントラフィックがリモートスパインに接続する単一のリンクを流れることは明らかです。サイト間のすべての BUM トラフィックは、常に、そのブリッジドメインの指定フォワーダとして選択されたスパインによって発信され、O-MTEP アドレス宛てに送信されます。これを受信したスパインは、ローカルサイト内で BUM トラフィックを転送します(受信サイトでこの機能を担う指定フォワーダを選択する必要はありません)。

● 上記の説明にもかかわらず、トポロジのベストプラクティスは、別々のサイトに属するスパイン間にフルメッシュ接続を作成することです。このトポロジを採用することで、図 65 に示すリモートスパインで障害が発生した場合のような障害シナリオにおいて、直接的なメリットが 2 つ得られます。まず、サイト間のレイヤ 2/レイヤ 3 ユニキャスト通信の場合、それぞれのローカルスパインで利用できる残された接続にローカルで VXLAN トラフィックを振り分けるだけでトラフィックを回復できます。次に、サイト間のレイヤ 2 BUM トラフィックにも同じことが言えます。この場合、ローカルの指定フォワーダを選択し直す必要はありません(別のリモートスパインの少なくとも 1 つと接続された状態にあるため)。

リモートスパインの障害シナリオでのフルメッシュ接続によるトラフィックの回復

注: 上図に示したトラフィックの回復は、リモートスパインで障害が発生するまで、すべての L2/L3 ユニキャストトラフィックと BUM トラフィックが点線に沿って流れていた場合を想定しています。

● 別々のサイトに展開されたスパインは、(論理的または物理的に)直接接続する必要があります。つまり、スパイン間にレイヤ 2 インフラストラクチャを展開できず、ダークファイバまたは DWDM 回線で接続する必要があります。

● EoMPLS 疑似回線も使用できます。別々のサイトにあるスパイン間のポイントツーポイント接続を MPLS コアネットワークにまたがって論理的に拡張できるためです。

Cisco ACI マルチサイトとサイト間トラフィックの暗号化(CloudSec)

異なるデータセンターにまたがってアプリケーション(またはアプリケーション コンポーネント)を展開する場合、サイト間で確立された通信のプライバシーと機密性を確保するために、データセンターのロケーションから送信されるトラフィックをすべて暗号化する必要に迫られることがよくあります。

従来の方法を採用する場合は、データパスにアドホック暗号化デバイスを展開するか、IPsec や MACsec などのネットワークベースのソリューションを有効にすることで、これが達成できます。どのシナリオを採用しても、データセンター間の通信を保護するために、必要な機能を備えた追加のハードウェアを展開する必要があります。

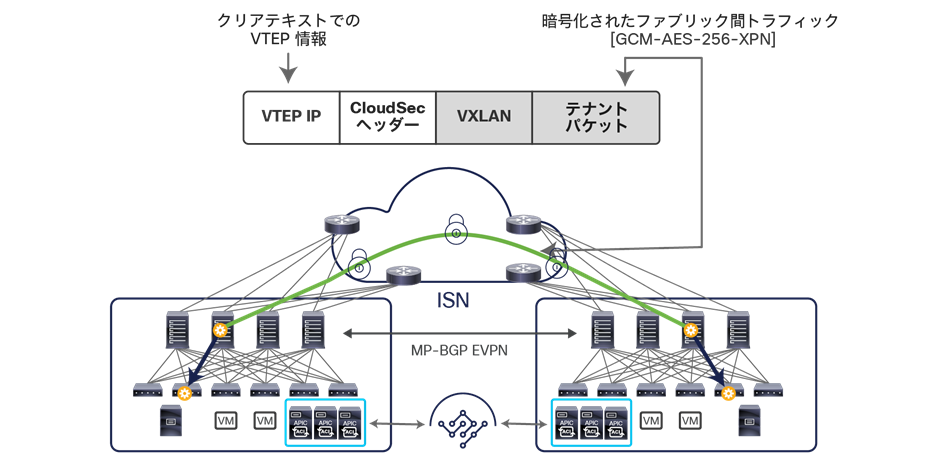

Cisco ACI リリース 4.0(1) では、「CloudSec」と呼ばれるセキュリティソリューションがサポートされています。CloudSec を一種の「マルチホップ MACsec」と考えると、その機能が簡単に理解できます。CloudSec を用いると、汎用的なレイヤ 3 ネットワークを介して接続された 2 つの VTEP デバイス間の通信を暗号化できます。

CloudSec を Cisco ACI マルチサイトアーキテクチャのコンテキストに挿入すると、ローカルスパインを通ってローカルサイトを出るトラフィックおよびローカルスパインからリモートスパインに入るトラフィックをすべて暗号化できます(図 66)。

CloudSec を使用すると、VXLAN ヘッダーを含む元のパケットを暗号化できます。暗号化によってサイト間で送信される各パケットの全体的な MTU サイズが、VXLAN カプセル化による 50 バイトに加えて、CloudSec ヘッダー用にさらに 40 バイト増加します。そのため、ISN の MTU 設定では、この増加も考慮する必要があります。

重要:CloudSec は、Nexus 9000 サイト間ネットワーク(ISN)インフラストラクチャを使用して内部的に検証されています。ISN インフラストラクチャがさまざまなデバイスで構成されている場合、またはデバイスが不明な場合(回線をサービスプロバイダーから購入した場合など)、各ファブリックのスパインとそれらの ISN デバイスとの間に Cisco 1000 シリーズ アグリゲーション サービス ルータ(ASR)を挿入する必要があります。パディングフィックスアップが有効になっている 1000 シリーズ ASR ルータにより、CloudSec トラフィックがサイト間の任意の IP ネットワークを通過できるようになります。

事前共有キーは最初にサポートされた唯一のモデルであり、これを用いることでサイトにまたがって展開されたスパインがトラフィックの暗号化と復号を適切にできるようになります。

この機能は、スパインノードに以下のハードウェアモデルを使用すればラインレートで(つまり、パフォーマンスに影響を与えることなく)実行されます(このホワイトペーパーの執筆時点では、CloudSec をサポートするモデルはこれがすべてです)。

● 9736C-FX シリーズ ラインカードを装着した Cisco Nexus 9500 モジュラスイッチのポート 29 ~ 36

● Cisco Nexus 9364C 非モジュラスイッチのポート 49 ~ 64

● Cisco Nexus 9332C 非モジュラスイッチのポート 25 ~ 32

CloudSec 機能は、スパイン HW モデルとして上に列挙した暗号化対応インターフェイスのいずれかでのみ有効化できます。したがって、サイトにまたがって CloudSec 暗号化が必要な場合は、これらのインターフェイスを使用してスパインを ISN に接続する必要があります。

現在の実装では、暗号スイート GCM-AES-256-XPN(256 ビットキーを使用)がデフォルトとして CloudSec で使用されています。このオプションの構成は不要です。Cisco Nexus 9000 ハードウェアでサポートされている最も自動化された安全なオプションです。

注: Cisco ACI リリース 5.1(1) より前は、サイト間の CloudSec 暗号化は、外部(ルーティング可能)TEP プールと併用できません。この TEP プールは、サイト間 L3Out 機能を有効にするとき、またはリモートリーフノードをマルチサイトドメインに属する ACI ファブリックに接続するときに必要となります。Cisco ACI リリース 5.1(1) 以降はこの制限がなくなったため、外部 TEP プールを展開し、同時に CloudSec 暗号化をオンにすることができます。ただし、別々の ACI ファブリックに接続されている内部エンドポイント間の通信のみが暗号化されます。ファブリック 1 に接続されたエンドポイントがリモートサイトに展開された L3Out 接続を介してこのファブリックの外部のリソースと通信するトラフィック(サイト間 L3Out 機能)の暗号化、または異なるサイトで定義された L3Out に接続されたリソース間のトラフィック(サイト間トランジットルーティング)の暗号化は、Cisco ACI リリース 5.2(4) 以降でサポートされます。

Cisco ACI マルチサイト展開で CloudSec 暗号化を有効にする方法の詳細は、https://www.cisco.com/c/ja_jp/td/docs/dcn/ndo/3x/configuration/cisco-nexus-dashboard-orchestrator-configuration-guide-aci-371/ndo-configuration-aci-infra-cloudsec-37x.html を参照してください。

Cisco ACI マルチサイトのオーバーレイ コントロール プレーン

Cisco ACI ファブリックでは、リーフノードに接続されているすべてのエンドポイントに関する情報は、スパインノードに用意された COOP データベースに保存されます。エンドポイントがリーフノードにローカルで接続されたことが検出されるたびに、そのリーフノードが COOP コントロール プレーン メッセージを発信して、エンドポイント情報(IPv4/IPv6 および MAC アドレス)をスパインノードと共有します。スパインはさらに、COOP を用いてスパイン間でこの情報を同期します。

Cisco ACI マルチサイト展開では、エンドポイント間の水平方向通信を可能にするために、検出されたエンドポイントのホスト情報を別々のファブリックに属するスパインノード間で交換する必要があります。ホスト情報をサイト間で交換する必要があるのは、そのエンドポイントが実際に通信する必要がある場合のみです。サイトにまたがって拡張された EPG に属するエンドポイントの場合(EPG 内の通信はコントラクトの定義がなくてもデフォルトで許可されているため)と、拡張されていない EPG に接続されたエンドポイントが相互の通信を定義済みコントラクトによって許可されている場合が該当します。このように動作を制御することは重要です。これにより、一部のエンドポイントの情報のみがサイトにまたがって同期されるため、サイト全体でサポートできるエンドポイントの総数を増やすことができます。

注: ブリッジドメインレベルでエンドポイント情報の交換を制御できます。したがって、複数の EPG が同じブリッジドメインに属している場合、ポリシーがそれらの EPG の 1 つについてルート情報の交換を指示すると、他のすべての EPG にもエンドポイント情報が送信されます。また、前述のように、優先グループのメンバーとして EPG を展開するか、vzAny を使用して「permit-all」コントラクトのプロバイダーやコンシューマとして設定すると、それらの EPG のメンバーとして検出されたすべてのエンドポイントとホストルート情報を交換できるようになります。

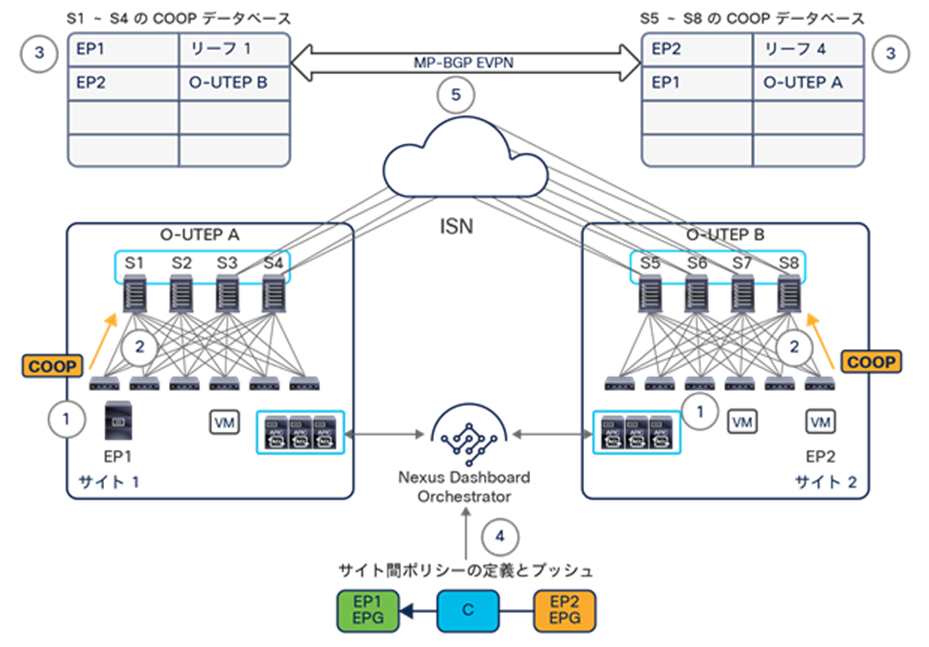

図 67 は、オーバーレイ コントロール プレーンでのイベントのシーケンスについて詳細を示しています。

Cisco ACI マルチサイトのオーバーレイ コントロール プレーン

1. エンドポイント EP1 と エンドポイント EP2 が、それぞれサイト 1 とサイト 2 に接続されます。

2. 各ファブリック内で COOP 通知が生成されます。この通知は、EP1 と EP2 が検出されたリーフノードからローカルスパインノードに送信されます。

3. このエンドポイント情報が、ローカルの COOP データベースに保存されます。サイト 1 のスパインノードは、ローカルに接続されたエンドポイントを認識します。サイト 2 のスパインノードも同様です。この時点では、EP1 EPG と EP2 EPG の情報がサイト間で交換されないことに注意してください。これらのエンドポイントの通信が必要となるポリシーがまだないためです。

4. サイト間ポリシーが、Cisco Nexus Dashboard Orchestrator で定義され、2 つのサイトにプッシュされレンダリングされます。

5. サイト間ポリシーが作成されると、EVPN タイプ 2 更新がサイト間でトリガーされ、EP1 と EP2 のホストルート情報が交換されます。エンドポイント情報は常に O-UTEP アドレスに関連付けられていて、各エンドポイントが検出されたサイトを一義的に識別することに注意してください。したがって、エンドポイントが同じファブリックに属する異なるリーフノード間を移動する場合、追加の EVPN 更新は必要ありません。エンドポイントが別のサイトに移行する際に必要になります。

注:エンドポイントのホストルート情報を交換するために、常に EVPN タイプ 2 更新のみがサイト間で送信されることに注意してください。Cisco ACI マルチサイトの現在の実装では、ブリッジドメインに関連付けられた IP サブネットプレフィックスのサイト間アドバタイズに EVPN タイプ 5 ルート更新を使用しません。接続されたエンドポイントが属する BD がレイヤ 2 で拡張されているか、各サイトでローカルに定義されているかにかかわらず、EVPN タイプ 2 更新が常に使用されます。

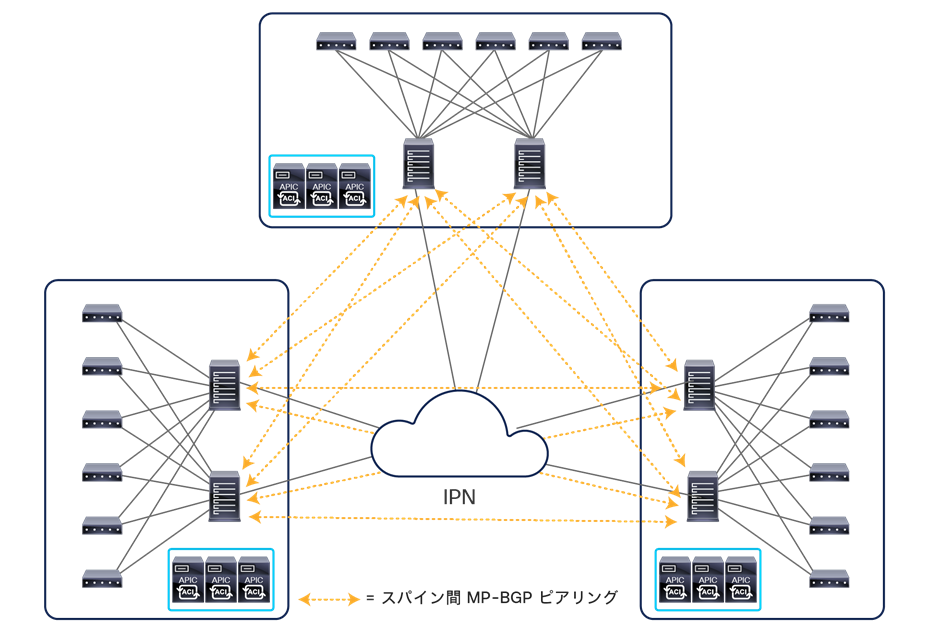

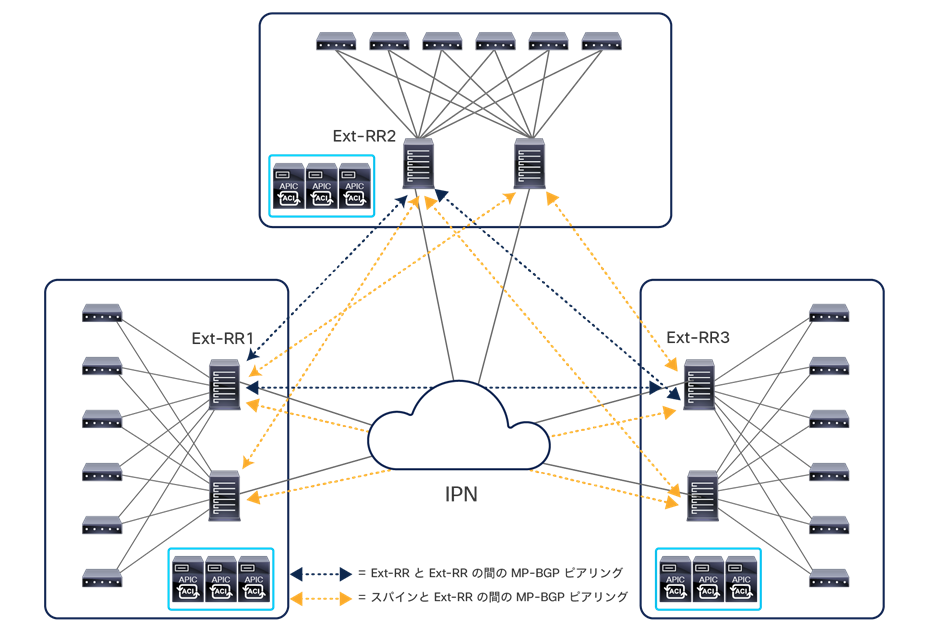

前述のように、EVPN-RID アドレスを使用して、MP-BGP EVPN 隣接関係が、異なるファブリックに属するスパインノード間に確立されます。各サイトが属する BGP 自律システムに応じて、MP 内部 BGP(MP-iBGP)セッションと MP 外部 BGP(MP-eBGP)セッションの両方がサポートされます。eBGP セッションをサイト間に展開すると、隣接関係のフルメッシュが NDO によって自動的に作成されます。すなわち、外部 IP ネットワークに接続されている各サイトのスパインが、すべてのリモートスパインスイッチとの間で EVPN ピアリングを確立します(図 68)。

サイト間で iBGP を使用する場合は、フルメッシュを使用するかルートリフレクタノードを導入するかを選択できます。このノードは、一般的に外部 RR(Ext-RR)と呼ばれます。iBGP を展開する場合でも、デフォルトの動作であるフルメッシュのピアリングを使用することをお勧めします。限られた数のサイト(つまり、20 未満)が相互接続されるのが常であり、拡張性に懸念が生じることはないと予想されるためです。

ただし、ルートリフレクタを導入したい場合は、Ext-RR ノードをいくつか展開し、それぞれのノードを別のサイトに配置することで復元力を確保する必要があります。図 69 に示すように、外部ルートリフレクタノードは相互にピアリングし、すべてのリモートスパインノードともピアリングします。

サイトにまたがる MP-iBGP EVPN 展開での外部ルートリフレクタの使用

内部の実装方法に起因する Ext-RR ノードの展開に関するベストプラクティスの推奨事項は以下のとおりです。

● Ext-RR として構成されていないスパインノードは、常に少なくとも 1 つのリモート Ext-RR ノードとピアリングしている必要があります。スパインは、サイト内で EVPN 隣接関係を確立しません。つまり、Ext-RR ノードとして構成されていないスパインは、常に 2 つのリモート Ext-RR とピアリングしている必要があります(リモート Ext-RR ノードに障害が発生した場合に動作を継続するため)。その結果、サイト間で確立する必要がある EVPN 隣接関係の全体的な数を実質的に減らすことができないため、2 サイトの展開で Ext-RR を構成することはほとんど意味がありません。

● 3 サイト以上の展開の場合、上の図 69 に示すように、最初の 3 つのサイトのみに 1 つの Ext-RR ノードを定義します(合計 3 つの Ext-RR ノード)。

注: 上記で説明した Ext-RR ノードは、別々のサイトに展開されたスパインノード間に MP-BGP EVPN ピアリングを確立するために使用されます。これらのノードの機能は、内部 RR ノードの機能とは異なります。内部 RR ノードは、常に L3Out 論理接続で学習された外部 IPv4/IPv6 プレフィックスを同じファブリックに属するすべてのリーフノードに配布するために展開されます。

Cisco ACI マルチサイトのオーバーレイデータプレーン

サイト間でエンドポイント情報が交換されると、VXLAN データプレーンを使用したレイヤ 2 とレイヤ 3 のサイト間通信が可能になります。この通信を確立する方法を詳しく見ていく前に、レイヤ 2 マルチ宛先トラフィック(通常は BUM と呼ばれます)がサイト間で処理される方法を理解する必要があります。

サイトにまたがるレイヤ 2 BUM トラフィックの処理

VXLAN が展開されている場合、複数のレイヤ 3 ホップで隔てられたエンドポイントが、同じ論理レイヤ 2 ドメインに属しているかのように通信できる、論理的抽象化が可能です。したがって、これらのエンドポイントには、レイヤ 2 マルチ宛先フレームを送信する機能が必要です。このフレームは、実際の物理的な場所に関係なく、同じレイヤ 2 セグメントに接続されている他のすべてのエンドポイントが受信できます。

この機能を実現するには、次の 2 つの方法があります。1 つ目はエンドポイントを相互接続するレイヤ 3 インフラストラクチャによって提供されるネイティブ マルチキャスト レプリケーション機能を使用する方法、2 つ目は送信元 VXLAN TEP(VTEP)デバイスで入力レプリケーション機能を有効にする方法です。後者の方法では、各 BUM フレームのユニキャストのコピーが複数作成され、同じレイヤ 2 ドメインに属するエンドポイントが接続されているすべてのリモート VTEP に送信されます。

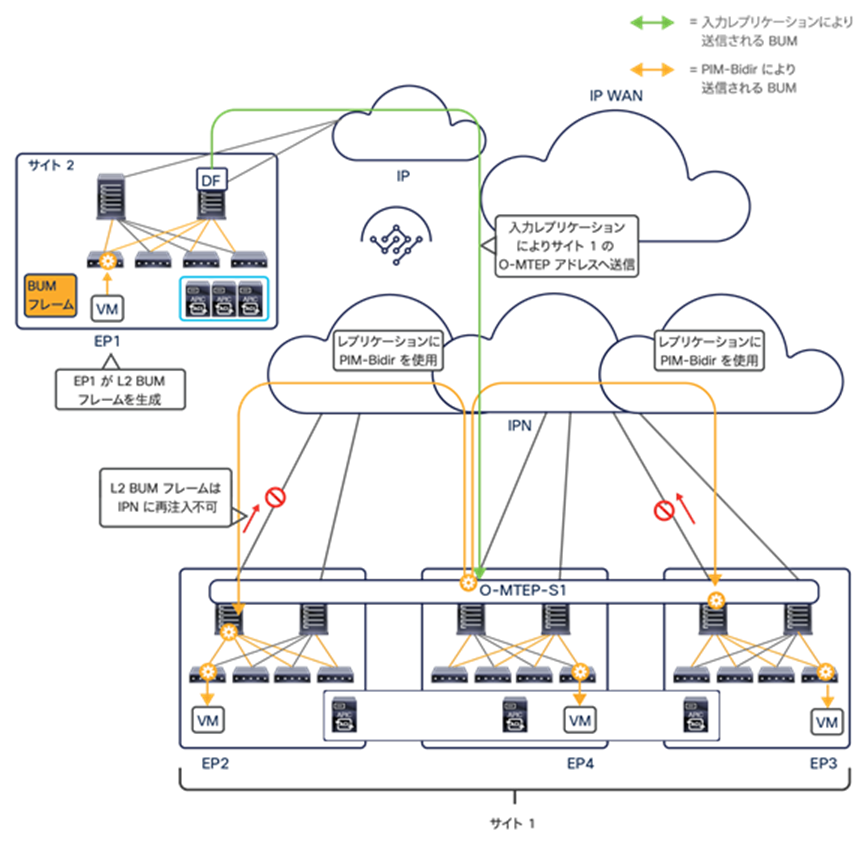

Cisco ACI マルチサイトの設計では、サイト間 BUM 転送にこの 2 つ目のアプローチを採用しており、マルチサイト対応のスパインスイッチが入力レプリケーション機能を実行します。これを採用した理由は、相互接続されたファブリックが世界中に展開される可能性があり、1 つ目のアプローチでは相互接続ネットワーク インフラストラクチャ全体でマルチキャストを適切にサポートすることが困難になるおそれがあるからです(このアプローチは、Cisco ACI マルチポッドアーキテクチャで採用されています)。

サイト間でのレイヤ 2 BUM フレームの送信は、フラッディングが有効な(つまり、[サイト間BUMトラフィック許可(Intersite BUM Traffic Allow)] フラグが設定された)ストレッチブリッジドメインに対してのみ必要です。レイヤ 2 BUM トラフィックには、3 つの異なるタイプがあります。以下では、ブリッジドメインのサイト間で BUM が許可されている場合のサイト間転送動作についてタイプごとに説明します。ここでは、ブリッジドメインの特定の構成ノブが APIC レベルで変更されることはなく、ブリッジドメインの構成は Cisco Nexus Dashboard Orchestrator レベルでのみ制御されると仮定しています。

● レイヤ 2 ブロードキャストフレーム(B):このフレームは、常にサイト間で転送されます。レイヤ 2 ブロードキャスト トラフィックの特殊なタイプとして ARP があります。これについての考慮事項は、「サイト間のサブネット内ユニキャスト通信」セクションを参照してください。

● レイヤ 2 の宛先不明のユニキャストフレーム(U):このフレームは、デフォルトではサイト間でフラッディングされず、ユニキャストモードで転送されます。宛先 MAC がローカルスパインの COOP データベースに登録されていることが前提です(そうでない場合、トラフィックは受信したスパインによってドロップされます)。ただし、Cisco Nexus Dashboard Orchestrator のブリッジドメイン固有の設定で、[宛先不明のL2ユニキャスト(L2 UNKNOWN UNICAST)] トラフィックに関連付けられた [フラッド(flood)] オプションを選択することにより、この動作を変更できます。

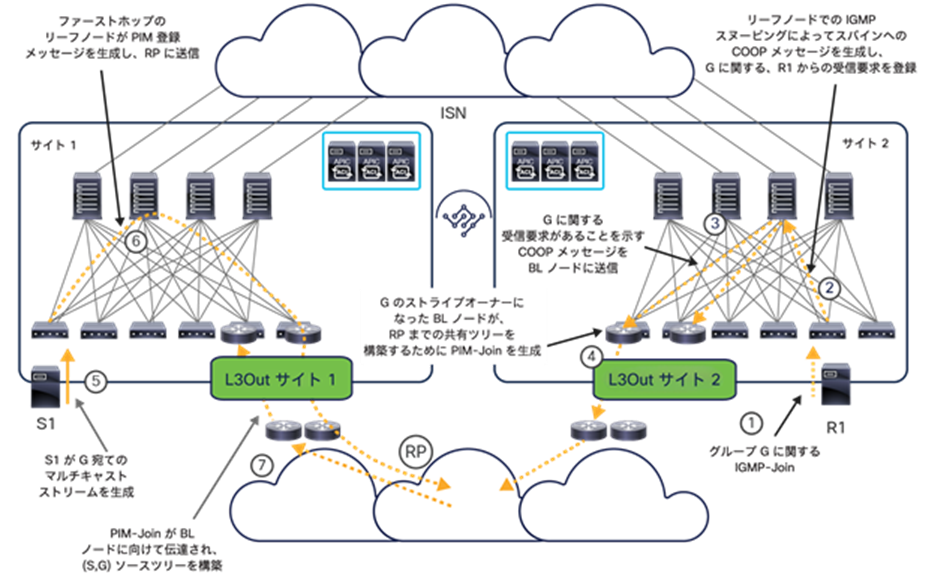

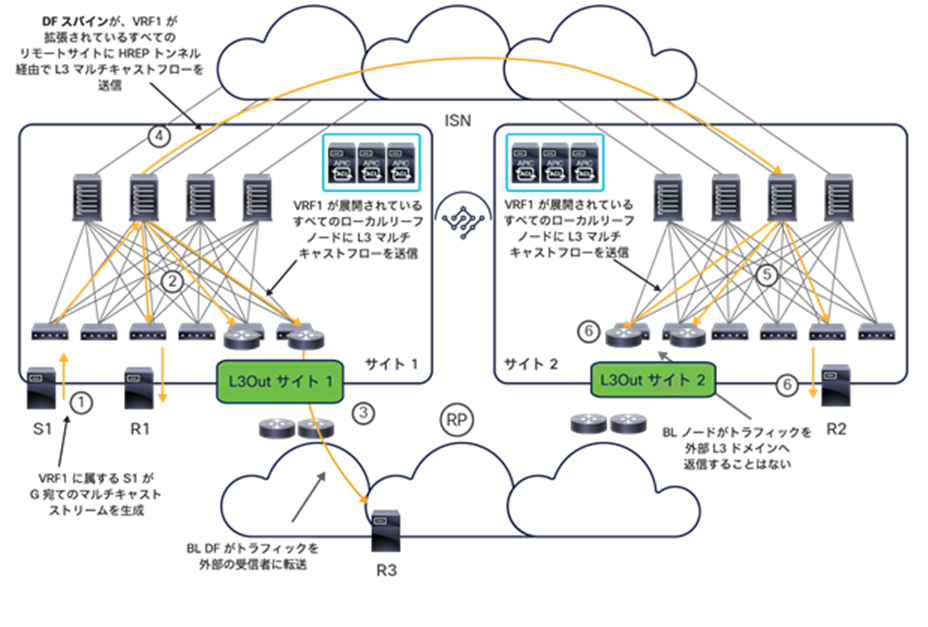

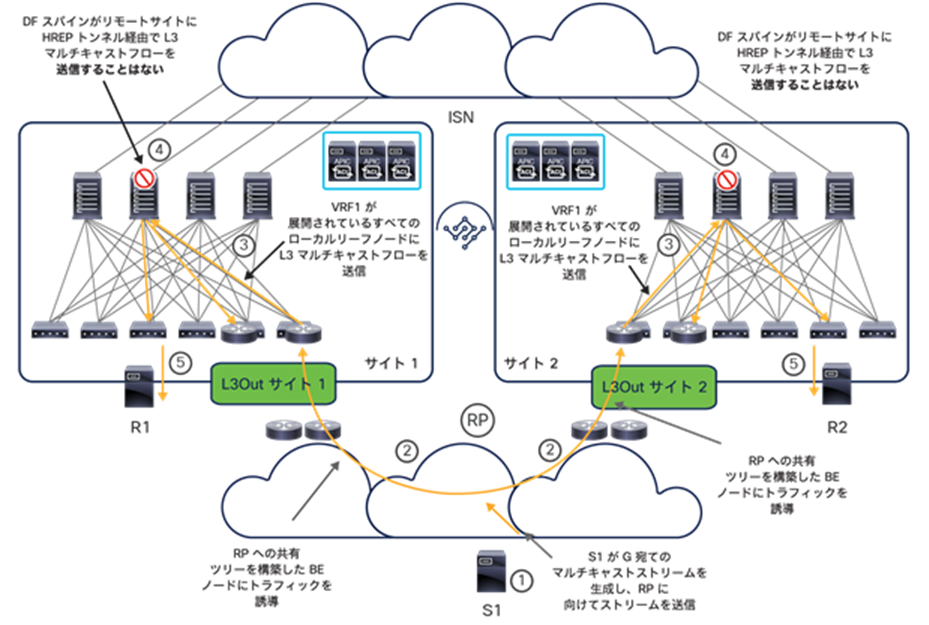

● レイヤ 2 マルチキャストフレーム(M):同じ転送動作が、ブリッジドメイン内の(つまり、送信元と受信者が同じ IP サブネットにあるか、違う IP サブネットにあるが同じブリッジドメインに属する)レイヤ 3 マルチキャストフレーム、または「本当」の(つまり、宛先 MAC アドレスがマルチキャストであり、パケットに IP ヘッダーがない)レイヤ 2 マルチキャストフレームに当てはまります。どちらの場合も、ブリッジドメインが拡張されているサイト間でトラフィックを転送するには、そのブリッジドメインで BUM 転送が有効になっている必要があります。

注:上記の説明は、マルチキャストルーティングが有効になっていない場合を想定しています。Cisco ACI マルチサイトでのマルチキャストルーティングのサポートに関するその他の考慮事項については、「マルチサイトにおけるレイヤ 3 マルチキャスト」セクションを参照してください。

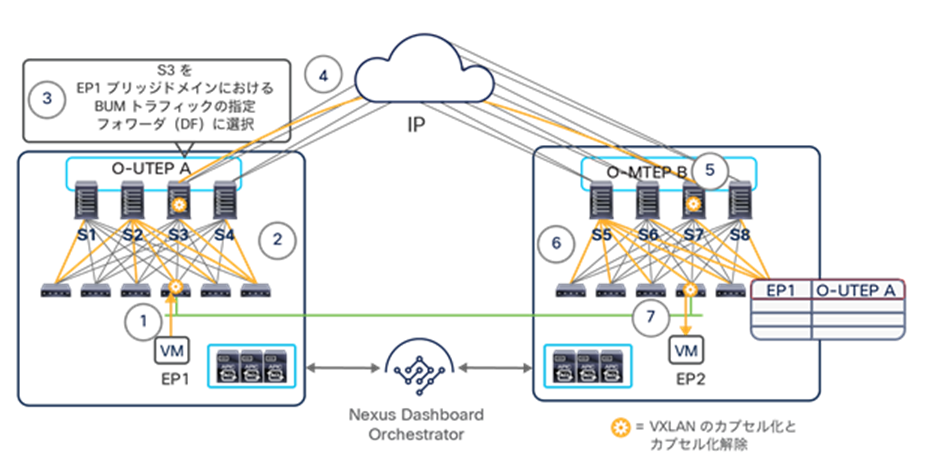

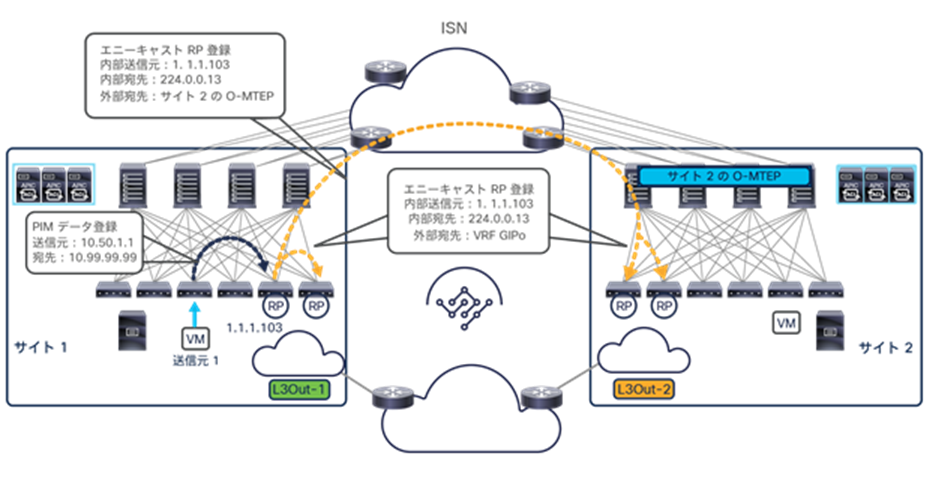

図 70 は、サイト間でレイヤ 2 BUM フレームを送信するために必要なイベントのシーケンスを示しています。

1. あるブリッジドメインに属する EP1 が、レイヤ 2 BUM フレームを生成します。

2. フレームのタイプと、対応するブリッジドメインの設定(上記で説明)によっては、リーフがそのレイヤ 2 ドメインでトラフィックをフラッディングする必要があります。このフレームは、VXLAN カプセル化の後、そのファブリック内でブリッジドメインに関連付けられた GIPo と呼ばれるマルチキャストグループを宛先として、GIPo に関連付けられたマルチ宛先ツリーの 1 つに従って送信されます。これによって、フレームが他のすべてのリーフおよびスパインノードに到達するようになります。

3. 外部のサイト間ネットワークに接続されているスパインノードの 1 つが、そのブリッジドメインの指定フォワーダとして選択されます(この選択は、スパインノード間で IS-IS プロトコル交換を使用して行われます)。指定フォワーダは、そのブリッジドメインの各 BUM フレームを、同じストレッチブリッジドメインを持つすべてのリモートサイトに複製する役割を担っています。

4. 指定フォワーダが、BUM フレームのコピーを作成しリモートサイトに送信します。パケットの VXLAN カプセル化の際に使用される宛先 IP アドレスは、各リモートサイトを識別する特別な IP アドレス(O-MTEP)です。この IP アドレスは、特にサイト間で BUM トラフィックを送信する際に使用されます。O-MTEP は、サイト間ネットワークに接続されているすべてのリモートスパインノードで定義された別のエニーキャスト IP アドレスです(各サイトが、一意の O-MTEP アドレスを使用します)。パケットの VXLAN カプセル化の際に使用される送信元 IP アドレスは、サイト間ネットワークに接続されているすべてのローカルスパインノードに展開されたエニーキャスト O-UTEP アドレスです。

注:O-MTEP(Cisco Nexus Dashboard Orchestrator の GUI では [オーバーレイマルチキャストTEP(Overlay Multicast TEP)] と表示されます)は、さらに別の IP アドレスであり、ファブリックを接続するレイヤ 3 ネットワークに送信する必要があります。

5. リモートスパインノードの 1 つがパケットを受信すると、そのヘッダーに含まれる VNID 値を同じブリッジドメインに関連付けられたローカルで有効な VNID 値に変換し、そのブリッジドメインに対して定義されたローカルのマルチ宛先ツリーの 1 つに従ってトラフィックをサイトに送信します(VXLAN ヘッダー内の宛先として、その BD にローカルで割り当てられたマルチキャストグループが使用されます)。

6. トラフィックがサイト内で転送され、すべてのスパインノードと、このブリッジドメインにアクティブに接続されているエンドポイントを持つリーフノードに到達します。

7. 受信側のリーフノードが、VXLAN ヘッダーに含まれる情報を使用して、BUM フレームを送信したエンドポイント EP1 のサイトのロケーションを学習します。また、このリーフノードは、ブリッジドメインに関連付けられたすべて(または一部)のローカルインターフェイスに BUM フレームを送信し、エンドポイント EP2(この例では)がフレームを受信できるようにします。

前述のように、定義されたブリッジドメインはすべて、マルチキャスト グループ アドレス(またはマルチキャストアドレスのセット)に関連付けられます。これらは通常、GIPo アドレスと呼ばれます。構成されたブリッジドメインの数によっては、同じ GIPo アドレスが、異なるブリッジドメインに関連付けられることがあります。この場合、これらのブリッジドメインの 1 つでフラッディングがサイトにまたがって有効になっていると、同じ GIPo アドレスを使用する他のブリッジドメインの BUM トラフィックもサイト間で送信され、受信したスパインノードでドロップされます。この動作により、サイト間ネットワークの帯域幅使用率が増加する可能性があります。

これを避けるため、ブリッジドメインが Cisco Nexus Dashboard Orchestrator GUI で BUM フラッディングが有効なストレッチドメインとして構成された場合、デフォルトでは、GIPo アドレスがマルチキャストアドレスの別の範囲から割り当てられます。GUI では、[WAN帯域幅の最適化(OPTIMIZE WAN BANDWIDTH)] フラグで設定されます。図 71 に示すように、NDO で直接作成される BD に対してはデフォルトで有効になっています。

ただし、ブリッジドメイン構成が APIC ドメインからインポートされた場合、フラグはデフォルトで無効になっています。手動でブリッジドメインを構成し、すでに関連付けられている GIPo アドレスを変更する必要があります。これを行うと、そのブリッジドメインが展開されているすべてのリーフノードで GIPo アドレスが更新されます。その数秒間、ブリッジドメインのファブリック内 BUM トラフィックが停止することに注意してください。

サイト間のサブネット内 IP 通信を実現するためには、まず送信元エンドポイントと宛先エンドポイント間の ARP 交換を完了する必要があります。前述のように、ARP は特殊なタイプのレイヤ 2 ブロードキャスト トラフィックであり、サイト間の転送はブリッジドメインレベルで制御できます。

注: 以下の説明では、ブリッジドメインが単一の IP サブネットに関連付けられていることを想定としていますが、同じブリッジドメインに対して複数のサブネットが定義されているシナリオもあり得ます。

考慮すべきシナリオは以下の 2 つです。

● ブリッジドメインで ARP フラッディングが有効:Cisco Nexus Dashboard Orchestrator で BUM 転送が有効なストレッチブリッジドメインを作成した場合のデフォルト設定です。この場合、前のセクションで説明した動作(図 70)と同一の動作になります。ARP 要求がリモートサイトの宛先エンドポイントに到達し、リモートリーフノードが送信元エンドポイントのサイトのロケーションを学習します。その結果、ARP ユニキャスト応答が VXLAN カプセル化されて、EP1 サイトを識別する O-UTEP アドレスに直接送信されます。これを受信したスパインノードの 1 つが VNID とクラス ID の変換を実行し、EP1 が接続されているローカルリーフノードにそのフレームを送信します(図 72)。

ARP 応答を受信することで、サイト 1 のリーフノードが EP2 のサイトの情報を学習できることに注意してください(EP2 は、EP2 サイトのスパインノードを識別する O-UTEP B アドレスに関連付けられています)。

注:ブリッジドメインの ARP フラッディングを有効にし(APIC レベルで)、対応する BUM 転送を有効にしないのは設定不備です。この設定では、サイト間の ARP 交換が完了できず、サイト間のブリッジドメイン内接続が切断されます。このような問題を防ぐために、Nexus Dashboard Orchestrator でのみ BD 転送特性を設定することを強くお勧めします。

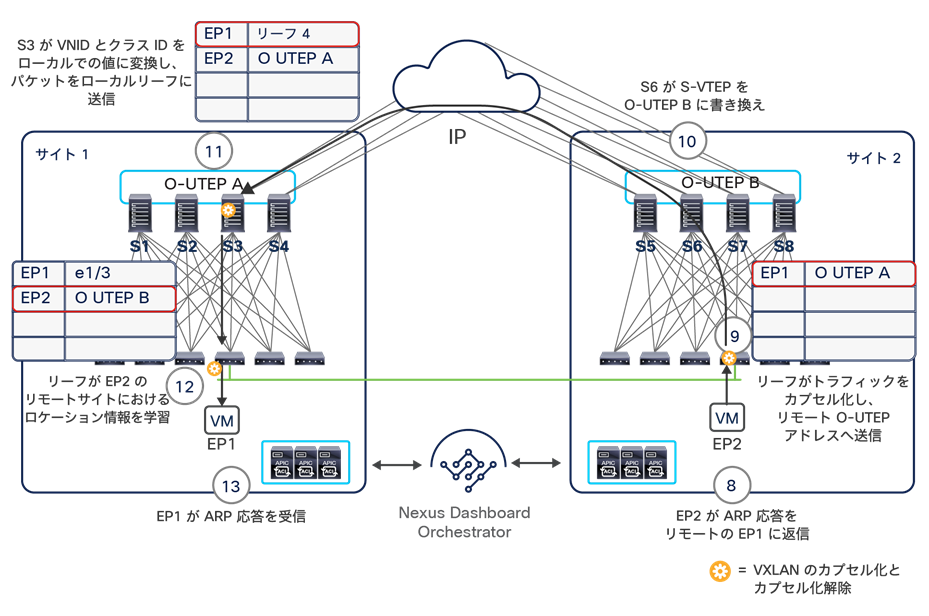

● ブリッジドメインで ARP フラッディングが無効:Cisco Nexus Dashboard Orchestrator で BUM 転送が無効なストレッチブリッジドメインを作成した場合のデフォルト設定です。この場合、ローカルスパインが受信した ARP 要求はサイト間でフラッディングできないため、VXLAN ユニキャストパケットへのカプセル化が必要です(図 73)。

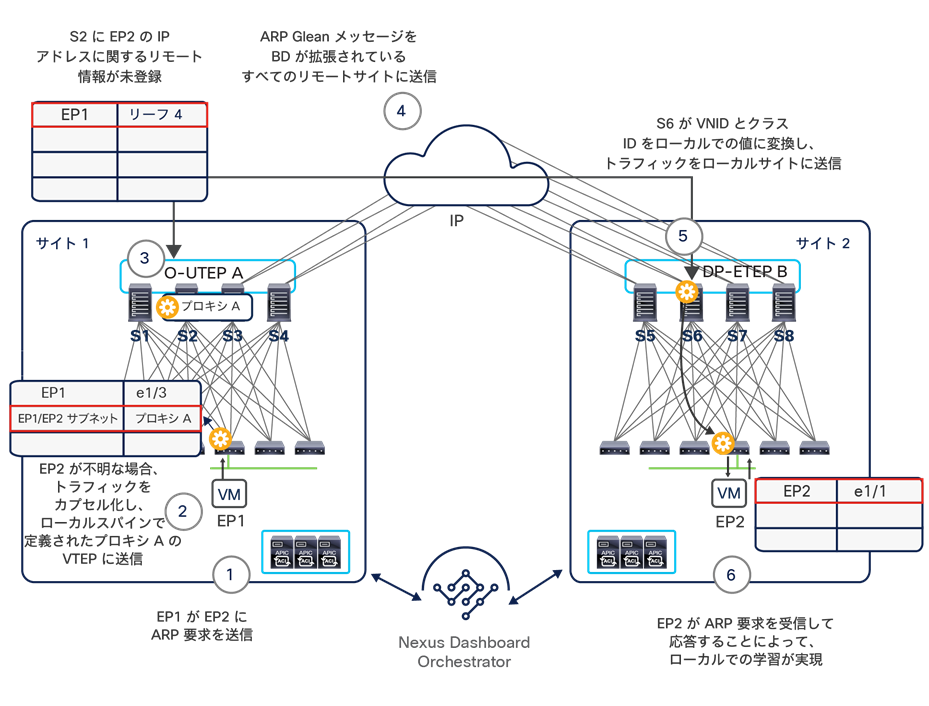

以下は、このユースケースでサイト 2 に ARP 要求を送信するために必要な一連のステップです。

1. EP1 が EP2 の IP アドレスの ARP 要求を生成します。

2. ローカルリーフノードが ARP ペイロードを検査し、宛先である EP2 の IP アドレスを決定します。最初に EP2 の IP 情報がローカルリーフで見つからなかった場合、COOP データベースでルックアップを実行するために、ARP 要求がカプセル化されてすべてのローカルスパインで定義されたプロキシ A のエニーキャスト VTEP アドレスに送信されます(ローカル ルーティング テーブルにインストールされているパーベイシブ EP1/EP2 IP サブネット情報が使用されます)。

3. ローカルスパインノードの 1 つが、ローカルリーフノードから ARP 要求を受信します。

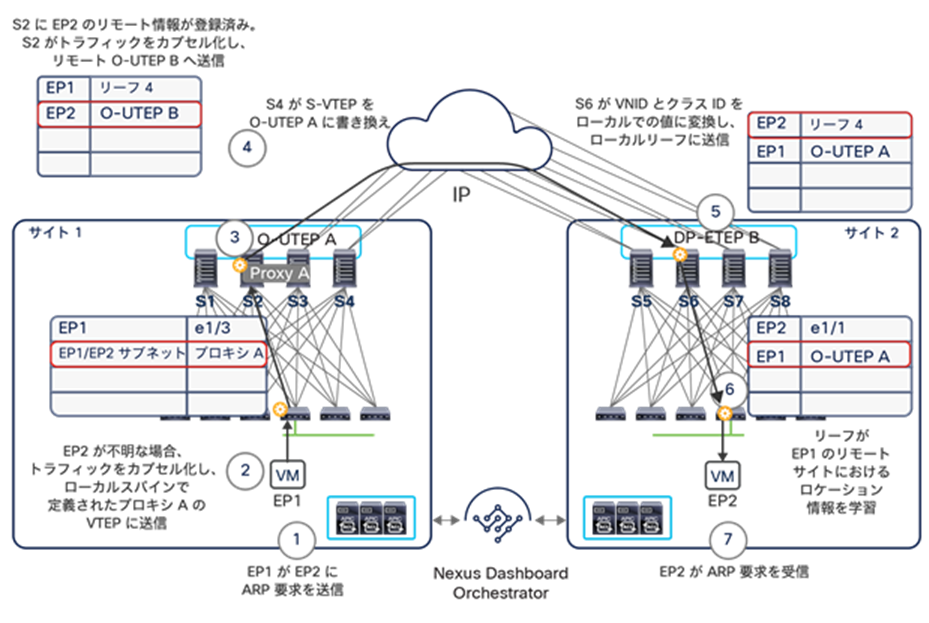

4. サイト間で「ユニキャストモード」を用いて ARP 要求を転送できるかどうかは、主にリモートエンドポイントの IP アドレスに関する情報(リモートスパインから MP-BGP EVPN コントロールプレーン経由で受信)が COOP データベースにあるかどうかに依存します。まず、リモートエンドポイントの IP アドレスがわかっている(つまり、EP2 が「サイレントホスト」ではない)場合は、EP2 が接続されているサイトを識別するリモート O-UTEP アドレスをローカルスパインノードが知っているため、パケットをカプセル化して ISN を介してリモートサイトに送信できます。スパインが VXLAN カプセル化パケットの送信元 IP アドレスも書き換えることに注意してください。リーフノードの VTEP アドレスがローカルサイトを識別するローカル O-UTEP A アドレスに置き換えられます。この動作は非常に重要です。サイト間の EVPN コントロールプレーンでのやり取りで説明したように、外部 IP ネットワークが認識するスパインノードの IP アドレスを、EVPN-RID、O-UTEP、O-MTEP に限定する必要があるためです。

5. この VXLAN フレームがリモートスパインノードの 1 つで受信されます。このノードが元の VNID とクラス ID をローカルで有効な値に変換し、ARP 要求をカプセル化したうえで、EP2 が接続されているローカルリーフノードに送信します。

6. リーフノードがフレームを受信してカプセル化を解除し、リモートエンドポイント EP1 のクラス ID とサイトのロケーションの情報を学習します。

7. 次に、EP2 を学習しているインターフェイスからこのフレームが送信され、エンドポイントに到達します。

この時点で、EP2 がユニキャスト ARP 応答を返信できるようになります。この応答は、図 72 で説明したのと同じ一連のステップで EP1 に配信されます(唯一の違いは、サイト間でフラッディングが有効になっていないことです)。

前のステップ 4 でリモートエンドポイントの IP アドレスがサイト 1 の COOP データベースになかった場合、Cisco ACI リリース 3.2(1) 以降導入された新しい「ARP Glean」機能が、リモートの「サイレントホスト」に ARP 要求の受信と応答を促し、リモートサイトで検出できるようします(下の図 74)。

注: 「ARP Glean」メッセージは、ブリッジドメインに関連付けられたエニーキャストゲートウェイ IP アドレスから発信されます。つまり、ARP 応答は EP2 が接続されているリーフノードによって常にローカルで消費されます。しかし、このプロセスによって EP2 が検出できるようになります(この時点で「サイレント」ではなくなっています)。

サブネット内通信のユースケースにおける ARP Glean 機能

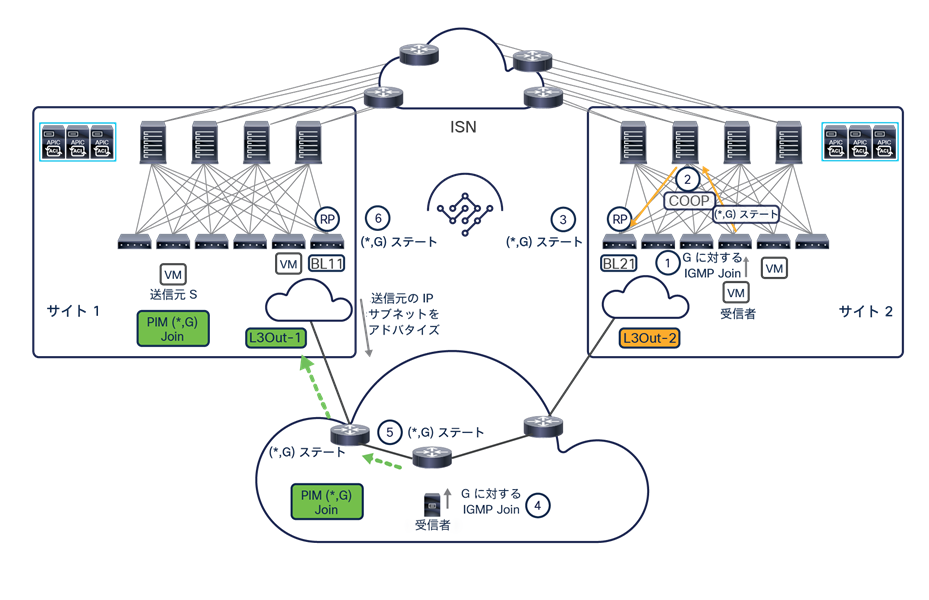

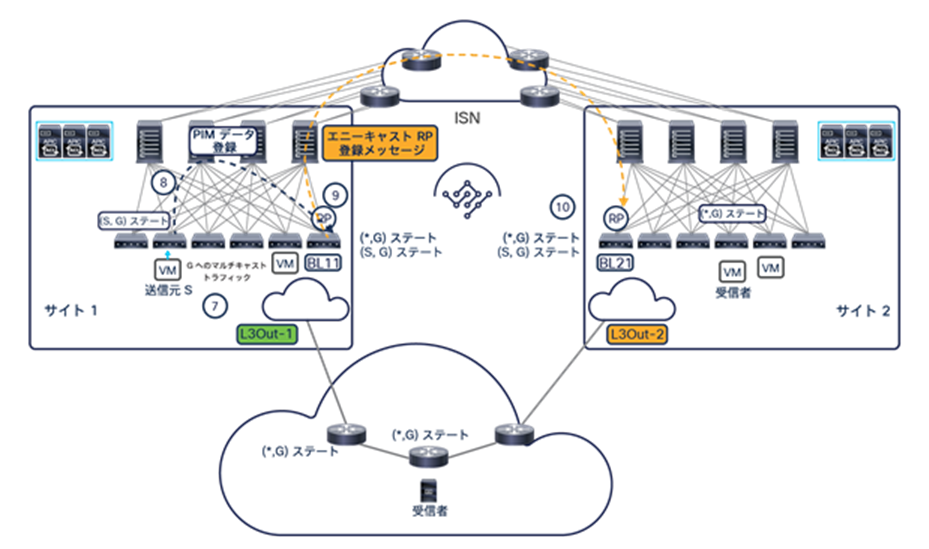

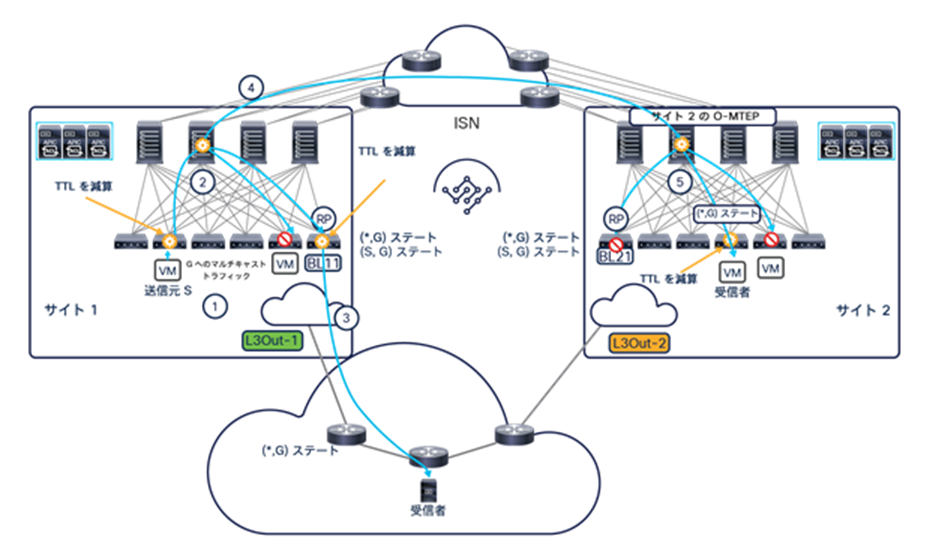

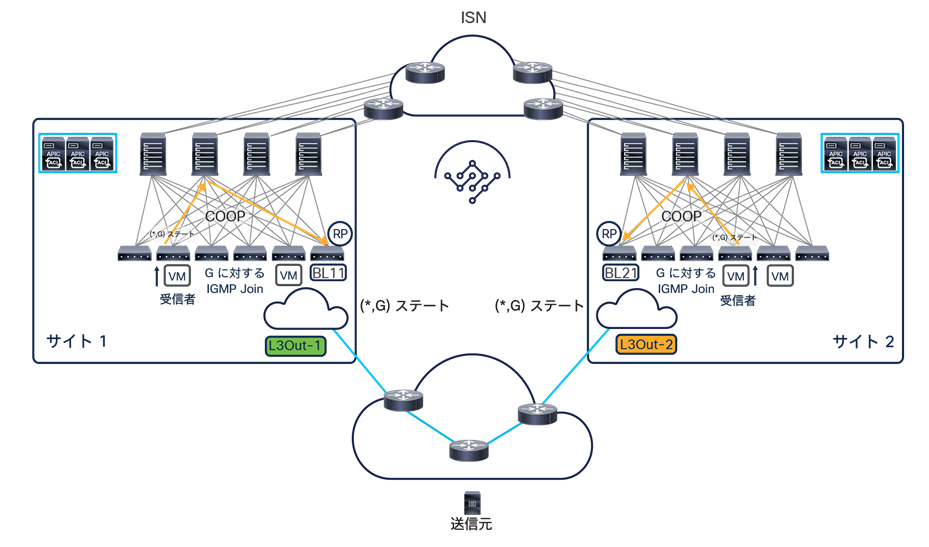

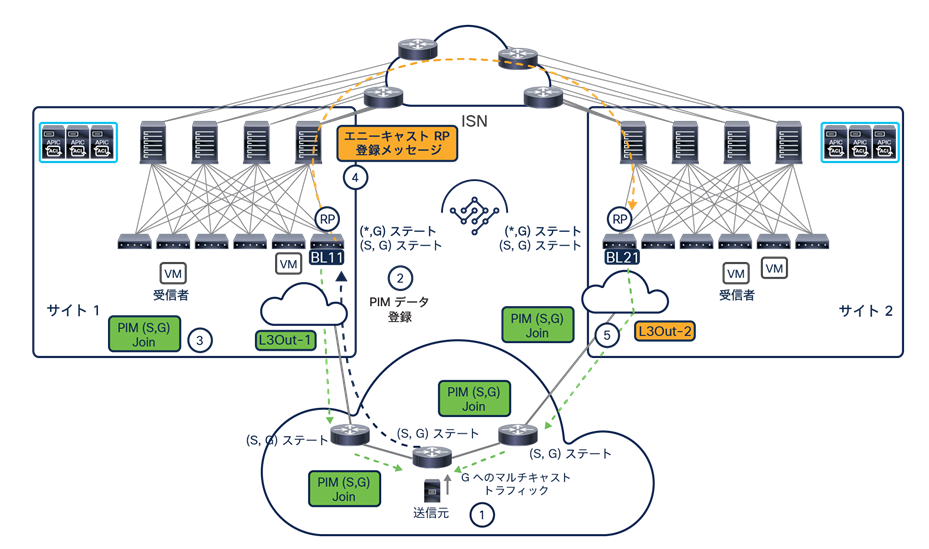

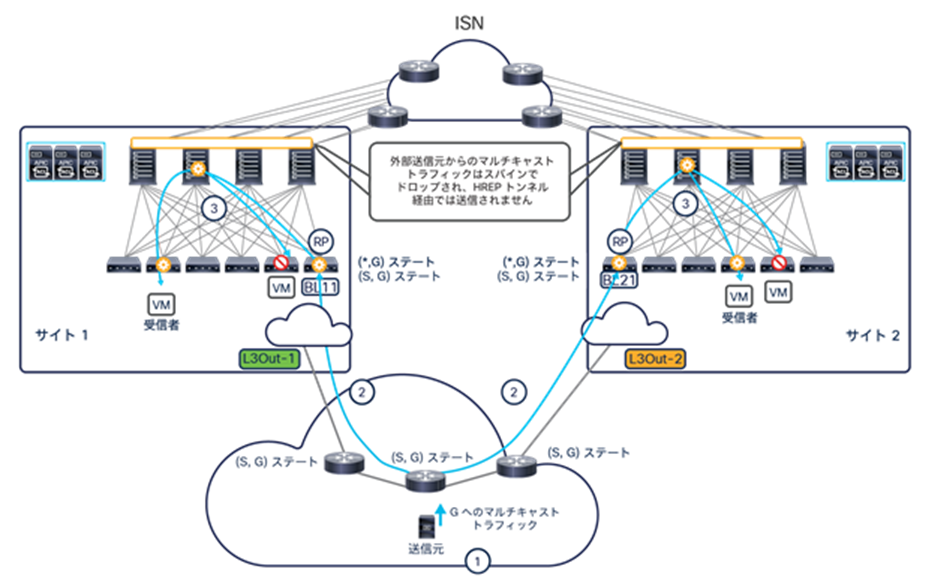

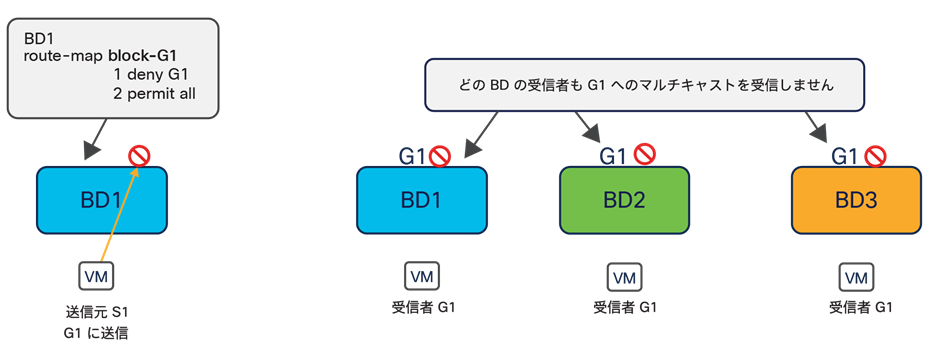

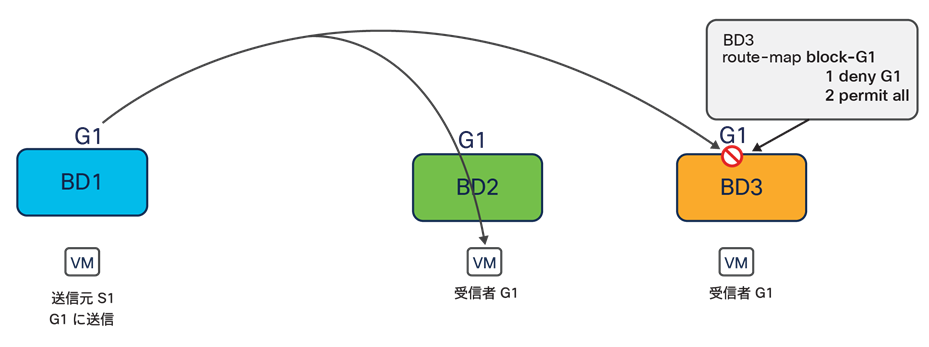

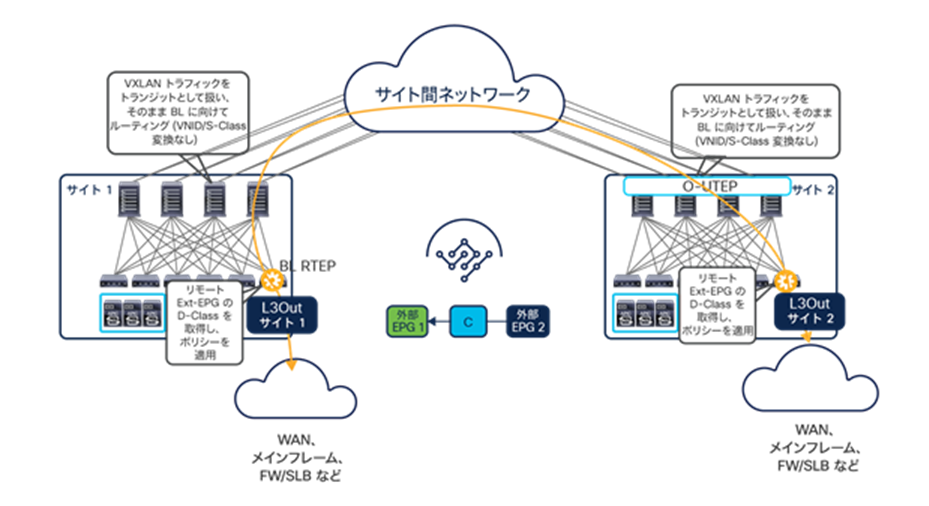

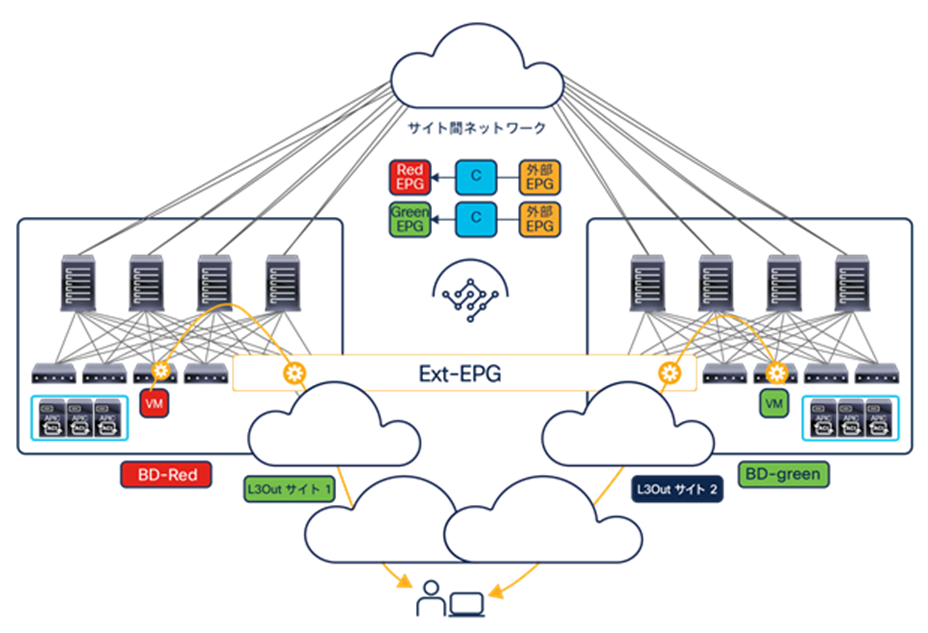

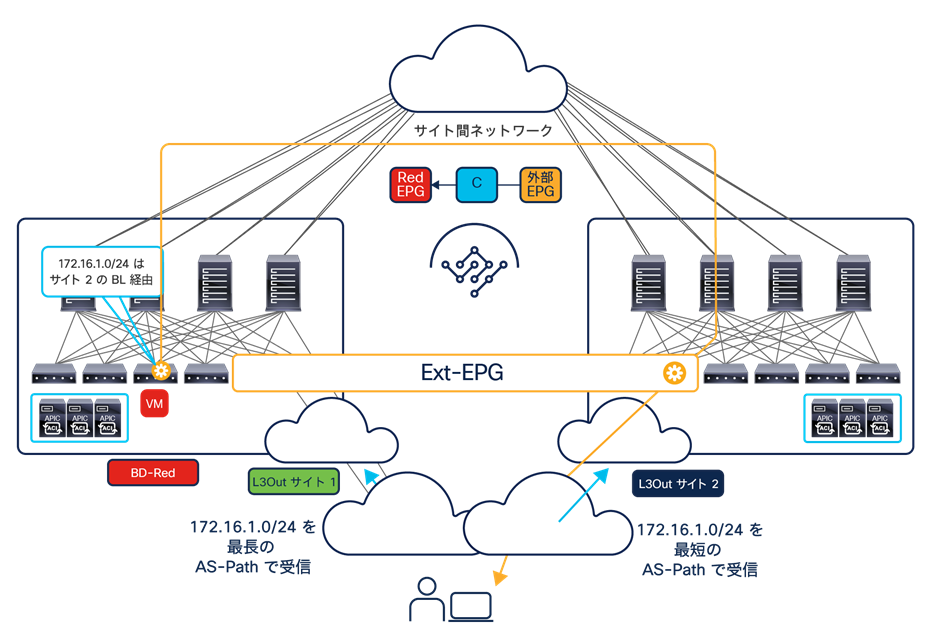

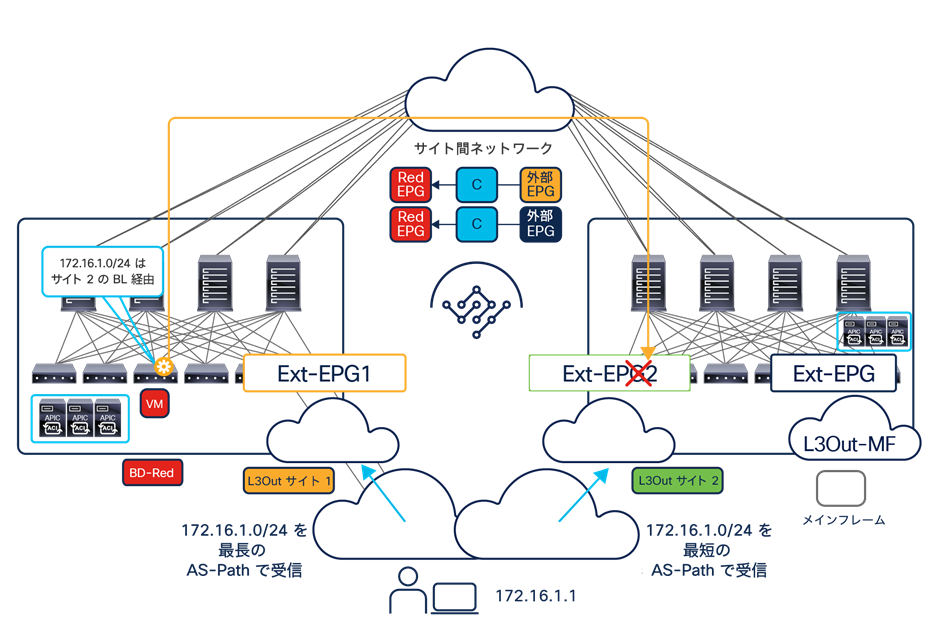

リモートエンドポイントの IP アドレスが検出され、EVPN コントロールプレーンを介してサイト間で共有されると、図 73 に示したように、EP1 によって発信された ARP 要求が、EP2 に向けてユニキャストモードで送信できるようになります。