ASAv on KVM 准则和限制

根据所需部署的实例数量和使用要求,ASAv 部署所使用的具体硬件可能会有所不同。创建的每台虚拟设备都需要主机满足最低资源配置要求,包括内存、CPU 数量和磁盘空间。

重要 |

ASAv 部署时的磁盘存储大小为 8GB。无法更改磁盘空间的资源配置。 |

在部署 ASAv 之前,请查看以下准则和限制。

ASAv on KVM 系统要求

请确保遵循以下规范,以确保最佳性能。ASAv 有以下要求:

-

主机 CPU 必须是包含虚拟化扩展的基于 x86 的服务器类 Intel 或 AMD CPU。

例如,ASAv 性能测试实验室最少使用以下设备:使用以 2.6GHz 运行的 Intel® Xeon® CPU E5-2690v4 处理器的 Cisco Unified Computing System™ (Cisco UCS®) C 系列 M4 服务器。

建议的 vNIC

推荐使用以下 vNIC 以获得最佳性能。

-

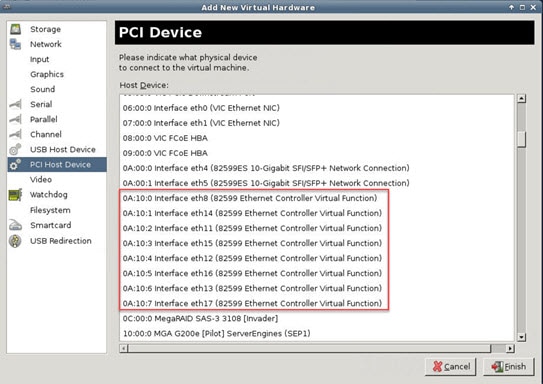

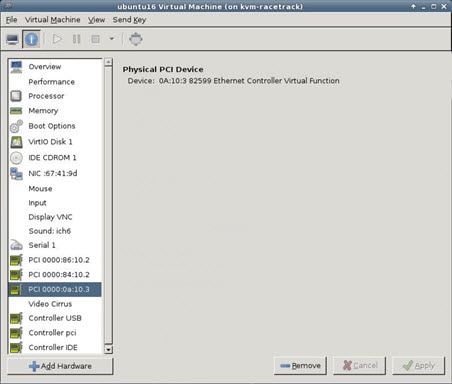

PCI 直通中的 i40e - 将服务器的物理 NIC 指定给 VM,并通过 DMA(直接内存访问)在 NIC 与 VM 之间传输数据包数据。移动数据包不需要任何 CPU 周期。

-

i40evf/ixgbe-vf - 基本同上(在 NIC 与 VM 之间传输 DMA 数据包),但允许在多个 VM 之间共享 NIC。SR-IOV 通常是首选的,因为它具有更多部署灵活性。请参阅

-

virtio - 这是并行虚拟化的网络驱动程序,支持 10Gbps 操作,但也需要 CPU 周期。

性能优化

为实现 ASAv 的最佳性能,您可以对 VM 和主机进行调整。有关详细信息,请参阅ASAv on KVM 的性能调整。

-

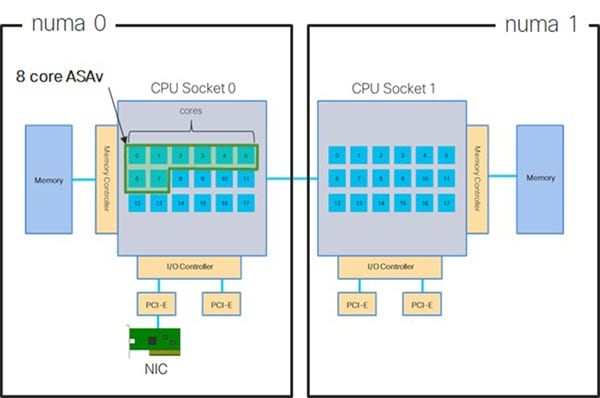

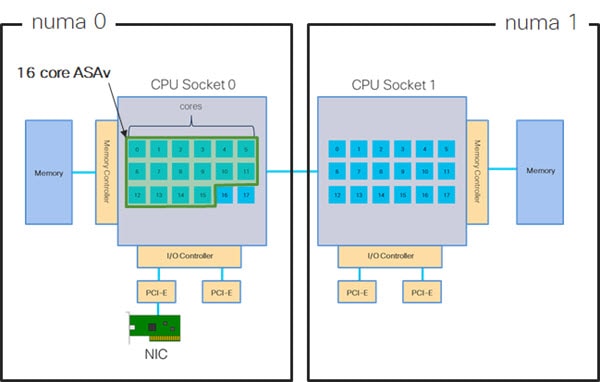

NUMA - 您可以通过将来宾 VM 的 CPU 资源隔离到单一非一致内存访问 (NUMA) 节点来提高 ASAv 的性能。有关详细信息,请参阅NUMA 准则。

-

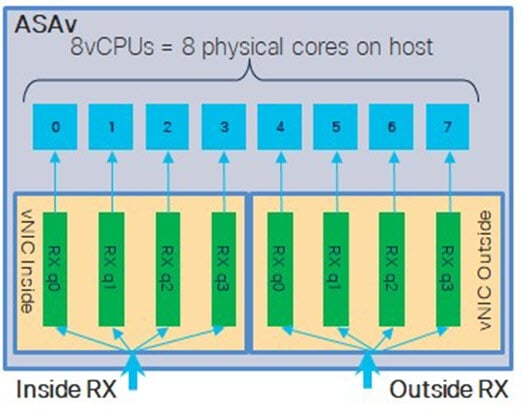

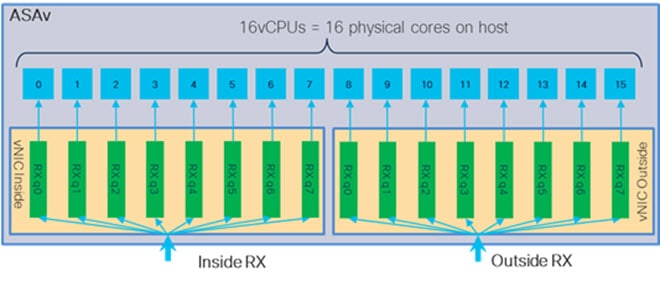

接收端扩展 - ASAv 支持接收端扩展 (RSS),网络适配器利用这项技术将网络接收流量分发给多个处理器内核。有关详细信息,请参阅用于接收端扩展 (RSS) 的多个 RX 队列。

-

VPN 优化 - 有关使用 ASAV 优化 VPN 性能的其他注意事项,请参阅VPN 优化。

CPU 固定

要使 ASAv 在 KVM 环境中正常工作,需要 CPU 固定;请参阅启用 CPU 固定功能。

通过故障切换实现高可用性准则

对于故障切换部署,请确保备用设备具有相同的许可证权限;例如,两台设备均应具备 2Gbps 权限。

重要 |

使用 ASAv 创建高可用性对时,需要按相同顺序将数据接口添加到每个 ASAv。如果将完全相同的接口添加到每个 ASAv,但顺序不同,ASAv 控制台上可能会显示错误。故障切换功能可能也会受到影响。 |

Proxmox VE 上的 ASAv

Proxmox 虚拟环境 (VE) 是可以管理 KVM 虚拟机的开源服务器虚拟化平台。Proxmox VE 还提供基于 Web 的管理界面。

在 Proxmox VE 上部署 ASAv 时,需要配置 VM 以拥有模拟串行端口。如果没有串行端口,ASAv 会在启动过程中进入环路。所有管理任务均可使用 Proxmox VE 基于 Web 的管理界面来完成。

注 |

对于习惯使用 Unix shell 或 Windows Powershell 的高级用户,Proxmox VE 提供了一个命令行界面来管理虚拟环境的所有组件。此命令行界面具有智能制表符补全和 UNIX 手册页形式的完整文档。 |

要让 ASAv 正常启动,虚拟机需要配置串行设备:

-

在主管理中心中,在左侧导航树中选择 ASAv VM。

-

断开虚拟机电源。

-

依次选择并添加串行端口。

-

接通虚拟机电源。

-

使用 Xterm.js 访问 ASAv VM。

有关如何在访客/服务器上设置和激活终端的信息,请参阅 Proxmox 串行终端 (Serial Terminal) 页面。

反馈

反馈