KVM 지침 및 제한 사항에서의 ASA 가상

ASA 가상 구축에 사용되는 특정 하드웨어는 구축된 인스턴스 수 및 사용 요구 사항에 따라 달라질 수 있습니다. 생성하는 각 가상 어플라이언스는 호스트 머신에서 최소 리소스 할당(메모리, CPU 수 및 디스크 공간)을 필요로 합니다.

중요사항 |

ASA 가상는 8GB 디스크 스토리지 크기로 구축됩니다. 디스크 공간의 리소스 할당은 변경할 수 없습니다. |

ASA 가상을 구축하기 전에 다음 지침 및 제한 사항을 검토하십시오.

KVM 시스템 요구 사항에서의 ASA 가상

최적의 성능을 보장하려면 아래 사양을 준수해야 합니다. ASA 가상에는 다음 요구 사항이 적용됩니다.

-

호스트 CPU는 가상화 확장을 사용하는 서버 클래스 x86 기반 Intel 또는 AMD CPU여야 합니다.

예를 들어 ASA 가상 성능 테스트 랩에서는 2.6GHz에서 실행되는 Intel® Xeon® CPU E5-2690v4 프로세서를 사용하는 Cisco UCS®(Unified Computing System™) C 시리즈 M4 서버가 최소 요구 사항입니다.

권장 vNIC

최적의 성능을 위해 다음 vNIC를 사용하는 것이 좋습니다.

-

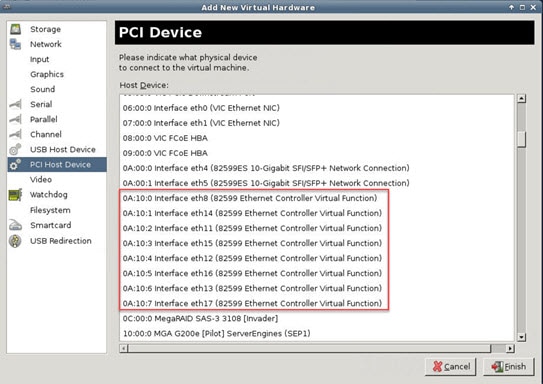

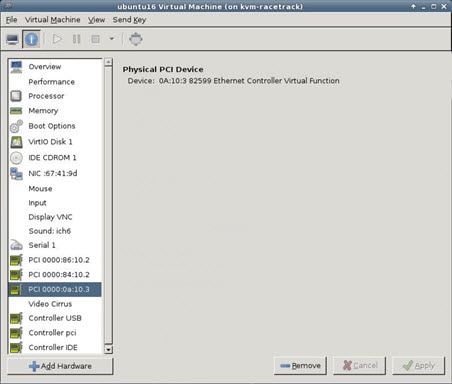

PCI 패스스루의 i40e - 서버의 물리적 NIC를 VM 전용으로 지정하고 DMA(Direct Memory Access)를 통해 NIC와 VM 간에 패킷 데이터를 전송합니다. 패킷 이동에는 CPU 사이클이 필요하지 않습니다.

-

i40evf/ixgbe-vf - 위와 사실상 동일하지만(NIC와 VM 간의 DMA 패킷) 여러 VM에서 NIC를 공유할 수 있습니다. 뛰어난 구축 유연성 때문에 일반적으로 SR-IOV를 선호합니다. 확인

-

virtio - 10Gbps 작업을 지원하지만 CPU 사이클이 필요한 반가상화 네트워크 드라이버입니다.

참고 |

KVM 시스템에서 실행 중인 ASA 가상 인스턴스는 vNIC 드라이버 i40e 버전 2.11.25를 사용하는 SR-IOV 인터페이스에서 데이터 연결 문제가 발생할 수 있습니다. 이 문제를 해결하려면 vNIC 버전을 다른 버전으로 업그레이드하는 것이 좋습니다. |

성능 최적화

ASA 가상에서 최상의 성능을 얻으려면 VM과 호스트를 모두 조정할 수 있습니다. 자세한 내용은 KVM의 ASA 가상에 대한 성능 조정를 참조하십시오.

-

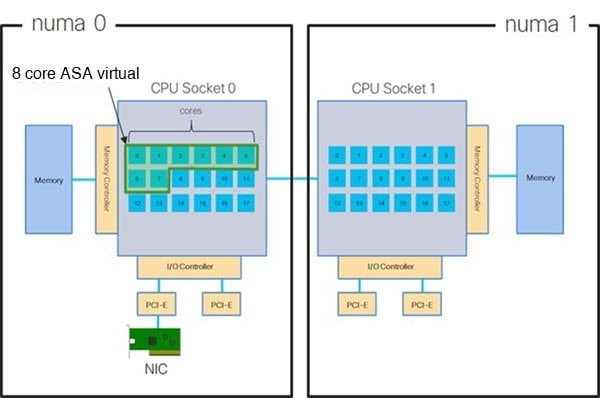

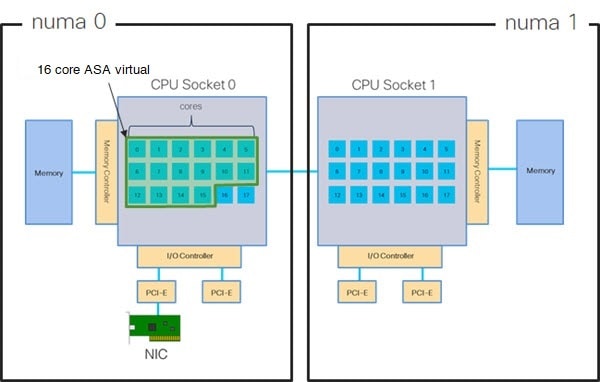

NUMA - 게스트 VM의 CPU 리소스를 단일 NUMA(Non-Uniform Memory Access) 노드로 격리하면 ASA 가상 성능을 개선할 수 있습니다. 자세한 내용은 NUMA 지침를 참조하십시오.

-

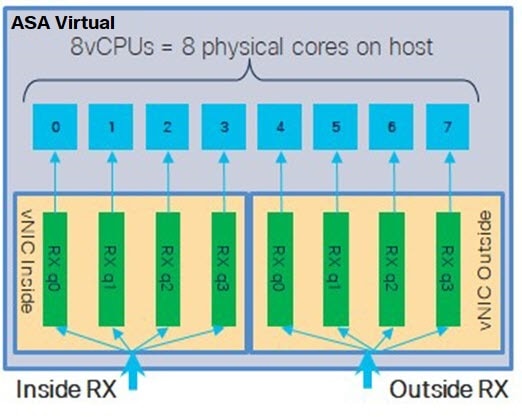

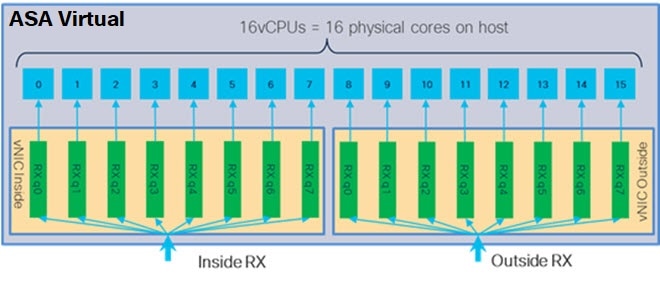

Receive Side Scaling — ASA 가상는 RSS(Receive Side Scaling)를 지원합니다. RSS는 네트워크 수신 트래픽을 여러 프로세서 코어로 분산하기 위해 네트워크 어댑터에서 활용하는 기술입니다. 자세한 내용은 RSS(Receive Side Scaling)를 위한 다중 RX 대기열를 참조하십시오.

-

VPN 최적화 - ASA 가상을 사용한 VPN 성능 최적화를 위한 추가 고려 사항은 VPN 최적화를 참조하십시오.

클러스터링

버전 9.17부터는 KVM에 구축된 ASA 가상 인스턴스에서 클러스터링이 지원됩니다. 자세한 내용은 ASAv용 ASA 클러스터를 참조하십시오.

CPU 고정

ASA 가상이 KVM 환경에서 작동하려면 CPU 고정이 필요합니다. CPU 피닝 활성화를 참조하십시오.

고가용성을 위한 장애 조치 지침

장애 조치 구축의 경우, 대기 유닛에 동일한 라이선스 엔타이틀먼트가 있는지 확인합니다. 예를 들어 두 유닛 모두 2Gbps 엔타이틀먼트가 있어야 합니다.

중요사항 |

ASA 가상을 이용해 고가용성 쌍을 만들 때는 동일한 순서로 각 ASA 가상에 데이터 인터페이스를 추가해야 합니다. 각 ASA 가상에 동일한 인터페이스를 추가했지만 순서가 다른 경우 ASA 가상 콘솔에서 오류가 나타날 수 있습니다. 장애 조치 기능도 영향을 받을 수 있습니다. |

Proxmox VE에서의 ASA 가상

Proxmox VE(Virtual Environment)는 KVM 가상 머신을 관리할 수 있는 오픈 소스 서버 가상화 플랫폼입니다. Proxmox VE는 웹 기반 관리 인터페이스도 제공합니다.

Proxmox VE에서 ASA 가상을 구축할 때는 에뮬레이션된 시리얼 포트를 갖도록 VM을 구성해야 합니다. 시리얼 포트가 없으면 ASA 가상은 부팅 프로세스 중에 루프에 빠집니니다. 모든 관리 작업은 Proxmox VE 웹 기반 관리 인터페이스를 사용하여 수행할 수 있습니다.

참고 |

Unix 쉘 또는 Windows Powershell에 익숙한 고급 사용자를 위해, Proxmox VE는 가상 환경의 모든 구성 요소를 관리할 수 있는 명령줄 인터페이스를 제공합니다. 이 명령줄 인터페이스는 지능형 탭 완성 기능과 UNIX 매뉴얼 페이지 형식의 전체 설명서를 제공합니다. |

ASA 가상이 올바르게 부팅하려면 VM에 시리얼 디바이스가 구성되어 있어야 합니다.

-

기본 관리 센터의 왼쪽 탐색 트리에서 ASA 가상 머신을 선택합니다.

-

가상 머신의 전원을 끕니다.

-

를 선택하고 시리얼 포트를 추가합니다.

-

가상 머신을 켭니다.

-

Xterm.js를 사용하여 ASA 가상 머신에 액세스합니다.

게스트/서버에서 터미널을 설정하고 활성화하는 자세한 방법은 Proxmox Serial Terminal(시리얼 터미널) 페이지를 참조하십시오.

피드백

피드백