Cisco Nexus 9000 スイッチを使用した AI インフラストラクチャ

偏向のない言語

この製品のドキュメントセットは、偏向のない言語を使用するように配慮されています。このドキュメントセットでの偏向のない言語とは、年齢、障害、性別、人種的アイデンティティ、民族的アイデンティティ、性的指向、社会経済的地位、およびインターセクショナリティに基づく差別を意味しない言語として定義されています。製品ソフトウェアのユーザインターフェイスにハードコードされている言語、RFP のドキュメントに基づいて使用されている言語、または参照されているサードパーティ製品で使用されている言語によりドキュメントに例外が存在する場合があります。シスコのインクルーシブ ランゲージの取り組みの詳細は、こちらをご覧ください。

翻訳について

このドキュメントは、米国シスコ発行ドキュメントの参考和訳です。リンク情報につきましては、日本語版掲載時点で、英語版にアップデートがあり、リンク先のページが移動/変更されている場合がありますことをご了承ください。あくまでも参考和訳となりますので、正式な内容については米国サイトのドキュメントを参照ください。

NVIDIA HGX™ H200 および NVIDIA Spectrum™-X を搭載した Cisco UCS® C885A M8 ラック サーバを特徴としています

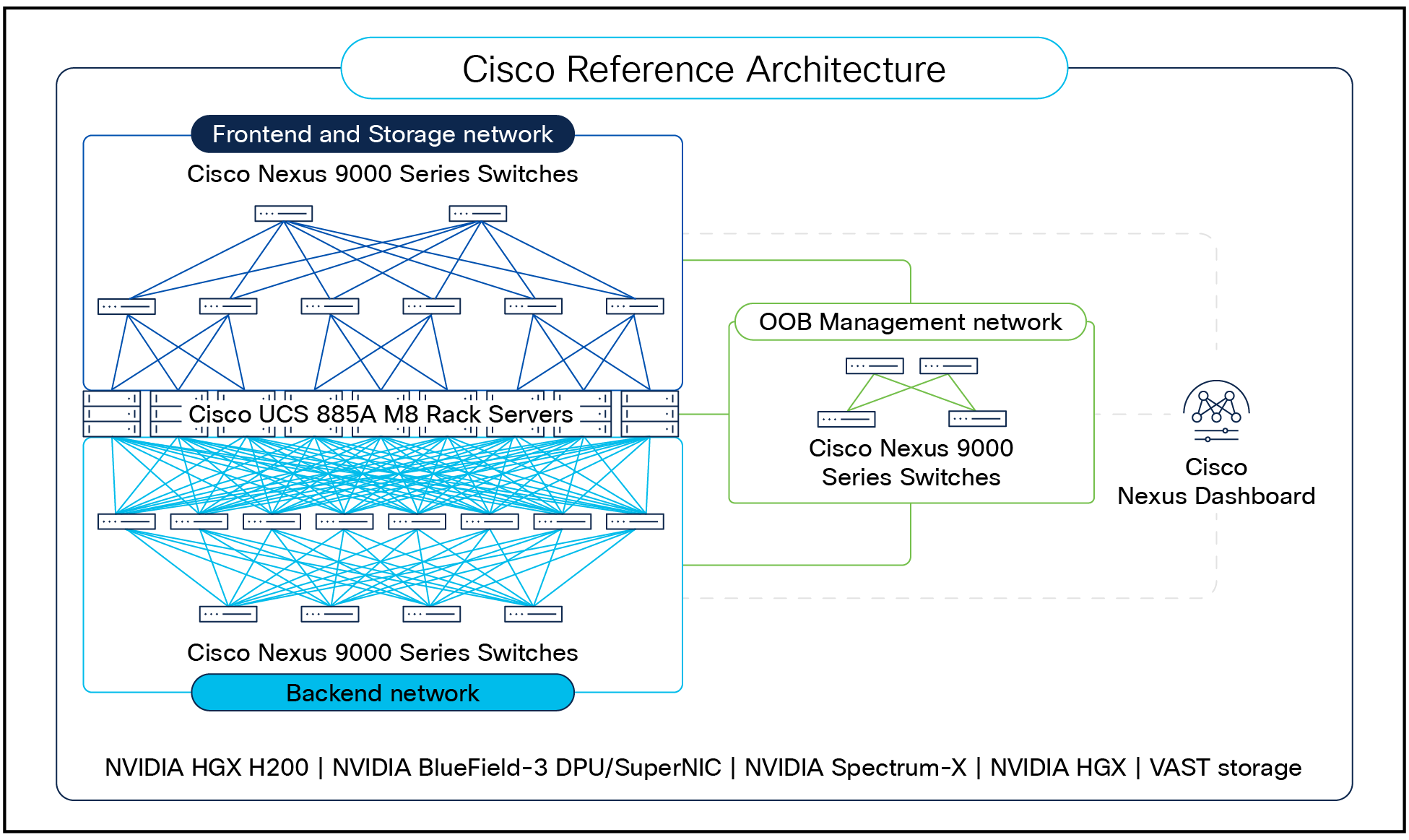

Cisco® エンタープライズ リファレンス アーキテクチャ(ERA)は、オンプレミスの Cisco Nexus Dashboard プラットフォームによって管理されるネットワーキング AI クラスタ用の Cisco Nexus® 9000 シリーズ スイッチに基づいています。これは、NVIDIA Spectrum-X ネットワーキングを備えた NVIDIA HGXH200 向け NVIDIA エンタープライズ リファレンス アーキテクチャに準拠しています。

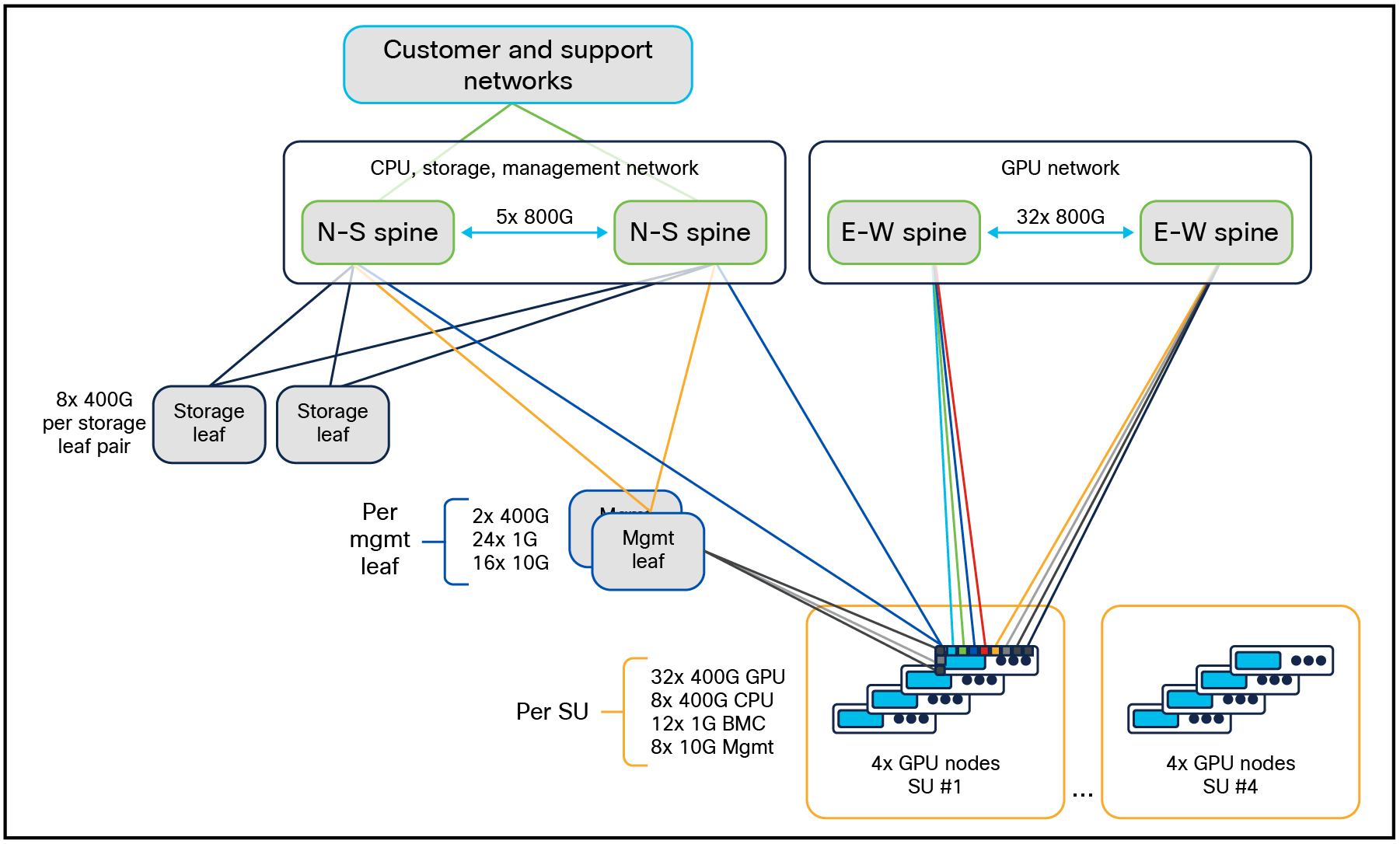

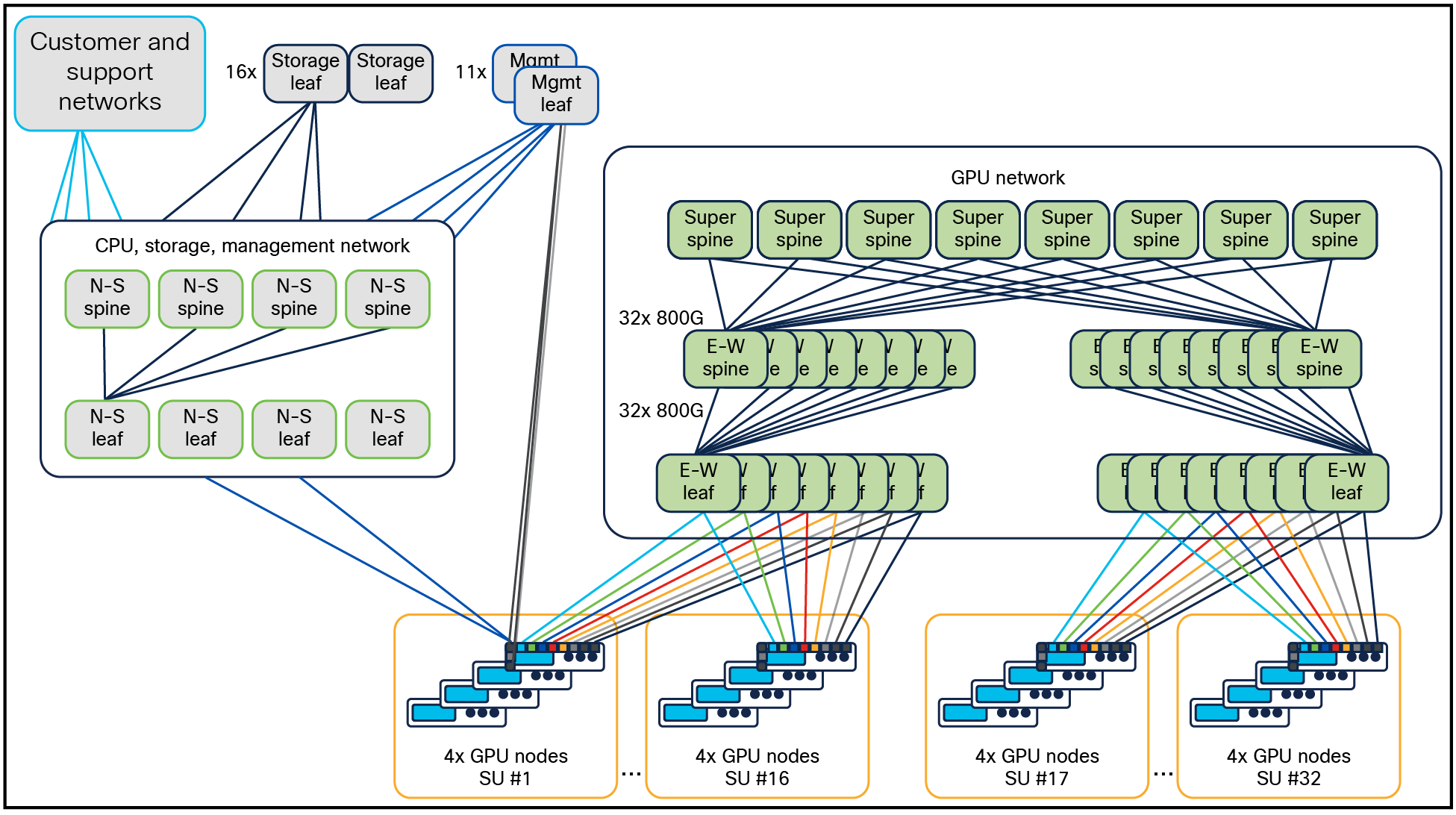

Cisco Nexus 9000 シリーズ スイッチは、Cisco Silicon One ® および Cisco Cloud Scale アーキテクチャを利用して、AI およびハイパフォーマンス コンピューティング(HPC)ワークロードに高速で確定的、低遅延、および電力効率の高い接続を提供します。Cisco NX-OS オペレーティング システムの複数のフォーム ファクタ、オプティクス、および豊富なソフトウェア機能を使用できるため、Nexus 9000 スイッチは、フロントエンド、ストレージ、バックエンド、およびアウトオブバンド(OOB)管理ネットワークに一貫性のあるエクスペリエンスを提供します(図 1 を参照)。

Cisco Nexus Dashboard は、Nexus 9000 スイッチベースのファブリックを管理するための運用および自動化プラットフォームです。組み込みのテンプレートを使用して構成を簡素化することで、Nexus 9000 スイッチのデータ プレーン機能を補完します。輻輳、ビットエラー、トラフィック バーストなどのネットワークの正常性の問題をリアルタイムで検出し、自動的に異常としてフラグを立てます。これらの問題は、一般的に使用されるツール(ServiceNow や Ansible など)との統合を使用してより迅速に解決でき、AI クラスタのネットワークを組織の既存のワークフローと整合させることができます。

Nexus Dashboard シリーズ プラットフォームによって管理される AI クラスタのネットワーク用の Cisco Nexus 9000 スイッチ

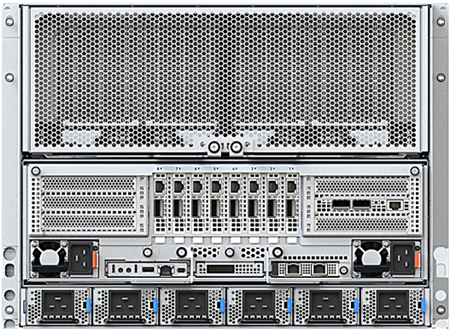

Cisco UCS C885A M8 ラック サーバは、大規模言語モデル(LLM)トレーニング、ファインチューニング、推論、取得拡張生成(RAG)などの AI ワークロード向けに、大規模でスケーラブルなパフォーマンスを提供する 8RU であり、高密度 GPU サーバ(ノード)です。C-G-N-B 命名規則は、2-8-10-40(C-G-N-B)内の NVIDIA HGX リファレンス アーキテクチャに基づいてが次のように定義されています:

● C:ノード内の CPU の数

● G:ノード内の GPU の数

● N:以下のように分類されているネットワーク アダプタ(NIC)の数

◦ North-south:フロントエンド ネットワークを通してノードと外部システムの間の通信。

◦ East-west:バックエンド ネットワークを通してクラスタ内の通信。

● B:GPU あたりの平均ネットワーク帯域幅(ギガビット/秒(Gb/s)単位)

サーバ内の 8x NVIDIA H200 SXM GPU は、高速 NVLink インターコネクトを使用してインターコネクトされています。他の物理サーバーへの GPU 接続は、East-West(EW)トラフィックに 8 個の NVIDIA BlueField-3 B3140H SuperNIC を使用して実行されます。North-South(NS)トラフィックでは、1x NVIDIA BlueField-3 B3220 DPU NIC(2x200G モード)を使用できます。各サーバには 2 つの AMD EPYC CPU、最大 3 TB の DDR DRAM、30 TB の NVMe ローカル ストレージ、およびホットスワップ可能なファン トレイと電源が含まれます。サーバの詳細な仕様については、付録 A を参照してください。

NVIDIA HGX を搭載した Cisco UCS C885A M8 ラック サーバ

Cisco UCS C885A M8 ラック サーバが図に使用されますが、この ERA は、2-8-10-400(CGNB)構成の NVIDIA HGX に基づく他のサーバに適用されます。

Cisco Nexus 93108TC-FX3 スイッチ(図 3 を参照)は、48 個の 100 Mbps または 1/10 Gbps 10GBASE-T ポートと、1RU フォームファクタで 6 個の 1/10/25/40/100 Gbps QSFP28 ポートを提供します。このスイッチは、管理ネットワークで使用できます。

Cisco Nexus 93108TC-FX3 スイッチ

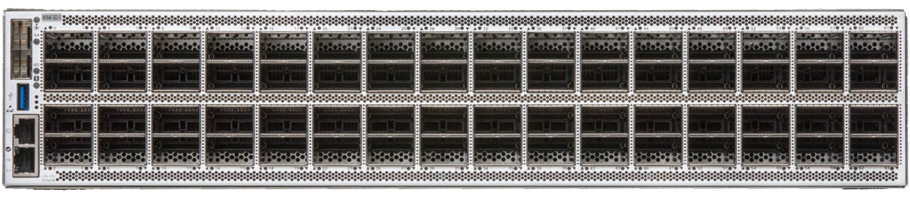

Cisco Nexus 9332D-GX2B スイッチ(図 4 を参照)は、1RU フォーム ファクタで 32 個の 400G QSFP-DD ポートに 10/25/50/100/200 Gbps ブレークアウト サポートを提供します。このスイッチは、リーフまたはスパイン ロールで使用できます。

Cisco Nexus 9332D-GX2B スイッチ

Cisco Nexus 9364E-SG2 スイッチ(図 5 を参照)は、QSFP-DD と OSFP の両方のポート タイプで使用可能な 2RU フォーム ファクタで、64 個の 800G ポートまたは 128 個の 400G ポートを提供します。このスイッチは、リーフまたはスパイン ロールで使用できます。

Cisco Nexus 9364E-SG2 スイッチ

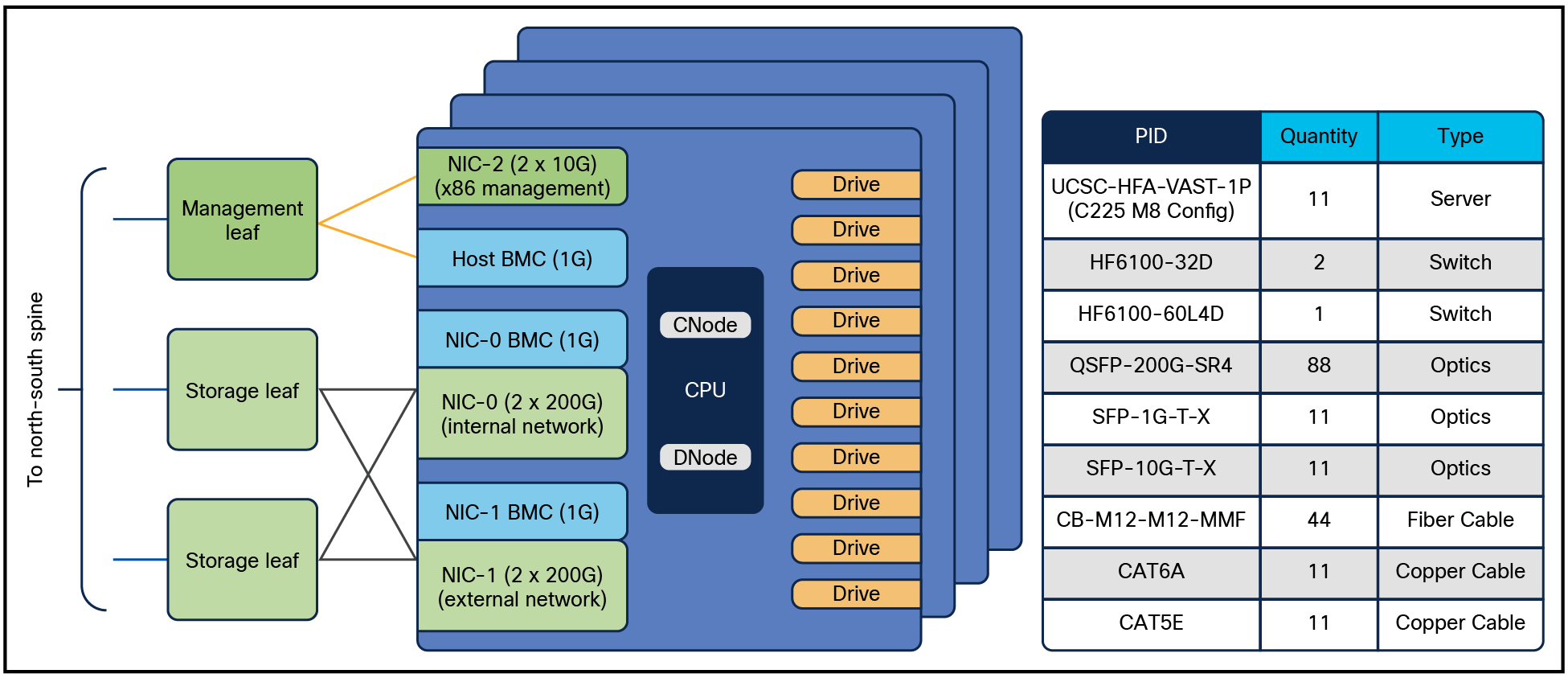

Cisco C225 M8 ラック サーバは 1RU の汎用サーバで、アプリケーション サーバ、サポート サーバ、Kubernetes(K8s)や Slurm の制御ノード、さらにはストレージ プラットフォームなど、さまざまなロールで使用できます。たとえば、これらのサーバは、ストレージ アーキテクチャの項で説明されているように、VAST ストレージ ソリューションを実行するためにも使用されます。

Cisco UCS C225 M8 ラック サーバ

Cisco Nexus 9000 シリーズ スイッチは、さまざまなタイプのデータセンター ファブリック設計に使用できます。ただし、NVIDIA ERA と密接に連携する設計のみが、このリファレンス アーキテクチャの一部と見なされます。

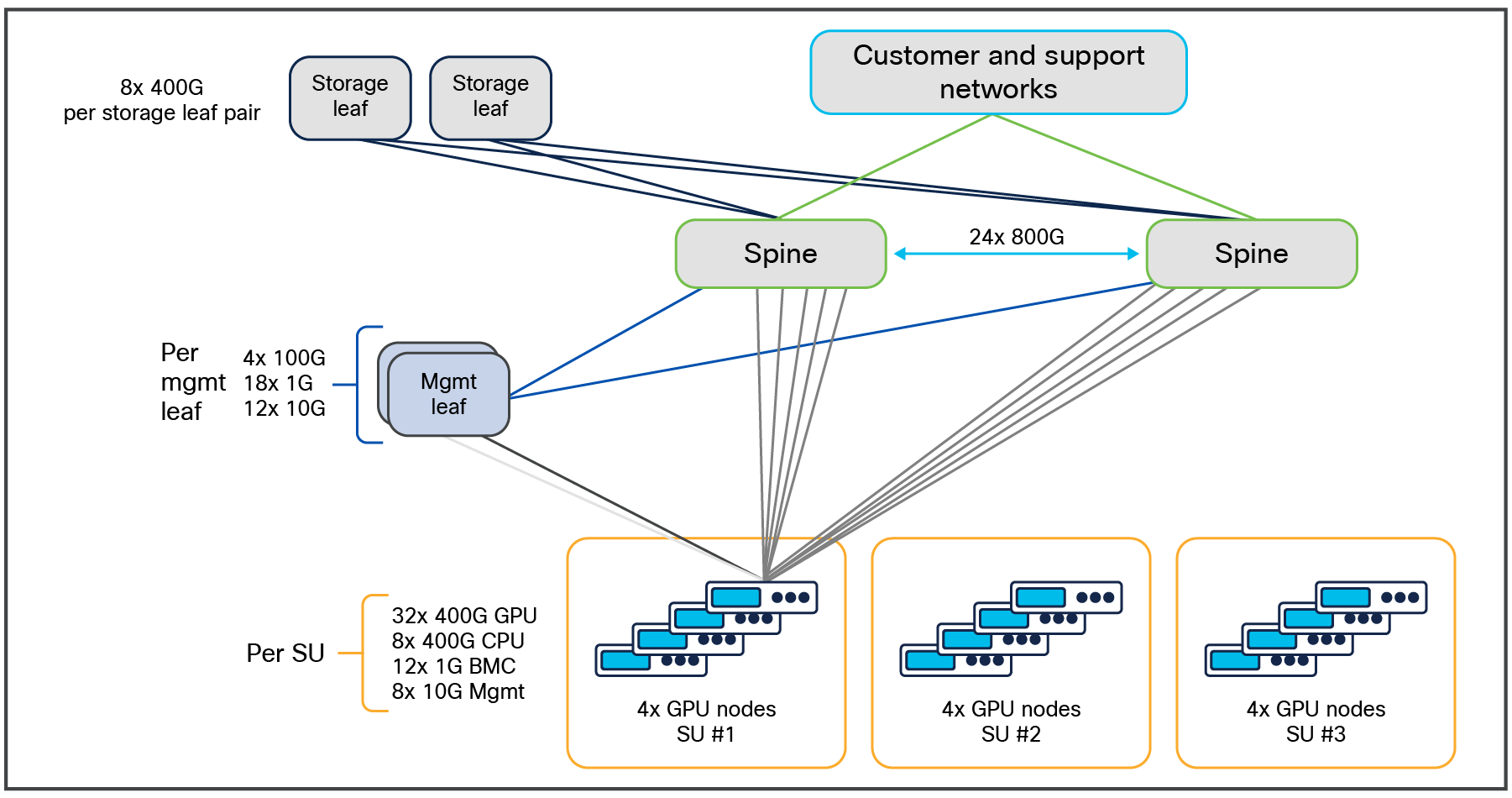

NVIDIA ARA と同様に、この Cisco ARA では、最大 128 の NVIDIA 8 GPU HGX ノードまで拡張して、合計 1024 H200 GPU をサポートできます。4 ノード スケーラブル ユニット(SU)のモジュラ設計を使用し、最大 32 の SU で 128 ノードに対応します。各 SU は、ネットワーク デバイスのポート アベイラビリティ サイズに接続された個別の計算エンティティです。SU を複製することで、環境の規模をより簡単に調整できます。

以下に示すように、Cisco のデザインの特定の側面に対応するために、マイナーな変更が加えられています:

● Cisco UCS C885A M8 ラックサーバー x86 管理ポートは、1G ではなく 10G の速度を使用します。

● VAST ストレージ ソリューションには、ストレージ ネットワークへの少なくとも8x400G リンクが必要です。ただし、この要件は、別の NVIDIA 認定ストレージ パートナーからのソリューションが使用された場合に変わる可能性があります。

● NVIDIA BlueField-3 SuperNIC の BMC ポートは接続されず、x86 ホストから管理されます。ただし、NVIDIA BlueField-3 DPU の BMC ポートは接続されます。

NVIDIA HGX を搭載した Cisco UCS C885A M8 ラック サーバのトポロジ

図 7 は、NVIDIA HGX を使用した最大 12 台の Cisco UCS C885A M8 ラック サーバーのクラスタ トポロジを、3 つの SU にグループ化して示しています。この小規模では、Cisco Nexus 9364E-SG2 スイッチのペアが、フロントエンド、バックエンド、ストレージ、管理ネットワークを統合するのに十分なポート密度を提供します。このコンバージェンスにより、VLAN を使用した論理的な分離を維持しながら、許容範囲とシンプルさが向上します。

NVIDIA HGX を搭載した 12 台の Cisco UCS C885A M8 ラック サーバ用エンタープライズ RA(96 GPU)

表 1 に、NVIDIA HGX を使用した 12 ノード Cisco UCS C885A M8 ラック サーバ クラスタの部品表(BOM)を示します。

表 1. NVIDIA HGX (96 GPU)を搭載した 12 ノード Cisco UCS C885A ラック サーバ クラスタの BOM

| PID |

説明 |

数量 |

| UCSC-885A-M8-H12 |

NVIDIA HGX を搭載した Cisco UCS C885A M8 サーバ |

12 |

| N9364E-SG2-O |

Cisco Nexus スイッチ、64x800Gbps OSFP |

2 |

| N9K-93108TC-FX3 |

Cisco Nexus スイッチ、48 1/10G BASE-T 6 QSFP28 |

2 |

| N9K-C9332D-GX2B |

Cisco Nexus スイッチ、32x400Gbps QSFP-DD |

2 |

| OSFP-800G-DR8 |

OSFP、800GBASE-DR8、SMF デュアル MPO-12 APC、500m |

114 |

| QDD-400G-DR4-S |

400G QSFP-DD トランシーバ、400GBASE-DR4、MPO-12、500m パラレル |

10 |

| QSFP-400G-DR4 |

400G QSFP112 トランシーバ、400GBASE-DR4、MPO-12、500 m パラレル |

118 |

| QSFP-100G-DR-S |

100GBASE DR QSFP トランシーバ、500 m(SMF 使用) |

8 |

| CB-M12-4LC-SMF |

ケーブル、MPO12-4X デュプレックス LC、ブレークアウト ケーブル、SMF、各種長さ |

2 |

| CB-M12-M12-SMF |

MPO-12 ケーブル |

204 |

| CAT6A |

10G 用銅ケーブル |

24 |

| CAT5E |

1G 用銅ケーブル |

36 |

Nexus 9364E-SG2-O スイッチは、800G から 400G 接続用に 2x400G MPO-12 コネクタを備えた OSFP-800G-DR8 ツイストポート トランシーバ(図 8 を参照)を使用します。

Cisco OSFP-800G-DR8 トランシーバ モジュール

各接続は、ブレークアウト ケーブルを必要とせずに独立して 400G をサポートします(図 9 を参照)。

Cisco OSFP-800G-DR8 プラグホール ビュー

図 7 に、NVIDIA HGX を使用した最大 16 の Cisco UCS C885A M8 ラック サーバ のクラスタ トポロジを示します。EW ネットワークは、レール 1 から 4 が左側の EW スパインに、レール 5 から 8 が右側の EW スパインに配置されています。

NVIDIA HGX を搭載した 16 台の Cisco UCS C885A M8 ラック サーバ用エンタープライズ RA(128 GPU)

表 2 に、NVIDIA HGX を使用した 16 ノード Cisco UCS C885A M8 ラック サーバ クラスタの BOM を示します。

表 2. NVIDIA HGX (128 GPU)を搭載した 16 ノード Cisco UCS C885A M8 ラック サーバ クラスタの BOM

| PID |

説明 |

数量 |

| UCSC-885A-M8-HC1 |

NVIDIA HGX を搭載した Cisco UCS C885A M8 ラック サーバ |

16 |

| N9364E-SG2-O |

Cisco Nexus スイッチ、64x800Gbps OSFP |

4 |

| N9K-93108TC-FX3 |

Cisco Nexus スイッチ、48 1/10G BASE-T 6 QSFP28 |

2 |

| N9K-C9332D-GX2B |

Cisco Nexus スイッチ、32x400Gbps QSFP-DD |

2 |

| OSFP-800G-DR8 |

OSFP、800GBASE-DR8、SMF デュアル MPO-12 APC、500m |

144 |

| QDD-400G-DR4 |

400G QSFP-DD トランシーバ、400GBASE-DR4、MPO-12、500m パラレル |

12 |

| QSFP-400G-DR4 |

400G QSFP112 トランシーバ、400GBASE-DR4、MPO-12、500 m パラレル |

158 |

| QSFP-100G-DR-S |

100GBASE DR QSFP トランシーバ、500 m(SMF 使用) |

8 |

| CB-M12-4LC-SMF |

ケーブル、MPO12-4X デュプレックス LC、ブレークアウト ケーブル、SMF、各種長さ |

2 |

| CB-M12-M12-SMF |

MPO-12 ケーブル |

198 |

| CAT6A |

10G 用銅ケーブル |

32 |

| CAT5E |

1G 用銅ケーブル |

48 |

クラスタ サイズが 16 を超える場合、East-West コンピューティング ネットワークはスパイン リーフ ファブリックに拡張されます。クラスタ サイズが最大の場合、128 Cisco UCS C885A M8 ラック サーバ クラスタの図 11 に示すように、north-south ネットワークもスパインリーフになります。E-W ネットワークは、各 EW リーフ 1〜8 にある各レール 1〜8 とレールに沿っています。

NVIDIA HGX を搭載した 128 台の Cisco UCS C885A M8 ラック サーバ用エンタープライズ RA(1024 GPU)

Cisco UCS C885A M8 ラック サーバでサイジング

表 3 と表 4 は、NVIDIA HGX を搭載した Cisco UCS C885A M8 ラック サーバ、8 EW B3140H NVIDIA BlueField-3 基の SuperNIC と 2 NS B3240 NVIDIA BlueField-3 DPU NIC を使用したさまざまなクラスタ サイズに必要なさまざまなユニットの数量を示しています。

表 3. NVIDIA HGX を搭載した Cisco UCS C885A M8 ラック サーバの East-west コンピューティング ファブリック テーブル:スイッチ、トランシーバ、およびケーブル数

| コンピューティング数 |

スイッチ数 |

トランシーバ数 |

ケーブル数 |

||||||

| ノード |

GPU |

リーフ |

スパイン |

SuperSpine |

ノードからリーフ |

スイッチ間 |

ノードからリーフ |

スイッチと |

|

| ノード |

リーフ |

||||||||

| 12 |

96 |

2 |

該当なし |

該当なし |

96 |

48 |

48 |

96 |

48 |

| 16 |

128 |

2 |

該当なし |

該当なし |

128 |

64 |

64 |

128 |

64 |

| 32 |

256 |

4 |

2 |

該当なし |

256 |

128 |

256 |

256 |

256 |

| 64 |

512 |

8 |

8 |

該当なし |

512 |

256 |

1024 |

512 |

1024 |

| 128 |

1024 |

16 |

16 |

8 |

1024 |

512 |

2048 |

1024 |

2048 |

表 4. NVIDIA HGX を搭載した Cisco UCS C885A M8 ラック サーバの North-south コンピューティング ファブリック テーブル:スイッチ、トランシーバ、およびケーブル数

| コンピューティング数 |

スイッチ数 |

トランシーバ数 |

ケーブル数 |

|||||||||||||||||

| ノード |

GPU |

リーフ |

スパイン |

管理 |

ストレージ |

ノードからコンピューティング |

ISL ポート |

ノードから管理リーフ(1/10G) |

リーフから |

ストレージ リーフから |

スパインからお客様 |

|||||||||

| ノード |

リーフ |

800G |

ノード |

リーフ |

リーフ |

スパイン |

リーフ |

スパイン |

お客様(800G) |

サポート |

SMF |

CAT6A + CAT5E |

||||||||

| 12 |

96 |

East-West でコンバージド |

2 |

2 |

24 |

12 |

なし |

なし |

なし |

8 |

2 |

8 |

4 |

8 |

4 |

60 |

60 |

|||

| 16 |

128 |

2 |

該当なし |

2 |

2 |

32 |

16 |

10 |

なし |

なし |

8 |

2 |

8 |

4 |

8 |

4 |

78 |

80 |

||

| 32 |

256 |

2 |

該当なし |

4 |

4 |

64 |

32 |

16 |

なし |

なし |

16 |

4 |

16 |

8 |

16 |

4 |

144 |

160 |

||

| 64 |

512 |

2 |

該当なし |

7 |

8 |

128 |

64 |

30 |

なし |

なし |

36 |

7 |

32 |

16 |

32 |

4 |

274 |

320 |

||

| 128 |

1024 |

4 |

4 |

14 |

16 |

256 |

128 |

256 |

なし |

なし |

56 |

14 |

64 |

32 |

64 |

4 |

756 |

640 |

||

第 1 段階では、表 5 に示すオプティクスおよびケーブルをシステム内のさまざまなデバイスで使用します。

表 5. さまざまなデバイスでサポートされるオプティクスおよびケーブルのリスト

| デバイス |

オプティクスおよびケーブル |

| B3140H、B3240 |

QSFP-400G-DR4 と SMF MPO-12 ケーブル |

| B3220 |

QSFP-200G-SR4 と MMF MPO-12 ケーブル |

| N9364E-SG2-O |

OSFP-800G-DR8(デュアル SMF MPO-12 ケーブル付属) |

| N9K-C9332D-GX2B |

SMF MPO-12 ケーブルを使用した QDD-400G-DR4 QSFP-200G-SR4 と MMF MPO-12 ケーブル |

| N9K-93108TC-FX3 |

SMF デュプレックス LC ケーブルを使用した QSFP-100G-DR-S CAT5E ケーブル CAT6A ケーブル |

Cisco は VAST Data と協力して、EBox アーキテクチャの Cisco UCS C225 M8 ラック サーバ上にストレージ ソフトウェアをオンボードします。VAST データは、サーバを段階的に追加することでストレージ容量と読み取り/書き込みパフォーマンスを水平方向にスケーリングできる「分散および共有(DASE)アーキテクチャ」をサポートします。AI データ パイプラインのすべてのステージをサポートするために、NFS、S3、および SMB などのすべてのプロトコル サーバが有効になっています。

図 12 は、2 つのストレージ リーフを備えた単一の EBox のストレージ サーバと BOM の全体的なネットワーク接続を示しています。データ パスの場合、各サーバは 2 つの NVIDIA BlueField-3 B3220L 2x200G NICを使用します。NIC0 はサーバ内の内部ネットワークに使用され、他のサーバからストレージ ドライブにアクセスできるようにします。 そして NIC1 は、NFS、S3、および SMB などのクライアント トラフィックをサポートする外部ネットワークに使用されます。注: すべてのサーバがすべてのリーフに接続するため、内部ネットワーク トラフィックはリーフでローカルに切り替えられます(スパインには到達しません)。クライアントが外部トラフィックに面する場合、EBox ごと、スパイン上の最小要件は 11x 200G または 6x 400G です。1G BMC および 10G x86 管理ポートは管理リーフ スイッチに接続されます。

ストレージ サブシステムのブロック図と BOM

クラスタ サイズが大きくなると、ストレージ リーフ スイッチと Ebox の数は、クラスタのサイジング テーブルにあるとおりに直線的に増加します。

VAST データに加えて、他の NVIDIA 認定ストレージ パートナーもこのリファレンス アーキテクチャ内で使用できます。

前述のように、Cisco NX-OS は Nexus 9000 シリーズ スイッチで実行されるオペレーティング システムですが、Nexus Dashboard はファブリックを管理するための運用および自動化プラットフォームです。

Cisco NX-OS および Nexus Dashboard では、次のことは行いません:

● 何らかの方法でコンピューティングまたはストレージを構成する

● サーバの BMC またはホスト CPU ソフトウェア ライフサイクルを管理する

● NVIDIA BlueField-3 NIC でカーネルおよびディストリビューションを管理する

サーバの構成および管理機能は、他の方法で管理する必要があります(Cisco Intersight® は、オプションです)。これらのツールの展開および使用は、お客様側で全責任を負います。ネットワーク コントローラの適切な範囲であることに加えて、この懸念事項の分離は、ネットワーク運用をコンピューティングとストレージからセグメント化するという主要な運用パラダイムと合致しています。

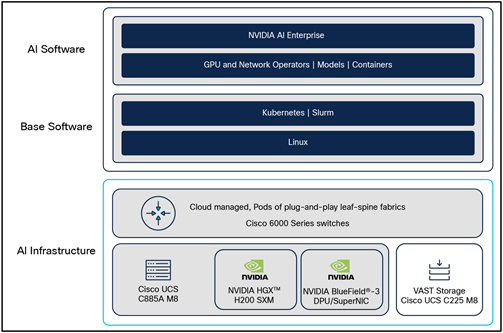

このリファレンス アーキテクチャは、NVIDIA AI Enterprise を含みます。そして、NVIDIA-certified Cisco UCS C885A M8 ラック サーバは、実稼働対応の AI エージェント、生成 AI、コンピュータ ビジョン、音声 AI などの開発と展開を合理化するクラウドネイティブなソフトウェア プラットフォームの NVIDIA HGX NVIDIA AI Enterprise でサポートされています。エンタープライズ レベルのセキュリティ、サポート、および API の安定性により、プロトタイプから実稼働へのスムーズな移行が保証されます。

NVIDIA NIM™ マイクロサービスは、オープンソース コミュニティ モデル、カスタム モデル、および NVIDIA AI Foundation モデルの実稼働展開のための完全な推論スタックを提供します。スケーラブルで最適化された推論エンジンと使いやすさにより、モデルが加速し、TCO が改善され、実稼働展開が迅速化されます。

クラスタ ソリューション全体が、Ubuntu Linux 22.04 LTS および NVIDIA Cloud Native Stack(CNS)バージョン 12.3 を実行しているコンピューティング ノードで検証されています。これには、Kubernetes(K8)環境内の互換性のあるドライバ、GPU、およびネットワーク オペレータが含まれます。Slurm バージョン 24.11.1 は、ワークロード オーケストレーション エンジンとして検証されています。NVIDIA® NGC™ カタログの下にあるコンテナは、Kubernetes と Slurm の両方で起動できます。

NVIDIA Spectrum-X ネットワーキング テクノロジーは、イーサネットベースの GPU およびストレージ ネットワークのパフォーマンスと効率を大幅に向上させます。その利点は、NVIDIA BlueField-3 SuperNIC に接続された NX- OS 10.6(1)F 以降を実行しているCisco Nexus 9000 スイッチで利用できます。Cisco Nexus 9000 スイッチで NVIDIA Spectrum-X を有効にするには、DCN Advantageライセンスに加えて、Fine Grain Load Balancing(FGLB)ライセンスが必要です。

コンピューティング サーバ ソフトウェア スタック

お客様は、NVIDIA が公開している NVIDIA AI Enterprise、ドライバ、および CNS 互換性マトリックスに従って、OS ディストリビューションとソフトウェア バージョンを選択して実行できます。

Cisco のネットワーク セキュリティおよびオブザーバビリティ サービスは、必要に応じて、クラスタのさまざまな ハードウェア(スイッチ、ホスト、NIC)およびソフトウェア コンポーネントに統合できます。

管理プレーン、コントロール プレーン、およびコンピューティング、ストレージとネットワーキングを組み合わせたデータ プレーンのあらゆる側面を考慮し、全体的なソリューションを徹底的にテストしています。また、HPC Benchmark、IB PerfTest、NCCL Test、MLCommons Training、Inference ベンチマークなど、多数のベンチマークテストスイートも実行され、パフォーマンスを評価し、調整を支援しています。NVIDIA AI エンタープライズ エコシステムのさまざまな要素とエンティティが投入およびテストされ、微調整、推論、および RAG に関する多数の企業中心のお客様のユース ケースを評価します。ネットワークを使用したシングル ノードおよびマルチ ノードの両方で NVIDIA 認定システム のテスト スイート バージョン 3.5 を実行した結果、Cisco UCS C885A M8 ラック サーバは合格しました。

Cisco Nexus 9000 シリーズ スイッチと Nexus Dashboard プラットフォームは、NVIDIA アクセラレーション コンピューティングを利用した AI インフラストラクチャに、スケーラブルで管理が容易な高パフォーマンスのネットワーキングを提供します。

表 6 に、この era で GPU ノードとして使用する Cisco UCS C885A M8 ラックサーバーの部品番号 UCSC-885A-M8-H12 の仕様を示します。

表 6. Cisco UCS C885A M8 8RU ラック サーバ

| エリア |

詳細 |

| フォーム ファクタ |

8RU ラック サーバ(空冷) |

| コンピューティング + メモリ |

第 5 世代 AMD EPYC 9575F X 2(400W、64 コア、最大 5GHz) 24x 96GB DDR5 RDIMM、最大 6,000 MT/S(推奨メモリ構成) 24x 128GB DDR5 RDIMM、最大 6,000 MT/S(サポートされる最大メモリ構成) |

| ストレージ |

RAID サポート付きデュアル 1 TB M.2 NVMe(ブート デバイス) 最大 16 台の PCIe5 x4 2.5 インチ U.2 1.92 TB NVMe SSD(データキャッシュ) |

| GPU |

8 X NVIDIA HGX™ H200(各 700W) |

| ネットワーク カード |

8 PCIe x16 HHHL NVIDIA BlueField-3 B3140H east-west NIC 1 PCIe x16 FHHL NVIDIA BlueField-3 B3220 north-south NIC 1 つのホスト管理用の OCP 3.0 X710-T2L |

| 冷却 |

システム冷却用の 16 ホットスワップ可能(N+1)ファン |

| 前面 IO |

2xUSB 2.0、1xID ボタン、1x電源ボタン |

| 背面 IO |

1x USB 3.0 A、1x USB 3.0 C、mDP、1x ID ボタン、1x 電源ボタン、1x USB 2.0 C、1x RJ45 |

| 電源装置 |

6 X 54V 3kW MCRPS(4+2 冗長性)および 2 X 12V 2.7kW CRPS(1+1 冗長性) |

汎用性の高い Cisco UCS C225 M8 1RU ラック サーバは、Slurm および Kubernetes(K8)、等のサポート サーバ(制御ノードサーバとも呼ばれます)として使用できます。表 7 は、サーバの最小仕様を表示します。

表 7. Cisco UCS C225 M8 1RU ラック サーバ

| エリア |

詳細 |

| フォーム ファクタ |

1RU ラック サーバ(空冷) |

| コンピューティング + メモリ |

1x第 4 世代 AMD EPYC 9454P(48 コア) 32GB DDR5 RDIMM X 12(4800MT/s) |

| ストレージ |

RAID 搭載デュアル 1 TB M.2 SATA SSD(ブート デバイス) 最大 10 台の 2.5 インチ PCIe Gen4 NVMe PCIe SSD(それぞれ容量 1.9 〜 15.3 TB)- オプション |

| ネットワーク カード |

1 PCIe x16 FHHL NVIDIA BlueField-3 B3220L(DPU モードで構成) または 1 PCIe x16 FHHL NVIDIA BlueField®-3 B3140H(DPU モードで構成) x86 ホスト管理用の 1 OCP 3.0 X710-T2L(2 x 10G RJ45) |

| 冷却 |

システム冷却用の 8 ホットスワップ可能(N+1)ファン |

| 電源装置 |

2x 1.2KW MCRP PSU N+1 冗長構成 |

| BMC |

ホスト管理用の 1G RJ45 |

2 ソケット CPU を使用する展開では、B3220 DPU NIC とともに Cisco UCS C245 M8 2RU ラック サーバ バリアントを使用できます。

● NVIDIA AI エンタープライズ ソフトウェア リファレンス アーキテクチャ:

https://docs.nvidia.com/ai-enterprise/reference-architecture/latest/index.html

● NVIDIA HGX:https://www.nvidia.com/en-us/data-center/hgx

● NVIDIA Spectrum-X ネットワーキング: https://www.nvidia.com/en-us/networking/spectrumx/

● Cisco Nexus 9000 シリーズ スイッチ:

https://www.cisco.com/site/us/en/products/networking/cloud-networking-switches/nexus-9000-switches/index.html

● Cisco Nexus Dashboard:

https://www.cisco.com/site/jp/ja/products/networking/cloud-networking/nexus-platform/index.html

● Cisco NX-OS Licensing Options Guide:https://www.cisco.com/c/en/us/td/docs/switches/datacenter/licensing-options/cisco-nexus-licensing-options-guide.html

| 新規トピックまたは改訂されたトピック |

説明 |

日付 |

| 初版 |

新しいドキュメント |

2025 年 3 月 |

| NVIDIA HGX を搭載した Cisco UCS C885A M8 ラック サーバのトポロジ |

2025 年 6 月 |

|

| Cisco Nexus 9000 スイッチでの Spectrum-X の可用性 |

2025 年 9 月 |