KVM での ASAv のガイドラインで制限事項

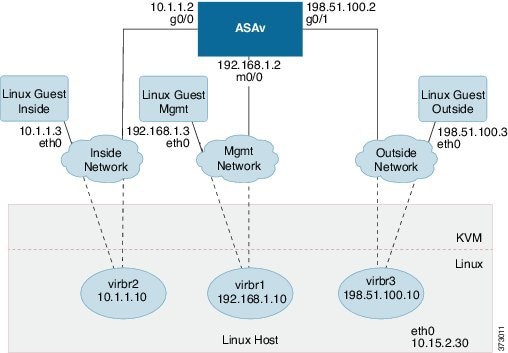

ASAv の導入に使用される特定のハードウェアは、導入されるインスタンスの数や使用要件によって異なります。作成する各仮想アプライアンスには、ホスト マシン上での最小リソース割り当て(メモリ、CPU 数、およびディスク容量)が必要です。

ASAv を導入する前に、次のガイドラインと制限事項を確認します。

KVM での ASAv のシステム要件

最適なパフォーマンスを確保するために、以下の仕様に準拠していることを確認してください。ASAv には、次の要件があります。

-

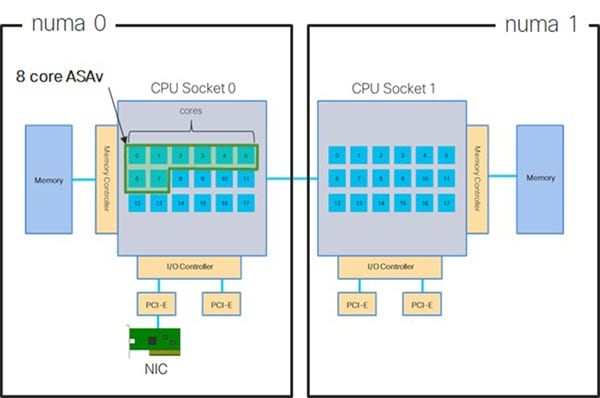

ホスト CPU は、仮想化拡張機能を備えたサーバークラスの x86 ベースの Intel または AMD CPU である必要があります。

たとえば、ASAv パフォーマンステストラボでは、2.6GHz で動作する Intel® Xeon® CPU E5-2690v4 プロセッサを搭載した Cisco Unified Computing System™(Cisco UCS®)C シリーズ M4 サーバーを最低限使用しています。

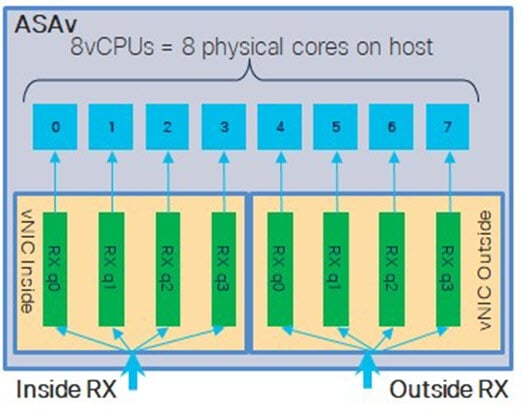

CPU ピニング

KVM 環境で ASAv を機能させるには、CPU ピニングが必要です。CPU ピンニングの有効化を参照してください。

ハイ アベイラビリティ ガイドラインのためのフェールオーバー

フェールオーバー配置の場合は、スタンバイ装置が同じモデル ライセンスを備えていることを確認してください(たとえば、両方の装置が ASAv30s であることなど)。

重要 |

ASAv を使用して高可用性ペアを作成する場合は、データインターフェイスを各 ASAv に同じ順序で追加する必要があります。完全に同じインターフェイスが異なる順序で各 ASAv に追加されると、ASAv コンソールにエラーが表示されることがあります。また、フェールオーバー機能にも影響が出ることがあります。 |

フィードバック

フィードバック