ITDについて

Intelligent Traffic Director(ITD)は、レイヤ 3 およびレイヤ 4 のトラフィック分散、ロードバランシング、およびリダイレクトのためのスケーラブルなアーキテクチャを構築できる、インテリジェントなハードウェア ベースのマルチテラビット ソリューションです。

ITD のメリット:

-

ライン レートでのマルチテラビット ソリューション

-

エンドデバイスへの透過性とステートレス プロトコルのメリット

-

Web Cache Communication Protocol(WCCP)やポリシーベースのルーティングなどの代替機能のための複雑さとアーキテクチャのスケーリングの軽減

-

プロビジョニングが簡素化され導入が容易

-

レガシー サービス アプライアンスは新しいものと共存できます

-

高価な外部ロードバランサの要件を削除します。

-

デバイスと Cisco NX-OS スイッチ間の認証/統合/認定が不要。

-

大幅な OPEX 削減の順序:構成の簡素化、展開の容易さ

-

サービス モジュールまたは外部 L4 ロードバランサは不要すべての Nexus ポートをロードバランサとして使用可能

ITD の機能:

-

ワイヤスピードでのハードウェアベースのマルチテラビット/秒 L3/L4 ロードバランシング

-

ゼロ遅延のロードバランシング

-

ラインレート トラフィックを任意のデバイスにリダイレクト、たとえば web cache エンジン、Web アクセラレータ エンジン(WAE)、ビデオキャッシュ、など)

-

ファイアウォール、侵入防御システム(IPS)、または Web アプリケーション ファイアウォール(WAF)、Hadoop クラスタなどのデバイスのクラスタを作成する機能

-

IP スティッキネス

-

ワイヤスピードでのハードウェアベースのマルチテラビット/秒 L3/L4 ロードバランシング

-

ゼロ遅延のロードバランシング

-

ラインレート トラフィックを任意のデバイスにリダイレクト、たとえば web cache エンジン、Web アクセラレータ エンジン(WAE)、ビデオキャッシュ、など)

-

ファイアウォール、侵入防御システム(IPS)、または Web アプリケーション ファイアウォール(WAF)、Hadoop クラスタなどのデバイスのクラスタを作成する機能

-

IP スティッキネス

-

回復力(回復力のある ECMP など)、一貫したハッシュ

-

仮想 IP ベースの L4 ロードバランシング

-

ノード間で加重負荷分散と Failaction がサポートされています

-

多数のデバイス/サーバーへの負荷分散

-

リダイレクトおよびロードバランシングと同時の ACL

-

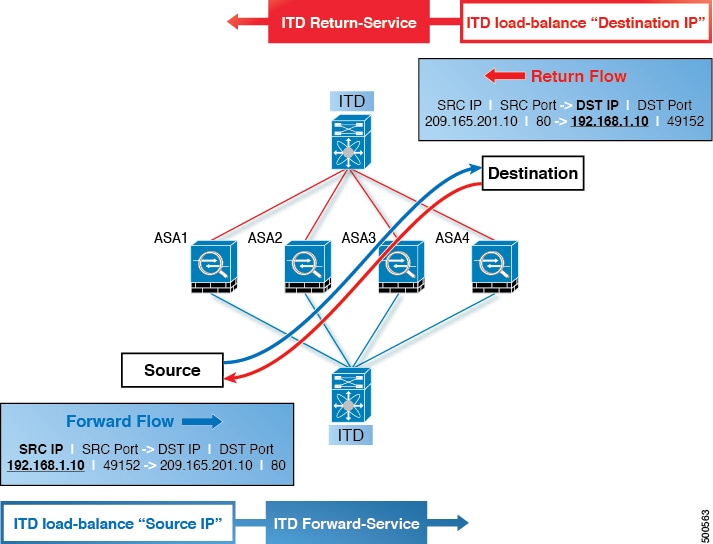

双方向のフロー一貫性。A–>B および B–>A からのトラフィックは同じノードに行きます

-

サーバ/アプライアンスを Nexus スイッチに直接接続する必要なし

-

IP SLA ベースのプローブを使用したサーバー/アプライアンスのヘルスの監視

-

N + M 冗長(N ノード数、M ホットスタンバイ数)

-

サーバー/アプライアンスの自動障害処理

-

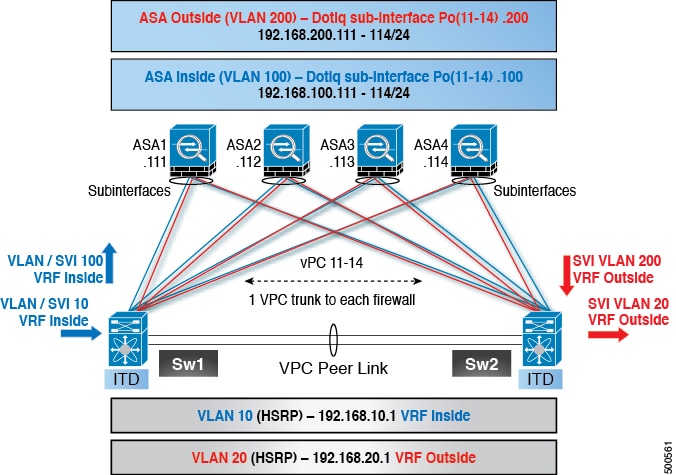

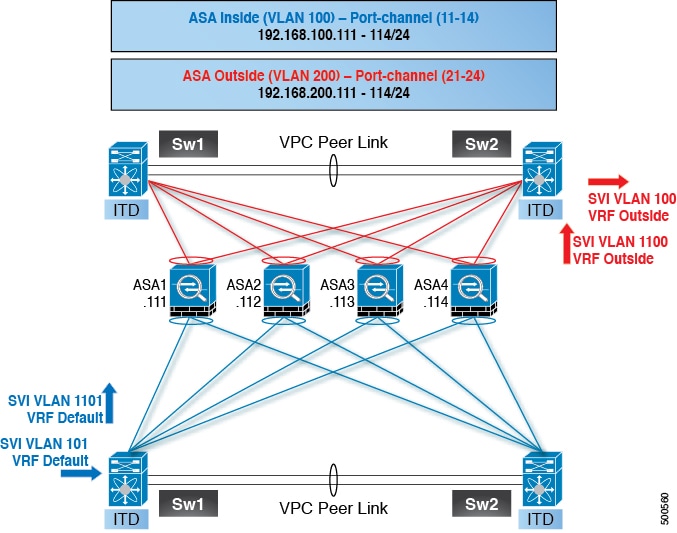

VRF サポート、vPC サポート

-

IPv4 と IPv6 の両方をサポート(すべてのプラットフォームは IPv6 をサポートしていません)

-

ITD 機能によるスーパーバイザ CPU への負荷の追加なし

-

無制限のフロー数を処理。

-

無停止でのノードの追加または削除

-

同時リダイレクトと負荷分散

-

同じスイッチ内の複数の ITD サービス間でのレート共有

使用例:

-

ファイアウォールのクラスタへの負荷分散。

-

NX-OS デバイスへのロードバランシングにより、IPS、IDS、および WAF を拡張します。

-

低コストの VM/コンテナ ベースの NFV にロードバランシングすることにより、NFV ソリューションを拡張します。

-

WAAS/WAE ソリューションをスケーリングします。Wide Area Application Services(WAAS)または Web Accelerator Engine(WAE)ソリューションのトラフィック リダイレクト メカニズム

-

VDS-TC(ビデオ キャッシュ)ソリューションのスケーリング

-

トラフィックを L7 LB に分散することにより、レイヤ 7 ロードバランサーをスケーリングします。

-

ECMP またはポートチャネルを置き換えて、再ハッシュを回避します。ITD は復元力があり、ノードの追加/削除/失敗時に再ハッシュを引き起こしません

-

DSR(Direct Server Return)モードでのサーバー負荷分散

-

NX-OS デバイスへのロードバランシングにより、NG 侵入防御システム(IPS)と Web アプリケーション ファイアウォール(WAF)をスケールアップします。

-

レイヤ 5 からレイヤ 7 のロードバランサへの負荷分散

展開モード

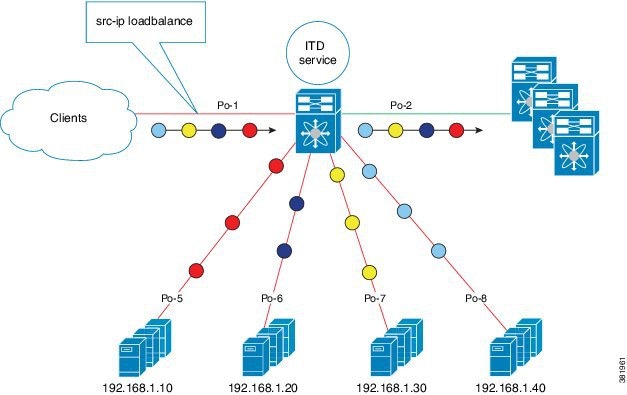

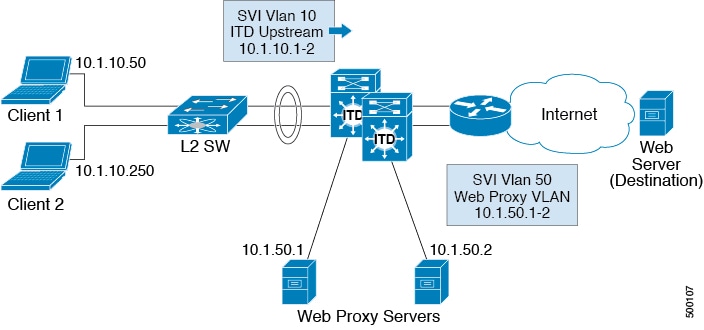

ワンアーム展開モード

ワンアーム展開モードでサーバーをスイッチに接続できます。このトポロジでは、サーバーはクライアント トラフィックまたはサーバー トラフィックの直接パスに存在しないため、既存のトポロジやネットワークを変更することなく、サーバーをネットワークに接続できます。

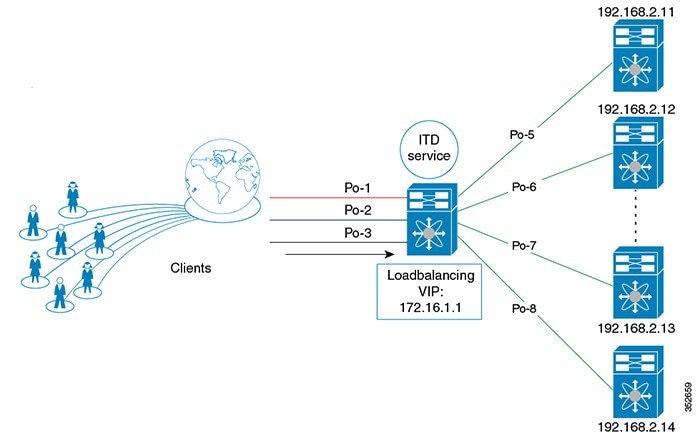

サーバー ロードバランシング展開モード

ITD サービスは、スイッチで仮想 IP(VIP)をホストするように構成できます。VIP を宛先とするインターネット トラフィックの負荷は、複数のアクティブなノードに分散されます。ITD サービスはステートフル ロードバランサではありません。

(注) |

各スイッチで同様の方法で、ITD サービスを手動で設定する必要があります。 |

デバイスグループ

ノードは、トラフィックを負荷分散できる物理サーバー、仮想サーバー、またはサービス アプライアンスにすることができます。これらのノードはデバイス グループの下にグループ化され、このデバイス グループをサービスにマップできます。

ITD はデバイス グループをサポートします。デバイス グループを構成するときは、次を指定できます。

-

デバイス グループのノード

-

デバイス グループのプローブ

プローブは、デバイス グループ レベルまたはノード レベルで構成できます。ノード レベルのプローブを行う場合、それぞれのノードは自身のプローブで構成可能なため、ノードごとにさらにカスタマイズすることができます。ノード レベルのプローブは、障害状態について各ノードを別々に監視する必要があるシナリオで役立ちます。

ITD サービス内の複数のデバイス グループ

デバイス グループがサポートされています(下図を参照してください)。ITD サービスは、さまざまなデバイス グループを指すさまざまなシーケンスを持つ単一のルートマップを生成します。

各デバイス グループは、異なるサービスを必要としますが、同じ入力インターフェイスに到着する異なるタイプのトラフィックを表します。インターフェイス上のトラフィックは、仮想 IP アドレスに基づいて適切なデバイス グループにリダイレクトされます。同じインターフェイスで ITD サービスごとに複数のデバイス グループをサポートすると、ITD を拡張できます。

ITD サービスで複数のデバイス グループを設定する方法を示す構成例については、 を参照してください。

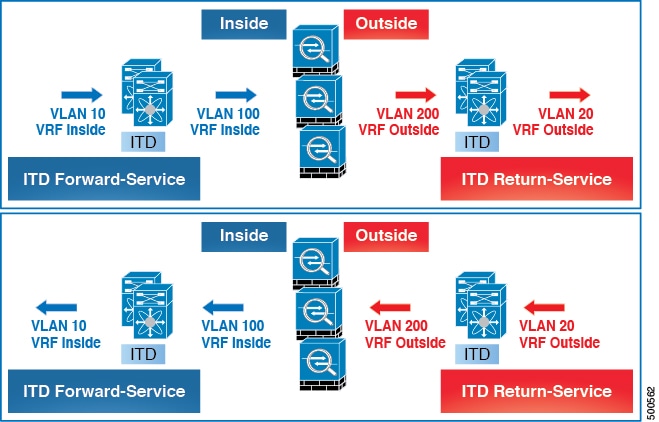

VRF のサポート

ITD サービスは、デフォルト VRF でもデフォルト以外の VRF でも構成できます。

入力インターフェイスは、ITD サービス用に設定された VRF に属している必要があります。サービスに VRF が構成されていない場合、入力インターフェイスはデフォルト VRF に属している必要があります。

Cisco NX-OS リリース 10.2(1) 以降では、ITD デバイス グループに対して VRF を構成できます。すべてのデバイス グループ ノード メンバーは、ITD デバイス グループ用に構成された VRF で到達可能である必要があります。デバイス グループに VRF が構成されていない場合、サービスのすべての入力インターフェイスと関連付けられたデバイス グループのノード メンバーが、サービスに構成された VRF で到達可能であることを確認する必要があります。デバイス グループとサービスに VRF が構成されていない場合、サービスのすべての入力インターフェイスと、関連付けられたデバイス グループのノード メンバーは、デフォルト VRF で到達可能である必要があります。

ACL の組み込みと除外

インクルード ACL

インクルード ACL 機能を使用すると、ITD サービスにアクセス制御リスト(ACL)を割り当てることができます。ACE に一致するトラフィックのみがノードに向かって負荷分散され、他のトラフィックはデフォルトのルーティング ルールに従います。

1 つの ITD サービスで最大 8 つのアクセス リストを設定できます。各アクセス リストを独自のデバイス グループ(マルチ ACL)に関連付けることができます。特定のデバイス グループが 1 つのユーザー ACL に関連付けられている場合、そのデバイス グループが優先され、デフォルトのデバイス グループが上書きされます。この機能により、ITD はさまざまな ACL に一致するトラフィックをさまざまなデバイス グループにロードバランシングできます。

除外 ACL

除外 ACL を設定して、ITD が ITD ロードバランサから除外するトラフィックを指定できます。除外 ACL が選択するトラフィックは RIB ルーティングされ、ITD をバイパスします。除外 ACL は、送信元フィールドと接続先フィールドの両方に基づいてフィルタリングできます。除外 ACL は、仮想 IP アドレスの前にあります。

仮想 IP アドレスのフィルタリング

仮想 IP アドレスを使用して、ITD のトラフィックをフィルタリングできます。トラフィックフィルタリング用の仮想 IP アドレスとサブネット マスクの組み合わせは、宛先フィールドでのみサポートされます。

ポート番号ベースのフィルタリング

ポート番号付けを使用して、ITD のトラフィックをフィルタリングできます。レイヤ 4 ポート(たとえば、ポート 80)に基づいてトラフィックをフィルタリングするために、次の方法がサポートされています。

-

一致する宛先ポート

宛先ポートが 80 の任意の送信元または宛先 IP アドレスが一致します。(例:仮想 IP アドレスは 0.0.0.0 0.0.0.0 tcp 80 として構成されています。)

-

一致する送信元ポート

80 以外のポートは ITD をバイパスし、ポート 80 はリダイレクトされます。(例:除外 ACL は、permit tcp any neq 80 any として設定されます。)

-

複数のポート番号の一致

ITD では、ポートごとに 1 つずつ、複数の仮想 IP アドレス行を設定できます。

ホットスタンバイ

ホットスタンバイ機能は、スイッチを再構成して、動作可能なホットスタンバイ ノードを探し、最初に使用可能なホットスタンバイ ノードを選択して、障害が発生したノードを置き換えます。ITD は、障害が発生したノードを当初宛先としていたトラフィック セグメントを、ホットスタンバイ ノードにリダイレクトするようにスイッチを再設定します。このサービスは、ホットスタンバイ ノードとアクティブ ノードとの固定マッピングを強要しません。

障害が発生したノードが再び動作可能になると、アクティブ ノードとして復元されます。動作中のホットスタンバイ ノードからのトラフィックは元のノードにリダイレクトされ、ホットスタンバイ ノードはスタンバイ ノードのプールに戻ります。

複数のノードで障害が発生した場合、それらすべてのノードを宛先とするトラフィックは、最初に使用可能なホットスタンバイ ノードにリダイレクトされます。

ホットスタンバイ ノードは、ノード レベルでのみ構成できます。ノード レベルで、関連付けられたアクティブ ノードが失敗した場合にのみホットスタンバイ ノードはトラフィックを受信します。

ITD は N + M 冗長性をサポートしており、M ノードは N アクティブ ノードのホットスタンバイ ノードとして機能できます。

複数の入力インターフェイス

複数の入力インターフェイスに対してトラフィック リダイレクト ポリシーを適用するように ITD サービスを構成できます。この機能では、単一の ITD サービスを使用して、さまざまなインターフェイスに到着するトラフィックを一連のノードにリダイレクトできます。

Cisco NX-OS リリース 7.0(3)I7(3) 以降、同じ入力インターフェイスを 2 つの ITD サービスに含めることができ、1 つの IPv4 ITD サービスと 1 つの IPv6 ITD サービスが可能になります。

IPv4 と IPv6 の両方の ITD サービスに同じ入力インターフェイスを含めると、IPv4 と IPv6 の両方のトラフィックが同じ入力インターフェイスに到着することができます。IPv4 トラフィックをリダイレクトするために IPv4 ITD ポリシーが適用され、IPv6 トラフィックをリダイレクトするために IPv6 ITD ポリシーが適用されます。

(注) |

同じ入力インターフェイスが複数の IPv4 ITD サービスまたは複数の IPv6 ITD サービスで参照されていないことを確認してください。システムはそれを自動的に適用せず、サポートされていません。 |

(注) |

ITD IPv4 サービスは、IPv4 PBR ポリシーがすでに適用されている入力インターフェイスでは有効にできません。ITD IPv6 サービスは、IPv6 PBR ポリシーがすでに適用されている入力インターフェイスでは有効にできません。 |

システム ヘルスモニタリング

ITD は、ノードとそれらのノードで実行されているアプリケーションの状態を定期的に監視して、障害を検出し、障害シナリオを処理します。

ICMP、TCP、UDP、DNS、および HTTP プローブがサポートされています。

ノードに接続されたインターフェイスの正常性

Cisco NX-OS リリース 7.0(3)I3(1) 以降、ITD ITD は IP サービスレベル アグリーメント(IP SLA)機能を利用して、各ノードを定期的にプローブします。以前のリリースでは、ITD は Internet Control Message Protocol(ICMP)を使用して、各ノードを定期的にプローブします。プローブはデフォルトで 10 秒の頻度で送信され、1 秒まで設定できます。それらはすべてのノードに同時に送信されます。プール グループ構成の一部としてプローブを構成できます。

プローブは、デフォルトで 3 回再試行した後に障害が発生したと宣言されます。この時点で、ノードの状態は「機能不全」、ステータスは「PROBE_FAILED」になります。

ノード障害の処理

ノードがダウン状態としてマークされると、ITD はトラフィックの中断を最小限に抑えて、トラフィックを残りの運用可能なノードに再配布するために自動的に次のタスクを行います。

-

障害が発生したノードを引き継ぐようにスタンバイ ノードが構成されているかどうかを判別します。

-

スタンバイ ノードが運用可能な場合、トラフィックを処理するノードの候補としてそのノードを識別します。

-

運用可能なスタンバイ ノードを使用できる場合、トラフィックを処理するアクティブ ノードとしてそのスタンバイ ノードを再定義します。

-

障害が発生したノードから新しくアクティブにされたスタンバイ ノードにトラフィックを再割り当てするように自動的にプログラムします。

Failaction 再割り当て

ITD の Failaction により、障害が発生したノードへのトラフィックを 1 つ以上のアクティブ ノードに再割り当てできます。障害が発生したノードが再びアクティブになると、接続の処理が再開されます。すべてのノードがダウンした場合、パケットは自動的にルーティングされます。すべての Failaction メカニズムは、IPv4 サービスと IPv6 サービスの両方でサポートされます。

(注) |

Failaction 機能をイネーブルにする前に、ITD デバイス グループにプローブを設定する必要があります。 |

Failaction ノードの再割り当て

ノードがダウンすると、そのノードに関連付けられたトラフィック バケットは、構成されている一連のノードで最初に検出されたアクティブ ノードに再割り当てされます。新しく再割り当てされたノードでも障害が発生すると、トラフィックは次に使用可能なアクティブ ノードに再割り当てされます。

ノードが回復し、それ以上の障害イベントがない場合は、障害が発生する前にノードに最初に割り当てられていたトラフィック バケットがそのノードに再割り当てされます。

Failaction ノードの最小バケット(Failaction Node Least-Bucket)

ノードがダウンすると、そのノードに関連付けられたトラフィック バケットは、現在最小数のトラフィック バケットからトラフィックを受信しているアクティブ ノードに再割り当てされます。後続のノード障害ごとに、トラフィック バケットが最も少ないアクティブ ノードが再計算され、障害が発生したノードに向けられたすべてのバケットがこのノードにリダイレクトされるため、再割り当てされたバケットを複数のアクティブ ノードに分散できます。

ノードが回復し、それ以上の障害イベントがない場合は、障害が発生する前にノードに最初に割り当てられていたトラフィック バケットがそのノードに再割り当てされます。

Failaction バケット分配(Failaction Bucket Distribute)

サービスが有効な場合、ITD は内部アルゴリズムを使用して、プライマリ ノードのさまざまなシーケンスを、プライマリ ノードごとに異なる優先順位を持つ代替バックアップ パスとして事前に選択します。ノードがダウンすると、そのノードへのトラフィックは、優先度が最も高い最初のアクティブ バックアップ ノードにリダイレクトされ、その後の障害についても同様にリダイレクトされ、それによってコンバージェンスの遅延が最小限に抑えられます。

ノードが回復すると、最初にプライマリとしてこのノードに割り当てられていたトラフィック バケットがそのノードに再割り当てされます。プライマリ ノードがまだ障害状態であり、新しく回復したノードが最も優先順位の高いアクティブ バックアップとして動作するトラフィック バケットも、そのトラフィック バケットに再割り当てされます。

のプライマリ ノード、またはデバイス グループの最大 32 のプライマリ ノード(いずれか少ない方)が、ノードごとに異なる優先順位で事前に選択されます。

(注) |

このアルゴリズムは、比較的均等なトラフィック分散を目的としていますが、ノード障害が発生した場合の均等な分散を保証するものではありません。 |

Failaction Node-Per-Bucket

特定のノードに障害が発生すると、バケットの数が最も少ないノードが識別され、バケットは、バケットの数が最も少ないノードから開始して、他のアクティブ ノードに分散されます。

ITD は、現在最も少ないバケット ノードを繰り返し識別し、すべてのバケットが再割り当てされるまで、そのノードに 1 つのバケットを割り当てます。したがって、すべてのバケットは、残りのすべてのアクティブ ノード間で均等に分散されます。

(注) |

Cisco Nexus NX-OS リリース 9.3(5) 以降、ITD ITD は、ノードの重みに基づいて、フェールオーバーするノードを識別します。ノードに重みが設定されていない場合、デフォルトの重み 1 が使用されます。 |

Failaction 再割り当てを使用しない場合

Failaction によるノードの再割り当てを設定しない場合は、次の 2 つのシナリオが考えられます。

プローブを構成して Failaction 再割り当てをしない

ITD プローブでは、ノードの障害やサービス到達可能性の消失を検出できます。ノードに障害が発生した場合、failaction が設定されていないため、トラフィックはルーティングされ、再割り当てされません。ノードが回復すると、その回復したノードがトラフィックの処理を開始します。

プローブの構成なしで Failaction 再割り当てをしない

プローブが構成されていないと、ITD はノードの障害を検出できません。ノードがダウンしても、ITD はアクティブ ノードへのトラフィックの再割り当てまたはリダイレクトを行いません。

フィードバック

フィードバック