Vervanging van OSPD-server UCS 240M4 - vEPC

Downloadopties

Inclusief taalgebruik

De documentatie van dit product is waar mogelijk geschreven met inclusief taalgebruik. Inclusief taalgebruik wordt in deze documentatie gedefinieerd als taal die geen discriminatie op basis van leeftijd, handicap, gender, etniciteit, seksuele oriëntatie, sociaaleconomische status of combinaties hiervan weerspiegelt. In deze documentatie kunnen uitzonderingen voorkomen vanwege bewoordingen die in de gebruikersinterfaces van de productsoftware zijn gecodeerd, die op het taalgebruik in de RFP-documentatie zijn gebaseerd of die worden gebruikt in een product van een externe partij waarnaar wordt verwezen. Lees meer over hoe Cisco gebruikmaakt van inclusief taalgebruik.

Over deze vertaling

Cisco heeft dit document vertaald via een combinatie van machine- en menselijke technologie om onze gebruikers wereldwijd ondersteuningscontent te bieden in hun eigen taal. Houd er rekening mee dat zelfs de beste machinevertaling niet net zo nauwkeurig is als die van een professionele vertaler. Cisco Systems, Inc. is niet aansprakelijk voor de nauwkeurigheid van deze vertalingen en raadt aan altijd het oorspronkelijke Engelstalige document (link) te raadplegen.

Inhoud

Inleiding

In dit document worden de stappen beschreven die nodig zijn om een defecte server te vervangen waarop de OpenStack Platform Director (OSPD) wordt gehost in een Ultra-M setup.

Achtergrondinformatie

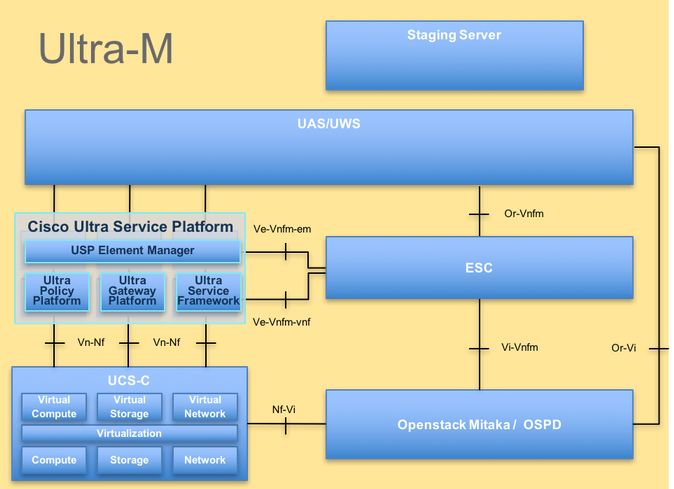

Ultra-M is een voorverpakte en gevalideerde gevirtualiseerde mobiele packet-core-oplossing die ontworpen is om de implementatie van VNF's te vereenvoudigen. OpenStack is de gevirtualiseerde Infrastructuurbeheerder (VIM) voor Ultra-M en bestaat uit de volgende knooppunten:

- Computeren

- Object Storage Disk - computing (OSD - computing)

- Controller

- OSPD

De hoogwaardige architectuur van Ultra-M en de betrokken componenten worden in dit beeld weergegeven:

UltraM-architectuur

UltraM-architectuur

Dit document is bedoeld voor het Cisco-personeel dat bekend is met Cisco Ultra-M platform en geeft de stappen aan die moeten worden uitgevoerd op OpenStack-niveau op het moment van de OSPD-serververvanging.

Opmerking: Ultra M 5.1.x release wordt overwogen om de procedures in dit document te definiëren.

Afkortingen

| VNF | Virtuele netwerkfunctie |

| CF | Bedieningsfunctie |

| SF | Servicefunctie |

| ESC | Elastic-servicecontroller |

| MOP | Werkwijze |

| OSD | Schijven voor objectopslag |

| HDD | Harde schijf |

| SSD | Solid state drive |

| VIM | Virtual Infrastructure Manager |

| VM | Virtuele machine |

| EM | Element Manager |

| UAS | Ultra-automatiseringsservices |

| UUID | Universele unieke IDentifier |

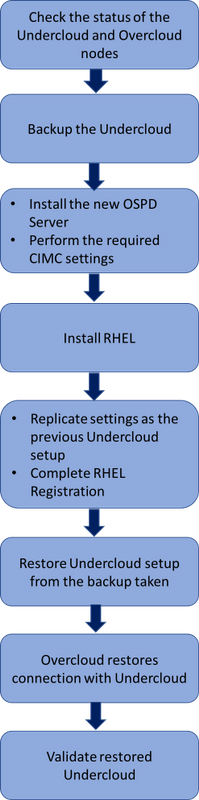

Werkstroom van de MoP

Werkstroom op hoog niveau van de vervangingsprocedure

Werkstroom op hoog niveau van de vervangingsprocedure

Voorwaarden

Statuscontrole

Voordat u een OSPD-server vervangt, is het belangrijk om de huidige status van de Red Hat OpenStack Platform omgeving te controleren en ervoor te zorgen dat het gezond is om complicaties te voorkomen wanneer het vervangingsproces is ingeschakeld.

Controleer de status van de OpenStack-stack en de lijst met knooppunten:

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack stack list --nested

[stack@director ~]$ ironic node-list

[stack@director ~]$ nova list

Zorg ervoor dat alle undercloud-services in geladen, actieve en actieve staat van de OSP-D-knooppunt zijn:

[stack@director ~]$ systemctl list-units "openstack*" "neutron*" "openvswitch*"

UNIT LOAD ACTIVE SUB DESCRIPTION

neutron-dhcp-agent.service loaded active running OpenStack Neutron DHCP Agent

neutron-openvswitch-agent.service loaded active running OpenStack Neutron Open vSwitch Agent

neutron-ovs-cleanup.service loaded active exited OpenStack Neutron Open vSwitch Cleanup Utility

neutron-server.service loaded active running OpenStack Neutron Server

openstack-aodh-evaluator.service loaded active running OpenStack Alarm evaluator service

openstack-aodh-listener.service loaded active running OpenStack Alarm listener service

openstack-aodh-notifier.service loaded active running OpenStack Alarm notifier service

openstack-ceilometer-central.service loaded active running OpenStack ceilometer central agent

openstack-ceilometer-collector.service loaded active running OpenStack ceilometer collection service

openstack-ceilometer-notification.service loaded active running OpenStack ceilometer notification agent

openstack-glance-api.service loaded active running OpenStack Image Service (code-named Glance) API server

openstack-glance-registry.service loaded active running OpenStack Image Service (code-named Glance) Registry server

openstack-heat-api-cfn.service loaded active running Openstack Heat CFN-compatible API Service

openstack-heat-api.service loaded active running OpenStack Heat API Service

openstack-heat-engine.service loaded active running Openstack Heat Engine Service

openstack-ironic-api.service loaded active running OpenStack Ironic API service

openstack-ironic-conductor.service loaded active running OpenStack Ironic Conductor service

openstack-ironic-inspector-dnsmasq.service loaded active running PXE boot dnsmasq service for Ironic Inspector

openstack-ironic-inspector.service loaded active running Hardware introspection service for OpenStack Ironic

openstack-mistral-api.service loaded active running Mistral API Server

openstack-mistral-engine.service loaded active running Mistral Engine Server

openstack-mistral-executor.service loaded active running Mistral Executor Server

openstack-nova-api.service loaded active running OpenStack Nova API Server

openstack-nova-cert.service loaded active running OpenStack Nova Cert Server

openstack-nova-compute.service loaded active running OpenStack Nova Compute Server

openstack-nova-conductor.service loaded active running OpenStack Nova Conductor Server

openstack-nova-scheduler.service loaded active running OpenStack Nova Scheduler Server

openstack-swift-account-reaper.service loaded active running OpenStack Object Storage (swift) - Account Reaper

openstack-swift-account.service loaded active running OpenStack Object Storage (swift) - Account Server

openstack-swift-container-updater.service loaded active running OpenStack Object Storage (swift) - Container Updater

openstack-swift-container.service loaded active running OpenStack Object Storage (swift) - Container Server

openstack-swift-object-updater.service loaded active running OpenStack Object Storage (swift) - Object Updater

openstack-swift-object.service loaded active running OpenStack Object Storage (swift) - Object Server

openstack-swift-proxy.service loaded active running OpenStack Object Storage (swift) - Proxy Server

openstack-zaqar.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server

openstack-zaqar@1.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server Instance 1

openvswitch.service loaded active exited Open vSwitch

LOAD = Reflects whether the unit definition was properly loaded.

ACTIVE = The high-level unit activation state, i.e. generalization of SUB.

SUB = The low-level unit activation state, values depend on unit type.

37 loaded units listed. Pass --all to see loaded but inactive units, too.

To show all installed unit files use 'systemctl list-unit-files'.

Back-up

Zorg ervoor dat u voldoende schijfruimte beschikbaar hebt voordat u het back-upproces uitvoert. Verwacht wordt dat deze tarball minimaal 3,5 GB zal zijn.

[stack@director ~]$df -h

Voer deze opdracht uit als de hoofdgebruiker om een back-up te maken van de gegevens van de undercloud-knooppunt naar een bestand met de naam undercloud-backup-[timestamp].tar.gz.

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql

[root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack

tar: Removing leading `/' from member names

Installeer het nieuwe OSPD-knooppunt

UCS-serverinstallatie

De stappen voor het installeren van een nieuwe UCS C240 M4-server en de eerste setup-stappen kunnen worden doorverwezen vanuit Cisco UCS C240 M4-serverinstallatie- en servicegids.

Log in op server met behulp van CIMC IP.

Voer een BIOS-upgrade uit als de firmware niet overeenkomt met de aanbevolen versie die eerder is gebruikt. De stappen voor de BIOS-upgrade worden hier gegeven: Cisco UCS C-Series BIOS-upgrade-handleiding voor rackservers.

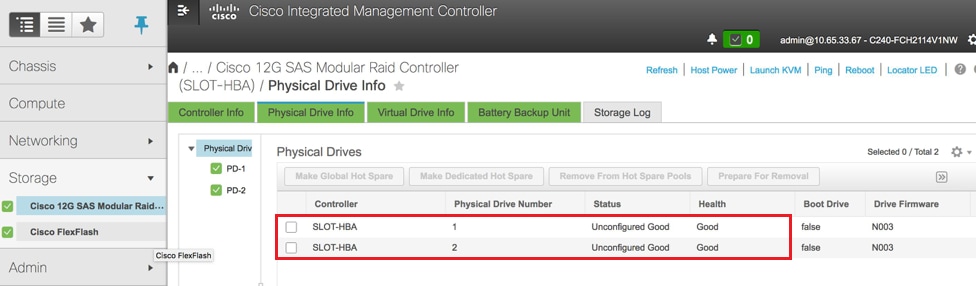

Controleer de status van Physical Drives. Het moet Ongeconfigureerd Goed zijn:

Ga naar Storage > Cisco 12G SAS Modular Raid Controller (SLEUF-HBA) > Physical Drive Info zoals hier in het beeld wordt getoond.

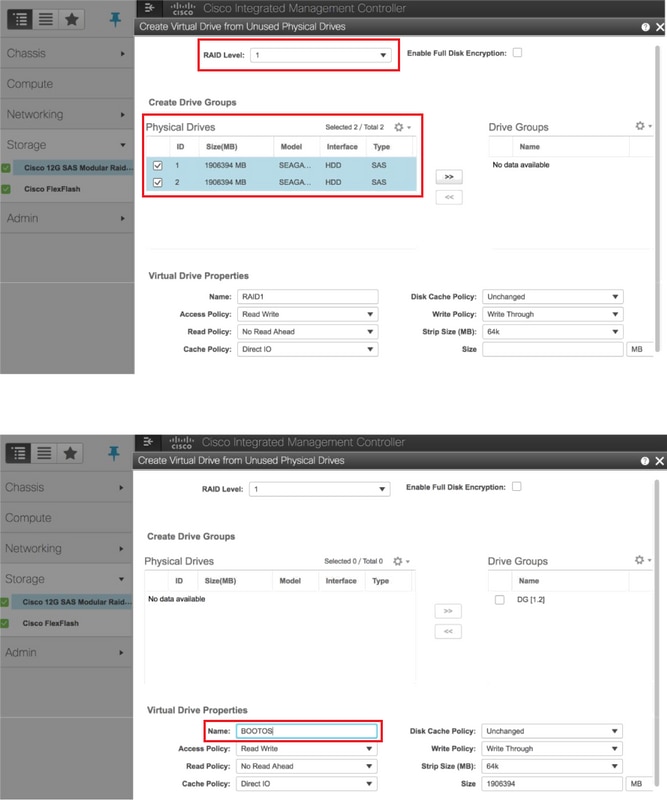

Maak een virtueel station van de fysieke schijven met RAID-niveau 1:

Navigeer naar Opslag > Cisco 12G SAS Modular Raid Controller (SLEUF-HBA) > Controller-informatie > Maak een virtuele schijf van ongebruikte fysieke schijven zoals in de afbeelding.

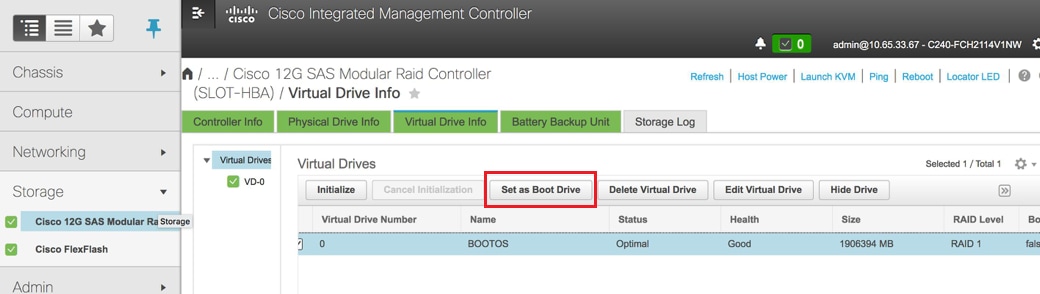

Selecteer de VD en configureer Set als Boot Drive zoals in de afbeelding.

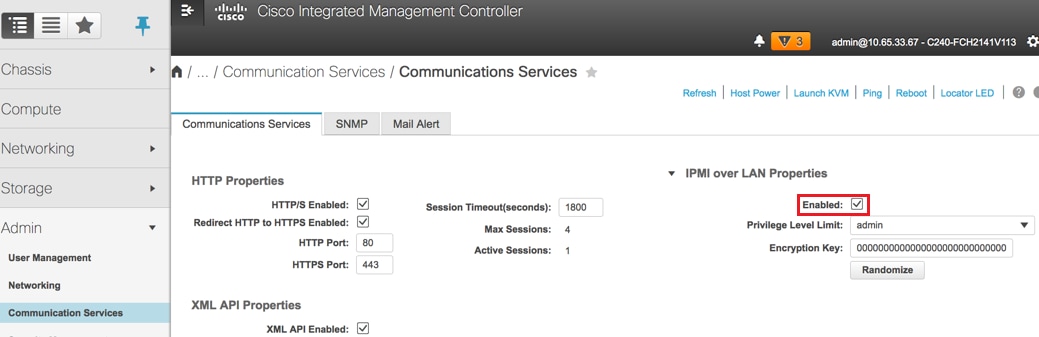

IPMI over LAN inschakelen:

Navigeer naar Beheerder > Communicatiediensten > Communicatiediensten zoals in de afbeelding.

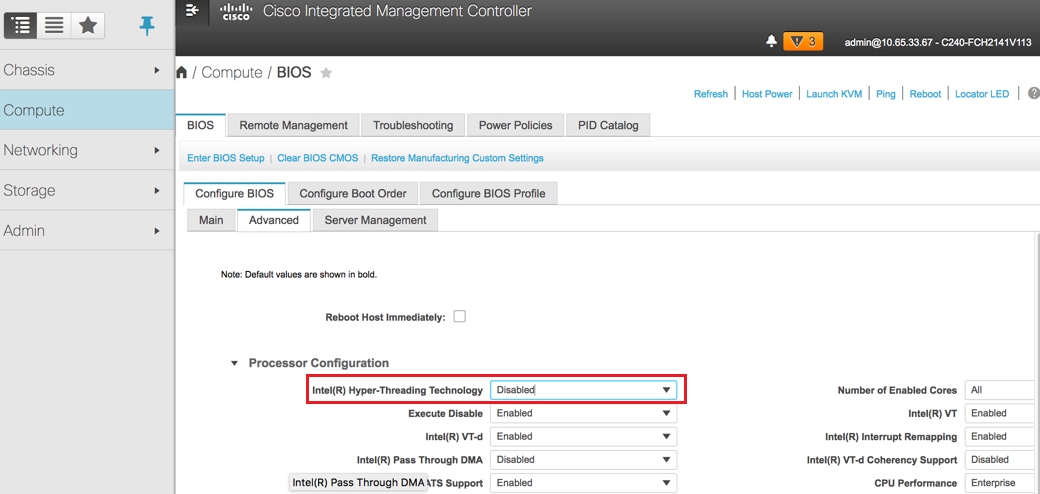

Hyperthreading uitschakelen:

Navigeer naar computing > BIOS > Configure BIOS > Advanced > Processor Configuration zoals getoond in de afbeelding.

Opmerking: Het hier getoonde beeld en de configuratie stappen die in deze sectie worden vermeld, hebben betrekking op de firmware versie 3.0(3e) en er kunnen kleine variaties optreden als u aan andere versies werkt.

Installatie met rode hoed

Monteer de Red Hat ISO Image

1. Log in op OSP-D Server.

2. Start KVM-console.

3. Navigeer naar Virtuele media > Virtuele apparaten activeren. Accepteer de sessie en schakel de geheugeninstelling in voor toekomstige verbindingen.

4. Selecteer Virtuele media > Cd/dvd toewijzenen breng de Red Hat ISO afbeelding in kaart.

5. Selecteer Voeding > Reset-systeem (warme start) om het systeem opnieuw op te starten.

6. Druk tijdens het opnieuw opstarten op F6en selecteer Cisco vKVM-versterkte vDVD1.2en druk Voer in.

Installeer Red Hat Enterprise Linux

Opmerking: De procedure in deze sectie vertegenwoordigt een vereenvoudigde versie van het installatieproces dat het minimumaantal parameters identificeert dat moet worden gevormd.

1. Selecteer de optie om Red Hat Enterprise Linux (RHEL) te installeren om de installatie te starten.

2. Selecteer Software selecteren > Alleen minimuminstallatie.

3. Configureer netwerkinterfaces (eno1 en eno2).

4. Klik op Network en Hostnaam.

- Selecteer de interface die zou worden gebruikt voor externe communicatie (eno1 of eno2)

- Klik op Configureren

- Selecteer het tabblad IPv4-instelling, selecteer de handmatige methode en klik op Toevoegen

- Stel deze parameters in zoals eerder gebruikt: Adres, Netmasker, Gateway, DNS-server

5. Selecteer Datum en tijd en geef de regio en de stad op.

6. Schakel netwerktijd in en configureer NTP-servers.

7. Selecteer Installatiebestemming en gebruik ext4-bestandssysteem .

Opmerking: Verwijderen /thuis/ en opnieuw toewijzen van de capaciteit onder root /.

8. Schakel Kdump uit.

9. Stel alleen Root-wachtwoord in.

10. Start de installatie .

De Undercloud herstellen

Installatie onder de cloud voorbereiden op basis van back-up

Nadat de machine met RHEL 7.3 is geïnstalleerd en in een schone staat verkeert, schakelt u alle abonnementen/repositories die nodig zijn voor het installeren en uitvoeren van de Director opnieuw in.

Configuratie Hostname:

[root@director ~]$sudo hostnamectl set-hostname <FQDN_hostname>

[root@director ~]$sudo hostnamectl set-hostname --transient <FQDN_hostname>

Bewerken/etc/hosts bestand:

[root@director ~]$ vi /etc/hosts

<ospd_external_address> <server_hostname> <FQDN_hostname>

10.225.247.142 pod1-ospd pod1-ospd.cisco.com

Waardebepaling hostnaam:

[root@director ~]$ cat /etc/hostname

pod1-ospd.cisco.com

DNS-configuratie valideren:

[root@director ~]$ cat /etc/resolv.conf

#Generated by NetworkManager

nameserver <DNS_IP>

Wijzig de voorlopige interface:

[root@director ~]$ cat /etc/sysconfig/network-scripts/ifcfg-eno1

DEVICE=eno1

ONBOOT=yes

HOTPLUG=no

NM_CONTROLLED=no

PEERDNS=no

DEVICETYPE=ovs

TYPE=OVSPort

OVS_BRIDGE=br-ctlplane

BOOTPROTO=none

MTU=1500

De registratie van de rode hoed voltooien

Download dit pakket om abonnementsbeheerder te configureren voor gebruik van rh-satelliet:

[root@director ~]$ rpm -Uvh http:///pub/katello-ca-consumer-latest.noarch.rpm

[root@director ~]$ subscription-manager config

Registreer bij rh-satelliet met behulp van deze activeringssleutel voor RHEL 7.3.

[root@director ~]$subscription-manager register --org="<ORG>" --activationkey="<KEY>"

Zo ziet u het abonnement:

[root@director ~]$ subscription-manager list –consumed

Schakel de repositories die vergelijkbaar zijn met de oude OSPD-repo's in:

[root@director ~]$ sudo subscription-manager repos --disable=*

[root@director ~]$ subscription-manager repos --enable=rhel-7-server-rpms --enable=rhel-7-server-extras-rpms --enable=rh

el-7-server-openstack-10-rpms --enable=rhel-7-server-rh-common-rpms --enable=rhel-ha-for-rhel-7-server-rpm

Werk uw systeem bij om er zeker van te zijn dat u over de nieuwste basissysteempakketten beschikt en start het systeem opnieuw:

[root@director ~]$sudo yum update -y

[root@director ~]$sudo reboot

Undercloud-herstel

Nadat u het abonnement hebt ingeschakeld, importeert u het opgeslagen tar-bestand undercloud-back-updatum +%F".tar.gz naar nieuwe OSP-D server root directory /root.

Installeer de mariadb server:

[root@director ~]$ yum install -y mariadb-server

Extraheer het MariaDB-configuratiebestand en de database (DB) back-up. Voer deze handeling uit als hoofdgebruiker.

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/my.cnf.d/server.cnf

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz root/undercloud-all-databases.sql

Bewerk /etc/my.cnf.d/server.cnf en becommentarieer de bind-address vermelding indien aanwezig:

[root@tb3-ospd ~]# vi /etc/my.cnf.d/server.cnf

Start de MariaDB service en update tijdelijk de max_allowable_packet instelling:

[root@director ~]$ systemctl start mariadb

[root@director ~]$ mysql -uroot -e"set global max_allowed_packet = 16777216;"

Reinig bepaalde machtigingen (later opnieuw te creëren):

[root@director ~]$ for i in ceilometer glance heat ironic keystone neutron nova;do mysql -e "drop user $i";done

[root@director ~]$ mysql -e 'flush privileges'

Opmerking: Als de plafondservice eerder is uitgeschakeld in de installatie, voert u deze opdracht uit en verwijdert u de plafondmeter.

De stapelgebruikersaccount maken:

[root@director ~]$ sudo useradd stack

[root@director ~]$ sudo passwd stack << specify a password

[root@director ~]$ echo "stack ALL=(root) NOPASSWD:ALL" | sudo tee -a /etc/sudoers.d/stack

[root@director ~]$ sudo chmod 0440 /etc/sudoers.d/stack

De Stack User Home directory terugzetten:

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz home/stack

Installeer de snelle en glance basispakketten en herstel vervolgens hun gegevens:

[root@director ~]$ yum install -y openstack-glance openstack-swift

[root@director ~]$ tar --xattrs -xzC / -f undercloud-backup-$DATE.tar.gz srv/node var/lib/glance/images

Bevestig dat de gegevens het eigendom zijn van de juiste gebruiker:

[root@director ~]$ chown -R swift: /srv/node

[root@director ~]$ chown -R glance: /var/lib/glance/images

Herstel de undercloud SSL-certificaten (optioneel - alleen te doen als de setup SSL-certificaten gebruikt).

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/instack-certs/undercloud.pem

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/ca-trust/source/anchors/ca.crt.pem

Voer de installatie van de undercloud opnieuw uit als de stapelgebruiker en zorg ervoor dat deze in de stack user home directory wordt uitgevoerd:

[root@director ~]$ su - stack

[stack@director ~]$ sudo yum install -y python-tripleoclient

Bevestig dat de hostnaam correct is ingesteld in /etc/hosts.

Installeer de ondercloud opnieuw:

[stack@director ~]$ openstack undercloud install

<snip>

#############################################################################

Undercloud install complete.

The file containing this installation's passwords is at

/home/stack/undercloud-passwords.conf.

There is also a stackrc file at /home/stack/stackrc.

These files are needed to interact with the OpenStack services, and must be

secured.

#############################################################################

Sluit de Herstelde Undercloud weer aan op de Overcloud

Nadat u deze stappen hebt voltooid, kan worden verwacht dat de undercloud automatisch zijn verbinding met de overcloud zal herstellen. De knooppunten blijven de Orchestratie (warmte) opvragen voor lopende taken, met behulp van een simpel HTTP-verzoek dat elke paar seconden wordt uitgegeven.

Voltooid herstel valideren

Gebruik deze opdrachten om een gezondheidscontrole van de pas herstelde omgeving uit te voeren:

[root@director ~]$ su - stack

Last Log in: Tue Nov 28 21:27:50 EST 2017 from 10.86.255.201 on pts/0

[stack@director ~]$ source stackrc

[stack@director ~]$ nova list

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| ID | Name | Status | Task State | Power State | Networks |

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| b1f5294a-629e-454c-b8a7-d15e21805496 | pod1-compute-0 | ACTIVE | - | Running | ctlplane=192.200.0.119 |

| 9106672e-ac68-423e-89c5-e42f91fefda1 | pod1-compute-1 | ACTIVE | - | Running | ctlplane=192.200.0.120 |

| b3ed4a8f-72d2-4474-91a1-b6b70dd99428 | pod1-compute-2 | ACTIVE | - | Running | ctlplane=192.200.0.124 |

| 677524e4-7211-4571-ac35-004dc5655789 | pod1-compute-3 | ACTIVE | - | Running | ctlplane=192.200.0.107 |

| 55ea7fe5-d797-473c-83b1-d897b76a7520 | pod1-compute-4 | ACTIVE | - | Running | ctlplane=192.200.0.122 |

| c34c1088-d79b-42b6-9306-793a89ae4160 | pod1-compute-5 | ACTIVE | - | Running | ctlplane=192.200.0.108 |

| 4ba28d8c-fb0e-4d7f-8124-77d56199c9b2 | pod1-compute-6 | ACTIVE | - | Running | ctlplane=192.200.0.105 |

| d32f7361-7e73-49b1-a440-fa4db2ac21b1 | pod1-compute-7 | ACTIVE | - | Running | ctlplane=192.200.0.106 |

| 47c6a101-0900-4009-8126-01aaed784ed1 | pod1-compute-8 | ACTIVE | - | Running | ctlplane=192.200.0.121 |

| 1a638081-d407-4240-b9e5-16b47e2ff6a2 | pod1-compute-9 | ACTIVE | - | Running | ctlplane=192.200.0.112 |

<snip>

[stack@director ~]$ ssh heat-admin@192.200.0.107

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod1-controller-0 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

3 nodes and 22 resources configured

Online: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Full list of resources:

ip-10.1.10.10 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.97 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

ip-192.200.0.106 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.95 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

ip-11.119.0.98 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.118.0.92 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: redis-master [redis]

Masters: [ pod1-controller-0 ]

Slaves: [ pod1-controller-1 pod1-controller-2 ]

openstack-cinder-volume (systemd:openstack-cinder-volume): Started pod1-controller-0

my-ipmilan-for-controller-0 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-1 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-2 (stonith:fence_ipmilan): Stopped

Failed Actions:

* my-ipmilan-for-controller-0_start_0 on pod1-controller-1 'unknown error' (1): call=190, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-1 'unknown error' (1): call=192, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-1 'unknown error' (1): call=188, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-0 'unknown error' (1): call=210, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-0 'unknown error' (1): call=207, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-0 'unknown error' (1): call=206, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20006ms

* ip-192.200.0.106_monitor_10000 on pod1-controller-0 'not running' (7): call=197, status=complete, exitreason='none',

last-rc-change='Wed Nov 22 13:51:31 2017', queued=0ms, exec=0ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-2 'unknown error' (1): call=183, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=1ms, exec=20006ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-2 'unknown error' (1): call=184, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-2 'unknown error' (1): call=177, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:02 2017', queued=0ms, exec=20005ms

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[heat-admin@pod1-controller-0 ~]$ sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod1-controller-0=11.118.0.40:6789/0,pod1-controller-1=11.118.0.41:6789/0,pod1-controller-2=11.118.0.42:6789/0}

election epoch 58, quorum 0,1,2 pod1-controller-0,pod1-controller-1,pod1-controller-2

osdmap e1398: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v1245812: 704 pgs, 6 pools, 542 GB data, 352 kobjects

1625 GB used, 11767 GB / 13393 GB avail

704 active+clean

client io 21549 kB/s wr, 0 op/s rd, 120 op/s wr

Controleer de werking van Identity Service (Keystone)

Deze stap valideert de identiteitsservice door een lijst met gebruikers op te vragen.

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack user list

+----------------------------------+------------------+

| ID | Name |

+----------------------------------+------------------+

| 69ac2b9d89414314b1366590c7336f7d | admin |

| f5c30774fe8f49d0a0d89d5808a4b2cc | glance |

| 3958d852f85749f98cca75f26f43d588 | heat |

| cce8f2b7f1a843a08d0bb295a739bd34 | ironic |

| ce7c642f5b5741b48a84f54d3676b7ee | ironic-inspector |

| a69cd42a5b004ec5bee7b7a0c0612616 | mistral |

| 5355eb161d75464d8476fa0a4198916d | neutron |

| 7cee211da9b947ef9648e8fe979b4396 | nova |

| f73d36563a4a4db482acf7afc7303a32 | swift |

| d15c12621cbc41a8a4b6b67fa4245d03 | zaqar |

| 3f0ed37f95544134a15536b5ca50a3df | zaqar-websocket |

+----------------------------------+------------------+

[stack@director ~]$

[stack@director ~]$ source <overcloudrc>

[stack@director ~]$ openstack user list

+----------------------------------+------------+

| ID | Name |

+----------------------------------+------------+

| b4e7954942184e2199cd067dccdd0943 | admin |

| 181878efb6044116a1768df350d95886 | neutron |

| 6e443967ee3f4943895c809dc998b482 | heat |

| c1407de17f5446de821168789ab57449 | nova |

| c9f64c5a2b6e4d4a9ff6b82adef43992 | glance |

| 800e6b1163b74cc2a5fab4afb382f37d | cinder |

| 4cfa5a2a44c44c678025842f080e5f53 | heat-cfn |

| 9b222eeb8a58459bb3bfc76b8fff0f9f | swift |

| 815f3f25bcda49c290e1b56cd7981d1b | core |

| 07c40ade64f34a64932129175150fa4a | gnocchi |

| 0ceeda0bc32c4d46890e53adef9a193d | aodh |

| f3caab060171468592eab376a94967b8 | ceilometer |

+----------------------------------+------------+

[stack@director ~]$

Afbeeldingen uploaden voor Future Node Introspection

Valideren /httpboot en al deze bestanden inspector.ipxe, agent.kernel, agent.ramdisk, als niet te gaan naar deze stappen.

[stack@director ~]$ ls /httpboot

inspector.ipxe

[stack@director ~]$ source stackrc

[stack@director ~]$ cd images/

[stack@director images]$ openstack overcloud image upload --image-path /home/stack/images

Image "overcloud-full-vmlinuz" is up-to-date, skipping.

Image "overcloud-full-initrd" is up-to-date, skipping.

Image "overcloud-full" is up-to-date, skipping.

Image "bm-deploy-kernel" is up-to-date, skipping.

Image "bm-deploy-ramdisk" is up-to-date, skipping.

[stack@director images]$ ls /httpboot

agent.kernel agent.ramdisk inspector.ipxe

[stack@director images]$

Opnieuw omheinen

Het omheinen zal in tegengehouden staat na OSPD herstel zijn. Deze procedure maakt afrasteringen mogelijk.

[heat-admin@pod1-controller-0 ~]$ sudo pcs property set stonith-enabled=true

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

[heat-admin@pod1-controller-0 ~]$sudo pcs stonith show

Gerelateerde informatie

Bijgedragen door Cisco-engineers

- Padmaraj RamanoudjamCisco geavanceerde services

- Partheban RajagopalCisco geavanceerde services

Contact Cisco

- Een ondersteuningscase openen

- (Vereist een Cisco-servicecontract)

Feedback

Feedback