はじめに

コンバージド イーサネット上の RDMA (RoCEv2)

RDMA Over コンバージド イーサネット (RoCE) v2 上のリモート ダイレクト メモリ アクセス (RDMA) では、ネットワーク上で直接メモリにアクセスすることができます。これは、イーサネットを介して Infiniband (IB) トランスポート パケットをカプセル化することによって行われます。RoCEv1 と RoCEv2 の 2 つの RoCE バージョンがあります。RoCEv1 はイーサネット リンク層プロトコルであるため、同じイーサネット ブロードキャスト ドメインにある任意の 2 ホスト間の通信を可能にします。RoCEv2 はインターネット層プロトコルであり、これは RoCEv2 パケットをルーティングできることを意味します。

RoCEv2 プロトコルは、UDP/IPv4 または UDP/IPv6 プロトコルのいずれかの上に存在します。UDP 宛先ポート番号4791は、RoCEv2 用に予約されています。RoCEv2 パケットはルーティング可能であるため、RoCEv2 プロトコルはルーティング可能な RoCE とも呼ばれます。

RoCEv2 は、Windows および Linux プラットフォームでサポートされています。

このドキュメントでは、Cisco Integrated Management Controller (Cisco IMC) を使用してモード 1 およびモード 2 で RoCEv2 を設定する方法について説明します。このドキュメントでは、vNIC のプロパティを設定する手順については説明しません。vNIC プロパティを設定する手順の詳細については、ご使用の Cisco IMC リリースの『設定ガイド』を参照してください。

ファイバ経由の NVMe

ファブリック上の NVMe (NVMeoF) は、あるコンピュータが別のコンピュータで使用可能な NVMe ネームスペースにアクセスできる通信プロトコルです。NVMeoF ストレージ デバイスを検出、接続、および接続解除するためのコマンドは、Linux に記載されているnvmeユーティリティに統合されています。Cisco がサポートする NVMeoF は、コンバージド イーサネット バージョン 2 (RoCEv2) 上の RDMA です。eNIC RDMA ドライバは eNIC ドライバと連携して動作します。これは、NVMeoF を設定するときに最初にロードする必要があります。

RoCEv2 を搭載した SMB ダイレクトを使用する際のガイドライン

一般的なガイドラインと制限事項

-

Cisco IMC 4.1.x 以降のリリース場合、Windows 2019 で RoCEv2 を搭載した Microsoft SMB ダイレクトをサポートしています。Microsoft からのすべての KB 更新を使用することを推奨します。

(注)

RoCEv2 は Windows サーバ 2016 ではサポートされていません。

-

Cisco では、Cisco IMC リリースに特有の UCS ハードウェアおよびソフトウェア互換性を確認して、Microsoft 2019 で RoCEv2 を使用した Microsoft SMB ダイレクトのサポートを決定することをお勧めします。

-

RoCEv2 を使用した Microsoft SMB ダイレクトは、Cisco UCS VIC 14xx シリーズ アダプタでのみサポートされています。RoCEv2 は、UCS VIC 12xx シリーズおよび 13xx シリーズ アダプタではサポートされていません。

(注)

RoCE v1 は、Cisco UCS VIC 14xx シリーズ アダプタではサポートされていません。

-

Cisco のアダプタ間では、RoCEv2 設定がサポートされています。シスコのアダプタとサードパーティ製のアダプタ間の相互運用性はサポートされていません。

-

アダプタごとに 2 つの RoCEv2 対応 vNIC のみがサポートされています。

-

アダプタ インターフェイスごとに 4 個の仮想ポートをサポートします。これは、セット スイッチ設定とは無関係です。

-

RoCEv2 は、NVGRE、NetFlow、および VMQ 機能と同じ vNIC インターフェイスでは使用できません。

-

RoCEv2 対応の vNIC インターフェイスでは、UCS Manager で非ドロップ QoS システム クラスが有効になっている必要があります。

-

RoCEv2 プロパティのキュー ペア設定は、少なくとも 4 個のキュー ペアにする必要があります。

-

アダプタごとのキュー ペアの最大数は 2048 個です。

-

RNIC インターフェイスあたりのメモリ領域の最大数は 131072 です。

-

Cisco IMC は、RoCEv2 対応の vNIC に対してファブリック フェールオーバーをサポートしません。

-

QOS no-drop クラス設定は、アップストリーム スイッチで正しく設定する必要があります。例:N9K

QoS の設定は、異なるアップストリーム スイッチ間で異なります。

-

Windows プラットフォームでの RoCEv2 の設定では、最初に RoCEv2 モード 1、次に RoCEv2 モード 2 を設定する必要があります。モード 1 と 2 は、ネットワーク ダイレクト カーネル プロバイダ インターフェイス (NDKPI) の実装に関連しています。モード 1 はネイティブ RDMA、モード 2 には RDMA を使用する仮想ポートの設定が含まれています。

MTU プロパティ

-

Windows の MTU は、Cisco IMC 設定からではなく、ジャンボ パケットのアドバンスト プロパティから導出されるようになりました。

-

VIC ドライバの古いバージョンは、MTU はスタンドアロン モードの Cisco IMC から導出されます。この動作は、VIC 14xx シリーズ アダプタで変更されました。 MTU は Windows OS ジャンボ パケットの詳細プロパティから制御されます。Cisco IMC から設定された値は影響しません。

-

RoCEv2 の MTU 値は常に 2 の累乗で、最大制限は 4096 です。

-

RoCEv2 MTU は、イーサネット MTU から導出されます。

-

RoCEv2 MTU は、イーサネット MTU よりも小さい最も高い電力量です。次に例を示します。

-

イーサネット値が 1500 の場合、RoCEv2 MTU 値は 1024 です。

-

イーサネット値が 4096 の場合、RoCEv2 MTU 値は 4096 です。

-

イーサネット値が 9000 の場合、RoCEv2 MTU 値は 4096 です。

-

RoCEv2 動作モード

Cisco IMC は、リリースに応じて 2 つのモードの RoCEv2 設定を提供します。

-

Cisco IMC リリース 4.1(1c) 以降では、RoCEv2 はモード 1 およびモード 2 で設定できます。

モード 1 では、仮想マシン キュー (VMQ) で既存の RoCEv2 プロパティを使用します。

モード 2 では、マルチキュー RoCEv2 プロパティを設定するための追加機能が導入されています。

モード 2 操作のために RoCEv2 が有効になっている vNICs では、信頼ホスト CoS が有効になっている必要があります。

RoCEv2 モード 1 およびモード 2 は相互に排他的です。RoCEv2 モード 2 を動作させるには、RoCEv2 モード 1 を有効にする必要があります。

-

4.1(1c) よりも前の Cisco IMC リリースでは、モード 1 のみがサポートされており、VMQ RoCE プロパティから設定できます。

ダウングレードに関する制限事項

Cisco では、サポートされていない RoCEv2 リリースにダウングレードする前に、RoCEv2 の設定を削除することを推奨しています。設定が削除または無効になっていない場合、ダウングレードは失敗する可能性があります。

モード 1 での vNIC プロパティの設定

VMQ RoCEv2 プロパティを使用して vNIC プロパティを設定するには、次の手順に従います。

始める前に

Cisco IMC GUI インターフェイスに精通するようにします。

手順の概要

- [Navigation] ペインの [Networking] メニューをクリックします。

- [Adapter Card] ペインで、[vNICs] タブをクリックします。

- [vNICs] ペインで、vNIC (デフォルトの eth0 または eth1、または新しく作成されたその他の vNIC のいずれか) を選択します。

- 必要に応じて vNIC のプロパティを設定します。詳細な手順については、『設定ガイド』を参照してください。モード 1 での RoCEv2 の設定に加えて、残りの手順を実行します。

- [vNIC プロパティ (vNIC Properties)] ペインの [全般 (General)] 領域で、[VMQ を有効化 (Enable VMQ)] チェックボックスをオンにします。

- [vNIC プロパティ (vNIC Properties)] ペインの [イーサネット割り込み (Ethernet Interrupt)] 領域で、次のフィールドを更新します。

- [vNIC プロパティ (vNIC Properties)] の [RoCE プロパティ (RoCE Properties)] 領域で、次のフィールドを更新します。

手順の詳細

| ステップ 1 |

[Navigation] ペインの [Networking] メニューをクリックします。 |

||||||||||||

| ステップ 2 |

[Adapter Card] ペインで、[vNICs] タブをクリックします。 |

||||||||||||

| ステップ 3 |

[vNICs] ペインで、vNIC (デフォルトの eth0 または eth1、または新しく作成されたその他の vNIC のいずれか) を選択します。 |

||||||||||||

| ステップ 4 |

必要に応じて vNIC のプロパティを設定します。詳細な手順については、『設定ガイド』を参照してください。モード 1 での RoCEv2 の設定に加えて、残りの手順を実行します。 |

||||||||||||

| ステップ 5 |

[vNIC プロパティ (vNIC Properties)] ペインの [全般 (General)] 領域で、[VMQ を有効化 (Enable VMQ)] チェックボックスをオンにします。 |

||||||||||||

| ステップ 6 |

[vNIC プロパティ (vNIC Properties)] ペインの [イーサネット割り込み (Ethernet Interrupt)] 領域で、次のフィールドを更新します。

|

||||||||||||

| ステップ 7 |

[vNIC プロパティ (vNIC Properties)] の [RoCE プロパティ (RoCE Properties)] 領域で、次のフィールドを更新します。

|

次のタスク

ホストの検証を実行して、モード 1 が正しく設定されていることを確認します。「ホスト上の設定の確認」を参照してください。

ホストシステムでの RoCEv2 モード 1 の設定

この手順を実行して、2 個のホスト インターフェイスで smb クライアントと smb サーバ間の接続を設定します。これらのサーバのそれぞれに対して、smb クライアントおよび smb サーバで、RoCEv2 対応 vNIC を設定します。

始める前に

Cisco IMC からモード 1 の RoCEv2 を設定します。モード 1 での vNIC プロパティの設定 を参照してください。

手順

| ステップ 1 |

Windows ホストで、[デバイス マネージャ (Device Manager)] に移動し、適切な Cisco VIC インターネット インターフェイスを選択します。 |

| ステップ 2 |

[アドバンスト (Advanced)] タブを選択し、[ネットワーク ダイレクト機能 (Network Direct Functionality)] プロパティが [有効 (Enabled)] になっていることを確認します。そうでない場合は有効にし、[OK] をクリックします。smb サーバと smb クライアントの両方の vNICs に対してこの手順を実行します。 |

| ステップ 3 |

を選択し、 を選択します。 |

| ステップ 4 |

PowerShell を使用して、ホスト オペレーティング システムで RoCE が有効になっていることを確認します。

|

| ステップ 5 |

Powershell を起動し、 SmbClientNetworkInterface コマンドを実行します。 |

| ステップ 6 |

enable - netadapterrdma [-name] ["Ethernetname"] と入力します |

| ステップ 7 |

ホストでの全体的な RoCEv2 モード 1 の設定を確認します。

|

| ステップ 8 |

Powershell コマンド ウィンドウで、 netstat-xan 出力コマンドを使用して接続エントリをチェックして、表示されていることを確認します。 |

| ステップ 9 |

デフォルトでは、Microsoft の SMB Direct は RDMA インターフェイスごとに 2 個の RDMA 接続を確立します。RDMA インターフェイスごとに RDMA 接続数を 1 個または複数の接続数に変更できます。 RDMA 接続数を 4 個に増やすには、PowerShell で次のコマンドを実行します。 |

次のタスク

RoCEv2 モード 2 を設定します。「モード 2 での vNIC プロパティの設定」を参照してください。

モード 2 での vNIC プロパティの設定

この手順に従い、モード 2 で vNIC プロパティを設定します。この手順は、Cisco IMC リリース 4.1(1c) 以降を使用して実行できます。

始める前に

-

Cisco IMC GUI インターフェイスに精通するようにします。

-

Cisco IMC リリース 4.1(1c) 以降を使用していることを確認します。

手順の概要

- [Navigation] ペインの [Networking] メニューをクリックします。

- [Adapter Card] ペインで、[vNICs] タブをクリックします。

- [vNICs] ペインで、vNIC (デフォルトの eth0 または eth1、または新しく作成されたその他の vNIC のいずれか) を選択します。

- 必要に応じて vNIC のプロパティを設定します。詳細な手順については、『設定ガイド』を参照してください。モード 1 での RoCEv2 の設定に加えて、残りの手順を実行します。

- [vNIC プロパティ (vNIC Properties)] ペインの [全般 (General)] 領域で、次のフィールドを更新します。

- [vNIC プロパティ (vNIC Properties)] ペインの [イーサネット割り込み (Ethernet Interrupt)] 領域で、次のフィールドを更新します。

- [vNIC プロパティ (vNIC Properties)] ペインの [マルチ キュー (Multi Queue)] 領域で、次のフィールドを更新します。

- [vNIC プロパティ (vNIC Properties)] の [RoCE プロパティ (RoCE Properties)] 領域で、次のフィールドを更新します。

手順の詳細

| ステップ 1 |

[Navigation] ペインの [Networking] メニューをクリックします。 |

||||||||||||||||||

| ステップ 2 |

[Adapter Card] ペインで、[vNICs] タブをクリックします。 |

||||||||||||||||||

| ステップ 3 |

[vNICs] ペインで、vNIC (デフォルトの eth0 または eth1、または新しく作成されたその他の vNIC のいずれか) を選択します。 |

||||||||||||||||||

| ステップ 4 |

必要に応じて vNIC のプロパティを設定します。詳細な手順については、『設定ガイド』を参照してください。モード 1 での RoCEv2 の設定に加えて、残りの手順を実行します。 |

||||||||||||||||||

| ステップ 5 |

[vNIC プロパティ (vNIC Properties)] ペインの [全般 (General)] 領域で、次のフィールドを更新します。

|

||||||||||||||||||

| ステップ 6 |

[vNIC プロパティ (vNIC Properties)] ペインの [イーサネット割り込み (Ethernet Interrupt)] 領域で、次のフィールドを更新します。

|

||||||||||||||||||

| ステップ 7 |

[vNIC プロパティ (vNIC Properties)] ペインの [マルチ キュー (Multi Queue)] 領域で、次のフィールドを更新します。

|

||||||||||||||||||

| ステップ 8 |

[vNIC プロパティ (vNIC Properties)] の [RoCE プロパティ (RoCE Properties)] 領域で、次のフィールドを更新します。

|

次のタスク

ホストの検証を実行して、モード 2 が正しく設定されていることを確認します。「ホスト上の設定の確認」を参照してください。

ホスト システムでの RoCEv2 モード 2 の設定

始める前に

-

Cisco IMC とホストの両方に対して、RoCEv2 モード 2 の接続を設定して確認します。

-

Cisco IMC の RoCEv2 モード 2 接続を設定します。

-

Windows ホスト サーバで Hyper-V を有効にします。

手順

| ステップ 1 |

Hyper-V スイッチ マネージャに移動します。 |

| ステップ 2 |

RoCEv2 対応イーサネット インターフェイスの新しい仮想ネットワーク スイッチ (vSwitch) を作成します。

|

| ステップ 3 |

Powershell インターフェイスを起動します。 |

| ステップ 4 |

デフォルト以外の vPort を設定し、次の Powershell コマンドを使用して RDMA を有効にします。 |

| ステップ 5 |

vPorts の IPv4 アドレスを設定します。 |

| ステップ 6 |

smb サーバで共有を作成し、smb クライアントで共有をマッピングします。

|

| ステップ 7 |

モード 2 設定を確認します。

|

ホスト上の設定の確認

設定が完了したら、次の手順を実行する必要があります。

-

モード 1 およびモード 2 の設定のホスト検証

-

RDMA 対応ポートのホスト検証

-

[アドバンスト プロパティ (Advanced Property)] を使用した RDMA 対応ポートの検証

-

各 PF での V ポート割り当て

手順の概要

- NIC ドライバは、モード 1 の各 RDMA 対応ポートと、モード 2 の V ポートにカーネル ソケット リスナーを作成し、着信リモート RDMA 要求を承認するようにします。

- ホストでの RDMA 対応ポートのホスト検証。

- Netstat-xan 出力には、リスナーに加えて確立された接続が表示されます。出力にトラフィックがあるリスナーのみが表示される場合は、トラフィックが TCP パスでのみ通過していることを示します。PF または vPorts で接続が作成されると、トラフィックは RDMA パスを通過します。

- [アドバンスト プロパティ (Advanced Property)] を使用した RDMA 対応ポートの検証このドライバによれば、[ネットワーク ダイレクト機能 (Network Direct functionality)] を RDMA 対応 VNIC で有効にすることができます。

- 各 PF で V ポート割り当てを確認します。

手順の詳細

| ステップ 1 |

NIC ドライバは、モード 1 の各 RDMA 対応ポートと、モード 2 の V ポートにカーネル ソケット リスナーを作成し、着信リモート RDMA 要求を承認するようにします。 例: |

| ステップ 2 |

ホストでの RDMA 対応ポートのホスト検証。 例: |

| ステップ 3 |

Netstat-xan 出力には、リスナーに加えて確立された接続が表示されます。出力にトラフィックがあるリスナーのみが表示される場合は、トラフィックが TCP パスでのみ通過していることを示します。PF または vPorts で接続が作成されると、トラフィックは RDMA パスを通過します。 例: |

| ステップ 4 |

[アドバンスト プロパティ (Advanced Property)] を使用した RDMA 対応ポートの検証このドライバによれば、[ネットワーク ダイレクト機能 (Network Direct functionality)] を RDMA 対応 VNIC で有効にすることができます。 |

| ステップ 5 |

各 PF で V ポート割り当てを確認します。 例: |

Linux 上で RoCEv2 を持つファブリック上の NVMe を使用する際の ガイドライン

一般的なガイドラインと制限事項

-

Cisco IMC リリース 4.1 (1x) 以降のリリースでは、Linux Z-Kernel 3.10.0 957.27.2 を使用した Redhat Enterprise Linux 7.6 で RoCEv2 がサポートされています。

-

Cisco では、Cisco IMC リリースに固有の UCS ハードウェアとソフトウェアの互換性をチェックして、NVMeoF のサポートを確認することを推奨します。NVMeoF は、Cisco UCS C シリーズ M5 以降のサーバでサポートされています。

-

RoCEv2 を使用した NVMeoF は、Cisco UCS VIC 14xx シリーズ アダプタでのみサポートされています。NVMeoF は、Cisco UCS VIC 12xx または 13xx シリーズ アダプタではサポートされていません。

-

RoCEv2 インターフェイスを設定する場合は、cisco.com からダウンロードした enic および enic_rdma の両方のバイナリ ドライバを使用して、一致する enic および enic_rdma ドライバのセットをインストールします。cisco.com からダウンロードされたバイナリ enic_rdma ドライバを受信トレイ enic ドライバで使用しようとしても動作しません。

-

アダプタごとに 2 個の RoCEv2 対応 vNICs のみがサポートされています。

-

NVMeoF ネームスペースからのブートはサポートされていません。

-

レイヤ 3 ルーティングはサポートされていません。

-

RoCEv2 は、結合をサポートしていません。

-

システム クラッシュ時に crashdump を NVMeoF ネームスペースに保存することはサポートされていません。

-

NVMeoF は、usNIC、VxLAN、VMQ、VMMQ、NVGRE、および DPDK の機能では使用できません。

-

QoS No Drop クラス設定は、Cisco Nexus 9000 シリーズ スイッチなどのアップストリーム スイッチで適切に設定する必要があります。QoS の設定は、異なるアップストリーム スイッチ間で異なります。

-

アップストリーム スイッチの VLAN および QoS ポリシーで、MTU サイズを正しく設定します。

-

スパニング ツリー プロトコル (STP) によって、フェールオーバまたはフェールバック イベントが発生したときに、ネットワーク接続が一時的に失われる可能性があります。この問題が発生しないようにするには、アップリンクスイッチで STP を無効にします。

割り込み

-

Linux RoCEv2 インターフェイスは、MSIx 割り込みモードのみをサポートしています。RoCEv2 プロパティを使用してインターフェイスが設定されている場合、Cisco では割り込みモードを変更しないことを推奨します。

-

Linux を使用した RoCEv2 を使用するための最小割り込み数は 8 です。

ダウングレードに関する制限事項

Cisco では、サポートされていない RoCEv2 リリースにダウングレードする前に、RoCEv2 の設定を削除することを推奨しています。

Linux の要件

Linux での RoCEv2 の設定と使用には、次のものが必要です。

-

Z-Kernel 3.10.0-957.27.2 を搭載した Red Hat Enterprise Linux 7.6 以降

-

InfiniBand カーネル API モジュール ib_core

-

Cisco IMC リリース 4.1(1x) 以降

-

VIC ファームウェア 5.1(1x) 以降

-

Cisco UCS VIC 14xx シリーズ アダプタを搭載した UCS C シリーズ M5 サーバ

-

eNIC ドライバ バージョン 4.0.0.6-802-21 以降 (4.1(1x) リリース パッケージ付属)

-

enic_rdma ドライバ バージョン 1.0.0.6-802-21 またはそれ以降 (4.1(1x) リリース パッケージに付属)

-

NVMeoF 接続をサポートするストレージ アレイ

Cisco IMC GUI を使用した NVMeoF の RoCEv2 設定

手順

| ステップ 1 |

[ナビゲーション (Navigation)] ペインで、[ネットワーキング (Networking)] をクリックします。 |

||||||||||||||||||||||||||||

| ステップ 2 |

[ネットワーキング (Networking)] を展開し、アダプタをクリックして RoCEv2 vNIC を設定します。 |

||||||||||||||||||||||||||||

| ステップ 3 |

[vNICs] タブを選択します。 |

||||||||||||||||||||||||||||

| ステップ 4 |

次のいずれかを実行します。

|

||||||||||||||||||||||||||||

| ステップ 5 |

[RoCE プロパティ (RoCE Properties)] を展開します。 |

||||||||||||||||||||||||||||

| ステップ 6 |

RoCE チェックボックスをオンにします。 |

||||||||||||||||||||||||||||

| ステップ 7 |

次の vNIC プロパティを変更します。

|

||||||||||||||||||||||||||||

| ステップ 8 |

[Save Changes] をクリックします。 |

||||||||||||||||||||||||||||

| ステップ 9 |

プロンプトに従って [再起動 (Reboot)] を選択します。 |

SRIOV BIOS ポリシーの有効化

Linux カーネルで IOMMU ドライバを有効にする前に、次の手順を実行して、RoCEv2 vNIC を使用してサーバを設定し、SRIOV BIOS ポリシーを有効にします。

手順

| ステップ 1 |

[ナビゲーション (Navigation)] ペインの [コンピューティング (Compute)] タブをクリックします。 |

| ステップ 2 |

[BIOS] > [BIOS の設定 (Configure BIOS)] > [I/O] を展開します。 |

| ステップ 3 |

[ダイレクト IO の Intel VT (Intel VT for direct IO)]を [有効 (Enabled)] にします。 |

| ステップ 4 |

[保存(Save)] をクリックします。 |

| ステップ 5 |

変更を有効にするには、ホストを再起動する必要があります。 |

ホスト システムで NVMeoF の RoCEv2 の設定

始める前に

RoCEv2 vNIC および SRIOV 対応 BIOS ポリシーを使用してサーバを設定します。

手順

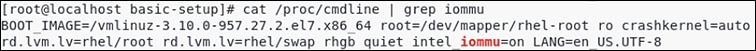

| ステップ 1 |

編集のために |

| ステップ 2 |

次の例に示すように、 |

| ステップ 3 |

ファイルを保存します。 |

| ステップ 4 |

次のコマンドを実行して、新しい

|

| ステップ 5 |

IOMMU を有効にした後に変更を有効にするにはサーバを再起動します。 |

| ステップ 6 |

出力ファイルを確認し、

例:  |

次のタスク

enic および enic_rdma ドライバをダウンロードします。

Cisco enic および enic_rdma ドライバのインストール

enic_rdma ドライバには enic ドライバが必要です。enic および enic_rdma ドライバをインストールする場合は、ここから、一致する enic および enic_rdma ドライバのセットをダウンロードして使用してください。cisco.com からダウンロードされたバイナリ enic_rdma ドライバを inbox enic ドライバと一緒に使用しないようにしてください。

始める前に

-

RHEL 7.6

-

カーネル バージョン 3.10.0 957.27.2 以降で更新されたサーバ

-

InfiniBand カーネル API モジュール ib_core

手順

| ステップ 1 |

次のコマンドを実行して、enic および enic_rdma rpm パッケージをインストールします。 enic_edma ドライバはインストールされていますが、動作中のカーネルでロードされません。 |

||

| ステップ 2 |

サーバを再起動して、実行中のカーネルに enic_rdma ドライバをロードします。 |

||

| ステップ 3 |

次のコマンドを実行して、enic_rdma ドライバと RoCEv2 インターフェイスのインストールを確認します。 |

||

| ステップ 4 |

次のコマンドを実行して、nvme-rdma カーネル モジュールをロードします。 サーバがリブートすると、nvme-rdma カーネル モジュールがアンロードされます。サーバの再起動ごとに nvme-rdma カーネルモジュールをロードするには、次を使用して nvme_rdma conf ファイルを作成します。

|

次のタスク

ターゲットを検出し、NVMe ネームスペースに接続します。システムでストレージへのマルチパス アクセスが必要な場合は、デバイス マッパー マルチパスの設定 を参照してください。

NVMe ターゲットの検出

NVMe のターゲットを検出し、NVMe ネームスペースを接続するには、次の手順を使用します。

始める前に

-

nvme-cli バージョン 1.6 以降がインストールされていることを確認します。

-

RoCEv2 インターフェイスで IP アドレスを設定し、インターフェイスがターゲット IP に対して ping を実行できることを確認します。

手順

| ステップ 1 |

次の手順を実行して、 /etcに nvme フォルダを作成し、手動で hostnqn を生成します。 |

||

| ステップ 2 |

settos.sh ファイルを作成し、IB フレームでプライオリティ フロー制御 (PFC) を設定するスクリプトを実行するには、次の手順を実行します。

|

||

| ステップ 3 |

次のコマンドを実行して、NVMe ターゲットを検出します。 例: |

||

| ステップ 4 |

検出された NVMe ターゲットに接続するには、次のコマンドを実行します。 例: |

||

| ステップ 5 |

nvme list コマンドを使用して、マッピングされたネームスペースを確認します。 |

デバイス マッパー マルチパスの設定

システムがデバイス マッパー マルチパス (DM マルチパス) を使用して設定されている場合は、次の手順を使用してデバイス マッパー マルチパスを設定します。

手順

| ステップ 1 |

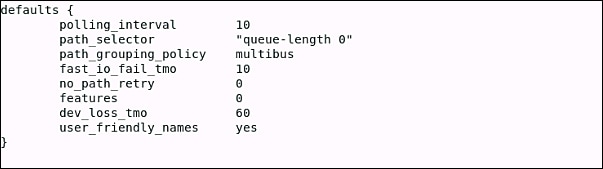

|

| ステップ 2 |

Multipathd を有効にして開始するには、次の手順を実行します。 |

| ステップ 3 |

etc/multipath.conf ファイルを編集して、次の値を使用します。  |

| ステップ 4 |

更新されたマルチパス デバイス マップを使用してフラッシュするには、次の手順を実行します。 |

| ステップ 5 |

マルチパスサービスを再起動するには、次の手順を実行します。 |

| ステップ 6 |

マルチパス デバイスを再スキャンするには、次の手順を実行します。 |

| ステップ 7 |

マルチパス ステータスを確認するには、次の手順を実行します。 |

Cisco IMC GUI を使用した vNIC インターフェイスでの RoCEv2 の削除

vNIC インターフェイスで RoCEv2 を削除するには、次の手順を実行します。

手順

| ステップ 1 |

[ナビゲーション (Navigation)] ペインで、[ネットワーキング (Networking)] をクリックします。 |

| ステップ 2 |

[ネットワーキング (Networking)] を展開し、RoCEv2 設定を削除するアダプタを選択します。 |

| ステップ 3 |

[vNICs] タブを選択します。 |

| ステップ 4 |

RoCEv2 設定を削除する vNIC を選択します。 |

| ステップ 5 |

[RoCE プロパティ (RoCE Properties)] タブを展開します。 |

| ステップ 6 |

[RoCE] チェックボックスをオフにします。 |

| ステップ 7 |

[Save Changes] をクリックします。 |

| ステップ 8 |

上の変更を有効にするには、サーバを再起動します。 |

Cisco IMC CLI を使用した RoCEv2 インターフェイスの設定

Cisco IMC CLI インターフェイスを使用して RoCEv2 インターフェイスを設定するには、次の手順を実行します。

始める前に

-

Cisco IMC CLI インターフェイスに精通するようにします。

-

管理権限を持つユーザーとしてログインする必要があります。

手順の概要

- server # scope chassis

- server/chassis # scope adapter index_number

- server/chassis/adapter # create host-eth-if vNIC_name

- server/chassis/adapter/host-eth-if *# set rocev2 enabled

- server/chassis/adapter/host-eth-if *# set rdma-cos 5

- server/chassis/adapter/host-eth-if *# set rdma_mr 131072

- server/chassis/adapter/host-eth-if *# set rdma_qp 1024

- server/chassis/adapter/host-eth-if *# set rdma_resgrp 8

- server/chassis/adapter/host-eth-if *# scope comp-queue

- server/chassis/adapter/host-eth-if/comp-queue *# set cq-count 2

- server/chassis/adapter/host-eth-if/comp-queue *# exit

- server/chassis/adapter/host-eth-if *# scope trans-queue

- server/chassis/adapter/host-eth-if/trans-queue *# set wq-count 1

- server/chassis/adapter/host-eth-if/trans-queue *# set wq-ring-size 256

- server/chassis/adapter/host-eth-if/trans-queue *# exit

- server/chassis/adapter/host-eth-if *# scope interrupt

- server/chassis/adapter/host-eth-if/interrupt *# set interrupt-count 256

- server/chassis/adapter/host-eth-if/interrupt *# set interrupt-mode MSIx

- server/chassis/adapter/host-eth-if/interrupt *# commit

手順の詳細

| コマンドまたはアクション | 目的 | |||

|---|---|---|---|---|

| ステップ 1 |

server # scope chassis |

シャーシ コマンド モードを開始します。 |

||

| ステップ 2 |

server/chassis # scope adapter index_number |

index_number で指定した PCI スロット番号に装着されているアダプタ カードに対してコマンド モードを開始します。

|

||

| ステップ 3 |

server/chassis/adapter # create host-eth-if vNIC_name |

vNIC を作成します。 |

||

| ステップ 4 |

server/chassis/adapter/host-eth-if *# set rocev2 enabled |

VNIC で RoCEv2 を有効にします。 |

||

| ステップ 5 |

server/chassis/adapter/host-eth-if *# set rdma-cos 5 |

RoCEv2 vNIC に RDMA CoS 5 を設定します。 |

||

| ステップ 6 |

server/chassis/adapter/host-eth-if *# set rdma_mr 131072 |

RoCEv2 vNIC の RDMA メモリ領域を 131072 として設定します。 |

||

| ステップ 7 |

server/chassis/adapter/host-eth-if *# set rdma_qp 1024 |

RoCEv2 vNIC の RDMA キュー ペアを 1024 に設定します。 |

||

| ステップ 8 |

server/chassis/adapter/host-eth-if *# set rdma_resgrp 8 |

RoCEv2 vNIC のRDMA リソース グループを 8 に設定します。 |

||

| ステップ 9 |

server/chassis/adapter/host-eth-if *# scope comp-queue |

[完了キュー (Completion Queue)] コマンド モードを開始します。 |

||

| ステップ 10 |

server/chassis/adapter/host-eth-if/comp-queue *# set cq-count 2 |

VNIC の 完了キュー数を 2 に設定します。 |

||

| ステップ 11 |

server/chassis/adapter/host-eth-if/comp-queue *# exit |

ホスト イーサネット インターフェイス コマンド モードを終了します。 |

||

| ステップ 12 |

server/chassis/adapter/host-eth-if *# scope trans-queue |

[送信キュー (Transmit Queue)] コマンド モードを開始します。 |

||

| ステップ 13 |

server/chassis/adapter/host-eth-if/trans-queue *# set wq-count 1 |

VNIC の送信キューカウントを 1 に設定します。 |

||

| ステップ 14 |

server/chassis/adapter/host-eth-if/trans-queue *# set wq-ring-size 256 |

vNIC の送信キュー リング バッファ サイズを 256 に設定します。 |

||

| ステップ 15 |

server/chassis/adapter/host-eth-if/trans-queue *# exit |

ホスト イーサネット インターフェイス コマンドを終了します。 |

||

| ステップ 16 |

server/chassis/adapter/host-eth-if *# scope interrupt |

[割り込み (Interrupt)] コマンド モードを開始します。 |

||

| ステップ 17 |

server/chassis/adapter/host-eth-if/interrupt *# set interrupt-count 256 |

VNIC の割り込み数を 256 に設定します。 |

||

| ステップ 18 |

server/chassis/adapter/host-eth-if/interrupt *# set interrupt-mode MSIx |

割り込みモードを MSIx に設定します |

||

| ステップ 19 |

server/chassis/adapter/host-eth-if/interrupt *# commit |

トランザクションをシステムの設定にコミットします。

|

例

server# scope chassis

server/chassis # scope adapter 1

server/chassis/adapter # create host-eth-if vNIC_Test

server/chassis/adapter/host-eth-if *# set rocev2 enabled

server/chassis/adapter/host-eth-if *# set rdma-cos 5

server/chassis/adapter/host-eth-if *# set rdma_mr 131072

server/chassis/adapter/host-eth-if *# set rdma_qp 1024

server/chassis/adapter/host-eth-if *# set rdma_resgrp 8

server/chassis/adapter/host-eth-if *# scope comp-queue

server/chassis/adapter/host-eth-if/comp-queue *# set cq-count 2

server/chassis/adapter/host-eth-if/comp-queue *# exit

server/chassis/adapter/host-eth-if *# scope trans-queue

server/chassis/adapter/host-eth-if/trans-queue *# set wq-count 1

server/chassis/adapter/host-eth-if/trans-queue *# set wq-ring-size 256

server/chassis/adapter/host-eth-if/trans-queue *# exit

server/chassis/adapter/host-eth-if *# scope interrupt

server/chassis/adapter/host-eth-if/interrupt *# set interrupt-count 256

server/chassis/adapter/host-eth-if/interrupt *# set interrupt-mode MSIx

server/chassis/adapter/host-eth-if/interrupt *# commit

Cisco IMC CLI を使用した RoCEv2 の削除

手順の概要

- server # scope chassis

- server/chassis # scope adapter index_number

- server/chassis/adapter # scope host-eth-if vNIC_name

- server/chassis/adapter/host-eth-if # set rocev2 disabled

- server/chassis/adapter/host-eth-if *# commit

手順の詳細

| コマンドまたはアクション | 目的 | |||

|---|---|---|---|---|

| ステップ 1 |

server # scope chassis |

シャーシ コマンド モードを開始します。 |

||

| ステップ 2 |

server/chassis # scope adapter index_number |

index_number で指定した PCI スロット番号に装着されているアダプタ カードに対してコマンド モードを開始します。

|

||

| ステップ 3 |

server/chassis/adapter # scope host-eth-if vNIC_name |

vNIC_name で指定された vNIC の コマンド モードを開始します。 |

||

| ステップ 4 |

server/chassis/adapter/host-eth-if # set rocev2 disabled |

vNIC の RoCE プロパティを無効にします。 |

||

| ステップ 5 |

server/chassis/adapter/host-eth-if *# commit |

トランザクションをシステムの設定にコミットします。

|

例

server# scope chassis

server/chassis # scope adapter 1

server/chassis/adapter # scope host-eth-if vNIC_Test

server/chassis/adapter/host-eth-if # set rocev2 disabled

server/chassis/adapter/host-eth-if *# commit

フィードバック

フィードバック