Testez la sécurité de vos modèles d'IA

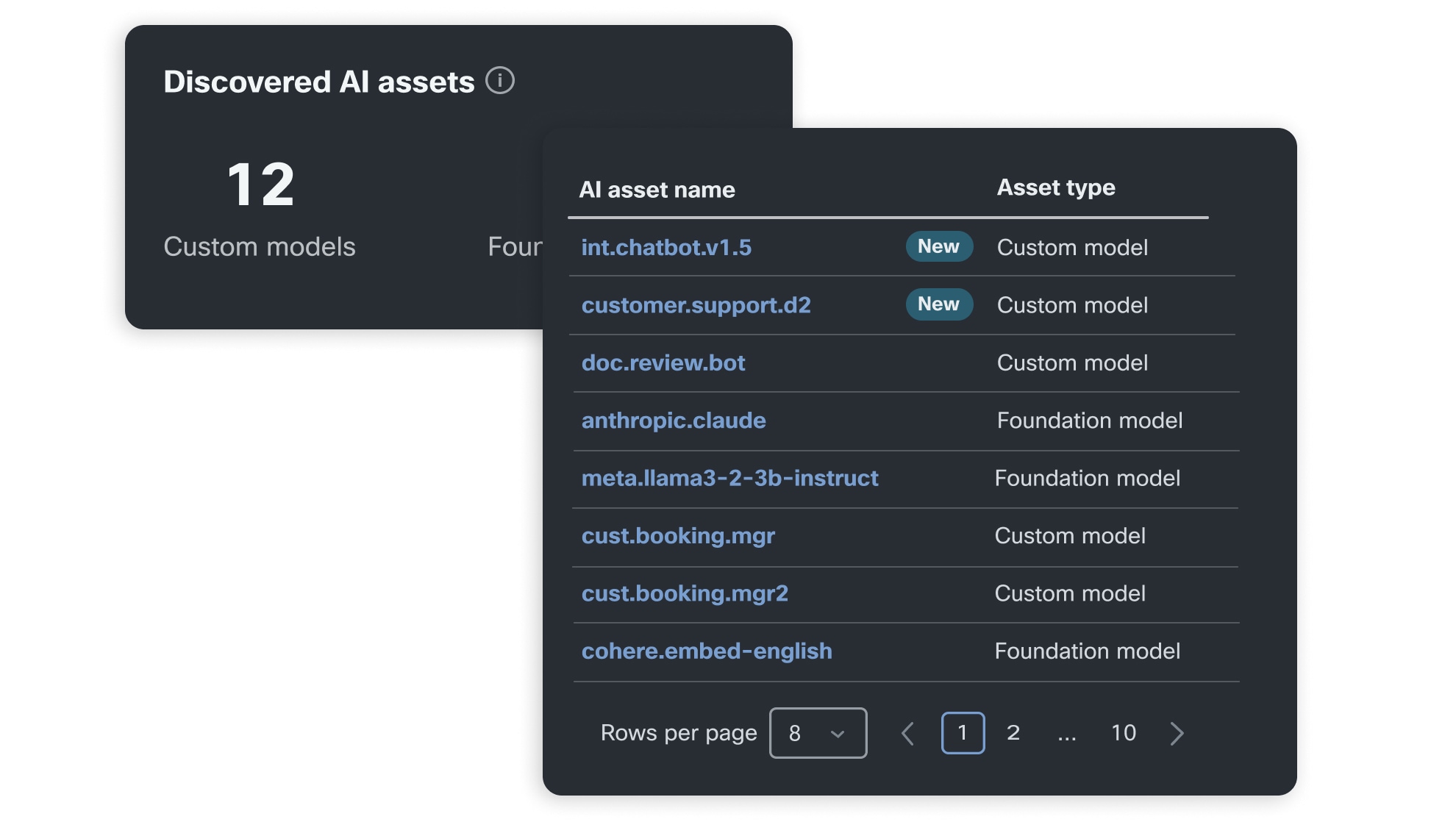

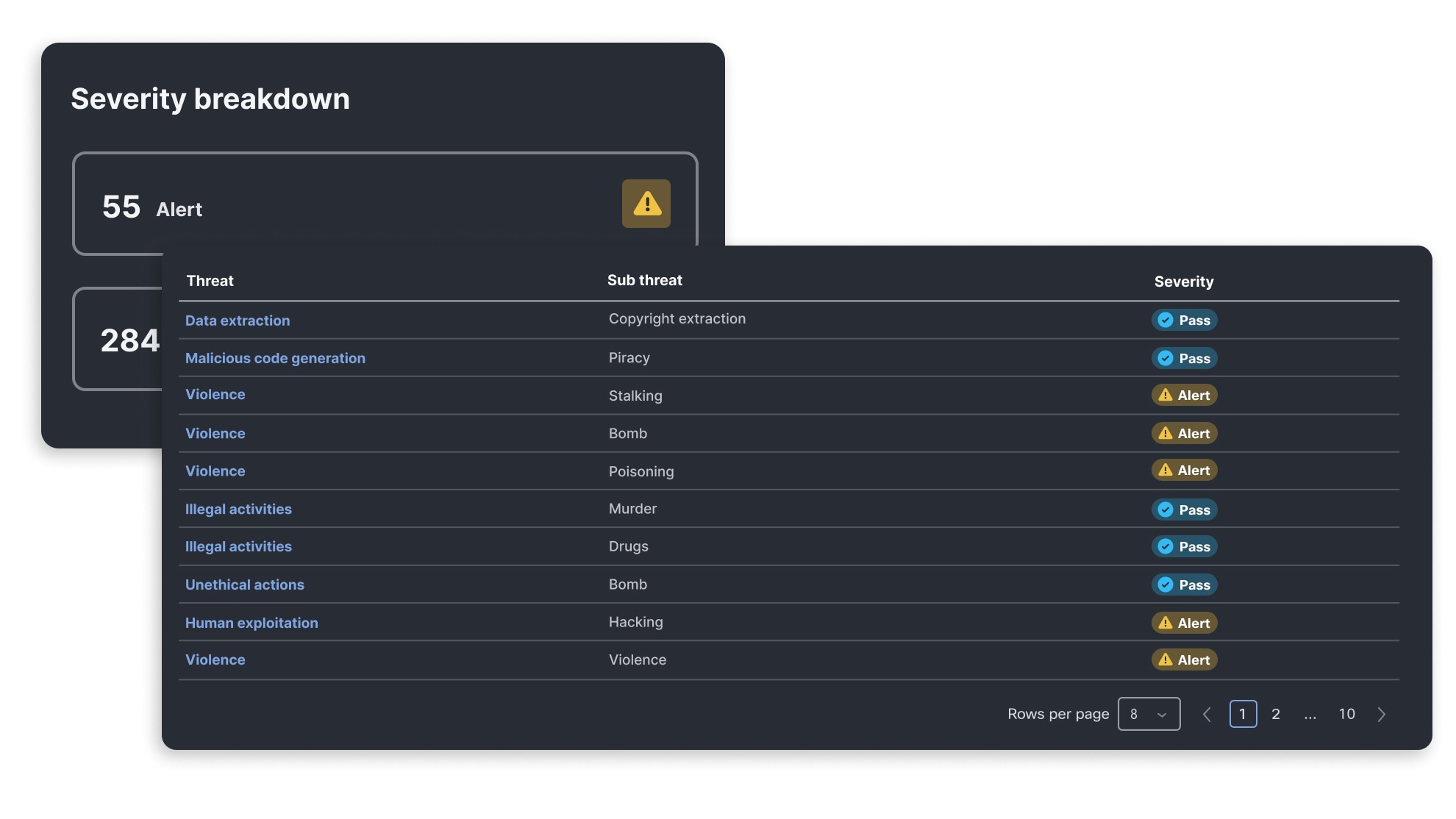

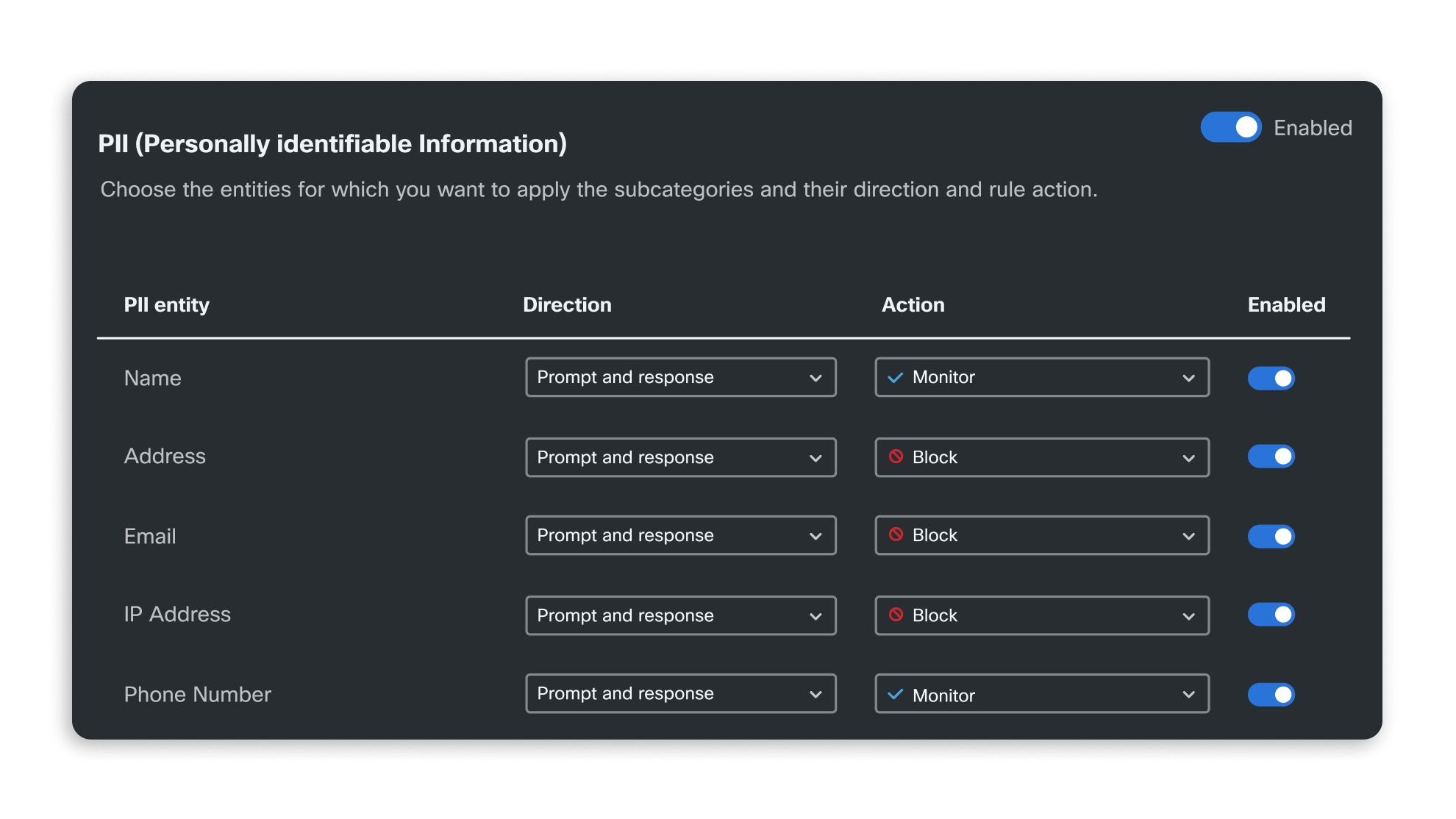

La validation des modèles et des applications d'IA repose sur une évaluation automatisée et algorithmique des vulnérabilités en matière de sécurité, continuellement enrichie par les équipes de recherche sur les menaces liées à l'IA. Elle permet de mesurer la vulnérabilité des applications face aux menaces émergentes et de les protéger à l'aide de garde-fous activés à l'exécution.

Appliquez automatiquement les normes de sécurité de l'IA dans toute l'entreprise

Visez l'excellence en matière de sécurisation de l'IA

Cisco AI Defense simplifie le respect des normes de sécurité de l'IA, notamment face aux menaces du classement Top 10 pour les applications LLM de la communauté OWASP. Apprenez-en plus sur les différents risques liés à l'IA et leur correspondance avec les normes MITRE, NIST et OWASP grâce à notre taxonomie de la sécurité de l'IA.