新機能および変更された機能に関する情報

次の表は、この最新リリースまでの主な変更点の概要を示したものです。ただし、今リリースまでの変更点や新機能の一部は表に記載されていません。

|

Cisco ACI CNI プラグインのリリース バージョン |

機能 |

|---|---|

|

6.0(4) |

Cisco Application Centric Infrastructure(ACI)は、ベア メタル サーバーで Red Hat エージェント ベースの OpenShift をサポートします。 |

ベア メタル上のエージェントベースの OpenShift 4.16

このドキュメントは、ACI CNI を使用した OCP のインストールに関連しています。ただし、ACI CNI に関連しないインフラストラクチャの問題を特定して解決するには、関連するインストール ガイドを参照して、デフォルトの OVN Kubernetes を使用してベア メタル ノードに OCP を最初にインストールしてください。OpenShift 4.16 コンテナ プラットフォームのドキュメントを確認できます。

(注) |

このドキュメントは単独では使用できません。このドキュメントは、OpenShift クラスタのインストールを実行するため のエージェントベースのインストーラドキュメントを使用した Red Hat OpenShift 4.16 オンプレミスクラスタのインストール とともに使用する必要があります。 |

ベア メタル サーバーで OpenShift 4.16 をサポートするための要件

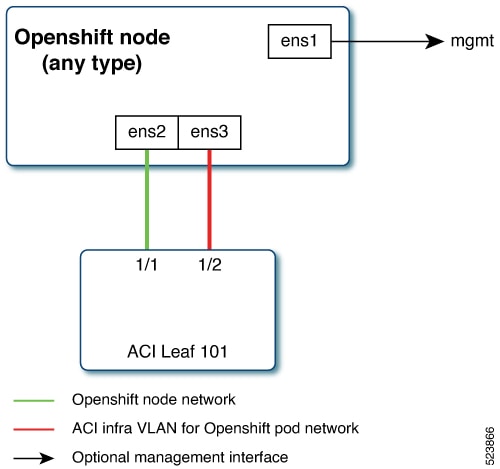

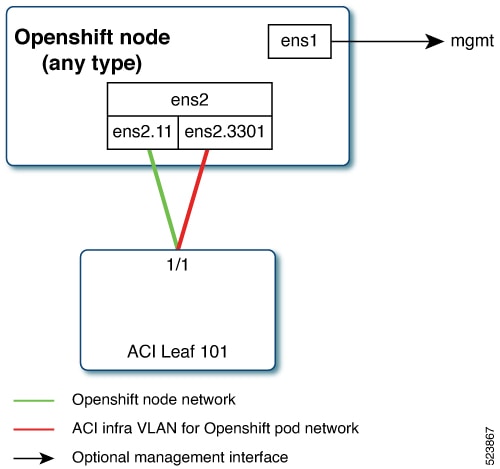

ベア メタル ノードには少なくとも 2 つのネットワーク インターフェイスが必要です。1 つはノード ネットワーク用、2 つ目はポッド ネットワーク用です。この設計では、OpenShift ノード トラフィックを異なる Neutron ネットワーク上のポッド トラフィックから分離します。分離を実現するために使用できるオプションは 2 つあります。その結果、制御マシンとコンピューティングマシンにそれぞれ 2 つのネットワーク インターフェイスが割り当てられます。

-

ノード ネットワークとインフラ ネットワークに分離された物理インターフェイス

-

ノード ネットワークとインフラ ネットワークの両方に対応する単一のサブインターフェイス

ノード ネットワークとインフラ ネットワークに分離された物理インターフェイス

1 つのインターフェイスはノード ネットワーク用で、2 つ目はポッド ネットワーク用です。2 番目のインターフェイスも、Cisco ACI コントロール プレーン トラフィックを伝送します。VLAN タグ付きサブインターフェイスは、ポッド トラフィックと Cisco ACI コントロール プレーン トラフィックを伝送するように 2 番目のインターフェイスで設定されます。

ノード ネットワークとインフラ ネットワークの両方に対応する単一のサブインターフェイス

ノード ネットワークとポッドネットワークは、bond0 または物理 NIC のいずれかの VLAN サブインターフェイスとして設定されています。管理用に追加の VLAN を使用してサーバーを設定したり、 ノード ネットワークを管理ネットワークに使用したりできます。設計は、サーバーのプロビジョニング方式(PXE または手動 ISO ブート)に依存する場合があります。

インストール プロセス

以下のセクションでは、ACI CNI を使用して OpenShift クラスタをインストールするために必要な手順について詳しく説明します。

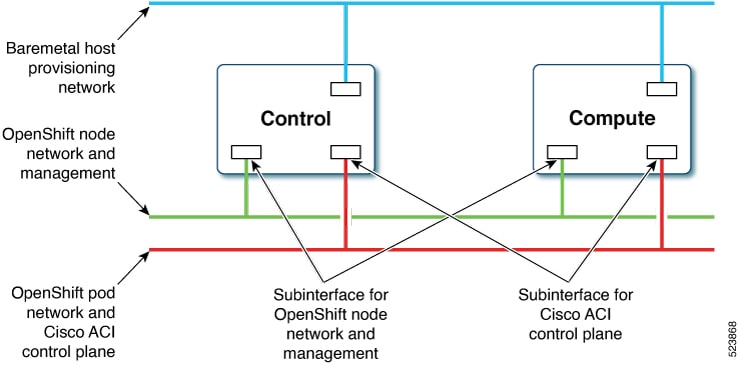

次の図は、インストール プロセスで使用されるさまざまなタイプのネットワークを示しています。

ベア メタル ノードには少なくとも 2 つのネットワーク インターフェイスが必要です。1 つはノード ネットワーク用、もう 1 つはポッド ネットワーク用です。この設計では、OpenShift ノードトラフィックをポッドトラフィックから分離します。3 番目のインターフェイスは、ベア メタル ホストのプロビジョニングに不可欠なプライベート ネットワーク用に構成されます。

OpenShift インストーラの構成

OpenShift インストーラを設定するには、次の手順を実行します。インストールでは、3 ノードクラスタを使用します(制御にはスケジューリングが有効になります)。インストール後のノードのスケーリングについては、 「ベア メタル オペレータによるエージェントベースのインストールのスケーリング」セクションを参照してください。

始める前に

OpenShift インストーラと OC クライアントをダウンロードします。

インストーラをダウンロードできる場所の詳細については、 「エージェントベースのインストーラを使用したオンプレミス クラスタのインストール」というタイトルの OpenShift 4.16 のドキュメントを参照してください。

手順

|

ステップ 1 |

|

|

ステップ 2 |

|

ACI インフラと CNI の構成

この手順を使用して、acc-provision を使用して ACI インフラと CNI を構成します。

手順

|

ACI 構成サンプル

上記のサンプル これにより、ACI CNI マニフェストを含む新しい |

OpenShift ノードのカスタム ネットワーク構成の準備

ACI CNI では、追加の VLAN を各 OpenShift ノードに拡張する必要があります。すべてのマスター ノードとワーカー ノードに追加の VLAN が必要です。

ノード ネットワーク サブネットで構成されるインターフェイス上で追加の VLAN を構成することも、ホスト上の追加の物理インターフェイス上で構成することもできます。

ホストのネットワーク インターフェイスを構成するために使用可能なオプションは、NMState 形式の agent-config.yaml で構成を提供することです。agent-config.yaml の作成の詳細については、「OpenShift インストーラの構成」の項を参照してください。

agent-config ファイルの変更

この手順を使用して、 agent-config.yaml ファイルを変更します。

始める前に

追加の NIC 設定を含む agent-config ファイルは、Cisco ACI 内部ネットワーク(インフラ VLAN)をサーバー レベルまで拡張する必要があります。このインターフェイスは、ポッドネットワークに適切なタグを使用して、OVS から ACI リーフ スイッチに VxLAN トラフィックを伝送するために使用されます。OpenShift ノード トラフィックとポッド トラフィックとの分離を実現するには、 ノードとインフラのネットワーク アプローチの両方にシングル サブ インターフェイス を使用します。関連する詳細については、 「要件」の項で説明しています。

次の YAML スニペットは、AgentConfig の概要を示しています。これには、ランデブー IP、ホスト構成、ネットワーク インターフェイス設定など、展開を合理化するための重要な詳細が含まれています。

apiVersion: v1alpha1

kind: AgentConfig

metadata:

name: ocpbm1

rendezvousIP: 192.168.1.3. -> A

AdditionalNTPSources:

- time.cisco.com

hosts: -> B

- hostname: ocpbm1-master1 -> C

role: master

interfaces:

- name: ens160

macAddress: 00:50:56:97:16:db

networkConfig: -> D

interfaces:

- name: ens160

mtu: 9000

ipv4:

enabled: false

ipv6:

enabled: false

- name: node

type: vlan

mtu: 9000

state: up

vlan:

base-iface: ens160

id: 11

ipv4:

enabled: true

address:

- ip: 192.168.1.3

prefix-length: 24

dhcp: false

ipv6:

enabled: false

- name: infra

type: vlan

mtu: 9000

state: up

vlan:

base-iface: ens160

id: 3301

ipv4:

enabled: true

dhcp: true

ipv6:

enabled: false

dns-resolver:

config:

server:

- 192.168.1.2

routes:

config:

- destination: 0.0.0.0/0

next-hop-address: 192.168.1.1

next-hop-interface: node

- destination: 224.0.0.0/4

next-hop-interface: infra

上記のサンプルでは、セクションは A、B、C、D とマークされています。よりよく理解するために詳細を以下に示します。

-

A:この IP アドレスは、ブートストラップ プロセスを実行するノードと、アシスト型サービス コンポーネントを実行するノードを決定するために使用されます。少なくとも 1 つのホストの IP アドレスを

networkConfigパラメータで指定しない場合は、ランデブー IP アドレスを指定する必要があります。このアドレスが指定されていない場合は、指定されたホストのnetworkConfigから 1 つの IP アドレスが選択されます。 -

B:ホスト構成定義されたホストの数は、

install-config.yamlファイルで定義されたホストの総数(compute.replicas パラメータとcontrolPlane.replicasパラメータの値の合計)を超えないようにする必要があります。 -

C:Dynamic Host Configuration Protocol(DHCP)または逆引き DNS ルックアップから取得したホスト名をオーバーライドします。各ホストには、次のいずれかの方法で指定する一意のホスト名が必要です。

-

D:ホストのネットワーク インターフェイスを NMSte 形式で構成します。

手順

|

ステップ 1 |

クラスタのルート フォルダを作成します。 |

|

ステップ 2 |

install-config.yaml、agent-config.yaml を新しく作成した upi フォルダにコピーします。 |

|

ステップ 3 |

openshift ディレクトリを作成します。 |

|

ステップ 4 |

upi/openshift/ にあるすべての ACI マニフェスト ファイルを抽出します。 |

|

ステップ 5 |

.iso イメージを作成します。 |

|

ステップ 6 |

ベアメタルマシンで agent.x86_64.iso イメージを起動します。

|

デフォルトの入力コントローラの更新

ACI ロードバランサを使用するようにデフォルトの Ingress コントローラの公開戦略を更新するには、cluster-admin 権限を持つユーザーとしてログインし、次を実行します。

oc replace --force --wait --filename - <<EOF

apiVersion: operator.openshift.io/v1 kind:

IngressController metadata:

namespace: openshift-ingress-operator

name: default spec:

endpointPublishingStrategy:

type: LoadBalancerService

loadBalancer:

scope: External

EOF

詳細については、『 Ingress Operator in OpenShift Container Platform Red Hat』 ガイドの「 Configuring the Default Ingress Controller for your Cluster to be Internal」 セクションを参照してください。

ベア メタル オペレータによるエージェント ベースのインストールのスケーリング

この手順を使用して、クラスタ内のワーカーまたはスケールノードを追加します。

手順

|

ステップ 1 |

ベースボード管理コントローラ(BMC)を使用してベアメタル ノードの電源をオフにし、オフになっていることを確認します。 |

||

|

ステップ 2 |

ベアメタル ノードの設定ファイルを適用し、次の例のいずれかの bmh.yaml ファイルを使用して、環境に合わせて YAML の値を置き換えます。

|

||

|

ステップ 3 |

作成されたそれぞれのオブジェクトを確認します(必要なコマンドが各オブジェクトに示されています)。

|

||

|

ステップ 4 |

使用可能なベア メタル ホストの数に一致するように、レプリカの数をスケール アップします。 |

フィードバック

フィードバック