Firepower Threat Defense(FTD)クラスタのトラブルシューティング

ダウンロード オプション

偏向のない言語

この製品のドキュメントセットは、偏向のない言語を使用するように配慮されています。このドキュメントセットでの偏向のない言語とは、年齢、障害、性別、人種的アイデンティティ、民族的アイデンティティ、性的指向、社会経済的地位、およびインターセクショナリティに基づく差別を意味しない言語として定義されています。製品ソフトウェアのユーザインターフェイスにハードコードされている言語、RFP のドキュメントに基づいて使用されている言語、または参照されているサードパーティ製品で使用されている言語によりドキュメントに例外が存在する場合があります。シスコのインクルーシブ ランゲージの取り組みの詳細は、こちらをご覧ください。

翻訳について

シスコは世界中のユーザにそれぞれの言語でサポート コンテンツを提供するために、機械と人による翻訳を組み合わせて、本ドキュメントを翻訳しています。ただし、最高度の機械翻訳であっても、専門家による翻訳のような正確性は確保されません。シスコは、これら翻訳の正確性について法的責任を負いません。原典である英語版(リンクからアクセス可能)もあわせて参照することを推奨します。

内容

はじめに

このドキュメントでは、Firepower Next-Generation Firewall(NGFW)でのクラスタセットアップのトラブルシューティングについて説明します。

前提条件

要件

次の項目に関する知識があることが推奨されます(リンクについては、「関連情報」セクションを参照)。

- Firepower プラットフォーム アーキテクチャ

- Firepowerクラスタの設定と動作

- FTDおよびFirepower eXtensible Operating System(FXOS)CLIに精通していること

- NGFW/データプレーンのログ

- NGFW/データプレーンパケットトレーサ

- FXOS/データプレーンのキャプチャ

使用するコンポーネント

- HW: Firepower 4125

- SW:6.7.0(ビルド65) – データプレーン9.15(1)

このドキュメントの情報は、特定のラボ環境にあるデバイスに基づいて作成されました。このドキュメントで使用するすべてのデバイスは、クリアな(デフォルト)設定で作業を開始しています。本稼働中のネットワークでは、各コマンドによって起こる可能性がある影響を十分確認してください。

背景説明

このドキュメントで説明する項目のほとんどは、適応型セキュリティアプライアンス(ASA)クラスタのトラブルシューティングにも完全に適用できます。

設定

クラスタ導入の設定部分については、FMCおよびFXOSの設定ガイドで説明します。

- Firepower Threat Defenseのクラスタリング

- スケーラビリティとハイアベイラビリティを実現するFirepower Threat Defense用のクラスタの導入

クラスタの基本

NGFWアーキテクチャ

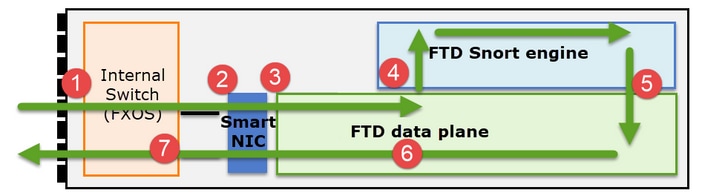

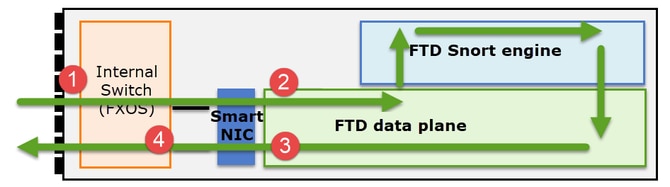

Firepower 41xxまたは93xxシリーズが中継パケットを処理する方法を理解することが重要です。

- パケットが入力インターフェイスに入り、シャーシの内部スイッチによって処理されます。

- パケットはSmart NICを通過します。フローがオフロード(HWアクセラレーション)されると、パケットはSmart NICによってのみ処理され、ネットワークに戻されます。

- パケットがオフロードされない場合、パケットは主にL3/L4チェックを行うFTDデータプレーンに入ります。

- ポリシーで必要とされる場合、パケットはSnortエンジンによって検査されます(主にL7検査)。

- Snortエンジンは、パケットに対する判定(許可やブロックなど)を返します。

- データプレーンは、Snortの判定に基づいてパケットをドロップまたは転送します。

- パケットがシャーシの内部スイッチを通過してシャーシから出ます。

クラスタのキャプチャ

Firepowerアプライアンスは、中継フローを可視化する複数のキャプチャポイントを提供します。クラスタキャプチャのトラブルシューティングと有効化を行う際の主な課題は次のとおりです。

- クラスタ内のユニット数が増えるほど、キャプチャの数も増えます。

- クラスタを通過するパケットを追跡するには、クラスタが特定のフローをどのように処理するかを認識する必要があります。

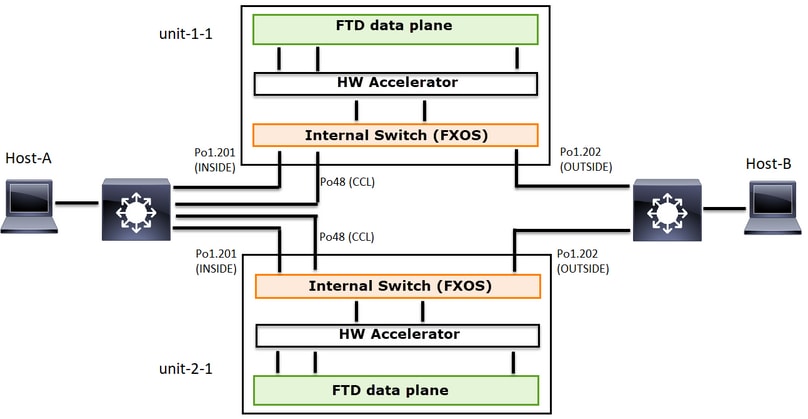

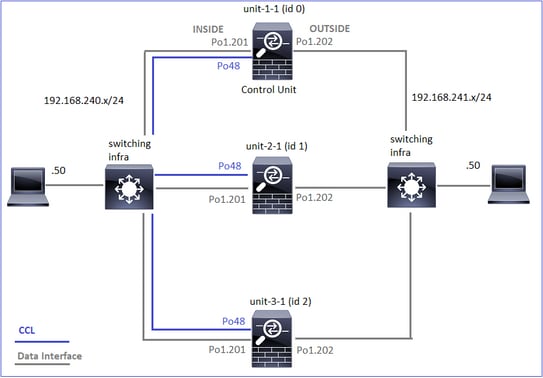

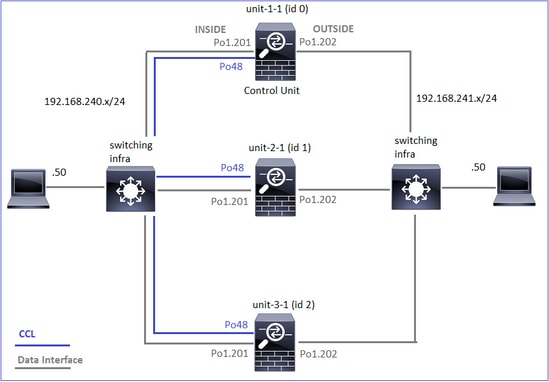

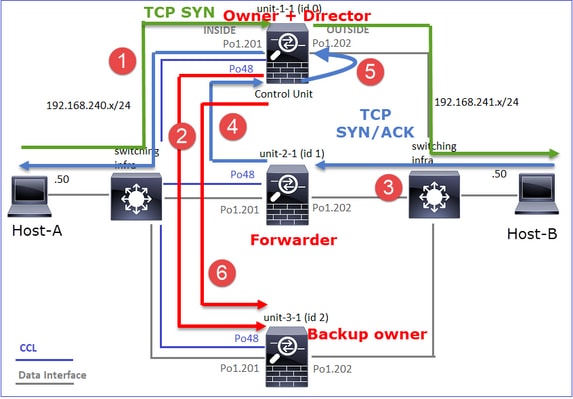

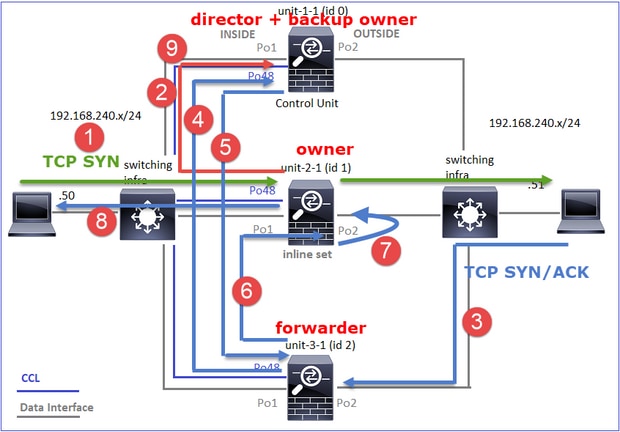

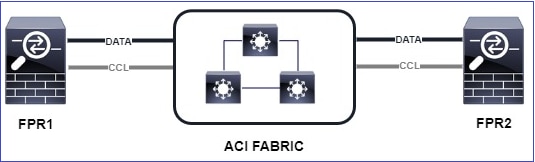

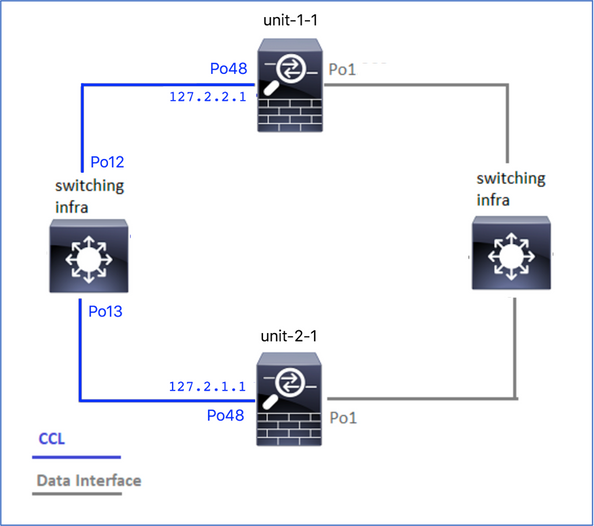

次の図は、2ユニットのクラスタ(FP941xx/FP9300など)を示しています。

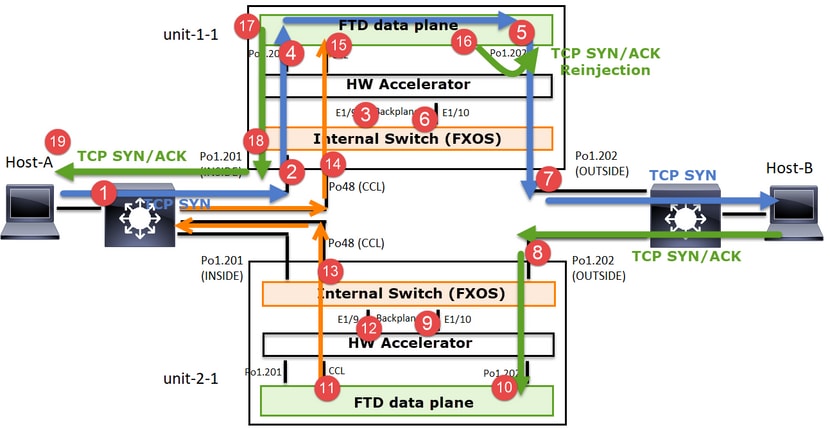

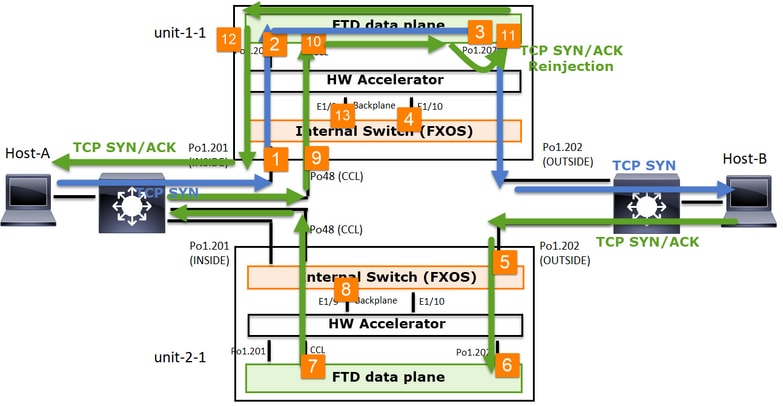

非対称TCP接続が確立される場合、TCP SYN、SYN/ACK交換は次のようになります。

転送トラフィック:

- TCP SYNがホストAからホストBに送信されます。

- TCP SYNがシャーシ(Po1のメンバの1つ)に着信します。

- TCP SYNは、シャーシバックプレーンインターフェイスの1つ(E1/9、E1/10など)を介してデータプレーンに送信されます。

- TCP SYNがデータプレーン入力インターフェイス(Po1.201/内部)に着信します。 この例では、unit1-1はフローの所有権を取得し、初期シーケンス番号(ISN)のランダム化を行い、シーケンス番号の所有権(cookie)情報をエンコードします。

- TCP SYNはPo1.202/OUTSIDE(データプレーン出力インターフェイス)から送信されます。

- TCP SYNがシャーシバックプレーンインターフェイスの1つに到着します(E1/9、E1/10など)。

- TCP SYNは、シャーシの物理インターフェイス(Po1のメンバの1つ)からHost-Bに向けて送信されます。

リターントラフィック:

- TCP SYN/ACKがホストBから送信され、ユニット2-1(Po1のメンバの1つ)に到達します。

- TCP SYN/ACKは、シャーシバックプレーンインターフェイスの1つ(E1/9、E1/10など)を介してデータプレーンに送信されます。

- TCP SYN/ACKがデータプレーン入力インターフェイス(Po1.202/OUTSIDE)に到達します。

- TCP SYN/ACKは、Cluster Control Link(CCL)からユニット1-1に向けて送信されます。デフォルトでは、ISNは有効になっています。したがって、フォワーダは、ディレクタの関与なしにTCP SYN+ACKの所有者情報を検出します。その他のパケットの場合、またはISNが無効の場合は、ディレクタへの問い合わせが行われます。

- TCP SYN/ACKがシャーシバックプレーンインターフェイスの1つに到着します(E1/9、E1/10など)。

- TCP SYN/ACKは、シャーシの物理インターフェイス(Po48のメンバの1つ)からユニット1-1に向けて送信されます。

- TCP SYN/ACKがユニット1-1(Po48のメンバの1つ)に到達します。

- TCP SYN/ACKは、シャーシバックプレーンインターフェイスのいずれかを介して、データプレーンCCLポートチャネルインターフェイス(nameifクラスタ)に転送されます。

- データプレーンは、TCP SYN/ACKパケットをデータプレーンインターフェイスPo1.202/OUTSIDEに再注入します。

- TCP SYN/ACKは、Po1.201/INSIDE(データプレーン出力インターフェイス)からHOST-Aに向けて送信されます。

- TCP SYN/ACKは、シャーシバックプレーンインターフェイスの1つ(E1/9、E1/10など)を通過し、Po1のいずれかのメンバから出力されます。

- TCP SYN/ACKがホストAに到達します。

このシナリオの詳細については、「クラスタ接続の確立ケーススタディ」の関連セクションを参照してください。

このパケット交換に基づいて、考えられるすべてのクラスタキャプチャポイントは次のとおりです。

転送トラフィック(TCP SYNなど)のキャプチャの対象:

- シャーシの物理インターフェイス(Po1メンバなど)。 このキャプチャは、Chassis Manager(CM)UIまたはCM CLIから設定します。

- データプレーン入力インターフェイス(Po1.201 INSIDEなど)。

- データプレーン出力インターフェイス(Po1.202 OUTSIDEなど)。

- シャーシバックプレーンインターフェイスFP4100には2つのバックプレーンインターフェイスがあります。FP9300では、合計6個(モジュールあたり2個)あります。 パケットがどのインターフェイスに到達するかわからないため、すべてのインターフェイスでキャプチャを有効にする必要があります。

リターントラフィック(TCP SYN/ACKなど)のキャプチャは次のとおりです。

- シャーシの物理インターフェイス(Po1メンバなど)。 このキャプチャは、Chassis Manager(CM)UIまたはCM CLIから設定します。

- データプレーン入力インターフェイス(Po1.202 OUTSIDEなど)。

- パケットはリダイレクトされるため、次のキャプチャポイントはデータプレーンCCLです。

- シャーシバックプレーンインターフェイスここでも、両方のインターフェイスでキャプチャを有効にする必要があります。

- ユニット1-1シャーシCCLメンバーインターフェイス

- データプレーンCCLインターフェイス(nameifクラスタ)。

- 入力インターフェイス(Po1.202外部)。 これは、CCLからデータプレーンに再注入されたパケットです。

- データプレーン出力インターフェイス(Po1.201 INSIDEなど)。

- シャーシバックプレーンインターフェイス

クラスタキャプチャを有効にする方法

FXOSキャプチャ

このプロセスは、FXOS構成ガイド:パケットキャプチャで説明されています。

注:FXOSキャプチャは、内部スイッチの観点からは入力方向でのみ取得できます。

データプレーンのキャプチャ

すべてのクラスタメンバーでキャプチャを有効にする推奨方法は、cluster exec コマンドを使用することです。

3ユニットのクラスタを考えてみます。

すべてのクラスタユニットにアクティブなキャプチャがあるかどうかを確認するには、次のコマンドを使用します。

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Po1.201(内部)のすべてのユニットでデータプレーンキャプチャを有効にするには、次の手順を実行します。

firepower# cluster exec capture CAPI interface INSIDE

キャプチャフィルタを指定し、大量のトラフィックが予想される場合は、キャプチャバッファを増やすことを強くお勧めします。

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

検証:

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

すべてのキャプチャの内容を表示するには、次のコマンドを実行します(この出力は非常に長くなることがあります)。

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

トレースのキャプチャ

各ユニットで入力パケットがデータプレーンでどのように処理されるかを調べるには、traceキーワードを使用します。これにより、最初の50個の入力パケットがトレースされます。最大1000の入力パケットをトレースできます。

注:インターフェイスに複数のキャプチャを適用する場合、1つのパケットをトレースできるのは1回だけです。

すべてのクラスタユニットのインターフェイスOUTSIDEで最初の1000個の入力パケットをトレースするには、次のコマンドを実行します。

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

対象のフローをキャプチャしたら、各ユニットで対象のパケットをトレースしていることを確認する必要があります。特定のパケットをUnit-1-1で#1信し、別のユニットで#2信するなどの方法をとることが重要です。

この例では、SYN/ACKはユニット2-1ではパケット#2ですが、ユニット3-1ではパケット#1であることがわかります。

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

ローカルユニットでパケット#2(SYN/ACK)をトレースするには、次のコマンドを実行します。

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

リモートユニットで同じパケット(SYN/ACK)をトレースするには、次のコマンドを実行します。

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

CCLキャプチャ

CCLリンク(すべてのユニット)でキャプチャを有効にするには、次の手順を実行します。

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

再インジェクト非表示

デフォルトでは、データプレーンデータインターフェイスで有効になっているキャプチャは、すべてのパケットを示します。

- 物理ネットワークから到達するもの

- CCLから再注入されるもの

再注入されたパケットを表示したくない場合は、reinject-hide オプションを使用します。これは、フローが非対称であるかどうかを確認する場合に役立ちます。

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

このキャプチャでは、ローカルユニットが特定のインターフェイスで物理ネットワークから直接受信した内容だけが示されており、他のクラスタユニットからは受信していません。

ASPドロップ

特定のフローのソフトウェアドロップを確認する場合は、asp-dropキャプチャを有効にできます。フォーカスするドロップの理由がわからない場合は、キーワードallを使用します。また、パケットペイロードを調べない場合は、headers-only キーワードを指定できます。これにより、20 ~ 30倍のパケットをキャプチャできます。

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

さらに、ASPキャプチャで対象のIPを指定できます。

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

キャプチャのクリア

すべてのクラスタユニットで実行されているキャプチャのバッファをクリアします。これにより、キャプチャは停止されず、バッファがクリアされるだけです。

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

キャプチャの停止

すべてのクラスタユニットでアクティブなキャプチャを停止するには、2つの方法があります。後で再開できます。

方法1:

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

再開するには:

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

方法2:

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

再開するには:

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

キャプチャの収集

キャプチャをエクスポートする方法は複数あります。

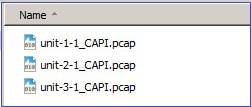

方法1:リモートサーバへ:

これにより、データプレーンからリモートサーバ(TFTPなど)にキャプチャをアップロードできます。 キャプチャ名は、ソースユニットを反映して自動的に変更されます。

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

アップロードされたpcapファイル:

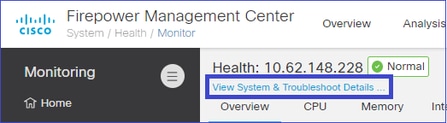

方法2:FMCからキャプチャを取得します。

この方法は、FTDにのみ適用されます。最初に、キャプチャをFTDディスクにコピーします。

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

expertモードから、/mnt/disk0/から/ngfw/var/common/ディレクトリにファイルをコピーします。

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

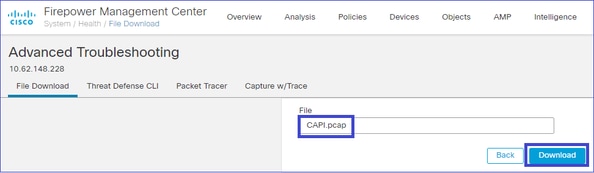

最後に、FMCでSystem > Health > Monitorセクションに移動します。View System & Troubleshoot Details > Advanced Troubleshooting の順に選択し、キャプチャファイルを取得します。

キャプチャの削除

すべてのクラスタユニットからキャプチャを削除するには、次のコマンドを使用します。

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

オフロードされたフロー

FP41xx/FP9300では、フローをハードウェアアクセラレータに静的(Fastpathルールなど)または動的にオフロードできます。フローオフロードの詳細については、FTDアクセスコントロールポリシールールアクションを明確にするを参照してください。

フローがオフロードされる場合、少数のパケットだけがFTDデータプレーンを通過します。それ以外は、ハードウェアアクセラレータ(Smart NIC)によって処理されます。

キャプチャの観点から見ると、これはFTDのデータプレーンレベルのキャプチャだけを有効にしても、デバイスを通過するすべてのパケットが表示されないことを意味します。この場合、FXOSシャーシレベルのキャプチャも有効にする必要があります。

Cluster Control Link(CCL)メッセージ

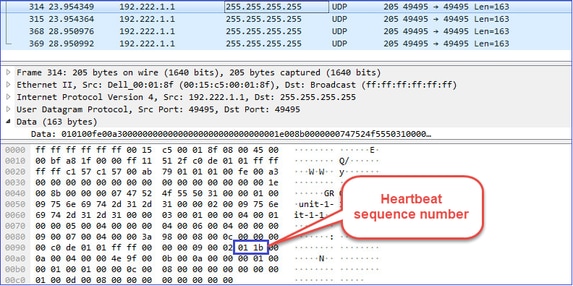

CCLでキャプチャを実行すると、クラスタユニットが異なるタイプのメッセージを交換していることがわかります。対象となるのは次の項目です。

|

プロトコル |

説明 |

|

UDP 49495 |

クラスタハートビート(キープアライブ) ・ L3ブロードキャスト(255.255.255.255) ・ これらのパケットは、ヘルスチェックの保留時間値の3分の1の時間に、すべてのクラスタユニットから送信されます。 ・ キャプチャに表示されるすべてのUDP 49495パケットがハートビートとは限らないことに注意してください ・ ハートビートにはシーケンス番号が含まれます。 |

|

UDP 4193 |

クラスタ制御プロトコルのデータパスメッセージ ・ ユニキャスト ・ これらのパケットには、フロー所有者、ダイレクタ、バックアップ所有者などに関する情報(メタデータ)が含まれています。次に例を示します。 ・ 新しいフローが作成されると、所有者からダイレクタに「cluster add」メッセージが送信される ・ フローが終了すると、「cluster delete」メッセージが所有者からダイレクタに送信される |

|

データパケット |

クラスタを通過するさまざまなトラフィックフローに属するデータパケット |

クラスタハートビート:

クラスタ制御ポイント(CCP)メッセージ

ハートビートメッセージに加えて、特定のシナリオでCCLを介して交換される多数のクラスタ制御メッセージがあります。一部はユニキャストメッセージで、他はブロードキャストです。

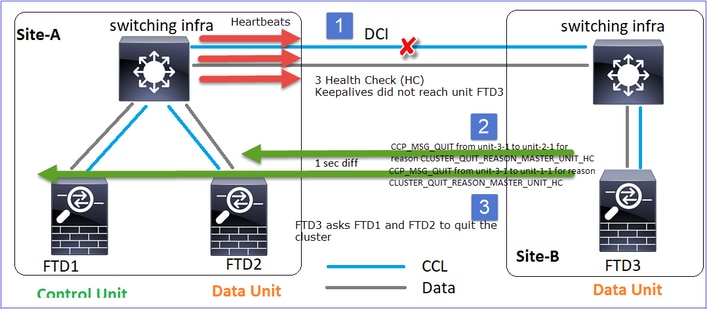

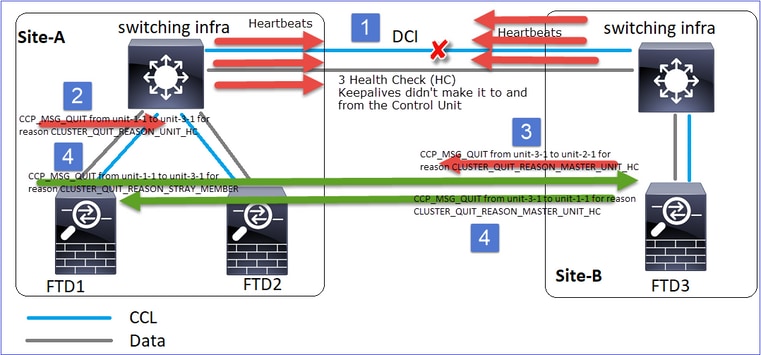

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC(クラスタ終了の理由_プライマリユニット_HC)

ユニットで制御ノードからの3つの連続するハートビートメッセージが失われるたびに、CCLを介してCLUSTER_QUIT_REASON_PRIMARY_UNIT_HCメッセージが生成されます。このメッセージの内容:

- ユニキャストです

- これは1秒の間隔で各ユニットに送信されます。

- ユニットがこのメッセージを受信すると、はクラスタを終了し(DISABLED)、再結合します。

Q. CLUSTER_QUIT_REASON_PRIMARY_UNIT_HCの目的は何ですか。

A. unit-3-1(Site-B)から見ると、Unit-1-1とunit-2-1の両方への接続をSite Aから失うため、できるだけ早くメンバリストからこれらの接続を削除する必要があります。そうしないと、unit-2-1がメンバリストに残っていて、unit-2-1が接続のディレクタになっている場合、パケットが失われる可能性があり、unit-2-1へのフロークエリは失敗します。

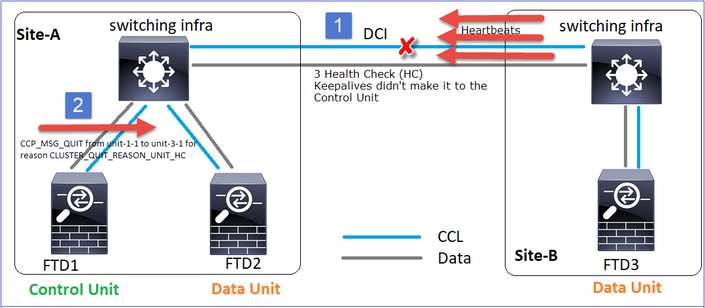

CLUSTER_QUIT_REASON_UNIT_HC(クラスタ終了の理由ユニット_HC)

制御ノードは、データノードから連続して3つのハートビートメッセージを失うと、CCL経由でCLUSTER_QUIT_REASON_UNIT_HCメッセージを送信します。このメッセージはユニキャストです。

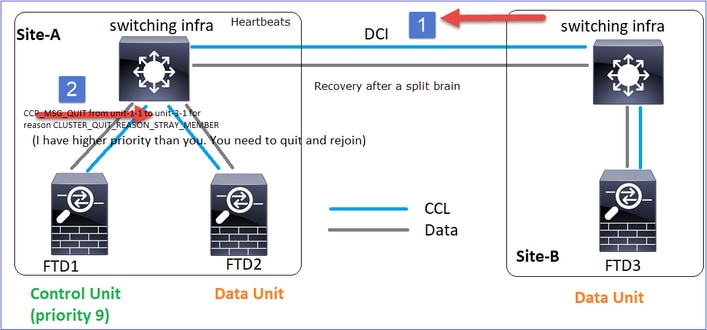

CLUSTER_QUIT_REASON_STRAY_MEMBERです。

分割パーティションがピアパーティションと再接続すると、新しいデータノードは支配的な制御ユニット(CU)によって流用メンバとして扱われ、CLUSTER_QUIT_REASON_STRAY_MEMBERの理由を含むCCP終了メッセージを受信します。

CLUSTER_QUIT_MEMBER_DROPOUTです。

データノードによって生成され、ブロードキャストとして送信されるブロードキャストメッセージ。ユニットでこのメッセージが受信されると、はDISABLEDステータスに移行します。さらに、自動再参加はキックオフしません。

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

クラスタ履歴には次のように表示されます。

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

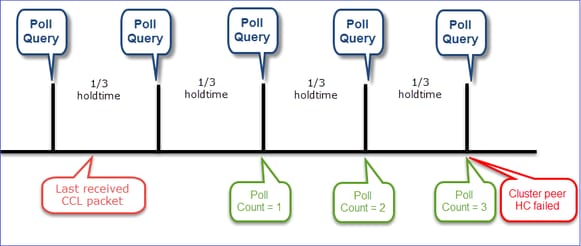

Cluster Health-Check(HC)メカニズム

主なポイント:

- 各クラスタユニットは、ヘルスチェック保留時間値の1/3ごとにハートビートを他のすべてのユニット(ブロードキャスト255.255.255.255)に送信し、CCL経由の転送としてUDPポート49495を使用します。

- 各クラスタユニットは、PollタイマーとPollカウント値を使用して、他のすべてのユニットを個別にトラッキングします。

- クラスタユニットが、ハートビート間隔内にクラスタピアユニットからパケット(ハートビートまたはデータパケット)を受信しなかった場合は、ポーリングカウントの値が増加します。

- クラスタピアユニットのポーリングカウント値が3になると、そのピアはダウンしていると見なされます。

- ハートビートを受信するたびにシーケンス番号がチェックされ、以前に受信したハートビートとの差分が1と異なる場合、それに応じてハートビートドロップカウンタが増加します。

- クラスタピアのPoll countカウンタが0以外の値で、パケットがピアによって受信されると、カウンタは0にリセットされます。

次のコマンドを使用して、クラスタのヘルスカウンタを確認します。

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

メイン列の説明:

|

カラム |

説明 |

|

単位(ID) |

リモートクラスタピアのID。 |

|

ハートビート数 |

CCLを介してリモートピアから受信したハートビートの数。 |

|

ハートビートのドロップ |

失われたハートビートの数。このカウンタは、受信したハートビートシーケンス番号に基づいて計算されます。 |

|

平均ギャップ |

受信したハートビートの平均時間間隔。 |

|

ポーリングカウント |

このカウンタが3になると、ユニットはクラスタから削除されます。ポーリングクエリ間隔はハートビート間隔と同じですが、独立して実行されます。 |

カウンタをリセットするには、次のコマンドを使用します。

firepower# clear cluster info health details

Q.ハートビートの頻度を確認する方法は?

A.ギャップの平均値を確認します。

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

Q. FTDのクラスタ保留時間を変更するには、どうすればよいのですか。

A. FlexConfigを使用します。

Q.スプリットブレインの後にコントロールノードになるのは誰ですか?

A.プライオリティが最も高い(最も小さい番号)ユニット:

firepower# show run cluster | include priority

priority 9

詳細については、HC障害シナリオ1を確認してください。

クラスタHC機構の可視化

指標タイマー:最小値と最大値は、最後に受信したCCLパケットの到達によって異なります。

|

Hold time |

ポーリングクエリチェック (周波数) |

最小検出時間 |

最大検出時間 |

|

3秒(デフォルト) |

~ 1秒 |

~3.01秒 |

~3.99秒 |

|

4 秒 |

~1.33秒 |

~4.01秒 |

~5.32秒 |

|

5 秒 |

~1.66秒 |

~5.01秒 |

~6.65秒 |

|

6 秒 |

~ 2秒 |

~6.01秒 |

~7.99秒 |

|

7 秒 |

~2.33秒 |

~7.01秒 |

~9.32秒 |

|

8 秒 |

~2.66秒 |

~8.01秒 |

~10.65秒 |

クラスタHCの障害シナリオ

このセクションの目的は次のデモンストレーションを行うことです。

- さまざまなクラスタHC障害シナリオ

- さまざまなログとコマンド出力を関連付ける方法

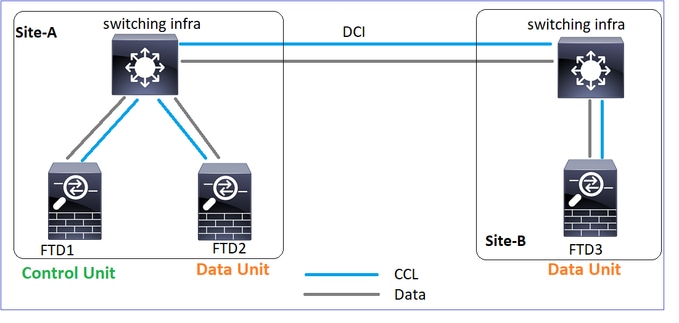

トポロジ

クラスタの設定:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

クラスタの状態:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

シナリオ1:両方向で4秒以上のCCL通信損失

障害が発生する前:

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

リカバリ後(ユニット・ロールの変更なし):

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

分析

障害(CCL通信が失われました)。

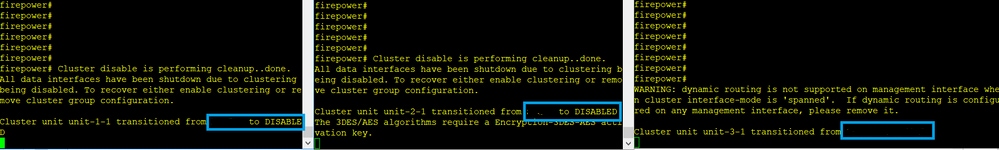

ユニット3-1のデータプレーンコンソールメッセージ:

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

ユニット1-1クラスタトレースログ:

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

スプリットブレイン:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

クラスタ履歴:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

|

イベントなし |

イベントなし |

09:38:16 UTC Nov 2 2020 |

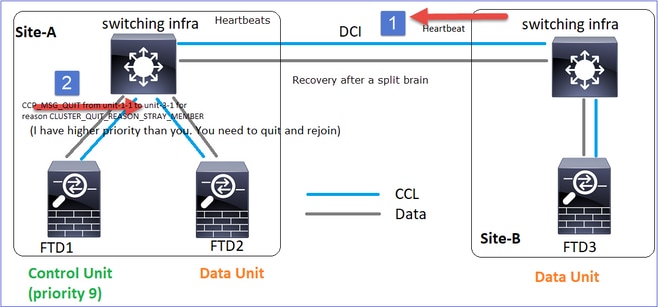

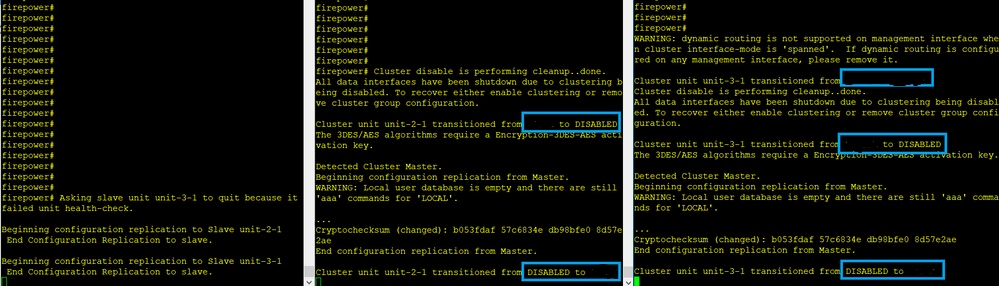

CCL通信の復元

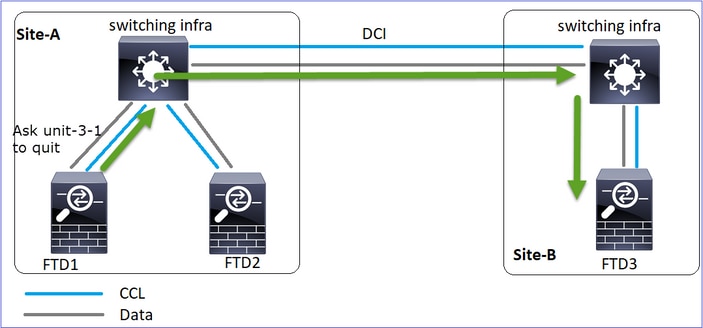

Unit-1-1は現在の制御ノードを検出し、Unit-1-1の方が優先順位が高いため、Unit-3-1にCLUSTER_QUIT_REASON_STRAY_MEMBERメッセージを送信して新しい選択プロセスをトリガーします。最後に、unit-3-1はデータノードとして再結合します。

分割パーティションがピアパーティションと再接続すると、データノードは支配的な制御ノードによって流用メンバとして扱われ、CLUSTER_QUIT_REASON_STRAY_MEMBERの理由を含むCCP終了メッセージを受信します。

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

両方のユニット(ユニット–1-1とユニット–3-1)がクラスタログに表示されます。

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

split-brainに対して生成されるsyslogメッセージもあります。

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

クラスタ履歴:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

|

イベントなし |

イベントなし |

09:47:33 UTC Nov 2 2020 |

シナリオ2:両方向でCCL通信損失が3 ~ 4秒以内

障害が発生する前:

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

リカバリ後(ユニット・ロールの変更なし):

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

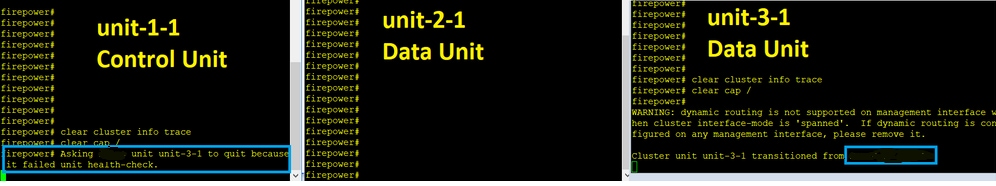

分析

イベント1:コントロールノードはユニット–3-1から3つのHCを失い、クラスタを離れるようユニット–3-1にメッセージを送信します。

イベント2: CCLが非常に速く回復し、制御ノードからのCLUSTER_QUIT_REASON_STRAY_MEMBERメッセージがリモート側に送信されました。ユニット3-1がDISABLEDモードに直接移行し、スプリットブレインが発生しない

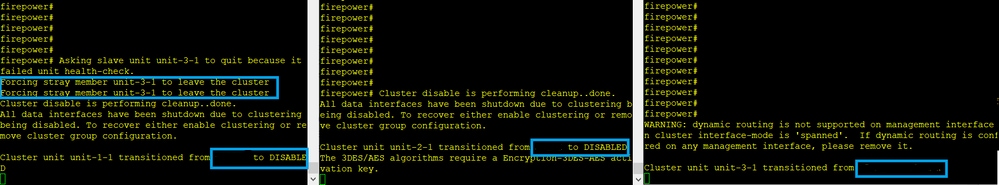

ユニット1-1(コントロール)では次のように表示されます。

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

ユニット3-1(データノード)では、次のように表示されます。

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

クラスタユニット3-1がDISABLED状態に移行し、CCL通信が復元されると、データノードとして再結合します。

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

シナリオ3:両方向でCCL通信損失が3 ~ 4秒以内

障害が発生する前:

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

リカバリ後(制御ノードが変更された場合):

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

データノード |

制御ノード |

データノード |

分析

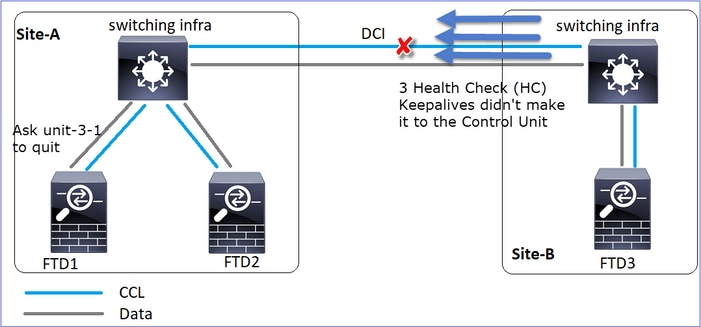

- CCLがダウンします。

- Unit-1-1はUnit-3-1から3つのHCメッセージを受信せず、QUITメッセージをUnit-3-1に送信します。このメッセージがユニット3-1に到達することはありません。

- ユニット3-1がユニット2-1にQUITメッセージを送信します。このメッセージがユニット2-1に到達することはありません。

CCLが回復します。

- Unit-1-1は、Unit-3-1が自身を制御ノードとしてアドバタイズしたことを確認し、QUIT_REASON_STRAY_MEMBERメッセージをUnit-3-1に送信します。unit-3-1でメッセージが受信されると、DISABLED状態になります。同時に、unit-3-1はQUIT_REASON_PRIMARY_UNIT_HCメッセージをunit-1-1に送信し、終了を依頼します。ユニット1-1が受信すると、このメッセージはDISABLED状態になります。

クラスタ履歴:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

シナリオ4:約3 ~ 4秒間のCCL通信損失

障害が発生する前:

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

リカバリ後(制御ノードがサイトを変更した場合):

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

データノード |

データノード |

制御ノード |

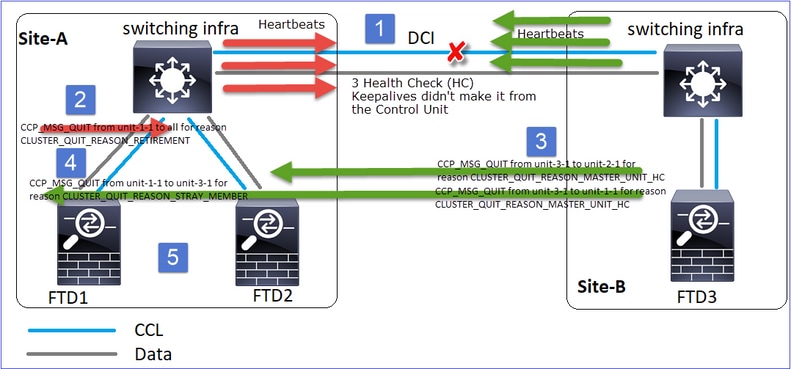

分析

障害

同じ障害の異なる種類。この場合、ユニット–1-1もユニット–3-1から3つのHCメッセージを受信せず、新しいキープアライブを受信した後、STRAYメッセージを使用してユニット–3-1をキックアウトしようとしましたが、メッセージはユニット–3-1に到達しませんでした。

- CCLが数秒間単方向になります。ユニット–3-1は、ユニット–1-1から3つのHCメッセージを受信せず、制御ノードとなる。

- ユニット2-1は、CLUSTER_QUIT_REASON_RETIREMENTメッセージ(ブロードキャスト)を送信する。

- ユニット–3-1がユニット–2-1にQUIT_REASON_PRIMARY_UNIT_HCメッセージを送信します。ユニット2-1はこれを受信し、クラスタを終了します。

- ユニット–3-1がユニット–1-1にQUIT_REASON_PRIMARY_UNIT_HCメッセージを送信します。ユニット1-1はそれを受信し、クラスタを終了します。CCLが回復します。

- ユニット1-1と2-1は、データノードとしてクラスタに再参加します。

注:ステップ5でCCLが回復しない場合、サイトAではFTD1が新しい制御ノードになり、CCLの回復後に新しい選択が行われます。

ユニット1-1のsyslogメッセージ:

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

ユニット1-1のクラスタトレースログ:

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

ユニット3-1のsyslogメッセージ:

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

クラスタ履歴

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

シナリオ 5

障害が発生する前:

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

リカバリ後(変更なし):

|

FTD1 |

FTD2 |

FTD3 |

|

サイトA |

サイトA |

サイトB |

|

制御ノード |

データノード |

データノード |

失敗:

ユニット3-1はユニット1-1とユニット2-1の両方にQUITメッセージを送信しましたが、接続の問題によりユニット2-1のみがQUITメッセージを受信しました。

ユニット1-1クラスタトレースログ:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

ユニット2-1クラスタトレースログ:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

クラスタ履歴:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

|

イベントなし |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

クラスタデータプレーン接続の確立

NGFWキャプチャポイント

NGFWは、次のポイントでキャプチャ機能を提供します。

- シャーシ内部スイッチ(FXOS)

- FTDデータプレーンエンジン

- FTD Snort エンジン

クラスタ上のデータパスの問題をトラブルシューティングする場合、ほとんどの場合に使用されるキャプチャポイントは、FXOSおよびFTDデータプレーンエンジンのキャプチャです。

- 物理インターフェイスでのFXOS入力キャプチャ

- データプレーンエンジンでのFTD入力キャプチャ

- データプレーンエンジンでのFTD出力キャプチャ

- バックプレーンインターフェイスでのFXOS入力キャプチャ

NGFWキャプチャの詳細については、次のドキュメントを参照してください。

クラスタユニットフローロールの基本

接続は、次のような要因に応じて、複数の方法でクラスタを介して確立できます。

- トラフィックのタイプ(TCP、UDPなど)

- 隣接スイッチで設定されたロードバランシングアルゴリズム

- ファイアウォールに設定された機能

- ネットワーク状態(IPフラグメンテーション、ネットワーク遅延など)

|

フローロール |

説明 |

フラグ |

|

主催者(Owner) |

通常は、最初に接続を受信したユニット |

UIO |

|

Director |

フォワーダからの所有者参照要求を処理するユニットです。 |

Y |

|

バックアップ所有者 |

ダイレクタが所有者と同じユニットでない限り、ダイレクタはバックアップ所有者でもあります。オーナーが自分自身をダイレクタとして選択した場合は、別のバックアップ・オーナーが選択されます。 |

Y(ダイレクタがバックアップ・オーナーでもある場合) y(ダイレクタがバックアップ・オーナーでない場合) |

|

フォワーダ |

パケットを所有者に転送するユニット |

z |

|

フラグメントオーナー |

フラグメント化されたトラフィックを処理するユニット |

- |

|

シャーシのバックアップ |

シャーシ間クラスタでは、ディレクタ/バックアップフローと所有者フローの両方が同じシャーシのユニットによって所有されている場合、他のいずれかのシャーシ内のユニットがセカンダリバックアップ/ディレクタになります。 このロールは、ブレードが1つ以上あるFirepower 9300シリーズのシャーシ間クラスタに固有のものです。 |

w |

- 詳細については、『コンフィギュレーションガイド』の関連セクションを参照してください(「関連情報」のリンクを参照)

- 特定のシナリオ(ケーススタディのセクションを参照)では、一部のフラグが常に表示されるわけではありません。

クラスタ接続の確立のケーススタディ

次のセクションでは、クラスタを介して接続を確立する方法の一部を示すさまざまなケーススタディについて説明します。目標は次のとおりです。

- ユニットのさまざまな役割を理解します。

- さまざまなコマンド出力を関連付ける方法をデモンストレーションします。

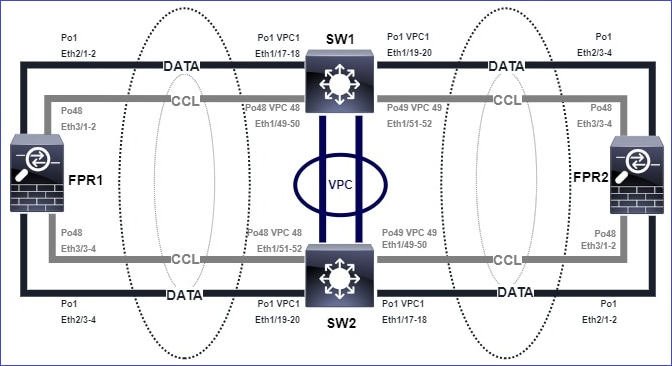

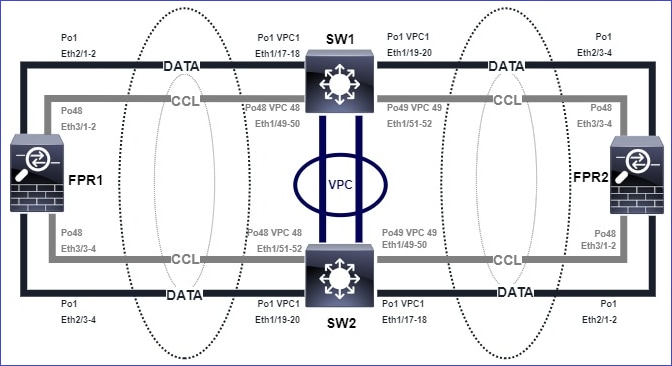

トポロジ

クラスタユニットとID:

|

ユニット1-1 |

ユニット2-1 |

ユニット3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

有効なクラスタキャプチャ:

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

注:これらのテストは、クラスタを通過するトラフィックが最小限のラボ環境で実行されました。実稼働環境では、キャプチャの「ノイズ」を最小限に抑えるために、可能な限り特定のキャプチャフィルタ(たとえば、宛先ポートと可能な限り送信元ポート)を使用するようにしてください。

ケース スタディ 1対称トラフィック(オーナーはディレクタでもある)

観察1.reinject-hideキャプチャは、ユニット1-1のパケットのみを示しています。これは、両方向のフローがユニット1-1(対称トラフィック)を通過したことを意味します。

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

観察2.送信元ポート45954を使用したフローの接続フラグ分析:

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

|

ユニット |

フラグ |

注 |

|

ユニット1-1 |

UIO |

・ フロー所有者 – ユニットがフローを処理します ・ ダイレクタ:ユニット3-1には「Y」ではなく「Y」があるため、このフローのダイレクタとしてユニット1-1が選択されたことを示しています。したがって、このユニットは所有者でもあるため、別のユニット(この場合はユニット3-1)がバックアップ所有者として選出されています |

|

ユニット2-1 |

- |

- |

|

ユニット3-1 |

y |

ユニットはバックアップ所有者です |

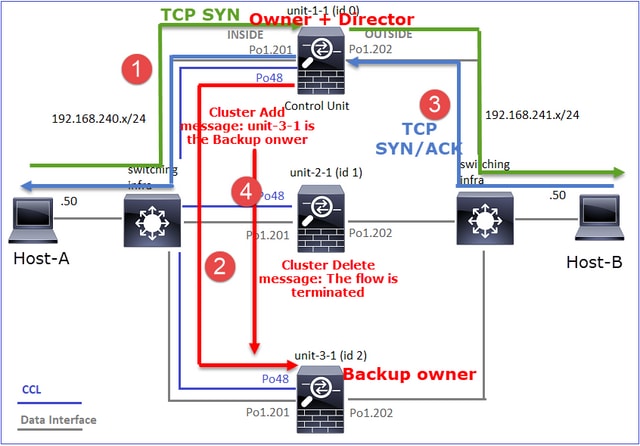

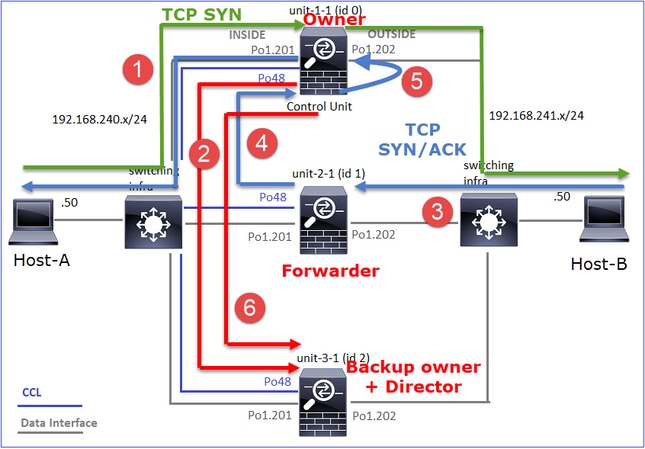

それを図で示します。

- TCP SYNパケットがホストAからユニット1-1に到着します。ユニット1-1がフローオーナーになります。

- ユニット1-1もフローディレクタとして選出されます。したがって、ユニット3-1もバックアップ所有者として選択されます(クラスタ追加メッセージ)。

- TCP SYN/ACKパケットがホストBからユニット3-1に到着します。流れは対称です。

- 接続が終了すると、所有者はクラスタ削除メッセージを送信して、バックアップ所有者からフロー情報を削除します。

観察3.トレース付きのキャプチャは、両方向がユニット1-1のみを通過することを示しています。

ステップ 1:送信元ポートに基づいて、すべてのクラスタユニットで対象となるフローとパケットを特定します。

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

ステップ 2:これはTCPフロートレースであるため、3ウェイハンドシェイクパケットをトレースします。この出力からわかるように、ユニット1-1が所有者です。わかりやすくするため、関連しないトレースフェーズは省略します。

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

リターントラフィック(TCP SYN/ACK):

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

観察4.FTDデータプレーンのsyslogには、すべてのユニットでの接続の作成と終了が表示されます。

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

ケース スタディ 2対称トラフィック(Directorとは異なる所有者)

- ケーススタディ#1と同じですが、このケーススタディでは、フローオーナーはディレクタとは別のユニットです。

- すべての出力はケーススタディ#1に類似しています。ケーススタディ#1との主な違いは、シナリオ1の「y」フラグを置き換える「Y」フラグです。

観察1.オーナーはディレクターとは異なります。

送信元ポート46278を使用したフローの接続フラグ分析:

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

|

ユニット |

フラグ |

注 |

|

ユニット1-1 |

UIO |

・ フロー所有者 – ユニットがフローを処理します |

|

ユニット2-1 |

- |

- |

|

ユニット3-1 |

Y |

・ ダイレクタとバックアップ・オーナー:ユニット3-1のフラグはY(ダイレクタ)です。 |

それを図で示します。

- TCP SYNパケットがホストAからユニット1-1に到着します。ユニット1-1がフローオーナーになります。

- Unit-3-1がフローディレクタに選出されるユニット3-1はバックアップ所有者でもあります(CCL経由のUDP 4193で「cluster add」メッセージが発生)。

- TCP SYN/ACKパケットがホストBからユニット3-1に到着します。流れは対称です。

- 接続が終了すると、所有者はCCL経由でUDP 4193の「cluster delete」メッセージを送信し、バックアップ所有者からフロー情報を削除します。

観察2.トレース付きのキャプチャは、両方向がユニット1-1のみを通過することを示しています。

ステップ 1:ケーススタディ1と同じアプローチを使用して、送信元ポートに基づいてすべてのクラスタユニットの対象フローとパケットを特定します。

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

OUTSIDEインターフェイスでのキャプチャ:

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

ステップ 2:入力パケット(TCP SYNおよびTCP SYN/ACK)に注目します。

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

ユニット1-1のSYN/ACKをトレースします。

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

観察3.FTDデータプレーンのsyslogには、所有者とバックアップ所有者の接続の作成と終了が表示されます。

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

ケース スタディ 3非対称トラフィック(ディレクタがトラフィックを転送)

観察1.reinject-hideキャプチャは、ユニット1-1(非対称フロー)とユニット2-1(非対称フロー)のパケットを示しています。

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

観察2.送信元ポート46502を使用したフローの接続フラグ分析

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

|

ユニット |

フラグ |

注 |

|

ユニット1-1 |

UIO |

・ フローオーナー – ユニットがフローを処理します。 |

|

ユニット2-1 |

Y |

・ ダイレクタ:unit-2-1にはフラグ「Y」があるため、このフローのダイレクタとしてunit-2-1が選択されたことを示しています。 ・ バックアップ・オーナー ・ 最後に、この出力から明らかではありませんが、show captureおよびshow logの出力から、ユニット2-1がこのフローを所有者に転送していることがわかります(技術的には、このシナリオではフォワーダとは見なされません)。 注:1つのユニットをディレクタ(Yフロー)とフォワーダ(Zフロー)の両方にすることはできない。これらの2つのロールは相互に排他的である。ダイレクタ(Yフロー)は引き続きトラフィックを転送できます。show logの出力については、このケーススタディの後半を参照してください。 |

|

ユニット3-1 |

- |

- |

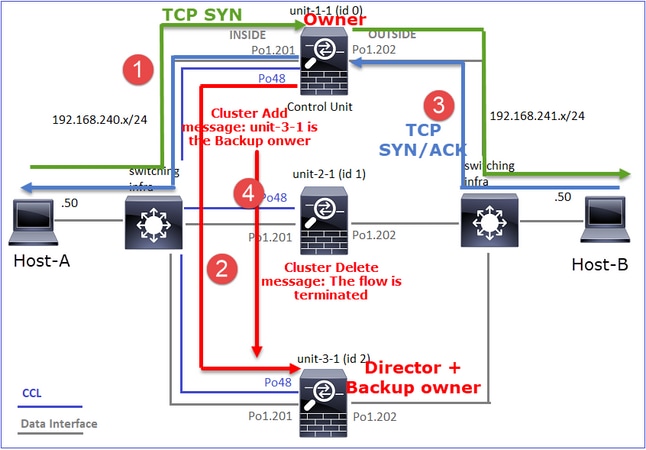

それを図で示します。

- TCP SYNパケットがホストAからユニット1-1に到着します。ユニット1-1がフローオーナーになります。

- ユニット2-1がフローディレクタとバックアップの所有者に選出されるフロー所有者は「cluster add」ユニキャストメッセージをUDP 4193で送信し、バックアップ所有者にフローについて通知します。

- TCP SYN/ACKパケットがホストBからユニット2-1に到着します。フローは非対称です。

- ユニット2-1は、(TCP SYN Cookieにより)CCL経由でパケットを所有者に転送します。

- 所有者はインターフェイスOUTSIDEでパケットを再注入してから、パケットをホストAに転送します。

- 接続が終了すると、所有者はクラスタ削除メッセージを送信して、バックアップ所有者からフロー情報を削除します。

観察3.トレースを使用したキャプチャは、非対称トラフィックと、ユニット–2-1からユニット–1-1へのリダイレクションを示しています。

ステップ 1:対象のフロー(ポート46502)に属するパケットを特定します。

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

戻り値の方向:

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

ステップ 2:パケットをトレースします。デフォルトでは、最初の50個の入力パケットのみがトレースされます。わかりやすくするために、関連しないトレースフェーズは省略します。

ユニット1-1(所有者)

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

ユニット2-1(フォワーダ)

リターントラフィック(TCP SYN/ACK)。対象のユニットは、ダイレクタ/バックアップ所有者であるユニット2-1で、トラフィックを所有者に転送します。

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

観察4.FTDデータプレーンのsyslogには、すべてのユニットでの接続の作成と終了が表示されます。

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)

Dec 01 2020 12:58:33: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46502 duration 0:00:00 forwarded bytes 0 Forwarding or redirect flow removed to create director or backup flow

Dec 01 2020 12:58:33: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 forwarded bytes 2048316300 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

firepower#

ケース スタディ 4非対称トラフィック(オーナーはディレクタ)

観察1.reinject-hideキャプチャは、ユニット1-1(非対称フロー)とユニット2-1(非対称フロー)のパケットを示しています。

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554229 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99924 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33552925 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 227690 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 4754 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

観察2.送信元ポート46916を使用したフローの接続フラグ分析

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46916, idle 0:00:00, bytes 414682616, flags UIO N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46916, idle 0:00:00, bytes 0, flags z

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 0 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46916, idle 0:00:04, bytes 0, flags y

|

ユニット |

フラグ |

注 |

|

ユニット1-1 |

UIO |

・ フロー所有者 – ユニットがフローを処理します ・ ダイレクタ:ユニット3-1には「Y」ではなく「Y」があるため、このフローのダイレクタとしてユニット1-1が選択されたことを示しています。したがって、このユニットは所有者でもあるため、別のユニット(この場合はユニット3-1)がバックアップ所有者として選出されています |

|

ユニット2-1 |

z |

・ フォワーダ |

|

ユニット3-1 |

y |

– バックアップ所有者 |

それを図で示します。

- TCP SYNパケットがホストAからユニット1-1に到着します。Unit-1-1がフローオーナーになり、ディレクタとして選出されます。

- ユニット3-1がバックアップ所有者として選出されます。フローオーナーはユニキャストの「cluster add」メッセージをUDP 4193で送信し、バックアップのオーナーにフローを通知します。

- TCP SYN/ACKパケットがホストBからユニット2-1に到着します。フローは非対称です。

- ユニット2-1は、(TCP SYN Cookieにより)CCL経由でパケットを所有者に転送します。

- 所有者はインターフェイスOUTSIDEでパケットを再注入してから、パケットをホストAに転送します。

- 接続が終了すると、所有者はクラスタ削除メッセージを送信して、バックアップ所有者からフロー情報を削除します。

観察3.トレースを使用したキャプチャは、非対称トラフィックと、ユニット–2-1からユニット–1-1へのリダイレクションを示しています。

ユニット2-1(フォワーダ):

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 16:11:33.653164 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46916: S 1331019196:1331019196(0) ack 3089755618 win 28960 <mss 1460,sackOK,timestamp 532473211 522117741,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

観察4.FTDデータプレーンのsyslogには、すべてのユニットでの接続の作成と終了が表示されます。

- ユニット1-1(所有者)

- ユニット2-1(フォワーダ)

- ユニット3-1(バックアップオーナー)

firepower# cluster exec show log | i 46916

unit-1-1(LOCAL):******************************************************

Dec 01 2020 16:11:33: %FTD-6-302013: Built inbound TCP connection 10023 for INSIDE:192.168.240.50/46916 (192.168.240.50/46916) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:11:42: %FTD-6-302014: Teardown TCP connection 10023 for INSIDE:192.168.240.50/46916 to OUTSIDE:192.168.241.50/80 duration 0:00:09 bytes 1024010016 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 16:11:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46916 (192.168.240.50/46916)

Dec 01 2020 16:11:42: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46916 duration 0:00:09 forwarded bytes 1024009868 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

Dec 01 2020 16:11:33: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/46916 (192.168.240.50/46916) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:11:42: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/46916 to OUTSIDE:192.168.241.50/80 duration 0:00:09 forwarded bytes 0 Cluster flow with CLU closed on owner

ケース スタディ 5非対称トラフィック(所有者がダイレクタと異なる)

観察1.reinject-hideキャプチャは、ユニット1-1(非対称フロー)とユニット2-1(非対称フロー)のパケットを示しています。

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553207 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 99396 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99224 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 99396 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99928 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554251 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 131925 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 2592 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

観察2.送信元ポート46994を使用したフローの接続フラグ分析:

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46994, idle 0:00:00, bytes 406028640, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46994, idle 0:00:00, bytes 0, flags z

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 2 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46994, idle 0:00:05, bytes 0, flags Y

|

ユニット |

フラグ |

注 |

|

ユニット1-1 |

UIO |

・ フロー所有者 – ユニットがフローを処理します |

|

ユニット2-1 |

z |

・ フォワーダ |

|

ユニット3-1 |

Y |

・ バックアップ・オーナー ·Director |

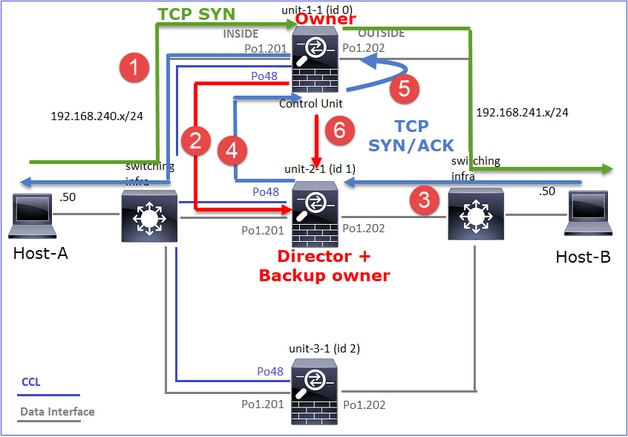

それを図で示します。

- TCP SYNパケットがホストAからユニット1-1に到着します。ユニット1-1がフローオーナーになります。

- ユニット3-1がディレクタおよびバックアップ所有者として選出されます。フロー所有者は「cluster add」ユニキャストメッセージをUDP 4193で送信し、バックアップ所有者にフローについて通知します。

- TCP SYN/ACKパケットがホストBからユニット2-1に到着します。フローは非対称です

- ユニット2-1は、(TCP SYN Cookieにより)CCL経由でパケットを所有者に転送します。

- 所有者はインターフェイスOUTSIDEでパケットを再注入してから、パケットをホストAに転送します。

- 接続が終了すると、所有者はクラスタ削除メッセージを送信して、バックアップ所有者からフロー情報を削除します。

観察3.トレースを使用したキャプチャは、非対称トラフィックと、ユニット–2-1からユニット–1-1へのリダイレクションを示しています。

ユニット1-1(所有者):

firepower# cluster exec show cap CAPI packet-number 1 trace

unit-1-1(LOCAL):******************************************************

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

ユニット2-1(フォワーダ):

firepower# cluster exec unit unit-2-1 show cap CAPO packet-number 1 trace

1: 16:46:44.232074 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46994: S 2863659376:2863659376(0) ack 2879616990 win 28960 <mss 1460,sackOK,timestamp 534583774 524228304,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

観察4.FTDデータプレーンのsyslogには、すべてのユニットでの接続の作成と終了が表示されます。

- ユニット1-1(所有者)

- ユニット2-1(フォワーダ)

- ユニット3-1(バックアップ・オーナー/ダイレクタ)

firepower# cluster exec show log | i 46994

unit-1-1(LOCAL):******************************************************

Dec 01 2020 16:46:44: %FTD-6-302013: Built inbound TCP connection 10080 for INSIDE:192.168.240.50/46994 (192.168.240.50/46994) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:46:53: %FTD-6-302014: Teardown TCP connection 10080 for INSIDE:192.168.240.50/46994 to OUTSIDE:192.168.241.50/80 duration 0:00:09 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 16:46:44: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46994 (192.168.240.50/46994)

Dec 01 2020 16:46:53: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46994 duration 0:00:09 forwarded bytes 1024000292 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

Dec 01 2020 16:46:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46994 (192.168.240.50/46994) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:46:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46994 to OUTSIDE:192.168.241.50/80 duration 0:00:09 forwarded bytes 0 Cluster flow with CLU closed on owner

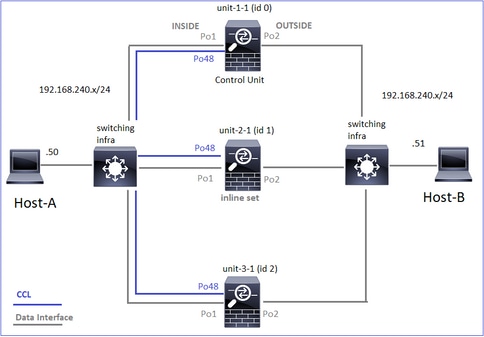

次のケーススタディでは、使用されるトポロジはインラインセットを持つクラスタに基づいています。

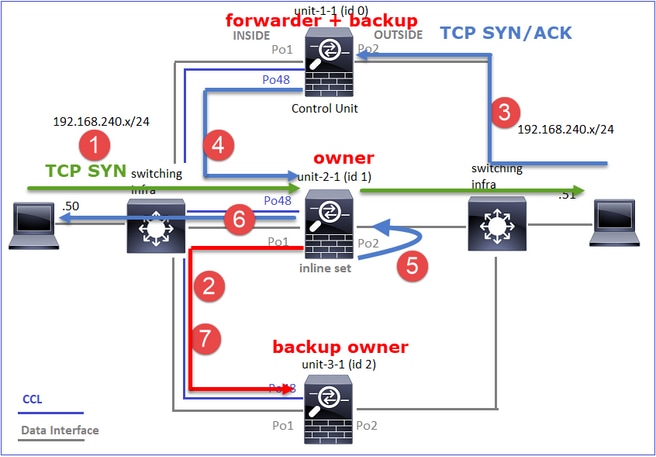

ケース スタディ 6非対称トラフィック(インラインセット、ディレクタはオーナー)

観察1.reinject-hideキャプチャは、ユニット1-1(非対称フロー)とユニット2-1(非対称フロー)のパケットを示しています。 さらに、所有者はユニット2-1です(内部と外部の両方のインターフェイスにreinject-hideキャプチャのパケットがありますが、ユニット1-1のインターフェイスはOUTSIDEだけです)。

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553253 bytes]

capture CAPO type raw-data trace interface OUTSIDE [Buffer Full - 523432 bytes]

match tcp host 192.168.240.50 host 192.168.240.51 eq www