Introduction

Ce document décrit comment configurer l'unité MTU (Maximum Transition Unit) jumbo de bout en bout sur les périphériques de data center Cisco.

Conditions préalables

Exigences

Cisco vous recommande de prendre connaissance des rubriques suivantes :

- VMware ESXi

- Cisco UCS

- Cisco N5k

- Cisco Internet Small Computer Systems Interface (iSCSI)

Composants utilisés

Ce document décrit comment configurer l'unité MTU (Maximum Transition Unit) jumbo de bout en bout sur les périphériques de data center Cisco dans un réseau constitué d'un hôte VMware ESXi installé sur Cisco Unified Computing System (UCS), les commutateurs Cisco Nexus 1000V (N1kV), les commutateurs Cisco Nexus 5000 (N5k) et le contrôleur Cisco NetApp.

Les informations contenues dans ce document sont basées sur les versions de matériel et de logiciel suivantes :

- Commutateurs de la gamme Cisco Nexus 5020 version 5.0(3)N2(2a)

- Cisco UCS version 2.1(1d)

- Serveur lame Cisco UCS B200 M3 avec carte d'interface virtuelle (VIC) Cisco 1240

- vSphere 5.0 (ESXi et vCenter)

- Cisco N1kV version 4.2(1)SV2(2.1a)

- NetApp FAS 3240

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

Configurer

Diagramme du réseau

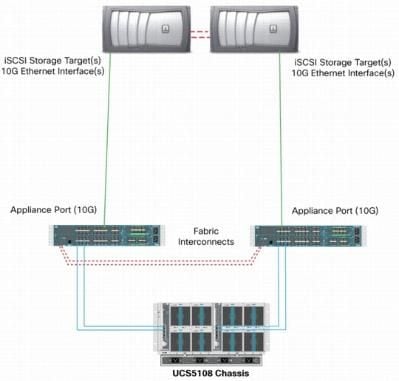

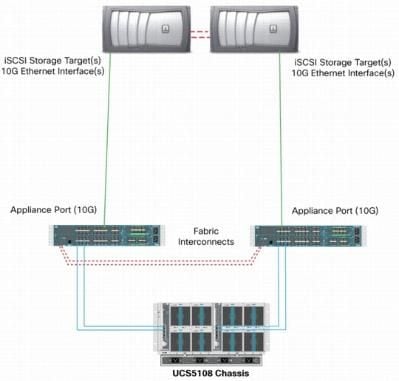

Le déploiement typique d'un réseau de stockage SAN iSCSI utilise Cisco UCS avec une interconnexion de fabric en mode hôte final Ethernet et la cible de stockage connectée via un commutateur ou un réseau commuté en amont.

Grâce à l'utilisation des ports de l'appliance sur l'UCS, le stockage peut être directement connecté aux interconnexions de fabric.

Que le réseau en amont soit 1 GbE ou 10 GbE, l'utilisation de trames jumbo (une taille MTU de 9 000, par exemple) améliore les performances car elle réduit le nombre de trames individuelles qui doivent être envoyées pour une quantité donnée de données et réduit la nécessité de séparer les blocs de données iSCSI en plusieurs trames Ethernet. Ils réduisent également l'utilisation de l'hôte et du processeur de stockage.

Si des trames jumbo sont utilisées, assurez-vous que l'UCS et la cible de stockage, ainsi que tout l'équipement réseau entre les deux, sont capables et configurés afin de prendre en charge la taille de trame plus importante.

Cela signifie que le MTU jumbo doit être configuré de bout en bout (de l'initiateur à la cible) pour être efficace dans l'ensemble du domaine.

Voici un aperçu de la procédure utilisée afin de configurer la MTU jumbo de bout en bout :

- Créez une classe système de qualité de service (QoS) UCS avec une MTU de 9 000, puis configurez la carte réseau virtuelle (vNIC) avec une MTU étendue.

- Activez les trames jumbo (MTU 9000) sur tous les commutateurs entre l'initiateur (UCS) et la cible iSCSI.

- Activez les trames jumbo sur la carte du système d'exploitation (port VMkernel de l'ESXi).

- Activez les trames jumbo sur les interfaces NetApp.

Remarque : consultez l'article Cisco Unified Computing System (UCS) Storage Connectivity Options and Best Practices with NetApp Storage Cisco pour plus d'informations.

Configuration de Cisco UCS

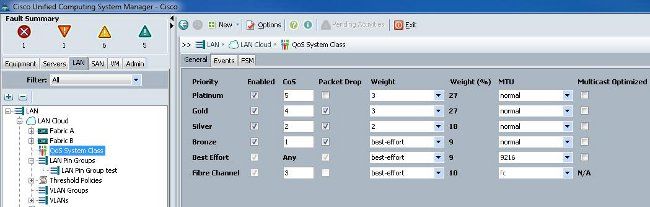

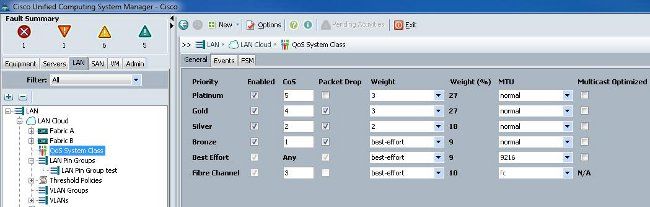

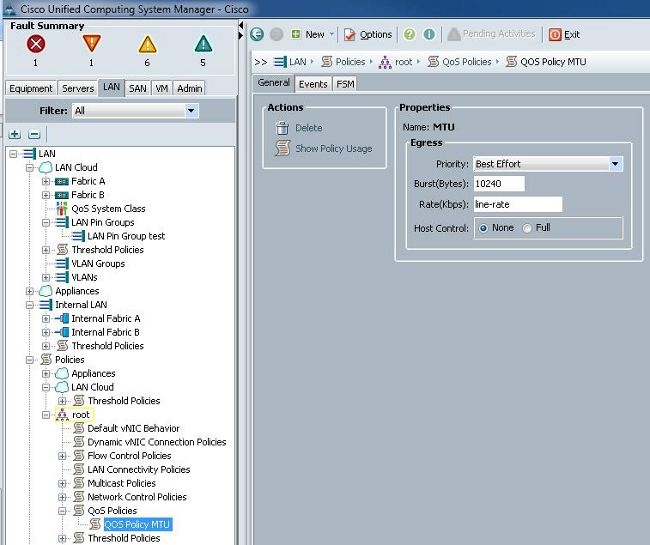

L'unité de transmission maximale (MTU) est définie par classe de service (CoS) dans l'UCS. Si aucune stratégie QoS n'est définie pour la vNIC qui se dirige vers le vSwitch, le trafic passe à la classe au mieux.

Complétez ces étapes afin d'activer les trames jumbo :

- Dans l'interface utilisateur graphique d'UCS, cliquez sur l'onglet LAN.

- Accédez à LAN > LAN Cloud > QoS System Class.

- Cliquez sur la QoS System Class et changez la classe de trafic (qui transporte le trafic iSCSI) MTU à 9216.

Remarque : cet exemple utilise la classe de trafic Best Effort afin d'illustrer cette mise à jour MTU.

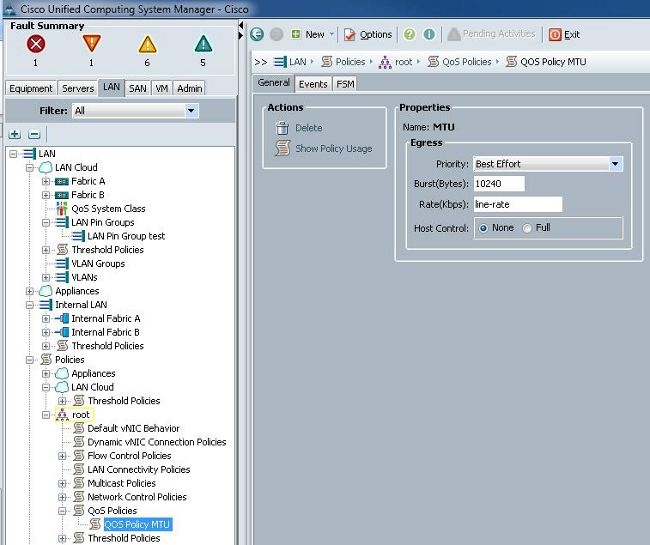

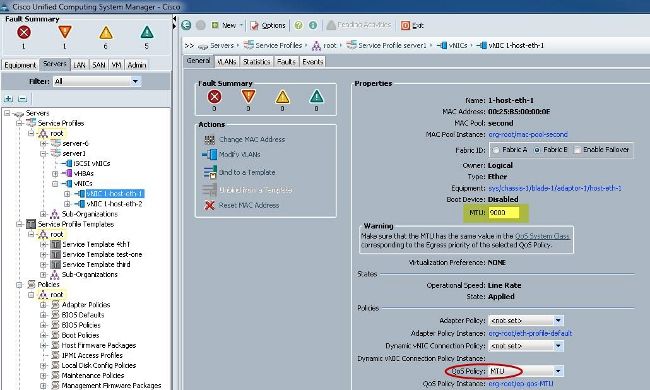

- Créez une stratégie QoS dans l'onglet LAN et appliquez-la à la vNIC qui transporte le trafic de stockage.

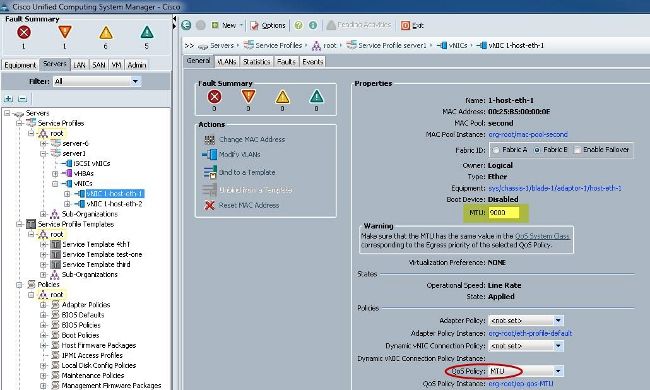

- Accédez au modèle vNIC ou à la vNIC réelle sous les profils de service et définissez la valeur MTU sur 9000.

Vérifier

Vérifiez que la MTU de la vNIC est configurée comme décrit précédemment.

Vérifiez que le MTU jumbo est activé sur les ports de liaison ascendante.

Configuration N5k

Avec le N5k, la MTU jumbo est activée au niveau du système.

Ouvrez une invite de commandes et entrez ces commandes afin de configurer le système pour le MTU jumbo :

switch(config)#policy-map type network-qos jumbo

switch(config-pmap-nq)#class type network-qos class-default

switch(config-pmap-c-nq)#mtu 9216

switch(config-pmap-c-nq)#exit

switch(config-pmap-nq)#exit

switch(config)#system qos

switch(config-sys-qos)#service-policy type network-qos jumbo

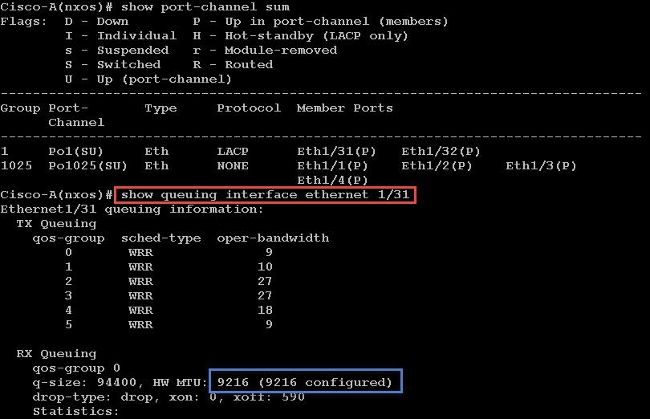

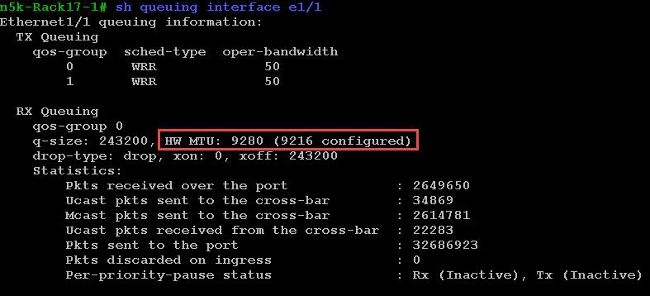

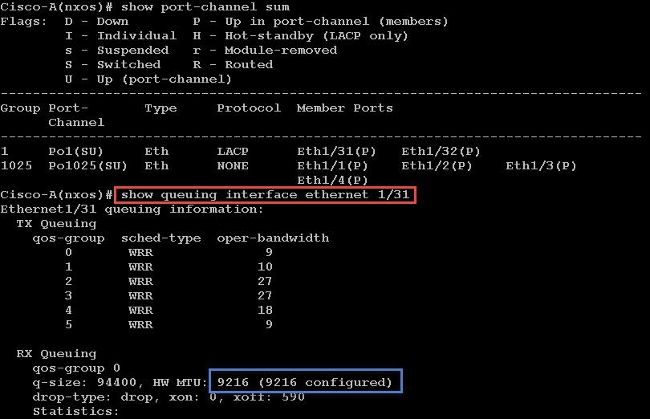

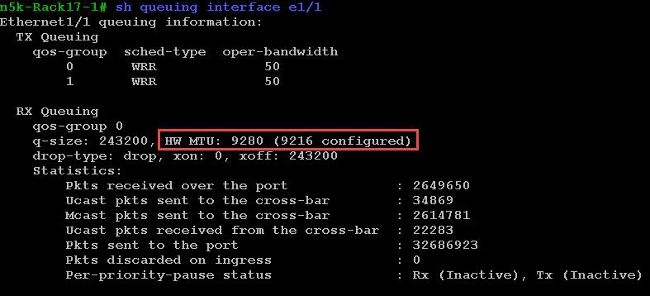

Vérifier

Entrez la commande show queuing interface Ethernet x/y afin de vérifier que le MTU jumbo est activé :

Remarque : la commande show interface Ethernet x/y affiche une MTU de 1500, mais ce n'est pas correct.

Configuration VMware ESXi

Vous pouvez configurer la valeur MTU d'un commutateur virtuel de sorte que tous les groupes de ports et les ports utilisent des trames jumbo.

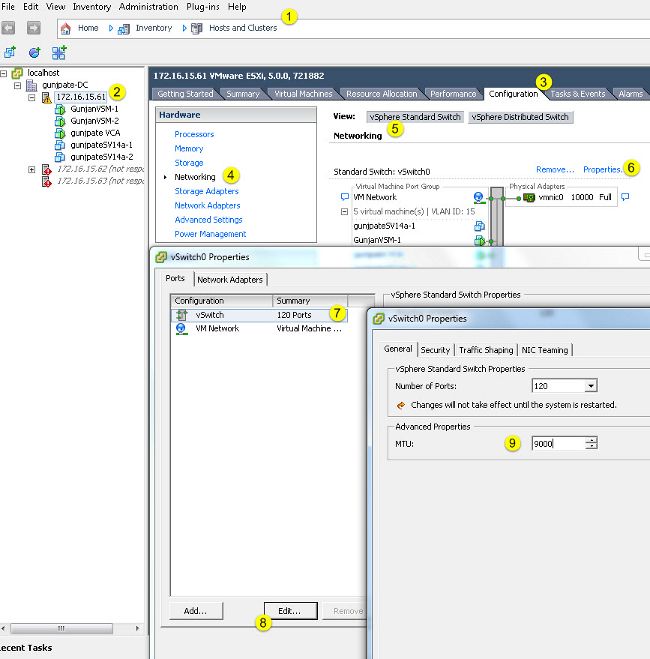

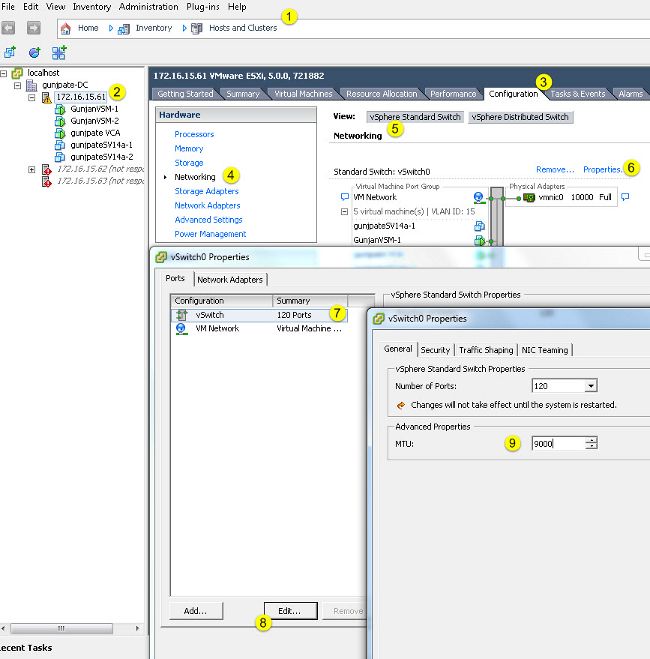

Complétez ces étapes afin d'activer les trames jumbo sur un commutateur virtuel hôte :

- Accédez à Accueil > Inventaire > Hôtes et clusters à partir du client vSphere.

- Sélectionnez l'hôte.

- Cliquez sur l'onglet Configuration.

- Sélectionnez Mise en réseau dans le menu Matériel.

- Sélectionnez Commutateur standard vSphere dans le champ View.

- Cliquez sur Properties.

- Sélectionnez vSwitch dans l'onglet Ports de la fenêtre contextuelle Propriétés.

- Cliquez sur Edit.

- Dans l'onglet Général de la fenêtre contextuelle, modifiez la valeur MTU (sous Propriétés avancées) de la valeur par défaut (1500) à 9000. Cela active les trames jumbo sur tous les groupes de ports et les ports du commutateur virtuel.

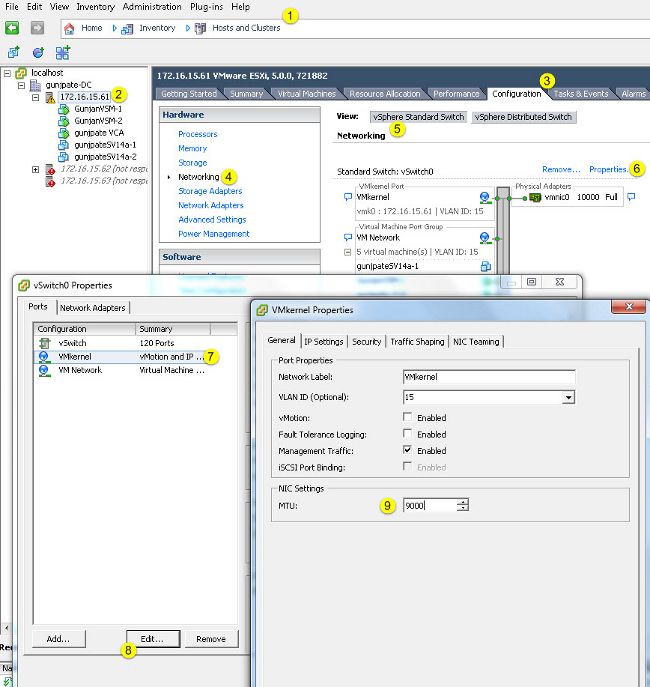

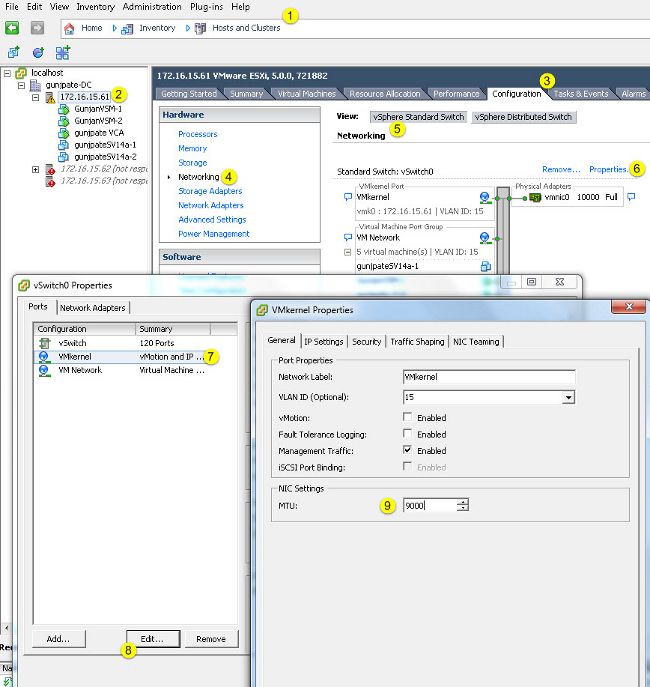

Complétez ces étapes afin d'activer les trames Jumbo uniquement sur un port VMkernel à partir du serveur vCenter :

- À partir du client vSphere, accédez à Home > Inventory > Hosts and Clusters.

- Sélectionnez l'hôte.

- Cliquez sur l'onglet Configuration.

- Sélectionnez Mise en réseau dans le menu Matériel.

- Sélectionnez Commutateur standard vSphere dans le champ View.

- Cliquez sur Properties.

- Sélectionnez VMkernel dans l'onglet Ports de la fenêtre contextuelle Propriétés.

- Cliquez sur Edit.

- Dans l'onglet General de la fenêtre contextuelle, changez la valeur MTU (sous NIC Settings) de la valeur par défaut (1500) à 9000. Cela active les trames jumbo sur un seul port VMkernel du commutateur virtuel.

Vérifier

Entrez la commande vmkping -d -s 8972 <storage appliance ip address> afin de tester la connectivité réseau et de vérifier que le port VMkernel peut envoyer une requête ping avec MTU jumbo.

Conseil : consultez l'article Test de la connectivité réseau de VMkernel avec la commande vmkping VMware pour plus d'informations sur cette commande.

Remarque : la taille de paquet réelle la plus grande est 8972, qui envoie un paquet de 9 000 octets lorsque vous ajoutez les octets d'en-tête IP et ICMP.

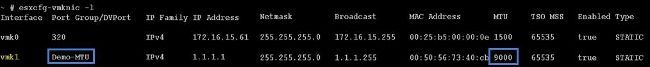

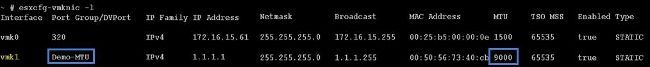

Au niveau de l'hôte ESXi, vérifiez que les paramètres MTU sont configurés correctement :

Configuration de Cisco IOS

Avec les commutateurs Cisco IOS®, il n'existe aucun concept de MTU globale au niveau du commutateur. Au lieu de cela, MTU est configuré au niveau de l'interface/de l'éther-canal.

Entrez ces commandes afin de configurer le MTU jumbo :

7609(config)#int gigabitEthernet 1/1

7609(config-if)#mtu ?

<1500-9216> MTU size in bytes

7609(config-if)#mtu 9216

Vérifier

Entrez la commande show interfaces gigabitEthernet 1/1 afin de vérifier que la configuration est correcte :

7609#show interfaces gigabitEthernet 1/1

GigabitEthernet1/1 is up, line protocol is up (connected)

Hardware is C6k 1000Mb 802.3, address is 0007.0d0e.640a (bia 0007.0d0e.640a)

MTU 9216 bytes, BW 1000000 Kbit, DLY 10 usec,

reliability 255/255, txload 1/255, rxload 1/255

Configuration N1kV

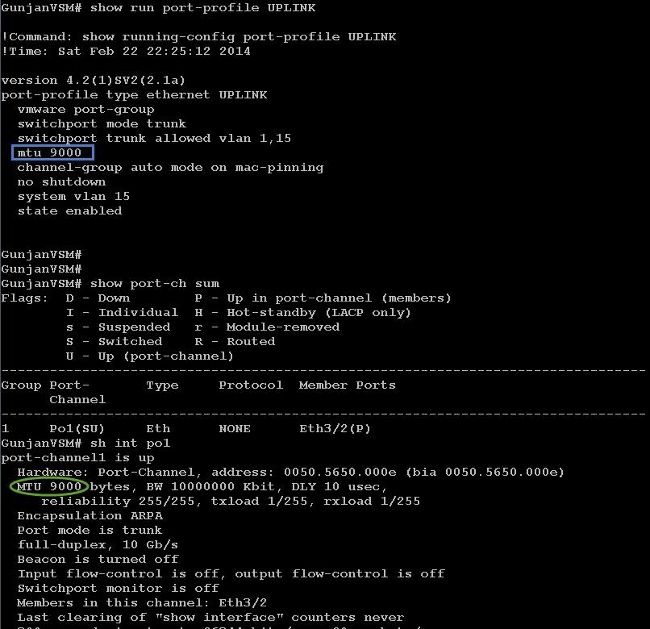

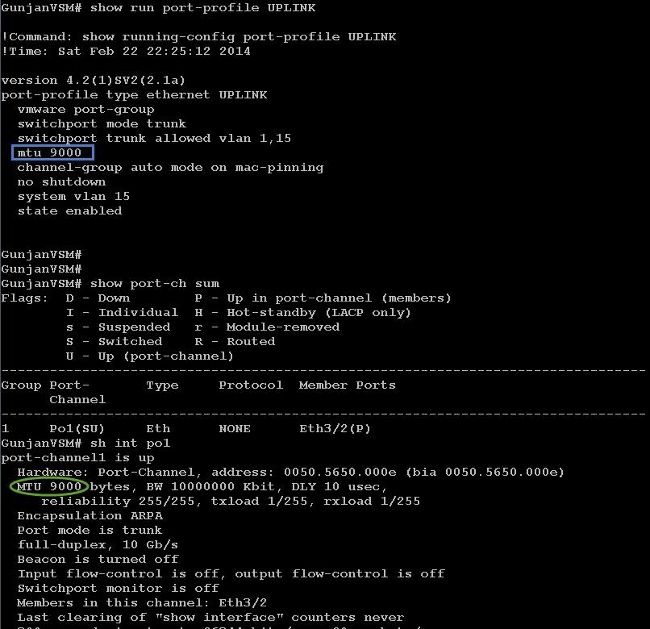

Avec le N1kV, la MTU jumbo ne peut être configurée que sur les profils de port Ethernet pour la liaison ascendante ; la MTU ne peut pas être configurée sur l'interface vEthernet.

Vérifier

Entrez la commande show run port-profile UPLINK afin de vérifier que la configuration est correcte :

Configuration de NetApp FAS 3240

Sur le contrôleur de stockage, le MTU jumbo doit être configuré sur les ports réseau connectés à l'interconnexion de fabric ou au commutateur de couche 2 (L2). Voici un exemple de configuration :

FAS3240-A> vlan create e1a 100

Ethernet e1a: Link being reconfigured.

vlan: e1a-100 has been created

Ethernet e1a: Link up.

FAS3240-A> vlan create e1b 100

Ethernet e1b: Link being reconfigured.

vlan: e1b-100 has been created

Ethernet e1b: Link up.

FAS3240-A> ifconfig e1a-100 192.168.101.105 netmask 255.255.255.0 mtusize 9000

partner e1a-100

FAS3240-A> ifconfig e1b-100 192.168.102.105 netmask 255.255.255.0 mtusize 9000

partner e1b-100

Vérifier

Utilisez cette section afin de vérifier que la configuration est correcte.

FAS3240-A> ifconfig –a

e1a: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2c (auto-10g_twinax-fd-up) flowcontrol full

e1b: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2e (auto-10g_twinax-fd-up) flowcontrol full

Commentaires

Commentaires