Application d'un correctif d'image ESXI non personnalisé sur un cluster Hyperflex

Options de téléchargement

-

ePub (720.5 KB)

Consulter à l’aide de différentes applications sur iPhone, iPad, Android ou Windows Phone -

Mobi (Kindle) (642.0 KB)

Consulter sur un appareil Kindle ou à l’aide d’une application Kindle sur plusieurs appareils

Langage exempt de préjugés

Dans le cadre de la documentation associée à ce produit, nous nous efforçons d’utiliser un langage exempt de préjugés. Dans cet ensemble de documents, le langage exempt de discrimination renvoie à une langue qui exclut la discrimination en fonction de l’âge, des handicaps, du genre, de l’appartenance raciale de l’identité ethnique, de l’orientation sexuelle, de la situation socio-économique et de l’intersectionnalité. Des exceptions peuvent s’appliquer dans les documents si le langage est codé en dur dans les interfaces utilisateurs du produit logiciel, si le langage utilisé est basé sur la documentation RFP ou si le langage utilisé provient d’un produit tiers référencé. Découvrez comment Cisco utilise le langage inclusif.

À propos de cette traduction

Cisco a traduit ce document en traduction automatisée vérifiée par une personne dans le cadre d’un service mondial permettant à nos utilisateurs d’obtenir le contenu d’assistance dans leur propre langue. Il convient cependant de noter que même la meilleure traduction automatisée ne sera pas aussi précise que celle fournie par un traducteur professionnel.

Introduction

Ce document décrit le processus de correction d'un noeud Hyperflex ESXI avec une image HX non personnalisée via l'interface de ligne de commande (CLI) ou via HX Connect.

Conditions préalables

Exigences

Cisco vous recommande de prendre connaissance des rubriques suivantes :

- Hyperflex

- ESXI

Composants utilisés

Les informations contenues dans ce document sont basées sur les versions de matériel et de logiciel suivantes :

- HyperFlex Connect 5.0.2d

- Cluster Hyperflex Standard

- vCenter 8.0

- VMware ESXI, 7.0.3 build-23794027

- VMware ESXI, 7.0.3 build-24585291 (correctif cible)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

Informations générales

Cisco ne fournit pas toujours un bundle HyperFlex distinct pour chaque nouvelle version de correctif VMware ESXI. Avec les mises à jour ESXI critiques, il est possible de les appliquer manuellement avec n'importe laquelle des méthodes présentées dans cet article. Toutefois, HyperFlex ne recommande pas la mise à niveau d'ESXI à l'aide de VMware Update Manager (VUM) ou de VMware Lifecycle Manager (vLCM), car cela peut entraîner des problèmes avec certains packs d'installation HyperFlex vSphere (VIB).

Les correctifs non personnalisés ne peuvent être appliqués que pour les mêmes versions d'ESXI. Si vous utilisez ESXI 7.0 u3, vous ne pouvez appliquer que des correctifs 7.0u3+ et vous ne pouvez pas effectuer de mise à niveau de 7.0u3 vers 8.0u2 ou 8.0u3, ni de mise à niveau de 8.0u2x vers 8.0u3x avec des images non personnalisées.

Avant d'appliquer un correctif, assurez-vous que votre version actuelle de la plate-forme de données HyperFlex (HXDP) est compatible avec la version ESXi que vous prévoyez d'installer. Le tableau de compatibilité est le suivant :

| Version | Serveurs VMware ESXi version HX |

| 6.0(1x) | 7,0 U3, 8,0 U2 |

| 5.5(2a) | 7,0 U3, 8,0 U2, 8,0 U3 |

| 5.5(1 bis) | 7,0 U3 |

| 5.0(x2) | 7,0 U3 |

Si votre version HXDP est plus ancienne, mettez d'abord à niveau HXDP, puis mettez à niveau ESXI.

Configurer

Téléchargez le fichier zip ESXI à partir du site Web Broadcom

Assurez-vous que le cluster est en ligne et qu'il est sain avant de commencer l'exercice.

Vérifiez les versions initiales des interfaces virtuelles Hyperflex, nenic et nfnic sur les noeuds ESXi du cluster.

esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc|nenic|nfnic'

Mise à niveau via CLI

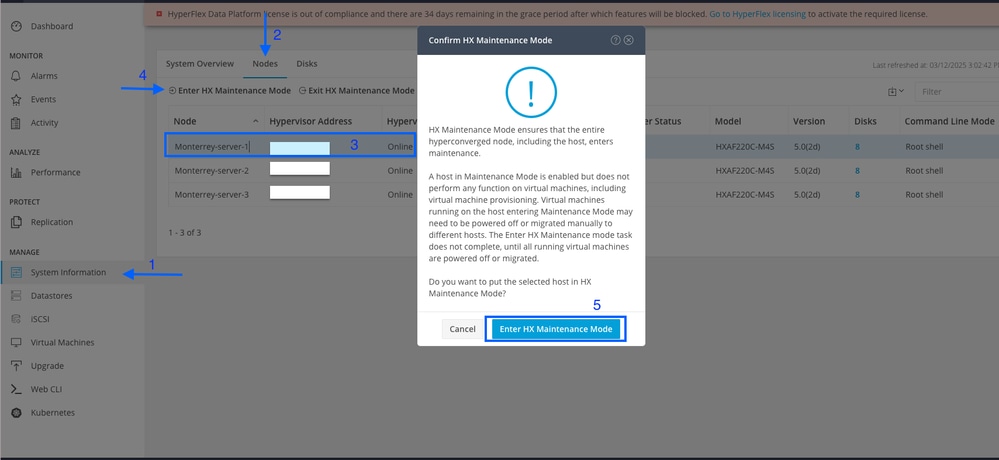

Étape 1. Dans HX Connect, accédez à System Information > Nodes, sélectionnez l’un des hôtes et cliquez sur Enter HX Maintenance Mode.

Une fois que l’hôte est en mode maintenance, passez aux étapes suivantes.

Étape 2 : transfert du fichier zip vers l’hôte

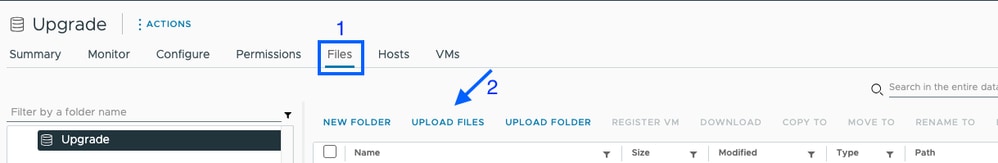

Vous pouvez le télécharger via vCenter vers un data store monté.

Naviguez jusqu'au data store souhaité et sélectionnez Files, puis UPLOAD FILES et téléchargez le fichier zip. Sur l'image ci-dessous, un datastore nommé Upgrade est utilisé.

Vous pouvez également copier à distance et en toute sécurité le bundle de mise à niveau ESXI dans un dossier approprié avec suffisamment d'espace avec SCP.

scp local_filename user@ESXIserver:/path/where/file/should/goÉtape 3. Établissez une connexion SSH avec l’hôte ESXI en mode maintenance et naviguez jusqu’au dossier du data store dans lequel l’offre groupée de mise à niveau ESXI est copiée. Dans ce scénario, le fichier est disponible sur le datastore de mise à niveau.

[root@Monterrey-server-1:~]cd /vmfs/volumes/UpgradeVous pouvez vérifier la version actuelle avec la commande vmware -v

[root@Monterrey-server-1:~] vmware -v

VMware ESXi 7.0.3 build-23794027

Exécutez cette commande afin d'afficher les détails du profil de package : esxcli software sources profile list -d /complete/path/VMware-ESXi...siffler

[root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software sources profile list -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip

Name Vendor Acceptance Level Creation Time Modification Time

----------------------------- ------------ ---------------- ------------------- -----------------

ESXi-7.0U3s-24585291-standard VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-03-04T00:00:00

ESXi-7.0U3s-24585291-no-tools VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-02-21T03:24:14

Étape 4. Exécutez cette commande pour installer le correctif : esxcli software profile update -d /complete/path/VMware-ESXi...zip -p PackageProfileName et attendez qu'il affiche un résultat réussi.

root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software profile update -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip -p ESXi-7.0U3s-24585291-standard

Update Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: VMware_bootbank_bmcal_7.0.3-0.135.24585291, VMware_bootbank_cpu-microcode_7.0.3-0.135.24585291, VMware_bootbank_crx_7.0.3-0.135.24585291, VMware_bootbank_esx-base_7.0.3-0.135.24585291, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.135.24585291, VMware_bootbank_esx-update_7.0.3-0.135.24585291, VMware_bootbank_esx-xserver_7.0.3-0.135.24585291, VMware_bootbank_esxio-combiner_7.0.3-0.135.24585291, VMware_bootbank_gc_7.0.3-0.135.24585291, VMware_bootbank_loadesx_7.0.3-0.135.24585291, VMware_bootbank_native-misc-drivers_7.0.3-0.135.24585291, VMware_bootbank_trx_7.0.3-0.135.24585291, VMware_bootbank_vdfs_7.0.3-0.135.24585291, VMware_bootbank_vsan_7.0.3-0.135.24585291, VMware_bootbank_vsanhealth_7.0.3-0.135.24585291

VIBs Removed: VMware_bootbank_bmcal_7.0.3-0.125.23794027, VMware_bootbank_cpu-microcode_7.0.3-0.125.23794027, VMware_bootbank_crx_7.0.3-0.125.23794027, VMware_bootbank_esx-base_7.0.3-0.125.23794027, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.125.23794027, VMware_bootbank_esx-update_7.0.3-0.125.23794027, VMware_bootbank_esx-xserver_7.0.3-0.125.23794027, VMware_bootbank_esxio-combiner_7.0.3-0.125.23794027, VMware_bootbank_gc_7.0.3-0.125.23794027, VMware_bootbank_loadesx_7.0.3-0.125.23794027, VMware_bootbank_native-misc-drivers_7.0.3-0.125.23794027, VMware_bootbank_trx_7.0.3-0.125.23794027, VMware_bootbank_vdfs_7.0.3-0.125.23794027, VMware_bootbank_vsan_7.0.3-0.125.23794027, VMware_bootbank_vsanhealth_7.0.3-0.125.23794027

VIBs Skipped: VMW_bootbank_atlantic_1.0.3.0-8vmw.703.0.20.19193900, VMW_bootbank_bnxtnet_216.0.50.0-44vmw.703.0.50.20036589, VMW_bootbank_bnxtroce_216.0.58.0-23vmw.703.0.50.20036589, VMW_bootbank_brcmfcoe_12.0.1500.2-3vmw.703.0.20.19193900, VMW_bootbank_elxiscsi_12.0.1200.0-9vmw.703.0.20.19193900, VMW_bootbank_elxnet_12.0.1250.0-5vmw.703.0.20.19193900, VMW_bootbank_i40en_1.11.1.32-1vmw.703.0.125.23794027, VMW_bootbank_iavmd_2.7.0.1157-3vmw.703.0.105.22348816, VMW_bootbank_icen_1.4.1.20-1vmw.703.0.50.20036589, VMW_bootbank_igbn_1.4.11.2-1vmw.703.0.20.19193900, VMW_bootbank_ionic-en_16.0.0-16vmw.703.0.20.19193900, VMW_bootbank_irdman_1.3.1.22-1vmw.703.0.50.20036589, VMW_bootbank_iser_1.1.0.1-1vmw.703.0.50.20036589, VMW_bootbank_ixgben_1.7.1.35-1vmw.703.0.20.19193900, VMW_bootbank_lpfc_14.0.169.26-5vmw.703.0.50.20036589, VMW_bootbank_lpnic_11.4.62.0-1vmw.703.0.20.19193900, VMW_bootbank_lsi-mr3_7.718.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt2_20.00.06.00-4vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt35_19.00.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt3_17.00.12.00-2vmw.703.0.105.22348816, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.703.0.20.19193900, VMW_bootbank_ne1000_0.9.0-1vmw.703.0.50.20036589, VMW_bootbank_nenic_1.0.33.0-1vmw.703.0.20.19193900, VMW_bootbank_nfnic_4.0.0.70-1vmw.703.0.20.19193900, VMW_bootbank_nhpsa_70.0051.0.100-4vmw.703.0.20.19193900, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx5-core_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_nmlx5-rdma_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_ntg3_4.1.9.0-5vmw.703.0.90.21686933, VMW_bootbank_nvme-pcie_1.2.3.16-3vmw.703.0.105.22348816, VMW_bootbank_nvmerdma_1.0.3.5-1vmw.703.0.20.19193900, VMW_bootbank_nvmetcp_1.0.0.3-1vmw.703.0.125.23794027, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.703.0.20.19193900, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.703.0.20.19193900, VMW_bootbank_pvscsi_0.1-4vmw.703.0.20.19193900, VMW_bootbank_qcnic_1.0.15.0-14vmw.703.0.20.19193900, VMW_bootbank_qedentv_3.40.5.53-22vmw.703.0.20.19193900, VMW_bootbank_qedrntv_3.40.5.53-18vmw.703.0.20.19193900, VMW_bootbank_qfle3_1.0.67.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3f_1.0.51.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3i_1.0.15.0-15vmw.703.0.20.19193900, VMW_bootbank_qflge_1.1.0.11-1vmw.703.0.20.19193900, VMW_bootbank_rste_2.0.2.0088-7vmw.703.0.20.19193900, VMW_bootbank_sfvmk_2.4.0.2010-6vmw.703.0.20.19193900, VMW_bootbank_smartpqi_70.4149.0.5000-1vmw.703.0.20.19193900, VMW_bootbank_vmkata_0.1-1vmw.703.0.20.19193900, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.703.0.20.19193900, VMW_bootbank_vmkusb_0.1-8vmw.703.0.85.21424296, VMW_bootbank_vmw-ahci_2.0.11-3vmw.703.0.125.23794027, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.703.0.20.19193900, VMware_bootbank_esx-ui_2.13.2-22721163, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.703.0.20.19193900, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.7.2173-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-12vmw.703.0.50.20036589, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-9vmw.703.0.105.22348816, VMware_bootbank_qlnativefc_4.1.14.0-26vmw.703.0.20.19193900, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.44-1vmw.703.0.20.19193900, VMware_locker_tools-light_12.3.5.22544099-23794019

Étape 5. Une fois la mise à niveau terminée, redémarrez l’hôte ESXi.

Étape 6. Accédez à l’hôte via SSH et vérifiez la version à l’aide de la commande suivante : vmware -v

[root@Monterrey-server-1:~] vmware -v

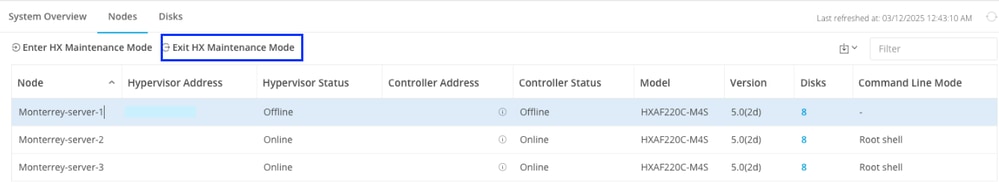

VMware ESXi 7.0.3 build-24585291Étape 7. Quittez le noeud du mode maintenance et attendez que le cluster soit sain.

Ouvrez le HX-Connect, choisissez System Information> Nodes, choisissez le noeud en mode maintenance et cliquez sur Exit HX Maintenance Mode

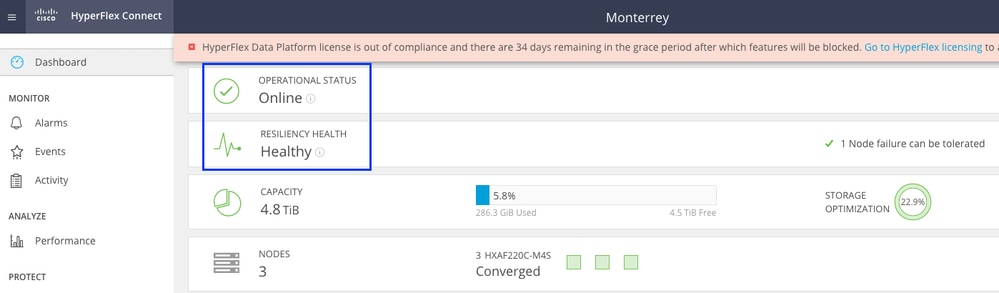

Attendez quelques minutes que le cluster Hyperflex termine la réparation. Le tableau de bord HX Connect vous indique l'état opérationnel, il doit être en ligne, et l'état de résilience doit indiquer Sain.

Assurez-vous également que le serveur peut voir tous les data stores à partir de VCenter.

Répétez les étapes sur tous les noeuds qui font partie du cluster, un par un.

Mise à niveau via HX Connect UI

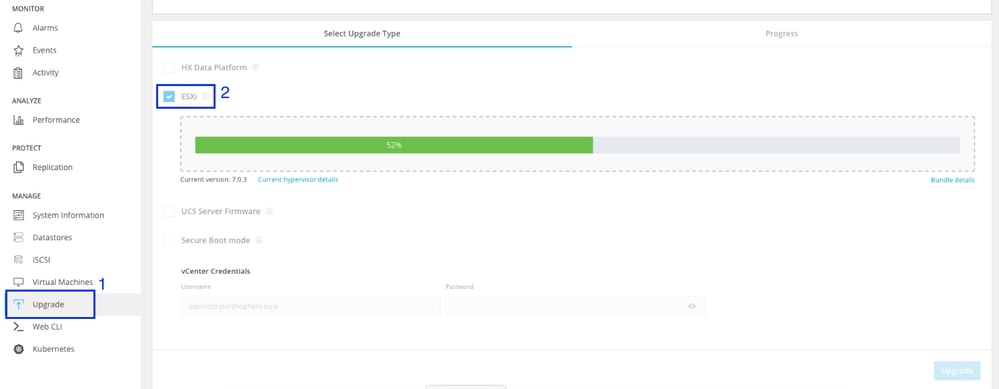

Accédez à l'onglet Upgrade, sélectionnez ESXI upgrade type et téléchargez le fichier de mise à niveau ESXI.

Remarque : Si votre cluster est sur HX version 5.5 ou 6.0, vous devez effectuer une mise à niveau combinée en sélectionnant HX Data Platform et en téléchargeant le bundle HX de votre version actuelle

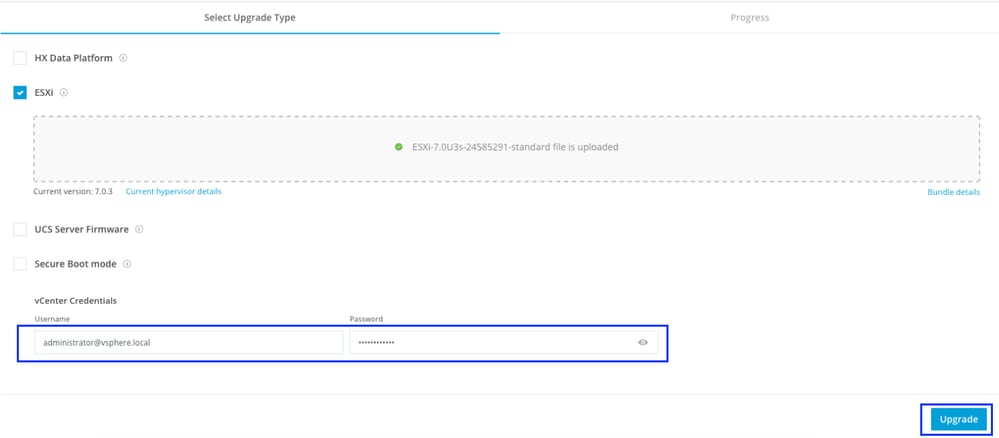

Une fois le fichier téléchargé, entrez les informations d'identification vCenter et cliquez sur Mettre à niveau.

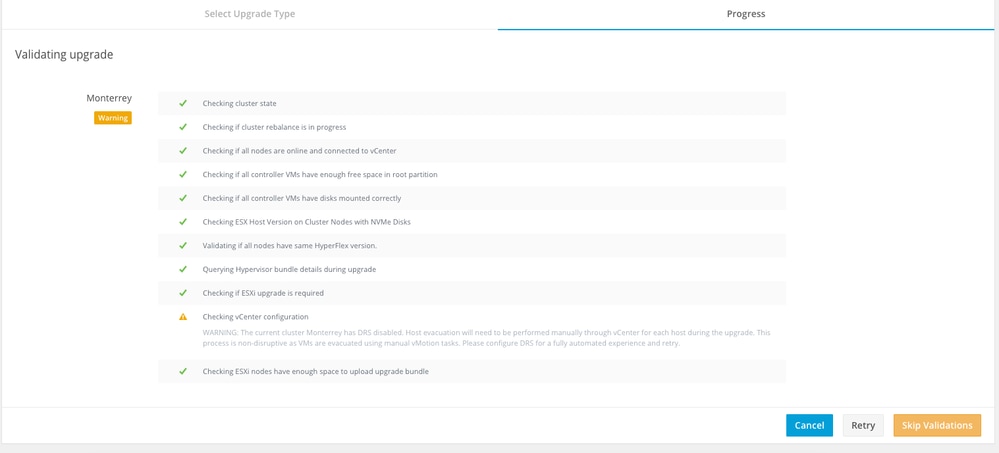

La première étape consiste à valider la mise à niveau. Si Distributed Resource Scheduler (DRS) est activé, les machines virtuelles sont automatiquement transférées vers d'autres hôtes.

Cliquez sur Ignorer les validations et la mise à niveau démarre automatiquement.

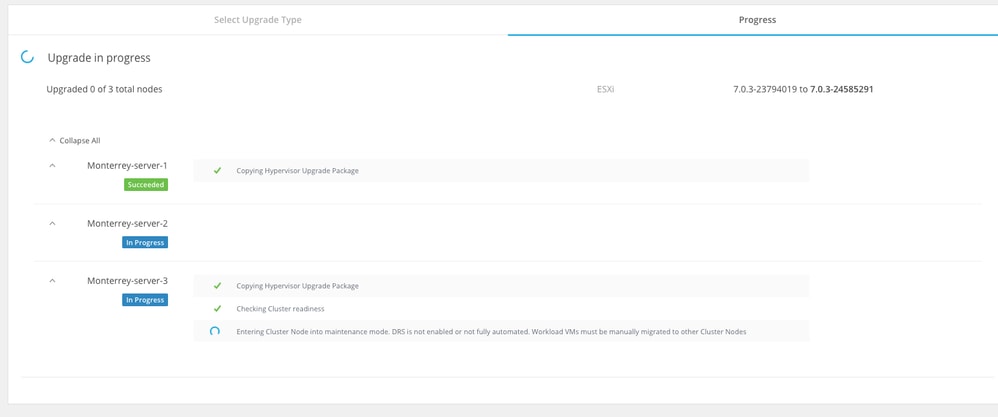

Surveillez le processus de mise à niveau.

Remarque : Si DRS est désactivé, vMotion active manuellement les machines virtuelles pour poursuivre le processus de mise à niveau.

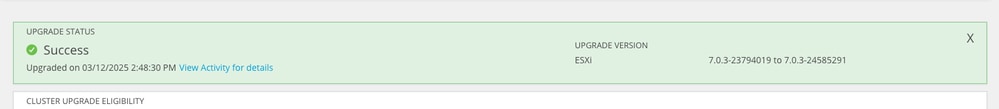

Attendez la fin de la mise à niveau sur tous les noeuds du cluster.

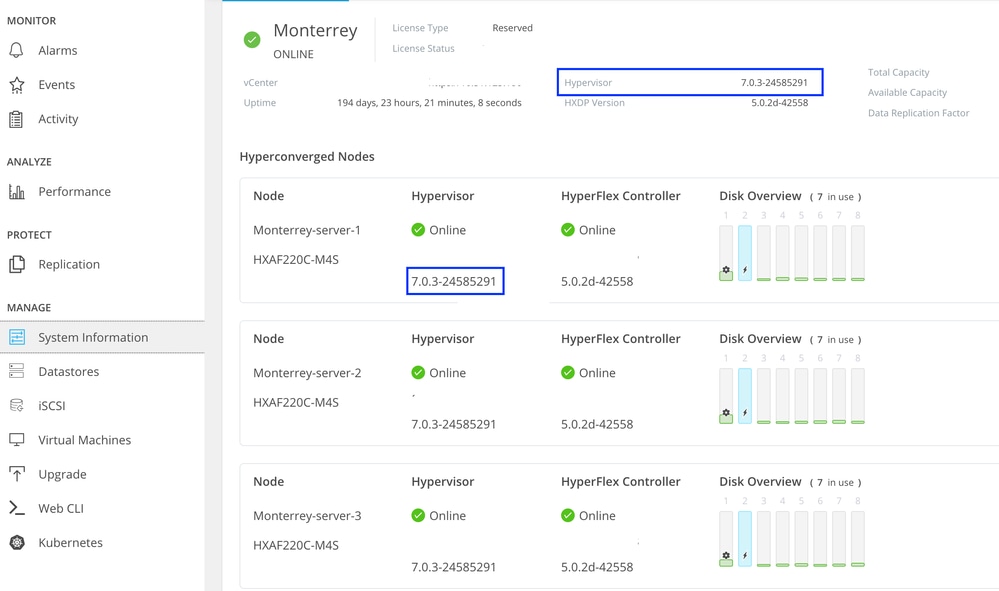

Vérifier

Vous pouvez vérifier la version installée d'ESXI à partir de HX Connect dans l'onglet System Information.

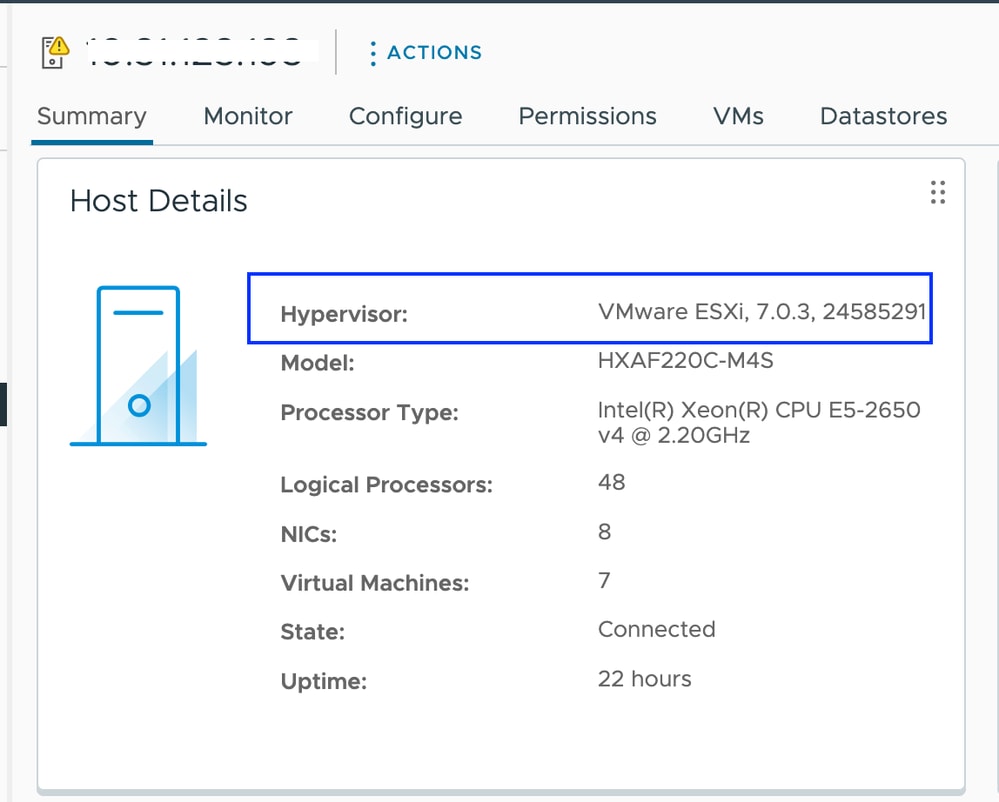

Depuis vCenter, vous pouvez voir la version ESXI sur le Résumé du serveur.

Comme l'image ESXI n'est pas personnalisée, vous devez confirmer que les VIB Hyperflex sont toujours intacts sur les serveurs.

Une fois le patch terminé et avant de commencer par le noeud suivant, établissez une connexion SSH avec chaque hôte ESXI et vérifiez les VIB Hyperflex à l'aide de la commande suivante : esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

Remarque : Dans les versions ESXi 7.0 U3, vmware-esx-STFSNasPlugin est devenu CIS-ESX-STFSNasPlugin

Dans les versions ESXi 8.0 U1, stHypervisorSvc est devenu sthypervisorsvc.

[root@Monterrey-server-1:~] esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

CIS-ESX-STFSNasPlugin 4.5.1-11 CIS VMwareAccepted 2023-10-25

scvmclient 5.5.1-38 CIS VMwareAccepted 2023-11-25

stHypervisorSvc 4.5.1-11 CIS VMwareAccepted 2023-10-24

Mise en garde : Dans certains scénarios, l'image non personnalisée peut écraser les VIB nenic et nfnic avec une version différente de celles de l'image personnalisée. Vous devez valider que nous avons les versions correctes après le correctif.

Une fois le patch terminé et avant de commencer par le noeud suivant, établissez une connexion SSH avec chaque hôte ESXI et vérifiez les VIB Hyperflex à l'aide de la commande suivante : esxcli software vib list | egrep -i 'nenic|nfnic'

[root@Monterrey-server-3:~] esxcli software vib list | egrep -i 'nenic|nfnic'

nfnic 5.0.0.43-1OEM.700.1.0.15843807 CIS VMwareCertified 2025-02-23

nenic-ens 1.0.6.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2023-10-25

nenic 2.0.10.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2024-03-17

Dépannage

Si nenic ou nfnic a été écrasé avec une version différente, vous pouvez installer les corrects en téléchargeant une image zip personnalisée ESXI de votre version à partir de software.cisco.com. Décompressez l'image a et du répertoire vib pour rechercher les répertoires nenic et nfnic. Extrayez le fichier vib et téléchargez-le via vCenter vers un data store monté sur les serveurs. Assurez-vous que le cluster est en ligne et sain.

Étape 1. Dans HX Connect, accédez à System Information > Nodes, sélectionnez l’un des hôtes et cliquez sur Enter HX Maintenance Mode.

Une fois que l’hôte est en mode maintenance, passez aux étapes suivantes.

Envoyez SSH à l'hôte ESXI en mode maintenance et naviguez jusqu'au dossier du data store où le fichier VIB ESXI est copié. Dans ce scénario, le fichier est disponible dans le datastore de mise à niveau

[root@Monterrey-server-3:~] cd /vmfs/volumes/Upgrade

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] ls

CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib

Exécutez cette commande afin de mettre à niveau le vib : esxcli software vib update -v "/complete/path/vib-file.vib" -f

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] esxcli software vib update -v "/vmfs/volumes/Upgrade/CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib" -f

Installation Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807

VIBs Removed: Cisco_bootbank_nenic_1.0.45.0-1OEM.700.1.0.15843807

VIBs Skipped:

Une fois la mise à jour de l'interface virtuelle terminée, redémarrez l'hôte ESXi.

SSH dans l'hôte et vérifiez que le vib a été mis à jour avec la commande : esxcli software vib list | egrep -i 'nenic|nfnic'

Quittez le noeud du mode maintenance et attendez que le cluster soit sain.

Ouvrez le HX-Connect, choisissez System Information> Nodes, choisissez le noeud en mode maintenance et cliquez sur Exit HX Maintenance Mode

Si votre serveur démarre à partir d'une carte SD, vous pouvez rencontrer un problème connu lors de l'application du correctif. "Impossible de corriger l'hôte en raison d'une erreur pendant l'attente du processus untar" Ce problème se produit lorsque le fonctionnement untar de VIB individuels prend plus de 30 secondes que le délai d'attente par défaut au cours du processus de résolution. Pour les environnements utilisant une carte SD comme partition OSData, il y a des chances que le processus untar des outils VMware prenne une durée légèrement plus élevée. Vous pouvez consulter cet article pour le résoudre.

Historique de révision

| Révision | Date de publication | Commentaires |

|---|---|---|

1.0 |

14-Mar-2025

|

Première publication |

Contribution d’experts de Cisco

- Alejandra Ortiz RegaladoIngénieur-conseil technique

Contacter Cisco

- Ouvrir un dossier d’assistance

- (Un contrat de service de Cisco est requis)

Commentaires

Commentaires