Configuration de la couche 2 disjointe dans les clusters Hyperflex

Options de téléchargement

-

ePub (1.3 MB)

Consulter à l’aide de différentes applications sur iPhone, iPad, Android ou Windows Phone -

Mobi (Kindle) (1.0 MB)

Consulter sur un appareil Kindle ou à l’aide d’une application Kindle sur plusieurs appareils

Langage exempt de préjugés

Dans le cadre de la documentation associée à ce produit, nous nous efforçons d’utiliser un langage exempt de préjugés. Dans cet ensemble de documents, le langage exempt de discrimination renvoie à une langue qui exclut la discrimination en fonction de l’âge, des handicaps, du genre, de l’appartenance raciale de l’identité ethnique, de l’orientation sexuelle, de la situation socio-économique et de l’intersectionnalité. Des exceptions peuvent s’appliquer dans les documents si le langage est codé en dur dans les interfaces utilisateurs du produit logiciel, si le langage utilisé est basé sur la documentation RFP ou si le langage utilisé provient d’un produit tiers référencé. Découvrez comment Cisco utilise le langage inclusif.

À propos de cette traduction

Cisco a traduit ce document en traduction automatisée vérifiée par une personne dans le cadre d’un service mondial permettant à nos utilisateurs d’obtenir le contenu d’assistance dans leur propre langue. Il convient cependant de noter que même la meilleure traduction automatisée ne sera pas aussi précise que celle fournie par un traducteur professionnel.

Table des matières

Introduction

Ce document décrit comment mettre en oeuvre une configuration de couche 2 disjointe (DL2) sur un cluster HX du point de vue d'UCS Manager (UCSM) et d'ESXi.

Conditions préalables

Exigences

Cisco vous recommande de prendre connaissance des rubriques suivantes :

- Compréhension de base de la configuration DL2

- Connaissances de base d'Hyperflex Cluster

- Connaissances UCSM recommandées sur les cartes réseau virtuelles, les profils de service et les modèles

Les autres exigences sont les suivantes :

- Au moins une liaison disponible sur chaque interconnexion de fabric et deux liaisons disponibles sur votre commutateur en amont.

- Les liaisons entre les interconnexions de fabric et le commutateur en amont doivent être actives, elles doivent être configurées en tant que liaisons ascendantes. Si ce n'est pas le cas, vérifiez cette Configuration du système - Configuration des ports pour les configurer sur UCSM.

- Les VLAN à utiliser doivent déjà être créés sur UCSM. Si ce n'est pas le cas, procédez comme suit : Network Configuration - Configuring Named VLAN.

- Les VLAN à utiliser doivent déjà être créés sur le commutateur en amont.

- Les VLAN à utiliser ne peuvent pas exister sur une autre carte réseau virtuelle (vNIC) des profils de service.

Composants utilisés

Ce document n'est pas limité à des versions de matériel et de logiciel spécifiques.

- 2 UCS-FI-6248UP

- 2 N5K-C5548UP

- UCSM version 4.2(1f)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

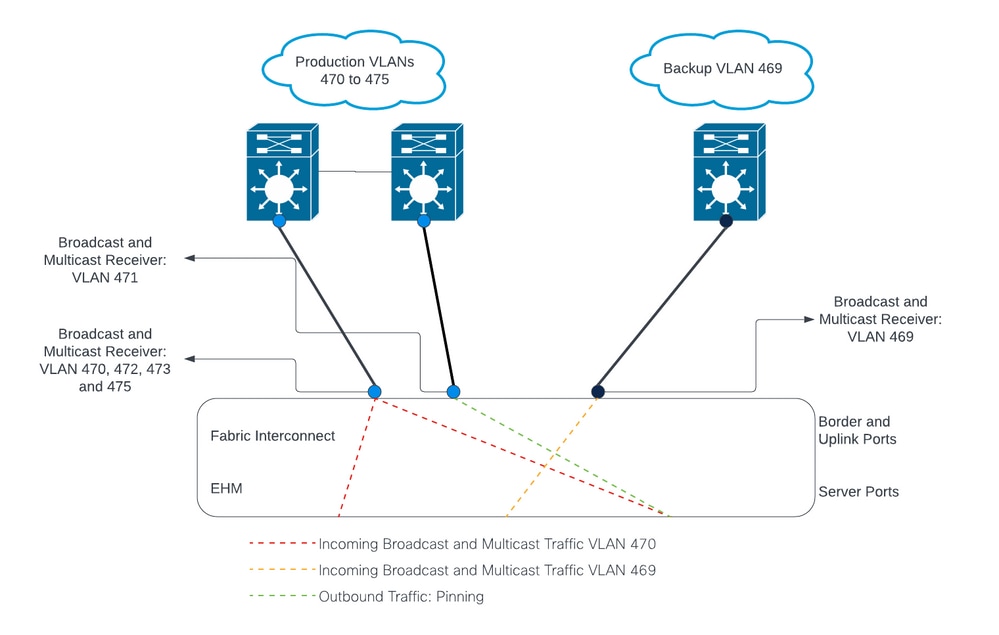

Diagramme du réseau

Configurations

Les configurations DL2 sont utilisées pour séparer le trafic sur des liaisons ascendantes spécifiques vers les périphériques en amont, de sorte que le trafic VLAN ne se mélange pas.

Configurer les nouvelles vNIC

Étape 1. Connectez-vous à UCSM et cliquez sur l'onglet LAN sur le panneau de gauche.

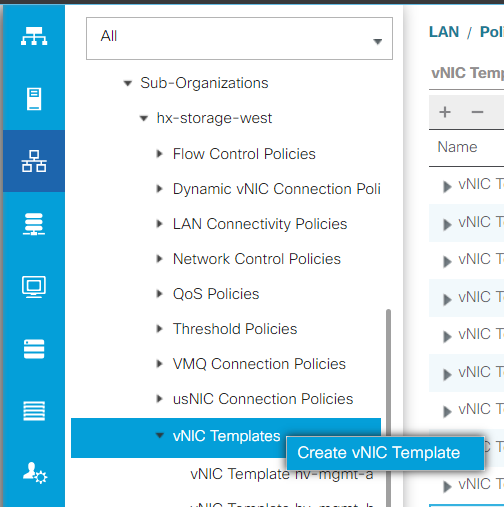

Accédez à Politiques > racine > Sous-organisations > Nom de la sous-organisation > Modèles de vNIC. Cliquez avec le bouton droit dessus et cliquez sur Créer un modèle vNIC.

Étape 2. Attribuez un nom au modèle, laissez Fabric A sélectionné, faites défiler la liste vers le bas et sélectionnez les VLAN appropriés pour la nouvelle liaison. Les autres paramètres peuvent être configurés comme vous le souhaitez.

Répétez ensuite le même processus, mais sélectionnez Fabric B cette fois-ci.

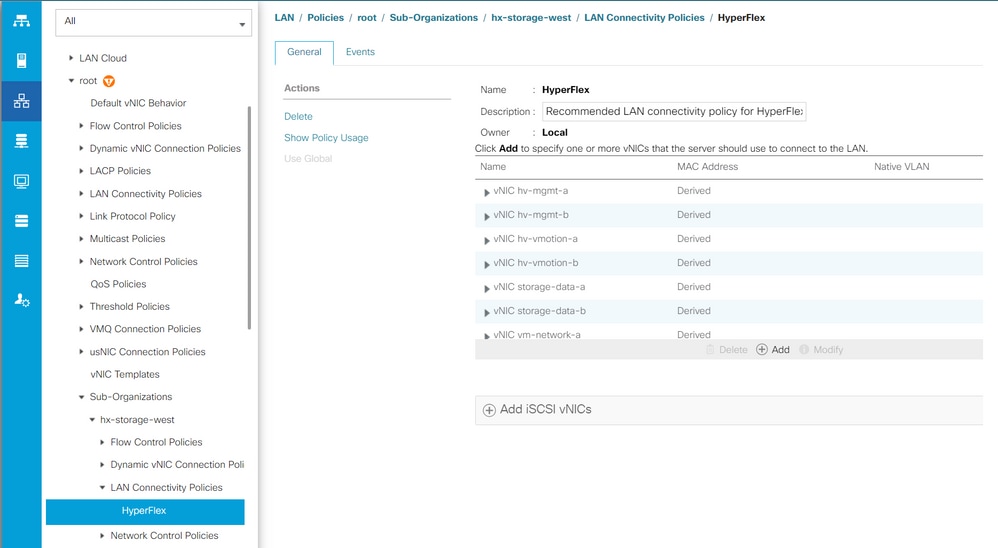

Étape 3. Dans l'onglet LAN, accédez à Politiques > racine > Sous-organisations > Nom de la sous-organisation > Politiques de connectivité LAN > Hyperflex.

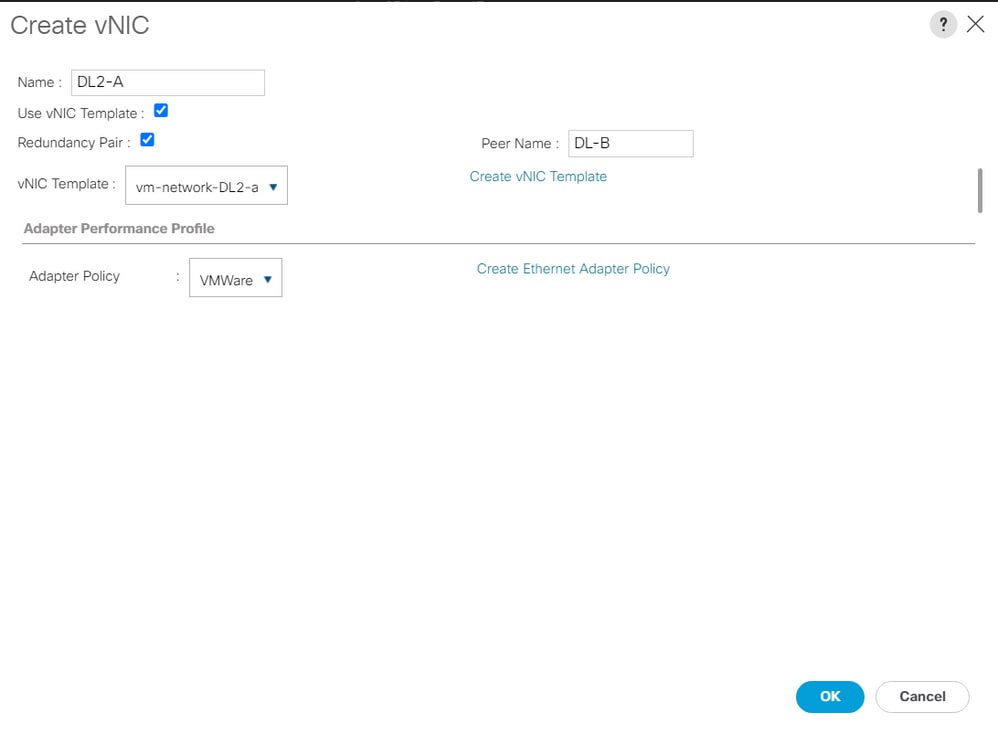

Étape 4. Cliquez sur Add, nommez la vNIC et sélectionnez un pool MAC dans le menu déroulant.

Cochez les cases Use vNIC Template et Redundancy Pair. Dans la liste déroulante Modèle vNIC, sélectionnez le nouveau modèle et, en regard, saisissez le Nom du pair.

Sélectionnez la politique d'adaptateur souhaitée et cliquez sur OK.

Étape 5. Dans la liste vNIC, recherchez l'homologue de celui que vous venez de créer, sélectionnez-le, puis cliquez sur Modifier.

Cliquez sur la zone Use vNIC Template et sélectionnez l'autre modèle qui a été créé dans la liste déroulante.

Cliquez sur Save Changes en bas, cela déclenche les Activités en attente pour les serveurs associés.

Accuser réception des activités en attente

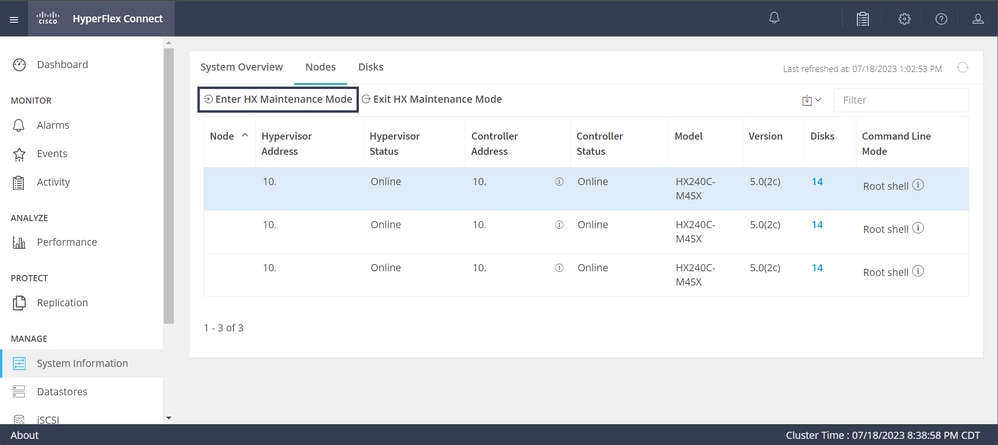

Étape 1. Connectez-vous à HX Connect, accédez à System Information > Nodes, cliquez sur l'un des noeuds, puis cliquez sur Enter HX Maintenance Mode, puis attendez la fin de la tâche.

Étape 2. À partir de vCenter, assurez-vous que le noeud est en maintenance.

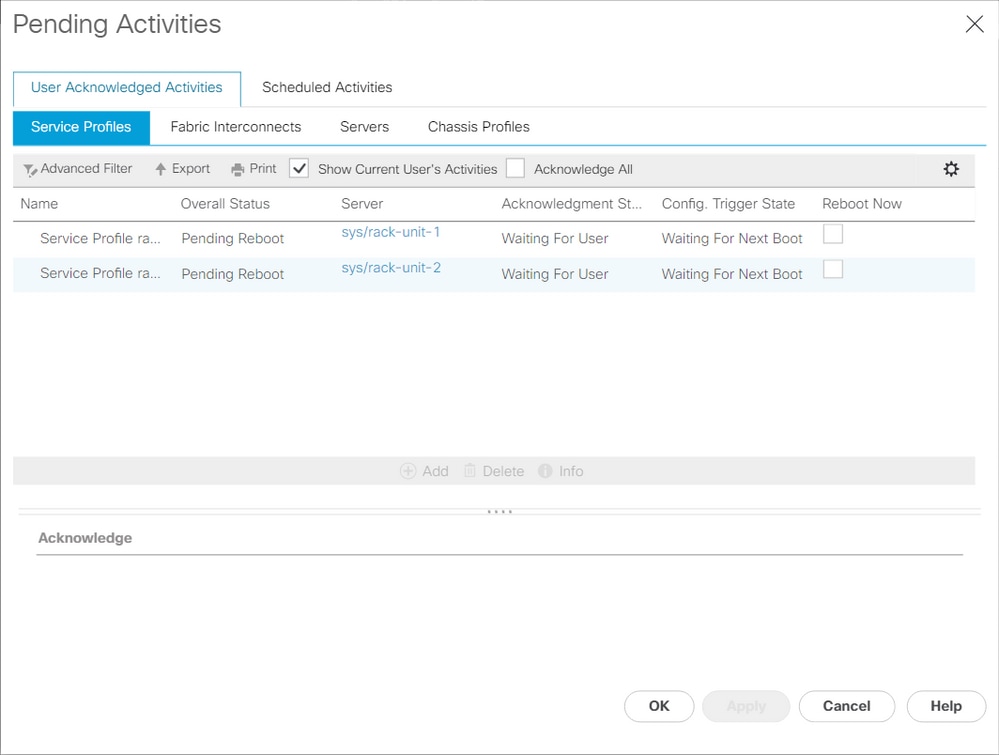

Étape 3. Une fois que le noeud est en maintenance, revenez à UCSM, cliquez sur l'icône en forme de cloche dans le coin supérieur droit et sous Reboot Now.

Cochez la case correspondant au serveur actuellement en maintenance, puis cliquez sur OK.

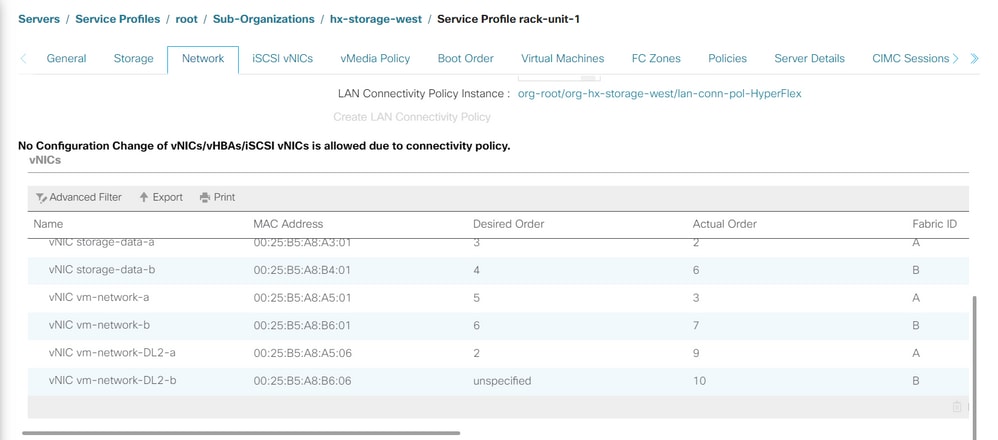

Étape 4. Une fois le serveur démarré, assurez-vous que les nouvelles vNIC sont présentes en naviguant vers Servers > Service Profiles > root > Sub-Organizations > Sub-organization name > Service Profile name.

Cliquez sur Network, faites défiler vers le bas et les nouvelles vNIC doivent y être.

Étape 5. Sortez le serveur du mode de maintenance à partir de l'interface utilisateur de HX Connect.

Cliquez sur Quitter le mode de maintenance HX.

Lorsque le serveur n'est plus en maintenance, la machine virtuelle du contrôleur de stockage (SCVM) démarre et le cluster lance le processus de réparation.

Afin de surveiller le processus de guérison, SSH dans l'IP Hyperflex (HX) Cluster Manager et exécutez la commande :

sysmtool --ns cluster --cmd healthdetailCluster Health Detail:

---------------------:

State: ONLINE

HealthState: HEALTHY

Policy Compliance: COMPLIANT

Creation Time: Tue May 30 04:48:45 2023

Uptime: 7 weeks, 1 days, 15 hours, 50 mins, 17 secs

Cluster Resiliency Detail:

-------------------------:

Health State Reason: Storage cluster is healthy.

# of nodes failure tolerable for cluster to be fully available: 1

# of node failures before cluster goes into readonly: NA

# of node failures before cluster goes to be crticial and partially available: 3

# of node failures before cluster goes to enospace warn trying to move the existing data: NA

# of persistent devices failures tolerable for cluster to be fully available: 2

# of persistent devices failures before cluster goes into readonly: NA

# of persistent devices failures before cluster goes to be critical and partially available: 3

# of caching devices failures tolerable for cluster to be fully available: 2

# of caching failures before cluster goes into readonly: NA

# of caching failures before cluster goes to be critical and partially available: 3

Current ensemble size: 3

Minimum data copies available for some user data: 3

Minimum cache copies remaining: 3

Minimum metadata copies available for cluster metadata: 3

Current healing status:

Time remaining before current healing operation finishes:

# of unavailable nodes: 0Étape 6. Une fois que le cluster est sain, répétez les étapes 1 à 6. Ne passez PAS à l'étape suivante tant que tous les serveurs ne disposent pas des nouvelles cartes réseau virtuelles.

Configuration des VLAN

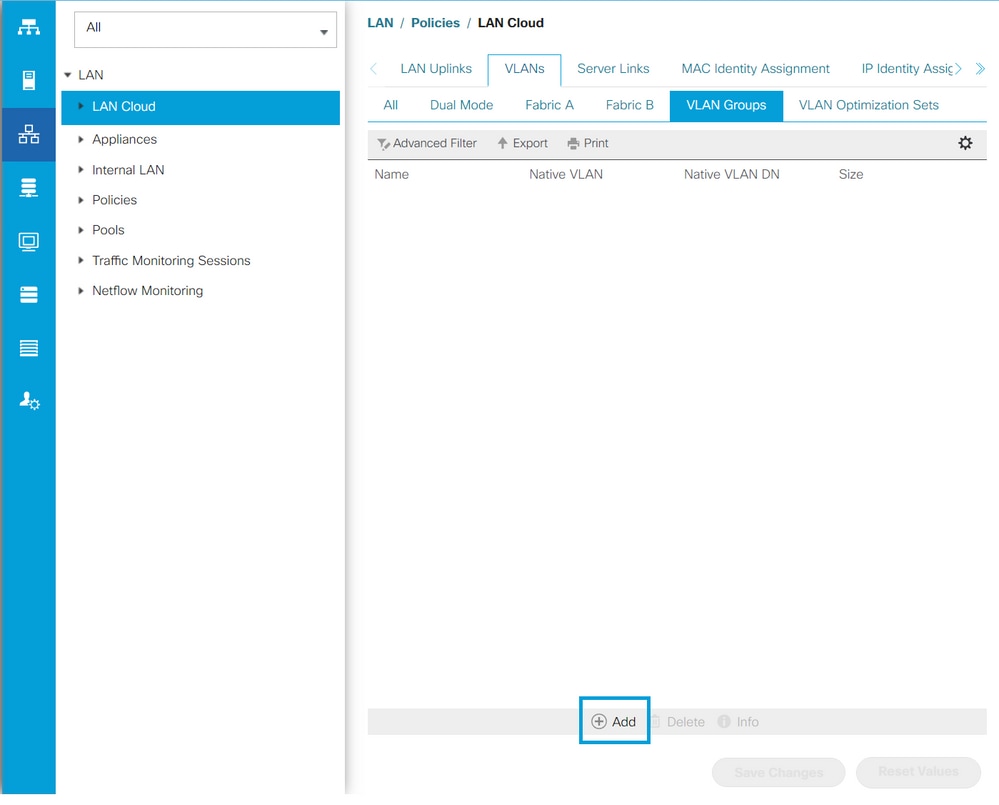

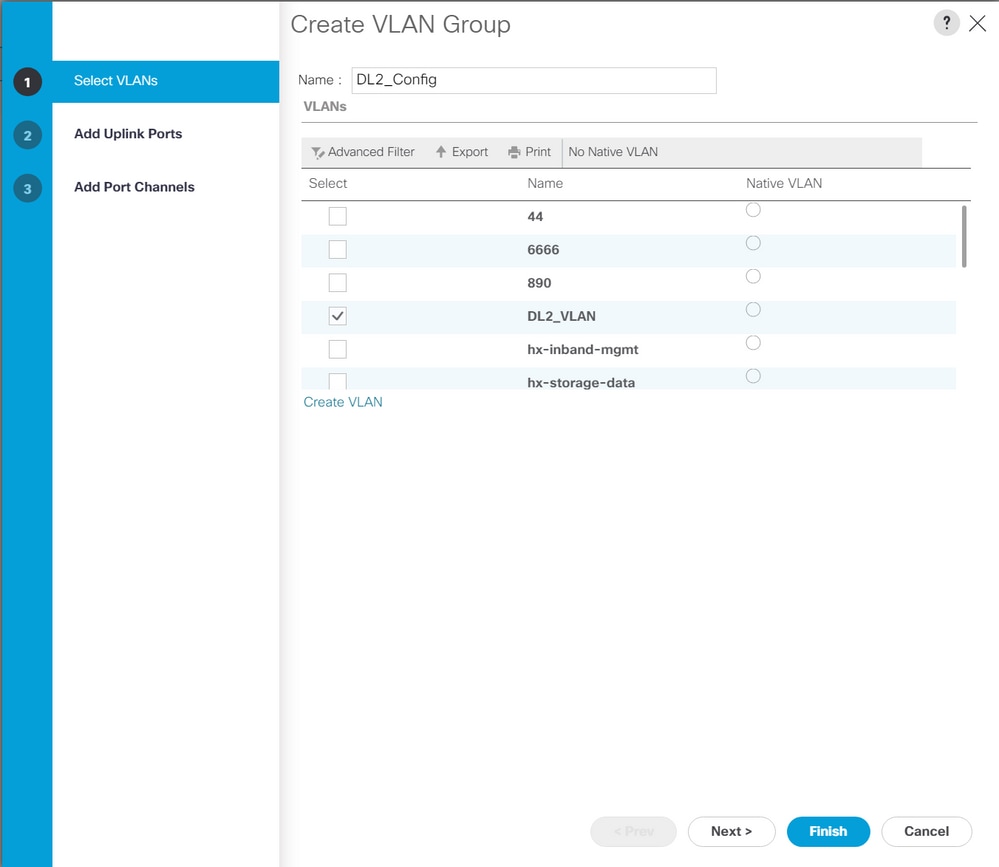

Étape 1. Dans UCSM, accédez à LAN > VLANs > VLAN Groups et cliquez sur Add.

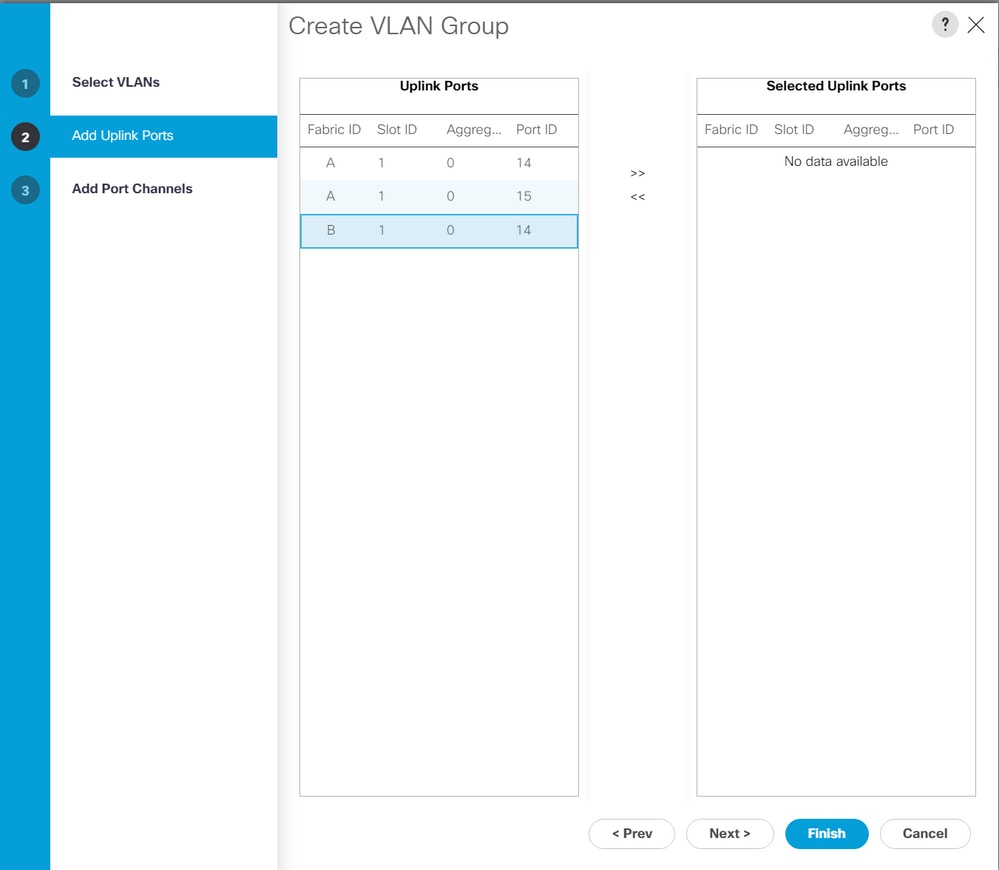

Étape 2. Nommez le groupe VLAN et sélectionnez les VLAN appropriés ci-dessous, cliquez sur Next, et passez à l'étape 2 de l'assistant pour ajouter des ports de liaisons ascendantes uniques ou à l'étape 3 pour ajouter des canaux de port.

Étape 3. Ajoutez le port de liaison ascendante ou le canal de port en cliquant dessus, puis sur l'icône >>. Cliquez sur Terminer en bas.

Configuration ESXi

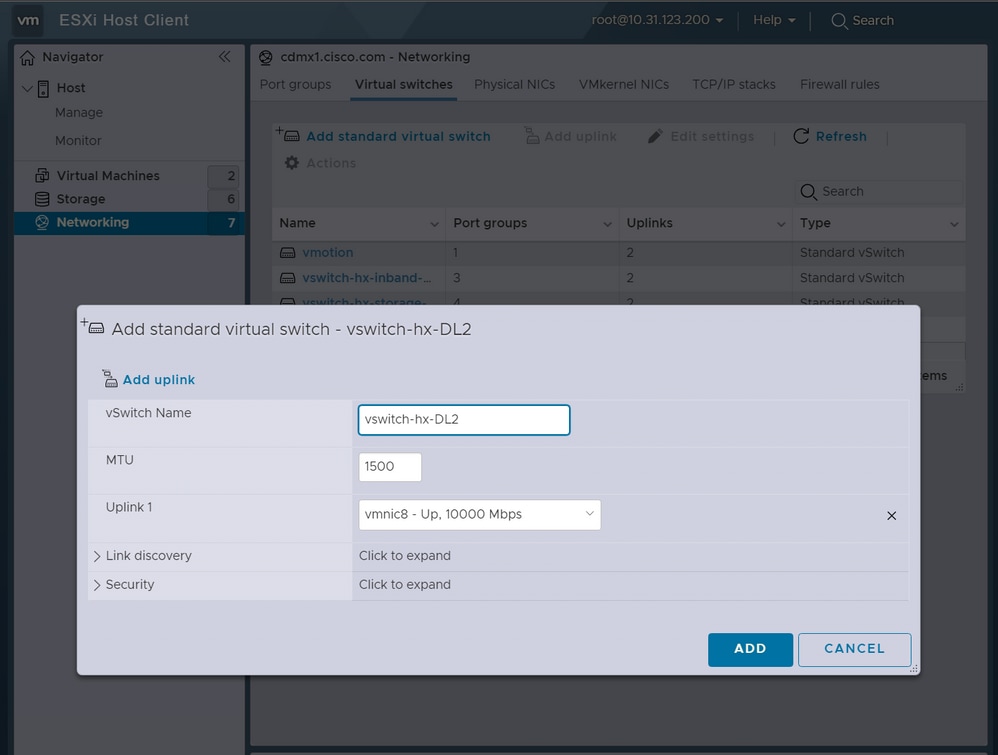

Étape 1. Connectez-vous à vSphere de l'hôte ESXi, accédez à Networking > Virtual Switches, et cliquez sur Ajoutez un commutateur virtuel standard.

Étape 2. Nommez le commutateur virtuel et l'un des nouveaux vmnics est déjà là, cliquez sur Add uplink pour ajouter le 2nd. Cliquez sur Add.

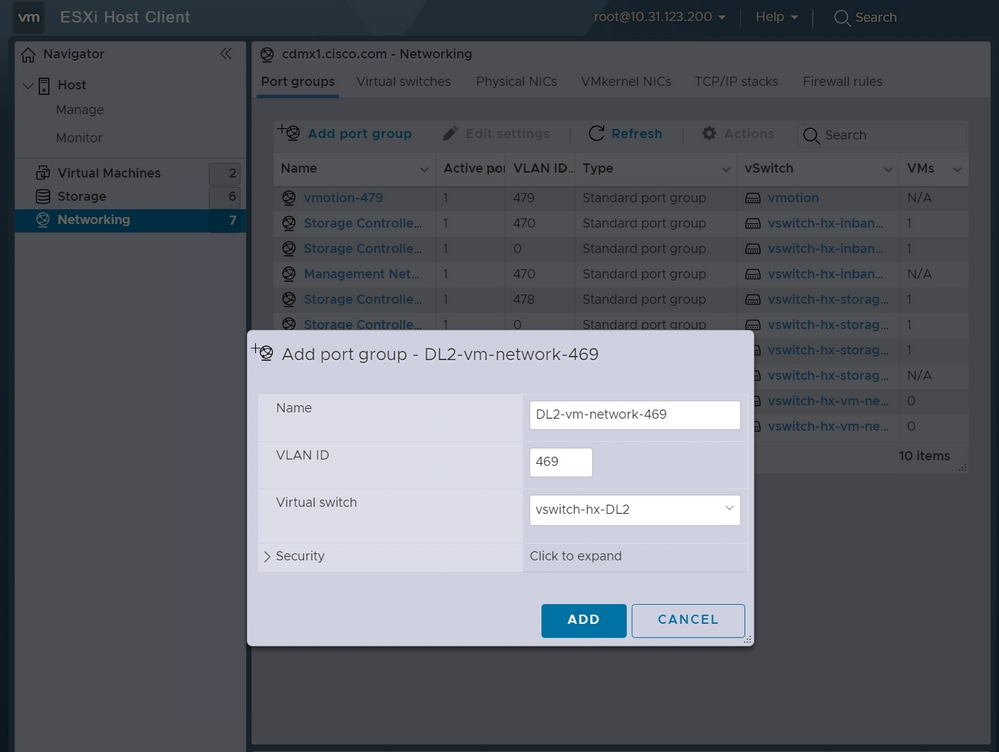

Étape 3. Accédez à Networking > Port groups et cliquez sur Add port group

Étape 4. Attribuez un nom au groupe de ports, entrez le VLAN souhaité et sélectionnez le nouveau commutateur virtuel dans la liste déroulante.

Étape 5. Répétez l’étape 4 pour chaque VLAN traversant les nouvelles liaisons.

Étape 6. Répétez les étapes 1 à 5 pour chaque serveur faisant partie du cluster.

Vérifier

Vérification UCSM

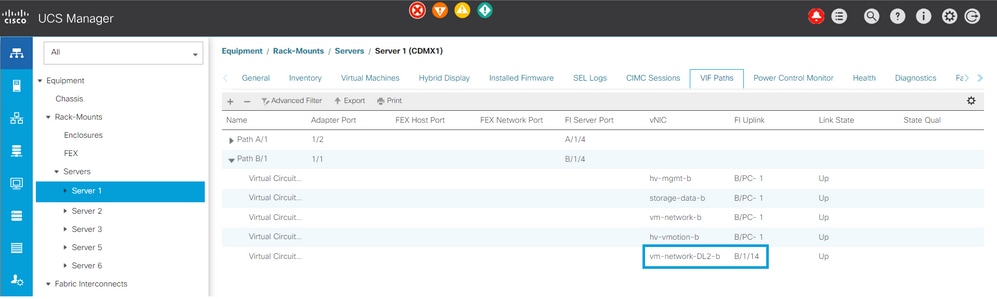

Accédez à Equipment > Rack-Mounts > Servers > Server # > VIF Paths et développez Path A ou B, sous la colonne vNIC, recherchez celui qui correspond à la vNIC DL2 et ce circuit virtuel doit être épinglé à la liaison ascendante ou au canal de port Fabric Interconnect (FI) qui a été récemment configuré.

Vérification CLI

Chemin de l'interface virtuelle (VIF)

Sur une session SSH vers les Fabric Interconnects, exécutez la commande suivante :

show service-profile circuit server <server-number>

Cette commande affiche les chemins VIF, les vNIC correspondantes et l'interface à laquelle ils sont épinglés.

Fabric ID: A

Path ID: 1

VIF vNIC Link State Oper State Prot State Prot Role Admin Pin Oper Pin Transport

---------- --------------- ----------- ---------- ------------- ----------- ---------- ---------- ---------

966 hv-mgmt-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

967 storage-data-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

968 vm-network-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

969 hv-vmotion-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

990 network-DL2-a Up Active No Protection Unprotected 0/0/0 1/0/14 Ether

La colonne Oper Pin doit afficher la liaison montante FI ou le canal de port récemment configuré sous la même ligne que la vNIC DL2.

Sur cette sortie, le VIF 990, qui correspond à la vNIC vm-network-DL2-b, est épinglé à l'interface 1/0/14.

Épinglage dans les liaisons ascendantes

Fabric-Interconnect-A# connect nx-os a

Fabric-Interconnect-A(nxos)# show pinning border-interfaces

--------------------+---------+----------------------------------------

Border Interface Status SIFs

--------------------+---------+----------------------------------------

Eth1/14 Active sup-eth2 Veth990 Veth992 Veth994Sur cette sortie, le numéro Veth doit correspondre au numéro VIF vu sur la sortie précédente et être sur la même ligne que l'interface de liaison ascendante correcte.

Destinataire désigné :

Fabric-Interconnect-A# connect nx-os a

Fabric-Interconnect-A(nxos)# show platform software enm internal info vlandb id <VLAN-ID>

vlan_id 469

-------------

Designated receiver: Eth1/14

Membership:

Eth1/14

Sur cette sortie, la liaison ascendante correcte doit être affichée.

Commutateurs en amont

Sur une session SSH vers les commutateurs en amont, la table d'adresses MAC peut être vérifiée et l'adresse MAC de n'importe quelle machine virtuelle (VM) sur ce VLAN doit être affichée.

Nexus-5K# show mac address-table vlan 469

Legend:

* - primary entry, G - Gateway MAC, (R) - Routed MAC, O - Overlay MAC

age - seconds since last seen,+ - primary entry using vPC Peer-Link

VLAN MAC Address Type age Secure NTFY Ports/SWID.SSID.LID

---------+-----------------+--------+---------+------+----+------------------

* 469 0000.0c07.ac45 static 0 F F Router

* 469 002a.6a58.e3bc static 0 F F Po1

* 469 0050.569b.048c dynamic 50 F F Eth1/14

* 469 547f.ee6a.8041 static 0 F F Router

Dans cet exemple de configuration, VLAN 469 est le VLAN disjoint, l'adresse MAC 0050:569B:048C appartient à une machine virtuelle Linux attribuée au commutateur virtuel vswitch-hx-DL2 et au groupe de ports DL2-vm-network-469, il est correctement affiché sur l'interface Ethernet 1/14, qui est l'interface du commutateur en amont connecté à l'interconnexion de fabric.

De la même session au commutateur en amont, la configuration VLAN peut être vérifiée.

Nexus-5K# show vlan brief

VLAN Name Status Ports

---- -------------------------------- --------- -------------------------------

1 default active Eth1/5, Eth1/8, Eth1/9, Eth1/10

Eth1/11, Eth1/12, Eth1/13

Eth1/15, Eth1/16, Eth1/17

Eth1/19, Eth1/20, Eth1/21

Eth1/22, Eth1/23, Eth1/24

Eth1/25, Eth1/26

469 DMZ active Po1, Eth1/14, Eth1/31, Eth1/32

Sur cette sortie, l'interface Ethernet 1/14 est correctement attribuée au VLAN 469.

Dépannage

Erreurs de configuration UCSM

Erreur : "Impossible de trouver un port de liaison ascendante opérationnel qui transporte tous les VLAN de la ou des vNIC. La ou les vNIC seront arrêtées, ce qui entraînera une interruption du trafic sur tous les VLAN existants sur la ou les vNIC. »

L'erreur signifie qu'il n'y a pas de nouvelles liaisons ascendantes pour transporter le nouveau trafic, ignorer les problèmes de couche 1 et de couche 2 sur les interfaces, et réessayer.

Erreur : "Echec de l'épinglage de la source ENM"

L'erreur est liée aux VLAN associés d'une vNIC introuvable sur une liaison ascendante.

Comportements incorrects possibles

Les liaisons ascendantes précédentes arrêtent le flux de données car les nouveaux VLAN existent déjà sur une vNIC et ils sont épinglés aux nouvelles liaisons ascendantes.

Supprimez tout VLAN en double sur le modèle de vNIC précédent. Accédez à Politiques > racine > Sous-organisations > Nom de la sous-organisation > Modèles de vNIC et supprimez le VLAN du modèle de vNIC vm-network.

Informations connexes

Historique de révision

| Révision | Date de publication | Commentaires |

|---|---|---|

1.0 |

25-Jul-2023

|

Première publication |

Contribution d’experts de Cisco

- Ignacio JimenezIngénieur TAC Cisco

- Sergio MoraIngénieur TAC Cisco

Contacter Cisco

- Ouvrir un dossier d’assistance

- (Un contrat de service de Cisco est requis)

Commentaires

Commentaires