Ersatz für OSPD-Server UCS 240M4 - vEPC

Download-Optionen

-

ePub (1.0 MB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einleitung

In diesem Dokument werden die Schritte beschrieben, die erforderlich sind, um einen fehlerhaften Server zu ersetzen, der den OpenStack Platform Director (OSPD) in einer Ultra-M-Konfiguration hostet.

Hintergrundinformationen

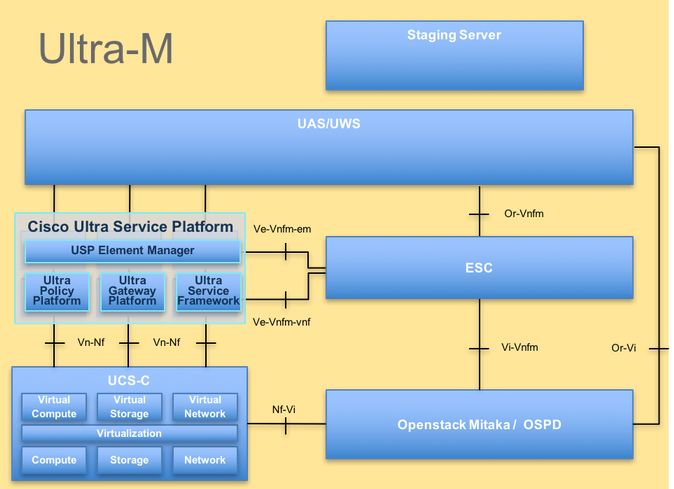

Ultra-M ist eine vorkonfigurierte und validierte virtualisierte Mobile Packet Core-Lösung, die die Bereitstellung von VNFs vereinfacht. OpenStack ist der Virtualized Infrastructure Manager (VIM) für Ultra-M und besteht aus den folgenden Knotentypen:

- Computing

- Objektspeicherplatte - Computing (OSD - Computing)

- Controller

- OSPD

Die High-Level-Architektur von Ultra-M und die beteiligten Komponenten sind in diesem Bild dargestellt:

UltraM-Architektur

UltraM-Architektur

Dieses Dokument richtet sich an Cisco Mitarbeiter, die mit der Cisco Ultra-M-Plattform vertraut sind. Es beschreibt die Schritte, die erforderlich sind, um auf OpenStack-Ebene zum Zeitpunkt des OSPD-Serveraustauschs durchgeführt zu werden.

Anmerkung: Die Ultra M 5.1.x-Version wird bei der Definition der in diesem Dokument beschriebenen Verfahren berücksichtigt.

Abkürzungen

| VNF | Virtuelle Netzwerkfunktion |

| KF | Kontrollfunktion |

| SF | Dienstfunktion |

| WSA | Elastischer Service-Controller |

| MOPP | Verfahrensweise |

| OSD | Objektspeicherplatten |

| Festplatte | Festplattenlaufwerk |

| SSD | Solid-State-Laufwerk |

| VIM | Manager für virtuelle Infrastruktur |

| VM | Virtuelles System |

| EM | Element-Manager |

| USA | Ultra-Automatisierungsservices |

| UUID | Universeller eindeutiger IDentifier |

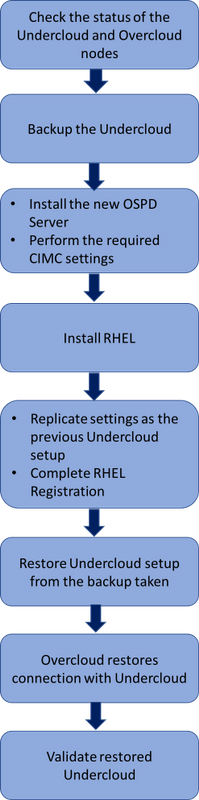

Workflow des MoP

High-Level-Workflow des Ersetzungsverfahrens

High-Level-Workflow des Ersetzungsverfahrens

Voraussetzungen

Statusüberprüfung

Bevor Sie einen OSPD-Server ersetzen, ist es wichtig, den aktuellen Zustand der Red Hat OpenStack Platform-Umgebung zu überprüfen und sicherzustellen, dass sie fehlerfrei ist, um Komplikationen zu vermeiden, wenn der Austauschprozess aktiviert ist.

Überprüfen Sie den Status des OpenStack-Stacks und der Knotenliste:

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack stack list --nested

[stack@director ~]$ ironic node-list

[stack@director ~]$ nova list

Stellen Sie sicher, dass alle Undercloud-Services über den OSP-D-Knoten geladen, aktiv und ausgeführt werden:

[stack@director ~]$ systemctl list-units "openstack*" "neutron*" "openvswitch*"

UNIT LOAD ACTIVE SUB DESCRIPTION

neutron-dhcp-agent.service loaded active running OpenStack Neutron DHCP Agent

neutron-openvswitch-agent.service loaded active running OpenStack Neutron Open vSwitch Agent

neutron-ovs-cleanup.service loaded active exited OpenStack Neutron Open vSwitch Cleanup Utility

neutron-server.service loaded active running OpenStack Neutron Server

openstack-aodh-evaluator.service loaded active running OpenStack Alarm evaluator service

openstack-aodh-listener.service loaded active running OpenStack Alarm listener service

openstack-aodh-notifier.service loaded active running OpenStack Alarm notifier service

openstack-ceilometer-central.service loaded active running OpenStack ceilometer central agent

openstack-ceilometer-collector.service loaded active running OpenStack ceilometer collection service

openstack-ceilometer-notification.service loaded active running OpenStack ceilometer notification agent

openstack-glance-api.service loaded active running OpenStack Image Service (code-named Glance) API server

openstack-glance-registry.service loaded active running OpenStack Image Service (code-named Glance) Registry server

openstack-heat-api-cfn.service loaded active running Openstack Heat CFN-compatible API Service

openstack-heat-api.service loaded active running OpenStack Heat API Service

openstack-heat-engine.service loaded active running Openstack Heat Engine Service

openstack-ironic-api.service loaded active running OpenStack Ironic API service

openstack-ironic-conductor.service loaded active running OpenStack Ironic Conductor service

openstack-ironic-inspector-dnsmasq.service loaded active running PXE boot dnsmasq service for Ironic Inspector

openstack-ironic-inspector.service loaded active running Hardware introspection service for OpenStack Ironic

openstack-mistral-api.service loaded active running Mistral API Server

openstack-mistral-engine.service loaded active running Mistral Engine Server

openstack-mistral-executor.service loaded active running Mistral Executor Server

openstack-nova-api.service loaded active running OpenStack Nova API Server

openstack-nova-cert.service loaded active running OpenStack Nova Cert Server

openstack-nova-compute.service loaded active running OpenStack Nova Compute Server

openstack-nova-conductor.service loaded active running OpenStack Nova Conductor Server

openstack-nova-scheduler.service loaded active running OpenStack Nova Scheduler Server

openstack-swift-account-reaper.service loaded active running OpenStack Object Storage (swift) - Account Reaper

openstack-swift-account.service loaded active running OpenStack Object Storage (swift) - Account Server

openstack-swift-container-updater.service loaded active running OpenStack Object Storage (swift) - Container Updater

openstack-swift-container.service loaded active running OpenStack Object Storage (swift) - Container Server

openstack-swift-object-updater.service loaded active running OpenStack Object Storage (swift) - Object Updater

openstack-swift-object.service loaded active running OpenStack Object Storage (swift) - Object Server

openstack-swift-proxy.service loaded active running OpenStack Object Storage (swift) - Proxy Server

openstack-zaqar.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server

openstack-zaqar@1.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server Instance 1

openvswitch.service loaded active exited Open vSwitch

LOAD = Reflects whether the unit definition was properly loaded.

ACTIVE = The high-level unit activation state, i.e. generalization of SUB.

SUB = The low-level unit activation state, values depend on unit type.

37 loaded units listed. Pass --all to see loaded but inactive units, too.

To show all installed unit files use 'systemctl list-unit-files'.

Backup

Stellen Sie sicher, dass ausreichend Speicherplatz zur Verfügung steht, bevor Sie den Sicherungsvorgang durchführen. Dieser Tarball wird voraussichtlich mindestens 3,5 GB groß sein.

[stack@director ~]$df -h

Führen Sie diesen Befehl als Root-Benutzer aus, um die Daten aus dem Untercloud-Knoten in einer Datei mit dem Namen undercloud-backup-[timestamp].tar.gz zu sichern.

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql

[root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack

tar: Removing leading `/' from member names

Neuen OSPD-Knoten installieren

Installation des UCS-Servers

Die Schritte zur Installation eines neuen UCS C240 M4 Servers sowie die ersten Einrichtungsschritte finden Sie im Cisco UCS C240 M4 Server Installation and Service Guide.

Melden Sie sich mit der CIMC-IP beim Server an.

Führen Sie ein BIOS-Upgrade durch, wenn die Firmware nicht der zuvor verwendeten empfohlenen Version entspricht. Die Schritte für das BIOS-Upgrade sind hier aufgeführt: Cisco UCS Rackmount-Server der C-Serie - BIOS-Upgrade-Leitfaden.

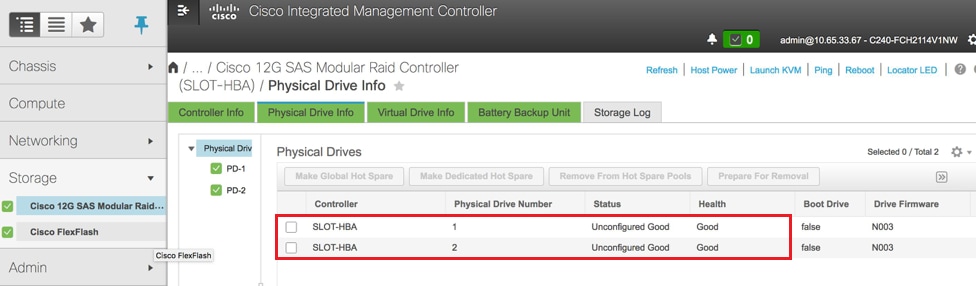

Überprüfen Sie den Status der physischen Laufwerke. Die Konfiguration muss zurückgesetzt sein Gut:

Navigieren Sie zu Storage > Cisco 12G SAS Modular Raid Controller (SLOT-HBA) > Physical Drive Info (Informationen zum physischen Laufwerk), wie im Bild gezeigt.

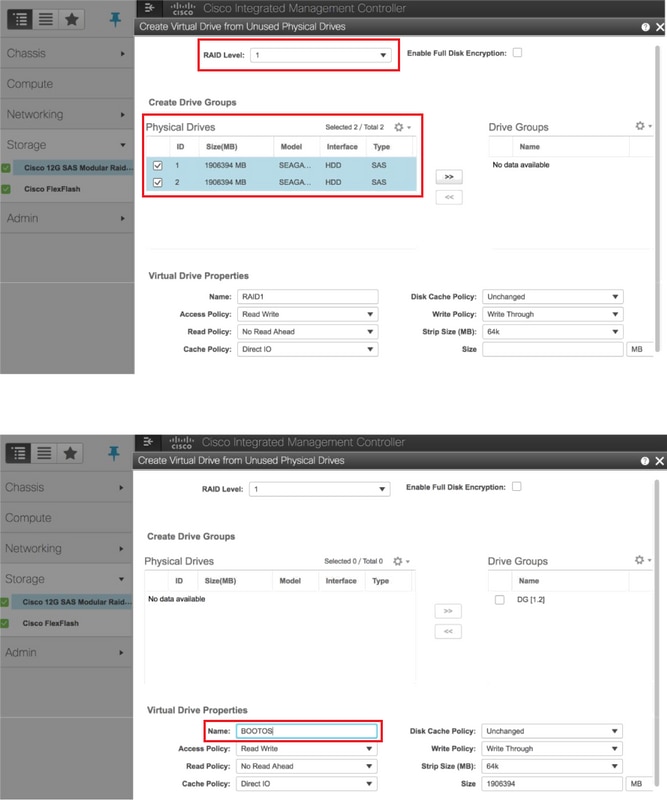

Erstellen Sie eine virtuelle Festplatte von physischen Festplatten mit RAID-Level 1:

Navigieren Sie zu Storage > Cisco 12G SAS Modular Raid Controller (SLOT-HBA) > Controller Info > Create Virtual Drive from Unused Physical Drives (Virtuelles Laufwerk aus nicht verwendeten physischen Laufwerken erstellen), wie im Bild dargestellt.

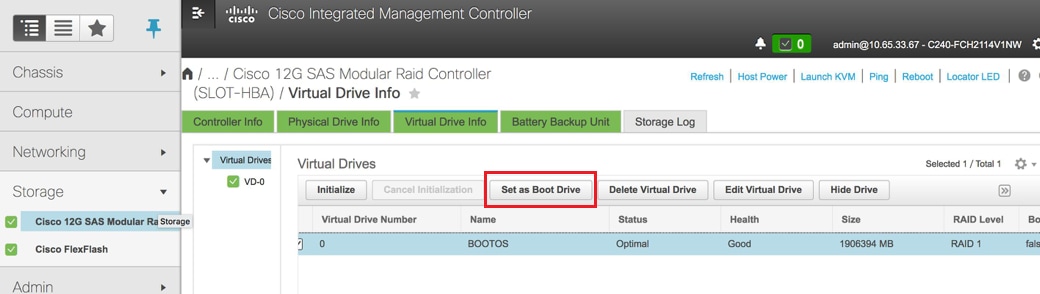

Wählen Sie das VD aus, und konfigurieren Sie Set as Boot Drive (Als Boot-Laufwerk festlegen), wie im Bild gezeigt.

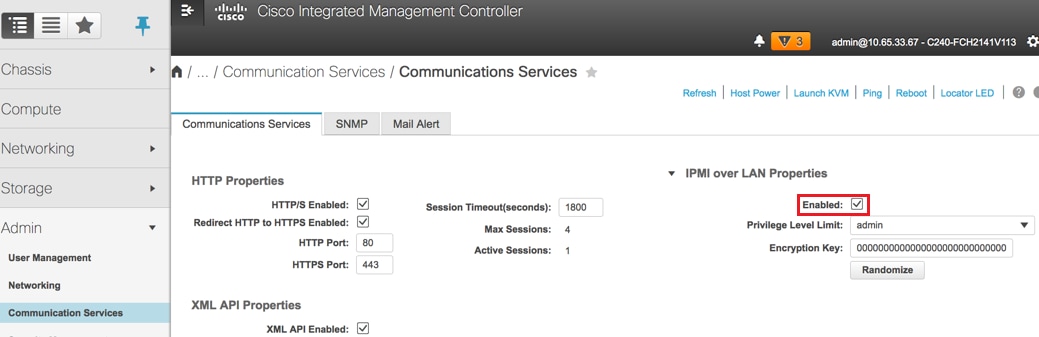

IPMI über LAN aktivieren:

Navigieren Sie zu Admin > Communication Services > Communication Services, wie im Bild dargestellt.

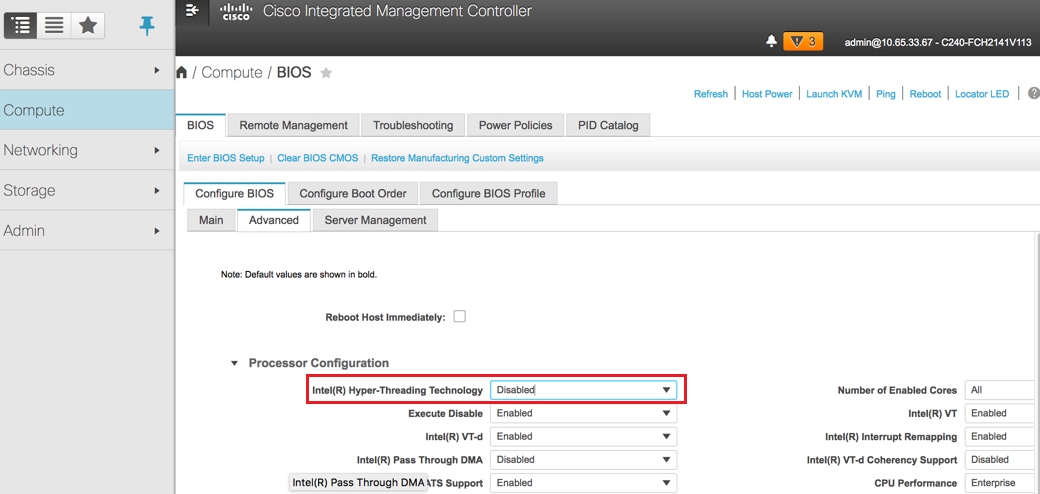

Hyperthreading deaktivieren:

Navigieren Sie zu Compute > BIOS > Configure BIOS > Advanced > Processor Configuration, wie in der Abbildung dargestellt.

Anmerkung: Die hier abgebildete Abbildung und die in diesem Abschnitt erwähnten Konfigurationsschritte beziehen sich auf die Firmware-Version 3.0(3e), und es können geringfügige Abweichungen auftreten, wenn Sie mit anderen Versionen arbeiten.

Red Hat Installation

Mounten Sie das Red Hat ISO-Image

1. Melden Sie sich beim OSP-D-Server an.

2. Starten Sie die KVM-Konsole.

3. Navigieren Sie zu Virtual Media > Virtuelle Geräte aktivieren. Akzeptieren Sie die Sitzung, und aktivieren Sie das Speichern Ihrer Einstellung für zukünftige Verbindungen.

4. Wählen Virtual Media > Karten-CD/DVDund das Red Hat ISO-Image abbilden.

5. Wählen Netzstrom > System zurücksetzen (Warmstart) um das System neu zu starten.

6. Drücken Sie nach dem Neustart F6und wählen Cisco vKVM-Mapped vDVD1.2und drücken Sie Geben Sie ein

Installation von Red Hat Enterprise Linux

Anmerkung: Das in diesem Abschnitt beschriebene Verfahren stellt eine vereinfachte Version des Installationsprozesses dar, in der die Mindestanzahl der zu konfigurierenden Parameter angegeben ist.

1. Wählen Sie die Option, um Red Hat Enterprise Linux (RHEL) zu installieren, um die Installation zu starten.

2. Wählen Sie Softwareauswahl > Nur minimale Installation.

3. Netzwerkschnittstellen konfigurieren (eno1 und eno2).

4. Klicken Sie auf Netzwerk und Hostname.

- Wählen Sie die Schnittstelle aus, die für die externe Kommunikation verwendet werden soll (entweder eno1 oder eno2).

- Klicken Sie auf Konfigurieren

- Wählen Sie die Registerkarte IPv4-Einstellungen, wählen Sie die manuelle Methode aus, und klicken Sie auf Hinzufügen

- Legen Sie die folgenden Parameter wie zuvor verwendet fest: Adresse, Netzmaske, Gateway, DNS-Server

5. Wählen Sie Datum und Uhrzeit und geben Sie Ihre Region und Ihren Ort an.

6. Aktivieren Sie die Netzwerkzeit, und konfigurieren Sie NTP-Server.

7. Wählen Sie Installationsziel und verwenden Sie ext4-Dateisystem .

Anmerkung: Löschen Sie /home/, und weisen Sie die Kapazität unter Root/erneut zu.

8. Deaktivieren Sie Kdump.

9. Nur Root-Kennwort festlegen.

10. Beginnen Sie mit der Installation .

Wiederherstellen der Unterwolke

Vorbereitung einer Cloud-basierten Installation auf der Grundlage eines Backups

Sobald der Computer mit RHEL 7.3 installiert wurde und sich in einem sauberen Zustand befindet, aktivieren Sie erneut alle Abonnements/Repositorys, die für die Installation und Ausführung von Director erforderlich sind.

Konfiguration des Hostnamens:

[root@director ~]$sudo hostnamectl set-hostname <FQDN_hostname>

[root@director ~]$sudo hostnamectl set-hostname --transient <FQDN_hostname>

Bearbeiten /etc/hosts-Datei:

[root@director ~]$ vi /etc/hosts

<ospd_external_address> <server_hostname> <FQDN_hostname>

10.225.247.142 pod1-ospd pod1-ospd.cisco.com

Hostnamen überprüfen:

[root@director ~]$ cat /etc/hostname

pod1-ospd.cisco.com

DNS-Konfiguration überprüfen:

[root@director ~]$ cat /etc/resolv.conf

#Generated by NetworkManager

nameserver <DNS_IP>

Ändern Sie die Provisioning NIC-Schnittstelle:

[root@director ~]$ cat /etc/sysconfig/network-scripts/ifcfg-eno1

DEVICE=eno1

ONBOOT=yes

HOTPLUG=no

NM_CONTROLLED=no

PEERDNS=no

DEVICETYPE=ovs

TYPE=OVSPort

OVS_BRIDGE=br-ctlplane

BOOTPROTO=none

MTU=1500

Schließen Sie die Red Hat-Registrierung ab

Laden Sie dieses Paket herunter, um Subscription-Manager für die Verwendung von rh-satellite zu konfigurieren:

[root@director ~]$ rpm -Uvh http:///pub/katello-ca-consumer-latest.noarch.rpm

[root@director ~]$ subscription-manager config

Registrieren Sie sich mit diesem Aktivierungsschlüssel für RHEL 7.3 bei rh-satellite.

[root@director ~]$subscription-manager register --org="<ORG>" --activationkey="<KEY>"

Um das Abonnement zu sehen:

[root@director ~]$ subscription-manager list –consumed

Aktivieren Sie die Repositorys ähnlich wie die alten OSPD-Repos:

[root@director ~]$ sudo subscription-manager repos --disable=*

[root@director ~]$ subscription-manager repos --enable=rhel-7-server-rpms --enable=rhel-7-server-extras-rpms --enable=rh

el-7-server-openstack-10-rpms --enable=rhel-7-server-rh-common-rpms --enable=rhel-ha-for-rhel-7-server-rpm

Führen Sie ein Update auf Ihrem System durch, um sicherzustellen, dass Sie über die neuesten Basispakete verfügen, und starten Sie das System neu:

[root@director ~]$sudo yum update -y

[root@director ~]$sudo reboot

Wiederherstellung unter der Cloud

Nachdem Sie das Abonnement aktiviert haben, importieren Sie die gesicherte Tar-Datei undercloud-backup-date +%F`.tar.gz in das neue OSP-D Server-Stammverzeichnis /-root.

Mariadb-Server installieren:

[root@director ~]$ yum install -y mariadb-server

Extrahieren Sie die MariaDB-Konfigurationsdatei und das Datenbank-Backup (DB). Führen Sie diesen Vorgang als Root-Benutzer aus.

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/my.cnf.d/server.cnf

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz root/undercloud-all-databases.sql

Bearbeiten Sie /etc/my.cnf.d/server.cnf, und kommentieren Sie den Eintrag bind-address aus, falls vorhanden:

[root@tb3-ospd ~]# vi /etc/my.cnf.d/server.cnf

Starten Sie den MariaDB-Dienst, und aktualisieren Sie vorübergehend die max_allowed_packet-Einstellung:

[root@director ~]$ systemctl start mariadb

[root@director ~]$ mysql -uroot -e"set global max_allowed_packet = 16777216;"

Bereinigen Sie bestimmte Berechtigungen (die später neu erstellt werden):

[root@director ~]$ for i in ceilometer glance heat ironic keystone neutron nova;do mysql -e "drop user $i";done

[root@director ~]$ mysql -e 'flush privileges'

Hinweis: Wenn der Deckenmesserdienst zuvor in der Konfiguration deaktiviert wurde, führen Sie diesen Befehl aus, und entfernen Sie den Deckenmesser.

Erstellen Sie das Stackuser-Konto:

[root@director ~]$ sudo useradd stack

[root@director ~]$ sudo passwd stack << specify a password

[root@director ~]$ echo "stack ALL=(root) NOPASSWD:ALL" | sudo tee -a /etc/sudoers.d/stack

[root@director ~]$ sudo chmod 0440 /etc/sudoers.d/stack

Stack-Benutzer-Hauptverzeichnis wiederherstellen:

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz home/stack

Installieren Sie die SWIFT- und GLANZ-Basispakete, und stellen Sie dann ihre Daten wieder her:

[root@director ~]$ yum install -y openstack-glance openstack-swift

[root@director ~]$ tar --xattrs -xzC / -f undercloud-backup-$DATE.tar.gz srv/node var/lib/glance/images

Vergewissern Sie sich, dass die Daten dem richtigen Benutzer gehören:

[root@director ~]$ chown -R swift: /srv/node

[root@director ~]$ chown -R glance: /var/lib/glance/images

Stellen Sie die SSL-Zertifikate unter der Cloud wieder her (optional - nur bei Verwendung von SSL-Zertifikaten im Setup).

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/instack-certs/undercloud.pem

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/ca-trust/source/anchors/ca.crt.pem

Führen Sie die Untercloud-Installation als Stackuser erneut aus, und stellen Sie sicher, dass sie im Stack-Benutzer-Hauptverzeichnis ausgeführt wird:

[root@director ~]$ su - stack

[stack@director ~]$ sudo yum install -y python-tripleoclient

Bestätigen Sie, dass der Hostname in /etc/hosts richtig eingestellt ist.

Installieren Sie die Undercloud neu:

[stack@director ~]$ openstack undercloud install

<snip>

#############################################################################

Undercloud install complete.

The file containing this installation's passwords is at

/home/stack/undercloud-passwords.conf.

There is also a stackrc file at /home/stack/stackrc.

These files are needed to interact with the OpenStack services, and must be

secured.

#############################################################################

Wiederhergestellte Undercloud wieder mit der Overcloud verbinden

Wenn Sie diese Schritte abgeschlossen haben, wird die Undercloud wahrscheinlich automatisch ihre Verbindung zur Overcloud wiederherstellen. Die Knoten werden weiterhin die Orchestrierung (Wärme) für ausstehende Aufgaben abfragen, wobei eine einfache HTTP-Anforderung verwendet wird, die alle paar Sekunden ausgegeben wird.

Validieren der abgeschlossenen Wiederherstellung

Verwenden Sie diese Befehle, um die Integrität der neu wiederhergestellten Umgebung zu überprüfen.:

[root@director ~]$ su - stack

Last Log in: Tue Nov 28 21:27:50 EST 2017 from 10.86.255.201 on pts/0

[stack@director ~]$ source stackrc

[stack@director ~]$ nova list

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| ID | Name | Status | Task State | Power State | Networks |

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| b1f5294a-629e-454c-b8a7-d15e21805496 | pod1-compute-0 | ACTIVE | - | Running | ctlplane=192.200.0.119 |

| 9106672e-ac68-423e-89c5-e42f91fefda1 | pod1-compute-1 | ACTIVE | - | Running | ctlplane=192.200.0.120 |

| b3ed4a8f-72d2-4474-91a1-b6b70dd99428 | pod1-compute-2 | ACTIVE | - | Running | ctlplane=192.200.0.124 |

| 677524e4-7211-4571-ac35-004dc5655789 | pod1-compute-3 | ACTIVE | - | Running | ctlplane=192.200.0.107 |

| 55ea7fe5-d797-473c-83b1-d897b76a7520 | pod1-compute-4 | ACTIVE | - | Running | ctlplane=192.200.0.122 |

| c34c1088-d79b-42b6-9306-793a89ae4160 | pod1-compute-5 | ACTIVE | - | Running | ctlplane=192.200.0.108 |

| 4ba28d8c-fb0e-4d7f-8124-77d56199c9b2 | pod1-compute-6 | ACTIVE | - | Running | ctlplane=192.200.0.105 |

| d32f7361-7e73-49b1-a440-fa4db2ac21b1 | pod1-compute-7 | ACTIVE | - | Running | ctlplane=192.200.0.106 |

| 47c6a101-0900-4009-8126-01aaed784ed1 | pod1-compute-8 | ACTIVE | - | Running | ctlplane=192.200.0.121 |

| 1a638081-d407-4240-b9e5-16b47e2ff6a2 | pod1-compute-9 | ACTIVE | - | Running | ctlplane=192.200.0.112 |

<snip>

[stack@director ~]$ ssh heat-admin@192.200.0.107

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod1-controller-0 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

3 nodes and 22 resources configured

Online: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Full list of resources:

ip-10.1.10.10 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.97 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

ip-192.200.0.106 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.95 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

ip-11.119.0.98 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.118.0.92 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: redis-master [redis]

Masters: [ pod1-controller-0 ]

Slaves: [ pod1-controller-1 pod1-controller-2 ]

openstack-cinder-volume (systemd:openstack-cinder-volume): Started pod1-controller-0

my-ipmilan-for-controller-0 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-1 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-2 (stonith:fence_ipmilan): Stopped

Failed Actions:

* my-ipmilan-for-controller-0_start_0 on pod1-controller-1 'unknown error' (1): call=190, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-1 'unknown error' (1): call=192, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-1 'unknown error' (1): call=188, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-0 'unknown error' (1): call=210, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-0 'unknown error' (1): call=207, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-0 'unknown error' (1): call=206, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20006ms

* ip-192.200.0.106_monitor_10000 on pod1-controller-0 'not running' (7): call=197, status=complete, exitreason='none',

last-rc-change='Wed Nov 22 13:51:31 2017', queued=0ms, exec=0ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-2 'unknown error' (1): call=183, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=1ms, exec=20006ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-2 'unknown error' (1): call=184, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-2 'unknown error' (1): call=177, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:02 2017', queued=0ms, exec=20005ms

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[heat-admin@pod1-controller-0 ~]$ sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod1-controller-0=11.118.0.40:6789/0,pod1-controller-1=11.118.0.41:6789/0,pod1-controller-2=11.118.0.42:6789/0}

election epoch 58, quorum 0,1,2 pod1-controller-0,pod1-controller-1,pod1-controller-2

osdmap e1398: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v1245812: 704 pgs, 6 pools, 542 GB data, 352 kobjects

1625 GB used, 11767 GB / 13393 GB avail

704 active+clean

client io 21549 kB/s wr, 0 op/s rd, 120 op/s wr

Funktion zum Überprüfen des Identitätsdiensts (Keystone)

In diesem Schritt werden Identity Service-Vorgänge validiert, indem eine Benutzerliste abgefragt wird.

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack user list

+----------------------------------+------------------+

| ID | Name |

+----------------------------------+------------------+

| 69ac2b9d89414314b1366590c7336f7d | admin |

| f5c30774fe8f49d0a0d89d5808a4b2cc | glance |

| 3958d852f85749f98cca75f26f43d588 | heat |

| cce8f2b7f1a843a08d0bb295a739bd34 | ironic |

| ce7c642f5b5741b48a84f54d3676b7ee | ironic-inspector |

| a69cd42a5b004ec5bee7b7a0c0612616 | mistral |

| 5355eb161d75464d8476fa0a4198916d | neutron |

| 7cee211da9b947ef9648e8fe979b4396 | nova |

| f73d36563a4a4db482acf7afc7303a32 | swift |

| d15c12621cbc41a8a4b6b67fa4245d03 | zaqar |

| 3f0ed37f95544134a15536b5ca50a3df | zaqar-websocket |

+----------------------------------+------------------+

[stack@director ~]$

[stack@director ~]$ source <overcloudrc>

[stack@director ~]$ openstack user list

+----------------------------------+------------+

| ID | Name |

+----------------------------------+------------+

| b4e7954942184e2199cd067dccdd0943 | admin |

| 181878efb6044116a1768df350d95886 | neutron |

| 6e443967ee3f4943895c809dc998b482 | heat |

| c1407de17f5446de821168789ab57449 | nova |

| c9f64c5a2b6e4d4a9ff6b82adef43992 | glance |

| 800e6b1163b74cc2a5fab4afb382f37d | cinder |

| 4cfa5a2a44c44c678025842f080e5f53 | heat-cfn |

| 9b222eeb8a58459bb3bfc76b8fff0f9f | swift |

| 815f3f25bcda49c290e1b56cd7981d1b | core |

| 07c40ade64f34a64932129175150fa4a | gnocchi |

| 0ceeda0bc32c4d46890e53adef9a193d | aodh |

| f3caab060171468592eab376a94967b8 | ceilometer |

+----------------------------------+------------+

[stack@director ~]$

Hochladen von Bildern für zukünftige Knoteninspektion

Validieren Sie /httpboot und alle diese Dateien inspector.ipxe, agent.kernel, agent.ramdisk, falls Sie nicht mit diesen Schritten fortfahren.

[stack@director ~]$ ls /httpboot

inspector.ipxe

[stack@director ~]$ source stackrc

[stack@director ~]$ cd images/

[stack@director images]$ openstack overcloud image upload --image-path /home/stack/images

Image "overcloud-full-vmlinuz" is up-to-date, skipping.

Image "overcloud-full-initrd" is up-to-date, skipping.

Image "overcloud-full" is up-to-date, skipping.

Image "bm-deploy-kernel" is up-to-date, skipping.

Image "bm-deploy-ramdisk" is up-to-date, skipping.

[stack@director images]$ ls /httpboot

agent.kernel agent.ramdisk inspector.ipxe

[stack@director images]$

Zaun neu starten

Die Umzäunung befindet sich nach der OSPD-Wiederherstellung im angehaltenen Zustand. Dieses Verfahren ermöglicht das Fencing.

[heat-admin@pod1-controller-0 ~]$ sudo pcs property set stonith-enabled=true

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

[heat-admin@pod1-controller-0 ~]$sudo pcs stonith show

Zugehörige Informationen

Beiträge von Cisco Ingenieuren

- Padmaraj RamanoudjamCisco Advanced Services

- Partheeban RajagopalCisco Advanced Services

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback