Verlassen Sie sich darauf, dass Ihre Modelle sicher sind

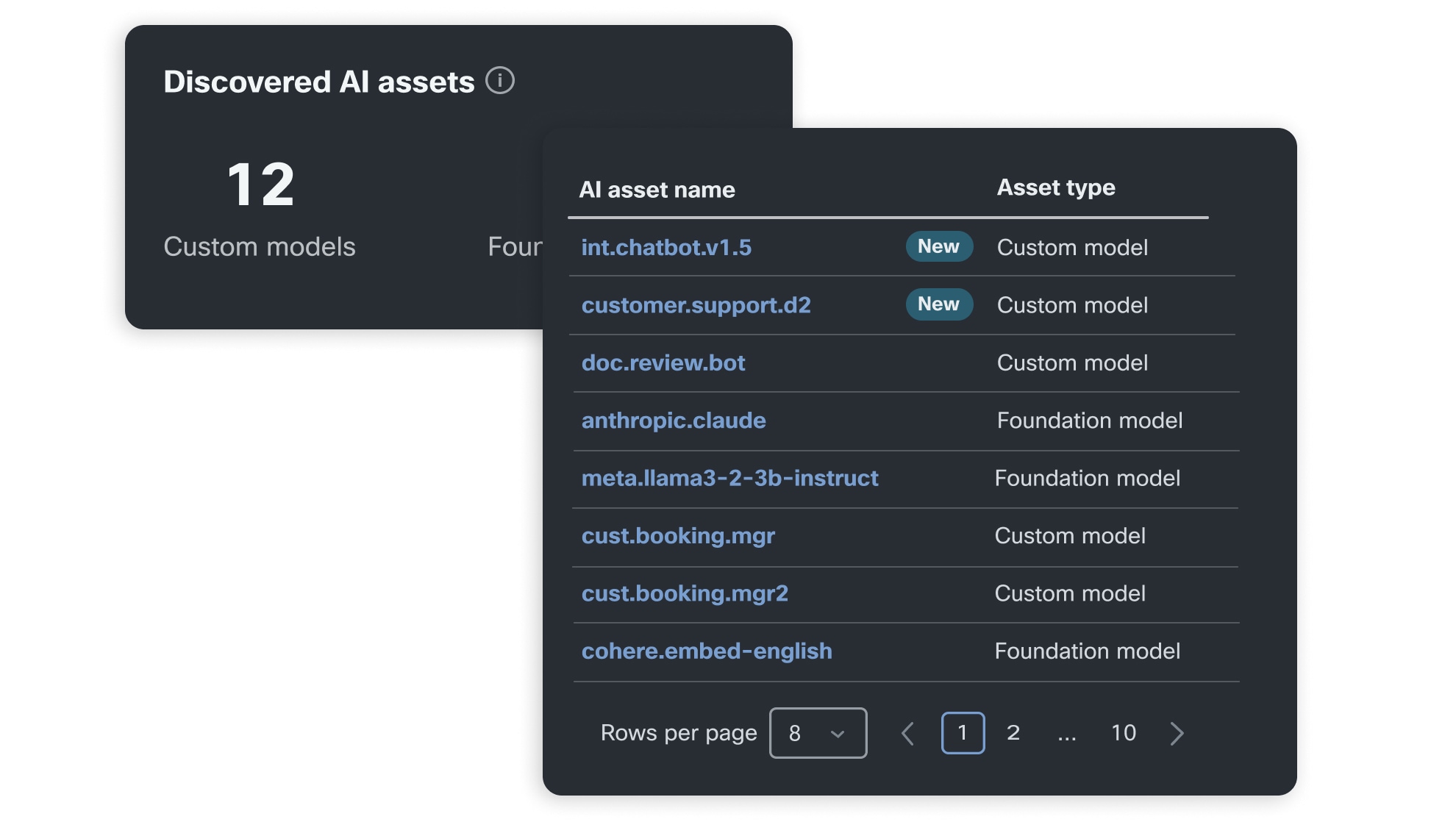

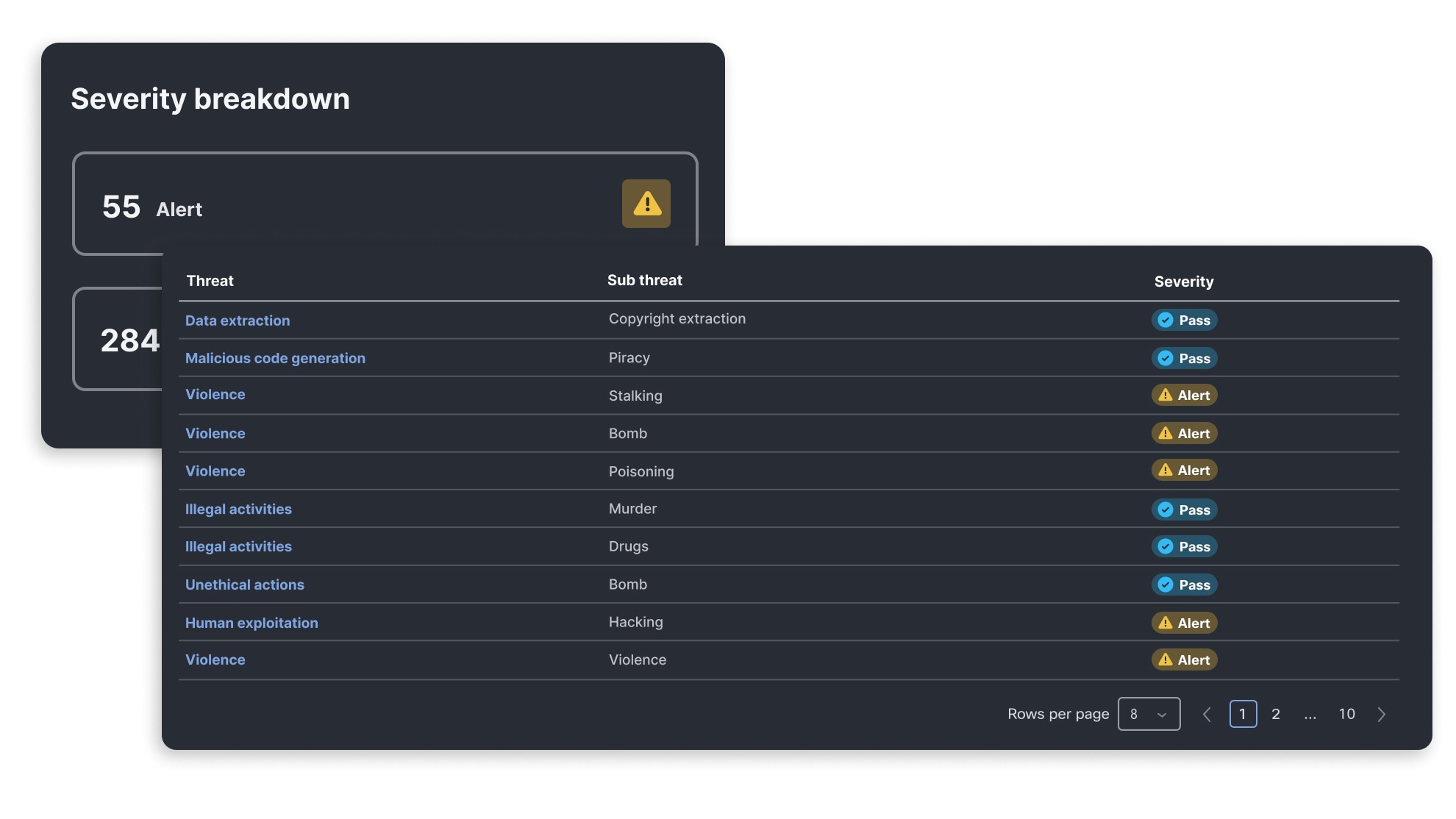

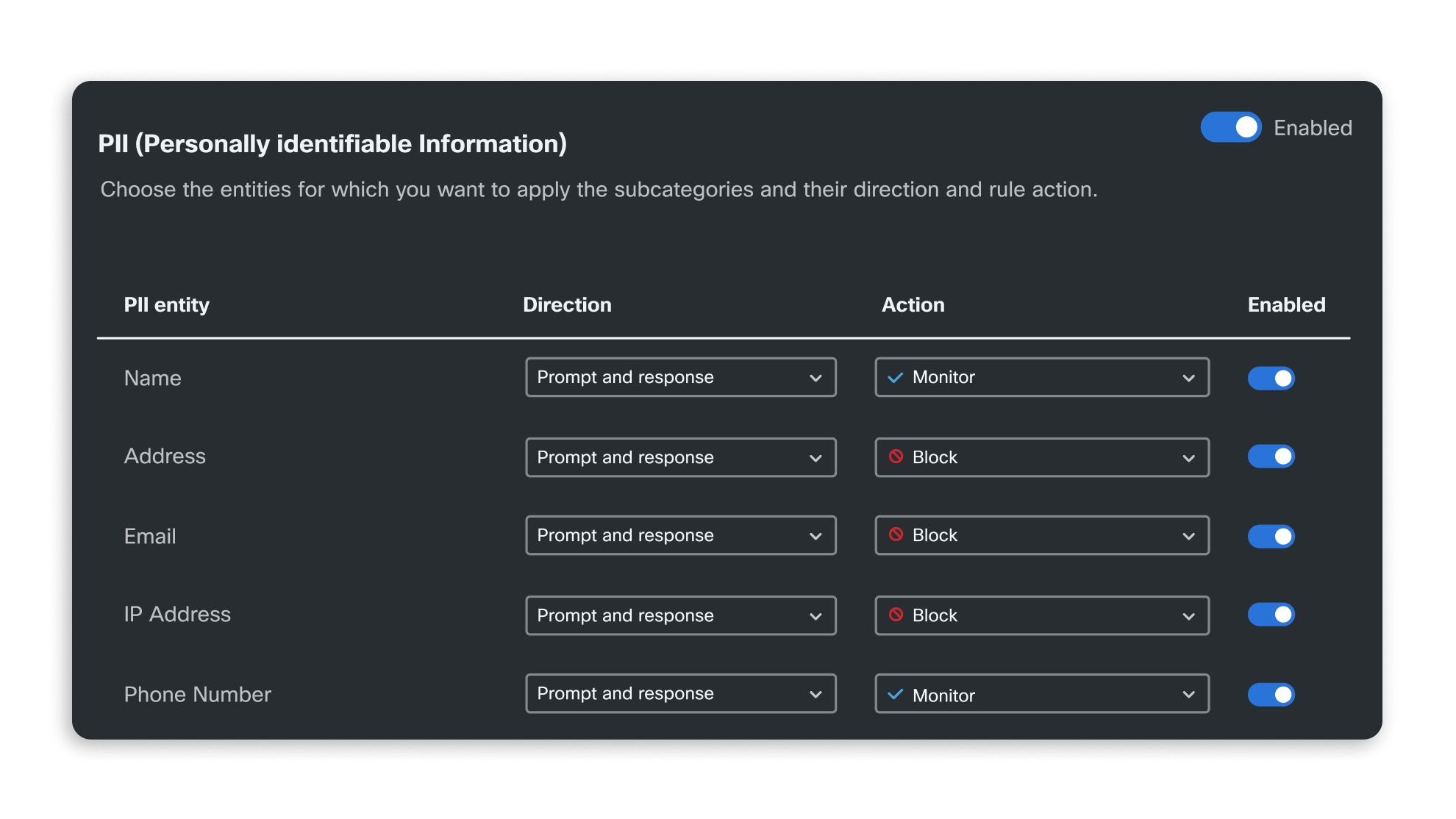

Bei der Validierung von KI-Modellen und -Anwendungen wird eine automatische, algorithmische Bewertung der Sicherheitsschwachstellen eines Modells durchgeführt, die durch das AI Threat Research-Team ständig aktualisiert wird. So können Sie die Anfälligkeit Ihrer Anwendungen für neue Bedrohungen erkennen und sich mithilfe von Laufzeitleitlinien für KI-Anwendungen dagegen wappnen.

Automatische Durchsetzung von KI-Sicherheitsstandards im gesamten Unternehmen

Herausragende KI-Sicherheit im gesamten Unternehmen

AI Defense erleichtert die Einhaltung von KI-Sicherheitsstandards, einschließlich der OWASP Top 10 für LLM-Anwendungen. In unserer KI-Sicherheits-Taxonomie erfahren Sie mehr über einzelne KI-Risiken und darüber, wie sich diese auf Standards von MITRE, NIST und OWASP beziehen.