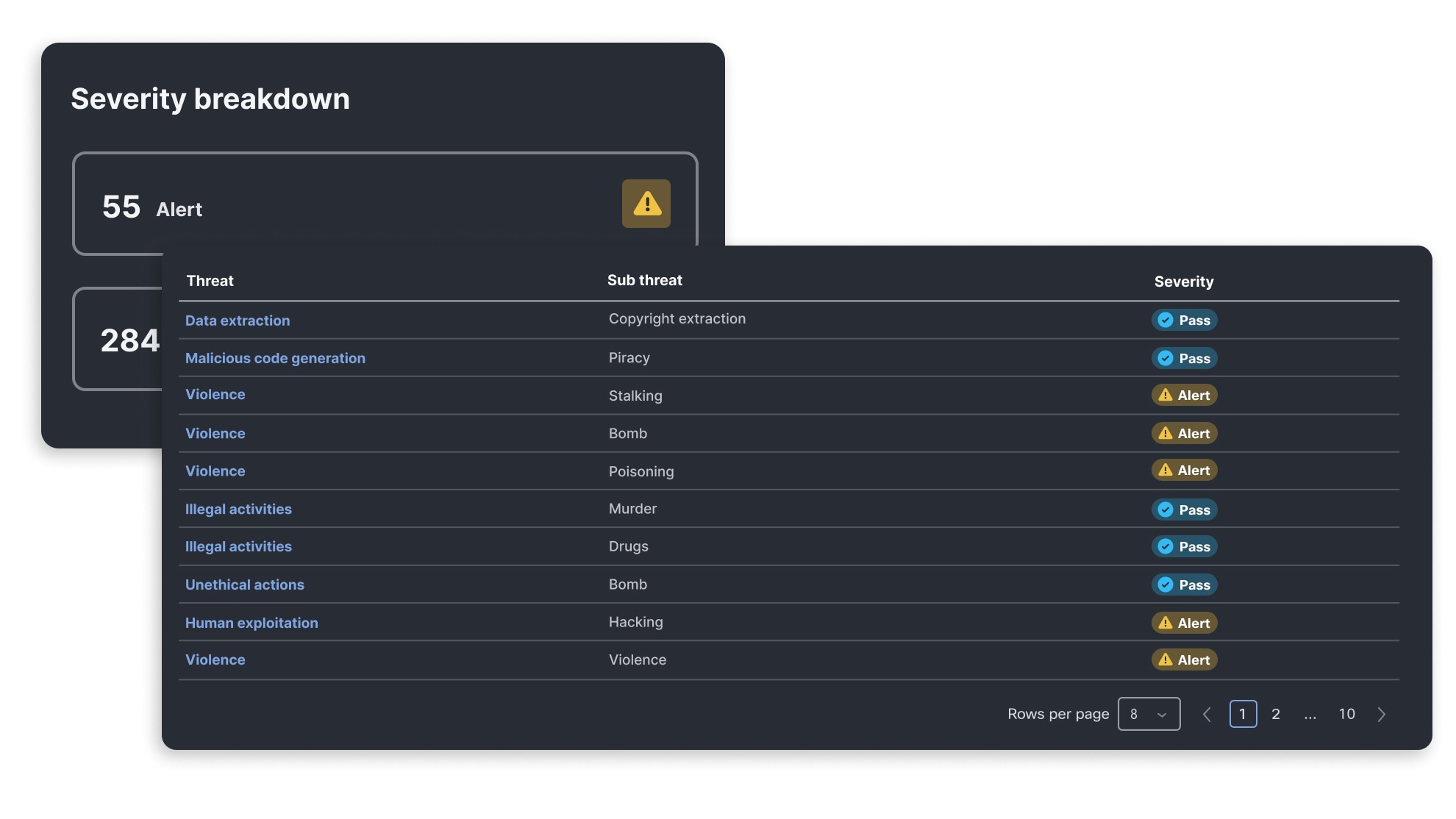

La certitude que vos modèles sont sûrs

La validation des modèles et applications d’intelligence artificielle repose sur une analyse algorithmique automatisée des vulnérabilités des modèles, constamment actualisée par les équipes de recherche en vulnérabilités liées à l’intelligence artificielle. Celle-ci vous permet d’évaluer la vulnérabilité de vos applications face aux menaces émergentes et de vous en protéger grâce à des garde-fous basés sur AI Runtime.

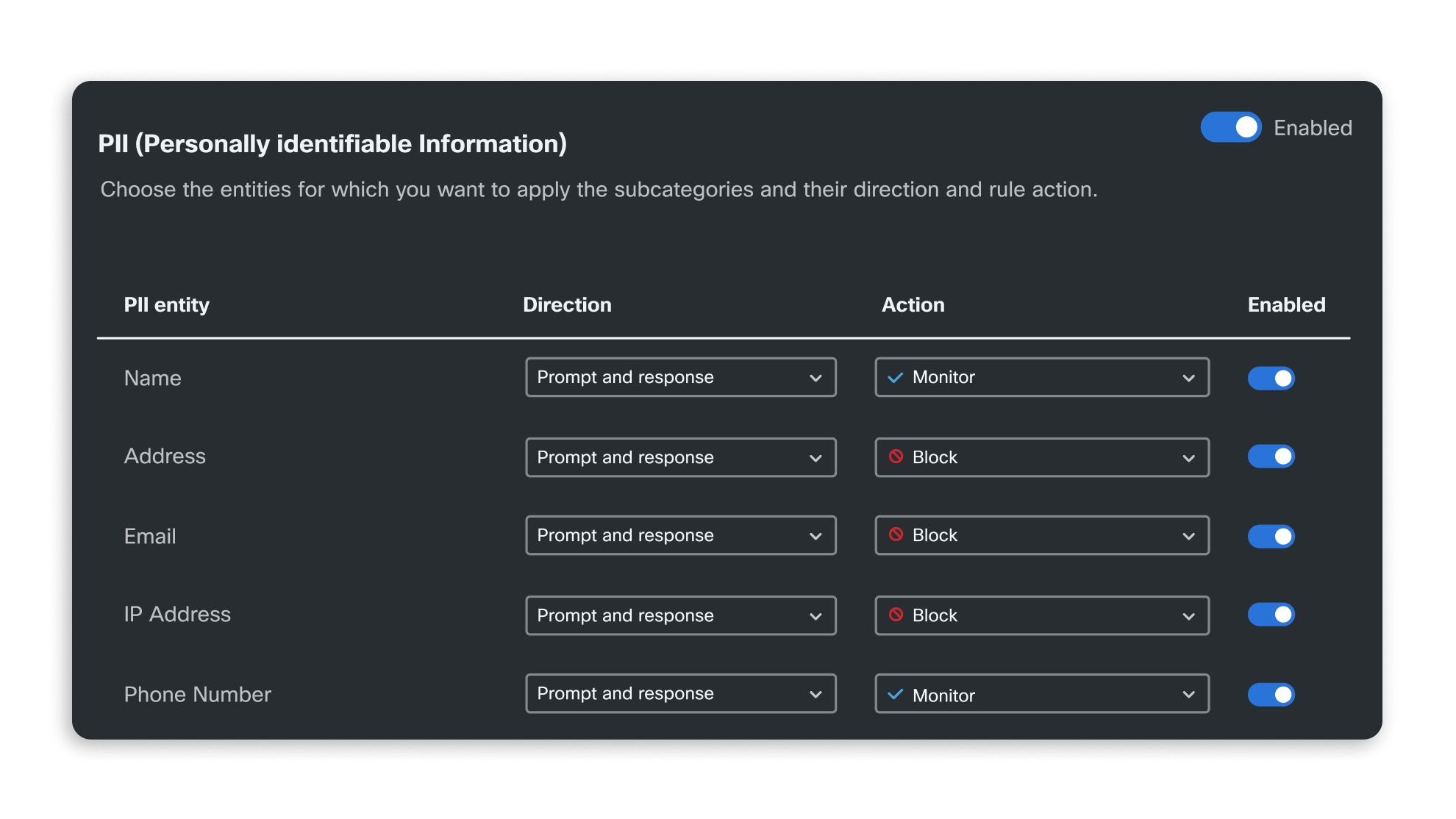

Appliquez automatiquement les normes de sécurité de l’intelligence artificielle à l’échelle de votre organisation

Atteignez l’excellence en matière de sécurité de l’intelligence artificielle au sein de votre organisation

AI Defense permet de se conformer facilement aux normes de sécurité de l’intelligence artificielle telles que l’OWASP Top 10 pour les applications LLM. Découvrez les risques liés à l’intelligence artificielle et leur lien avec les normes MITRE, NIST et OWASP dans notre taxonomie de la sécurité de l’intelligence artificielle.

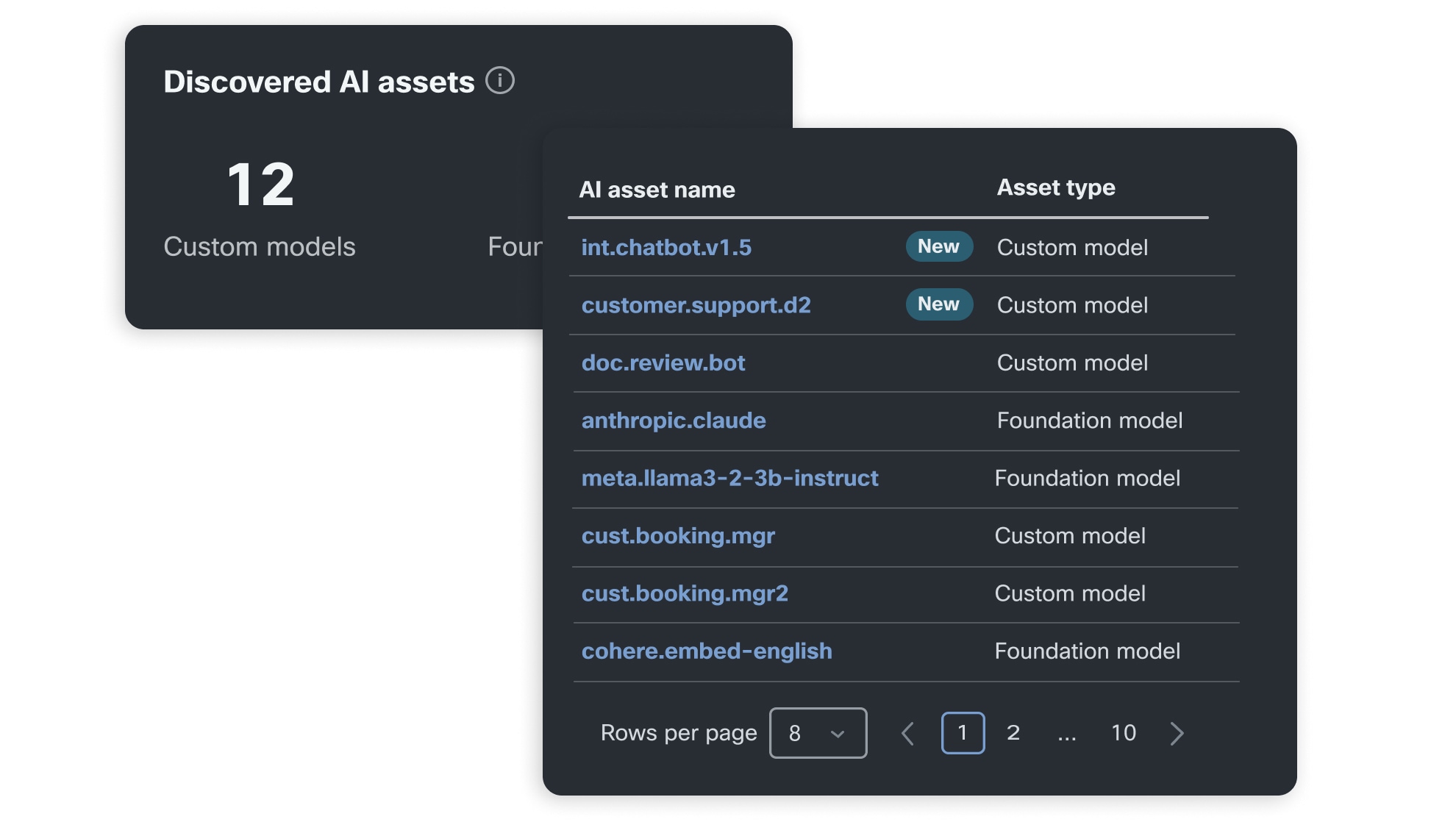

Testez les modèles qui alimentent votre application

Modèles de base

Les modèles de base sont au cœur de la plupart des applications d’intelligence artificielle actuelles, qu’ils soient modifiés par ajustement ou créés sur mesure. Découvrez les défis à relever pour garantir leur sécurité et leur fiabilité.

Applications RAG

La génération augmentée de récupération (RAG) devient rapidement la norme pour enrichir le contexte des applications LLM. Découvrez les implications spécifiques de la RAG en matière de sécurité.

Robots conversationnels et agents basés sur l’intelligence artificielle

Les robots conversationnels constituent une application majeure des LLM, tandis que les agents autonomes, capables d’agir au nom des utilisateurs, émergent progressivement. Découvrez les risques qu’ils représentent en matière de sécurité.