Configurar o recurso VXLAN nos dispositivos Cisco IOS XE

Opções de download

Linguagem imparcial

O conjunto de documentação deste produto faz o possível para usar uma linguagem imparcial. Para os fins deste conjunto de documentação, a imparcialidade é definida como uma linguagem que não implica em discriminação baseada em idade, deficiência, gênero, identidade racial, identidade étnica, orientação sexual, status socioeconômico e interseccionalidade. Pode haver exceções na documentação devido à linguagem codificada nas interfaces de usuário do software do produto, linguagem usada com base na documentação de RFP ou linguagem usada por um produto de terceiros referenciado. Saiba mais sobre como a Cisco está usando a linguagem inclusiva.

Sobre esta tradução

A Cisco traduziu este documento com a ajuda de tecnologias de tradução automática e humana para oferecer conteúdo de suporte aos seus usuários no seu próprio idioma, independentemente da localização. Observe que mesmo a melhor tradução automática não será tão precisa quanto as realizadas por um tradutor profissional. A Cisco Systems, Inc. não se responsabiliza pela precisão destas traduções e recomenda que o documento original em inglês (link fornecido) seja sempre consultado.

Contents

Introdução

Este documento descreve a configuração básica e a solução de problemas em dispositivos Cisco IOS® XE.

Pré-requisitos

Requisitos

A Cisco recomenda que você tenha conhecimento destes tópicos:

- Compreensão básica de sobreposições e multicast de DCI

Componentes Utilizados

As informações neste documento são baseadas nestas versões de software e hardware:

- ASR1004 executando o software 03.16.00.S

- CSR100v(VXE) executando o software 3.16.03.S

As informações neste documento foram criadas a partir de dispositivos em um ambiente de laboratório específico. Todos os dispositivos utilizados neste documento foram iniciados com uma configuração (padrão) inicial. Se a rede estiver ativa, certifique-se de que você entenda o impacto potencial de qualquer comando.

Informações de Apoio

A Virtual Extensible LAN (VXLAN) está se tornando mais popular como uma solução de interconexão de data center (DCI). O recurso VXLAN é usado para fornecer extensão de Camada 2 sobre o domínio de Roteamento Público de Camada 3. Este documento discute a configuração básica e a solução de problemas em dispositivos Cisco IOS XE.

As seções Configurar e Verificar deste documento abordam dois cenários:

- O cenário A descreve uma configuração de VXLAN entre três data centers no modo multicast.

- O cenário B descreve uma configuração de VXLAN entre dois data centers no modo unicast.

Configurar

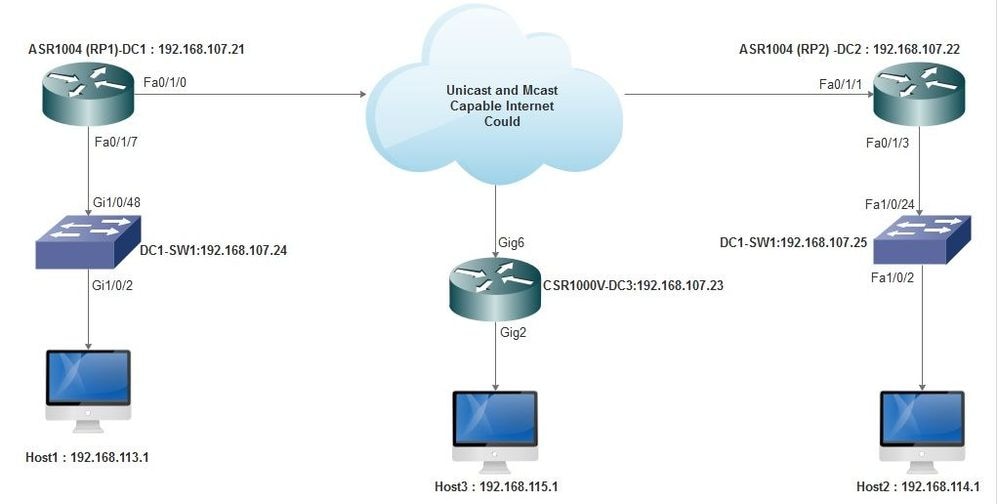

Cenário A: configurar VXLAN entre três data centers no modo multicast

Configuração de base

O modo multicast requer conectividade unicast e multicast entre os locais. Este guia de configuração usa o OSPF (Open Shortest Path First) para fornecer conectividade unicast e o PIM (Protocol Independent Multicast) bidirecional para fornecer conectividade multicast.

Aqui está a configuração básica em todos os três data centers para o modo de operação multicast:

! DC1#show run | sec ospf router ospf 1 network 10.1.1.1 0.0.0.0 area 0 network 10.10.10.4 0.0.0.3 area 0

!

Configuração bidirecional PIM:

!

DC1#show run | sec pim ip pim bidir-enable ip pim send-rp-discovery scope 10 ip pim bsr-candidate Loopback1 0 ip pim rp-candidate Loopback1 group-list 10 bidir ! access-list 10 permit 239.0.0.0 0.0.0.255

!

DC1#

!

Além disso, o modo esparso de PIM é ativado em todas as interfaces L3, incluindo o loopback:

!

DC1#show run interface lo1 Building configuration... Current configuration : 83 bytes ! interface Loopback1 ip address 10.1.1.1 255.255.255.255 ip pim sparse-mode end

Verifique também se o roteamento multicast está ativado no dispositivo e se você vê a tabela multicast mroute sendo preenchida.

Diagrama de Rede

Internet compatível com unicast e multicast

Internet compatível com unicast e multicast

Configuração de DC1(VTEP1)

! ! Vxlan udp port 1024 ! Interface Loopback1 ip address 10.1.1.1 255.255.255.255 ip pim sparse-mode !

Defina os membros do VNI e a interface do membro na configuração de domínio de ponte:

! bridge-domain 1 member vni 6001 member FastEthernet0/1/7 service-instance 1 !

Crie a NVE (Network Virtual Interface, interface virtual de rede) e defina os membros do VNI que precisam ser estendidos pela WAN para outros data centers:

! interface nve1 no ip address shut member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 !

Crie instâncias de serviço na interface LAN (ou seja, a interface que conecta a rede LAN) para sobrepor a VLAN específica (tráfego marcado 802.1q) - neste caso, a VLAN 1:

! interface FastEthernet0/1/7 no ip address negotiation auto cdp enable no shut !

Remova a marca da VLAN antes de enviar o tráfego pela sobreposição e empurre-a depois que o tráfego de retorno estiver sendo enviado para a VLAN:

! service instance 1 ethernet encapsulation unagged !

Configuração DC2(VTEP2)

! ! Vxlan udp port 1024 ! interface Loopback1 ip address 10.2.2.2 255.255.255.255 ip pim sparse-mode ! ! bridge-domain 1 member vni 6001 member FastEthernet0/1/3 service-instance 1 ! ! interface nve1 no ip address member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 shut ! ! interface FastEthernet0/1/3 no ip address negotiation auto cdp enable no shut ! service instance 1 ethernet encapsulation untagged !

Configuração de DC3(VTEP3)

! ! Vxlan udp port 1024 ! interface Loopback1 ip address 10.3.3.3 255.255.255.255 ip pim sparse-mode ! ! bridge-domain 1 member vni 6001 member GigabitEthernet2 service-instance 1 ! interface nve1 no ip address shut member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 ! interface gig2 no ip address negotiation auto cdp enable no shut ! service instance 1 ethernet encapsulation untagged !

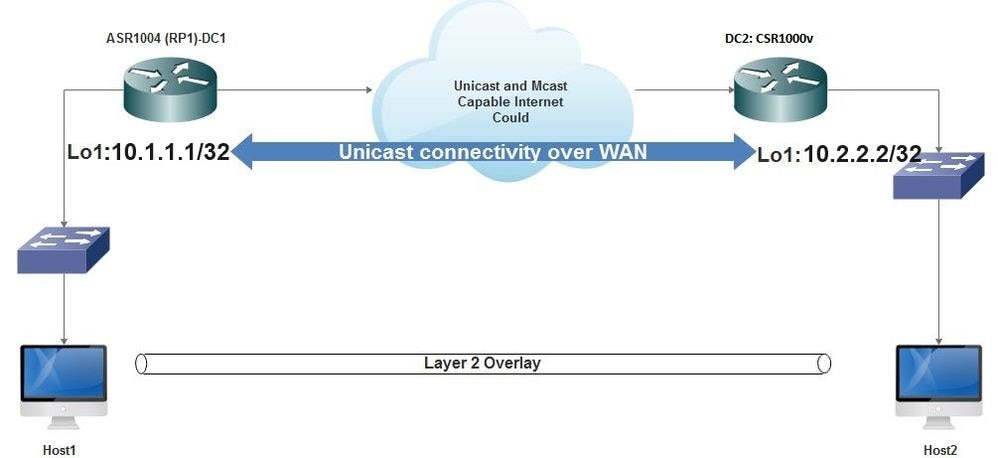

Cenário B: Configurar VXLAN entre dois data centers no modo unicast

Diagrama de Rede

Conectividade unicast sobre WAN

Conectividade unicast sobre WAN

Configuração do DC1

! interface nve1 no ip address member vni 6001 ! ingress replication shold be configured as peer data centers loopback IP address. ! ingress-replication 10.2.2.2 ! source-interface Loopback1 ! ! interface gig0/2/1 no ip address negotiation auto cdp enable ! service instance 1 ethernet encapsulation untagged ! ! ! bridge-domain 1 member vni 6001 member gig0/2/1 service-instance 1

Configuração DC2

! interface nve1 no ip address member vni 6001 ingress-replication 10.1.1.1 ! source-interface Loopback1 ! ! interface gig5 no ip address negotiation auto cdp enable ! service instance 1 ethernet encapsulation untagged ! ! bridge-domain 1 member vni 6001 member gig5 service-instance 1

Verificar

Cenário A: configurar VXLAN entre três data centers no modo multicast

Depois de concluir a configuração para o Cenário A, os hosts conectados em cada data center devem ser capazes de se comunicar dentro do mesmo domínio de broadcast.

Use estes comandos para verificar as configurações. Alguns exemplos são fornecidos no Cenário B.

Router#show nve vni Router#show nve vni interface nve1 Router#show nve interface nve1 Router#show nve interface nve1 detail Router#show nve peers

Cenário B: Configurar VXLAN entre dois data centers no modo unicast

No DC1:

DC1#show nve vni Interface VNI Multicast-group VNI state nve1 6001 N/A Up DC1#show nve interface nve1 detail Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan source-interface: Loopback1 (primary:10.1.1.1 vrf:0) Pkts In Bytes In Pkts Out Bytes Out 60129 6593586 55067 5303698 DC1#show nve peers Interface Peer-IP VNI Peer state nve1 10.2.2.2 6000 -

No DC2:

DC2#show nve vni

Interface VNI Multicast-group VNI state

nve1 6000 N/A Up

DC2#show nve interface nve1 detail

Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan

source-interface: Loopback1 (primary:10.2.2.2 vrf:0)

Pkts In Bytes In Pkts Out Bytes Out

70408 7921636 44840 3950835

DC2#show nve peers

Interface Peer-IP VNI Peer state

nve 10.1.1.1 6000 Up

DC2#show bridge-domain 1

Bridge-domain 1 (3 ports in all)

State: UP Mac learning: Enabled

Aging-Timer: 300 second(s)

BDI1 (up)

GigabitEthernet0/2/1 service instance 1

vni 6001

AED MAC address Policy Tag Age Pseudoport

0 7CAD.74FF.2F66 forward dynamic 281 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 B838.6130.DA80 forward dynamic 288 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 0050.56AD.1AD8 forward dynamic 157 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

Troubleshooting

Os comandos descritos na seção Verificar fornecem etapas básicas de solução de problemas. Esses diagnósticos adicionais podem ser úteis quando o sistema não estiver funcionando.

Observação: alguns desses diagnósticos podem causar o aumento da utilização da memória e da CPU.

Depurar Diagnósticos

#debug nve error

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes eer nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

#show nve log error

[01/01/70 00:04:34.130 UTC 1 3] NVE-MGR-STATE ERROR: vni 6001: error in create notification to Tunnel

[01/01/70 00:04:34.314 UTC 2 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 00:04:34.326 UTC 3 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:50:59.650 UTC 4 3] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:50:59.654 UTC 5 3] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:50:59.701 UTC 6 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:50:59.705 UTC 7 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:54:55.166 UTC 8 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:54:55.168 UTC 9 61] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:55:04.432 UTC A 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:55:04.434 UTC B 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:55:37.670 UTC C 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

#show nve log event

[01/04/70 19:48:51.883 UTC 1DD16 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD17 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD18 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD19 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD1A 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1B 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1C 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1D 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1E 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD1F 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD20 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:21.884 UTC 1DD21 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

Captura de pacotes incorporada

Captura de pacotes incorporadaO recurso Embedded Packet Capture (EPC) disponível no software Cisco IOS XE pode fornecer informações adicionais para a solução de problemas.

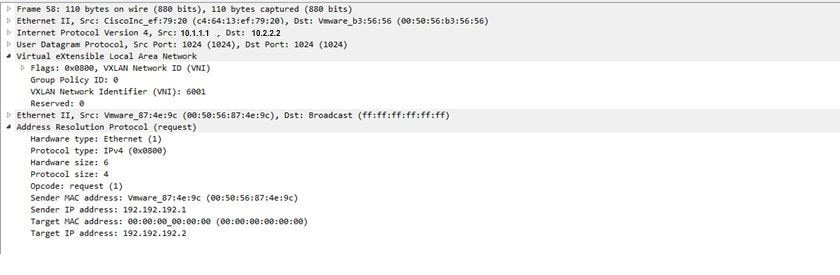

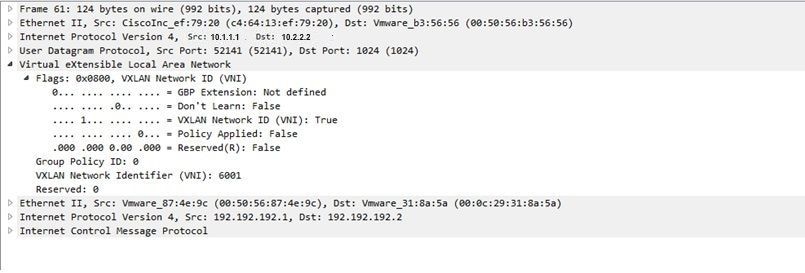

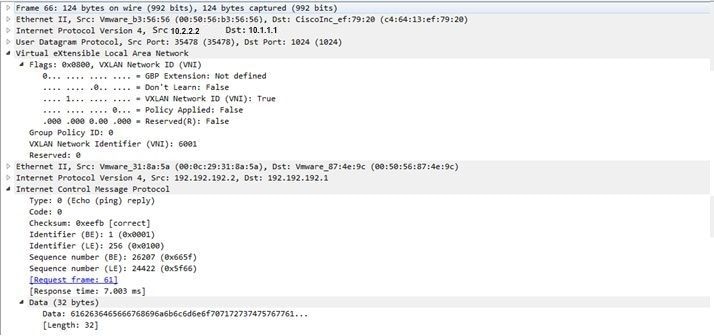

Por exemplo, esta captura explica o pacote sendo encapsulado por VXLAN:

Configuração de EPC (TEST_ACL é a lista de acesso usada para filtrar os dados de captura):

#monitor capture TEST access-list TEST_ACL interface gigabitEthernet0/2/0 both #monitor capture TEST buffer size 10 #monitor capture TEST start Aqui está o despejo de pacote que resulta:

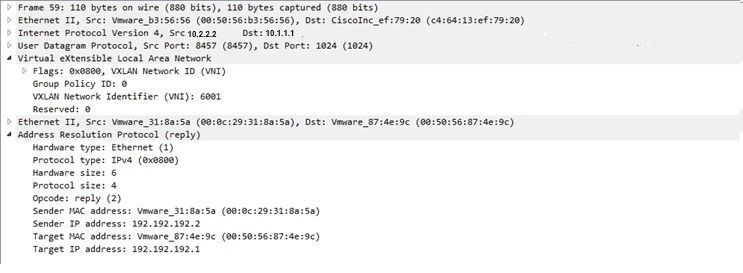

# show monitor capture TEST buffer dump # monitor capture TEST export bootflash:TEST.pcap // with this command you can export the capture in pcap format to the bootflash, which can be downloaded and opened in wireshark. Este é um exemplo que explica como o ICMP (Internet Control Message Protocol) simples funciona sobre VXLAN.

Address Resolution Protocol (ARP) enviado sobre a sobreposição de VXLAN:

Resposta ARP:

Solicitação ICMP:

Resposta ICMP:

Comandos adicionais de depuração e solução de problemas

Comandos adicionais de depuração e solução de problemasEsta seção descreve mais alguns comandos de depuração e solução de problemas.

Neste exemplo, as partes destacadas da depuração mostram que a interface NVE não pôde ingressar no grupo multicast. Portanto, o encapsulamento VXLAN não foi ativado para VNI 6002. Esses resultados de depuração apontam para problemas de multicast na rede.

#debug nve all

*Jan 5 06:13:55.844: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:13:55.846: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was failure

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:13:55.851: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:13:55.857: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:13:55.857: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Down

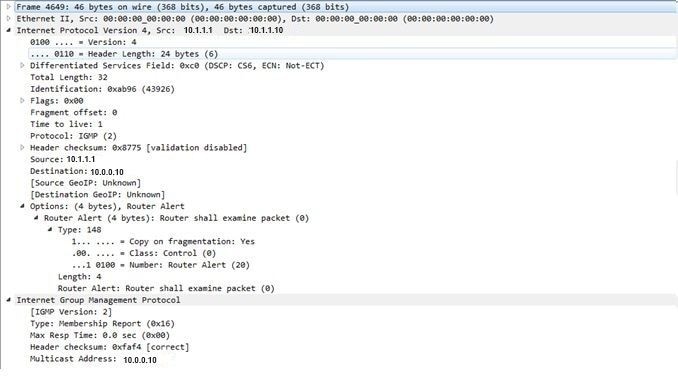

Este é o relatório de associação do Internet Group Management Protocol (IGMP) que pode ser enviado quando o VNI se une ao grupo mcast:

Este exemplo mostra o resultado de depuração esperado depois que você configurar um VNI em NVE para o modo Multicast, se o Multicast estiver funcionando conforme esperado:

*Jan 5 06:19:20.335: NVE-MGR-DB: [IF 0x14]VNI node creation

*Jan 5 06:19:20.335: NVE-MGR-DB: VNI Node created [437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 create notification to PD

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 Create notif successful, map [pd 0x1020017] to [pi 0x437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:19:20.342: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was successful

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:19:20.347: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:19:20.347: NVE-MGR-DB: Return pd_hdl[0x1020017] for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.347: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.351: NVE-MGR-EI: L2FIB query for info 0x437C9B28

*Jan 5 06:19:20.351: NVE-MGR-EI: PP up notification for bd_id 3

*Jan 5 06:19:20.351: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.352: NVE-MGR-STATE: vni 6002: Notify clients of state change Create to Up

*Jan 5 06:19:20.352: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.353: NVE-MGR-PD: VNI 6002 Create to Up State update to PD successful

*Jan 5 06:19:20.353: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: No state change Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: New State as a result of create Up

Informações Relacionadas

Informações Relacionadas Histórico de revisões

| Revisão | Data de publicação | Comentários |

|---|---|---|

2.0 |

04-Dec-2023

|

Recertificação |

1.0 |

03-Nov-2016

|

Versão inicial |

Colaborado por engenheiros da Cisco

- Shambhu MishraEngenheiro do Cisco TAC

Contate a Cisco

- Abrir um caso de suporte

- (É necessário um Contrato de Serviço da Cisco)

Feedback

Feedback