ASAv no modo GoTo (L3) com o uso da versão AVS- ACI 1.2(x)

Opções de download

Linguagem imparcial

O conjunto de documentação deste produto faz o possível para usar uma linguagem imparcial. Para os fins deste conjunto de documentação, a imparcialidade é definida como uma linguagem que não implica em discriminação baseada em idade, deficiência, gênero, identidade racial, identidade étnica, orientação sexual, status socioeconômico e interseccionalidade. Pode haver exceções na documentação devido à linguagem codificada nas interfaces de usuário do software do produto, linguagem usada com base na documentação de RFP ou linguagem usada por um produto de terceiros referenciado. Saiba mais sobre como a Cisco está usando a linguagem inclusiva.

Sobre esta tradução

A Cisco traduziu este documento com a ajuda de tecnologias de tradução automática e humana para oferecer conteúdo de suporte aos seus usuários no seu próprio idioma, independentemente da localização. Observe que mesmo a melhor tradução automática não será tão precisa quanto as realizadas por um tradutor profissional. A Cisco Systems, Inc. não se responsabiliza pela precisão destas traduções e recomenda que o documento original em inglês (link fornecido) seja sempre consultado.

Introdução

Este documento descreve como implantar um switch Application Virtual Switch (AVS) com um único firewall Adaptive Security Virtual Appliance (ASAv) no modo Roteado/GOTO como um Gráfico de Serviço L4-L7 entre dois Grupos de Ponto Final (EPGs) para estabelecer a comunicação cliente-servidor usando a versão ACI 1.2(x).

Pré-requisitos

Requisitos

A Cisco recomenda que você tenha conhecimento destes tópicos:

- Políticas de acesso configuradas e interfaces ativas e em serviço

- EPG, domínio de ponte (BD) e roteamento e encaminhamento virtual (VRF) já configurados

Componentes Utilizados

As informações neste documento são baseadas nestas versões de software e hardware:

Hardware e software:

- UCS C220 - 2.0(6d)

- ESXi/vCenter - 5.5

- ASAv - asa-device-pkg-1.2.4.8

- AVS - 5.2.1.SV3.1.10

- APIC - 1.2(1i)

- Folha/colunas - 11.2(1i)

- Pacotes de dispositivo *.zip já baixados

Recursos:

- AVS

- ASAv

- EPGs, BD, VRF

- Lista de controle de acesso (ACL)

- Gráfico de serviço L4-L7

- vCenter

As informações neste documento foram criadas a partir de dispositivos em um ambiente de laboratório específico. Todos os dispositivos utilizados neste documento foram iniciados com uma configuração (padrão) inicial. Se a rede estiver ativa, certifique-se de que você entenda o impacto potencial de qualquer comando.

Configurar

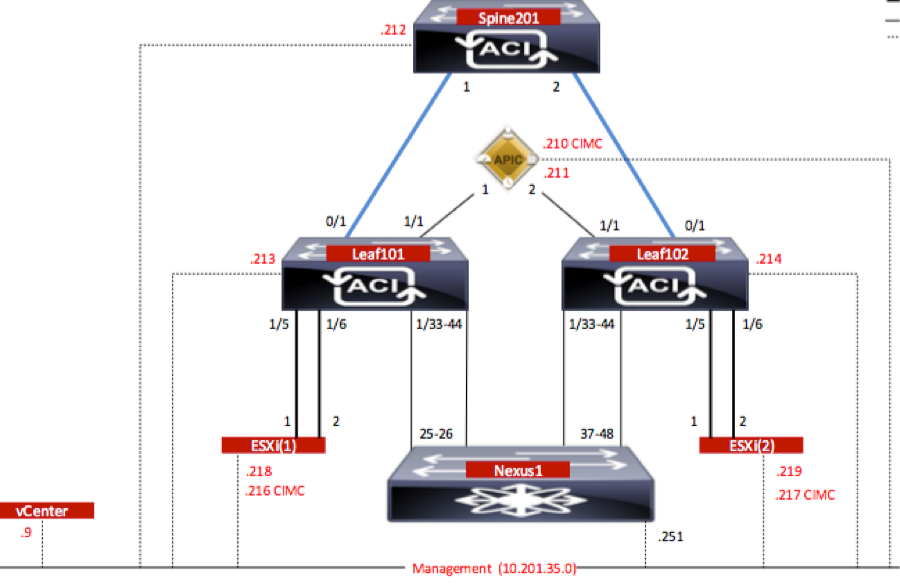

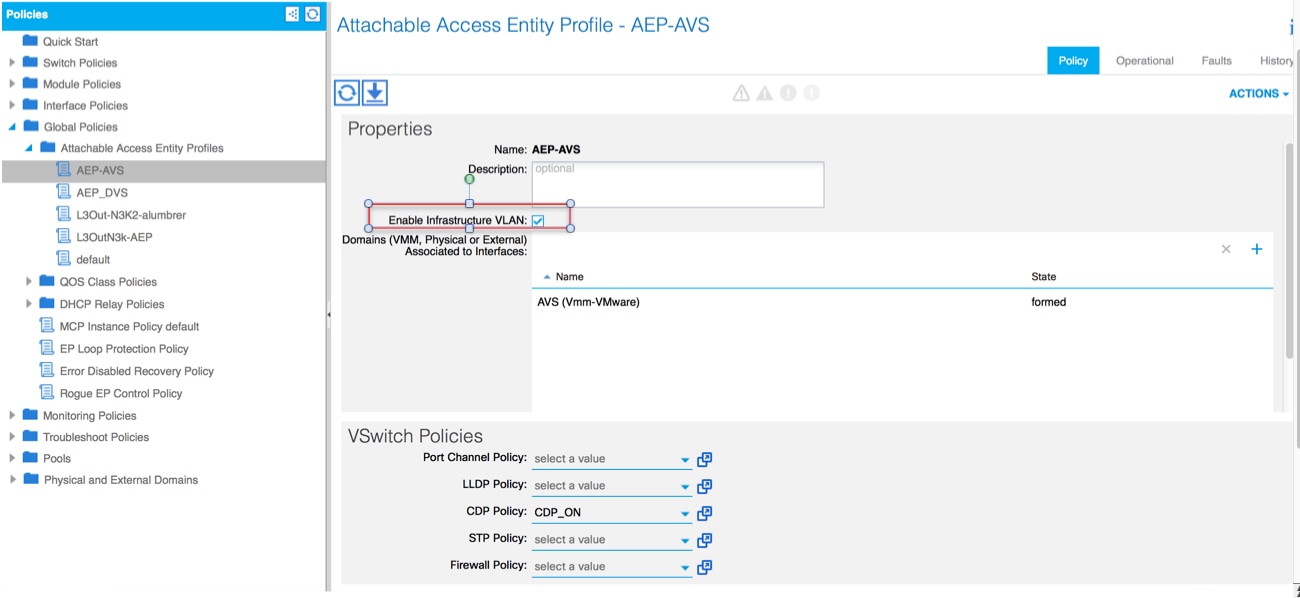

Diagrama de Rede

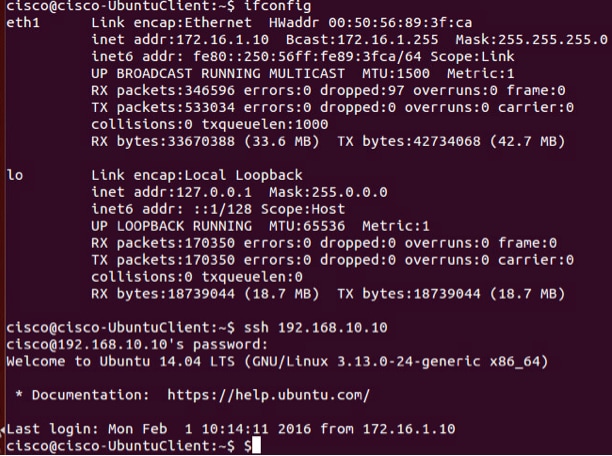

Conforme mostrado na imagem,

Configurações

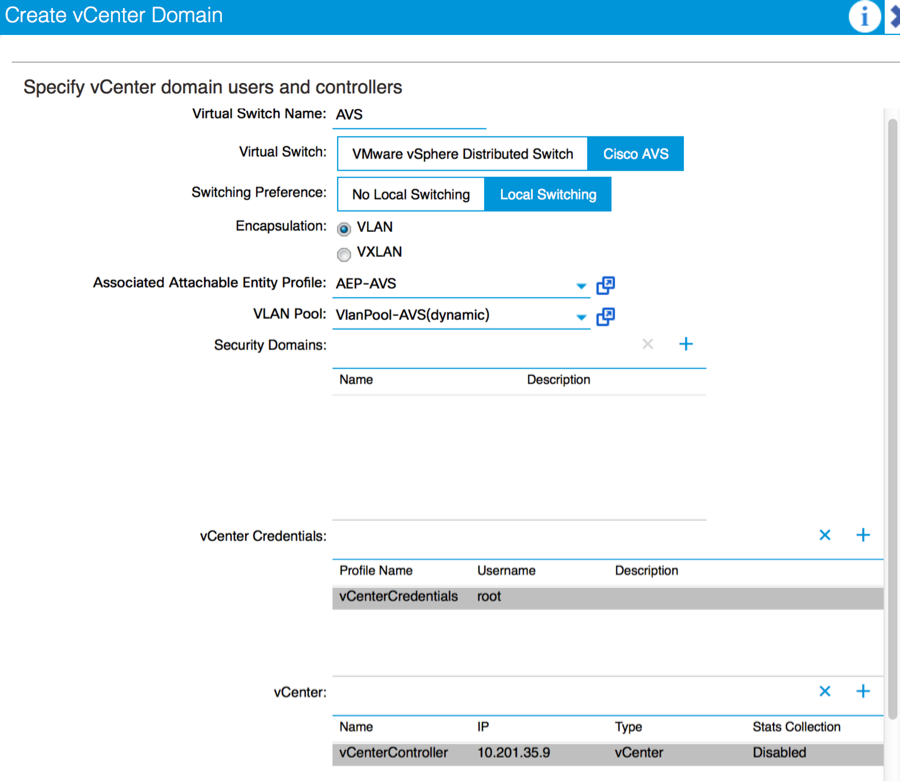

A configuração inicial do AVS cria um VMware vCenter Domain (integração do VMM)2

Note:

- Você pode criar vários datacenters e entradas de Comutador virtual distribuído (DVS) em um único domínio. No entanto, você pode ter apenas um Cisco AVS atribuído a cada datacenter.

- A implantação do gráfico de serviço com o Cisco AVS é suportada pela Cisco ACI Versão 1.2(1i) com o Cisco AVS Versão 5.2(1)SV3(1.10). Toda a configuração do gráfico de serviço é realizada no Cisco Application Policy Infrastructure Controller (Cisco APIC).

- A implantação da máquina virtual (VM) de serviço com o Cisco AVS é suportada apenas em domínios do Virtual Machine Manager (VMM) com modo de encapsulamento de redes locais virtuais (VLAN). No entanto, as VMs de computação (as VMs do provedor e do consumidor) podem fazer parte dos domínios do VMM com Virtual Extensible LAN (VXLAN) ou encapsulamento de VLAN.

- Observe também que, se for usado o switching local, o endereço Multicast e o pool não serão necessários. Se nenhuma comutação local for selecionada, o pool Multicast deverá ser configurado e o endereço multicast de toda a malha AVS não deverá fazer parte do pool Multicast. Todo o tráfego originado do AVS será encapsulado em VLAN ou VXLAN.

Navegue até VM Networking > VMWare > Create vCenter Domain, conforme mostrado na imagem:

Se você estiver usando o canal de porta ou o VPC (canal de porta virtual), é recomendável definir as políticas do vSwitch para usar a Fixação de Mac.

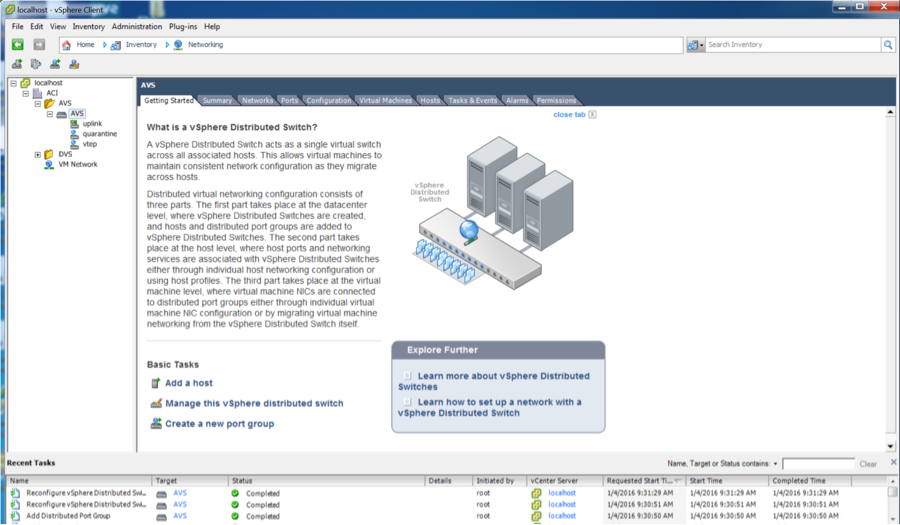

Depois disso, o APIC deve enviar a configuração do switch AVS para o vCenter, como mostrado na imagem:

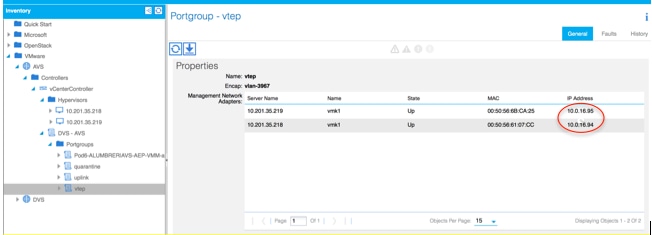

No APIC, você pode observar que um endereço VTEP (VXLAN Tunnel Endpoint) é atribuído ao grupo de portas VTEP para AVS. Esse endereço é atribuído independentemente do modo de conectividade usado (VLAN ou VXLAN)

Instale o software Cisco AVS no vCenter

- Faça o download do vSphere Installation Bundle (VIB) do CCO usando este link

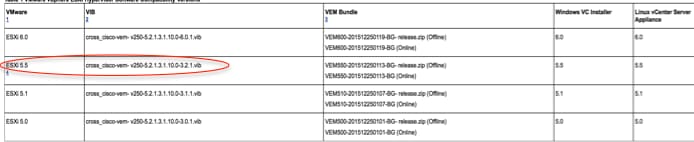

Nota:Nesse caso, estamos usando o ESX 5.5, a Tabela 1 mostra a Matriz de compatibilidade para o ESXi 6.0, 5.5, 5.1 e 5.0

Tabela 1 - Compatibilidade da versão do software do host para ESXi 6.0, 5.5, 5.1 e 5.0

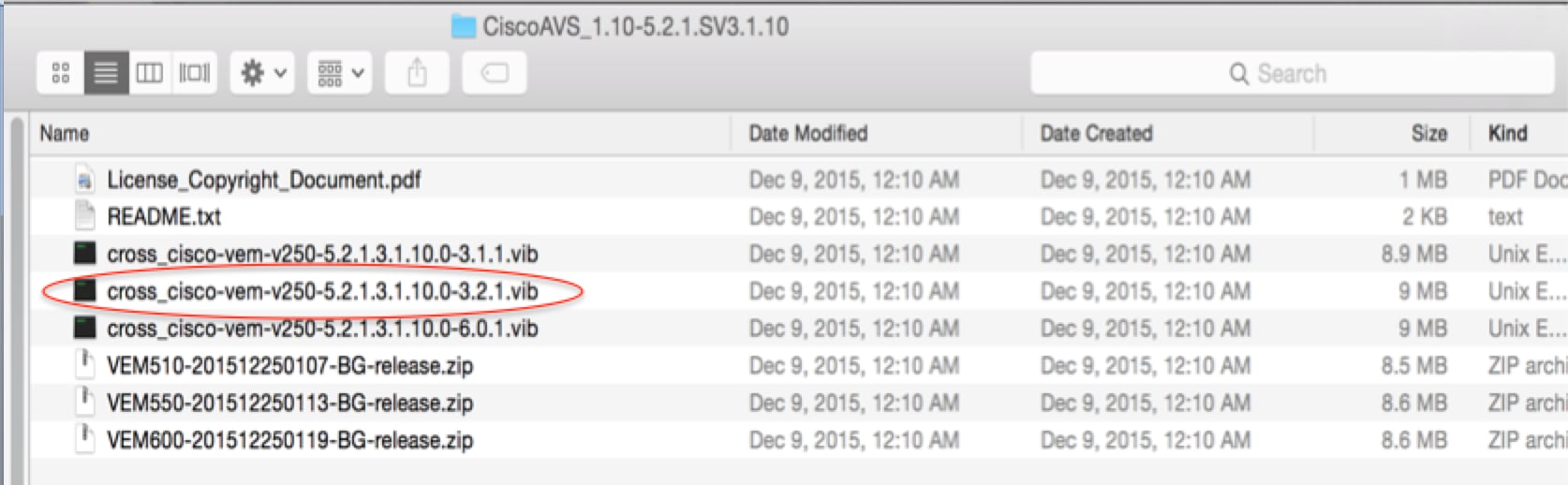

Dentro do arquivo ZIP, há 3 arquivos VIB, um para cada versão do host ESXi, selecione o apropriado para o ESX 5.5, como mostrado na imagem:

- Copie o arquivo VIB para o ESX Datastore - isso pode ser feito via CLI ou diretamente do vCenter

Note: Se houver um arquivo VIB no host, remova-o usando o comando esxcli software vib remove.

esxcli software vib remove -n cross_cisco-vem-v197-5.2.1.3.1.5.0-3.2.1.vib

ou navegando diretamente no datastore.

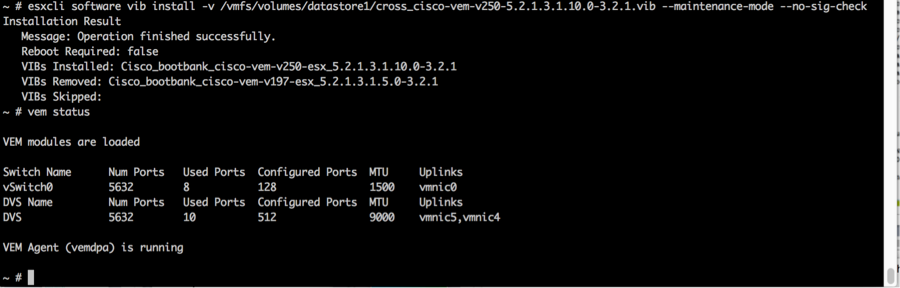

- Instale o software AVS usando o seguinte comando no host ESXi:

esxcli software vib install -v /vmfs/volumes/datastore1/cross_cisco-vem-v250-5.2.1.3.1.10.0-3.2.1.vib —modo de manutenção —no-sig-check

- Quando o módulo Virtual Ethernet (VEM) estiver ativo, você poderá adicionar Hosts ao seu AVS:

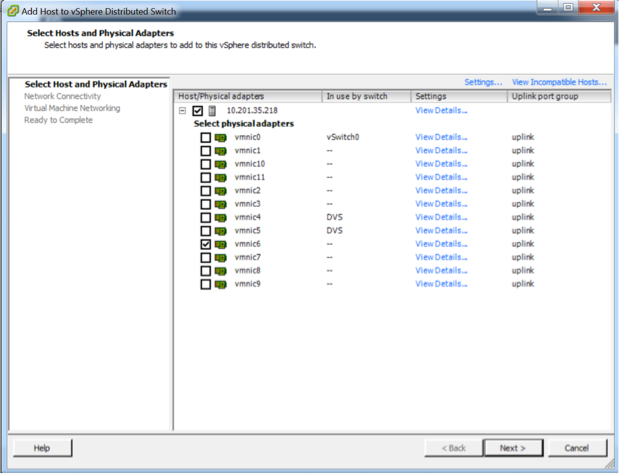

Na caixa de diálogo Add Host to vSphere Distributed Switch, escolha as portas NIC virtuais que estão conectadas ao switch folha (neste exemplo, você move apenas vmnic6), como mostrado na imagem:

- Clique em Next

- Na caixa de diálogo Conectividade de rede, clique em Avançar

- Na caixa de diálogo Rede de máquina virtual, clique em Avançar

- Na caixa de diálogo Pronto para concluir, clique em Concluir

Note: Se vários hosts ESXi forem usados, todos eles precisarão executar o AVS/VEM para que possam ser gerenciados do switch padrão para o DVS ou AVS.

Com isso, a integração AVS foi concluída e estamos prontos para continuar com a implantação do ASAv de L4-L7:

Configuração inicial do ASAv

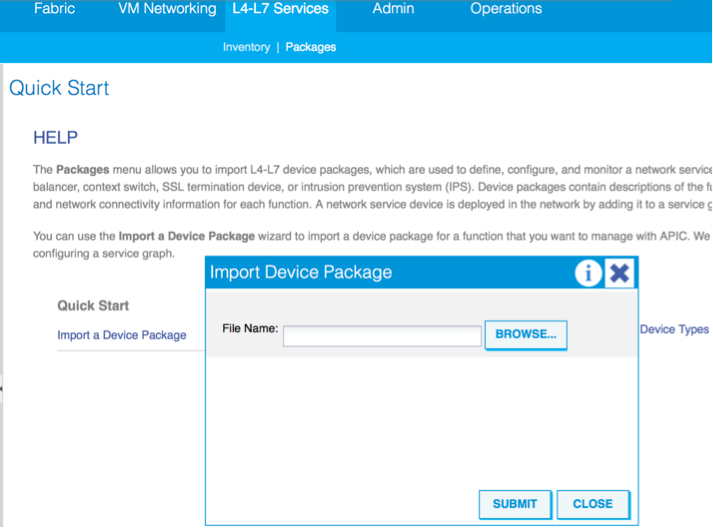

- Faça o download do pacote de dispositivos Cisco ASAv e importe-o para o APIC:

Navegue para Serviços L4-L7 > Pacotes > Importar pacote de dispositivo, como mostrado na imagem:

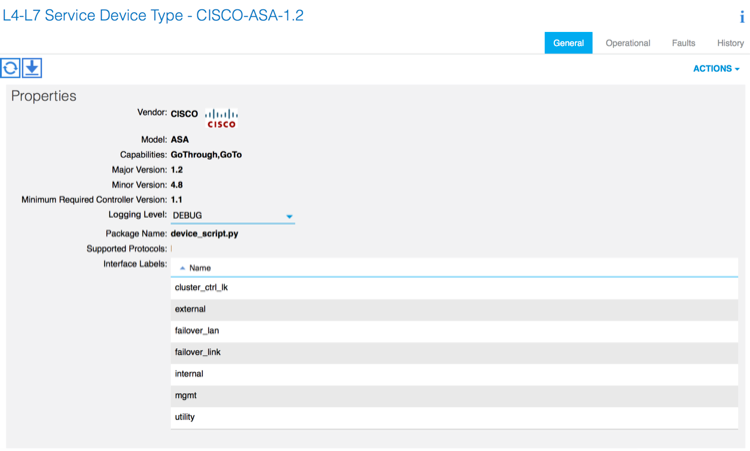

- Se tudo funcionar bem, você pode ver o pacote de dispositivo importado expandindo a pasta L4-L7 Service Device Types, como mostrado na imagem:

Antes de continuar, há alguns aspectos da instalação que precisam ser determinados antes que a integração L4-L7 real seja executada:

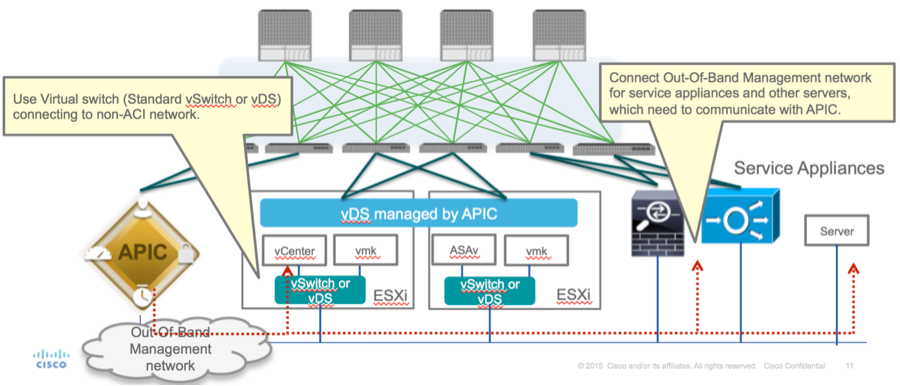

Há dois tipos de redes de gerenciamento, gerenciamento dentro da banda e fora da banda (OOB), que podem ser usados para gerenciar dispositivos que não fazem parte da ACI (Application Centric Infrastructure, infraestrutura centrada em aplicativos) básica (leaf, spines ou controlador apic), que incluiriam ASAv, balanceadores de carga etc.

Nesse caso, o OOB para ASAv é implantado com o uso do vSwitch padrão. Para ASA bare metal ou outros dispositivos de serviço e/ou servidores, conecte a porta de gerenciamento OOB ao switch ou à rede OOB, como mostrado na imagem.

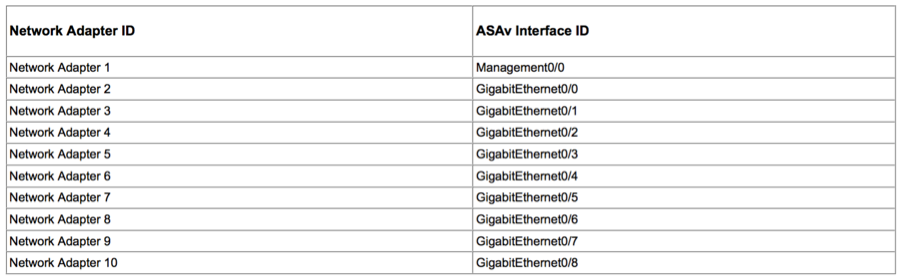

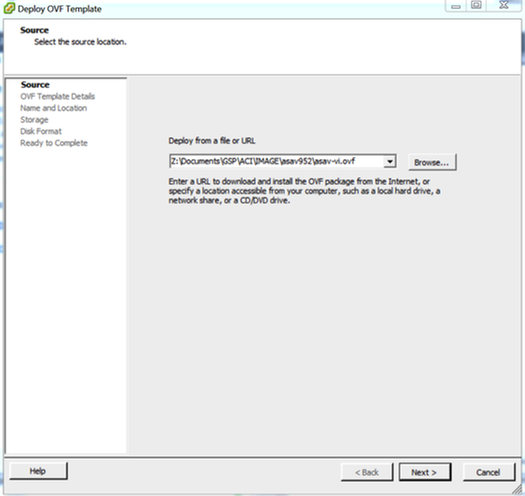

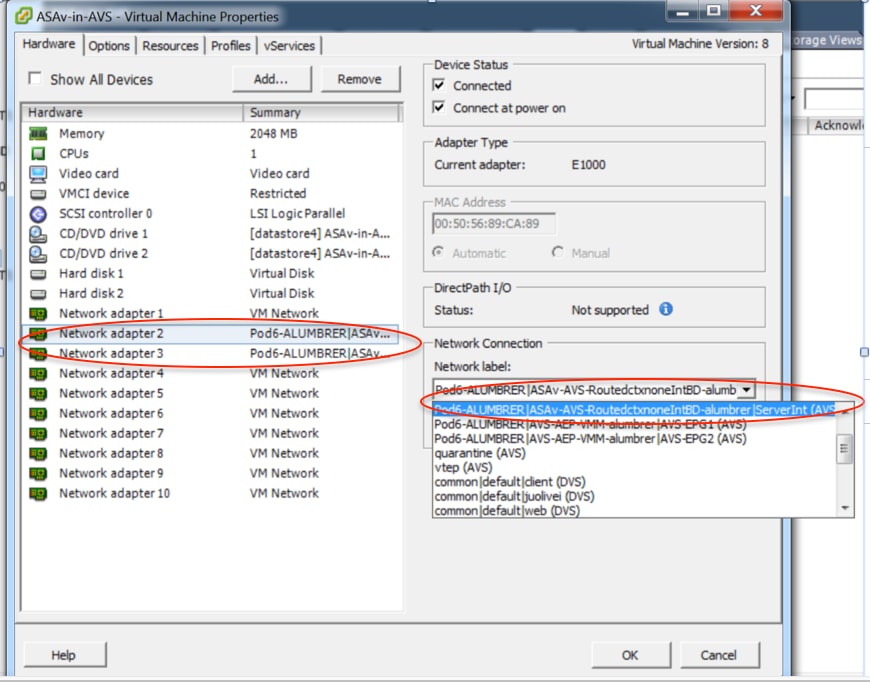

A conexão de gerenciamento de porta do ASAv OOB Mgmt precisa usar portas de uplink ESXi para se comunicar com o APIC via OOB. Ao mapear interfaces vNIC, o adaptador de rede 1 sempre corresponde à interface Management0/0 no ASAv, e o restante das interfaces do plano de dados são iniciadas a partir do adaptador de rede 2.

A Tabela 2 mostra a concordância de IDs de adaptadores de rede e IDs de interface ASAv:

Tabela 2

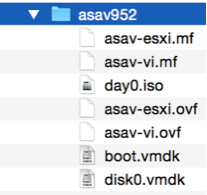

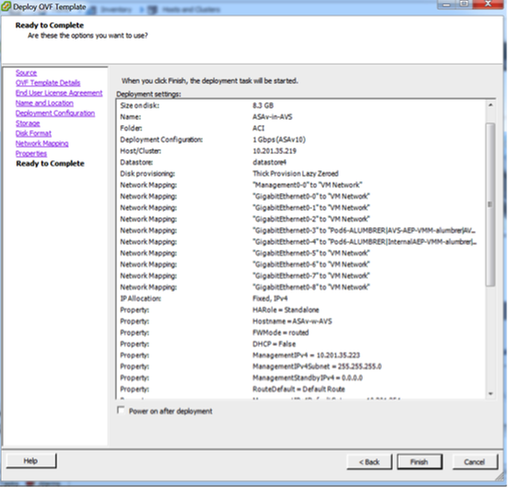

- Implante a ASAv VM através do assistente a partir de File>Deploy OVF (Open Virtualization Format) Template

- Selecione asav-esxi se quiser usar o ESX Server autônomo ou o asav-vi para o vCenter. Nesse caso, o vCenter é usado.

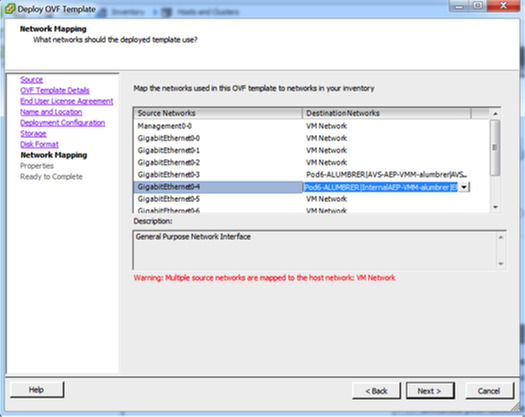

- Vá até o assistente de instalação, aceite os termos e condições. No meio do assistente, você pode determinar várias opções como nome do host, gerenciamento, endereço IP, modo de firewall e outras informações específicas relacionadas ao ASAv. Lembre-se de usar o gerenciamento OOB para ASAv, como neste caso, você precisa manter a interface Management0/0 enquanto você usa a Rede VM (Switch Padrão) e a interface GigabitEthernet0-8 são as portas de rede padrão.

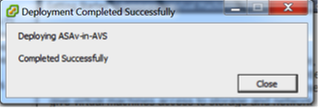

- Clique em Finish e aguarde até que a implantação do ASAv seja concluída

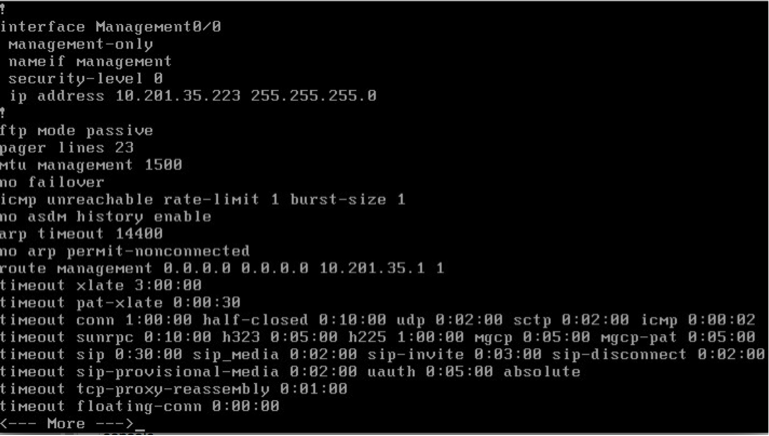

- Ligue sua VM ASAv e faça login via console para verificar a configuração inicial

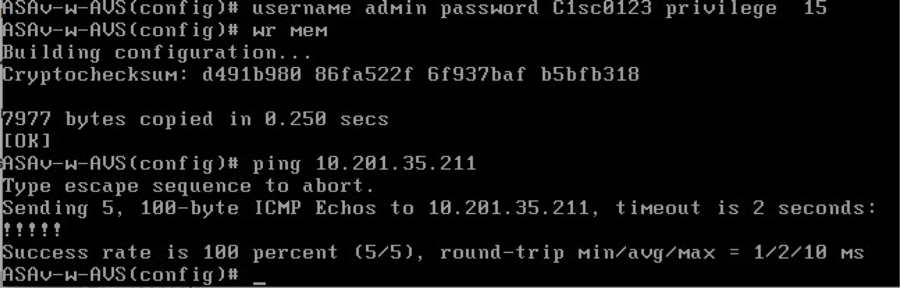

- Como mostrado na imagem, algumas configurações de gerenciamento já foram enviadas para o firewall ASAv. Configure o nome de usuário e a senha do administrador. Esse nome de usuário e senha são usados pelo APIC para fazer login e configurar o ASA. O ASA deve ter conectividade com a rede OOB e deve ser capaz de acessar o APIC.

nome de usuário admin senha <device_password> privilégio criptografado 15

Além disso, no modo de configuração global, habilite o servidor http:

habilitar servidor http

http 0.0.0.0 0.0.0.0 gerenciamento

L4-L7 para integração do ASAv no APIC:

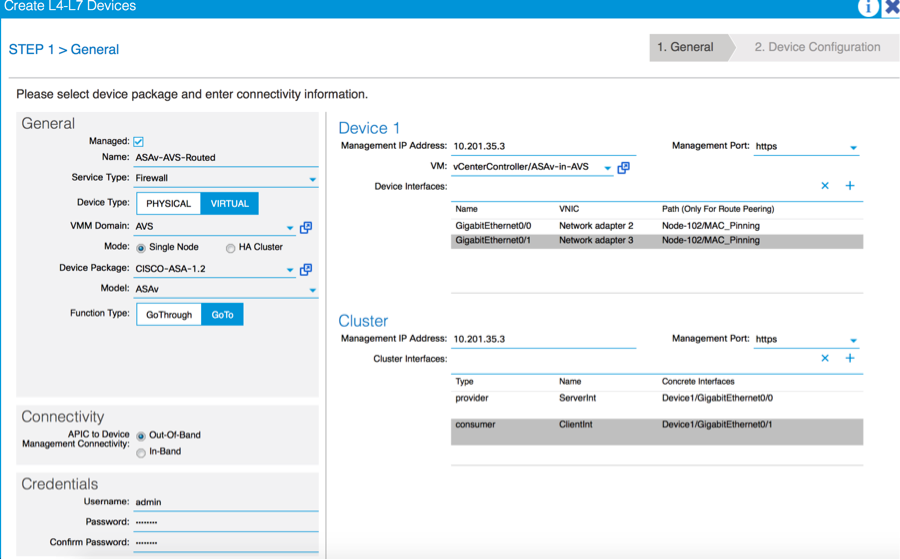

- Faça login na GUI da ACI e clique no Espaço onde o gráfico de serviço será implantado. Expanda os serviços L4-L7 na parte inferior do painel de navegação e clique com o botão direito em Dispositivos L4-L7 e clique em Criar dispositivos L4-L7 para abrir o assistente

-

Para esta implementação, serão aplicadas as seguintes configurações:

- Modo gerenciado

- Serviço de firewall

-Dispositivo virtual

-Conectado ao domínio AVS com um único nó

-Modelo ASAv

- Modo roteado (GoTo)

-Endereço de gerenciamento (deve corresponder ao endereço anteriormente atribuído à interface Mgmt0/0)

- Usar HTTPS como APIC por padrão usa o protocolo mais seguro para se comunicar com ASAv

- A definição correta das interfaces do dispositivo e das interfaces do cluster é essencial para uma implantação bem-sucedida

Para a primeira parte, use a Tabela 2 mostrada na seção anterior para fazer a correspondência correta das IDs de adaptadores de rede com as IDs de interface ASAv que você gostaria de usar. O Caminho se refere à Porta física ou ao canal de porta ou VPC que permite a entrada e saída das interfaces do Firewall. Nesse caso, o ASA está localizado em um host ESX, onde as entradas e saídas são as mesmas para ambas as interfaces. Em um dispositivo físico, dentro e fora do firewall (FW) seriam portas físicas diferentes.

Para a segunda parte, as interfaces de cluster devem ser definidas sempre sem exceções (mesmo se o Cluster HA não for usado), isso ocorre porque o Object Model tem uma associação entre a interface mIf (metainterface no Device Package), a interface LIf (interface de folha como por exemplo, externa, interna, interna, etc.) e a CIf (interface concreta). Os dispositivos concretos L4-L7 precisam ser configurados em um cluster de dispositivos e essa abstração é chamada de dispositivo lógico. O dispositivo lógico tem interfaces lógicas que são mapeadas para interfaces concretas no dispositivo concreto.

Para este exemplo, a seguinte associação será usada:

Gi0/0 = vmnic2 = ServerInt/provedor/servidor > EPG1

Gi0/1 = vmnic3 = ClienteInt/consumidor/cliente > EPG2

Note: Para implantações de failover/HA, o GigabitEthernet 0/8 é pré-configurado como a interface de failover.

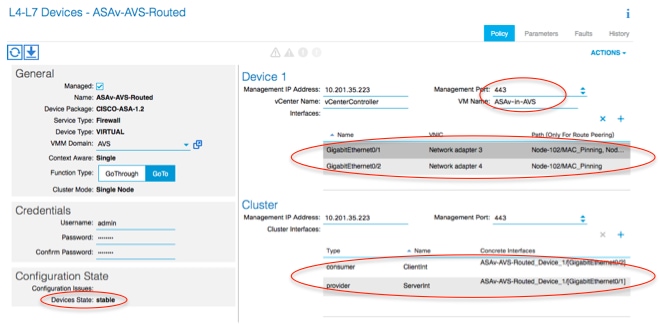

O estado do dispositivo deve ser Estável e você deve estar pronto para implantar o Perfil de função e o Modelo de gráfico de serviço

Templo do Gráfico de Serviço

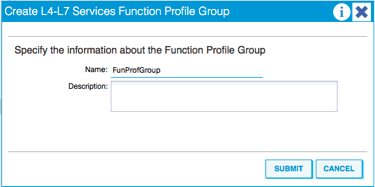

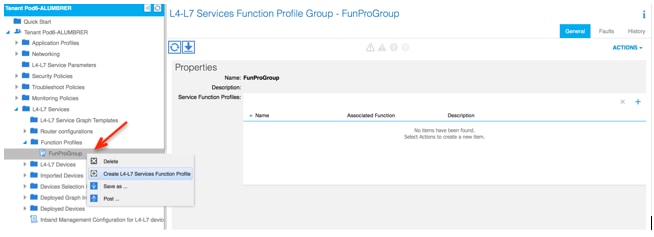

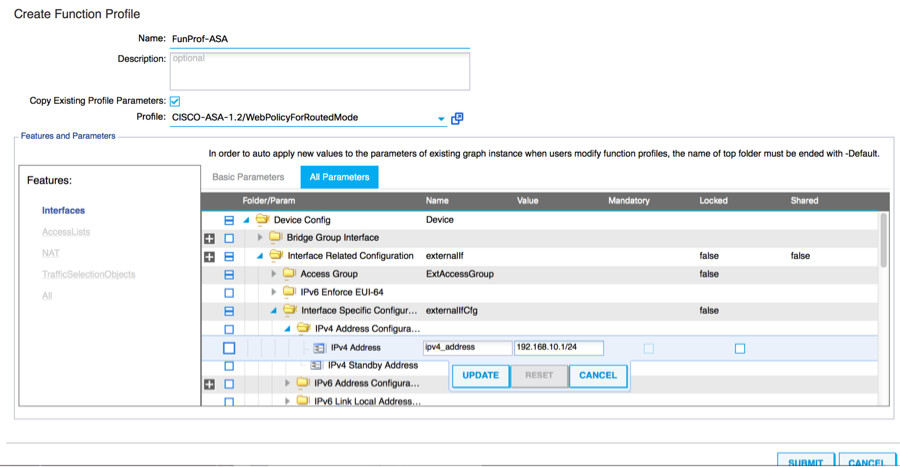

Primeiro, crie um Perfil de função para ASAv, mas antes disso você precisa criar o Grupo de perfil de função e, em seguida, L4-L7 Serviços Perfil de função sob essa pasta, como mostrado na imagem:

- Selecione o perfil WebPolicyForRoutedMode no menu suspenso e continue para configurar as interfaces no firewall. A partir daqui, as etapas são opcionais e podem ser implementadas/modificadas posteriormente. Essas etapas podem ser executadas em diferentes estágios na implantação, dependendo do quão reutilizável ou personalizado o Gráfico de serviços pode ser.

Para este exercício, um firewall roteado (modo GoTo) requer que cada interface tenha um endereço IP exclusivo. A configuração padrão do ASA também tem um nível de segurança de interface (a interface externa é menos segura, a interface interna é mais segura). Você também pode alterar o nome da interface conforme seu requisito. Os padrões são usados neste exemplo.

- Expanda Configuração Específica da Interface, adicione o endereço IP e o nível de segurança para ServerInt com o seguinte formato para o endereço IP x.x.x.x/y.y.y.y ou x.x.x.x/yy. Repita o processo para a interface ClientInt.

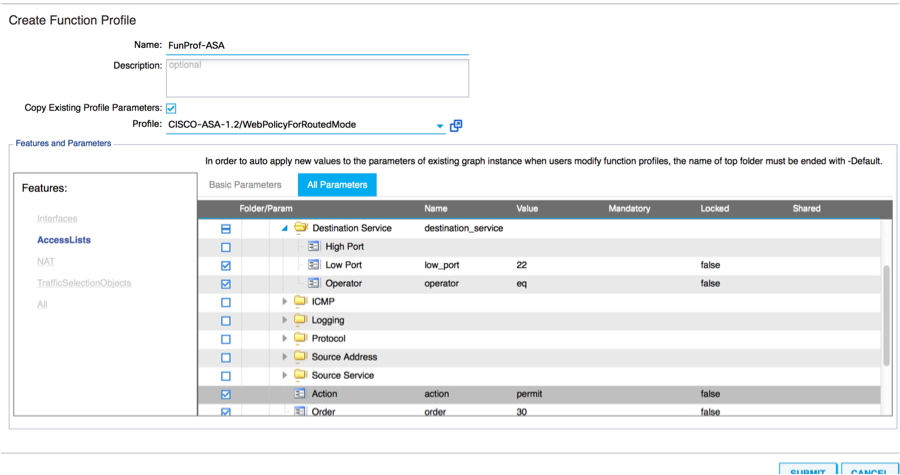

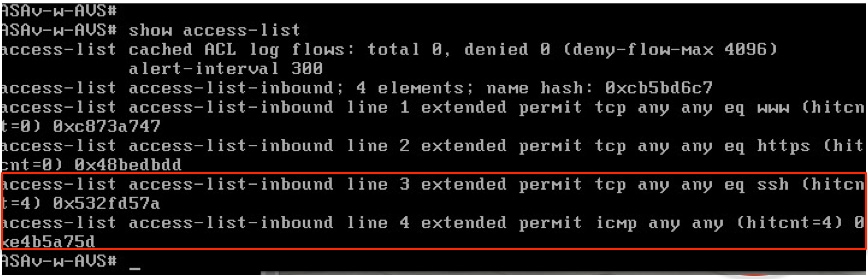

Note: Você também pode modificar as configurações padrão da lista de acesso e criar seu próprio modelo base. Por padrão, o modelo RoutedMode incluirá regras para HTTP e HTTPS. Para este exercício, SSH e ICMP serão adicionados à lista de acesso externo permitido.

- Em seguida, clique em Enviar

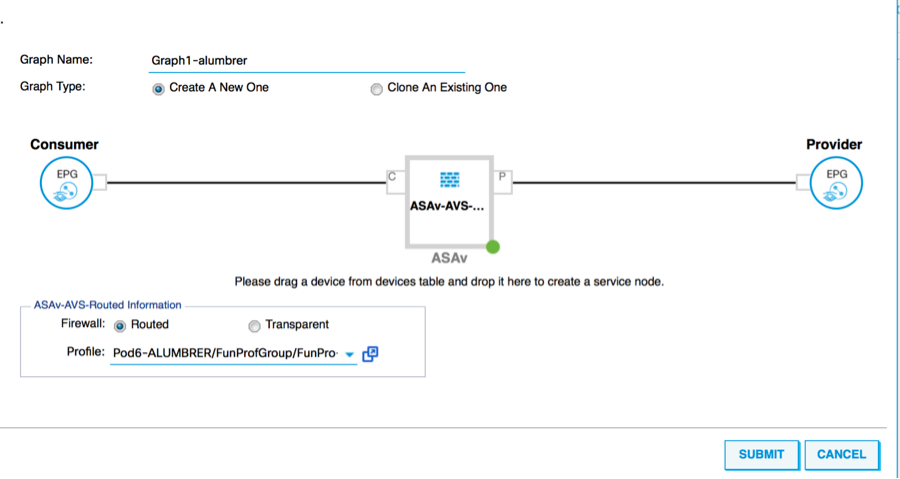

- Agora, crie o Modelo de gráfico de serviço

- Arraste e solte o cluster de dispositivos à direita para formar o relacionamento entre o consumidor e o provedor, selecione Modo roteado e o perfil de função criado anteriormente.

- Verifique se há falhas no modelo. Os modelos são criados para serem reutilizáveis, eles devem ser aplicados a EPGs específicos etc.

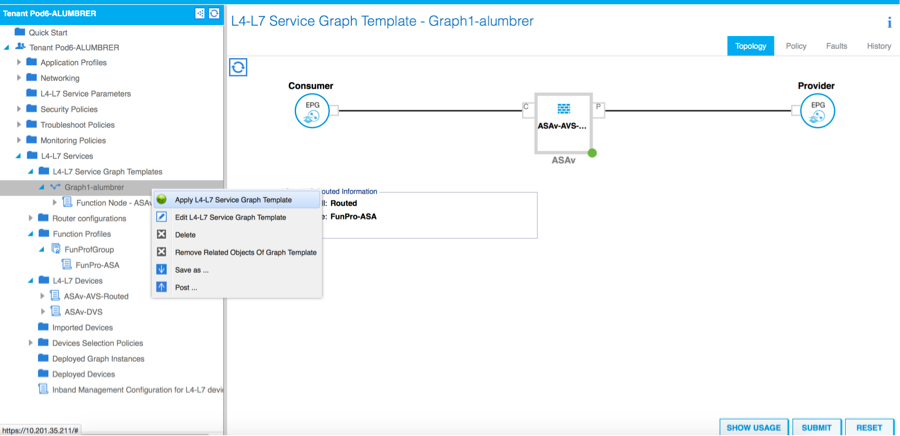

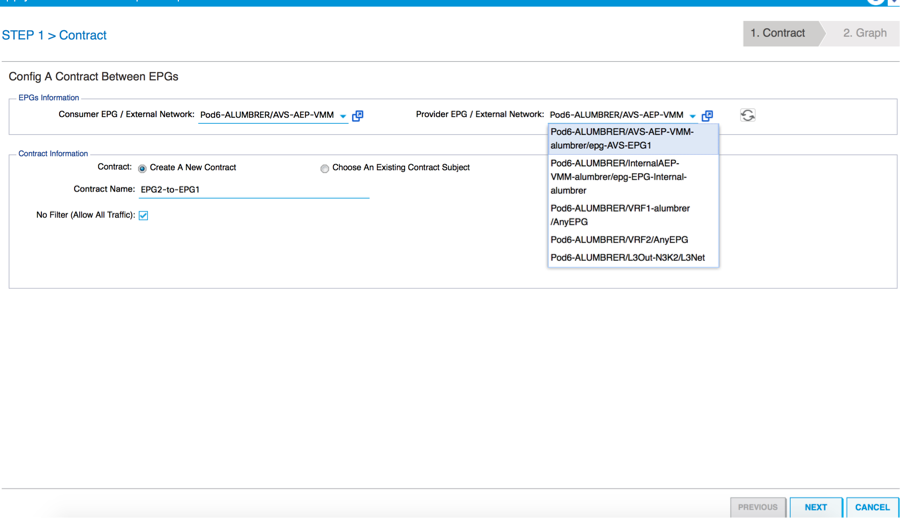

- Para aplicar um modelo, clique com o botão direito e selecione Aplicar modelo de gráfico de serviço L4-L7

- Defina qual EPG ficará do lado do consumidor e do lado do provedor. Neste exercício, AVS-EPG2 é o Consumidor (Cliente) e AVS-EPG1 é o Provedor (servidor). Lembre-se de que nenhum filtro é aplicado, isso permitirá que o firewall faça toda a filtragem com base na lista de acesso definida na última seção deste assistente.

- Clique em Next

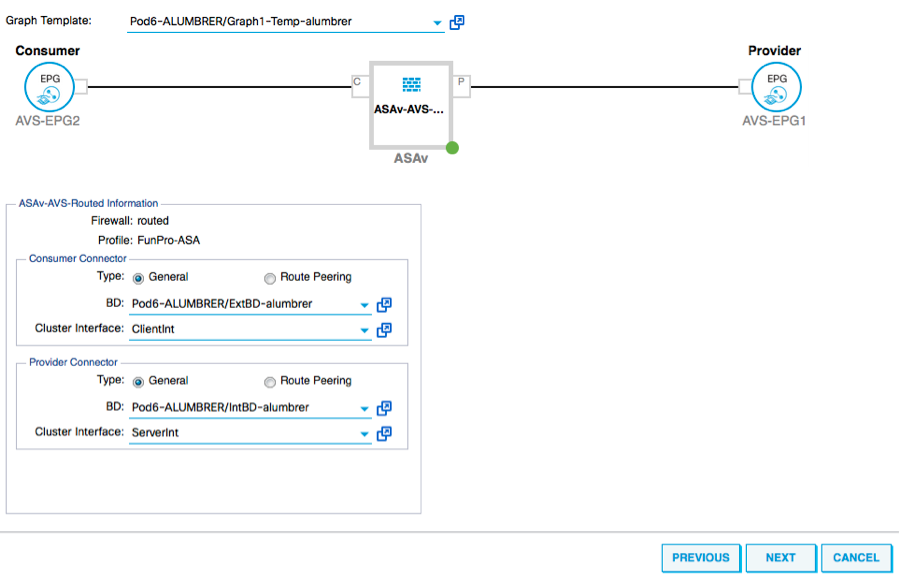

- Verifique as informações de BD para cada EPG. Nesse caso, EPG1 é o provedor no BD IntBD DB e EPG2 é o consumidor no BD ExtBD. O EPG1 se conectará à interface do firewall ServerInt e o EPG2 será conectado à interface ClientInt. Ambas as interfaces FW se tornarão o DG de cada um dos EPGs para que o tráfego seja forçado a atravessar o firewall o tempo todo.

- Clique em Next

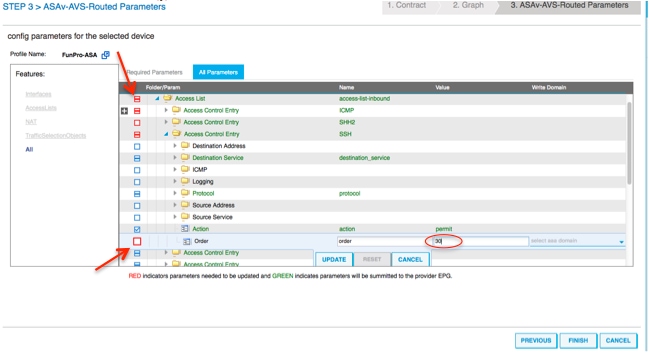

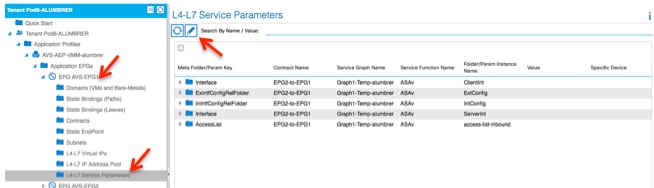

- Na seção Parâmetros de configuração, clique em Todos os parâmetros e verifique se há indicadores VERMELHOS que precisam ser atualizados/configurados. Na saída como mostrado na imagem, pode-se notar que a ordem na lista de acesso está perdida. Isso equivale à ordem de linha que você verá em um show ip access-list X.

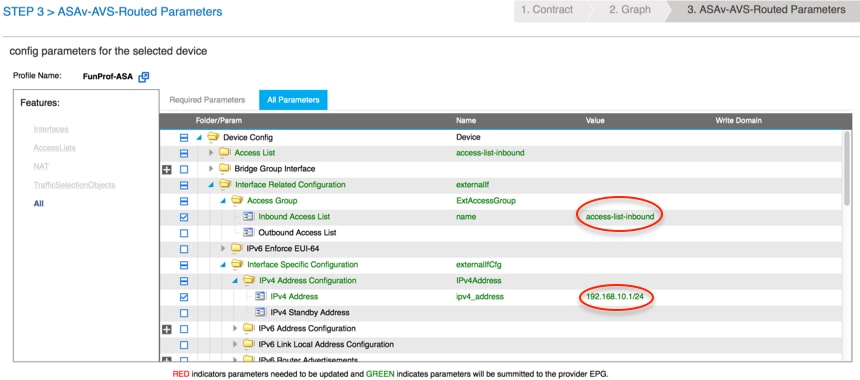

- Você também pode verificar o endereçamento IP atribuído a partir do Perfil de função definido anteriormente. Há uma boa chance de alterar as informações, se necessário. Quando todos os parâmetros estiverem definidos, clique em Finish, como mostrado na imagem:

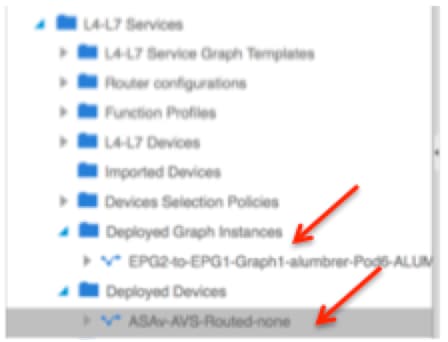

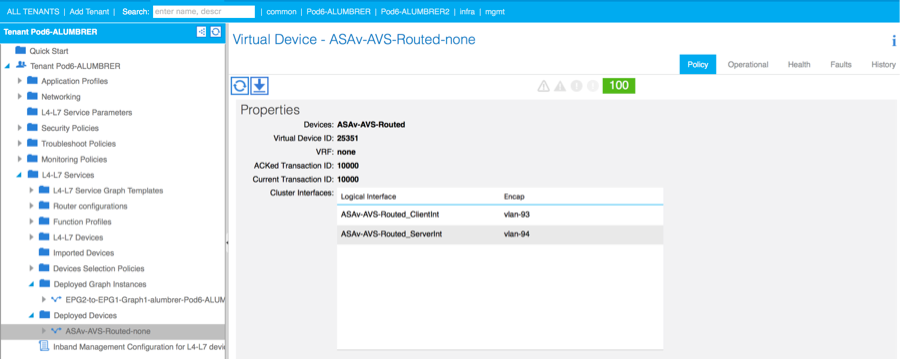

- Se tudo correr bem, um novo dispositivo implantado e uma instância de gráfico devem aparecer.

Verificar

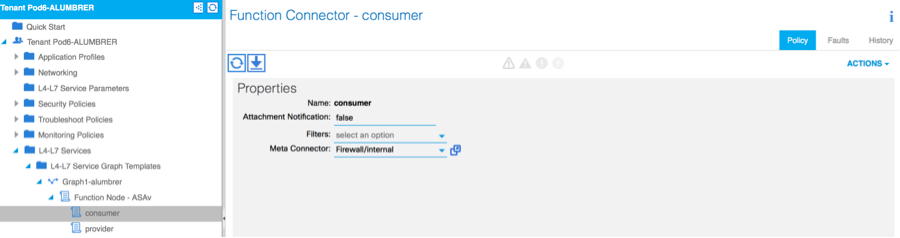

- Uma coisa importante a ser verificada após a criação do gráfico de Serviço é que a relação Consumidor/Provedor foi criada com o Conector Meta apropriado. Verifique em Propriedades do Conector de Função.

Note: Cada interface do Firewall será atribuída com um encap-vlan do pool dinâmico AVS. Verifique se não há falhas.

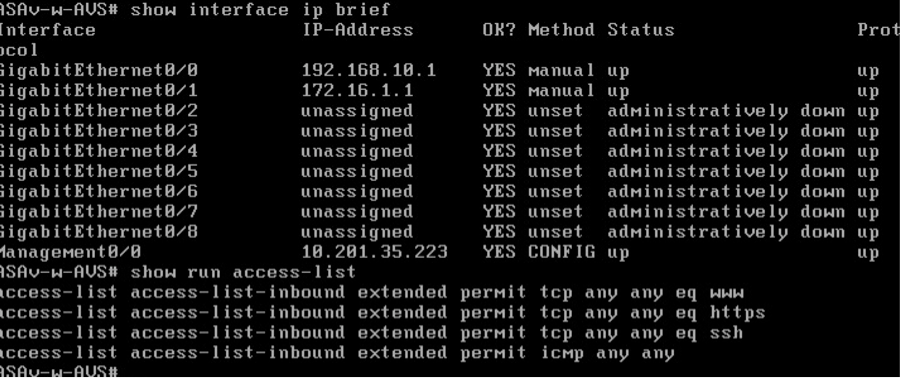

- Agora, você também pode verificar as informações que foram enviadas para o ASAv

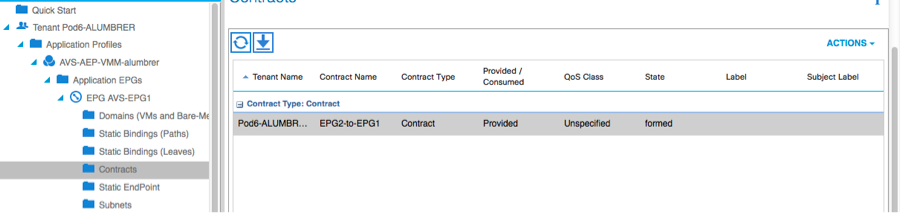

- Um novo contrato é atribuído sob os EPGs. A partir de agora, se você precisar modificar algo na lista de acesso, a alteração deverá ser feita a partir dos parâmetros de serviço L4-L7 do EPG do provedor.

- No vCenter, você também pode verificar se os EPGs de sombra estão atribuídos a cada uma das interfaces FW:

Para este teste, eu tinha os 2 EPGs se comunicando com contratos padrão, esses 2 EPGs estão em domínios diferentes e VRFs diferentes, portanto o vazamento de rota entre eles foi configurado anteriormente. Isso simplifica um pouco após a inserção do Gráfico de serviço, à medida que o FW configura o roteamento e a filtragem entre os 2 EPGs. A DG configurada anteriormente no EPG e no BD agora pode ser removida da mesma forma que os contratos. Somente o contrato enviado pelos L4-L7 deve permanecer sob os EPGs.

À medida que o contrato padrão é removido, você pode confirmar que o tráfego agora flui através do ASAv, o comando show access-list deve exibir a contagem de ocorrências para a regra que aumenta cada vez que o cliente envia uma solicitação ao servidor.

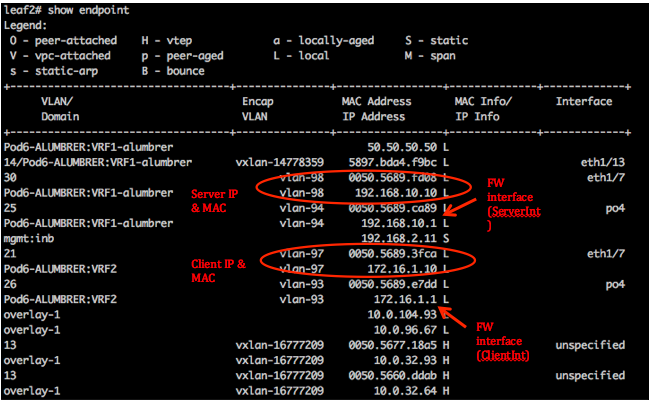

No leaf, os endpoints devem ser aprendidos para as VMs cliente e servidor, bem como para as interfaces ASAv

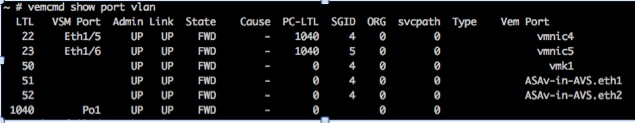

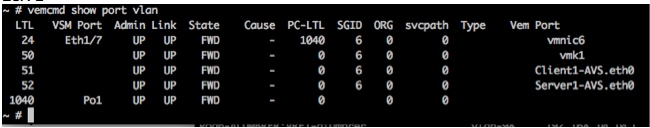

veja as duas interfaces de firewall conectadas ao VEM.

ESX-1

ESX-2

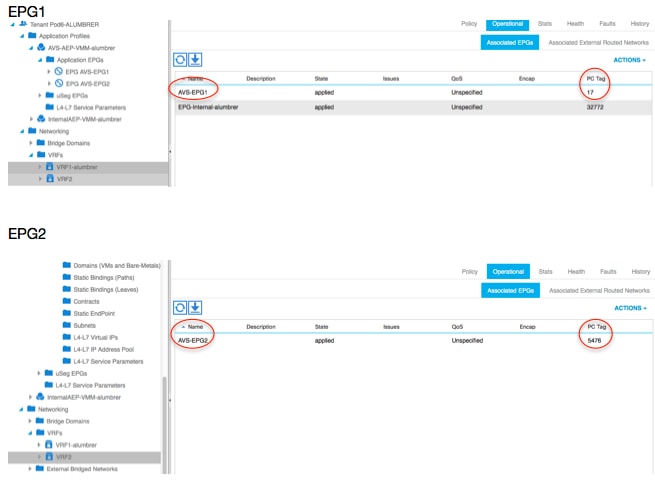

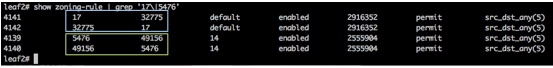

Finalmente, as regras de firewall também podem ser verificadas no nível de folha, se soubermos as marcas do PC para EPGs de origem e destino:

As IDs de filtro podem ser combinadas com as marcas do PC no leaf para verificar as regras do FW.

Note: O EPG PCTags/Sclass nunca se comunica diretamente. A comunicação é interrompida ou vinculada por meio dos EPGs de sombra criados pela inserção do gráfico de serviço L4-L7.

E a comunicação entre cliente e servidor funciona.

Troubleshooting

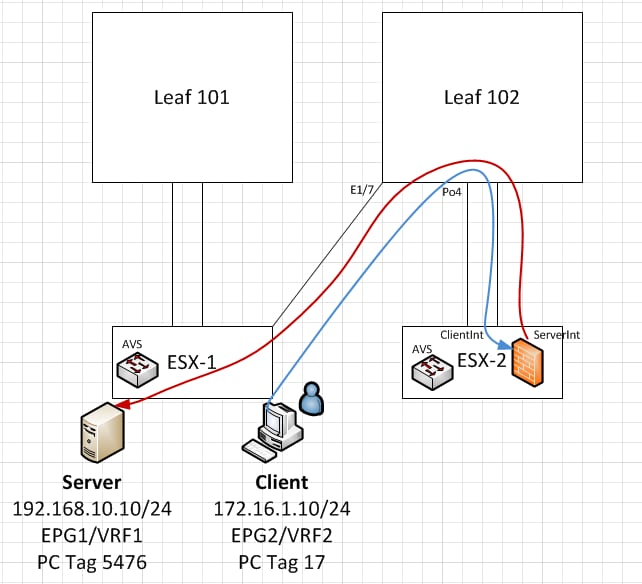

O endereço VTEP não está atribuído

Verifique se Infrastructure Vlan está marcado sob AEP:

Versão sem suporte

Verificar se a versão do VEM está correta e oferecer suporte ao sistema ESXi VMWare apropriado.

~ # vem version Running esx version -1746974 x86_64 VEM Version: 5.2.1.3.1.10.0-3.2.1 OpFlex SDK Version: 1.2(1i) System Version: VMware ESXi 5.5.0 Releasebuild-1746974 ESX Version Update Level: 0

A comunicação de VEM e de estrutura não está funcionando

- Check VEM status vem status - Try reloading or restating the VEM at the host: vem reload vem restart - Check if there’s connectivity towards the Fabric. You can try pinging 10.0.0.30 which is (infra:default) with 10.0.0.30 (shared address, for both Leafs) ~ # vmkping -I vmk1 10.0.0.30 PING 10.0.0.30 (10.0.0.30): 56 data bytes --- 10.0.0.30 ping statistics --- 3 packets transmitted, 0 packets received, 100% packet loss If ping fails, check: - Check OpFlex status - The DPA (DataPathAgent) handles all the control traffic between AVS and APIC (talks to the immediate Leaf switch that is connecting to) using OpFlex (opflex client/agent).

All EPG communication will go thru this opflex connection. ~ # vemcmd show opflex Status: 0 (Discovering) Channel0: 0 (Discovering), Channel1: 0 (Discovering) Dvs name: comp/prov-VMware/ctrlr-[AVS]-vCenterController/sw-dvs-129 Remote IP: 10.0.0.30 Port: 8000 Infra vlan: 3967 FTEP IP: 10.0.0.32 Switching Mode: unknown Encap Type: unknown NS GIPO: 0.0.0.0 you can also check the status of the vmnics at the host level: ~ # esxcfg-vmknic -l Interface Port Group/DVPort IP Family IP Address Netmask Broadcast MAC Address MTU TSO MSS Enabled Type vmk0 Management Network IPv4 10.201.35.219 255.255.255.0 10.201.35.255 e4:aa:5d:ad:06:3e 1500 65535 true STATIC vmk0 Management Network IPv6 fe80::e6aa:5dff:fead:63e 64 e4:aa:5d:ad:06:3e 1500 65535 true STATIC, PREFERRED vmk1 160 IPv4 10.0.32.65 255.255.0.0 10.0.255.255 00:50:56:6b:ca:25 1500 65535 true STATIC vmk1 160 IPv6 fe80::250:56ff:fe6b:ca25 64 00:50:56:6b:ca:25 1500 65535 true STATIC, PREFERRED ~ # - Also on the host, verify if DHCP requests are sent back and forth: ~ # tcpdump-uw -i vmk1 tcpdump-uw: verbose output suppressed, use -v or -vv for full protocol decode listening on vmk1, link-type EN10MB (Ethernet), capture size 96 bytes 12:46:08.818776 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300 12:46:13.002342 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300 12:46:21.002532 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300 12:46:30.002753 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300

Neste ponto, é possível determinar que a comunicação em malha entre o host ESXi e a folha não funciona corretamente. Alguns comandos de verificação podem ser verificados no lado da folha para determinar a causa raiz.

leaf2# show cdp ne

Capability Codes: R - Router, T - Trans-Bridge, B - Source-Route-Bridge

S - Switch, H - Host, I - IGMP, r - Repeater,

V - VoIP-Phone, D - Remotely-Managed-Device,

s - Supports-STP-Dispute

Device-ID Local Intrfce Hldtme Capability Platform Port ID

AVS:localhost.localdomainmain

Eth1/5 169 S I s VMware ESXi vmnic4

AVS:localhost.localdomainmain

Eth1/6 169 S I s VMware ESXi vmnic5

N3K-2(FOC1938R02L)

Eth1/13 166 R S I s N3K-C3172PQ-1 Eth1/13

leaf2# show port-c sum

Flags: D - Down P - Up in port-channel (members)

I - Individual H - Hot-standby (LACP only)

s - Suspended r - Module-removed

S - Switched R - Routed

U - Up (port-channel)

M - Not in use. Min-links not met

F - Configuration failed

-------------------------------------------------------------------------------

Group Port- Type Protocol Member Ports

Channel

-------------------------------------------------------------------------------

5 Po5(SU) Eth LACP Eth1/5(P) Eth1/6(P)Há 2 portas usadas no ESXi conectadas via Po5

leaf2# show vlan extended VLAN Name Status Ports ---- -------------------------------- --------- ------------------------------- 13 infra:default active Eth1/1, Eth1/20 19 -- active Eth1/13 22 mgmt:inb active Eth1/1 26 -- active Eth1/5, Eth1/6, Po5 27 -- active Eth1/1 28 :: active Eth1/5, Eth1/6, Po5 36 common:pod6_BD active Eth1/5, Eth1/6, Po5 VLAN Type Vlan-mode Encap ---- ----- ---------- ------------------------------- 13 enet CE vxlan-16777209, vlan-3967 19 enet CE vxlan-14680064, vlan-150 22 enet CE vxlan-16383902 26 enet CE vxlan-15531929, vlan-200 27 enet CE vlan-11 28 enet CE vlan-14 36 enet CE vxlan-15662984A partir da saída acima, pode-se observar que a Infra Vlan não é permitida ou não passa pelas portas Uplinks que vão para o host ESXi (1/5-6). Isso indica um erro de configuração com a política de interface ou política de switch configurada no APIC.

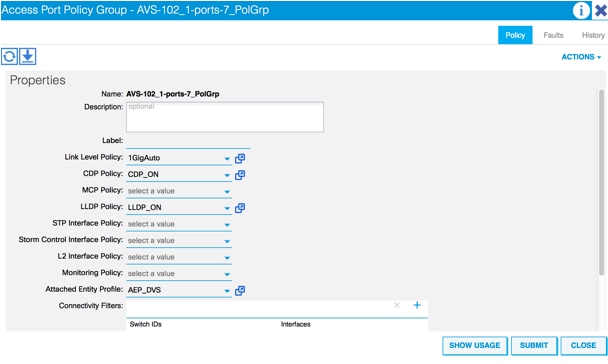

Marque ambos:

Políticas de acesso > Políticas de interface > Políticas de acesso de perfis > Políticas de switch > Perfis

Nesse caso, os perfis de interface são anexados ao AEP errado (o antigo AEP usado para DVS), como mostrado na imagem:

Após a definição do AEP correto para AVS, podemos ver que a Infra Vlan é vista através dos deslinks apropriados na folha:

leaf2# show vlan extended

VLAN Name Status Ports

---- -------------------------------- --------- -------------------------------

13 infra:default active Eth1/1, Eth1/5, Eth1/6,

Eth1/20, Po5

19 -- active Eth1/13

22 mgmt:inb active Eth1/1

26 -- active Eth1/5, Eth1/6, Po5

27 -- active Eth1/1

28 :: active Eth1/5, Eth1/6, Po5

36 common:pod6_BD active Eth1/5, Eth1/6, Po5

VLAN Type Vlan-mode Encap

---- ----- ---------- -------------------------------

13 enet CE vxlan-16777209, vlan-3967

19 enet CE vxlan-14680064, vlan-150

22 enet CE vxlan-16383902

26 enet CE vxlan-15531929, vlan-200

27 enet CE vlan-11

28 enet CE vlan-14

36 enet CE vxlan-15662984

and Opflex connection is restablised after restarting the VEM module:

~ # vem restart

stopDpa

VEM SwISCSI PID is

Warn: DPA running host/vim/vimuser/cisco/vem/vemdpa.213997

Warn: DPA running host/vim/vimuser/cisco/vem/vemdpa.213997

watchdog-vemdpa: Terminating watchdog process with PID 213974

~ # vemcmd show opflex

Status: 0 (Discovering)

Channel0: 14 (Connection attempt), Channel1: 0 (Discovering)

Dvs name: comp/prov-VMware/ctrlr-[AVS]-vCenterController/sw-dvs-129

Remote IP: 10.0.0.30 Port: 8000

Infra vlan: 3967

FTEP IP: 10.0.0.32

Switching Mode: unknown

Encap Type: unknown

NS GIPO: 0.0.0.0

~ # vemcmd show opflex

Status: 12 (Active)

Channel0: 12 (Active), Channel1: 0 (Discovering)

Dvs name: comp/prov-VMware/ctrlr-[AVS]-vCenterController/sw-dvs-129

Remote IP: 10.0.0.30 Port: 8000

Infra vlan: 3967

FTEP IP: 10.0.0.32

Switching Mode: LS

Encap Type: unknown

NS GIPO: 0.0.0.0

Informações Relacionadas

Instalação do Comutador Virtual do Aplicativo

Cisco Systems, Inc. Guia de instalação do switch virtual de aplicativos da Cisco, versão 5.2(1)SV3(1.2)Implante o ASAv usando o VMware

Cisco Systems, Inc. Guia de início rápido do Cisco Adaptive Security Virtual Appliance (ASAv), 9.4

White paper sobre o design do gráfico de serviços com a infraestrutura centrada em aplicativos da Cisco

Histórico de revisões

| Revisão | Data de publicação | Comentários |

|---|---|---|

1.0 |

11-Apr-2016

|

Versão inicial |

Colaborado por engenheiros da Cisco

- Aida LumbrerasEngenheiro de serviços avançados da Cisco

Contate a Cisco

- Abrir um caso de suporte

- (É necessário um Contrato de Serviço da Cisco)

Feedback

Feedback