Problemen oplossen met Firepower Threat Defense (FTD)-cluster

Downloadopties

Inclusief taalgebruik

De documentatie van dit product is waar mogelijk geschreven met inclusief taalgebruik. Inclusief taalgebruik wordt in deze documentatie gedefinieerd als taal die geen discriminatie op basis van leeftijd, handicap, gender, etniciteit, seksuele oriëntatie, sociaaleconomische status of combinaties hiervan weerspiegelt. In deze documentatie kunnen uitzonderingen voorkomen vanwege bewoordingen die in de gebruikersinterfaces van de productsoftware zijn gecodeerd, die op het taalgebruik in de RFP-documentatie zijn gebaseerd of die worden gebruikt in een product van een externe partij waarnaar wordt verwezen. Lees meer over hoe Cisco gebruikmaakt van inclusief taalgebruik.

Over deze vertaling

Cisco heeft dit document vertaald via een combinatie van machine- en menselijke technologie om onze gebruikers wereldwijd ondersteuningscontent te bieden in hun eigen taal. Houd er rekening mee dat zelfs de beste machinevertaling niet net zo nauwkeurig is als die van een professionele vertaler. Cisco Systems, Inc. is niet aansprakelijk voor de nauwkeurigheid van deze vertalingen en raadt aan altijd het oorspronkelijke Engelstalige document (link) te raadplegen.

Inhoud

Inleiding

In dit document wordt beschreven hoe problemen met een clusterconfiguratie in de Next-Generation Firewall (NGFW) van Firepower kunnen worden opgelost.

Voorwaarden

Vereisten

Cisco raadt u aan kennis te hebben van deze onderwerpen (zie de sectie Verwante informatie voor links):

- Firepower-platformarchitectuur

- Configuratie en werking van Firepower Cluster

- Bekendheid met de FTD en Firepower Extensible Operating System (FXOS) CLI

- Logboeken NGFW/gegevensvlak

- NGFW/data plane packet-tracer

- FXOS/gegevensvlak vastleggen

Gebruikte componenten

- HW: Firepower 4125

- SW: 6.7.0 (Build 65) – gegevensvlak 9.15(1)

De informatie in dit document is gebaseerd op de apparaten in een specifieke laboratoriumomgeving. Alle apparaten die in dit document worden beschreven, hadden een opgeschoonde (standaard)configuratie. Als uw netwerk live is, moet u zorgen dat u de potentiële impact van elke opdracht begrijpt.

Achtergrondinformatie

De meeste items die in dit document worden behandeld, zijn ook volledig van toepassing op de probleemoplossing van het cluster Adaptive Security Appliance (ASA).

Configureren

Het configuratiegedeelte van een clusterimplementatie wordt behandeld in de configuratiehandleidingen van de FMC en FXOS:

- Clustering voor de verdediging tegen vuurkracht

- Een cluster implementeren voor Firepower Threat Defense voor schaalbaarheid en hoge beschikbaarheid

Basisprincipes clusters

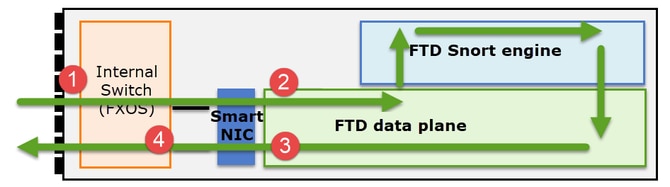

NGFW-architectuur

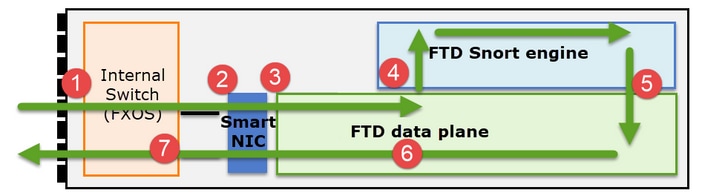

Het is belangrijk om te begrijpen hoe een Firepower 41xx- of 93xx-reeks met doorvoerpakketten omgaat:

- Een pakket komt de ingangsinterface binnen en wordt afgehandeld door de interne switch van het chassis.

- Het pakket gaat via de Smart NIC. Als de stroom wordt uitgeladen (HW-versnelling), wordt het pakket alleen door de Smart NIC afgehandeld en vervolgens teruggestuurd naar het netwerk.

- Als het pakket niet wordt gelost, komt het in het FTD-gegevensvlak dat voornamelijk L3 / L4-controles uitvoert.

- Als het beleid dit vereist, wordt het pakket geïnspecteerd door de Snort-motor (voornamelijk L7-inspectie).

- De Snort-engine geeft een oordeel (bijvoorbeeld toestaan of blokkeren) voor het pakket.

- Het gegevensvlak laat het pakket vallen of doorsturen op basis van het oordeel van Snort.

- Het pakket verlaat het chassis via de interne switch van het chassis.

Clusteropnamen

Vuurkrachtapparaten bieden meerdere opnamepunten die zicht bieden op de doorvoerstromen. Wanneer u problemen oplost en clustervastleggingen inschakelt, zijn de belangrijkste uitdagingen:

- Het aantal opnames neemt toe naarmate het aantal eenheden in het cluster toeneemt.

- U moet zich bewust zijn van de manier waarop het cluster een specifieke stroom verwerkt om het pakket door het cluster te kunnen volgen.

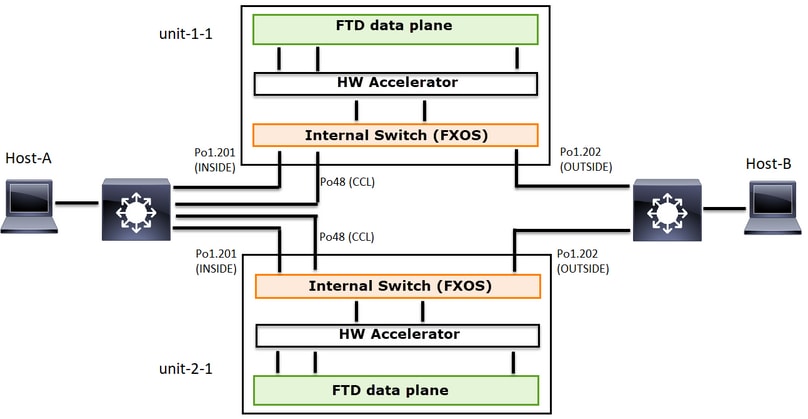

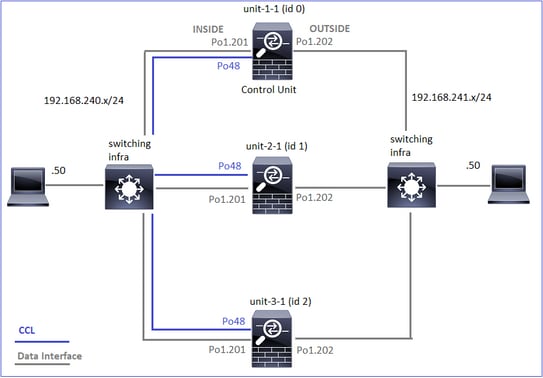

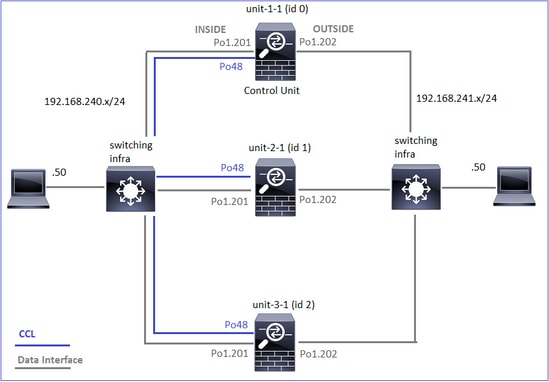

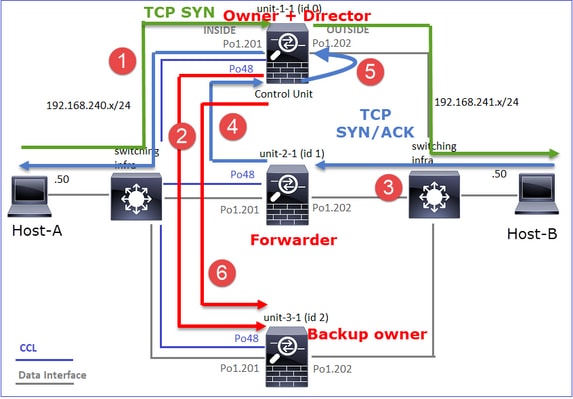

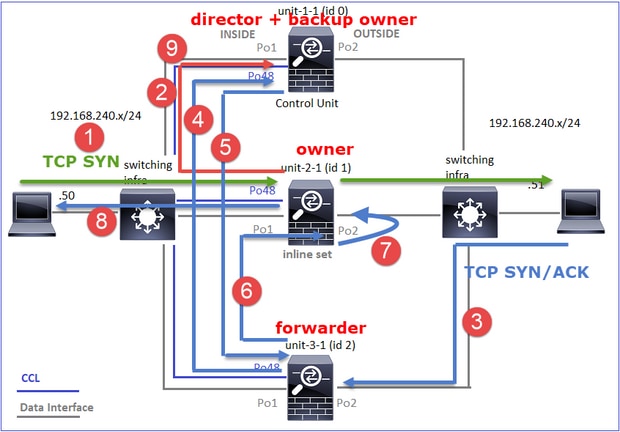

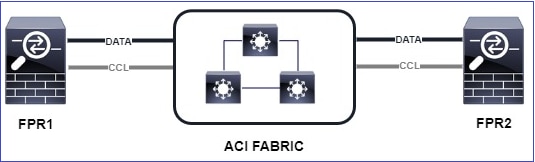

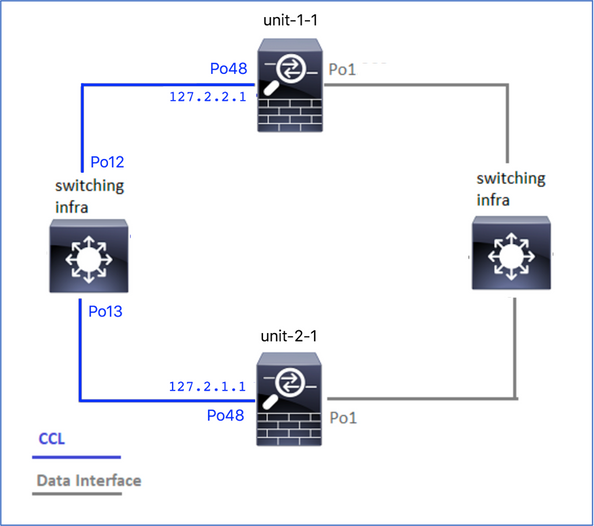

Dit diagram toont een cluster met 2 eenheden (bijvoorbeeld FP941xx/FP9300):

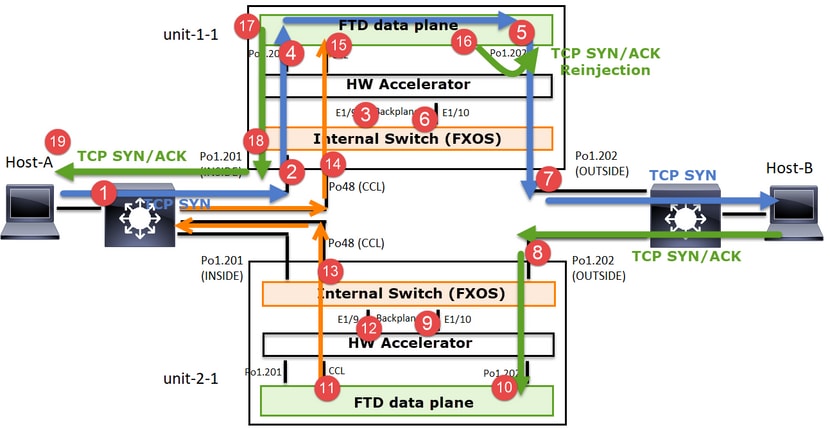

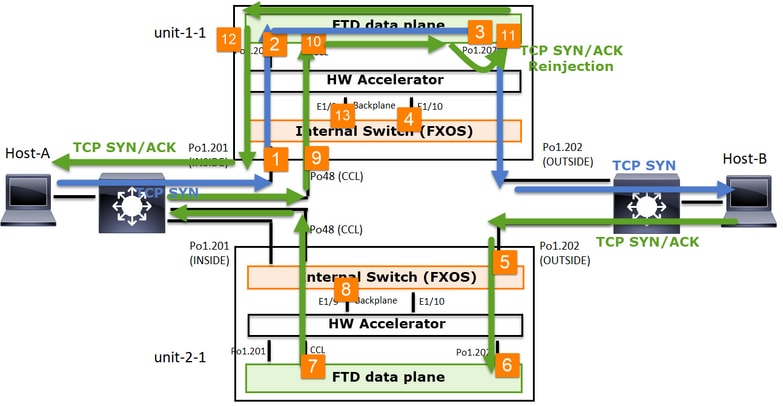

In het geval van een asymmetrische TCP-verbinding ziet een TCP SYN, SYN/ACK-uitwisseling er als volgt uit:

Voorwaarts verkeer:

- TCP-SYN wordt verzonden van host-A naar host-B.

- TCP SYN arriveert op het chassis (een van de leden van Po1).

- TCP SYN wordt via een van de backplaneinterfaces van het chassis (bijvoorbeeld E1/9, E1/10, enz.) naar het gegevensvlak verzonden.

- TCP SYN arriveert op de ingangsinterface van het gegevensvlak (Po1.201/INSIDE). In dit voorbeeld neemt unit1-1 het eigendom van de stroom, doet Initial Sequence Number (ISN) randomisatie en codeert de eigendoms (cookie) informatie in Seq-nummer.

- TCP SYN wordt verzonden vanuit Po1.202/OUTSIDE (data plane egress interface).

- TCP SYN arriveert op een van de backplane-interfaces van het chassis (bijvoorbeeld E1/9, E1/10, enz.).

- TCP SYN wordt vanuit de fysieke interface van het chassis (een van de leden van Po1) naar Host-B gestuurd.

Terugkeerverkeer:

- TCP SYN/ACK wordt verzonden vanaf Host-B en arriveert op unit-2-1 (een van de leden van Po1).

- TCP SYN/ACK wordt via een van de backplane-interfaces van het chassis (bijvoorbeeld E1/9, E1/10, enz.) naar het gegevensvlak verzonden.

- TCP SYN/ACK arriveert op de ingangsinterface van het gegevensvlak (Po1.202/OUTSIDE).

- TCP SYN/ACK wordt verzonden vanuit Cluster Control Link (CCL) naar unit-1-1. ISN is standaard ingeschakeld. Zo vindt de expediteur de eigenaarsinfo voor TCP SYN+ACK's zonder de betrokkenheid van de directeur. Voor andere pakketten of wanneer ISN is uitgeschakeld, wordt de regisseur gevraagd.

- TCP SYN/ACK arriveert op een van de backplane-interfaces van het chassis (bijvoorbeeld E1/9, E1/10, enzovoort).

- TCP SYN/ACK wordt vanuit de fysieke interface van het chassis (een van de leden van Po48) naar unit-1-1 gestuurd.

- TCP SYN/ACK arriveert op unit-1-1 (een van de leden van Po48).

- TCP SYN/ACK wordt via een van de backplane-interfaces van het chassis doorgestuurd naar de CCL-poort-kanaalinterface (nameif cluster) van het gegevensvlak.

- Het gegevensvlak injecteert het TCP SYN/ACK-pakket opnieuw in de interface van het gegevensvlak Po1.202/OUTSIDE.

- TCP SYN/ACK wordt verzonden vanuit Po1.201/INSIDE (data plane egress interface) naar HOST-A.

- De TCP SYN/ACK doorkruist een van de backplane-interfaces van het chassis (bijvoorbeeld E1/9, E1/10, enz.) en schakelt een van de leden van Po1 uit.

- TCP SYN/ACK komt op Host-A.

Lees voor meer informatie over dit scenario het gerelateerde gedeelte in de casestudy's van de vestiging van clusterverbindingen.

Op basis van deze pakketuitwisseling zijn alle mogelijke clusteropnamepunten:

Voor het voorwaartse verkeer (bijvoorbeeld TCP SYN) vastleggen op:

- De fysieke interface van het chassis (bijvoorbeeld Po1-leden). Deze opname wordt geconfigureerd vanuit de Chassis Manager (CM) UI of de CM CLI.

- Interface voor gegevensinvoer (bijvoorbeeld Po1.201 INSIDE).

- Gegevensvlak uitgang interface (bijvoorbeeld Po1.202 BUITEN).

- Chassis backplane-interfaces. Op FP4100 zijn er 2 backplane interfaces. Op FP9300 zijn er in totaal 6 (2 per module). Aangezien u niet weet in welke interface het pakket arriveert, moet u het vastleggen op alle interfaces inschakelen.

Voor het retourverkeer (bijvoorbeeld TCP SYN/ACK) op:

- De fysieke interface van het chassis (bijvoorbeeld Po1-leden). Deze opname wordt geconfigureerd vanuit de Chassis Manager (CM) UI of de CM CLI.

- Interface voor gegevensinvoer (bijvoorbeeld Po1.202 OUTSIDE).

- Aangezien het pakket wordt omgeleid, is het volgende opnamepunt het gegevensvlak CCL.

- Chassis backplane-interfaces. Nogmaals, u moet het vastleggen op beide interfaces inschakelen.

- Unit-1-1 chassis CCL-ledeninterfaces.

- Data plane CCL-interface (naam van cluster).

- Ingress interface (Po1.202 BUITEN). Dit is het opnieuw geïnjecteerde pakket van CCL naar het gegevensvlak.

- Data plane-uitgang-interface (bijvoorbeeld Po1.201 INSIDE).

- Chassis backplane-interfaces.

Hoe de clusteropnamen in te schakelen

FXOS-opnamen

Het proces wordt beschreven in de FXOS Config Guide: Packet Capture

Opmerking: FXOS-opnamen kunnen alleen vanuit het oogpunt van de interne switch in de ingangsrichting worden gemaakt.

Opnamen van gegevensvlak

De aanbevolen manier om vastleggen op alle clusterleden in te schakelen, is met de opdracht clusterexec.

Overweeg een cluster met drie eenheden:

Gebruik deze opdracht om te controleren of alle clustereenheden actieve opnamen bevatten:

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Om een data plane capture op alle eenheden op Po1.201 (INSIDE) mogelijk te maken:

firepower# cluster exec capture CAPI interface INSIDE

Het wordt ten zeerste aanbevolen om een opnamefilter op te geven en, als u veel verkeer verwacht, de opnamebuffer te verhogen:

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Verificatie:

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

De inhoud van alle opnamen bekijken (deze uitvoer kan erg lang zijn):

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

Sporen vastleggen

Als u wilt zien hoe de ingangspakketten worden afgehandeld door het gegevensvlak op elke eenheid, gebruikt u het trefwoord trace. Dit traceert de eerste 50 ingresspakketten. U kunt maximaal 1000 ingress-pakketten traceren.

Opmerking: als u meerdere opnamen hebt toegepast op een interface, kunt u slechts één pakket één keer traceren.

Om de eerste 1000 ingresspakketten op de interface OUTSIDE op alle clustereenheden te traceren:

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

Zodra u de interessestroom hebt vastgelegd, moet u ervoor zorgen dat u de interessepakketten op elke eenheid traceert. Het belangrijkste om te onthouden is dat een specifiek pakket # 1 kan zijn op unit-1-1, maar # 2 op een andere unit, enzovoort.

In dit voorbeeld kunt u zien dat de SYN / ACK is pakket # 2 op unit-2-1, maar pakket # 1 op unit-3-1:

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Pakket nr. 2 (SYN/ACK) op de lokale eenheid traceren:

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Hetzelfde pakket (SYN/ACK) op de externe eenheid traceren:

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

CCL-opname

Opname inschakelen op de CCL-koppeling (op alle eenheden):

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Hide opnieuw injecteren

Standaard worden bij een opname die is ingeschakeld op een gegevensinterface van een gegevensvlak alle pakketten weergegeven:

- Degenen die uit het fysieke netwerk komen

- Degenen die opnieuw worden geïnjecteerd uit de CCL

Als u de opnieuw geïnjecteerde pakketten niet wilt zien, gebruikt u de optie opnieuw injecteren verbergen. Dit kan handig zijn als u wilt controleren of een stroom asymmetrisch is:

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Deze opname laat alleen zien wat de lokale eenheid daadwerkelijk ontvangt op de specifieke interface rechtstreeks van het fysieke netwerk, en niet van de andere clustereenheden.

ASP Drops

Als u wilt controleren op softwaredruppels voor een specifieke stroom, kunt u asp-drop vastleggen inschakelen. Als u niet weet op welke dropreden u zich moet concentreren, gebruikt u het zoekwoord allemaal. Bovendien, als u niet geïnteresseerd bent in de pakketlading, kunt u het trefwoord voor alleen headers opgeven. Hiermee kunt u 20-30 keer meer pakketten vastleggen:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Daarnaast kunt u de IP's opgeven die van belang zijn voor de ASP-vastlegging:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

Een vastlegging wissen

De buffer vrijmaken van elke opname die in alle clustereenheden wordt uitgevoerd. Dit stopt de opnames niet, maar ruimt alleen de buffers op:

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Een opname stoppen

Er zijn 2 manieren om actieve vastlegging op alle clustereenheden te stoppen. Later kun je weer verder.

Manier 1:

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Om te hervatten:

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Manier 2:

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Om te hervatten:

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Verzamel een opname

Er zijn meerdere manieren om een opname te exporteren.

Manier 1 - Naar een externe server:

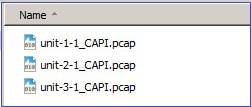

Hiermee kunt u een opname uploaden van het gegevensvlak naar een externe server (bijvoorbeeld TFTP). De namen van de vastlegging worden automatisch gewijzigd om de broneenheid weer te geven:

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

De geüploade pcap-bestanden:

Way 2 - Haal de opnames op bij het FMC:

Dit is alleen van toepassing op FTD. Eerst kopieert u de opname naar de FTD-schijf:

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

Kopieer het bestand vanuit de expertmodus van /mnt/disk0/ naar /ngfw/var/common/ directory:

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

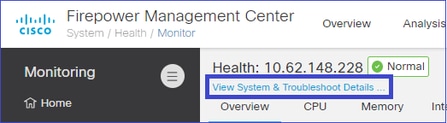

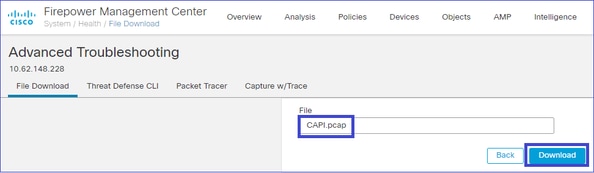

Navigeer ten slotte op FMC naar Systeem > Gezondheid > sectie Monitor. Kies Systeem bekijken en problemen oplossen > Geavanceerde probleemoplossing en haal het vastleggingsbestand op:

Een opname verwijderen

Als u een opname uit alle clustereenheden wilt verwijderen, gebruikt u deze opdracht:

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

geoffloade stromen

Op FP41xx/FP9300 kunnen stromen worden overgeladen naar HW Accelerator, hetzij statisch (bijvoorbeeld Fastpath-regels) of dynamisch. Raadpleeg dit document voor meer informatie over flow-offload: Verduidelijking van FTD-beleidsregels voor toegangscontrole.

Als een stroom wordt uitgeladen, gaan er maar een paar pakketten door het FTD-gegevensvlak. De rest wordt afgehandeld door de HW-versneller (Smart NIC).

Vanuit het oogpunt van vastleggen betekent dit dat als u alleen FTD-opnamen op gegevensniveau inschakelt, u niet alle pakketten ziet die door het apparaat gaan. In dit geval moet u ook FXOS-opnamen op chassisniveau inschakelen.

CCL-berichten (Cluster Control Link)

Als u een opname maakt op de CCL, merkt u dat de clustereenheden verschillende soorten berichten uitwisselen. De meest interessante zijn:

|

Protocol |

Beschrijving |

|

UDP 49495 |

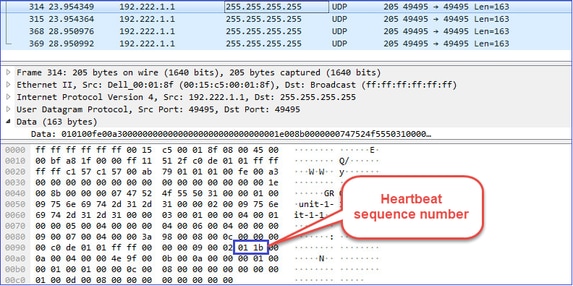

Clusterhartslag (levendgeborenen) · L3 uitzending (255.255.255.255) · Deze pakketten worden door elke clustereenheid verzonden tegen 1/3 van de wachttijd voor de gezondheidscontrole. · Merk op dat niet alle UDP 49495-pakketten die in de opname worden gezien hartslagen zijn · De hartslagen bevatten een volgnummer. |

|

UDP 4193 |

Berichten over gegevenspad voor clusterbesturingsprotocol · Unicast · Deze pakketten bevatten informatie (metagegevens) over de eigenaar van de stroom, de directeur, de eigenaar van de back-up, enzovoort. Voorbeelden zijn: · Een "cluster add" bericht wordt verzonden van de eigenaar naar de directeur wanneer een nieuwe stroom wordt gemaakt · Een "cluster delete" bericht wordt verzonden van de eigenaar naar de directeur wanneer een stroom wordt beëindigd |

|

Gegevenspakketten |

Gegevenspakketten die behoren tot de verschillende verkeersstromen die door het cluster lopen |

Cluster hartslag:

Berichten van het Cluster Control Point (CCP)

Naast de hartslagberichten zijn er een aantal clustercontroleberichten die in specifieke scenario’s via de CCL worden uitgewisseld. Sommige daarvan zijn unicast-berichten, terwijl andere uitzendingen zijn.

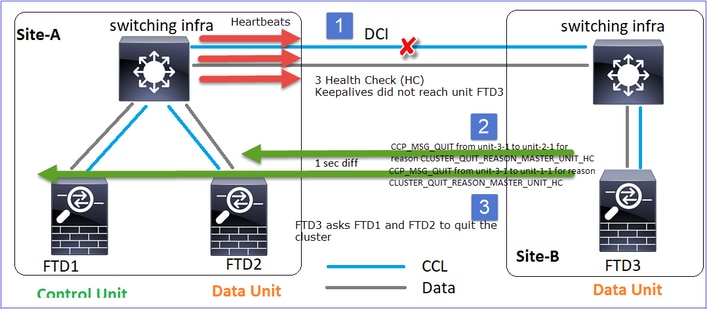

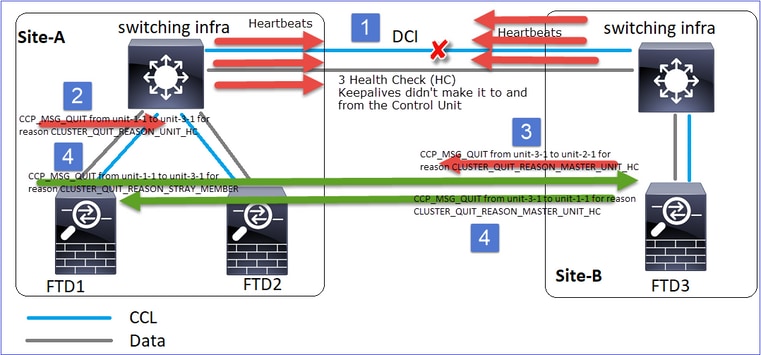

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Wanneer een eenheid 3 opeenvolgende hartslagberichten van de controlenode verliest, genereert deze een CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC-bericht via de CCL. Dit bericht:

- Het is een unicast.

- Het wordt verzonden naar elk van de eenheden met een interval van 1 sec.

- Wanneer een eenheid dit bericht ontvangt, sluit het cluster (UITGESCHAKELD) en wordt opnieuw lid.

V. Wat is het doel van de CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC?

A. Vanuit het oogpunt van unit-3-1 (Site-B) verliest het de verbinding met zowel unit-1-1 als unit-2-1 van site A, dus het moet ze zo snel mogelijk uit zijn ledenlijst verwijderen, anders kan het pakket verloren gaan als unit-2-1 nog steeds in zijn ledenlijst staat en unit-2-1 toevallig een regisseur van een verbinding is en de stroomquery naar unit-2-1 mislukt.

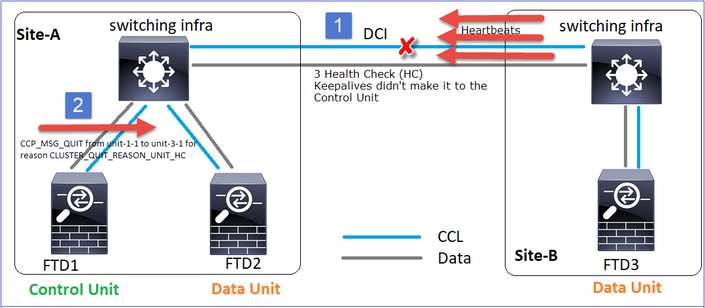

CLUSTER_QUIT_REASON_UNIT_HC

Wanneer de control node 3 opeenvolgende hartslagberichten verliest van een data node, stuurt deze een CLUSTER_QUIT_REASON_UNIT_HC bericht over de CCL. Dit bericht is unicast.

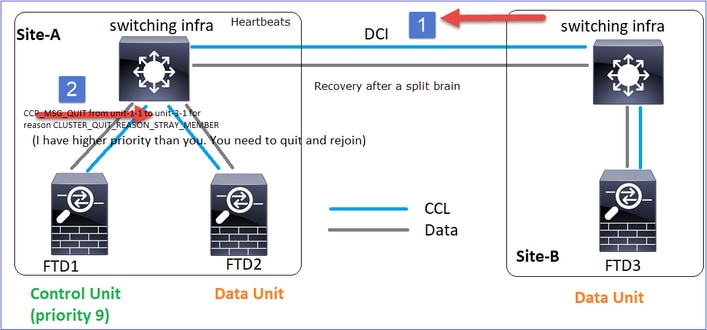

CLUSTER_QUIT_REASON_STRAY_MEMBER

Wanneer een gesplitste partitie opnieuw verbinding maakt met een peer-partitie, wordt het nieuwe gegevensknooppunt door de dominante besturingseenheid behandeld als een verdwaald lid en ontvangt het een CCP-stopbericht met de reden CLUSTER_QUIT_REASON_STRAY_MEMBER.

CLUSTER_QUIT_MEMBER_DROPOUT

Een broadcast-bericht dat wordt gegenereerd door een gegevensknooppunt en wordt verzonden als een uitzending. Zodra een eenheid dit bericht ontvangt, gaat deze naar de status UITGESCHAKELD. Bovendien wordt automatisch opnieuw lid worden niet afgetrapt:

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

De clustergeschiedenis laat zien:

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

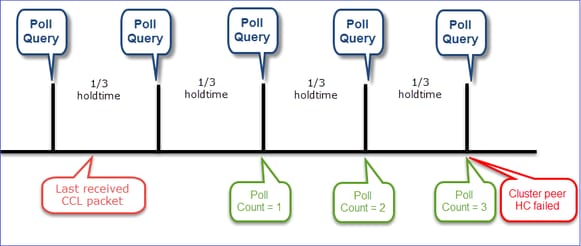

Cluster Health Check (HC)-mechanisme

Hoofdpunten:

- Elke clustereenheid verzendt een hartslag om de 1/3 van de wachttijd voor de gezondheidscontrole naar alle andere eenheden (uitgezonden op 255.255.255.255) en gebruikt UDP-poort 49495 als transport over de CCL.

- Elke clustereenheid volgt onafhankelijk elke andere eenheid met een poll-timer en een poll-telwaarde.

- Als een clustereenheid binnen een hartslaginterval geen pakket (hartslag of gegevenspakket) ontvangt van een clusterpeer-eenheid, wordt de waarde voor het aantal polls verhoogd.

- Wanneer de waarde voor het aantal peilingen voor een cluster-peereenheid 3 wordt, wordt de peer als omlaag beschouwd.

- Wanneer een hartslag wordt ontvangen, wordt het volgnummer gecontroleerd en in het geval dat het verschil met de eerder ontvangen hartslag anders is dan 1, neemt de hartslagvalteller dienovereenkomstig toe.

- Als de teller voor het aantal polls voor een clusterpeer anders is dan 0 en de peer een pakket ontvangt, wordt de teller teruggezet naar een waarde van 0.

Gebruik deze opdracht om de statustellers van het cluster te controleren:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

Beschrijving van de belangrijkste kolommen:

|

zuil |

Beschrijving |

|

Eenheid (ID) |

De ID van de externe clusterpeer. |

|

Hartslagtelling |

Het aantal hartslagen dat van de externe peer via de CCL wordt ontvangen. |

|

Hartslagdruppels |

Het aantal gemiste hartslagen. Deze teller wordt berekend op basis van het ontvangen hartslagvolgnummer. |

|

Gemiddelde gap |

Het gemiddelde tijdsinterval van de ontvangen hartslagen. |

|

Poll-telling |

Wanneer deze teller 3 wordt, wordt de eenheid uit het cluster verwijderd. De poll query interval is hetzelfde als de hartslag interval, maar loopt onafhankelijk. |

U kunt de tellers als volgt resetten:

firepower# clear cluster info health details

V. Hoe de frequentie van de hartslag te controleren?

A. Controleer de gemiddelde waarde van de tussenruimte:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

V. Hoe kunt u de wachttijd van het cluster op FTD wijzigen?

A. FlexConfig gebruiken.

V. Wie wordt het controleknooppunt na een split-brain?

De eenheid met de hoogste prioriteit (laagste aantal):

firepower# show run cluster | include priority

priority 9

Controleer HC-faalscenario 1 voor meer details.

Het HC-mechanisme voor clustervisualisatie

Indicatieve timers: De min en max zijn afhankelijk van de laatst ontvangen CCL-pakketaankomst.

|

Wachtstandtijd |

Controle poll query (frequentie) |

Min detectietijd |

Max. detectietijd |

|

3 sec (standaard) |

~1 sec |

~3,01 sec |

~3,99 sec |

|

4 sec. |

~1,33 sec |

~4,01 sec |

~5,32 sec |

|

5 sec. |

~1,66 sec |

~5,01 sec |

~6,65 sec |

|

6 sec. |

~2 sec |

~6,01 sec |

~7,99 sec |

|

7 sec. |

~2,33 sec |

~7,01 sec |

~9,32 sec |

|

8 sec. |

~2,66 sec |

~8,01 sec |

~10,65 sec |

Cluster HC-storingsscenario's

Het doel van deze sectie is om aan te tonen:

- Verschillende HC-faalscenario's voor clusters.

- Hoe de verschillende logs en commando-uitgangen kunnen worden gecorreleerd.

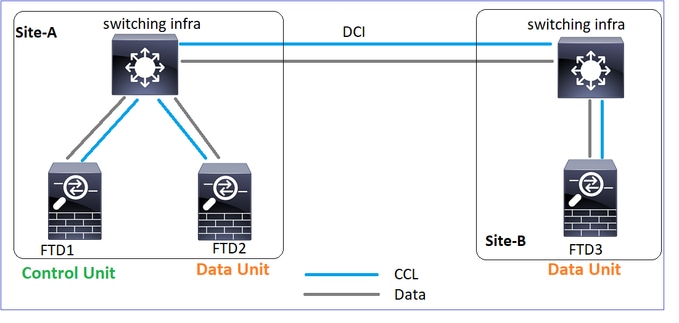

Topologie

Clusterconfiguratie:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

Clusterstatus:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Scenario 1 - CCL-communicatieverlies voor ~4+ seconden in beide richtingen

Voor de mislukking:

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

Na het herstel (geen wijzigingen in de eenheidsrollen):

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

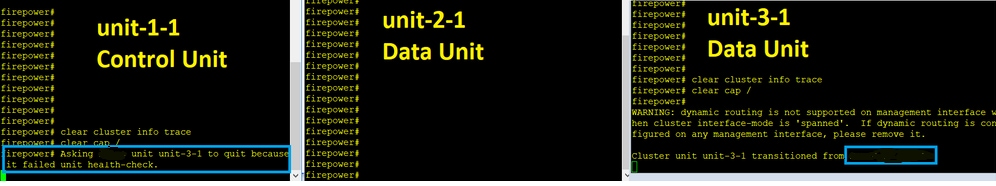

analyse

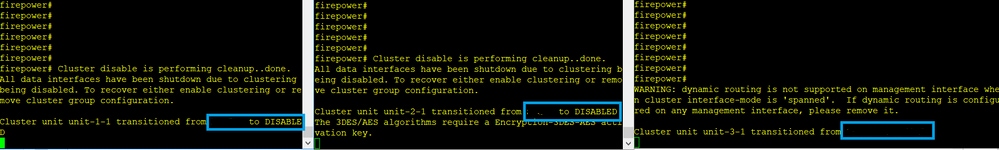

De storing (CCL-communicatie ging verloren).

Het bericht op de console van het gegevensvlak op unit-3-1:

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

Eenheid-1-1-clustertraceringslogs:

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

Gespleten hersenen:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Clustergeschiedenis:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

|

Geen evenementen |

Geen evenementen |

09:38:16 UTC Nov 2 2020 |

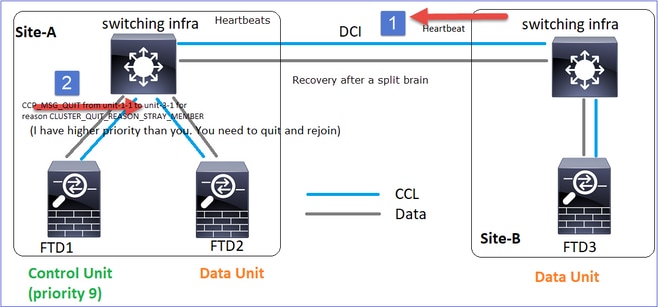

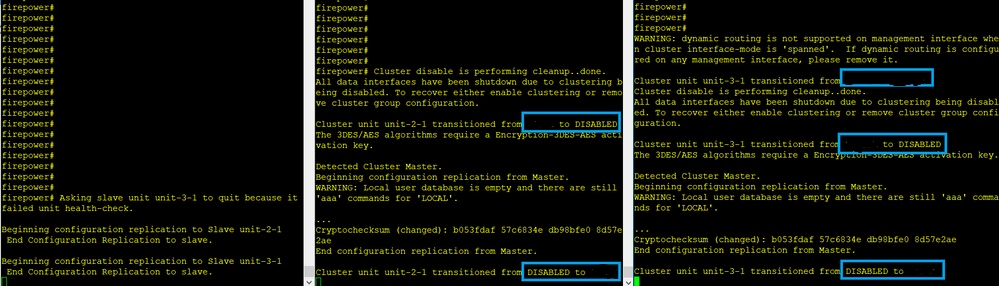

CCL-communicatieherstel

Unit-1-1 detecteert de huidige controlenode en aangezien unit-1-1 een hogere prioriteit heeft, stuurt een CLUSTER_QUIT_REASON_STRAY_MEMBER-bericht naar unit-3-1 om een nieuw selectieproces te starten. Eenheid-3-1 wordt uiteindelijk opnieuw toegevoegd als een gegevensknooppunt.

Wanneer een gesplitste partitie opnieuw verbinding maakt met een peer-partitie, wordt het gegevensknooppunt door het dominante controleknooppunt behandeld als een verdwaald lid en ontvangt het een CCP-stop msg met een reden van CLUSTER_QUIT_REASON_STRAY_MEMBER.

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

Beide eenheden (unit-1-1 en unit-3-1) tonen in hun clusterlogboeken:

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Er zijn ook syslog-berichten gegenereerd voor de split-brain:

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Clustergeschiedenis:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

|

Geen evenementen |

Geen evenementen |

09:47:33 UTC Nov 2 2020 |

Scenario 2 - CCL-communicatieverlies voor ~ 3-4 seconden in beide richtingen

Voor de mislukking:

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

Na het herstel (geen wijzigingen in de eenheidsrollen):

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

analyse

Gebeurtenis 1: De controlenode verliest 3 HC's van de unit-3-1 en stuurt een bericht naar unit-3-1 om het cluster te verlaten.

Gebeurtenis 2: De CCL herstelde zeer snel en het bericht CLUSTER_QUIT_REASON_STRAY_MEMBER van de control node bereikte de externe zijde. Unit-3-1 gaat direct naar DISABLED-modus en er is geen split-brain

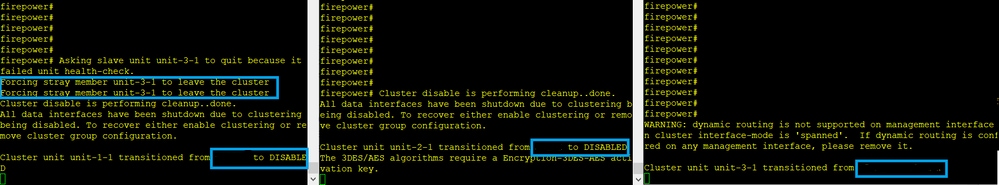

Op unit-1-1 (controle) zie je:

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

Op unit-3-1 (data node) zie je:

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

Clustereenheid-3-1 wordt overgezet naar een UITGESCHAKELDE status en zodra de CCL-communicatie is hersteld, wordt deze opnieuw als een gegevensknooppunt toegevoegd:

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

Scenario 3 - CCL-communicatieverlies voor ~ 3-4 seconden in beide richtingen

Voor de mislukking:

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

Na het herstel (de controlenode is gewijzigd):

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

Gegevensknooppunt |

besturingsknooppunt |

Gegevensknooppunt |

analyse

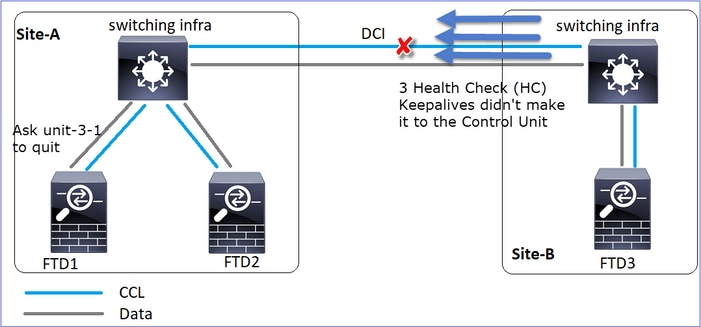

- CCL gaat naar beneden.

- Unit-1-1 krijgt geen 3 HC-berichten van unit-3-1 en stuurt een QUIT-bericht naar unit-3-1. Dit bericht bereikt nooit eenheid-3-1.

- Unit-3-1 stuurt een QUIT-bericht naar unit-2-1. Dit bericht bereikt nooit eenheid-2-1.

CCL herstelt.

- Unit-1-1 ziet dat unit-3-1 zichzelf heeft geadverteerd als een control node en verzendt QUIT_REASON_STRAY_MEMBER bericht naar unit-3-1. Zodra unit-3-1 krijgt dit bericht gaat naar een UITGESCHAKELD staat. Tegelijkertijd stuurt unit-3-1 een QUIT_REASON_PRIMARY_UNIT_HC-bericht naar unit-1-1 en vraagt het om te stoppen. Zodra unit-1-1 dit bericht krijgt, gaat het naar een UITGESCHAKELDE status.

Clustergeschiedenis:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

Scenario 4 - CCL-communicatieverlies voor ~3-4 seconden

Voor de mislukking:

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

Na het herstel (de controlenode veranderde van locatie):

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

Gegevensknooppunt |

Gegevensknooppunt |

besturingsknooppunt |

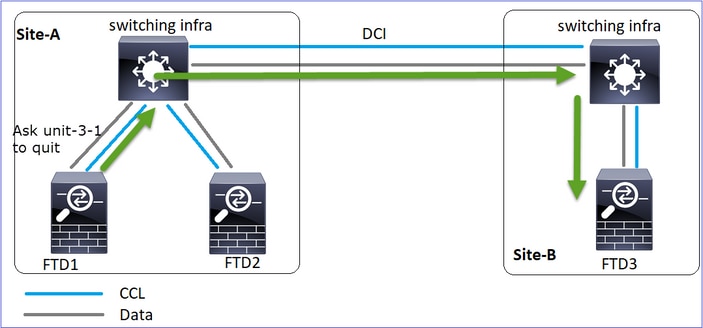

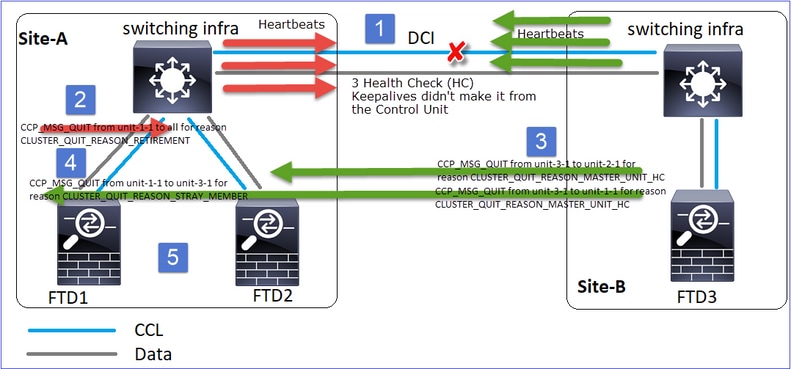

analyse

De mislukking

Een andere smaak van dezelfde mislukking. In dit geval kreeg de unit-1-1 ook geen 3 HC-berichten van de unit-3-1, en zodra het een nieuwe keepalive kreeg, probeerde het de unit-3-1 uit te schoppen met behulp van een STRAY-bericht, maar het bericht bereikte nooit de unit-3-1:

- CCL wordt een paar seconden eenrichtingsverkeer. Unit-3-1 ontvangt geen 3 HC-berichten van de unit-1-1 en wordt een besturingsknooppunt.

- Unit-2-1 stuurt een CLUSTER_QUIT_REASON_RETIREMENT-bericht (broadcast).

- Unit-3-1 stuurt een QUIT_REASON_PRIMARY_UNIT_HC bericht naar unit-2-1. Unit-2-1 ontvangt het en verlaat het cluster.

- Unit-3-1 stuurt een QUIT_REASON_PRIMARY_UNIT_HC bericht naar unit-1-1. Unit-1-1 ontvangt het en verlaat het cluster. CCL herstelt.

- De eenheden 1-1 en 2-1 sluiten zich opnieuw aan bij het cluster als gegevensknooppunten.

Opmerking: Als in stap 5 de CCL niet herstelt, wordt in site-A de FTD1 de nieuwe besturingsnode en na het CCL-herstel wint deze de nieuwe verkiezing.

Syslog-berichten op unit-1-1:

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

Clustertraceringslogs op eenheid-1-1:

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Syslog-berichten op unit-3-1:

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

Clustergeschiedenis

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

Scenario 5

Voor de mislukking:

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

Na herstel (geen wijzigingen):

|

FTD1 |

FTD2 |

FTD3 |

|

Site-A |

Site-A |

Site-B |

|

besturingsknooppunt |

Gegevensknooppunt |

Gegevensknooppunt |

De mislukking:

Unit-3-1 stuurde QUIT-berichten naar zowel unit-1-1 als unit-2-1, maar vanwege connectiviteitsproblemen ontving alleen unit-2-1 het QUIT-bericht.

Eenheid-1-1-clustertraceringslogs:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Eenheid-2-1-clustertraceringslogs:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Clustergeschiedenis:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

|

Geen evenementen |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

installatie voor de verbinding van het clustergegevensvliegtuig

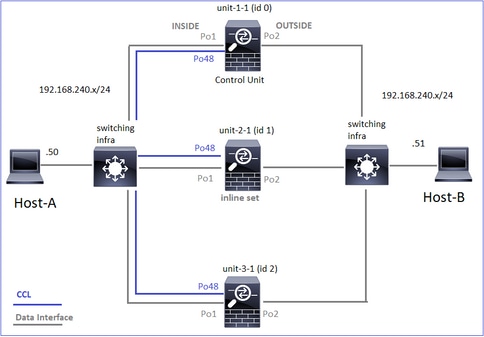

NGFW-opnamepunten

De NGFW biedt mogelijkheden voor het vastleggen van deze punten:

- Interne switch van het chassis (FXOS)

- FTD-gegevensvliegtuigmotor

- FTD Snort-engine

Wanneer u problemen met gegevenspaden in een cluster oplost, zijn de opnamepunten die in de meeste gevallen worden gebruikt de FXOS- en FTD-gegevensvliegtuigmotoropnamen.

- FXOS-ingangsopname op de fysieke interface

- FTD-ingangsopname in de data plane-engine

- FTD-regresregistratie in gegevensvliegtuigmotor

- FXOS-ingangsopname op backplaneinterface

Raadpleeg dit document voor meer informatie over NGFW-opnamen:

Basisbeginselen voor stroomrollen voor clustereenheden

Verbindingen kunnen op verschillende manieren worden gemaakt via een cluster, afhankelijk van factoren zoals:

- Soort verkeer (TCP, UDP, enz.)

- Algoritme voor taakverdeling geconfigureerd op de aangrenzende switch

- Functies geconfigureerd op de firewall

- Netwerkcondities (bijvoorbeeld IP-fragmentatie, netwerkvertragingen, enzovoort)

|

Flow, rol |

Beschrijving |

Vlag(en) |

|

eigenares |

Meestal is het apparaat dat in eerste instantie de verbinding ontvangt |

UIO |

|

Directeur |

De eenheid die de opzoekverzoeken van de eigenaar van expediteurs behandelt. |

Y |

|

Back-up eigenaar |

Zolang de directeur niet dezelfde eenheid is als de eigenaar, is de directeur ook de eigenaar van de back-up. Als de eigenaar zichzelf kiest als de directeur, wordt een afzonderlijke back-up eigenaar gekozen. |

Y (als de directeur ook de eigenaar van de back-up is) y (als de regisseur niet de eigenaar van de back-up is) |

|

expediteur |

Een eenheid die pakketten doorstuurt naar de eigenaar |

z |

|

Fragmenteigenaar |

De eenheid die het gefragmenteerde verkeer verwerkt |

- |

|

Chassisback-up |

In een interchassiscluster wordt een eenheid in een van de andere chassisblokken een secundaire back-up/directeur wanneer zowel de director/back-up- als de eigenaarsstromen eigendom zijn van de eenheden van hetzelfde chassis. Deze rol is specifiek voor clusters tussen chassis van de Firepower 9300-reeks met meer dan één blade. |

W |

- Raadpleeg het betreffende gedeelte in de configuratiehandleiding voor meer informatie (zie koppelingen in de gerelateerde informatie)

- In specifieke scenario's (zie het gedeelte met casestudy's) worden sommige vlag(s) niet altijd getoond.

Casestudy's over het opzetten van clusterverbindingen

In het volgende gedeelte worden verschillende casestudy's behandeld die enkele manieren aantonen waarop een verbinding via een cluster kan worden gemaakt. De doelstellingen zijn:

- Maak je vertrouwd met de verschillende rollen.

- Demonstreer hoe de verschillende commando-uitgangen kunnen worden gecorreleerd.

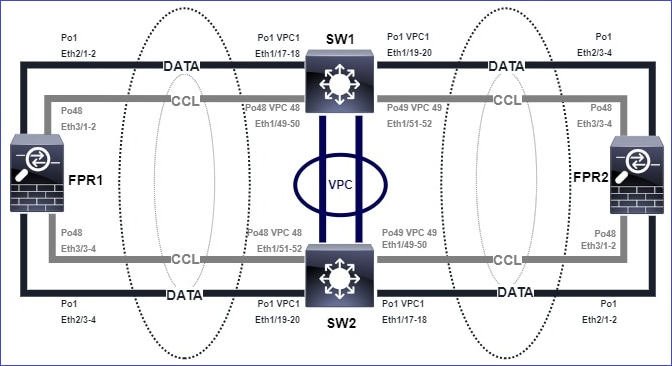

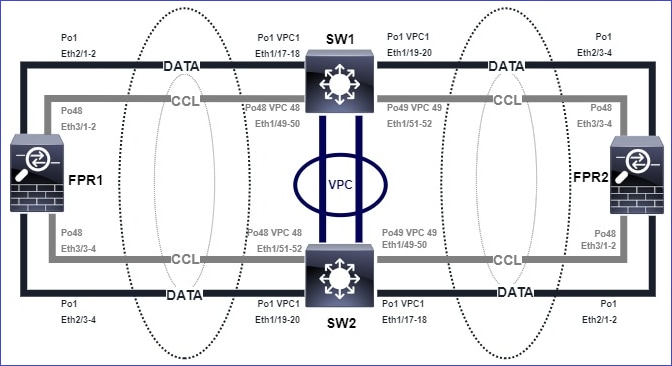

Topologie

Clustereenheden en ID's:

|

Eenheid-1-1 |

Eenheid-2-1 |

Eenheid-3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

Clusteropnamen ingeschakeld:

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

Opmerking: deze tests werden uitgevoerd in een laboratoriumomgeving met minimaal verkeer door het cluster. Probeer in de productie zo specifiek mogelijke opnamefilters te gebruiken (bijvoorbeeld bestemmingspoort en waar mogelijk de bronpoort) om het ‘geluid’ in de opnamen te minimaliseren.

Casestudy 1. Symmetrisch verkeer (eigenaar is ook de directeur)

Bevinding 1. De herinjecteerbare captures tonen alleen pakketten op unit-1-1. Dit betekent dat de stroom in beide richtingen ging door unit-1-1 (symmetrisch verkeer):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Opmerking 2. Analyse van de verbindingsvlag voor stroom met bronpoort 45954:

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

|

eenheid |

vlag |

Opmerking |

|

Eenheid-1-1 |

UIO |

· Flow Owner – De eenheid regelt de stroom · Directeur – Aangezien unit-3-1 ‘y’ heeft en niet ‘Y’, betekent dit dat unit-1-1 is gekozen als de regisseur voor deze stroom. Omdat het ook de eigenaar is, werd een andere eenheid (in dit geval unit-3-1) gekozen als de back-up-eigenaar |

|

Eenheid-2-1 |

- |

- |

|

Eenheid-3-1 |

y |

De eenheid is eigenaar van de back-up |

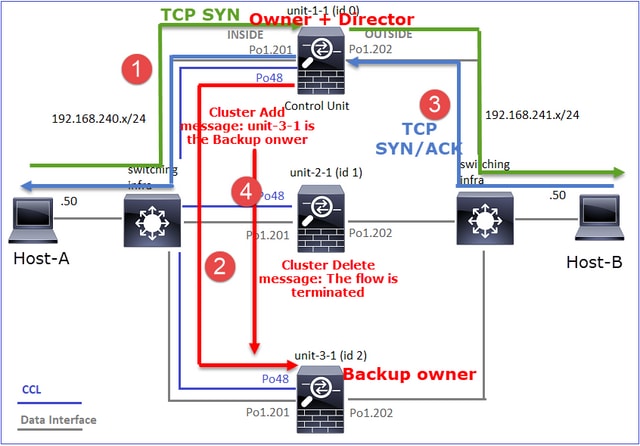

Dit kan als volgt worden weergegeven:

- TCP SYN-pakket komt van host-A naar unit-1-1. Unit-1-1 wordt de eigenaar van de stroom.

- Unit-1-1 wordt ook gekozen als de flow director. Zo wordt ook unit-3-1 gekozen als de back-up-eigenaar (clusteradd-bericht).

- TCP SYN/ACK-pakket komt van host-B naar unit-3-1. De stroming is symmetrisch.

- Zodra de verbinding is beëindigd, stuurt de eigenaar een bericht voor het verwijderen van clusters om de stroominformatie van de eigenaar van de back-up te verwijderen.

Opmerking 3. Opname met spoor laat zien dat beide richtingen alleen door eenheid-1-1 gaan:

Stap 1. Identificeer de stroom en pakketten die van belang zijn voor alle clustereenheden op basis van de bronpoort:

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Stap 2. Aangezien dit een TCP-stroom is, traceert u de 3-weg handshake-pakketten. Zoals te zien is in deze output, is unit-1-1 de eigenaar. Voor de eenvoud worden de niet-relevante traceringsfasen weggelaten:

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

Het retourverkeer (TCP/SYN/ACK):

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

Opmerking 4. De FTD-gegevensvliegtuigsystemen tonen het maken en beëindigen van de verbinding op alle eenheden:

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

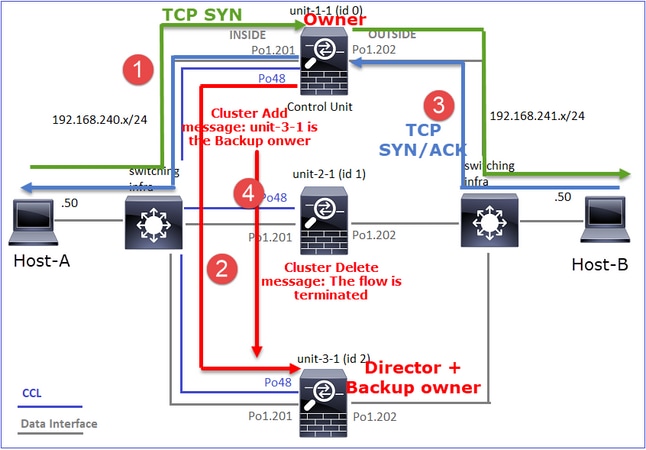

Casestudy 2. Symmetrisch verkeer (eigenaar anders dan de directeur)

- Hetzelfde als casestudy #1, maar in deze casestudy is een flow-eigenaar een andere eenheid dan de directeur.

- Alle resultaten zijn vergelijkbaar met casestudy #1. Het belangrijkste verschil ten opzichte van casestudy #1 is de ‘Y’-vlag die de ‘y’-vlag van scenario 1 vervangt.

Bevinding 1. De eigenaar is anders dan de directeur.

Analyse van de verbindingsvlag voor stroom met bronpoort 46278:

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

|

eenheid |

vlag |

Opmerking |

|

Eenheid-1-1 |

UIO |

· Flow Owner – De eenheid regelt de stroom |

|

Eenheid-2-1 |

- |

- |

|

Eenheid-3-1 |

Y |

· Directeur en Backup eigenaar – Unit 3-1 heeft de vlag Y (Director). |

Dit kan als volgt worden weergegeven:

- TCP SYN-pakket komt van host-A naar unit-1-1. Unit-1-1 wordt de eigenaar van de stroom.

- Unit-3-1 wordt gekozen als de flow director. Unit-3-1 is ook de eigenaar van de back-up ("cluster add"-bericht op UDP 4193 via de CCL).

- TCP SYN/ACK-pakket komt van host-B naar unit-3-1. De stroming is symmetrisch.

- Zodra de verbinding is beëindigd, verzendt de eigenaar via de CCL een "cluster delete" -bericht op UDP 4193 om de stroominformatie van de eigenaar van de back-up te verwijderen.

Opmerking 2. Opname met spoor laat zien dat beide richtingen alleen door eenheid-1-1 gaan.

Stap 1. Gebruik dezelfde aanpak als in casestudy 1 om de stroom en pakketten te identificeren die van belang zijn voor alle clustereenheden op basis van de bronpoort:

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Opnemen via de interface BUITEN:

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Stap 2. Focus op de toegangspakketten (TCP SYN en TCP SYN/ACK):

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Volg de SYN/ACK op unit-1-1:

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

Opmerking 3. De FTD-gegevensvliegtuigsystemen tonen het maken en beëindigen van de verbinding voor de eigenaar en de eigenaar van de back-up:

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

Casestudy 3. Asymmetrisch verkeer (Directeur Vooruit het verkeer)

Bevinding 1. De opnieuw injecteren-verbergen captures tonen pakketten op unit-1-1 en unit-2-1 (asymmetrische flow):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Opmerking 2. Analyse van de verbindingsvlag voor stroom met bronpoort 46502.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

|

eenheid |

vlag |

Opmerking |

|

Eenheid-1-1 |

UIO |

· Flow Owner – De eenheid regelt de stroom. |

|

Eenheid-2-1 |

Y |

· Directeur - Aangezien unit-2-1 de vlag 'Y' heeft, betekent dit dat unit-2-1 is gekozen als de directeur voor deze stroom. · Eigenaar van back-up · Tot slot, hoewel het niet duidelijk uit deze output, van de show capture en show log outputs is het duidelijk dat unit-2-1 stuurt deze stroom naar de eigenaar (hoewel technisch gezien wordt niet beschouwd als een forwarder in dit scenario). Opmerking: een eenheid kan niet zowel een regisseur (Y-stroom) als een doorstuurder (z-stroom) zijn, deze 2 rollen sluiten elkaar uit. Bestuurders (Y-flow) kunnen nog steeds verkeer doorsturen. Zie de uitvoer van het showlogboek later in deze casestudy. |

|

Eenheid-3-1 |

- |

- |

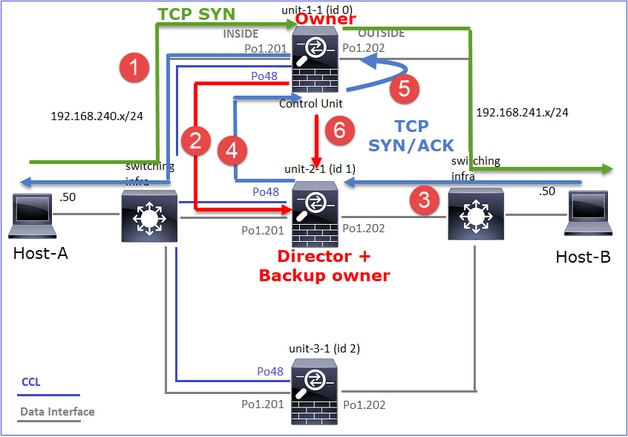

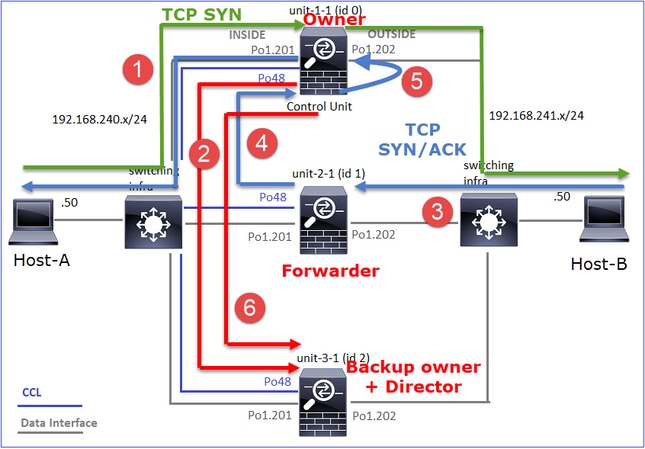

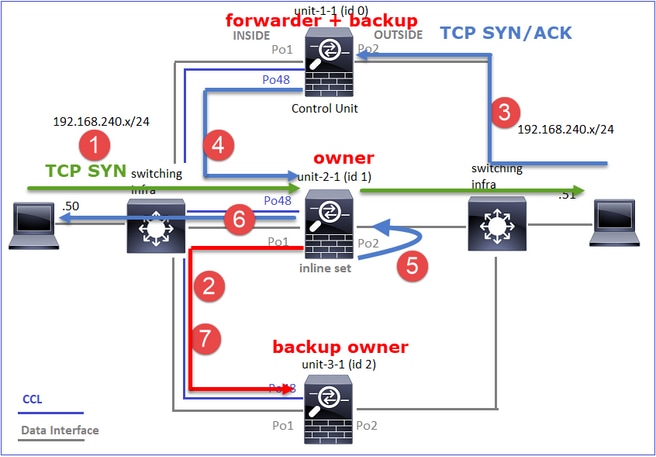

Dit kan als volgt worden weergegeven:

- TCP SYN-pakket komt van host-A naar unit-1-1. Unit-1-1 wordt de eigenaar van de stroom.

- Unit-2-1 wordt gekozen als de flow director en back-up eigenaar. De eigenaar van de stroom verzendt een unicastbericht "cluster add" op UDP 4193 om de eigenaar van de back-up te informeren over de stroom.

- TCP SYN/ACK-pakket komt van host-B naar unit-2-1. De stroming is asymmetrisch.

- Unit-2-1 stuurt het pakket door de CCL naar de eigenaar (vanwege TCP SYN Cookie).

- De eigenaar injecteert het pakket opnieuw op de interface BUITEN en stuurt het pakket vervolgens door naar Host-A.

- Zodra de verbinding is beëindigd, stuurt de eigenaar een bericht voor het verwijderen van clusters om de stroominformatie van de eigenaar van de back-up te verwijderen.

Opmerking 3. Opname met spoor toont het asymmetrische verkeer en de omleiding van eenheid-2-1 naar eenheid-1-1.

Stap 1. Identificeer de pakketten die behoren tot de stroom van belang (poort 46502):

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

De terugkeerrichting:

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

Stap 2. Traceer de pakketten. Standaard worden alleen de eerste 50 ingresspakketten getraceerd. Voor de eenvoud worden de niet-relevante traceringsfasen weggelaten.

Unit-1-1 (eigenaar)

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Unit-2-1 (Forwarder)

Het retourverkeer (TCP SYN/ACK) De eenheid van belang is unit-2-1 die de directeur/back-up eigenaar is en het verkeer doorstuurt naar de eigenaar:

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

Opmerking 4. De FTD-gegevensvliegtuigsystemen tonen het maken en beëindigen van de verbinding op alle eenheden:

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)

Dec 01 2020 12:58:33: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46502 duration 0:00:00 forwarded bytes 0 Forwarding or redirect flow removed to create director or backup flow

Dec 01 2020 12:58:33: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 forwarded bytes 2048316300 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

firepower#

Casestudy 4. Asymmetrisch verkeer (eigenaar is de directeur)

Bevinding 1. De opnieuw injecteren-verbergen captures tonen pakketten op unit-1-1 en unit-2-1 (asymmetrische flow):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554229 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98974 bytes]