Applicazione di una patch per immagine ESXI non personalizzata su un cluster Hyperflex

Opzioni per il download

Linguaggio senza pregiudizi

La documentazione per questo prodotto è stata redatta cercando di utilizzare un linguaggio senza pregiudizi. Ai fini di questa documentazione, per linguaggio senza di pregiudizi si intende un linguaggio che non implica discriminazioni basate su età, disabilità, genere, identità razziale, identità etnica, orientamento sessuale, status socioeconomico e intersezionalità. Le eventuali eccezioni possono dipendere dal linguaggio codificato nelle interfacce utente del software del prodotto, dal linguaggio utilizzato nella documentazione RFP o dal linguaggio utilizzato in prodotti di terze parti a cui si fa riferimento. Scopri di più sul modo in cui Cisco utilizza il linguaggio inclusivo.

Informazioni su questa traduzione

Cisco ha tradotto questo documento utilizzando una combinazione di tecnologie automatiche e umane per offrire ai nostri utenti in tutto il mondo contenuti di supporto nella propria lingua. Si noti che anche la migliore traduzione automatica non sarà mai accurata come quella fornita da un traduttore professionista. Cisco Systems, Inc. non si assume alcuna responsabilità per l’accuratezza di queste traduzioni e consiglia di consultare sempre il documento originale in inglese (disponibile al link fornito).

Introduzione

In questo documento viene descritto il processo di applicazione di patch a un nodo ESXI Hyperflex con un'immagine HX non personalizzata tramite l'interfaccia della riga di comando (CLI) o tramite HX Connect.

Prerequisiti

Requisiti

Cisco raccomanda la conoscenza dei seguenti argomenti:

- Hyperflex

- ESXI

Componenti usati

Le informazioni fornite in questo documento si basano sulle seguenti versioni software e hardware:

- HyperFlex Connect 5.0.2d

- Cluster Hyperflex Standard

- vCenter 8.0

- VMware ESXI, 7.0.3 build-23794027

- VMware ESXI, 7.0.3 build-24585291 (patch di destinazione)

Le informazioni discusse in questo documento fanno riferimento a dispositivi usati in uno specifico ambiente di emulazione. Su tutti i dispositivi menzionati nel documento la configurazione è stata ripristinata ai valori predefiniti. Se la rete è operativa, valutare attentamente eventuali conseguenze derivanti dall'uso dei comandi.

Premesse

Cisco non sempre fornisce un bundle HyperFlex separato per ogni nuova versione di patch VMware ESXI. Con gli aggiornamenti critici di ESXI è possibile applicarli manualmente con uno qualsiasi dei metodi presentati in questo articolo. Tuttavia, HyperFlex sconsiglia di aggiornare ESXI utilizzando VMware Update Manager (VUM) o VMware Lifecycle Manager (vLCM), in quanto può causare problemi con alcuni pacchetti di installazione HyperFlex vSphere (VIB).

Le patch non personalizzate possono essere applicate solo per le stesse versioni ESXI. Se si utilizza ESXI 7.0 u3 è possibile applicare solo patch 7.0u3+ e non è possibile eseguire l'aggiornamento da 7.0u3 a 8.0u2 o 8.0u3, né l'aggiornamento da 8.0u2x a 8.0u3x con immagini non personalizzate.

Prima di applicare qualsiasi patch, verificare che la versione corrente di HyperFlex Data Platform (HXDP) sia compatibile con la versione ESXi che si intende installare. La tabella di compatibilità è la seguente:

| Version | Server VMware ESXi versione HX |

| 6.0 (1) | 7,0 U3, 8,0 U2 |

| 5.5, paragrafo 2 bis | 7,0 U3, 8,0 U2, 8,0 U3 |

| 5.5, paragrafo 1 bis | 7,0 U3 |

| 5,0 (2x) | 7,0 U3 |

Se la versione HXDP è meno recente, aggiornare prima HXDP, quindi ESXI.

Configurazione

Scarica il file zip ESXI dal sito Web Broadcom

Verificare che il cluster sia online e integro prima di iniziare l'attività.

Verificare le versioni iniziali per Hyperflex, Nenic e NFC sui nodi ESXi del cluster.

elenco vib software esxcli | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc|nenic|nfnic'

Aggiornamento tramite CLI

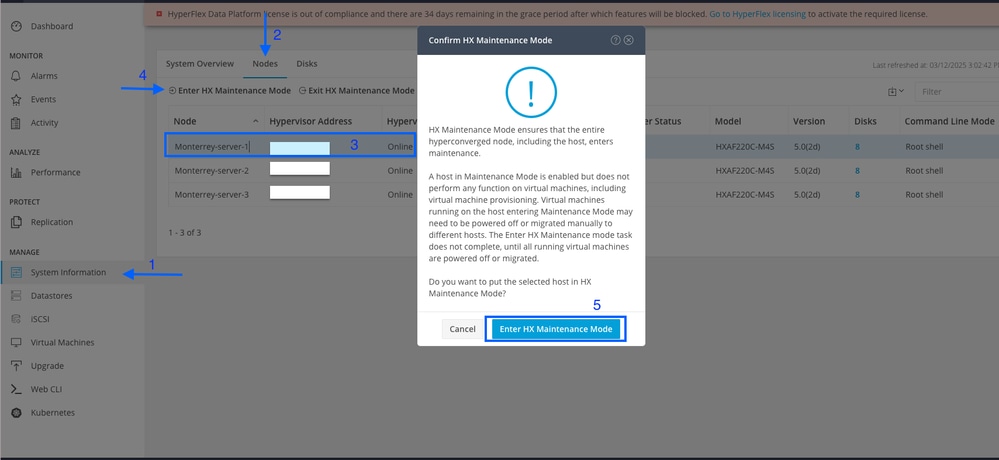

Passaggio 1. Da HX Connect (Connessione HX) passare a System Information > Nodes (Informazioni di sistema), selezionare uno degli host e fare clic su Enter HX Maintenance Mode (Accedi modalità manutenzione HX).

Una volta che l'host entra in modalità di manutenzione, procedere con i passaggi successivi.

Passaggio 2. Trasferire il file zip sull'host.

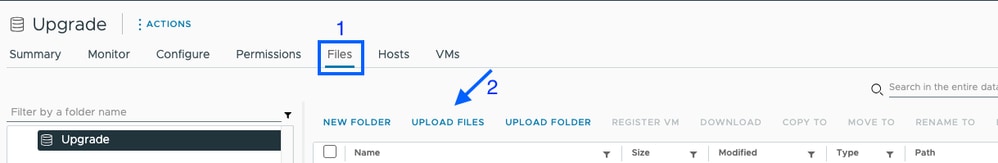

È possibile caricarlo tramite vCenter in un archivio dati installato.

Passare all'archivio dati desiderato e selezionare Files, quindi selezionare UPLOAD FILES e caricare il file zip. Nell'immagine seguente viene utilizzato un archivio dati denominato Upgrade.

È inoltre possibile copiare in remoto e in modo sicuro il pacchetto di aggiornamento ESXI in una cartella appropriata con spazio sufficiente con SCP.

scp local_filename user@ESXIserver:/path/where/file/should/goPassaggio 3. SSH sull'host ESXI in modalità manutenzione e passare alla cartella del datastore in cui viene copiato il bundle di aggiornamento ESXI. In questo scenario, il file è disponibile nell'archivio dati di aggiornamento.

[root@Monterrey-server-1:~]cd /vmfs/volumes/UpgradePer verificare la versione corrente, usare il comando vmware -v

[root@Monterrey-server-1:~] vmware -v

VMware ESXi 7.0.3 build-23794027

Eseguire questo comando per visualizzare i dettagli del profilo del pacchetto: Elenco profili origini software esxcli -d /complete/path/VMware-ESXi...zip

[root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software sources profile list -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip

Name Vendor Acceptance Level Creation Time Modification Time

----------------------------- ------------ ---------------- ------------------- -----------------

ESXi-7.0U3s-24585291-standard VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-03-04T00:00:00

ESXi-7.0U3s-24585291-no-tools VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-02-21T03:24:14

Passaggio 4. Eseguire questo comando per installare la patch: aggiornamento profilo software esxcli -d /complete/path/VMware-ESXi...zip -p NomeProfiloPacchetto e attendere finché non viene visualizzato il risultato corretto.

root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software profile update -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip -p ESXi-7.0U3s-24585291-standard

Update Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: VMware_bootbank_bmcal_7.0.3-0.135.24585291, VMware_bootbank_cpu-microcode_7.0.3-0.135.24585291, VMware_bootbank_crx_7.0.3-0.135.24585291, VMware_bootbank_esx-base_7.0.3-0.135.24585291, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.135.24585291, VMware_bootbank_esx-update_7.0.3-0.135.24585291, VMware_bootbank_esx-xserver_7.0.3-0.135.24585291, VMware_bootbank_esxio-combiner_7.0.3-0.135.24585291, VMware_bootbank_gc_7.0.3-0.135.24585291, VMware_bootbank_loadesx_7.0.3-0.135.24585291, VMware_bootbank_native-misc-drivers_7.0.3-0.135.24585291, VMware_bootbank_trx_7.0.3-0.135.24585291, VMware_bootbank_vdfs_7.0.3-0.135.24585291, VMware_bootbank_vsan_7.0.3-0.135.24585291, VMware_bootbank_vsanhealth_7.0.3-0.135.24585291

VIBs Removed: VMware_bootbank_bmcal_7.0.3-0.125.23794027, VMware_bootbank_cpu-microcode_7.0.3-0.125.23794027, VMware_bootbank_crx_7.0.3-0.125.23794027, VMware_bootbank_esx-base_7.0.3-0.125.23794027, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.125.23794027, VMware_bootbank_esx-update_7.0.3-0.125.23794027, VMware_bootbank_esx-xserver_7.0.3-0.125.23794027, VMware_bootbank_esxio-combiner_7.0.3-0.125.23794027, VMware_bootbank_gc_7.0.3-0.125.23794027, VMware_bootbank_loadesx_7.0.3-0.125.23794027, VMware_bootbank_native-misc-drivers_7.0.3-0.125.23794027, VMware_bootbank_trx_7.0.3-0.125.23794027, VMware_bootbank_vdfs_7.0.3-0.125.23794027, VMware_bootbank_vsan_7.0.3-0.125.23794027, VMware_bootbank_vsanhealth_7.0.3-0.125.23794027

VIBs Skipped: VMW_bootbank_atlantic_1.0.3.0-8vmw.703.0.20.19193900, VMW_bootbank_bnxtnet_216.0.50.0-44vmw.703.0.50.20036589, VMW_bootbank_bnxtroce_216.0.58.0-23vmw.703.0.50.20036589, VMW_bootbank_brcmfcoe_12.0.1500.2-3vmw.703.0.20.19193900, VMW_bootbank_elxiscsi_12.0.1200.0-9vmw.703.0.20.19193900, VMW_bootbank_elxnet_12.0.1250.0-5vmw.703.0.20.19193900, VMW_bootbank_i40en_1.11.1.32-1vmw.703.0.125.23794027, VMW_bootbank_iavmd_2.7.0.1157-3vmw.703.0.105.22348816, VMW_bootbank_icen_1.4.1.20-1vmw.703.0.50.20036589, VMW_bootbank_igbn_1.4.11.2-1vmw.703.0.20.19193900, VMW_bootbank_ionic-en_16.0.0-16vmw.703.0.20.19193900, VMW_bootbank_irdman_1.3.1.22-1vmw.703.0.50.20036589, VMW_bootbank_iser_1.1.0.1-1vmw.703.0.50.20036589, VMW_bootbank_ixgben_1.7.1.35-1vmw.703.0.20.19193900, VMW_bootbank_lpfc_14.0.169.26-5vmw.703.0.50.20036589, VMW_bootbank_lpnic_11.4.62.0-1vmw.703.0.20.19193900, VMW_bootbank_lsi-mr3_7.718.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt2_20.00.06.00-4vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt35_19.00.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt3_17.00.12.00-2vmw.703.0.105.22348816, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.703.0.20.19193900, VMW_bootbank_ne1000_0.9.0-1vmw.703.0.50.20036589, VMW_bootbank_nenic_1.0.33.0-1vmw.703.0.20.19193900, VMW_bootbank_nfnic_4.0.0.70-1vmw.703.0.20.19193900, VMW_bootbank_nhpsa_70.0051.0.100-4vmw.703.0.20.19193900, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx5-core_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_nmlx5-rdma_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_ntg3_4.1.9.0-5vmw.703.0.90.21686933, VMW_bootbank_nvme-pcie_1.2.3.16-3vmw.703.0.105.22348816, VMW_bootbank_nvmerdma_1.0.3.5-1vmw.703.0.20.19193900, VMW_bootbank_nvmetcp_1.0.0.3-1vmw.703.0.125.23794027, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.703.0.20.19193900, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.703.0.20.19193900, VMW_bootbank_pvscsi_0.1-4vmw.703.0.20.19193900, VMW_bootbank_qcnic_1.0.15.0-14vmw.703.0.20.19193900, VMW_bootbank_qedentv_3.40.5.53-22vmw.703.0.20.19193900, VMW_bootbank_qedrntv_3.40.5.53-18vmw.703.0.20.19193900, VMW_bootbank_qfle3_1.0.67.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3f_1.0.51.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3i_1.0.15.0-15vmw.703.0.20.19193900, VMW_bootbank_qflge_1.1.0.11-1vmw.703.0.20.19193900, VMW_bootbank_rste_2.0.2.0088-7vmw.703.0.20.19193900, VMW_bootbank_sfvmk_2.4.0.2010-6vmw.703.0.20.19193900, VMW_bootbank_smartpqi_70.4149.0.5000-1vmw.703.0.20.19193900, VMW_bootbank_vmkata_0.1-1vmw.703.0.20.19193900, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.703.0.20.19193900, VMW_bootbank_vmkusb_0.1-8vmw.703.0.85.21424296, VMW_bootbank_vmw-ahci_2.0.11-3vmw.703.0.125.23794027, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.703.0.20.19193900, VMware_bootbank_esx-ui_2.13.2-22721163, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.703.0.20.19193900, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.7.2173-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-12vmw.703.0.50.20036589, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-9vmw.703.0.105.22348816, VMware_bootbank_qlnativefc_4.1.14.0-26vmw.703.0.20.19193900, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.44-1vmw.703.0.20.19193900, VMware_locker_tools-light_12.3.5.22544099-23794019

Passaggio 5. Al termine dell'aggiornamento, riavviare l'host ESXi.

Passaggio 6. SSH sull'host e verificare la versione con il comando: vmware -v

[root@Monterrey-server-1:~] vmware -v

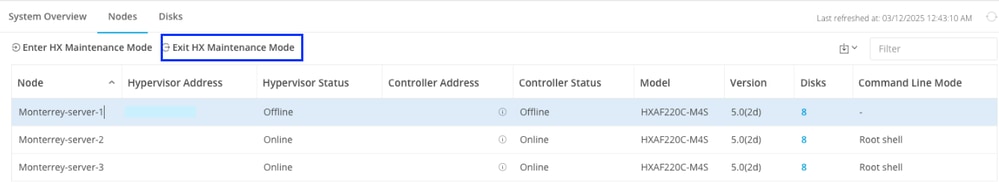

VMware ESXi 7.0.3 build-24585291Passaggio 7. Uscire dal nodo dalla modalità di manutenzione e attendere che il cluster diventi integro.

Aprire la connessione HX, scegliere System Information> Nodes, scegliere il nodo in modalità di manutenzione e fare clic su Exit HX Maintenance Mode

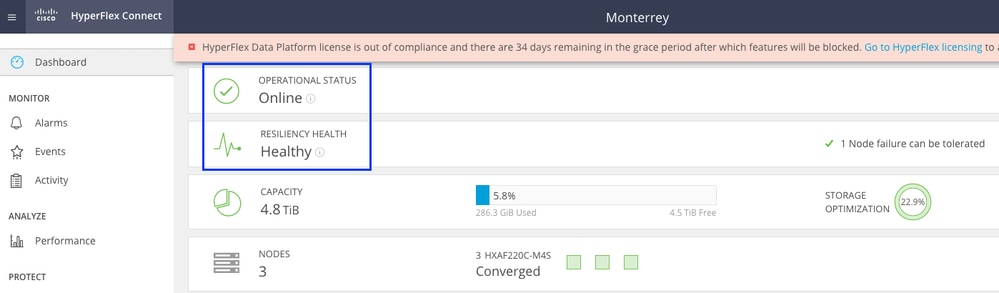

Attendere alcuni minuti prima che il cluster Hyperflex completi la correzione. Il dashboard di connessione HX mostra lo stato operativo, deve essere online e lo stato della resilienza deve essere integro.

Verificare inoltre che il server sia in grado di visualizzare tutti gli archivi dati.

Ripetere i passaggi su tutti i nodi che fanno parte del cluster, uno alla volta.

Aggiorna tramite interfaccia utente di connessione HX

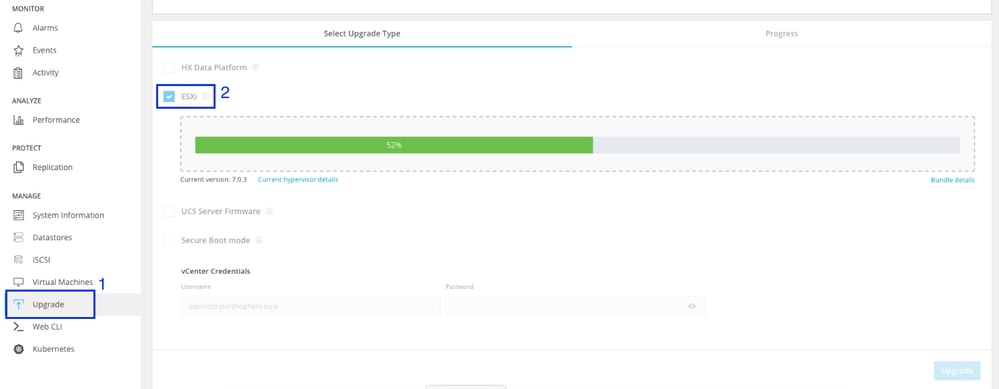

Passare alla scheda Aggiornamento, selezionare il tipo di aggiornamento ESXI e caricare il file di aggiornamento ESXI.

Nota: Se il cluster si trova nella versione HX 5.5 o 6.0, è necessario eseguire un aggiornamento combinato selezionando HX Data Platform e caricando il bundle HX della versione corrente

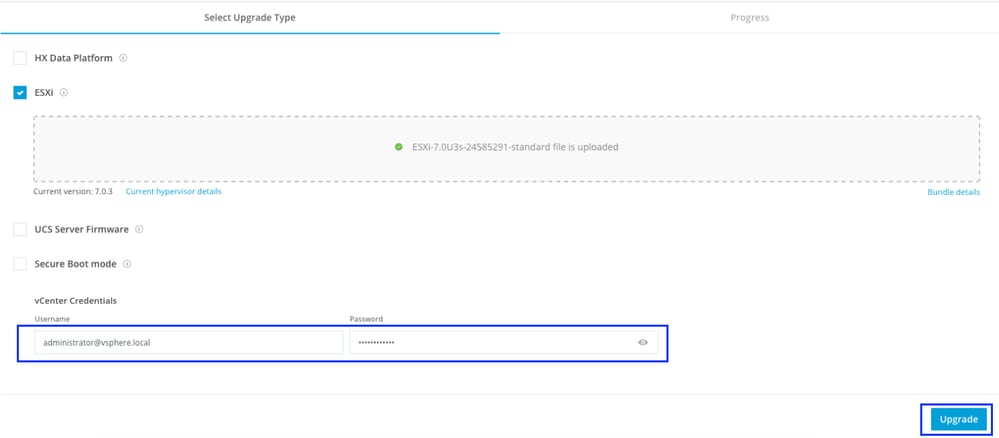

Una volta caricato il file, immettere le credenziali vCenter e fare clic su Aggiorna.

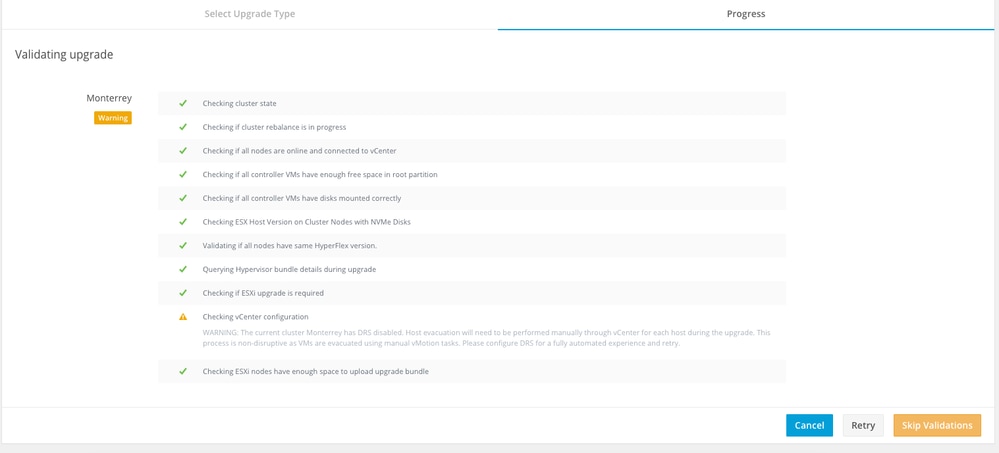

La prima fase consiste nel convalidare l'aggiornamento. Se DRS (Distributed Resource Scheduler) è abilitato, le VM vengono automaticamente sottoposte a vMotion su altri host.

Fare clic su Ignora convalide e avviare automaticamente l'aggiornamento.

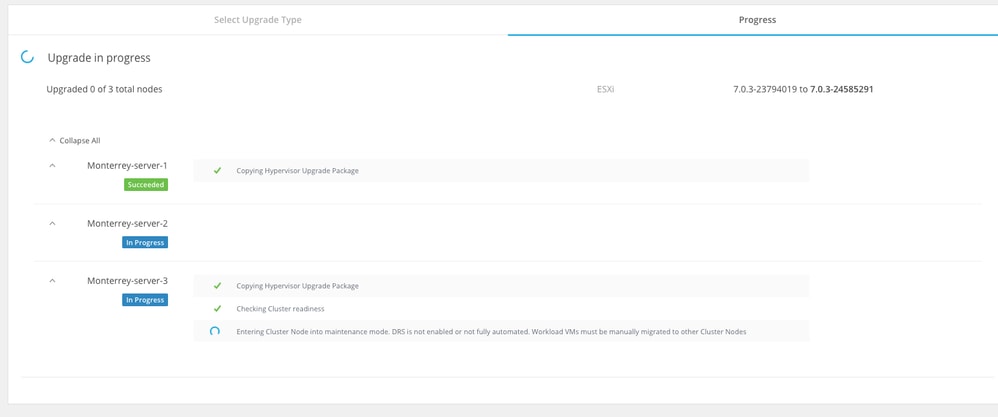

Monitorare il processo di aggiornamento.

Nota: Se DRS è disattivato, vMotion le VM continueranno manualmente il processo di aggiornamento.

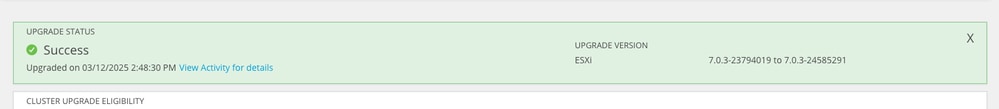

Attendere il completamento dell'aggiornamento in tutti i nodi del cluster.

Verifica

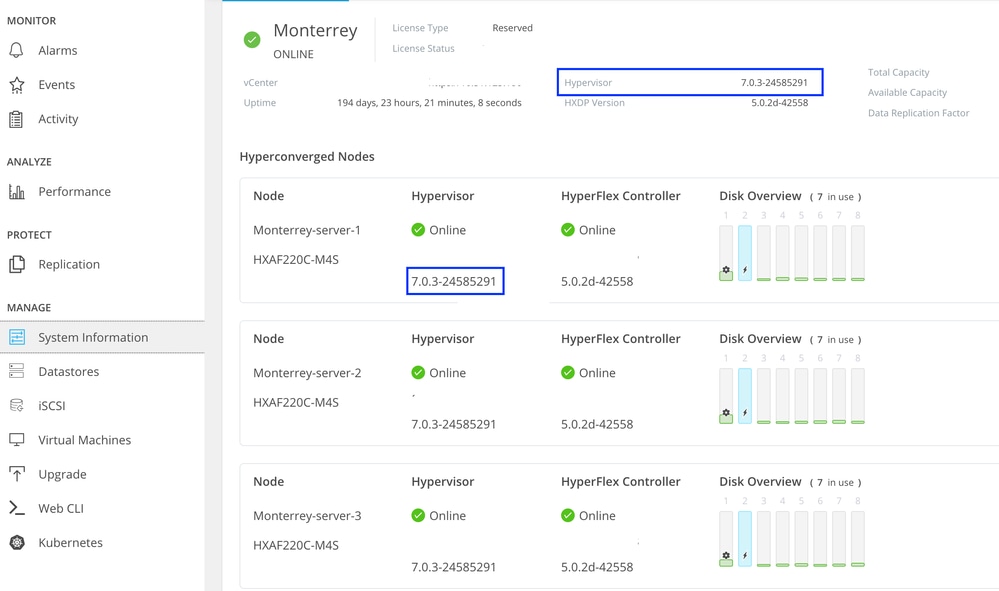

È possibile verificare la versione installata di ESXI da HX Connect nella scheda System Information.

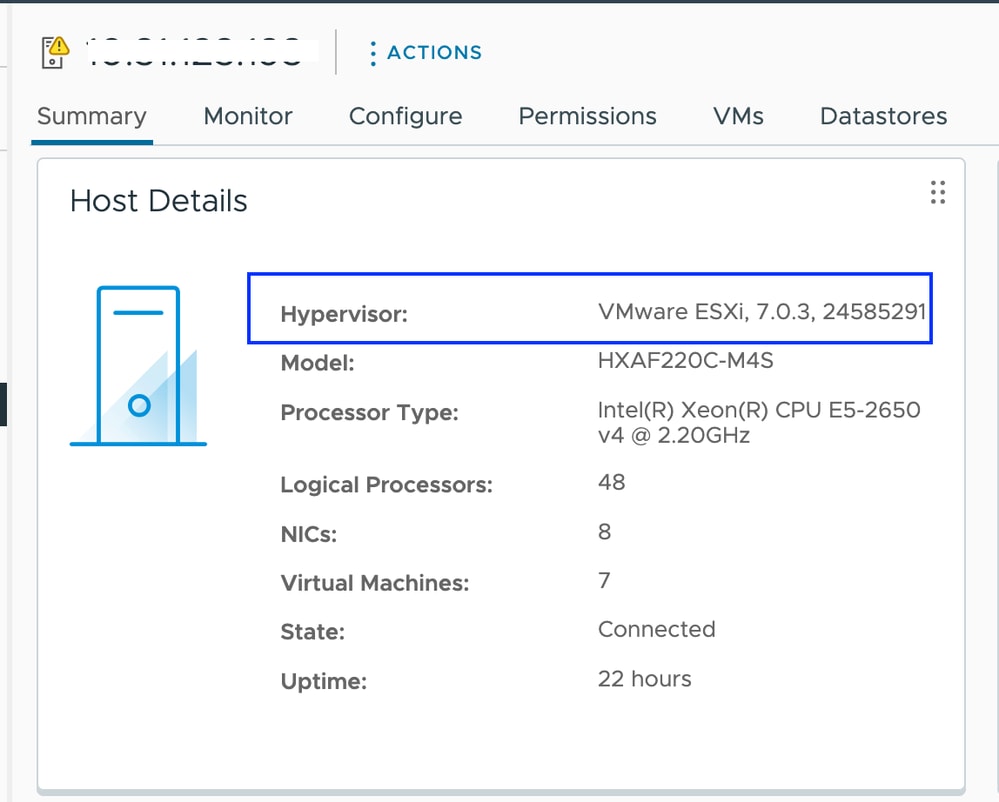

Da vCenter è possibile visualizzare la versione ESXI nel riepilogo del server.

Poiché l'immagine ESXI non è personalizzata, è necessario confermare che i file VIB di Hyperflex sono ancora visualizzati intatti sui server.

SSH su ciascun host ESXI dopo il completamento della patch e prima di iniziare con il nodo successivo e verificare gli Hyperflex VIB con il comando: elenco vib software esxcli | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

Nota: Nelle versioni ESXi 7.0 U3, vmware-esx-STFSNasPlugin è stato cambiato in CIS-ESX-STFSNasPlugi

Nelle versioni ESXi 8.0 U1, stHypervisorSvc è stato modificato in sthypervisorsvc.

[root@Monterrey-server-1:~] esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

CIS-ESX-STFSNasPlugin 4.5.1-11 CIS VMwareAccepted 2023-10-25

scvmclient 5.5.1-38 CIS VMwareAccepted 2023-11-25

stHypervisorSvc 4.5.1-11 CIS VMwareAccepted 2023-10-24

Attenzione: In alcuni scenari, l'immagine non personalizzata può sovrascrivere le VIB neniche e nfnic con una versione diversa da quelle dell'immagine personalizzata. È necessario verificare che siano disponibili le versioni corrette dopo la patch.

SSH su ciascun host ESXI dopo il completamento della patch e prima di iniziare con il nodo successivo e verificare gli Hyperflex VIB con il comando: elenco vib software esxcli | egrep -i 'nenic|nfnic'

[root@Monterrey-server-3:~] esxcli software vib list | egrep -i 'nenic|nfnic'

nfnic 5.0.0.43-1OEM.700.1.0.15843807 CIS VMwareCertified 2025-02-23

nenic-ens 1.0.6.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2023-10-25

nenic 2.0.10.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2024-03-17

Risoluzione dei problemi

Se nenic o nfnic sono stati sovrascritti con una versione diversa, è possibile installare quelle corrette scaricando un'immagine zip ESXI personalizzata della stessa versione da software.cisco.com. Decomprimere l'immagine a e dalla directory vib cercare le directory nenic e nfnic. Estrarre il file vib e caricarlo tramite vCenter in un datastore installato sui server. Verificare che il cluster sia online e integro.

Passaggio 1. Da HX Connect (Connessione HX) passare a System Information > Nodes (Informazioni di sistema), selezionare uno degli host e fare clic su Enter HX Maintenance Mode (Accedi modalità manutenzione HX).

Una volta che l'host entra in modalità di manutenzione, procedere con i passaggi successivi.

SSH all'host ESXI in modalità di manutenzione e passare alla cartella del datastore in cui è stato copiato il file ESXI vib. In questo scenario, il file è disponibile nell'archivio dati di aggiornamento

[root@Monterrey-server-3:~] cd /vmfs/volumes/Upgrade

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] ls

CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib

Eseguire questo comando per aggiornare il file vib: aggiornamento vib software esxcli -v "/complete/path/vib-file.vib" -f

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] esxcli software vib update -v "/vmfs/volumes/Upgrade/CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib" -f

Installation Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807

VIBs Removed: Cisco_bootbank_nenic_1.0.45.0-1OEM.700.1.0.15843807

VIBs Skipped:

Al termine dell'aggiornamento vib, riavviare l'host ESXi.

SSH sull'host e verificare che il file vib sia stato aggiornato correttamente con il comando esxcli software vib list | egrep -i 'nenic|nfnic'

Uscire dal nodo dalla modalità di manutenzione e attendere che il cluster diventi integro.

Aprire la connessione HX, scegliere System Information> Nodes, scegliere il nodo in modalità di manutenzione e fare clic su Exit HX Maintenance Mode

Se il server viene avviato dalla scheda SD, è possibile riscontrare un problema noto durante l'applicazione della patch. "Impossibile correggere l'host a causa di un errore durante l'attesa del processo di ripristino" Questo problema si verifica quando il funzionamento di singoli VIB richiede più del timeout predefinito di 30 secondi durante il processo di ripristino. Per gli ambienti che utilizzano la scheda SD come partizione OSData, è possibile che il processo VMware tools untar richieda una durata leggermente superiore. È possibile fare riferimento a questo articolo per risolverlo.

Cronologia delle revisioni

| Revisione | Data di pubblicazione | Commenti |

|---|---|---|

1.0 |

14-Mar-2025

|

Versione iniziale |

Contributo dei tecnici Cisco

- Alejandra Ortiz RegaladoTecnico di consulenza

Feedback

Feedback