Configurare il multicast di routing del tenant (TRM) in ACI

Opzioni per il download

Linguaggio senza pregiudizi

La documentazione per questo prodotto è stata redatta cercando di utilizzare un linguaggio senza pregiudizi. Ai fini di questa documentazione, per linguaggio senza di pregiudizi si intende un linguaggio che non implica discriminazioni basate su età, disabilità, genere, identità razziale, identità etnica, orientamento sessuale, status socioeconomico e intersezionalità. Le eventuali eccezioni possono dipendere dal linguaggio codificato nelle interfacce utente del software del prodotto, dal linguaggio utilizzato nella documentazione RFP o dal linguaggio utilizzato in prodotti di terze parti a cui si fa riferimento. Scopri di più sul modo in cui Cisco utilizza il linguaggio inclusivo.

Informazioni su questa traduzione

Cisco ha tradotto questo documento utilizzando una combinazione di tecnologie automatiche e umane per offrire ai nostri utenti in tutto il mondo contenuti di supporto nella propria lingua. Si noti che anche la migliore traduzione automatica non sarà mai accurata come quella fornita da un traduttore professionista. Cisco Systems, Inc. non si assume alcuna responsabilità per l’accuratezza di queste traduzioni e consiglia di consultare sempre il documento originale in inglese (disponibile al link fornito).

Sommario

Introduzione

In questo documento viene descritto come configurare il trm (Tenant Routed Multicast) in ACI per abilitare il routing multicast di layer 3 tra VRF.

Prerequisiti

Abbreviazioni

ACI: Infrastruttura incentrata sull'applicazione

VRF: Routing e inoltro virtuale

BD: Dominio bridge

EPG: Gruppo EndPoint

IGMP: Protocollo Internet Group Management

PIM: Multicast indipendente dal protocollo

ASM: Any Source Multicast

RP: Punto di rendering

DURATA: Multicast con routing tenant

SVI Interfaccia virtuale switch

vPC: virtual Port-channel

Requisiti

Per questo articolo è consigliabile avere una conoscenza generale dei seguenti argomenti:

- Concetti ACI: Criteri di accesso, apprendimento degli endpoint, contratti e L3out

- Protocolli multicast: IGMP e PIM

Componenti usati

Questo esempio di configurazione è basato sulla versione ACI 6.0(7e) con gli switch Nexus di seconda generazione N9K-C93180YC-EX con ACI versione 16.0(7).

Le informazioni discusse in questo documento fanno riferimento a dispositivi usati in uno specifico ambiente di emulazione. Su tutti i dispositivi menzionati nel documento la configurazione è stata ripristinata ai valori predefiniti. Se la rete è operativa, valutare attentamente eventuali conseguenze derivanti dall'uso dei comandi.

Configurazione

Questo articolo è incentrato sulla configurazione multicast, pertanto l'esempio presuppone che si disponga già di raggiungibilità unicast all'interno e all'esterno dell'infrastruttura.

Suggerimento: Se non è disponibile la raggiungibilità unicast tra le parti interessate (origine multicast, RP, ricevitori e così via), è molto probabile che il flusso multicast venga influenzato.

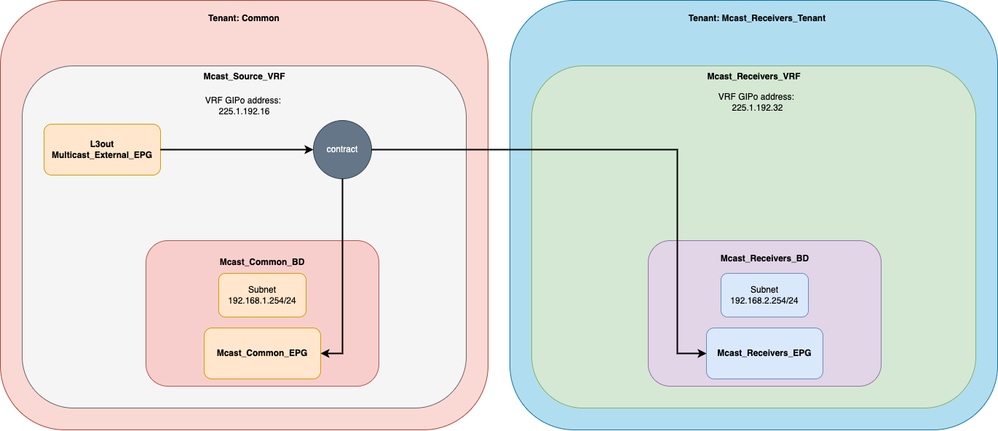

Lo scopo di questo esempio di configurazione è abilitare prima il multicast sul tenant/VRF comune per consentire al traffico di entrare nella fabric tramite un'uscita L3 e di essere ricevuto sui ricevitori sul VRF comune. Quindi, la seconda parte verte su come estendere questo flusso multicast a un diverso VRF sul tenant definito dall'utente.

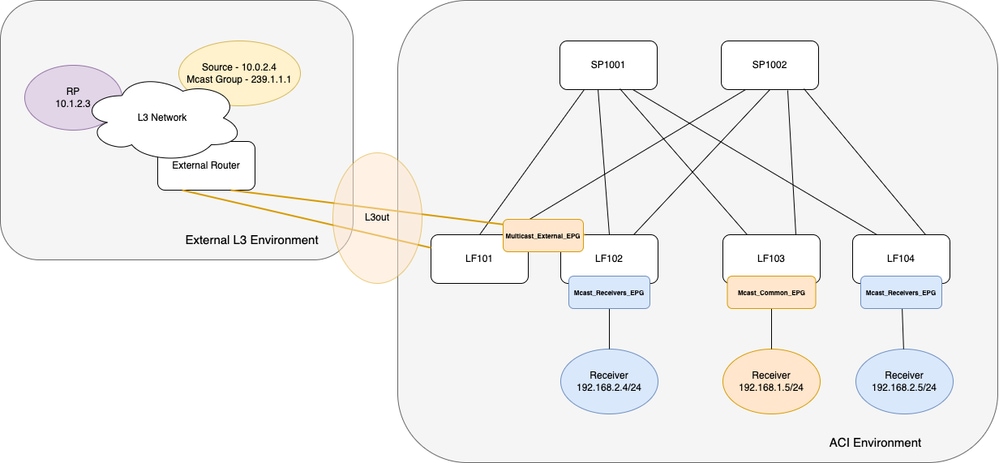

ACI Fabric è un singolo POD con 2 Spine e 4 Interruttori Leaf. Due di questi quattro switch Leaf sono switch con interfaccia border-leaf che si connettono a uno switch NXOS L3 esterno tramite un'uscita OSPF-L3. La configurazione della rete L3 esterna non è trattata in questo articolo.

All'interno dell'infrastruttura sono connessi 3 endpoint che ricevono il traffico multicast. Ogni endpoint è connesso a uno switch foglia diverso. Logicamente, in ogni endpoint sono presenti due tenant con un VRF. Un tenant è il tenant comune e un altro è un tenant definito dall'utente. Sul tenant comune si ha l'EPG esterno per l'L3out e un ricevitore. Nel tenant definito dall'utente sono presenti due ricevitori che fanno parte dello stesso EPG. Per ulteriori informazioni, vedere i diagrammi nella sezione successiva.

Esempio di rete

Topologia fisica

Diagramma logico

Configurazione del multicast nel VRF di origine

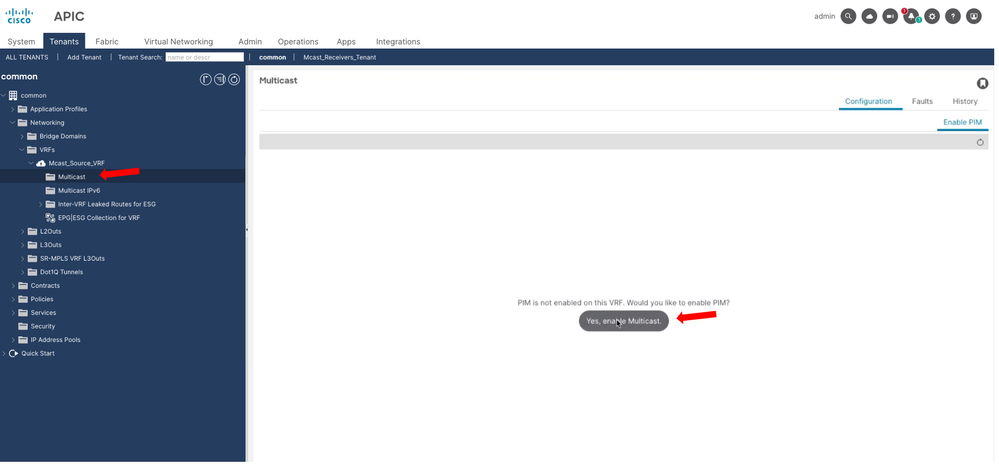

Passaggio 1. Abilitare il multicast a livello VRF.

Passare a Tenant > comune > Rete > VRF > Mcast_Source_VRF > Multicast e nel riquadro principale selezionare Sì, abilita multicast.

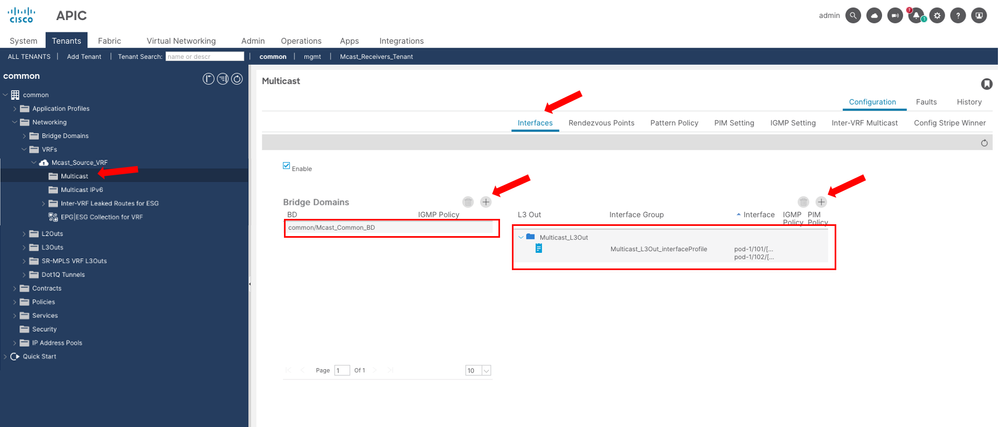

Passaggio 2. Aggiungere i domini bridge e L3Out.

Passare a Tenant > comune > Rete > VRF > Mcast_Source_VRF > Multicast e nel riquadro principale della scheda Interfacce è possibile aggiungere i domini bridge e le uscite L3out che partecipano al flusso multicast.

Questi domini bridge e le uscite L3 sono locali rispetto al VRF.

Attenzione: Su ciascun border-leaf abilitato per il multicast L3, è necessario avere un indirizzo di loopback IPv4 univoco raggiungibile dalla rete esterna. Viene utilizzato per i messaggi PIM Hello. Nell'esempio, l'uscita L3D è stata configurata per utilizzare l'ID router OSPF come interfaccia di loopback.

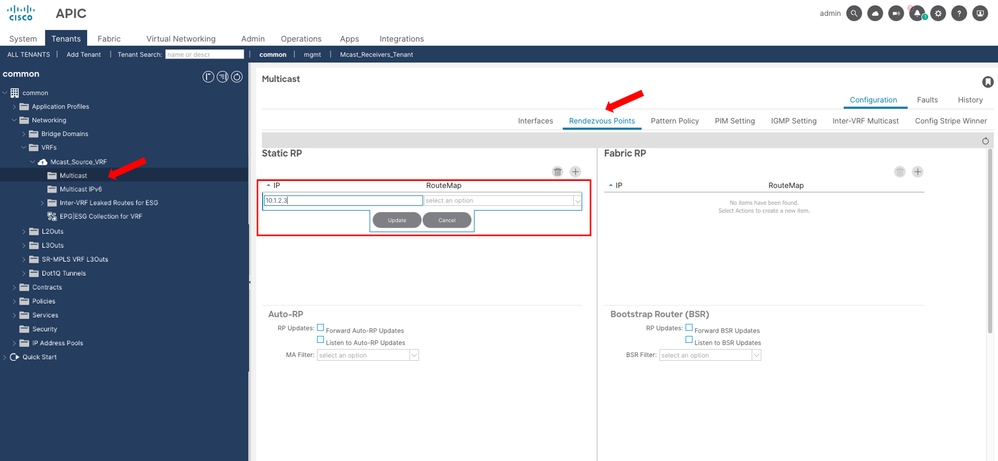

Passaggio 3. Configurare l'RP.

Passare a Tenant > comune > Rete > VRF > Mcast_Source_VRF > Multicast e nel riquadro principale della scheda Punti di rendering sono visualizzate le opzioni per configurare l'RP.

Nota: In questo esempio viene utilizzato un RP statico per tutti i gruppi multicast, pertanto non viene specificato RouteMap.

Dopo questo passaggio, il traffico multicast sta raggiungendo il ricevitore 192.168.1.5 sul tenant/VRF comune.

Configurazione Multicast nel ricevitore VRF - Multicast di routing tenant

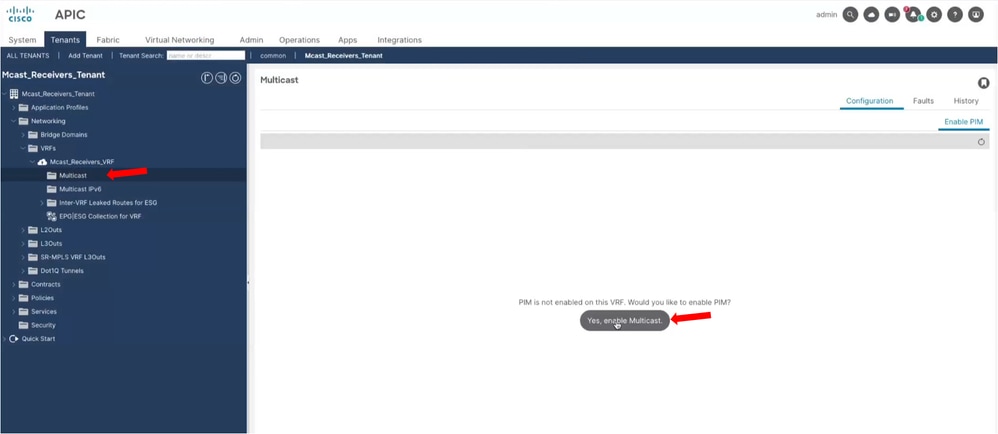

Passaggio 1. Abilitare il multicast a livello VRF.

Passare a Tenant > Mcast_Receivers_Tenant > Rete > VRF > Mcast_Receivers_VRF > Multicast e nel riquadro principale selezionare Sì, abilita multicast.

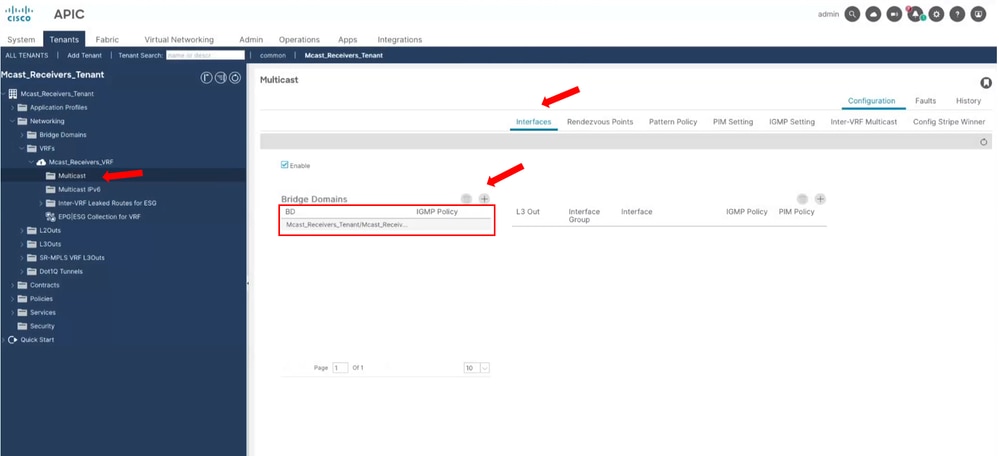

Passaggio 2. Aggiungere domini Bridge.

Passare a Tenant > Mcast_Receivers_Tenant > Rete > VRF > Mcast_Receivers_VRF > Multicast e nel riquadro principale della scheda Interfacce è possibile aggiungere i domini bridge che partecipano al flusso multicast.

Questi domini bridge sono locali rispetto al VRF.

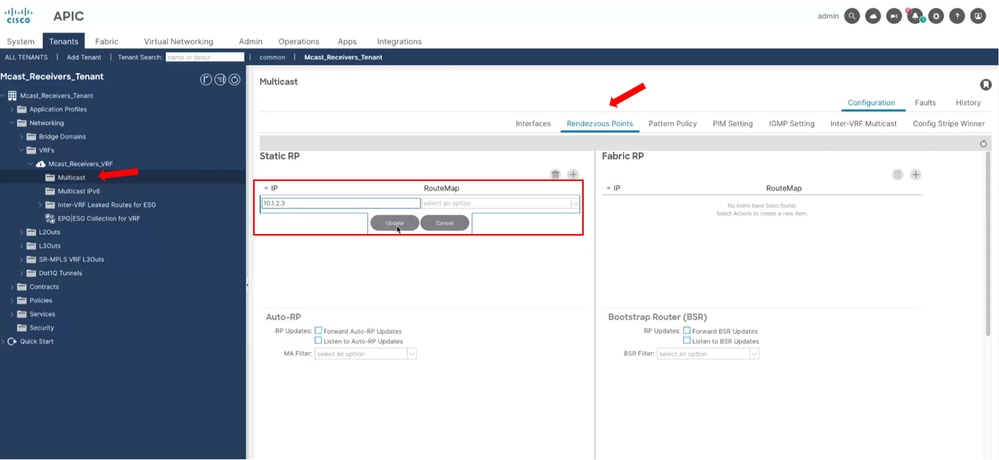

Passaggio 3. Configurare l'RP.

Passare a Tenant > Mcast_Receivers_Tenant > Reti > VRF > Mcast_Receivers_VRF > Multicast e nel riquadro principale della scheda Punti di rendering sono visualizzate le opzioni per la configurazione dell'RP.

Nota: In questo esempio viene utilizzato un RP statico per tutti i gruppi multicast, pertanto non viene specificato RouteMap.

Passaggio 4. Configurare Il Multicast Di Routing Del Tenant.

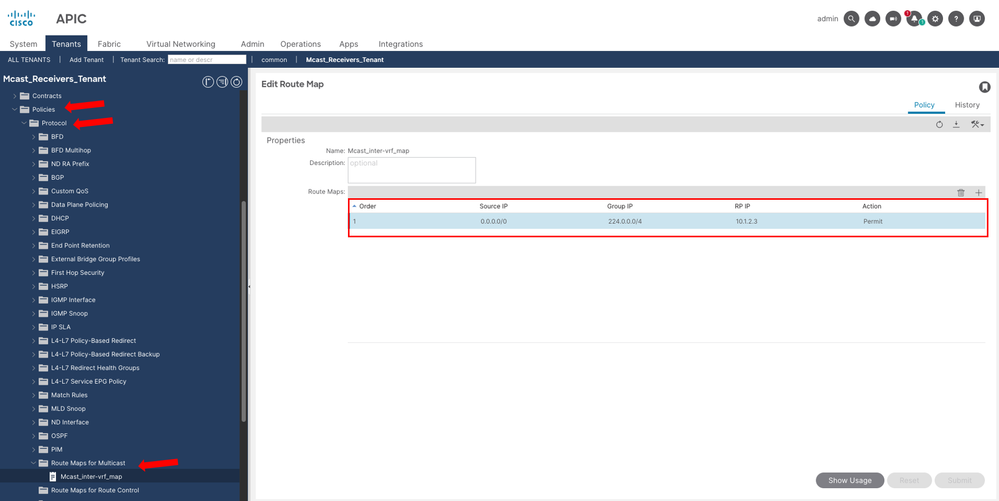

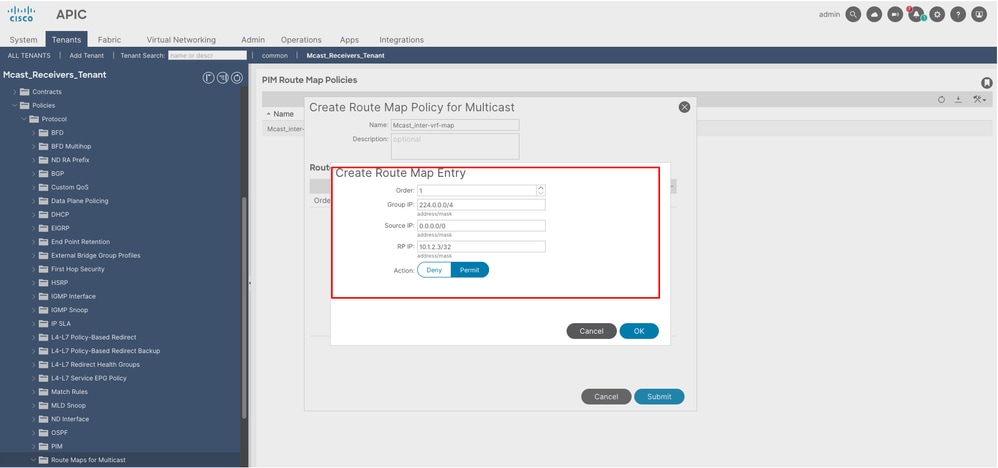

Passaggio 4.1. Creare una RouteMap per consentire il traffico multicast dal VRF di origine al VRF di ricezione.

Passare a Tenant > Mcast_Receivers_Tenant > Criteri > Protocollo > Route map per multicast, fare clic con il pulsante destro del mouse per crearne una nuova.

Assegnate un nome e aggiungete una voce della mappa route. Tutti i valori IP sono intervalli basati sulla network mask. Impostare l'azione su Consenti per consentire il traffico.

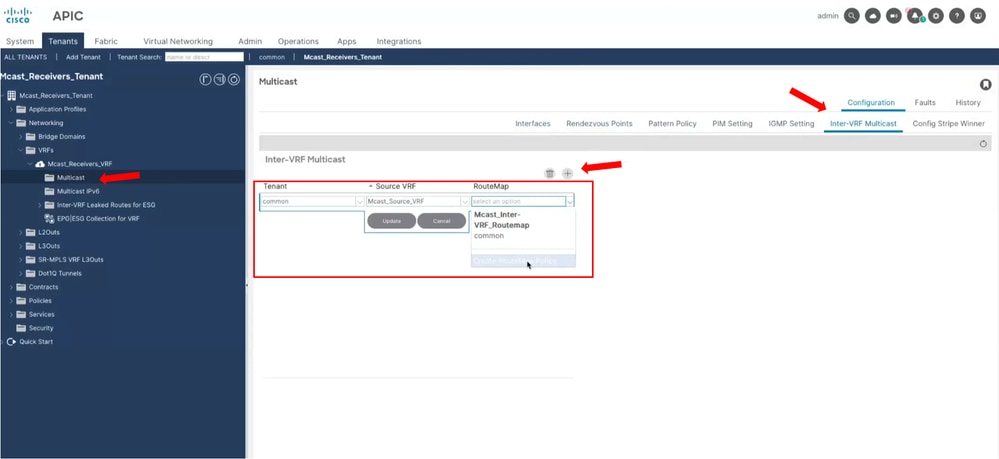

Passaggio 4.2. Applicare la RouteMap sul ricevitore VRF.

Passare a Tenant > Mcast_Receivers_Tenant > Rete > VRF > Mcast_Receivers_VRF > Multicast e nel riquadro principale della scheda Multicast tra VRF selezionare il tenant e il VRF da cui proviene il traffico multicast. Inoltre, selezionare la RouteMap appena creata.

Suggerimento: In questa fase è anche possibile creare la RouteMap.

Dopo questo passaggio, il traffico multicast sta raggiungendo il ricevitore 192.168.2.4 sul tenant/VRF comune. Il ricevitore 192.168.2.5 non riesce a ottenere il traffico a causa di una limitazione discussa nella sezione successiva.

Limitazioni

In questo articolo vengono evidenziate alcune importanti considerazioni relative alla progettazione. Per le linee guida e le limitazioni complete, fare riferimento a:

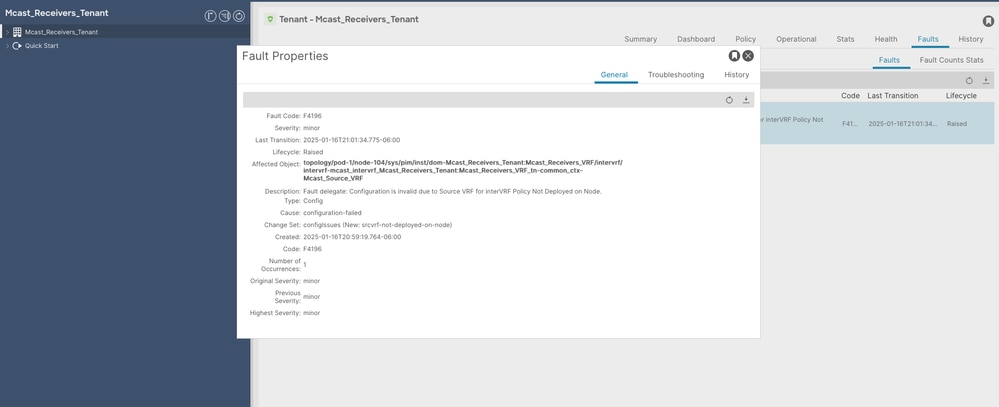

Con il TRM, ogni elemento foglia con il ricevitore VRF deve avere il VRF sorgente installato. Se non è presente, si verifica un errore di configurazione.

Nota: Per questo motivo, il ricevitore 192.168.2.5 non ha ricevuto il flusso multicast. Perché il VRF di origine non è distribuito su LF104. Al contrario, il ricevitore 192.168.2.4 ha ricevuto il flusso multicast perché su LF102 il VRF di origine è distribuito perché l'uscita L3 si trova su tale foglia

L3out supporta le seguenti interfacce per il multicast L3:

- Interfacce di routing

- Sottointerfacce di routing

- Canali porta L3

- Interfacce SVI (non in vPC)

Nota: Nell'esempio di configurazione, vengono utilizzate interfacce SVI che NON sono presenti in vPC. L'utilizzo di SVI su un'uscita vPC L3 non è supportato per il multicast L3.

Su ciascun border-leaf abilitato per il multicast L3 è necessario avere un indirizzo di loopback IPv4 univoco raggiungibile dalla rete esterna. Viene utilizzato per i messaggi PIM Hello

Nota: Nell'esempio, l'uscita L3D è stata configurata per utilizzare l'ID router OSPF come interfaccia di loopback.

Procedura di verifica e comandi per la risoluzione dei problemi

Ricevitori attivi

Una volta aggiunto il dominio bridge alle interfacce multicast (passaggio 2), IGMP è ora abilitato. Se vi sono endpoint che richiedono attivamente traffico multicast, è possibile visualizzarlo con il comando successivo.

LF102# show ip igmp groups vrf Mcast_Receivers_Tenant:Mcast_Receivers_VRF

Type: S - Static, D - Dynamic, L - Local, T - SSM Translated

IGMP Connected Group Membership for VRF "Mcast_Receivers_Tenant:Mcast_Receivers_VRF"

Group Address Type Interface Uptime Expires Last Reporter

239.1.1.1 D vlan39 3d5h 00:02:49 192.168.2.4

LF102# LF103# show ip igmp groups vrf common:Mcast_Source_VRF

Type: S - Static, D - Dynamic, L - Local, T - SSM Translated

IGMP Connected Group Membership for VRF "common:Mcast_Source_VRF"

Group Address Type Interface Uptime Expires Last Reporter

239.1.1.1 D vlan82 05:22:51 00:03:51 192.168.1.5

LF103#LF104# show ip igmp groups vrf Mcast_Receivers_Tenant:Mcast_Receivers_VRF

Type: S - Static, D - Dynamic, L - Local, T - SSM Translated

IGMP Connected Group Membership for VRF "Mcast_Receivers_Tenant:Mcast_Receivers_VRF"

Group Address Type Interface Uptime Expires Last Reporter

239.1.1.1 D vlan73 3d5h 00:02:36 192.168.2.5

LF104# Indirizzo IP e gruppo RP distribuiti

Una volta configurato l'IP RP (Passaggio 3), è possibile verificare che venga distribuito correttamente in ciascuna foglia del rispettivo VRF.

LF102# show ip pim rp vrf common:Mcast_Source_VRF

PIM RP Status Information for VRF:"common:Mcast_Source_VRF"

BSR disabled

Auto-RP disabled

RP: 10.1.2.3, uptime: 3d5h, expires: never

priority: 0, RP-source: (local) group-map: None, group ranges:

224.0.0.0/4

LF102# show ip pim rp vrf Mcast_Receivers_Tenant:Mcast_Receivers_VRF

PIM RP Status Information for VRF:"Mcast_Receivers_Tenant:Mcast_Receivers_VRF"

BSR disabled

Auto-RP disabled

RP: 10.1.2.3, uptime: 3d5h, expires: never

priority: 0, RP-source: (local) group-map: None, group ranges:

224.0.0.0/4

LF102# Adiacenza PIM

Dopo aver aggiunto l'uscita L3a alle interfacce multicast (passaggio 2), PIM è ora abilitato. Verificare che il vicinato PIM su L3out sia formato. Si può anche vedere che le foglie di confine cambiano dal vicinato PIM tra loro sopra il tessuto.

LF101# show ip pim neighbor vrf common:Mcast_Source_VRF

PIM Neighbor information for Dom:common:Mcast_Source_VRF

Neighbor Interface Uptime Expires DRPriority Bidir BFDState

10.0.0.102/32 tunnel17 3d13h 00:01:44 1 no n/a

10.0.1.4/32 vlan39 3d5h 00:01:39 1 yes n/a

LF101# LF102# show ip pim neighbor vrf common:Mcast_Source_VRF

PIM Neighbor information for Dom:common:Mcast_Source_VRF

Neighbor Interface Uptime Expires DRPriority Bidir BFDState

10.0.0.101/32 tunnel19 3d13h 00:01:25 1 no n/a

10.0.2.4/32 vlan42 3d5h 00:01:22 1 yes n/a

LF102# Vincitore

Se sono presenti più switch a foglia di bordo con PIM attivato, uno viene scelto come vincitore di Stripe. Il vincitore di Stripe è responsabile dell'invio dei messaggi di join/eliminazione PIM a origini esterne/RP. Inoltre, è anche responsabile di inoltrare il traffico nel fabric. È possibile avere più di una Stripe-Winner, ma questo argomento non viene trattato in questo esempio.

Con il comando successivo è possibile verificare quale bordo foglia viene scelto come vincitore di Stripe

LF101# show ip pim internal stripe-winner 239.1.1.1 vrf common:Mcast_Source_VRF

PIM Stripe Winner info for VRF "common:Mcast_Source_VRF" (BL count: 2)

(*, 239.1.1.1)

BLs:

Group hash 1656089684 VNID 2326529

10.0.0.101 hash: 277847025 (local)

10.0.0.102 hash: 1440909112

Winner: 10.0.0.102 best_hash: 1440909112

Configured Stripe Winner info for VRF "common:Mcast_Source_VRF"

Not found

LF101# LF102# show ip pim internal stripe-winner 239.1.1.1 vrf common:Mcast_Source_VRF

PIM Stripe Winner info for VRF "common:Mcast_Source_VRF" (BL count: 2)

(*, 239.1.1.1)

BLs:

Group hash 1656089684 VNID 2326529

10.0.0.102 hash: 1440909112 (local)

10.0.0.101 hash: 277847025

Winner: 10.0.0.102 best_hash: 1440909112

Configured Stripe Winner info for VRF "common:Mcast_Source_VRF"

Not found

LF102# Mroute

Il controllo delle route è utile per molte operazioni.

- È possibile verificare se esiste una voce (S,G), ovvero se viene ricevuto traffico da un'origine specifica.

- Controllare l'interfaccia in ingresso e verificare che sia il percorso previsto verso l'origine e l'RP.

- Controllare l'elenco delle interfacce in uscita per vedere dove il traffico viene inoltrato e come ha ottenuto quella voce, tramite IGMP o PIM.

- Sugli switch a foglia di bordo è possibile vedere anche chi è il vincitore Stripe. Ha i Mroute, e non i border-leaf non eletti.

LF101# show ip mroute 239.1.1.1 vrf common:Mcast_Source_VRF

IP Multicast Routing Table for VRF "common:Mcast_Source_VRF"

Group not found

LF101# LF102# show ip mroute 239.1.1.1 vrf common:Mcast_Source_VRF

IP Multicast Routing Table for VRF "common:Mcast_Source_VRF"

(*, 239.1.1.1/32), uptime: 3d05h, ngmvpn ip pim mrib

Incoming interface: Vlan42, RPF nbr: 10.0.2.4

Outgoing interface list: (count: 1) (Fabric OIF)

Tunnel19, uptime: 3d05h, ngmvpn

Extranet receiver list: (vrf count: 1, OIF count: 1)

Extranet receiver in vrf Mcast_Receivers_Tenant:Mcast_Receivers_VRF:

(*, 239.1.1.1/32) OIF count: 1

(10.0.2.4/32, 239.1.1.1/32), uptime: 01:32:02, ip mrib pim ngmvpn

Incoming interface: Vlan42, RPF nbr: 10.0.2.4

Outgoing interface list: (count: 1) (Fabric OIF)

Tunnel19, uptime: 01:32:02, mrib, ngmvpn

Extranet receiver list: (vrf count: 1, OIF count: 1)

Extranet receiver in vrf Mcast_Receivers_Tenant:Mcast_Receivers_VRF:

(10.0.2.4/32, 239.1.1.1/32) OIF count: 1

LF102# LF102# show ip mroute 239.1.1.1 vrf Mcast_Receivers_Tenant:Mcast_Receivers_VRF

IP Multicast Routing Table for VRF "Mcast_Receivers_Tenant:Mcast_Receivers_VRF"

(*, 239.1.1.1/32), uptime: 3d05h, igmp ip pim

Incoming interface: Vlan42, RPF nbr: 10.0.2.4

Outgoing interface list: (count: 1)

Vlan39, uptime: 3d05h, igmp

(10.0.2.4/32, 239.1.1.1/32), uptime: 01:33:19, pim mrib ip

Incoming interface: Vlan42, RPF nbr: 10.0.2.4

Outgoing interface list: (count: 1)

Vlan39, uptime: 01:33:19, mrib

LF102# LF103# show ip mroute 239.1.1.1 vrf common:Mcast_Source_VRF

IP Multicast Routing Table for VRF "common:Mcast_Source_VRF"

(*, 239.1.1.1/32), uptime: 05:38:05, igmp ip pim

Incoming interface: Tunnel19, RPF nbr: 10.2.184.64

Outgoing interface list: (count: 1)

Vlan82, uptime: 05:38:05, igmp

LF103# LF104# show ip mroute 239.1.1.1 vrf Mcast_Receivers_Tenant:Mcast_Receivers_VRF

IP Multicast Routing Table for VRF "Mcast_Receivers_Tenant:Mcast_Receivers_VRF"

(*, 239.1.1.1/32), uptime: 3d05h, igmp ip pim

Incoming interface: Tunnel19, RPF nbr: 10.2.184.67

Outgoing interface list: (count: 1)

Vlan73, uptime: 3d05h, igmp

LF104#

Inoltro multicast nell'infrastruttura

All'interno dell'infrastruttura ACI per gestire il traffico BUM (Broadcast, Unknown Unicast e Multicast), viene creato un tunnel VXLAN con l'IP di destinazione che è un IP Multicast, detto indirizzo IP. A ogni dominio bridge (per il traffico L2) o VRF (per il traffico L3) viene assegnato automaticamente un indirizzo GIPo.

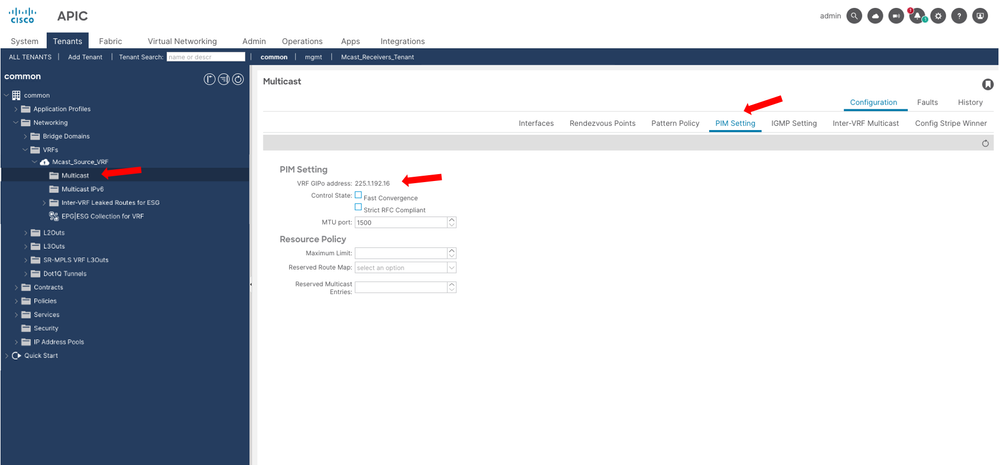

Questo indirizzo GIPo può essere consultato sull'interfaccia GUI dell'APIC. Passare a Tenant > comune > Rete > VRF > Mcast_Source_VRF > Multicast e nel riquadro principale della scheda Impostazioni PIM, è possibile vedere che l'indirizzo GIP VRF utilizzato in questo esempio è 225.1.192.16.

Sugli switch Spine è possibile vedere a quali switch Leaf è distribuito il VRF, perché l'indirizzo GIPo elenca le interfacce di ciascun Leaf. Per questo motivo, se il VRF di origine non è implementato su un Leaf specifico, il TRM non riesce a estendere il flusso multicast al VRF del ricevitore. In questo output, si noti che LF104 non fa parte dell'OIL per il GIPo.

Nota: È possibile che il VRF GIPo possa essere installato su una foglia in cui il VRF non è distribuito, in modo da poter essere installato dall'albero FTAG completo. Quella Foglia si chiama Foglia di Transito. L'argomento della struttura FTAG non viene trattato in questo articolo per focalizzare l'attenzione sulla configurazione TRM.

SP1001# show ip mroute 225.1.192.16 vrf overlay-1

IP Multicast Routing Table for VRF "overlay-1"

(*, 225.1.192.16/32), uptime: 5d05h, isis

Incoming interface: Null, RPF nbr: 0.0.0.0

Outgoing interface list: (count: 4)

Ethernet1/1.1, uptime: 00:01:19

Ethernet1/11.39, uptime: 06:01:14

Ethernet1/2.13, uptime: 5d05h

SP1001# show lldp neighbors

Capability codes:

(R) Router, (B) Bridge, (T) Telephone, (C) DOCSIS Cable Device

(W) WLAN Access Point, (P) Repeater, (S) Station, (O) Other

Device ID Local Intf Hold-time Capability Port ID

LF101 Eth1/1 120 BR Eth1/52

LF102 Eth1/2 120 BR Eth1/52

LF103 Eth1/11 120 BR Eth1/52

LF501 Eth1/13 120 BR Eth1/54

LF401 Eth1/15 120 BR Eth1/53

LF402 Eth1/16 120 BR Eth1/53

LF104 Eth1/31 120 BR Eth1/52

Informazioni correlate

Cronologia delle revisioni

| Revisione | Data di pubblicazione | Commenti |

|---|---|---|

1.0 |

29-Jan-2025

|

Versione iniziale |

Contributo dei tecnici Cisco

- Victor Manuel Menchaca AlanisTecnico di consulenza

Feedback

Feedback