Aplicación de un parche de imagen ESXI no personalizado en un clúster Hyperflex

Opciones de descarga

-

ePub (720.2 KB)

Visualice en diferentes aplicaciones en iPhone, iPad, Android, Sony Reader o Windows Phone -

Mobi (Kindle) (641.6 KB)

Visualice en dispositivo Kindle o aplicación Kindle en múltiples dispositivos

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Introducción

Este documento describe el proceso para aplicar parches a un nodo de ESXI Hyperflex con una imagen HX no personalizada a través de la interfaz de línea de comandos (CLI) o de HX Connect.

Prerequisites

Requirements

Cisco recomienda que tenga conocimiento sobre estos temas:

- Hiperflex

- ESXI

Componentes Utilizados

La información que contiene este documento se basa en las siguientes versiones de software y hardware.

- HyperFlex Connect 5.0.2d

- Clúster estándar Hyperflex

- vCenter 8.0

- VMware ESXI, versión 7.0.3 (23794027)

- VMware ESXI, 7.0.3 build-24585291 (parche de destino)

La información que contiene este documento se creó a partir de los dispositivos en un ambiente de laboratorio específico. Todos los dispositivos que se utilizan en este documento se pusieron en funcionamiento con una configuración verificada (predeterminada). Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Antecedentes

Cisco no siempre proporciona un paquete HyperFlex independiente para cada nueva versión de parche de VMware ESXI. Con las actualizaciones críticas de ESXI es posible aplicarlas manualmente con cualquiera de los métodos presentados en este artículo. Sin embargo, HyperFlex no recomienda actualizar ESXI con VMware Update Manager (VUM) o VMware Lifecycle Manager (vLCM), ya que puede causar problemas con determinados paquetes de instalación de HyperFlex vSphere (VIB).

Los parches no personalizados solo se pueden aplicar para las mismas versiones de ESXI. Si utiliza ESXI 7.0 u3, solo puede aplicar parches de 7.0u3+ y no puede actualizar de 7.0u3 a 8.0u2 u 8.0u3, ni actualizar de 8.0u2x a 8.0u3x con imágenes no personalizadas.

Antes de aplicar cualquier parche, asegúrese de que la versión actual de la plataforma de datos HyperFlex (HXDP) es compatible con la versión de ESXi que tiene pensado instalar. El gráfico de compatibilidad es el siguiente:

| Versión | Servidores VMware ESXi versión HX |

| 6.0(1x) | 7 U3, 8 U2 |

| 5.5(2a) | 7 U3, 8 U2, 8 U3 |

| 5.5(1 bis) | 7 U3 |

| 5.0(2) | 7 U3 |

Si su versión de HXDP es anterior, actualice primero HXDP y, a continuación, ESXI.

Configurar

Descargar el archivo zip de ESXI desde el sitio web de Broadcom

Asegúrese de que el clúster está en línea y en buen estado antes de comenzar con la actividad.

Verifique las versiones iniciales de los VIP de Hyperflex, nenic y nfnic en los nodos ESXi del clúster.

esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc|nenic|nfnic'

Actualizar mediante CLI

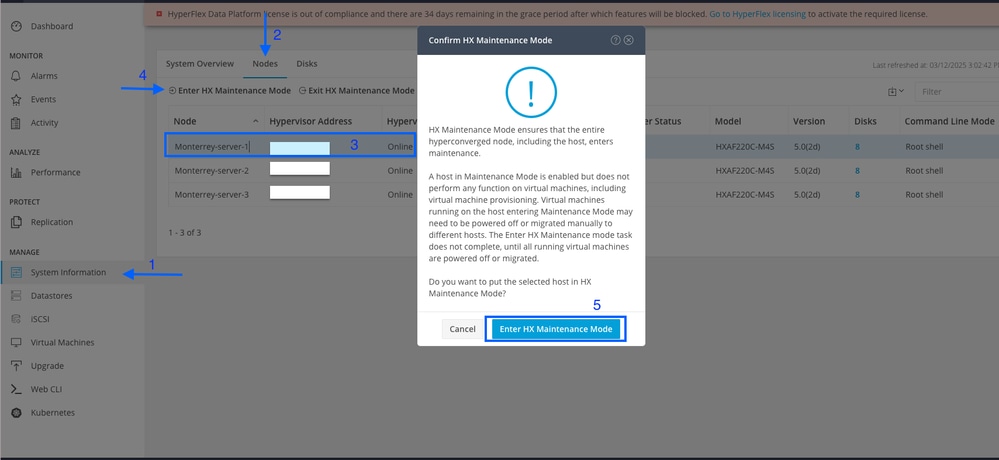

Paso 1. En HX Connect, vaya a System Information > Nodes, seleccione uno de los hosts y haga clic en Enter HX Maintenance Mode.

Una vez que el host entra en modo de mantenimiento, continúe con los siguientes pasos.

Paso 2. Transfiera el archivo zip al host.

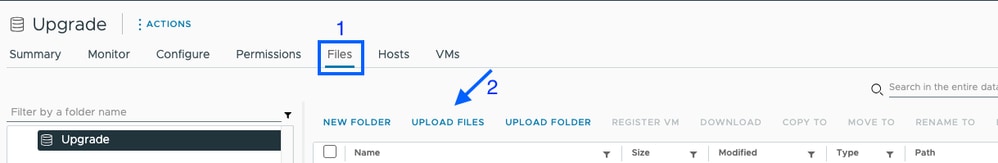

Puede cargarlo mediante vCenter en un almacén de datos montado.

Navegue hasta el almacén de datos deseado y seleccione Files, luego seleccione UPLOAD FILES y cargue el archivo zip. En la siguiente imagen, se utiliza un almacén de datos llamado Upgrade.

También puede copiar de forma remota y segura el paquete de actualización de ESXI en una carpeta apropiada con espacio suficiente con SCP.

scp local_filename user@ESXIserver:/path/where/file/should/goPaso 3. SSH al host de ESXI en modo de mantenimiento y navegue hasta la carpeta del almacén de datos donde se copia el paquete de actualización de ESXI. En este escenario, el archivo está disponible en el almacén de datos Upgrade.

[root@Monterrey-server-1:~]cd /vmfs/volumes/UpgradePuede verificar la versión actual con el comando vmware -v

[root@Monterrey-server-1:~] vmware -v

VMware ESXi 7.0.3 build-23794027

Ejecute este comando para ver los detalles del perfil del paquete: esxcli software sources profile list -d /complete/path/VMware-ESXi...cremallera

[root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software sources profile list -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip

Name Vendor Acceptance Level Creation Time Modification Time

----------------------------- ------------ ---------------- ------------------- -----------------

ESXi-7.0U3s-24585291-standard VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-03-04T00:00:00

ESXi-7.0U3s-24585291-no-tools VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-02-21T03:24:14

Paso 4. Ejecute este comando para instalar el parche: esxcli software profile update -d /complete/path/VMware-ESXi...zip -p PackageProfileName y espere hasta que se muestre el resultado correcto.

root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software profile update -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip -p ESXi-7.0U3s-24585291-standard

Update Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: VMware_bootbank_bmcal_7.0.3-0.135.24585291, VMware_bootbank_cpu-microcode_7.0.3-0.135.24585291, VMware_bootbank_crx_7.0.3-0.135.24585291, VMware_bootbank_esx-base_7.0.3-0.135.24585291, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.135.24585291, VMware_bootbank_esx-update_7.0.3-0.135.24585291, VMware_bootbank_esx-xserver_7.0.3-0.135.24585291, VMware_bootbank_esxio-combiner_7.0.3-0.135.24585291, VMware_bootbank_gc_7.0.3-0.135.24585291, VMware_bootbank_loadesx_7.0.3-0.135.24585291, VMware_bootbank_native-misc-drivers_7.0.3-0.135.24585291, VMware_bootbank_trx_7.0.3-0.135.24585291, VMware_bootbank_vdfs_7.0.3-0.135.24585291, VMware_bootbank_vsan_7.0.3-0.135.24585291, VMware_bootbank_vsanhealth_7.0.3-0.135.24585291

VIBs Removed: VMware_bootbank_bmcal_7.0.3-0.125.23794027, VMware_bootbank_cpu-microcode_7.0.3-0.125.23794027, VMware_bootbank_crx_7.0.3-0.125.23794027, VMware_bootbank_esx-base_7.0.3-0.125.23794027, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.125.23794027, VMware_bootbank_esx-update_7.0.3-0.125.23794027, VMware_bootbank_esx-xserver_7.0.3-0.125.23794027, VMware_bootbank_esxio-combiner_7.0.3-0.125.23794027, VMware_bootbank_gc_7.0.3-0.125.23794027, VMware_bootbank_loadesx_7.0.3-0.125.23794027, VMware_bootbank_native-misc-drivers_7.0.3-0.125.23794027, VMware_bootbank_trx_7.0.3-0.125.23794027, VMware_bootbank_vdfs_7.0.3-0.125.23794027, VMware_bootbank_vsan_7.0.3-0.125.23794027, VMware_bootbank_vsanhealth_7.0.3-0.125.23794027

VIBs Skipped: VMW_bootbank_atlantic_1.0.3.0-8vmw.703.0.20.19193900, VMW_bootbank_bnxtnet_216.0.50.0-44vmw.703.0.50.20036589, VMW_bootbank_bnxtroce_216.0.58.0-23vmw.703.0.50.20036589, VMW_bootbank_brcmfcoe_12.0.1500.2-3vmw.703.0.20.19193900, VMW_bootbank_elxiscsi_12.0.1200.0-9vmw.703.0.20.19193900, VMW_bootbank_elxnet_12.0.1250.0-5vmw.703.0.20.19193900, VMW_bootbank_i40en_1.11.1.32-1vmw.703.0.125.23794027, VMW_bootbank_iavmd_2.7.0.1157-3vmw.703.0.105.22348816, VMW_bootbank_icen_1.4.1.20-1vmw.703.0.50.20036589, VMW_bootbank_igbn_1.4.11.2-1vmw.703.0.20.19193900, VMW_bootbank_ionic-en_16.0.0-16vmw.703.0.20.19193900, VMW_bootbank_irdman_1.3.1.22-1vmw.703.0.50.20036589, VMW_bootbank_iser_1.1.0.1-1vmw.703.0.50.20036589, VMW_bootbank_ixgben_1.7.1.35-1vmw.703.0.20.19193900, VMW_bootbank_lpfc_14.0.169.26-5vmw.703.0.50.20036589, VMW_bootbank_lpnic_11.4.62.0-1vmw.703.0.20.19193900, VMW_bootbank_lsi-mr3_7.718.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt2_20.00.06.00-4vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt35_19.00.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt3_17.00.12.00-2vmw.703.0.105.22348816, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.703.0.20.19193900, VMW_bootbank_ne1000_0.9.0-1vmw.703.0.50.20036589, VMW_bootbank_nenic_1.0.33.0-1vmw.703.0.20.19193900, VMW_bootbank_nfnic_4.0.0.70-1vmw.703.0.20.19193900, VMW_bootbank_nhpsa_70.0051.0.100-4vmw.703.0.20.19193900, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx5-core_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_nmlx5-rdma_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_ntg3_4.1.9.0-5vmw.703.0.90.21686933, VMW_bootbank_nvme-pcie_1.2.3.16-3vmw.703.0.105.22348816, VMW_bootbank_nvmerdma_1.0.3.5-1vmw.703.0.20.19193900, VMW_bootbank_nvmetcp_1.0.0.3-1vmw.703.0.125.23794027, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.703.0.20.19193900, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.703.0.20.19193900, VMW_bootbank_pvscsi_0.1-4vmw.703.0.20.19193900, VMW_bootbank_qcnic_1.0.15.0-14vmw.703.0.20.19193900, VMW_bootbank_qedentv_3.40.5.53-22vmw.703.0.20.19193900, VMW_bootbank_qedrntv_3.40.5.53-18vmw.703.0.20.19193900, VMW_bootbank_qfle3_1.0.67.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3f_1.0.51.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3i_1.0.15.0-15vmw.703.0.20.19193900, VMW_bootbank_qflge_1.1.0.11-1vmw.703.0.20.19193900, VMW_bootbank_rste_2.0.2.0088-7vmw.703.0.20.19193900, VMW_bootbank_sfvmk_2.4.0.2010-6vmw.703.0.20.19193900, VMW_bootbank_smartpqi_70.4149.0.5000-1vmw.703.0.20.19193900, VMW_bootbank_vmkata_0.1-1vmw.703.0.20.19193900, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.703.0.20.19193900, VMW_bootbank_vmkusb_0.1-8vmw.703.0.85.21424296, VMW_bootbank_vmw-ahci_2.0.11-3vmw.703.0.125.23794027, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.703.0.20.19193900, VMware_bootbank_esx-ui_2.13.2-22721163, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.703.0.20.19193900, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.7.2173-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-12vmw.703.0.50.20036589, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-9vmw.703.0.105.22348816, VMware_bootbank_qlnativefc_4.1.14.0-26vmw.703.0.20.19193900, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.44-1vmw.703.0.20.19193900, VMware_locker_tools-light_12.3.5.22544099-23794019

Paso 5. Una vez completada la actualización, reinicie el host de ESXi.

Paso 6. SSH en el host y verifique la versión con el comando: vmware -v

[root@Monterrey-server-1:~] vmware -v

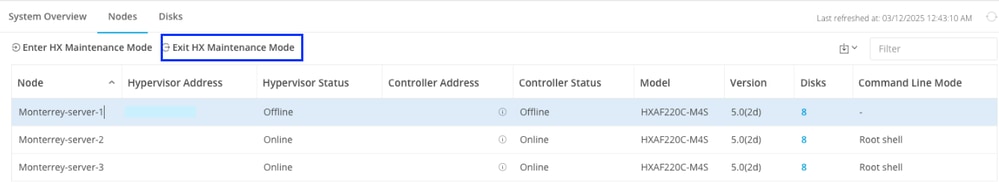

VMware ESXi 7.0.3 build-24585291Paso 7. Salga del nodo del modo de mantenimiento y espere a que el clúster funcione correctamente.

Abra HX-Connect, elija System Information> Nodes, elija el nodo en el modo de mantenimiento y haga clic en Exit HX Maintenance Mode .

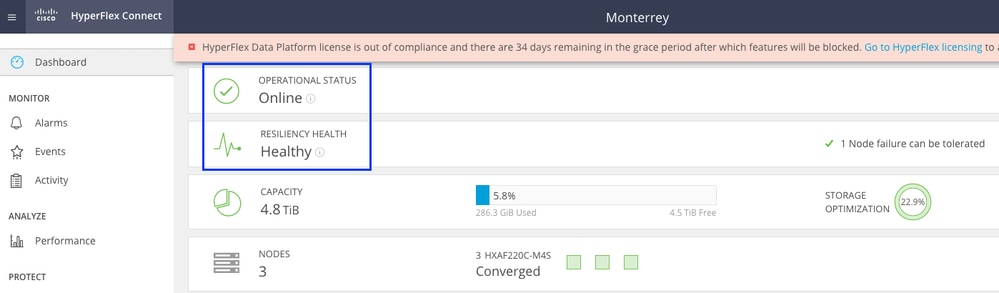

Espere unos minutos para que el clúster Hyperflex complete la recuperación. El panel de HX Connect muestra el estado operativo, debe ser Online y el estado de la resistencia debe mostrar Healthy.

También desde VCenter, asegúrese de que el servidor puede ver todos los almacenes de datos.

Repita los pasos en todos los nodos que forman parte del clúster, uno a uno.

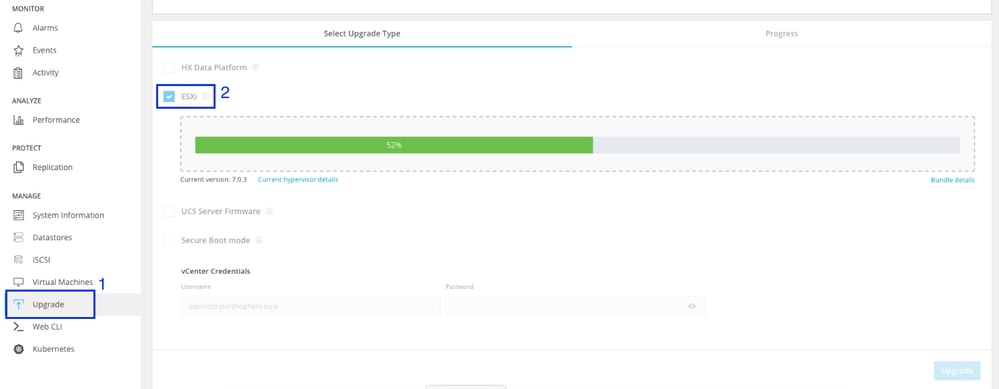

Actualización mediante interfaz de usuario de HX Connect

Vaya a la ficha Actualizar, seleccione el tipo de actualización de ESXI y cargue el archivo de actualización de ESXI.

Nota: Si su clúster está en la versión 5.5 o 6.0 de HX, debe realizar una actualización combinada seleccionando HX Data Platform y cargando el paquete HX de su versión actual

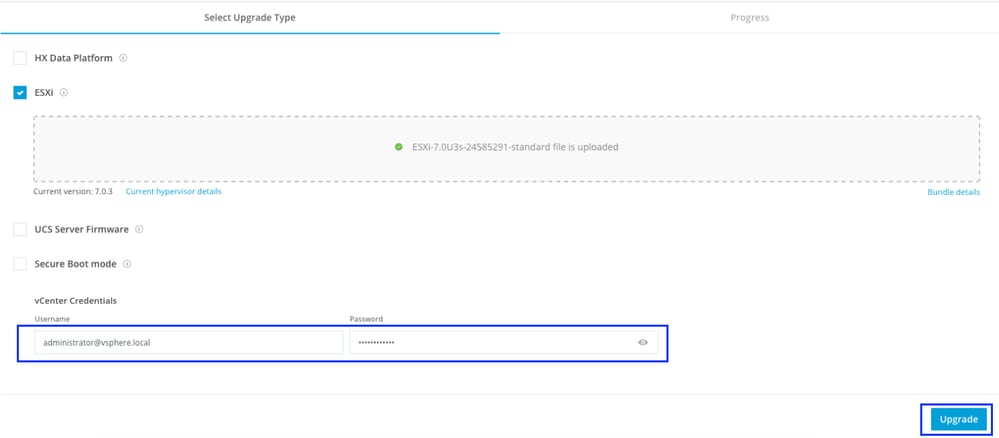

Una vez cargado el archivo, introduzca las credenciales de vCenter y haga clic en Actualizar.

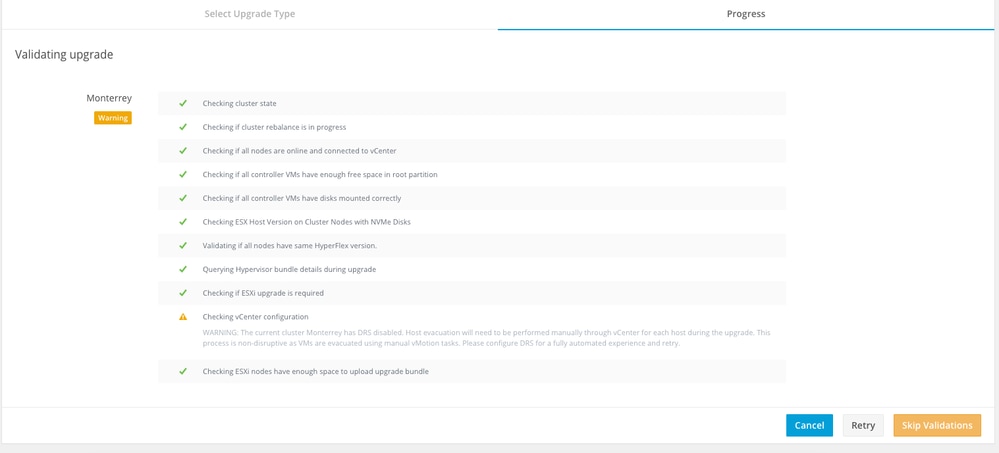

La primera etapa consiste en validar la actualización. Si Distributed Resource Scheduler (DRS) está habilitado, las VM se trasladan automáticamente a otros hosts.

Haga clic en Omitir validaciones y la actualización se iniciará automáticamente.

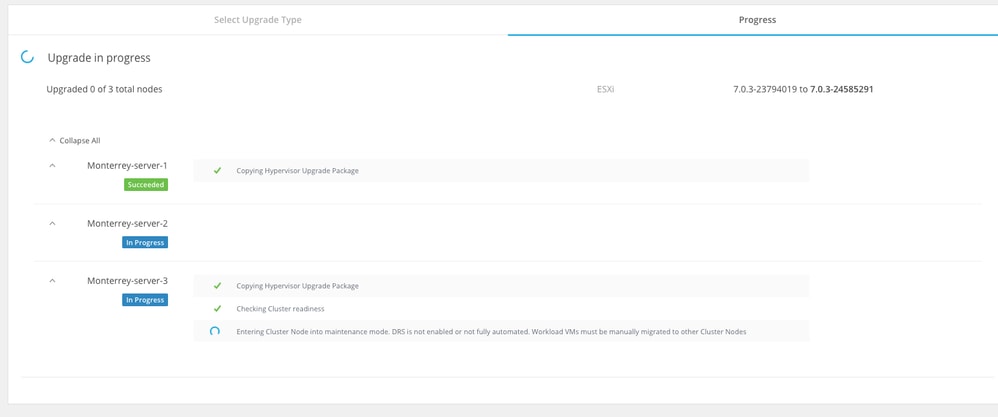

Supervise el proceso de actualización.

Nota: Si DRS está desactivado, vMotion envía las VM manualmente para continuar el proceso de actualización.

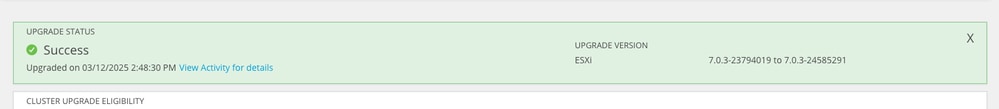

Espere hasta que se complete la actualización en todos los nodos del clúster.

Verificación

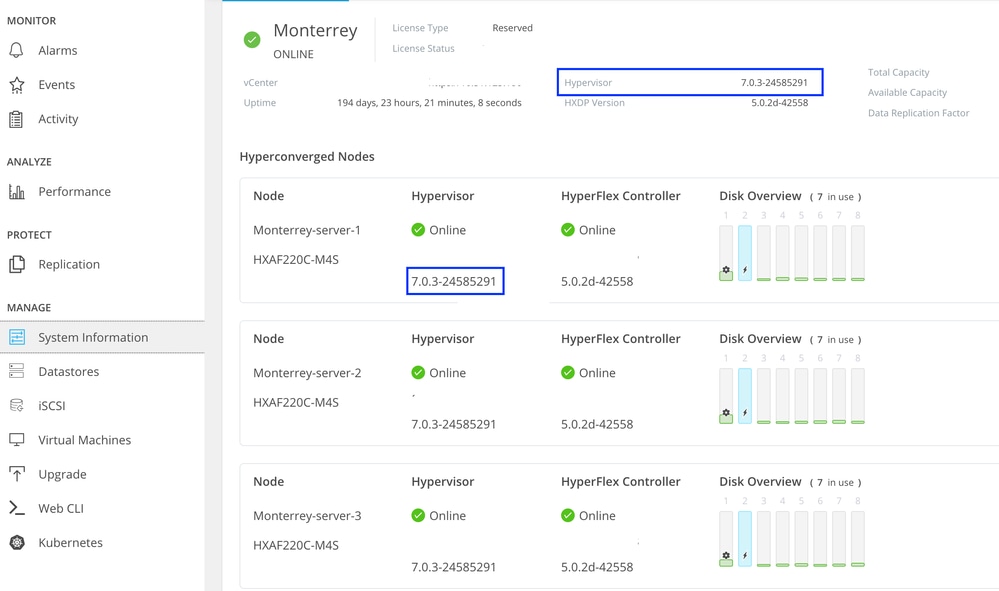

Puede verificar la versión instalada de ESXI desde HX Connect en la pestaña Información del sistema.

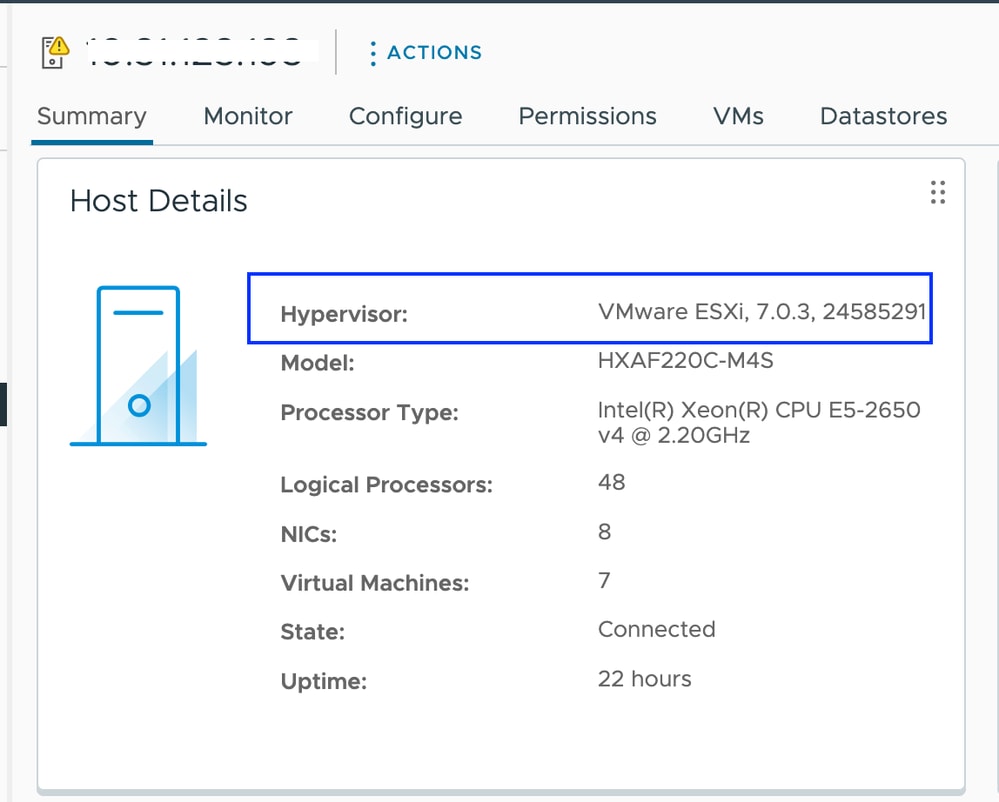

Desde vCenter puede ver la versión de ESXI en el Resumen del servidor.

Dado que la imagen de ESXI no es personalizada, debe confirmar que los VIP de Hyperflex aún se muestran intactos en los servidores.

SSH en cada host de ESXI después de que se haya completado el parche y antes de comenzar con el siguiente nodo y verifique los VIP de Hyperflex con el comando: esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

Nota: En las versiones ESXi 7.0 U3, vmware-esx-STFSNasPlugin cambió a CIS-ESX-STFSNasPlugin

En las versiones ESXi 8.0 U1, stHypervisorSvc cambió a sthypervisorsvc.

[root@Monterrey-server-1:~] esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

CIS-ESX-STFSNasPlugin 4.5.1-11 CIS VMwareAccepted 2023-10-25

scvmclient 5.5.1-38 CIS VMwareAccepted 2023-11-25

stHypervisorSvc 4.5.1-11 CIS VMwareAccepted 2023-10-24

Precaución: En ciertos escenarios, la imagen no personalizada puede sobrescribir los VIB nenic y nfnic con una versión diferente a las de la imagen personalizada. Debe validar que tenemos las versiones correctas después del parche.

SSH en cada host de ESXI después de que se haya completado el parche y antes de comenzar con el siguiente nodo y verifique los VIP de Hyperflex con el comando: esxcli software vib list | egrep -i 'nenic|nfnic'

[root@Monterrey-server-3:~] esxcli software vib list | egrep -i 'nenic|nfnic'

nfnic 5.0.0.43-1OEM.700.1.0.15843807 CIS VMwareCertified 2025-02-23

nenic-ens 1.0.6.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2023-10-25

nenic 2.0.10.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2024-03-17

Troubleshoot

Si nenic o nfnic se sobrescribieron con una versión diferente, puede instalar las correctas descargando una imagen zip personalizada de ESXI de su misma versión de software.cisco.com. Descomprima la imagen a y desde el directorio vib busque los directorios nenic y nfnic. Extraiga el archivo vib y cárguelo a través de vCenter en un almacén de datos montado en los servidores. Asegúrese de que el clúster está en línea y en buen estado.

Paso 1. En HX Connect, vaya a System Information > Nodes, seleccione uno de los hosts y haga clic en Enter HX Maintenance Mode.

Una vez que el host entra en modo de mantenimiento, continúe con los siguientes pasos.

SSH al host ESXI en modo de mantenimiento y navegue hasta la carpeta del almacén de datos donde se copia el archivo vib de ESXI. En esta situación, el archivo está disponible en el almacén de datos de actualización

[root@Monterrey-server-3:~] cd /vmfs/volumes/Upgrade

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] ls

CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib

Ejecute este comando para actualizar el vib: esxcli software vib update -v "/complete/path/vib-file.vib" -f

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] esxcli software vib update -v "/vmfs/volumes/Upgrade/CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib" -f

Installation Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807

VIBs Removed: Cisco_bootbank_nenic_1.0.45.0-1OEM.700.1.0.15843807

VIBs Skipped:

Una vez completada la actualización de vib, reinicie el host de ESXi.

SSH en el host y verifique que vib se haya actualizado correctamente con el comando: esxcli software vib list | egrep -i 'nenic|nfnic'

Salga del nodo del modo de mantenimiento y espere a que el clúster funcione correctamente.

Abra HX-Connect, elija System Information> Nodes, elija el nodo en el modo de mantenimiento y haga clic en Exit HX Maintenance Mode .

Si el servidor arranca desde la tarjeta SD, puede encontrarse con un problema conocido mientras aplica el parche. "No se puede remediar el host debido a un error mientras se esperaba el proceso untar". Este problema se produce cuando la operación untar de VIB individuales tarda más del tiempo de espera predeterminado de 30 segundos durante el proceso de remediación. Para los entornos que utilizan la tarjeta SD como la partición OSData, hay posibilidades de que el proceso de desactivación de las herramientas VMware tome una duración ligeramente mayor. Puede consultar este artículo para resolverlo.

Historial de revisiones

| Revisión | Fecha de publicación | Comentarios |

|---|---|---|

1.0 |

14-Mar-2025

|

Versión inicial |

Con la colaboración de ingenieros de Cisco

- Alejandra Ortiz RegaladoTechnical Consulting Engineer

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios