Anwenden eines nicht benutzerdefinierten ESXI-Image-Patches auf einen Hyperflex-Cluster

Download-Optionen

-

ePub (722.3 KB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Einleitung

In diesem Dokument wird das Patchen eines Hyperflex ESXI-Knotens mit einem nicht benutzerdefinierten HX-Image über die Befehlszeilenschnittstelle (CLI) oder HX Connect beschrieben.

Voraussetzungen

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in folgenden Bereichen verfügen:

- Hyperflex

- ESX

Verwendete Komponenten

Die Informationen in diesem Dokument basierend auf folgenden Software- und Hardware-Versionen:

- HyperFlex Connect 5.0.2d

- HyperFlex Standard-Cluster

- vCenter 8.0

- VMware ESXI, 7.0.3 Build-23794027

- VMware ESXI, 7.0.3 Build-24585291 (Ziel-Patch)

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die möglichen Auswirkungen aller Befehle kennen.

Hintergrundinformationen

Cisco bietet nicht immer ein separates HyperFlex-Paket für jede neue VMware ESXI-Patch-Version an. Bei kritischen ESXI-Aktualisierungen können diese manuell mit einer der in diesem Artikel vorgestellten Methoden angewendet werden. HyperFlex empfiehlt jedoch kein Upgrade von ESXI mit VMware Update Manager (VUM) oder VMware Lifecycle Manager (vLCM), da dies Probleme mit bestimmten HyperFlex vSphere-Installationspaketen (VIBs) verursachen kann.

Nicht benutzerdefinierte Patches können nur für die gleichen ESXI-Versionen angewendet werden. Wenn Sie ESXI 7.0 u3 verwenden, können Sie nur Patches von 7.0u3+ anwenden, und Sie können weder von 7.0u3 auf 8.0u2 oder 8.0u3 aktualisieren noch von 8.0u2x auf 8.0u3x mit nicht benutzerdefinierten Images aktualisieren.

Stellen Sie vor der Installation eines Patches sicher, dass Ihre aktuelle HyperFlex Data Platform (HXDP)-Version mit der ESXi-Version kompatibel ist, die Sie installieren möchten. Das Kompatibilitätsdiagramm ist wie folgt:

| Version | VMware ESXi Version HX-Server |

| 6,0 (1 x) | 7,0 U3, 8,0 U2 |

| 5,5 (2a) | 7,0 U3, 8,0 U2, 8,0 U3 |

| 5.5 (1a) | 7,0 HE3 |

| 5,0 (2 x) | 7,0 HE3 |

Wenn Ihre HXDP-Version älter ist, aktualisieren Sie zuerst die HXDP und dann die ESXI.

Konfigurieren

ESXI-ZIP-Datei von der Broadcom-Website herunterladen

Stellen Sie sicher, dass der Cluster online und fehlerfrei ist, bevor Sie mit der Aktivität beginnen.

Überprüfen Sie die Erstversionen für Hyperflex-, nenic- und nfnic-Vibs auf ESXi-Knoten des Clusters.

esxcli software vib liste | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc|nenic|nfnic'

Upgrade über CLI

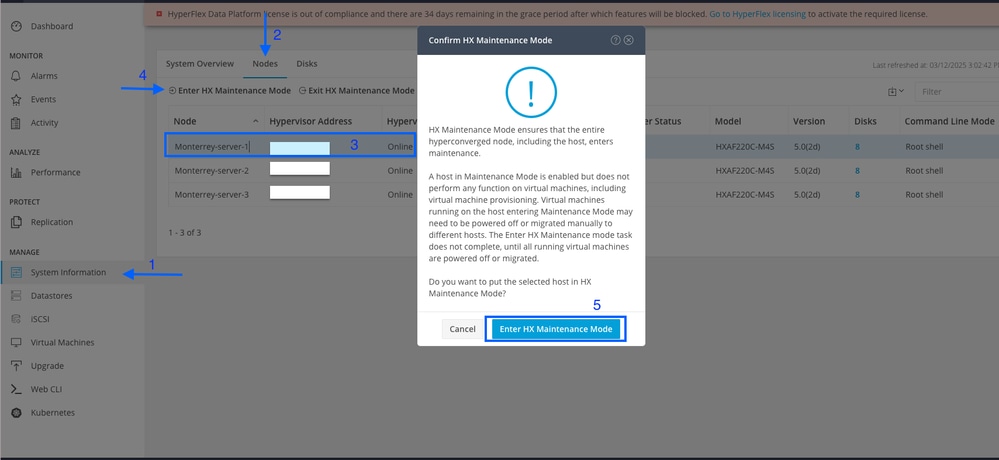

Schritt 1: Navigieren Sie in HX Connect zu Systeminformationen > Knoten, wählen Sie einen der Hosts aus, und klicken Sie auf HX-Wartungsmodus eingeben.

Fahren Sie mit den nächsten Schritten fort, nachdem der Host in den Wartungsmodus gewechselt ist.

Schritt 2: Übertragen Sie die ZIP-Datei auf den Host.

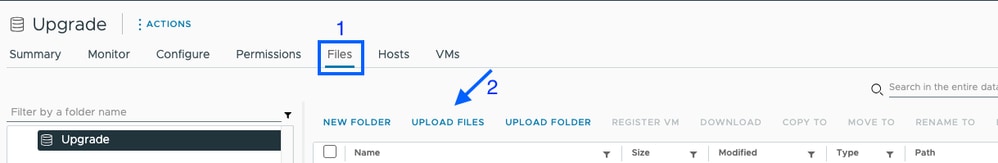

Sie können sie über vCenter in einen gemounteten Datenspeicher hochladen.

Navigieren Sie zum gewünschten Datenspeicher, und wählen Sie Dateien und dann DATEIEN HOCHLADEN aus, und laden Sie die ZIP-Datei hoch. Auf dem Bild unten wird ein Datenspeicher mit dem Namen Upgrade verwendet.

Mit SCP können Sie das ESXI-Upgrade-Paket per Remote-Zugriff sicher in einen geeigneten Ordner kopieren, der ausreichend Speicherplatz bietet.

scp local_filename user@ESXIserver:/path/where/file/should/goSchritt 3: Rufen Sie den ESXI-Host im Wartungsmodus auf, und navigieren Sie zum Datenspeicherordner, in den das ESXI-Upgrade-Paket kopiert wird. In diesem Szenario ist die Datei im Upgrade-Datenspeicher verfügbar.

[root@Monterrey-server-1:~]cd /vmfs/volumes/UpgradeSie können die aktuelle Version mit dem Befehl vmware -v überprüfen

[root@Monterrey-server-1:~] vmware -v

VMware ESXi 7.0.3 build-23794027

Führen Sie diesen Befehl aus, um die Paketprofildetails anzuzeigen: esxcli software sources profile list -d /complete/path/VMware-ESXi...Reißverschluss

[root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software sources profile list -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip

Name Vendor Acceptance Level Creation Time Modification Time

----------------------------- ------------ ---------------- ------------------- -----------------

ESXi-7.0U3s-24585291-standard VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-03-04T00:00:00

ESXi-7.0U3s-24585291-no-tools VMware, Inc. PartnerSupported 2025-03-04T00:00:00 2025-02-21T03:24:14

Schritt 4. Führen Sie diesen Befehl aus, um den Patch zu installieren: esxcli software profile update -d /complete/path/VMware-ESXi...zip -p PackageProfileName und warten, bis das Ergebnis angezeigt wird.

root@Monterrey-server-1:/vmfs/volumes/2f27e295-70f773c4] esxcli software profile update -d /vmfs/volumes/Upgrade/VMware-ESXi-7.0U3s-24585291-depot.zip -p ESXi-7.0U3s-24585291-standard

Update Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: VMware_bootbank_bmcal_7.0.3-0.135.24585291, VMware_bootbank_cpu-microcode_7.0.3-0.135.24585291, VMware_bootbank_crx_7.0.3-0.135.24585291, VMware_bootbank_esx-base_7.0.3-0.135.24585291, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.135.24585291, VMware_bootbank_esx-update_7.0.3-0.135.24585291, VMware_bootbank_esx-xserver_7.0.3-0.135.24585291, VMware_bootbank_esxio-combiner_7.0.3-0.135.24585291, VMware_bootbank_gc_7.0.3-0.135.24585291, VMware_bootbank_loadesx_7.0.3-0.135.24585291, VMware_bootbank_native-misc-drivers_7.0.3-0.135.24585291, VMware_bootbank_trx_7.0.3-0.135.24585291, VMware_bootbank_vdfs_7.0.3-0.135.24585291, VMware_bootbank_vsan_7.0.3-0.135.24585291, VMware_bootbank_vsanhealth_7.0.3-0.135.24585291

VIBs Removed: VMware_bootbank_bmcal_7.0.3-0.125.23794027, VMware_bootbank_cpu-microcode_7.0.3-0.125.23794027, VMware_bootbank_crx_7.0.3-0.125.23794027, VMware_bootbank_esx-base_7.0.3-0.125.23794027, VMware_bootbank_esx-dvfilter-generic-fastpath_7.0.3-0.125.23794027, VMware_bootbank_esx-update_7.0.3-0.125.23794027, VMware_bootbank_esx-xserver_7.0.3-0.125.23794027, VMware_bootbank_esxio-combiner_7.0.3-0.125.23794027, VMware_bootbank_gc_7.0.3-0.125.23794027, VMware_bootbank_loadesx_7.0.3-0.125.23794027, VMware_bootbank_native-misc-drivers_7.0.3-0.125.23794027, VMware_bootbank_trx_7.0.3-0.125.23794027, VMware_bootbank_vdfs_7.0.3-0.125.23794027, VMware_bootbank_vsan_7.0.3-0.125.23794027, VMware_bootbank_vsanhealth_7.0.3-0.125.23794027

VIBs Skipped: VMW_bootbank_atlantic_1.0.3.0-8vmw.703.0.20.19193900, VMW_bootbank_bnxtnet_216.0.50.0-44vmw.703.0.50.20036589, VMW_bootbank_bnxtroce_216.0.58.0-23vmw.703.0.50.20036589, VMW_bootbank_brcmfcoe_12.0.1500.2-3vmw.703.0.20.19193900, VMW_bootbank_elxiscsi_12.0.1200.0-9vmw.703.0.20.19193900, VMW_bootbank_elxnet_12.0.1250.0-5vmw.703.0.20.19193900, VMW_bootbank_i40en_1.11.1.32-1vmw.703.0.125.23794027, VMW_bootbank_iavmd_2.7.0.1157-3vmw.703.0.105.22348816, VMW_bootbank_icen_1.4.1.20-1vmw.703.0.50.20036589, VMW_bootbank_igbn_1.4.11.2-1vmw.703.0.20.19193900, VMW_bootbank_ionic-en_16.0.0-16vmw.703.0.20.19193900, VMW_bootbank_irdman_1.3.1.22-1vmw.703.0.50.20036589, VMW_bootbank_iser_1.1.0.1-1vmw.703.0.50.20036589, VMW_bootbank_ixgben_1.7.1.35-1vmw.703.0.20.19193900, VMW_bootbank_lpfc_14.0.169.26-5vmw.703.0.50.20036589, VMW_bootbank_lpnic_11.4.62.0-1vmw.703.0.20.19193900, VMW_bootbank_lsi-mr3_7.718.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt2_20.00.06.00-4vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt35_19.00.02.00-1vmw.703.0.20.19193900, VMW_bootbank_lsi-msgpt3_17.00.12.00-2vmw.703.0.105.22348816, VMW_bootbank_mtip32xx-native_3.9.8-1vmw.703.0.20.19193900, VMW_bootbank_ne1000_0.9.0-1vmw.703.0.50.20036589, VMW_bootbank_nenic_1.0.33.0-1vmw.703.0.20.19193900, VMW_bootbank_nfnic_4.0.0.70-1vmw.703.0.20.19193900, VMW_bootbank_nhpsa_70.0051.0.100-4vmw.703.0.20.19193900, VMW_bootbank_nmlx4-core_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-en_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx4-rdma_3.19.16.8-2vmw.703.0.20.19193900, VMW_bootbank_nmlx5-core_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_nmlx5-rdma_4.19.16.11-1vmw.703.0.20.19193900, VMW_bootbank_ntg3_4.1.9.0-5vmw.703.0.90.21686933, VMW_bootbank_nvme-pcie_1.2.3.16-3vmw.703.0.105.22348816, VMW_bootbank_nvmerdma_1.0.3.5-1vmw.703.0.20.19193900, VMW_bootbank_nvmetcp_1.0.0.3-1vmw.703.0.125.23794027, VMW_bootbank_nvmxnet3-ens_2.0.0.22-1vmw.703.0.20.19193900, VMW_bootbank_nvmxnet3_2.0.0.30-1vmw.703.0.20.19193900, VMW_bootbank_pvscsi_0.1-4vmw.703.0.20.19193900, VMW_bootbank_qcnic_1.0.15.0-14vmw.703.0.20.19193900, VMW_bootbank_qedentv_3.40.5.53-22vmw.703.0.20.19193900, VMW_bootbank_qedrntv_3.40.5.53-18vmw.703.0.20.19193900, VMW_bootbank_qfle3_1.0.67.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3f_1.0.51.0-22vmw.703.0.20.19193900, VMW_bootbank_qfle3i_1.0.15.0-15vmw.703.0.20.19193900, VMW_bootbank_qflge_1.1.0.11-1vmw.703.0.20.19193900, VMW_bootbank_rste_2.0.2.0088-7vmw.703.0.20.19193900, VMW_bootbank_sfvmk_2.4.0.2010-6vmw.703.0.20.19193900, VMW_bootbank_smartpqi_70.4149.0.5000-1vmw.703.0.20.19193900, VMW_bootbank_vmkata_0.1-1vmw.703.0.20.19193900, VMW_bootbank_vmkfcoe_1.0.0.2-1vmw.703.0.20.19193900, VMW_bootbank_vmkusb_0.1-8vmw.703.0.85.21424296, VMW_bootbank_vmw-ahci_2.0.11-3vmw.703.0.125.23794027, VMware_bootbank_elx-esx-libelxima.so_12.0.1200.0-4vmw.703.0.20.19193900, VMware_bootbank_esx-ui_2.13.2-22721163, VMware_bootbank_lsuv2-hpv2-hpsa-plugin_1.0.0-3vmw.703.0.20.19193900, VMware_bootbank_lsuv2-intelv2-nvme-vmd-plugin_2.7.2173-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-lsiv2-drivers-plugin_1.0.0-12vmw.703.0.50.20036589, VMware_bootbank_lsuv2-nvme-pcie-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-dell-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-hp-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-oem-lenovo-plugin_1.0.0-1vmw.703.0.20.19193900, VMware_bootbank_lsuv2-smartpqiv2-plugin_1.0.0-9vmw.703.0.105.22348816, VMware_bootbank_qlnativefc_4.1.14.0-26vmw.703.0.20.19193900, VMware_bootbank_vmware-esx-esxcli-nvme-plugin_1.2.0.44-1vmw.703.0.20.19193900, VMware_locker_tools-light_12.3.5.22544099-23794019

Schritt 5: Starten Sie nach Abschluss des Upgrades den ESXi-Host neu.

Schritt 6: SSH auf dem Host und überprüfen Sie die Version mit dem folgenden Befehl: vmware -v

[root@Monterrey-server-1:~] vmware -v

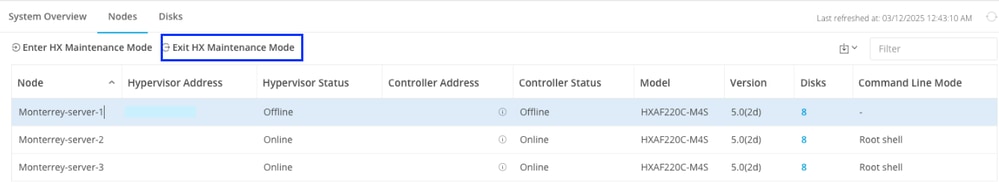

VMware ESXi 7.0.3 build-24585291Schritt 7: Beenden Sie den Knoten aus dem Wartungsmodus, und warten Sie, bis der Cluster fehlerfrei ist.

Öffnen Sie HX-Connect, wählen Sie Systeminformationen > Knoten aus, wählen Sie den Knoten im Wartungsmodus aus, und klicken Sie auf HX-Wartungsmodus beenden

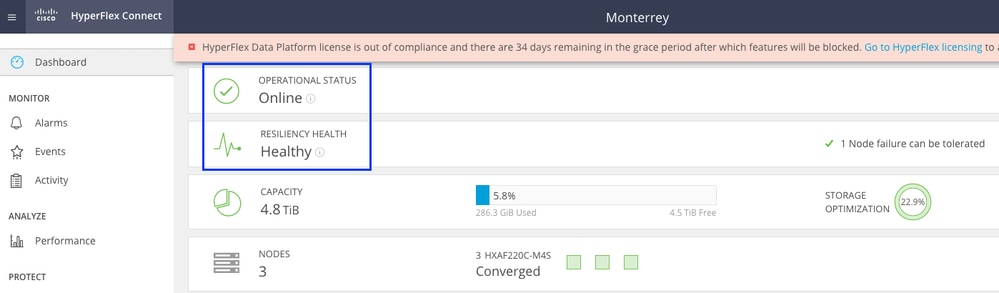

Warten Sie einige Minuten, bis der HyperFlex-Cluster vollständig geheilt ist. Das HX Connect Dashboard zeigt den Betriebsstatus an, es muss "Online" und der Ausfallsicherheitsstatus "Gesund" lauten.

Stellen Sie außerdem sicher, dass der Server von VCenter aus alle Datenspeicher sehen kann.

Wiederholen Sie die Schritte für alle Knoten, die Teil des Clusters sind, einzeln.

Upgrade über HX Connect-Benutzeroberfläche

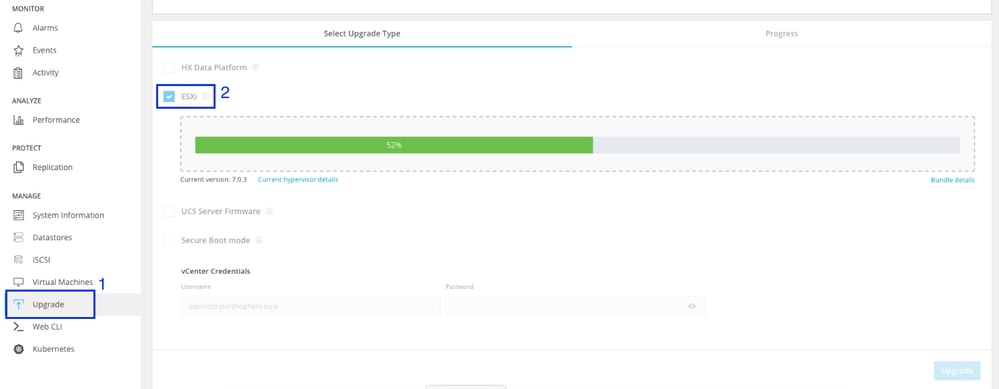

Navigieren Sie zur Registerkarte Upgrade, wählen Sie den ESXI-Upgrade-Typ aus, und laden Sie die ESXI-Upgrade-Datei hoch.

Anmerkung: Wenn sich Ihr Cluster auf der HX-Version 5.5 oder 6.0 befindet, müssen Sie ein kombiniertes Upgrade durchführen, indem Sie HX Data Platform auswählen und das HX-Paket Ihrer aktuellen Version hochladen.

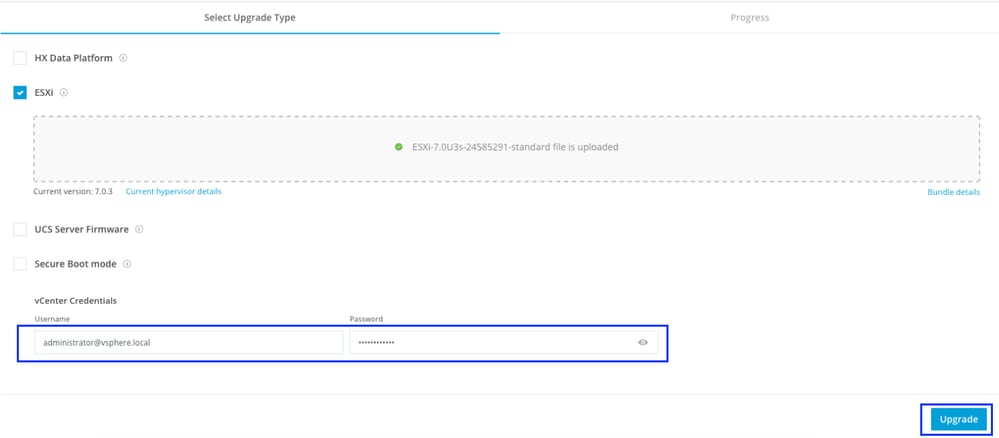

Nachdem die Datei hochgeladen wurde, geben Sie die vCenter-Anmeldeinformationen ein, und klicken Sie auf Upgrade.

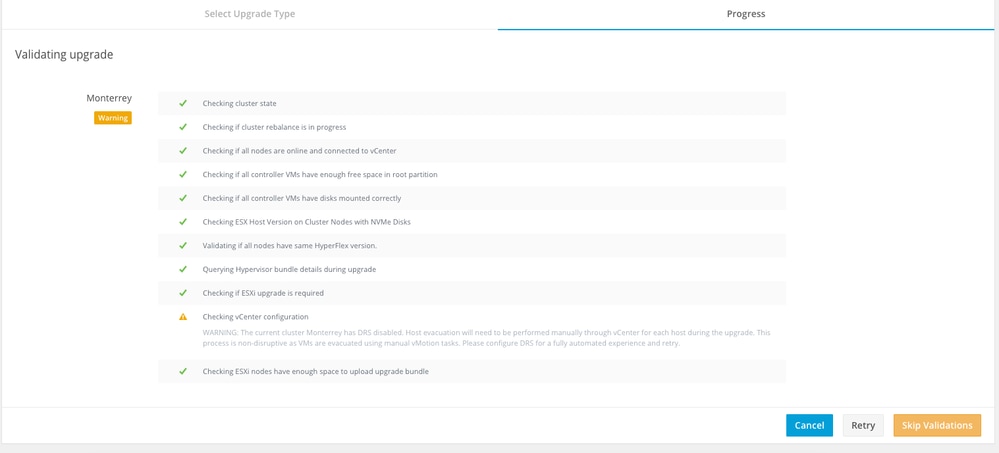

In der ersten Phase wird das Upgrade validiert. Wenn Distributed Resource Scheduler (DRS) aktiviert ist, werden die virtuellen Systeme automatisch auf andere Hosts verschoben.

Klicken Sie auf Validierungen überspringen und das Upgrade automatisch starten.

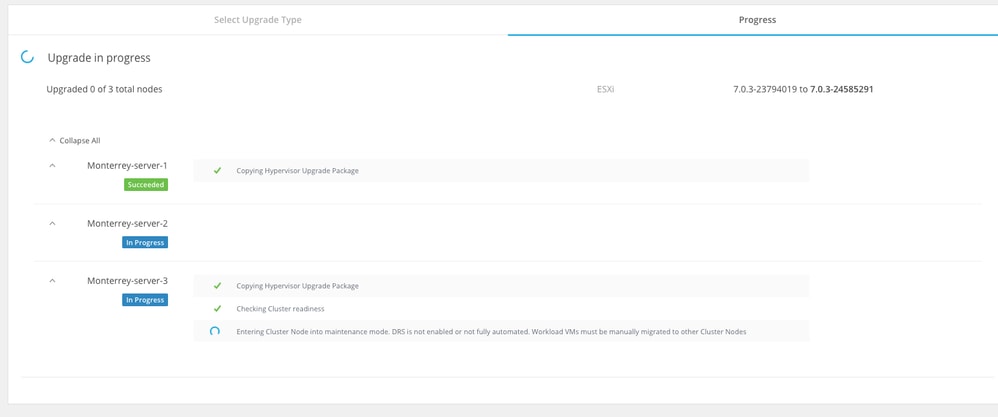

Überwachen Sie den Aktualisierungsprozess.

Anmerkung: Wenn DRS deaktiviert ist, übertragen Sie die VMs manuell in vMotion, um den Upgrade-Prozess fortzusetzen.

Warten Sie, bis die Aktualisierung auf allen Knoten des Clusters abgeschlossen ist.

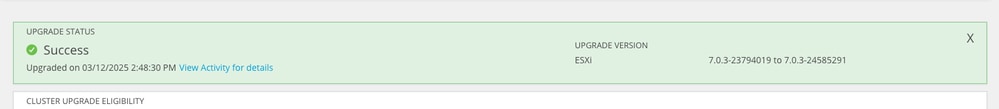

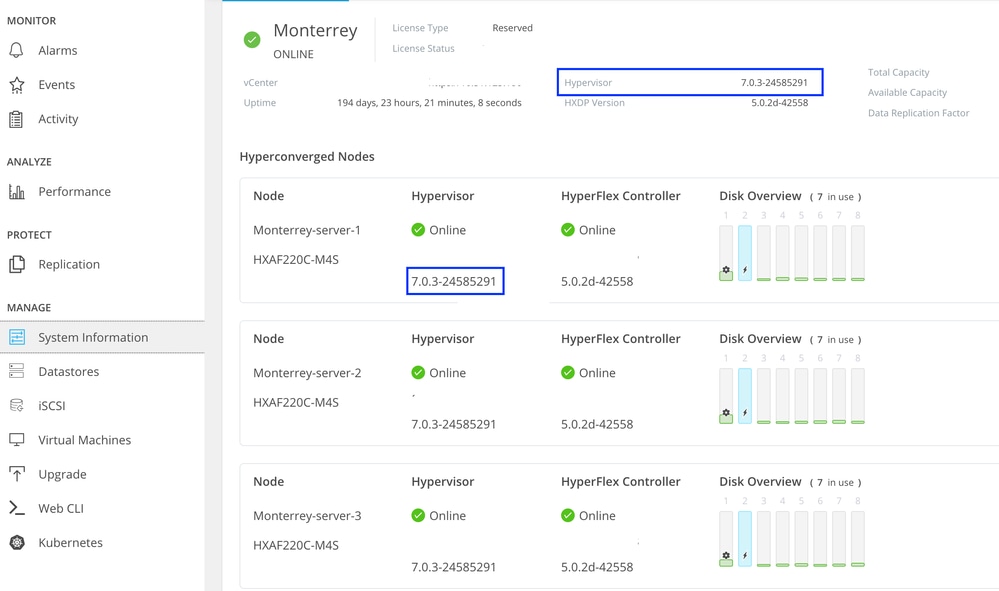

Überprüfung

Sie können die installierte ESXI-Version von HX Connect auf der Registerkarte Systeminformationen überprüfen.

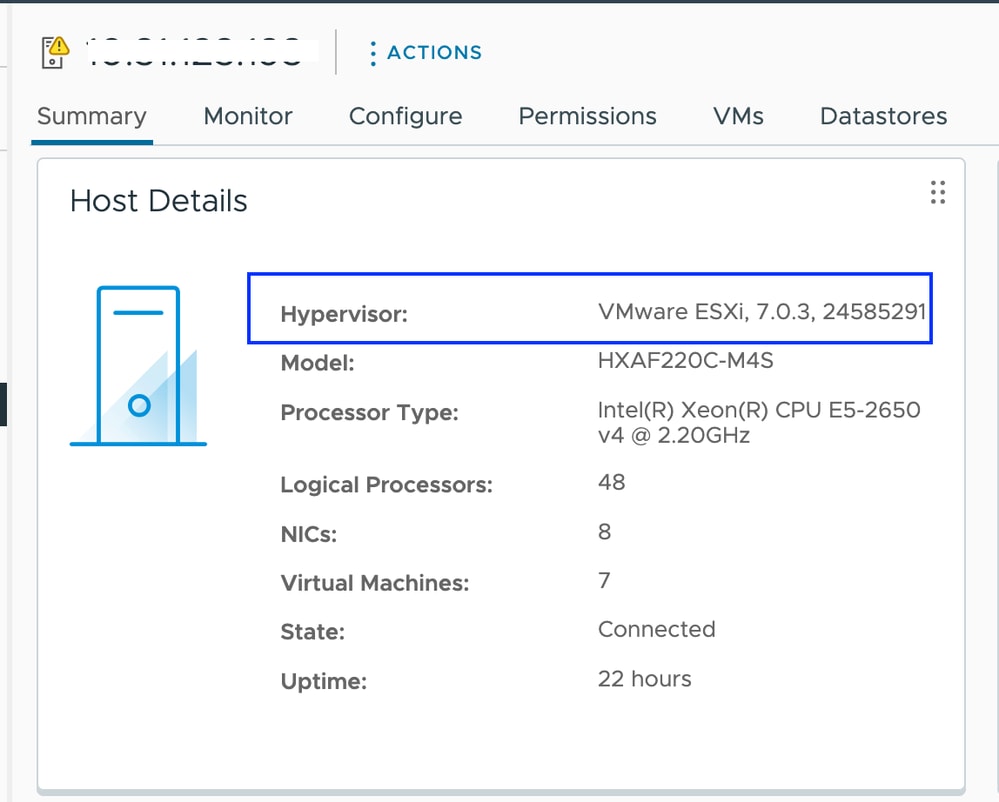

In vCenter wird die ESXI-Version in der Zusammenfassung des Servers angezeigt.

Da das ESXI-Image nicht benutzerdefiniert ist, müssen Sie sicherstellen, dass Hyperflex-VIBs auf den Servern weiterhin intakt angezeigt werden.

SSH in jeden ESXI-Host nach Abschluss des Patches und vor dem Start mit dem nächsten Knoten und Verifizieren der Hyperflex-VIBs mithilfe des folgenden Befehls: esxcli software vib liste | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

Anmerkung: In den Versionen ESXi 7.0 U3 wurde "vmware-esx-STFSNasPlugin" zu "CIS-ESX-STFSNasPlugin" geändert.

In Version ESXi 8.0 U1 wurde stHypervisorSvc zu sthypervisorsvc geändert.

[root@Monterrey-server-1:~] esxcli software vib list | egrep -i 'scvmclient|STFSNasPlugin|stHypervisorSvc'

CIS-ESX-STFSNasPlugin 4.5.1-11 CIS VMwareAccepted 2023-10-25

scvmclient 5.5.1-38 CIS VMwareAccepted 2023-11-25

stHypervisorSvc 4.5.1-11 CIS VMwareAccepted 2023-10-24

Vorsicht: In bestimmten Szenarien kann das nicht-benutzerdefinierte Image die nenic- und nfnic-VIBs mit einer anderen Version als der des benutzerdefinierten Images überschreiben. Sie müssen überprüfen, ob wir die richtigen Versionen nach dem Patch haben.

SSH in jeden ESXI-Host nach Abschluss des Patches und vor dem Start mit dem nächsten Knoten und Verifizieren der Hyperflex-VIBs mithilfe des folgenden Befehls: esxcli software vib liste | egrep -i 'nenic|nfnic'

[root@Monterrey-server-3:~] esxcli software vib list | egrep -i 'nenic|nfnic'

nfnic 5.0.0.43-1OEM.700.1.0.15843807 CIS VMwareCertified 2025-02-23

nenic-ens 1.0.6.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2023-10-25

nenic 2.0.10.0-1OEM.700.1.0.15843807 Cisco VMwareCertified 2024-03-17

Fehlerbehebung

Wenn nenic oder nfnic mit einer anderen Version überschrieben wurde, können Sie die richtigen installieren, indem Sie ein benutzerdefiniertes ESXI-Zip-Image Ihrer Version von software.cisco.com herunterladen. Entpacken Sie das Bild a und aus dem vib Verzeichnis suchen Sie nach nenic und nfnic Verzeichnissen. Extrahieren Sie die VIB-Datei, und laden Sie sie über vCenter in einen auf den Servern gemounteten Datenspeicher hoch. Stellen Sie sicher, dass der Cluster online und fehlerfrei ist.

Schritt 1: Navigieren Sie in HX Connect zu Systeminformationen > Knoten, wählen Sie einen der Hosts aus, und klicken Sie auf HX-Wartungsmodus eingeben.

Fahren Sie mit den nächsten Schritten fort, nachdem der Host in den Wartungsmodus gewechselt ist.

SSH auf den ESXI-Host im Wartungsmodus und navigieren Sie zu dem Datenspeicherordner, in den die ESXI-VIB-Datei kopiert wird. In diesem Szenario ist die Datei im Aktualisierungsdatenspeicher verfügbar.

[root@Monterrey-server-3:~] cd /vmfs/volumes/Upgrade

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] ls

CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib

Führen Sie diesen Befehl aus, um die vib: esxcli software vib update -v "/complete/path/vib-file.vib" -f

[root@Monterrey-server-3:/vmfs/volumes/2f27e295-70f773c4] esxcli software vib update -v "/vmfs/volumes/Upgrade/CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807.vib" -f

Installation Result

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: CIS_bootbank_nenic_2.0.10.0-1OEM.700.1.0.15843807

VIBs Removed: Cisco_bootbank_nenic_1.0.45.0-1OEM.700.1.0.15843807

VIBs Skipped:

Starten Sie den ESXi-Host neu, sobald das vib-Update abgeschlossen ist.

SSH in den Host und überprüfen Sie, ob vib erfolgreich mit dem Befehl aktualisiert wurde: esxcli software vib list | egrep -i 'nenic|nfnic'

Beenden Sie den Knoten aus dem Wartungsmodus, und warten Sie, bis der Cluster funktionsfähig ist.

Öffnen Sie HX-Connect, wählen Sie Systeminformationen > Knoten aus, wählen Sie den Knoten im Wartungsmodus aus, und klicken Sie auf HX-Wartungsmodus beenden

Wenn Ihr Server von der SD-Karte bootet, können Sie während der Anwendung des Patches auf ein bekanntes Problem stoßen. "Der Host kann aufgrund eines Fehlers beim Warten auf den Untar-Prozess nicht behoben werden." Dieses Problem tritt auf, wenn der Untar-Vorgang einzelner VIBs mehr als die standardmäßige 30-Sekunden-Zeitüberschreitung während des Behebungsvorgangs dauert. In Umgebungen, in denen SD-Karten als OSData-Partition verwendet werden, besteht die Möglichkeit, dass der Untar-Prozess von VMware-Tools eine etwas längere Dauer in Anspruch nimmt. Sie können diesen Artikel zu verweisen, um es zu lösen.

Revisionsverlauf

| Überarbeitung | Veröffentlichungsdatum | Kommentare |

|---|---|---|

1.0 |

14-Mar-2025

|

Erstveröffentlichung |

Beiträge von Cisco Ingenieuren

- Alejandra Ortiz RegaladoTechnical Consulting Engineer

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback