ソリューション概要

Cisco Unified Computing System:業界変革における次のフェーズを実装するアーキテクチャ

過渡期にある業界

コンピュータ業界は大きな転換期に差し掛かっています。x86 アーキテクチャは 1990 年代からほとんど変化せず、プロセッサやシステムの小型化が進み、性能が高まる一方で、サーバ スプロール(無秩序な増殖)、増え続ける電力供給と冷却、一貫したポリシーの欠如、セキュリティ、および管理と課題は増え続けています。この 10 年の間に仮想化の普及が進んで、サーバ集約が可能になり、仮想マシンがITシステムにおいてあって当たり前の存在となりました。けれども、複雑さが増す勢いは変わらず、データセンターの展開においては、多数の独立したコンポーネントを手作業で組み合わせることが依然として必要になっています。今日の仮想化および非仮想化サーバ環境における複雑さの原因としては、次のようなものが考えられます。

- ラックマウント型またはブレード型のサーバとシャーシ、それら1つひとつが独立した管理ポイントであること。それぞれが固有のID(識別子)を持ち、I/O 構成はハードウェアに結び付けられているため、ワークロードの変化にすばやく対応することができません。

- サーバ、ブレード、およびシャーシのファームウェアの更新は手作業で、時間がかかる。

- ネットワーク アクセス レイヤがいくつものレベルに多段化されている。たとえば、アクセス レイヤ スイッチ、ブレード シャーシに内蔵されたスイッチ、仮想化ソフトウェアに必要なソフトウェア スイッチなどです。スイッチごとに機能や制限が異なり、元々複雑な環境の管理がさらに複雑になります。

- 仮想サーバ スプロール(無秩序な増殖)の原因である、仮想マシンは「簡単に自由に無料で作れるもの」であるという概念。しかし、サポートを担当する IT 部門は新たな問題が生まれたことを認識しています。データセンター環境のコンポーネントの数が増えたために管理ツールの数も増え、その結果、仮想マシンの移動に伴うネットワーク ポリシーの追跡が難しくなっています。また、物理サーバやオペレーティング システムと同じ標準に従ってネットワークとストレージの両方のセキュリティを維持することの難しさも年々高まっています。

- 仮想化の優れた機能(仮想マシンの動的な移動やハイアベイラビリティなど)を活用するには、共有ストレージが必要であること。ラック内のすべてのサーバからファイバ チャネル SAN へのアクセスを可能にするには、非常に多くのケーブル、アダプタ、およびアップストリーム スイッチ ポートが必要になります。

IT業界は、今、次の段階へ進もうとしています。x86 アーキテクチャと仮想化を業界の標準とするところから次の論理的な段階への自然進化は始まりました。第 2 のフェーズは、ユニファイド ネットワーク ファブリックの登場によって実現しました。ユニファイド ネットワーク ファブリックは、ネットワーク、ストレージ、サーバ、およびアプリケーションの統合と仮想化を通して、データセンター テクノロジーを最適化し、拡張します。第 3 のフェーズでは、データセンター全体が仮想化されます。そのために、ネットワーク、サーバ、ストレージ アクセス、および仮想化のリソースを 1 つに集めた統合型アーキテクチャが必要です。シスコは、このアーキテクチャを「ユニファイド コンピューティング」と呼びます。そして、それを初めて具現化させたのが Cisco® Unified Computing System です。

Cisco Unified Computing System の紹介

次世代のデータセンター プラットフォームである Cisco Unified Computing System は、総所有コスト(TCO)の削減とビジネス俊敏性の向上を目的として、サーバ、ネットワーク、ストレージ アクセス、および仮想化を緊密に統合して 1 つのシステムを作ります。このシステムでは、低遅延でロスレスの 10 ギガビット イーサネット ユニファイド ネットワーク ファブリックにエンタープライズ クラスの x86 アーキテクチャ サーバが統合されます。このシステムは拡張性のあるモジュラ型のマルチシャーシ プラットフォームであり、すべてのリソースが 1 つの統合された管理ドメインに属します。このシステムの主なコンポーネントは次のとおりです。

- サーバ:このシステムの基盤であるコンピューティング システムはまったく新しいクラスのものであり、Intel Xeon 5500番台プロセッサをベースとするブレード サーバが採用されています。ブレード サーバには、特許取得済みのシスコ拡張メモリ テクノロジーが組み込まれているので、大量のデータ セットを扱うデータベースなどのアプリケーションも実行でき、サーバあたりの仮想マシン数も増加します。

- ネットワーク:このシステムは、低遅延でロスレスの 10 Gbps ユニファイド ネットワーク ファブリック上で統合されます。このネットワーク基盤は、現状では LAN、SAN、ハイパフォーマンス コンピューティング ネットワークという 3 つの異なるネットワークとして扱われているものを統合します。ユニファイド ファブリックでは、ネットワーク アダプタ、スイッチ、およびケーブルの数が減ると共に電力供給と冷却の所要量が減少するので、コストが低下します。

・ 仮想化:このシステムでは仮想化の力がフルに発揮されて、仮想環境のスケーラビリティとパフォーマンスが高まり、詳細な運用コントロールが可能になります。シスコのセキュリティ、ポリシー適用、および診断の機能が仮想環境でも利用できるようになり、ビジネスと IT の要件の変化への適切な対応が可能になります。

- ストレージ アクセス:このシステムでは、SAN ストレージと NAS の両方のアクセスがユニファイド ファブリック上で集約されます。ストレージ アクセスが集約されると、Cisco Unified Computing System からストレージへのアクセス媒体としてイーサネット、ファイバ チャネル、Fibre Channel over Ethernet(FCoE)および iSCSI が利用できるようになるので、お客様の選択肢が増えると共に、投資が保護されます。さらに、システムからストレージ リソースへの接続に関するストレージ アクセス ポリシーをあらかじめ割り当てておくことができるので、ストレージの接続と管理が単純になり、生産性も向上します。

- 管理:このシステムの特色は、あらゆるシステム コンポーネントが統合されて、ソリューション全体を 1 つのエンティティとして、Cisco UCS Manager ソフトウェアから管理できることです。Cisco UCS Manager では、直感的なグラフィカル ユーザ インターフェイス(GUI)、コマンドライン インターフェイス(CLI)、および堅牢な API(Application-Programming Interface)を使用して、システムのあらゆる構成および操作を管理することができます。Cisco UCS Manager は IT スタッフの生産性向上に貢献します。また、ストレージ、ネットワーク、およびサーバの管理者の共同作業による、アプリケーションのサービス プロファイル作成が可能になります。サービス プロファイルとは、システムとして展開したい物理構成とインフラストラクチャ ポリシーを論理的に表現したものです。サービス プロファイルによって、プロビジョニングが自動化されると共にビジネス俊敏性が向上し、データセンターのリソースのプロビジョニングを数日ではなく数分で完了できるようになります。

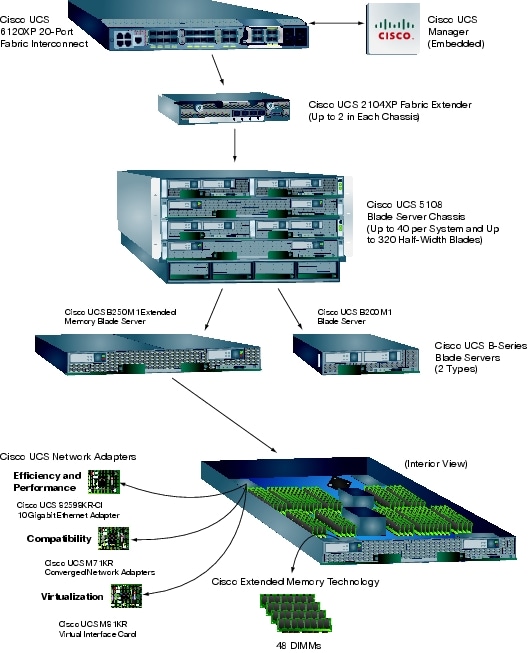

1 つの緊密に結合されたシステムとして動作するこれらのコンポーネントによって、データセンター内のテクノロジーが統一されます。従来のシステムと比べると、非常にシンプルなつくりなっており、データセンターの運用が容易になると共に、電力と冷却の所要量が削減されます。このシステムは、ビジネスの業績向上に必要な IT 俊敏性を高めます。Cisco Unified Computing System のコンポーネントを図 1 に示します。後列左からファブリック インターコネクト、ブレード サーバ シャーシ、ブレード サーバ、前列はファブリック エクステンダとネットワーク アダプタです。

図 1 Cisco Unified Computing System はコンポーネントのファミリを統合して 1 つの緊密に結合されたシステムを作る:ファブリック インターコネクト、ブレード サーバ シャーシ、ブレード サーバ、ファブリック エクステンダ、およびネットワーク アダプタ

緊密に統合されたシステム

Cisco Unified Computing System によって、コンピューティングとネットワークのリソースが緊密に統合され、1 つの動的なエンティティとして管理されます。このソリューションでは、冗長構成のとれる 10 Gbps ユニファイド ファブリックにエンタープライズ クラスの x86 アーキテクチャ サーバが統合されます。サーバ数が 1 台ではなく 320 台で、数千もの仮想マシンがあるような場合も、Cisco Unified Computing System ならば複雑さを増すことなく規模を拡張することできます。

ビジネスの俊敏性の向上

このようにシステムが緊密に結合されていれば、アプリケーションの展開に必要なサーバとネットワークの状態およびインフラストラクチャ ポリシー(電力供給と冷却、セキュリティ、ID、ハードウェア健全性、イーサネットとストレージ ネットワーキングなど)をサーバ プロファイルとしてカプセル化し、移動あるいは再利用することが可能になります。サービス プロファイルの内容は、ネットワーク ID 情報、MAC アドレスとワールドワイド ネーム(WWN)、I/O インターフェイスのタイプと構成、ファームウェアのバージョン、ブート順序とブート論理ユニット番号(LUN)、RAID レベル、およびネットワーク接続特性(VLAN、QoS、VSAN など)です。サービス プロファイルには、1 つのアプリケーションまたはワークロードに必要なネットワークおよびコンピューティングのリソース要件すべての指定が含まれます。また、サービス プロファイルは、管理ドメイン内のどのコンピューティング/ネットワーク リソースにも適用することができます。めまぐるしく変化するビジネス要件に合わせて環境を動的に形成するためには、サービス プロファイルは欠かせないテクノロジーです。このシステムでは、すべてのワークロードが、仮想化されているか否かにかかわらず、移動可能です。

ビジネス要件やワークロードの変動に IT が迅速に適応するために、ニーズの変化に合わせてリソースをジャストインタイム方式でプロビジョニングします。ファームウェアと構成設定が自動的に、整合性を維持して展開されるので、正確な設定を瞬時に適用できます。サービス プロファイルの利点には、次のようなものがあります。

- サーバ、ネットワーク、およびストレージの管理者がアーキテクチャに関するデザイン・設定レベルの決定を行った後は、その決定事項を繰り返し実装する作業を運用スタッフに委任し、手順を自動化することもできるので、管理者は戦略的な、ビジネスを左右する重要な問題に専念できます。

- 既存のソフトウェア スタックをシステム内の別の独立サーバに移動するときも、サービス プロファイルを作成して展開すれば、移動元システムとまったく同じシステムをもう一度作成することができます。

- 動的プロビジョニングを通して、OS とアプリケーション ソフトウェア スタックをサーバ間で移動することができます。サーバのいずれかで障害が発生した場合は、そのサーバを外部へのネットワーク接続設定もそのまま再現した正確なレプリカ上で、ソフトウェア スタックを再起動することができます。ハードウェアのアップグレードが必要な場合は、リソースを増やした新しいサーバをプロビジョニングして、そのサーバ上でソフトウェア スタックを再起動することができます。たとえば、データベース管理システムの移動元のサーバのメイン メモリが 72 GB で、移動先のメイン メモリが 384 GB の場合も、1 回のリブートだけで、元のサーバと同じ ID を持つサーバをジャストインタイム方式でプロビジョニングし、データベース管理システムを移動することが可能です。

- 仮想マシンの移動がシステム全体でサポートされます。I/O とネットワークのプロファイル(VLAN 設定、アクセス コントロール リスト、QoS 設定、バッファリング特性、帯域幅のパラメータなど)は、仮想マシンと共に自動的に移動するので、アベイラビリティ、セキュリティ、およびパフォーマンスが高まります。

複雑さを増すことなく拡張が可能

このシステムはハイアベイラビリティを特長としており、1 組のファブリック インターコネクトでブレード シャーシ最大 40 台とブレード サーバ 320 枚を接続できます。新しいコンピューティング リソースが稼働させるまでの時間が短縮され、手動のプロビジョニング プロセスに費やしていた時間を節約できます。Cisco UCS Manager は、ブレード シャーシのスロットに挿入された新しいリソースを即座に認識し、プロビジョニングを行い、あらかじめ設定されたポリシーに従ってすぐに稼働させることができます。さらに、シスコ拡張メモリ テクノロジーによってメモリ容量は 384 GB と従来の デュアル ソケット サーバの 2 倍を上回る物を用意できます。、この大容量メモリによりパフォーマンスとキャパシティが増大し、仮想化や大量のデータセットを扱うワークロードの処理も可能になります。また、メモリをあまり必要としないワークロードに対しては、より廉価なメモリを使用することによりコスト削減を図ることもできます。

アーキテクチャの大幅な単純化

Cisco Unified Computing System によって、サーバとネットワークの展開方法はこれまでに比べて大幅にシンプルになります。このシステムでは、ブレード サーバ シャーシ内部のスイッチが排除されるので、多段で複雑なネットワーク アクセス レイヤを持つ必要がなくなります。コンピューティング リソースは、ユニファイド I/O ファブリック上で統合されます。このファブリックは、標準の IP プロトコルに加えてファイバ チャネルも Fibre Channel over Ethernet(FCoE)カプセル化を通してサポートします。このシステムでは、ネットワーク アダプタを最初に設定した後、スロットが足りないため後で追加ができないといったハードウェアにおけるI/O 構成の固定という制限がなくなります。ソフトウェアからサーバ単位で I/O 構成を変更できるようにアーキテクチャが設計されているので、必要な数だけの I/O 接続を必要な時にジャストインタイム方式で構成することが可能になります。このような大幅な単純化の結果、スイッチ、ケーブル、アダプタ、および管理ポイントの数が減り、コスト、複雑さ、電力所要量、および冷却オーバーヘッドの削減につながります。

エンドツーエンドの最適化

このシステムは、仮想環境をエンドツーエンドで最適化しますが、従来の OS およびアプリケーション スタックに対しても、より動的で可動性の高い物理環境を作ることができます。このシステムは、ビジネスの問題を解決するための最も適したコンピューティング モデルであると同時に、投資が保護も実現します。

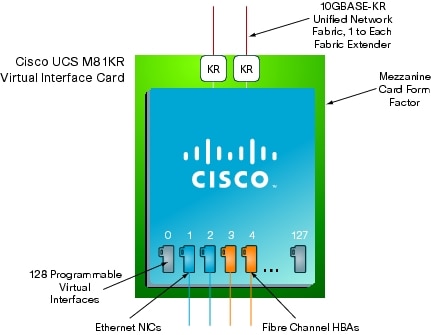

ブレード サーバに装着される Cisco UCS M81KR 仮想インターフェイス カードは、このシステムの特長であるエンドツーエンドでの仮想化サポート能力をフルに発揮させます。このカードは、I/O デバイスのタイプと MAC アドレスなどの ID をオンデマンドで構成できるように設計されています。物理カード上で仮想的なネットワーク インターフェイスを動的にプロビジョニングして、仮想マシンとはパススルー スイッチングまたはハイパーバイザ バイパス テクノロジーを使用して直接接続することができます。生成されたインターフェイスの定義とそれに付随するネットワーク プロファイルは、仮想マシンと共にサーバ間を移動できるので、ワークロードのバランス、新しいアプリケーションへの対応、およびビジネス要件の変化への対応のために、システム全体を動的に調整することが可能です。

エンドツーエンドの最適化の結果、リスクも軽減します。物理マシンのネットワーク接続と同じように、仮想マシンの接続をプロビジョニングして管理することができるので、仮想リンクの可視性が高まります。標準や規制に適合させるための仮想リンクの管理や監査を、仮想マシン単位で実行することができます。たとえば、物理リンクと同様に仮想リンクの QoS を設定することができます。仮想マシンの 1 つがリンクの帯域幅を使い尽くしてしまうリスクを緩和するための手段として、仮想リンク単位の QoS はもちろん、その仮想マシンのネットワーク接続を、同じシステム内の他の仮想マシンに影響を及ぼすことなく遮断することも可能です。

業界標準に基づく

Cisco Unified Computing System には、シスコとそのエコシステム パートナーとの密接なコラボレーションの成果が反映されています。ユニファイド ファブリックは 10 ギガビット イーサネット標準に基づいています。Cisco Data Center Ethernet(Cisco DCE™)を構成する、標準化されたさまざまな拡張機能の他に、FCoE、拡張フロー制御、およびネットワーク管理をサポートするその他の標準機能が実装されます。ネットワーク アダプタには、シスコのパートナー製のイーサネット NIC とファイバ チャネル ホスト バス アダプタ(HBA)シリコンが組み込まれているため、既存のシステムおよびドライバ、管理ソフトウェア、およびデータセンター ベスト プラクティスとの相互運用が可能です。コンピューティング リソースの基盤となっているのは、業界標準の x86 システム コンポーネントです。また、Cisco UCS Manager からはシステムの構成情報を構成管理データベース(CMDB)にエクスポートできるので、ITIL(Information Technology Infrastructure Library)の概念に基づくプロセスの実現に役立ちます。さらに、Cisco UCS Manager の XML API を利用すれば、Cisco UCS Manager を使用して構成されたサーバ上で、サードパーティ製のプロビジョニング ツールを使用して仮想マシンを展開することや、オペレーティング システム、アプリケーション ソフトウェアをインストールすることが可能になります。

エネルギー効率を高める設計

シスコ ユニファイド コンピューティング システムのほぼあらゆる面が、エネルギー効率を高めるように設計されています。ブレード シャーシのエアフロー設計は画期的であり、ミッドプレーンの 63% が開放されて、空気が遮られずに通るようになっています。電源装置の効率は 92% となっています。ブレード シャーシのスイッチが排除され、NIC および HBA が集約された結果、電力所要量が減少します。ブレード サーバの Intel Xeon 5500 番台プロセッサは、電力消費とパフォーマンスのバランスを取る設計となっており、負荷が低いときは電力消費を減少させ、負荷が高いときは熱条件の許す範囲で個々のコアのクロック レートを上げます。サーバあたりのインストール可能メモリの容量が増大すれば、メモリ所要量を増加させるためだけに追加で 2 あるいは 4 ソケットのサーバを購入する必要はなくなり、追加しない分、電力供給と冷却も追加で必要なくなります。

将来への対応を可能にする投資

Cisco Unified Computing System ならば、データセンターの拡張が容易になると同時に、将来のテクノロジーの発展に備えることができるので、今日の投資回収率の向上だけでなく、長期的な投資の保護にも役立ちます。ブレード サーバ シャーシ、電源装置、およびミッドプレーンは、より処理能力の高いサーバが将来登場した場合も対応できるようになっています。シャーシは、40 ギガビット イーサネット標準が将来実用化されたときにサポートできるように設計されています。

合理的なシステム アーキテクチャ

シスコ ユニファイド コンピューティング システムは、Cisco UCS 6100 シリーズ ファブリック インターコネクト 1 台または 2 台と、Cisco UCS 5100 シリーズ ブレード サーバ シャーシ 1 台以上、およびシャーシに収容された Cisco UCS B シリーズ ブレード サーバから構成されます。Cisco UCS Manager はファブリック インターコネクトに組み込まれており、すべてのサーバ シャーシを 1 つの冗長可能な管理ドメインとしてサポートします。

各シャーシには、Cisco UCS 6100 シリーズ ファブリック インターコネクトとの 10 ギガビット ユニファイド ファブリック接続が 1 本以上必要です。ブレード シャーシは 40 台まで構成可能で、320 枚のブレード サーバを収容すると、冗長構成された Cisco UCS 6140XP ファブリック インターコネクトの固定ポート 40 個がすべて埋まります。一般的な構成では、各シャーシからは、アクティブ/アクティブ構成がとられたファブリック インターコネクトそれぞれに対して 2 本から 4 本のユニファイド ファブリックで接続されます。

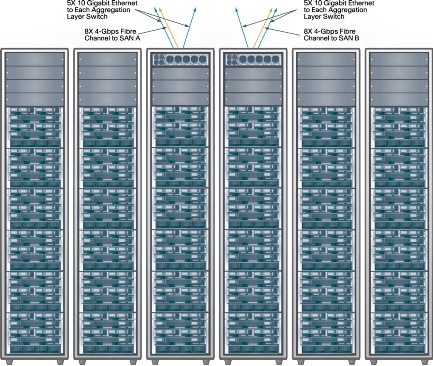

たとえば、図 2 では、36 台のブレード サーバ シャーシが、フェールオーバーをサポートするファブリック インターコネクトのアクティブ/アクティブ ペアに接続されています。2 台のファブリック インターコネクトの拡張モジュールによって、LAN トラフィックは LAN アグリゲーションまたはコア レイヤに伝送され、SAN トラフィックはネイティブ ファイバ チャネルを通して SAN A または SAN B に伝送されます。

Cisco Unified Computing System には、シスコとそのエコシステム パートナーとの密接なコラボレーションの成果が反映されています。ユニファイド ファブリックは 10 ギガビット イーサネット標準に基づいています。ユニファイド ファブリックは、、標準化されたさまざまな拡張機能を備える Cisco Data Center Ethernet(Cisco DCE™)の他に、FCoE、拡張されたフロー制御、およびネットワーク管理をサポートするその他の標準機能が実装されます。CNA には、シスコのパートナー製のイーサネット NIC とファイバ チャネル ホスト バス アダプタ(HBA)シリコンが組み込まれているため、既存のシステムおよびドライバ、管理ソフトウェア、およびデータセンター ベスト プラクティスとの相互運用が可能です。コンピューティング リソースの基盤となっているのは、業界標準の x86 システム コンポーネントです。さらに、Cisco UCS Manager は標準ベースのエンタープライズ管理システムとの統合をサポートしています。Cisco UCS Manager の標準ベースのオープン API を通して、上位のプロビジョニング/管理ツールと統合すれば、ジャストインタイム方式でプロビジョニングされたサーバ上で、さらに上位ツールによって OS とアプリケーション スタックをプロビジョニングすることができます。

将来も無駄にならない投資

Cisco Unified Computing System ならば、データセンターの拡張が容易になると同時に、将来のテクノロジーの発展にも備えることができるので、即座に投資回収率が向上されるだけでなく、長期的な投資の保護にも役立ちます。ブレード サーバ シャーシ、電源装置、およびミッドプレーンは、将来のサーバにも対応できるように設計されています。CPU の処理能力は今後ますます高まるでしょう。また、40 ギガビット イーサネット標準が実用化されれば、ハーフ幅ブレード サーバ 1 枚あたりの総帯域幅は 80 Gbps となります。

システムの概要

シスコ ユニファイド コンピューティング システムは、Cisco UCS 6100 シリーズ ファブリック インターコネクト 1 台または 2 台と、Cisco UCS 5100 シリーズ ブレード サーバ シャーシ 1 台以上、およびシャーシに収容された Cisco UCS B シリーズ ブレード サーバから構成されます。Cisco UCS Manager はファブリック インターコネクトに組み込まれており、すべてのサーバ シャーシを 1 つの冗長可能な管理ドメインとしてサポートします。

各シャーシには、Cisco UCS 6100 シリーズ ファブリック インターコネクトとの 10 ギガビット ユニファイド ファブリック接続が 1 本以上必要です。ブレード シャーシは 40 台まで構成可能で、320 枚のブレード サーバを収容すると、冗長構成されたCisco UCS 6140XP ファブリック インターコネクトの固定ポート 40 個がすべて埋まります。一般的な構成では、各シャーシからは、アクティブ/アクティブ 構成がとられたファブリック インターコネクトそれぞれに対して 2 本から 4 本のユニファイド ファブリックで接続されます。

たとえば、図 2 では、36 台のブレード サーバ シャーシが、フェールオーバーをサポートするファブリック インターコネクトのアクティブ/アクティブ ペアに接続されています。2 台のファブリック インターコネクトからのアップリンクによって、LAN トラフィックは LAN アグリゲーションまたはコア レイヤに送信され、SAN トラフィックはネイティブ ファイバ チャネルを介して SAN A または SAN B に送信されます。

図 2 シスコ ユニファイド コンピューティング システムの例(Cisco UCS 5100 シリーズ ブレード サーバ シャーシ 36 台と Cisco UCS 6140XP シリーズ ファブリック インターコネクト 2 台で構成)

- Cisco UCS 6100 シリーズ ファブリック インターコネクトによってユニファイド ファブリックはサポートされます。 この図の Cisco UCS 6120XP ファブリック インターコネクトには、固定ポート 20 個と拡張モジュール スロット 1 個があります。

- Cisco UCS Manager は、2 台の Cisco UCS 6100 シリーズ ファブリック インターコネクトの中で実行され、システムを 1 つの統合された管理ドメインとして管理します。この管理ソフトウェアは、クラスタ化されたアクティブ/パッシブ構成で展開されるので、一方のインターコネクトに障害が発生しても管理プレーンはまったく影響を受けません。

- ユニファイド ファブリックは、最大 40 台のブレード シャーシそれぞれに、ブレード シャーシあたり最大 2 枚の Cisco UCS 2100 シリーズ ファブリック エクステンダを通して接続されます。ファブリック エクステンダ 1 枚で最大 4 本のユニファイド ファブリック接続が可能です。各シャーシからは、親である Cisco UCS 6100 シリーズ ファブリック インターコネクトとの接続が 1 本以上必要です。

図 3 Cisco Unified Computing System を構成するインターコネクト、ファブリック エクステンダ、ブレード サーバ シャーシ、ブレード サーバ、CNA、およびシスコ拡張メモリ テクノロジー

- Cisco UCS 5100 シリーズ ブレード サーバ シャーシには、最大 8 枚の Cisco UCS B シリーズ ブレード サーバを収容できます。このシャーシは、ハーフ幅とフル幅のブレードをサポートします。Cisco UCS B シリーズ ブレード サーバには Intel Xeon 5500 番台プロセッサが採用されており、インテリジェントにパフォーマンスの変更、自動的なエネルギーの効率化、および柔軟な仮想化が可能です。

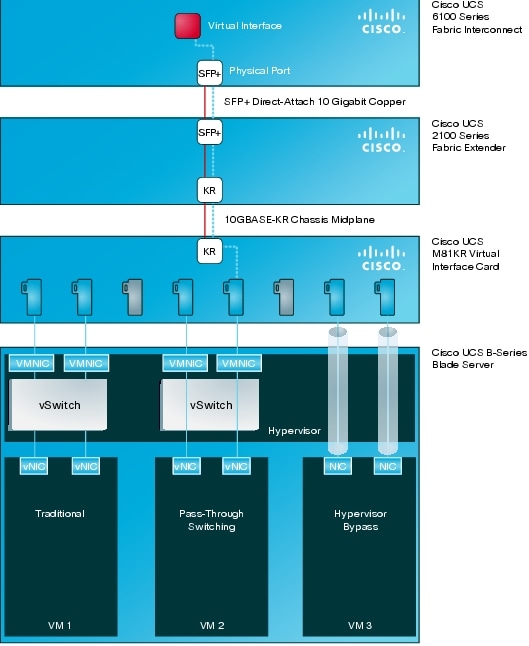

- ユニファイド ファブリックへの透過的なアクセスを可能にするために、3 種類のネットワーク アダプタが用意されています。いずれもメザニン カード フォーム ファクタで、それぞれの目的に合わせて最適化されています。仮想インターフェイス カードには Cisco VN-Link テクノロジーが組み込まれており、最大 128 個の仮想インターフェイス デバイスを動的に構成することができます。統合型ネットワーク アダプタ(CNA)は固定数のイーサネット/FCoE(Fibre Channel over Ethernet)接続が可能で、既存のファイバ チャネル ドライバ スタックとの相互運用が可能です。もう 1 つは、効率に優れたハイパフォーマンス 10 ギガビット イーサネット用のネットワーク インターフェイスです。

- シスコ拡張メモリ テクノロジーは Cisco UCS B250 M1 拡張メモリ ブレード サーバに採用されており、デュアル ソケット x86 サーバで使用可能なメモリ容量を拡張します。この拡張メモリ ブレード サーバがサポート可能な DDR3 メモリは最大 384 GB(業界標準 DIMM 最大 48 個)です。

Cisco UCS Manager

データセンター環境は複雑さを増しており、無数の管理ポイントが存在します。ネットワークに目を向けると、アクセス レイヤが多段化されてしまっています。従来のアクセス レイヤ スイッチ、ブレード サーバ内のスイッチ、および仮想化ソフトウェアで使用されるソフトウェア スイッチのそれぞれが、機能も管理パラダイムも異なるからです。今日のブレード サーバ システムのほとんどは、シャーシごとに独立した電力供給および環境管理のためのモジュールを持っていて、これが理由でコストと管理の複雑さが増大しています。ブレード サーバ システムでもラックマウント サーバでも、イーサネット NIC およびファイバ チャネル HBA の構成とファームウェアの更新がブレード サーバあるいはラックマウント サーバごとに必要です。ブレードおよびラックマウントのサーバ ファームウェアのメンテナンスも必要で、BIOS 設定については整合性を維持するための管理が必要です。その結果、データセンター環境の維持は難しく、コストもかかるようになりましたが、セキュリティとパフォーマンスは求められる水準を満たしているとは限りません。データセンターには変化が必要ですが、x86 サーバ アーキテクチャを展開するための古いパラダイムが変化を難しくしています。

- 物理サーバが OS とアプリケーション ソフトウェア スタックを実行するという固定された環境では、規模の変更や負荷管理の要件に応じて稼働中のサーバを別のサーバに移動させるのは困難です。ソフトウェアを別のサーバに移動するには、I/O デバイスとその構成、ネットワーク構成、ファームウェア、および BIOS 設定をすべて手動で設定する必要があります。そのため、時間がかかり、作業中にエラーが起きる可能性もあります。このような環境では、ピーク時のワークロードのニーズに対応できるように予備の固定サーバをあらかじめ展開しておくのが一般的です。一日のほとんどの時間、この予備のサーバの使用率は非常に低いか、まったく使用されないため、資本的コストと運用コストの両方が上昇します。

- 仮想環境には固定環境の欠点がすべて受け継がれていますが、それだけはありません。アクセス レイヤが多段化されているため、仮想マシンの移動を追跡するのが難しく、セキュリティの維持、可視性向上、仮想マシン単位の QoS のサポート、および I/O 接続維持のために仮想マシンにネットワーク ポリシーを適用するのも困難です。仮想化のメリットは多大ですが、複雑さも増します。

プログラムによって展開されるサーバ リソース

Cisco UCS Manager によって中央集中型の管理が可能になり、管理ドメインが 1 つに統合されます。Cisco UCS Manager は、シスコ ユニファイド コンピューティング システムにおいて中枢神経系の役割を果たす製品です。組み込み型のデバイス管理ソフトウェアである Cisco UCS Manager は、システム全体を 1 つの論理エンティティとして管理するために直感的にわかりやすい GUI、CLI、および XML API を備えています。このソフトウェアは、ロールおよびポリシーをベースとした管理を、サービス プロファイルとテンプレートを使用して行います。このような方法を取ることで、IT の生産性とビジネス俊敏性が向上します。インフラストラクチャのプロビジョニングが数日ではなく数分で完了するので、IT 部門はメンテナンスよりも戦略的イニシアティブに注力できるようになります。

サービス プロファイルによる動的なプロビジョニング

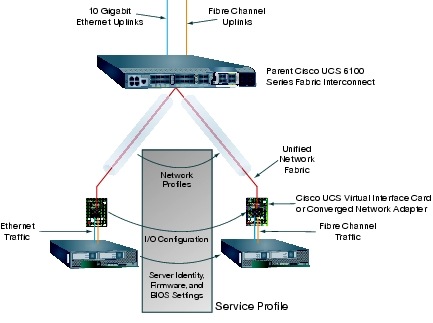

Cisco Unified Computing System では、リソースは抽象化されており、リソースの ID、I/O 構成、MAC アドレスと WWN、ファームウェアのバージョン、BIOS ブート順序、およびネットワーク属性(QoS 設定、ACL、ピン グループ、しきい値のポリシーなど)はすべて、ジャストインタイム プロビジョニング モデルを使用してプロビジョニングすることができます。Cisco UCS Manager はこの ID、接続、および構成の情報を Cisco UCS 6100 シリーズ ファブリック インターコネクト上でサービス プロファイルとして保存します。サービス プロファイルはどのリソースにも適用でき、適用されたリソースは特定のソフトウェア スタックのサポートに必要な特性を持つようにプロビジョニングされます。図 4 に示すように、定義されたサーバおよびネットワークの設定は、サービス プロファイルを使用することで、管理ドメイン内で移動させることができるので、システム リソースを柔軟に使用できるようになります。

図 4 ソフトウェア スタックが物理的でも仮想でも、Cisco UCS Manager のサービス プロファイルによってサーバとネットワークのリソースがジャストインタイム モデルを使用してプログラミングされる

サービス プロファイル テンプレートを使用すると、個別のリソース クラスを定義して多数のリソースに適用することができます。各リソースには、あらかじめ指定されたプールから一意の ID が割り当てられます。サーバが物理的なものでも、Cisco UCS VIC M81KR 仮想インターフェイス カードの 128 個の仮想デバイスのいずれかに直接接続された仮想マシンでも、同じ手法で管理されます。

ロール ベース管理とマルチテナント サポート

UCS Manager ではロール ベースの管理が可能であり、管理者という限られたリソースの有効利用に役立ちます。Cisco UCS Manager ならば、IT の各領域の分担を維持しながらチームワーク、コラボレーション、および全体的な効率を向上させることができます。 従来、サーバ、ネットワーク、およびストレージの管理責任者がそれぞれの領域でそれぞれのポリシーを考え適用していますが、その責任分担は、1 つに統合された管理環境の中でもそのまま維持されます。ただし、これまでとは異なり、コンピュータ インフラストラクチャのプロビジョニングを行うために担当者間の細かい調整に時間をかける必要はありません。システム内のロールと特権の修正や、新しいロールの作成も容易です。

管理者は、コンピュータ インフラストラクチャとネットワーク接続のプロビジョニングに必要なポリシーの定義に専念します。管理者どうしが連携して、戦略的なアーキテクチャの問題に取り組み、サーバの基本的な設定は自動化することができます。また、Cisco UCS Managerは、別会社や別部署にそれぞれ個別のシステム・サービスを提供する必要があるマルチテナント サービス プロバイダーやエンタープライズ データセンターをサポートするための機能を備えています。システム全体を個別な論理的なパーティションに分割し、それぞれ異なるクライアントまたは顧客に割り当てて、パーティションごとに管理することができます。

Cisco UCS 6100 シリーズ ファブリック インターコネクト

今日のデータセンターでは、各サーバにイーサネット NIC、ファイバ チャネル HBAともに 2 つ以上取り付け、ネットワークとストレージ リソースの両方へのアクセスを常時維持するよう設計されます。ファイバ チャネル ストレージへのアクセスのためには、イーサネットのインフラストラクチャとは別にファイバ チャネルのインフラストラクチャを構築する必要があります。このインフラストラクチャのためには、HBA と、高価なファイバ トランシーバ、および各サーバから SAN アクセス レイヤ スイッチまでの専用の配線が必要となってきます。これらのコンポーネントをすべて購入して構成しなければならず、さらにメンテナンス、電力供給、および冷却も必要です。この複雑さが理由で、データセンターの資本コストと運用コストが増加します。また、このようにファイバ チャネル インフラストラクチャの構築にはコストがかかるため、限られた場所でしかファイバ チャネル インフラストラクチャは構築できず、データセンター内のどのサーバからもストレージにアクセスできるようにするといったユニバーサル ストレージアクセスの実現が難しくなります。これは非常に大きな制約です。仮想マシン ポータビリティの利点をフルに発揮させてハイアベイラビリティとロード バランシングを可能にするには、すべてのサーバが共有ストレージにアクセスすることが必須だからです。

ユニファイド ファブリック インターコネクト

Cisco UCS 6100 シリーズ ファブリック インターコネクトは、ラインレート、低遅延、ロスレスの 10 ギガビット イーサネット、Cisco DCE および FCoE をサポートするインターコネクト スイッチです。この製品によって、システム レベルの I/O 統合が実現されます。Cisco Nexus 5000 シリーズ スイッチと同じスイッチング テクノロジーに基づいて設計された Cisco UCS 6100 シリーズ ファブリック インターコネクトは、さらに、Cisco Unified Computing System の中核となる管理能力、機能が追加されています。

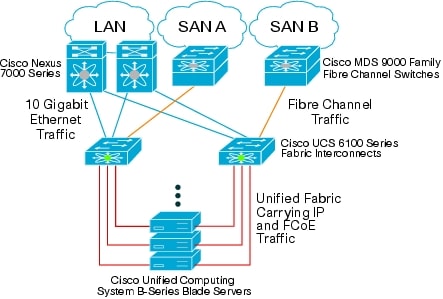

ファブリック インターコネクトによって提供されるユニファイド ファブリックによって、システム内のすべてのサーバが接続されます。ダウンリンクには「配線は一度だけ(wire-once)」の 10 ギガビット イーサネットと FCoE が使用され、アップリンクには柔軟性に優れた 10 ギガビット イーサネットおよび 1/2/4 Gbps ファイバ チャネルが使用されます(図 5)。アウトオブバンド管理、スイッチ冗長性などのために、専用の管理およびクラスタリング ポートも用意されています。このファブリック インターコネクトの特長である前面から背面へのエアー フロー、前面に配置された冗長かつ挿抜可能なファンと電源装置、および背面に配置されたケーブル ポートによって、すぐれた冷却の仕組みと運用効率を提供します。通常は、2 台のファブリック インターコネクトでアクティブ/アクティブの冗長構成を組みます。ファブリック インターコネクトはネットワークとストレージの両方にどのサーバからもユニバーサルにアクセスできるようにし、リソース プールから必要なときに必要なリソースを取り出すことができる完全に仮想化された環境を実現するためのインフラを提供します。

図 5 ユニファイド ファブリックによって複数のトラフィック ストリームが Cisco UCS 6100 シリーズ ファブリック インターコネクトまで伝送され、その先はイーサネットとファイバ チャネルのネットワークにトラフィックが分かれる

ファブリック インターコネクトによってラック レベルの I/O が集約され、ブレード シャーシとインターコネクトの間のトラフィックは、低コスト、低遅延で 10 ギガビット速度を実現する SFP+(Small Form-Factor Pluggable Plus)銅 Twinax ケーブル、または 10 ギガビット SFP+ ファイバ ケーブルを介して伝送されます。OS からは、アクセス対象のイーサネットおよびファイバ チャネルのデバイスが従来のサーバ環境にあるように見えますが、物理的実装では、使用する物理リンクは 1 本だけです。ファイバ チャネル トラフィックをネイティブのファイバ チャネル ネットワークに転送するには、ファイバ チャネル接続のための拡張モジュールを使用します。

Cisco DCE の機能によって、同じネットワーク リンク上で伝送される個々のトラフィック ストリームの管理が容易になり、パフォーマンスも向上します。IEEE 802.1Qbb 標準の優先度フロー制御(PFC)によって、個々のトラフィック ストリームの管理が可能になります。たとえば、ストレージ トラフィックのためのロスレス クラスを作成すれば、標準 IP ネットワーク トラフィックとは別の方法で管理することができます。IEEE 802.1Qaz 拡張伝送選択(ETS)によって、各トラフィック クラスへの帯域幅割り当てが可能になり、たとえばネットワーク帯域幅をストレージ トラフィック専用にすることができます。このような機能によって、FCoE および iSCSI のプロトコルの管理が容易になります。

1 つのシステムとして見える

ファブリック インターコネクトが存在することで、アップストリームのイーサネット/ファイバ チャネル スイッチからは、管理ドメイン全体が 1 つのシステムに見えます。この機能によって、イーサネット レイヤ 2 の管理とファイバ チャネルのネットワーク構成が大幅にシンプルになり、コストが削減されると同時に、パフォーマンスが向上します。アクティブ/アクティブのネットワーク アップリンクがサポートされ、リンクのいずれかが使用できなくなったときにスイッチの管理下でフェールオーバーが実行されるからです。

このシンプルな環境を実現するために、イーサネットとファイバ チャネルの両方でエンドホスト モードが使用されます。その結果、スパニング ツリー プロトコルが不要になり、代わりに物理サーバと仮想サーバの両方の MAC アドレスと WWN がアップリンク インターフェイスにおいて固定されます。このようなアプローチを取ることで、ファブリック インターコネクトとサーバとを接続するユニファイド ファブリックをファブリック インターコネクトが完全に制御できるようになります。また、アクティブ/アクティブのイーサネット アップリンクが使用されるので、アップリンク ポート帯域幅の利用率が向上します。

仮想化の最適化

Cisco UCS 6100 シリーズ ファブリック インターコネクトは、Cisco VN-Link アーキテクチャをサポートします。Cisco VNLink によって、ポリシー ベースの仮想マシン接続が可能になり、仮想マシンの移動と共にネットワーク プロパティを移動できるようになります。また、物理と仮想の両方の環境の運用モデルが統一されます。

データセンターの将来を見据えた配線方式

Cisco UCS 6100 シリーズ ファブリック インターコネクトは、データセンターの将来を見据えた配線方式(ラック内およびポッド内の相互接続には銅線を使用し、データセンターのラック間接続、オーバーヘッド ケーブル トレイでは光ファイバを使用する)をサポートします。

この配線方式の最初の部分であるブレード シャーシとファブリック インターコネクトの接続には、10 ギガビット SPF+銅 Twinax ケーブルを使用します。この低コストかつ低遅延の製品は、ブレード シャーシとその親インターコネクトの間の多数の短距離接続をサポートするのに最適です。

データセンター内でこれよりも長い距離を接続するには、光ファイバが一般的です。オーバーヘッド ケーブル トレイで光ファイバを使用すれば、データセンター内の各ラック位置まで配線されるケーブルの数が比較的少なくなると共に、後でケーブルを別の目的に転用することも可能です。光ファイバは銅ケーブルよりも長期的な投資保護の点で優れています。接続速度を向上させるテクノロジーは、ほとんどの場合、まず光ファイバに実装されるからです。つまり、ラック間接続、オーバーヘッド ケーブル トレイでは光ファイバを使用すれば、将来の LAN および SAN の速度に対応するうえで有利です。

Cisco UCS 2100 シリーズ ファブリック エクステンダ

従来のブレード システムでは、ブレード シャーシに複数のスイッチを内蔵する必要があるため、ブレード内にもう 1 つスイッチング層が追加され、アクセス レイヤが多段化されて複雑になってしまいます。 ブレード シャーシ内のスイッチが増えるほど、ブレード システムの資本コストが増加し、管理のコストとシステムの複雑さも増大します。このコストとシステムの複雑さは、データセンターにシャーシが追加されるたびに増えています。さらに、ブレード システムには一般にそのブレードを提供したメーカー独自のスイッチが使用されており、機能セットもメーカー、スイッチごとに異なるため、さまざまなサーバおよびシャーシの間でネットワーク構成を連携させることや、統一されたポリシーを適用することが難しくなっています。その結果、仮想マシンがサーバ間で移動したときの仮想環境の複雑さがさらに増します。

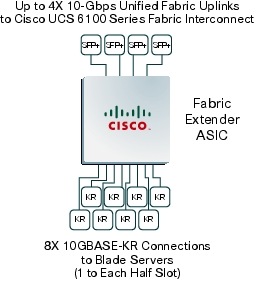

Cisco UCS 2104XP ファブリック エクステンダによって、I/O ファブリックはブレード サーバ シャーシまで拡張されます。ブレード サーバと親のファブリック インターコネクトの間は最大 4 本の 10 Gbpsで接続され、診断、配線、および管理がシンプルになります。ファブリック エクステンダからのトラフィックはすべて多重化され、カットスルー アーキテクチャを使用して 1 〜 4 本の 10 Gbps ユニファイド ファブリック接続上で転送されます。すべてのトラフィックは親であるファブリック インターコネクトに渡されます。ネットワークのプロファイルは、ファブリック インターコネクトによって効率的に管理されています。ブレード サーバ シャーシあたり最大 2 枚のファブリック エクステンダを挿入でき、それぞれ、8 本の 10GBASE-KR 接続でブレード シャーシのミッドプレーン経由でシャーシ内のハーフ幅ブレード サーバに接続されており、8 個のハーフ幅ブレード サーバからはそれぞれ 1 本の 10GBASE-KR 接続でファブリック エクステンダと接続されます(図 6)。ハーフ幅のブレード サーバのそれぞれが 10 Gbps ユニファイド ファブリック接続を 2 本使用し、2 つのファブリック エクステンダに接続できるので、スループットと冗長性が高まります。

図 6 Cisco UCS2100 シリーズ ファブリック エクステンダの中核である ASIC によって、8 個の 10GBASE-KR インターフェイスからのトラフィックが多重化されて 4 本の 10 ギガビット イーサネット接続上で転送される

このファブリック エクステンダにより、ここでもCisco Unified Computing System の特徴である「大幅シンプルなシステム」の実現が可能になります。ファブリック エクステンダがあれば、中間アクセス レイヤの役割を果たすスイッチをブレード シャーシ内に複数収容して個別に管理する必要がなくなります。サーバ接続のために必要なアクセス レイヤ スイッチングの機能はすべてファブリック インターコネクトが提供するので、管理がシンプルになり、コストが削減されます。

物理的には、ファブリック エクステンダはそれぞれブレード シャーシに収容され、ブレード シャーシのミッドプレーンに接続されています。論理的には、ファブリック エクステンダはファブリック インターコネクトのリモート ライン カードとして動作し、Cisco UCS Manager によって制御されるスイッチ管理ドメインの一部となります。ファブリック エクステンダは状態(ステート)を一切維持せず、自身のファームウェア、設定は親スイッチから直接受け取ります。スイッチとファブリック エクステンダのファームウェアは 1 つのユニットとして配信されてインストールされるので、ファームウェアのバージョンが不一致になるというリスクはありません。

ファブリック エクステンダのその他の機能

データ プレーンのサポートに加えて、Cisco UCS 2104XP シリーズ ファブリック エクステンダには、シャーシ管理コントローラが内蔵されています。これは、ブレード シャーシのすべての物理コンポーネント(電源、ファン、温度センサーなど)とのインターフェイスとして機能します。ファブリック エクステンダは、各ブレードの管理ポートとも接続されており、このポートを通して管理、監視、およびファームウェアのアップデートを行います。つまり、管理モジュールを別途購入する必要はありません。

ファブリック エクステンダを使用したシステム デザインには、次のような利点があります。

-

スケーラビリティ:ファブリック エクステンダ 1枚あたり最大 4 本の 10 Gbps アップリンクを持つことができます。ワークロードの増大に合わせてネットワーク接続のキャパシティを増やすときも、追加のアップリンクを設定するだけで、より多くのトラフィックを伝送できるようになります。

- ハイアベイラビリティ:ファブリック エクステンダを 2 枚使用するようにシャーシを構成すれば、ネットワーク環境のアベイラビリティが高まります。

- 信頼性:ネットワーク アダプタからファブリック エクステンダを通してユニファイド ファブリックに伝送されるトラフィック フローの管理をファブリック エクステンダが行います。ネットワーク アダプタからネットワークに流れるトラフィックがファブリック エクステンダによって動的に抑制されるので、アダプタからファブリック インターコネクトまでのファブリックにおけるパケット ロスが減少します。

- 管理性:ファブリック エクステンダ モデルでは、アクセス レイヤの規模が拡大しても複雑さや管理ポイントが増すことはないため、より戦略的な問題に管理スタッフが専念できるようになります。ブレード シャーシの管理と環境の監視もファブリック エクステンダによって行われるので、必要な管理ポイントの数が減り、コストが削減されます。

- 仮想化の最適化:ファブリック エクステンダは、Cisco VN-Link アーキテクチャをサポートしています。Cisco UCS の他のコンポーネント(ファブリック インターコネクトやネットワーク アダプタなど)が持つ VN-Link 機能とファブリック エクステンダとの統合によって、仮想化のさまざまな利点、たとえば仮想マシン ベースのポリシー適用や、ネットワーク プロパティの移動、可視性の向上、仮想環境における容易な問題診断が実現します。

- 投資の保護:ファブリック エクステンダはモジュラ式であるため、帯域幅や接続の特性が異なる同等のモジュールを将来開発することも可能であり、ブレード サーバ シャーシへの投資が保護されます。

- コスト削減:ファブリック エクステンダ テクノロジーを採用すればスモール スタートが可能になります。ユニファイド ネットワークのコストをシステムの増加に合わせて少しずつ支払うことが可能になり、予算が限られている時期のコスト抑制に役立ちます。ずっと先になる必要になるキャパシティを見越して、大規模な固定構成ファブリック インフラストラクチャをスタート時点から構築する必要がなくなり、大規模な初期投資も必要なくなります。

Cisco UCS 5100 シリーズ ブレード サーバ シャーシ

ブレード シャーシのほとんどは、シャーシごとにサーバおよびシャーシを管理する管理モジュールが必要で、LAN/SAN のスイッチもシャーシ内に存在しそれらも管理する必要があるため、1 ブレードシャーシ内だけでも複数の管理ポイントがあるのにシャーシが複数になると管理はさらに複雑になります。対照的に、Cisco UCS 5100 シリーズ ブレード サーバ シャーシは、論理的には親インターコネクトの一部として振る舞い、すべてのブレード サーバ シャーシは 1 つの統合されたシステムとして管理されます。ファブリック インターコネクトはサーバの管理のみならず、ブレード サーバ シャーシ、ブレード サーバに必要な I/O とネットワークの管理もすべて行います。ユニファイド ファブリックおよびユニファイド I/O により、 Cisco Unified Computing System におけるサーバ シャーシのつくりは、シンプルで合理的、それでいて LAN、SAN と包括的な I/O オプションを提供できるものになります。その結果、シャーシの基本コンポーネントはわずか 5 種類となっています。ミッドプレーンを除くすべてのコンポーネントはホットプラグ可能で、ユーザによる保守が可能です(図 7)。

-

物理シャーシ:パッシブ ミッドプレーンとアクティブ環境モニタリング回路を備えています。

- 電源ベイ 4 個:電力入力部は背面にあります。冗長化とホットスワップが可能な電源ユニットには前面パネルからアクセスできます。

- ホットスワップ対応ファン トレイ 8 個:各トレイに 2 個ずつファンがあります。

- ファブリック エクステンダ スロット 2 個:背面パネルから設置、交換が可能です。

- ブレード サーバ スロット 8 個:前面パネルから設置、交換が可能です。

ブレード サーバ シャーシの中は、取り外し可能な仕切板を使用して柔軟にブレード サーバ シャーシ内を区分けできます。シャーシは次の 2 種類のブレード サーバ フォーム ファクタに対応します。

- ハーフ幅ブレード サーバ:電源への接続と、各ファブリック エクステンダ スロットに 1 本ずつ、計 2 本の10GBASE-KR 接続を使用できます。

- フル幅ブレード サーバ:電源への接続と、各ファブリック エクステンダに対して 2 本ずつ、計 4 本の接続を使用できます。

図 7 Cisco UCS 5108 シリーズ ブレード サーバ シャーシは 2 種類のブレード フォーム ファクタをサポートする

将来のために設計されたブレード シャーシ

このブレード サーバ シャーシは、現時点で最も高性能な x86 アーキテクチャ プロセッサを装備したブレード サーバをサポートできるように作られています。今後、さらに性能の高いブレード サーバやネットワーク テクノロジーもサポートできるように、次のような機能が設計に組み込まれています。

- 4 個の N+1 および N+N 2500 W グリッド冗長電源:効率 92% で動作するように設計されており、低消費電力で高効率を実現します。電源は余裕を持たせた設計となっており、プロセッサあたりの消費電力が最大130 Wのブレード サーバが将来出てきたとしても、それをサポートすることが可能です。

- シャーシのつくりがシンプルになった結果、ミッドプレーンの 63% が開放されています。空気は前面から背面まで直線上を通過するので、ホット スポットや効率低下の原因であるデッドゾーンや気流の乱れが減少します。この設計は、熱放散量の大きい将来のブレード サーバの冷却に必要なエアフローもサポートします。

- ミッドプレーンは将来のニーズの増大を考慮して設計されており、リンクあたりの帯域幅は最大 40 Gbps をサポートします。

Cisco UCS B シリーズ ブレード サーバ

x86 アーキテクチャがエンタープライズ データセンターにおける事実上の標準となっているのは、広く普及しており、コストが低く、対応するソフトウェアも多いからです。Microsoft Windows、Linux、種々のUNIX オペレーティング システム、および仮想化ソフトウェア(VMware ESX Server など)といったソフトウェアはいずれも、x86 アーキテクチャのサーバ上で動作します。Cisco UCS B シリーズ ブレード サーバは、互換性、パフォーマンス、省エネルギー、大容量メモリ、管理性、ユニファイド I/O 接続に関して、次のように設計されています。

- 相互運用性:Cisco UCS B シリーズ ブレード サーバの設計の中心となっているのは、2 個のマルチコア Intel Xeon 5500 番台プロセッサと DDR3 メモリ、および I/O ブリッジです。ブレード サーバの前面パネルからは、ビデオ、2 つの USB、およびコンソール接続に直接アクセスできます。

- パフォーマンス:シスコのブレード サーバに採用されている Intel の次世代サーバ プロセッサ、Intel Xeon 5500 番台は、インテリジェントなパフォーマンス増減、エネルギー効率の自動化、および仮想化に対する柔軟な対応が特長です。Intel Turbo Boost Technology は、プロセッサ周波数を上げると共にハイパースレッディングを使用することで、プロセッシング能力を自動的に引き上げるテクノロジーです。ワークロードが増大したときは、この方法で、温度条件が許す限りパフォーマンスを高めることができます。仮想環境のサポートについても Intel Virtualization Technology は非常に優れており、たとえば仮想マシンと物理 I/O デバイスとの直接接続をハードウェアでサポートします。

- エネルギー効率:ワークロードは時間と共に変動するものがほとんどです。突然ワークロードが増大することもあれば、日、週、あるいは月のサイクルでワークロードを予測できることもあります。Intel Intelligent Power Technology は、CPU 利用率を監視して自動的にエネルギー消費量を抑えるテクノロジーです。リアルタイムのワークロード特性に応じて、プロセッサコアを低電力状態に移行させます。

- 大容量メモリのサポート:新しい世代のプロセッサが登場するたびに、アプリケーションが利用できるパワーも大きくなりますが、CPU パフォーマンスとのバランスを取るためにメモリ容量も拡張しなければなりません。仮想化が広く利用されるようになると、メモリ所要量はさらに増大します。仮想化環境では、複数の OS インスタンスを同一サーバ上で実行することが必要になるからです。シスコ ブレード サーバにはシスコ拡張メモリ テクノロジーが採用されており、ブレードあたり最大 384 GB までサポート可能です。

- 管理性:Cisco Unified Computing System は、1 つの緊密に結合されたシステムとして管理されます。ブレードサーバの設定と管理は Cisco UCS Manager によって行われます。つまり、ブレード ファームウェア、BIOS 設定、および RAID コントローラ設定のアクセスとアップデートを、親の Cisco UCS 6100 シリーズ ファブリック インターコネクトから実行できます。環境パラメータも Cisco UCS Manager によって監視されるので、管理ポイントの数が減少します。

- ユニファイド I/O:Cisco UCS B シリーズ ブレード サーバは、最大 2 つのネットワーク アダプタをサポートします。このような設計の結果、LAN と SAN の両方のインフラストラクチャをサーバ/シャーシ/ラックレベルで維持する必要がなくなるので、アダプタ、ケーブル、およびアクセス レイヤ スイッチの数を半分にまで減らすことが可能になりました。管理のオーバーヘッド、および電力供給と冷却の所要量が低下するので、資本支出と運用支出の削減につながります。

2 種類のブレード サーバ

Cisco Unified Computing System のブレード サーバ製品は次の 2 種類があります(図 8)。

- Cisco UCS B200 M1 ブレード サーバは、ハーフ幅の デュアル ソケット ブレード サーバです。Intel Xeon 5500 番台 プロセッサ 2 個を使用し、DDR3 メモリを最大 96 GB、ホットスワップ対応 SFF(Small Form Factor)シリアル接続 SCSI(SAS)ディスク ドライブ 2 個(オプション)、メザニン コネクタ 1 個(合計最大 20 Gbpsの I/O スループット)を備えています。 シンプルさ、パフォーマンス、および集積率のバランスをよく兼ね備えたこのサーバは、通常稼働レベルの仮想化や、その他のデータセンターにおける一般的なワークロードに適しています。

- Cisco UCS B250 M1 拡張メモリ ブレード サーバは、シスコの拡張メモリ テクノロジーを採用したフル幅の デュアル ソケット ブレード サーバです。Intel Xeon 5500 シリーズ プロセッサ 2 個、DDR3 メモリを最大 384 GB、SFF SAS ディスク ドライブ 2 個(オプション)、およびメザニンコネクタ 2 個(合計最大 40 Gbpsの I/O スループット)をサポートします。パフォーマンスとキャパシティを高めたこのサーバは、大容量のメモリと高いスループットを必要とする仮想化や大量データセットを扱うワークロードにも対応します。

図 8 Cisco UCS B250 M1 ブレード サーバと Cisco UCS B200 M1 拡張メモリ ブレード サーバ

Cisco 拡張メモリ テクノロジー

メモリ コントローラを内蔵した近年の CPU では、CPU あたりのサポート可能メモリ チャネルおよびスロットの数が限られています。仮想化ソフトウェアを実行するには複数の OS インスタンスが稼働している必要があるため、大容量のメモリが必要になり、加えて CPU のパフォーマンスがメモリのパフォーマンスを上回っていることから、メモリがボトルネックとなっています。従来の仮想化されていないアプリケーションでさえも、大容量のメインメモリを必要とします。たとえば、データベース管理システムはデータベース テーブルをメモリ内にキャッシュすることによりパフォーマンスが大幅に向上します。また、モデリングやシミュレーションのソフトウェアは、Problem State を多くメモリ内にキャッシュするほどパフォーマンスが向上します。

メモリ容量を拡大するために、多くの企業では大型かつ高価な 4 ソケット サーバへのアップグレードを強いられています。4 ソケット構成をサポートする CPU は一般に高価で、消費電力も大きく、ライセンスコストも高額です。

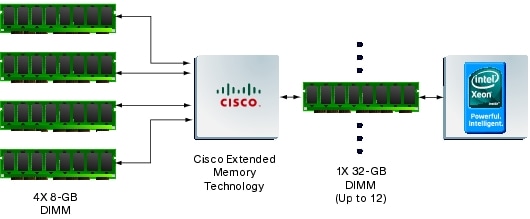

Cisco 拡張メモリ テクノロジーは、“CPU ベースのメモリ コントローラ”の能力を拡張するテクノロジーです。このテクノロジーによってメインメモリの構造が論理的に変更されますが、標準の DDR3 メモリを引き続き使用することができます。このテクノロジーが採用されている拡張メモリ ブレード サーバでは、4 個の DIMM スロットが、CPU のメモリ コントローラからは 1 つの DIMM(容量は4 倍)に見えます。(図 9)。たとえば、標準の DDR3 DIMM を使用する場合は、4 つの 8 GB DIMM が 1 つの 32 GB DIMM として認識されます。この特許取得済みテクノロジーによって、デュアルソケット サーバの CPU からアクセスできる業界標準メモリの大きさが拡大します。

- 大容量のメモリを必要とする環境では、データセンターの CPU パワー対メモリの比率が改善されます。メモリ容量を増やすためだけに、高価で大量のエネルギーを消費する 4 ソケット サーバに移行する必要はありません。メイン メモリの容量が拡大すれば、CPU 使用率が向上します。ページインやその他 I/O オペレーションのためのディスク待機が減るからです。その結果、資本投資の有効活用が可能になり、エネルギーも節約できます。

- 相当量のメイン メモリを必要とするけれども、384 GB までは必要ない場合は、小容量の DIMM を 8GB DIMM の代わりに使用すれば、コストを節約できます。1 GB DIMM 8 個は一般に、8 GB DIMM 1 個よりも安価です。

図 9 Cisco UCS 拡張メモリ テクノロジーが採用されている環境では、4 個の物理 DIMM が CPU からは 1 個の大容量論理 DIMM として認識される

Cisco UCS ネットワーク アダプタ

従来のラックマウント型やブレード型のサーバ構成のうち、I/O の構成は基本的に変更することが難しいです。I/O 構成を変更するには一般に、シャーシの電源をオフにしてから別の I/O デバイスをインストールし、この I/O デバイスにアクセスするオペレーティング システムやハイパーバイザの再設定を行います。これらはすべて手作業で行われ、その間アプリケーションは停止します。このダウンタイムが終わった後も、MAC アドレスや WWN の変化が原因でライセンスの問題が発生することがあります。

シスコ ユニファイド コンピューティング システムでは、このような問題の解決と、動的で仮想化された環境の実現のために、次の 3 つのテクノロジーが採用されています。

- ユニファイド ファブリックでは「配線は一度だけ(wire-once)」配線モデルがサポートされているため、サーバの I/O 特性が変化しても、システムの配線を変更する必要はありません。ユニファイド ファブリックによってコストが削減されるのは、LAN、SAN、およびハイパフォーマンスコンピューティング ネットワークごとに別のアダプタ、別のケーブル、および別のスイッチを用意する必要がないからです。

- Cisco UCS Manager では、サービス プロファイルを使用してサーバの I/O 特性を指定するという方法が採用されているので、物理環境または仮想環境の移動やホスト変更に必要な作業は、サービス プロファイルを新しいブレード サーバに適用して、新しいサーバを再起動することだけです。サービス プロファイル テンプレートを利用すれば、I/O 特性が同一でそれぞれ ID が異なる多数のサーバをプロビジョニングすることができるので、需要に応じたシステムの規模拡大が可能です。

- 3 種類のネットワーク アダプタが用意されており、ビジネスの要件に合わせたサーバの I/O 構成が可能です。

- 仮想化のために最適化された仮想インターフェイス カード:Cisco Unified Computing System の能力をフルに発揮させるために、ホスト オペレーティング システムまたはハイパーバイザに対して最大 128 個の NIC および HBA の任意の組み合わせをオンデマンドでプロビジョニングできます(インターフェイスのうち 8 個はシステムでの使用のために予約されています)。タイプ(イーサネットまたはファイバ チャネル)とID:アイデンティティ(MAC アドレスと WWN)の両方が、サービスプロファイルを通して動的にプロビジョニングされます。

- 相互運用性を高めるように最適化されたConverged Network Adaptor(CNA):OS からは 1 対のイーサネット NIC および 1 対のファイバ チャネル HBA として認識される。Emulex 製や QLogic 製の HBA を使用する標準的なデータセンターでの使用方法を引き続き使用することが可能です。

- 効率とパフォーマンスを高めるように最適化されたネットワーク アダプタ:10 ギガビット イーサネット NIC 2 個として機能するので、NAS や iSCSI のストレージを使用する環境に最適です。

Cisco UCS ネットワーク アダプタは、Cisco UCS B シリーズ ブレード サーバに装着可能なメザニン カード フォーム ファクタとして設計されています。アダプタからミッドプレーンへは 2 本のユニファイド ファブリック接続があり、この接続はさらに 2 個のファブリック エクステンダ スロットのそれぞれに接続します。したがって、ハーフ幅のブレード サーバでも冗長ネットワーク ファブリックへの接続が可能になるので、帯域幅の使用率とアベイラビリティが向上します。

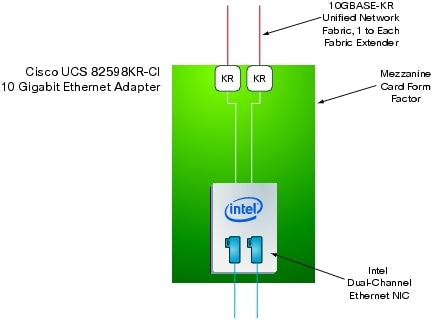

効率に優れたハイパフォーマンス イーサネットのための Cisco UCS 82598KR-CI 10 ギガビット イーサネット アダプタ

Cisco UCS 82598KR-CI 10 ギガビット イーサネット アダプタは、効率に優れたハイパフォーマンス イーサネット接続のための製品です。このアダプタには Intel 製シリコンが採用されており、PCI(Peripheral Component Interconnect)デバイス ツリー上では 2 個の 10 ギガビット イーサネット NIC として認識されます。NIC はそれぞれ、シャーシ上の 2 つのファブリック エクステンダ スロットの 1 つに接続されます(図 10)。Cisco Unified Computing System 用の他のメザニンカードと同様に、このカードも Cisco DCE の機能をサポートしているので、複数の独立したネットワーク トラフィック ストリームを同じリンク上で伝送することが可能です。アダプタの MAC アドレスは Cisco UCS Manager によってジャストインタイムに設定されます。このアダプタが適しているのは、次のような環境です。

- ネットワークへの負荷が高いワークロード。たとえば、Web サーバでは、コンテンツへのアクセスはすべて NFS(Network File System)または iSCSI のプロトコルを介して行われます。

- 効率とパフォーマンスの高さが重要である環境。

図 10 Cisco UCS 82598KR-CI 10 ギガビット イーサネット アダプタは、サーバ OS からは 2 個の 10 ギガビット イーサネット NIC として認識される

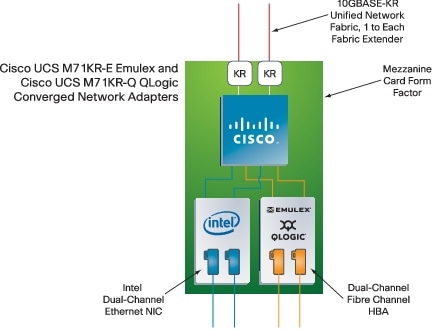

相互運用性のための Cisco UCS M71KR-E Emulex/UCS M71KR-Q QLogic 統合型ネットワーク アダプタ

Emulex 製または QLogic 製のファイバ チャネル HBA を使用しているデータセンターにおいて、既存の運用方法を維持する必要がある場合は、Converged Network Adaptor(CNA)である Cisco UCS M71KR-E Emulex/Cisco UCS M71KR-Q QLogic を使用すれば、Emulex および QLogic のインターフェイスへの対応が可能です。これらの CNA には Intel 製シリコンも採用されており、PCI デバイスツリー上では 2 つの 10 ギガビット イーサネット NIC として、また 2 つの Emulex 製または QLogic 製 HBA として認識されます。オペレーティングシステムからは 2 つの NIC と 2 つの HBA として認識され、ユニファイド ファブリックの存在はまったく意識されません。シスコ製の ASIC(特定用途向け集積回路)によってイーサネットのストリームとファイバ チャネルのストリーム トラフィックは多重化され、2 つのミッドプレーン接続のうちの 1 つの上を通ってファブリック エクステンダ スロットまで伝送されます(図 11)。これらの CNA が最も適しているのは、次のような場合です。

- Emulex 製または QLogic 製のドライバを引き続き Cisco Unified Computing System でも使用する場合

- 新しいファイバ チャネル ハードウェアの「Qualification」のために時間を費やしたくない場合(標準の HBA シリコンを使用していれば、HBA ベンダー提供のドライバをそのまま使用できます)

- 従来の物理環境と仮想化環境の両方

図 11 Cisco UCS M71KR-E Emulex/UCS M71KR-Q QLogic 統合型ネットワーク アダプタにはシスコの ASIC テクノロジーが採用されており、イーサネットおよびファイバ チャネルのトラフィックが多重化されて 2 本のユニファイド ファブリック接続で伝送される

仮想化のための Cisco UCS M81KR 仮想インターフェイス カード

Cisco Unified Computing System の効果をフルに発揮させるには、Cisco UCS M81KR 仮想インターフェイス カードをブレード サーバで使用します。このカードは PCI Express(PCIe)標準に準拠しており、PCI デバイス ツリー上では最大 128 個の仮想インターフェイスとして認識されます(図 12)。128 個の仮想インターフェイスのうち 8 個はシステムでの使用のために予約されています。

図 12 Cisco UCS M81KR 仮想インターフェイス カードは、PCI デバイス ツリー上では 128 個のプログラミング可能インターフェイスとして認識される

他のネットワーク アダプタでは各物理 NIC および HBA の ID だけが Cisco UCS Manager を通してプログラミング可能であるのに対し、Cisco UCS M81KR 仮想インターフェイス カードでは、仮想 NIC ごとに、タイプと ID の両方をプログラミングすることができます。仮想的なイーサネット NIC とファイバ チャネル HBA を自由な組み合わせでカード上に作成し、作成したそれぞれの仮想NIC/HBA に対して MAC アドレスと WWN を割り当てるようプログラミングできます。これによりサーバの I/O アーキテクチャを、動的にプロビジョニング、プログラミングすることが可能にになります。

このカードとサービス プロファイルとの組み合わせによって、非常に強力かつ柔軟な「配線は一度だけ(wire-once)」の環境がサポートされるようになります。サービスプロファイルをサーバに適用すると、仮想 NIC が定義されます。たとえば、Cisco UCS M81KR 仮想インターフェイス カードに、あるサービス プロファイルを適用したときは 4 個のイーサネット NIC を持つカードとしてネットワーク接続ストレージ(NAS)に接続するように構成し、別のサービス プロファイルを適用したときは 4 個のファイバチャネル HBA と 6 個のイーサネット NIC を持つ FCoE カードとして構成することもできます。

プログラミング可能という特性を持つこの仮想インターフェイス カードが適しているのは、次のような場合です。

- サービス プロバイダーやエンタープライズ データセンターにおいて、非常に柔軟にサーバ リソースの展開をする必要がある場合

- 強力な投資保護を必要とする場合。1 つのアダプタでイーサネットとファイバ チャネルの両方の接続の要求が満たされ、1 つの I/O インターフェイスをデータセンター内の多数のシステムに展開することが可能になります。

- 固定サーバ環境において、アプリケーションの処理能力を上げたり、移動したりするために再度サーバを立ち上げ直す必要がある場合。

- 次のような仮想環境

- 仮想 NIC それぞれが、仮想マシンからは 1 つの物理 NIC として認識されるようにする(仮想スイッチのオーバーヘッドを排除するため

- 仮想マシン単位のネットワーク ポリシーの適用が必要である(セキュリティや QoS など)

- パススルー スイッチングを通して I/O パフォーマンスを高めることが重要である

仮想環境における高い柔軟性

最大 128 個の仮想デバイスをプログラミング可能ですが、これは仮想環境においてハイパーバイザが物理デバイスを直接仮想マシンに割り当てるのに十分な数です。究極的には、仮想マシンといえども仮想マシンそれぞれが専用の物理デバイスをもつことが望ましい状態です。このモデルでは、ハードウェアネットワーク スイッチをエミュレートするためにソフトウェア スイッチをもたなくて良いので、CPU サイクルを使用する必要がなくなります。また、それぞれの仮想マシンの I/O オペレーションを行うたびにハイパーバイザ介入によるオーバーヘッドが発生することはなくなります。仮想化ソフトウェアと Cisco UC S6100 シリーズファブリックインターコネクトの連携によって、サーバおよびシャーシ間での仮想マシンの移動が可能になり、移動先のサーバ上でデバイスとネットワークのプロファイルが動的に構成されます。

Cisco UCS M81KR 仮想インターフェイス カードによって生成される仮想デバイスを仮想環境で使用するには、3 通りの方法があります。仮想マシンと仮想デバイスとのインターフェイスに関するいくつかのアプローチを図 13 に示します。後のアプローチほど柔軟性が高く、オーバーヘッドが低くなるので、リソースの利用率と ROI の向上に役立ちます。

- 従来型のアプローチ(図の VM 1):物理デバイスを仮想マシン NIC(VMNIC)として認識させ、仮想マシンの中の仮想デバイスを仮想 NIC(vNIC)として認識させます。この 2 つを仮想スイッチ(vSwitch)で接続します。このアプローチにはオーバーヘッドがあり、管理が複雑です。ハイパーバイザ内にネットワークスイッチを実装するのは本質的に非効率的です。ただし、Cisco UCS M81KR 仮想インターフェイス カードでは従来の構成もサポートしているので、このような仮想ネットワークモデルを引き続き利用することもできます。

このシステムでは、従来のアプローチに加えて、Cisco Nexus 1000V シリーズ 仮想マシン アクセス スイッチについてもサポートしています。Cisco Nexus 1000V シリーズは、VMware ESX Server 環境のために実装されたインテリジェントなソフトウェア スイッチです。VMware ESX Server の内部で実行される Cisco Nexus 1000V シリーズによって、VN-Link サーバ仮想化テクノロジーがサポートされるので、以下のことが可能になります。

- 仮想マシンごとのネットワーク ポリシー:仮想マシン ネットワークをプロビジョニングするためのスケーラブルなメカニズ

- 仮想マシンと一緒に移動するセキュリティ/ネットワーク ポリシー:仮想マシンがサーバ間を移動するときに、仮想マシンと一緒にポリシーが移動します。

- サーバ仮想化およびネットワークの管理者のためのわかりやすく、サービス断を作らない運用モデル。Cisco CLI、SNMP(Simple Network Management Protocol)、および XML API によって VMware VirtualCenter と完全に統合されます。

- 高いスケーラビリティ。サーバあたりの仮想インターフェイスの最大数は 256 です。

- パススルー スイッチング アプローチ(図の VM 2):プログラミング可能デバイスが多数存在することを利用して、vNIC と VMNIC とを直接接続します。このアプローチは、ソフトウェアのスイッチを実装しないため、その分オーバーヘッドが少なくなり管理も複雑ではなくなります。このアプローチでも、各 I/Oオペレーション時にハイパーバイザの介入はある程度必要です。

図 13 シスコ ユニファイド コンピューティング システムでのエンドツーエンド仮想化の方法

Cisco UCS Manager と VMware Infrastructure ソフトウェアが連携して動作するので、このような構成を作るのは非常に簡単です。管理者が Cisco UCS Manager を使用してポート プロファイルを作成すると、Cisco UCS Manager によってこのプロファイルが VMware VirtualCenter にエクスポートされます。VMware のコンテキストでは、このポート プロファイルはポート グループとして認識されます。仮想マシンがハイパーバイザに展開されると、UCS システムはポート グループをポート プロファイルとして認識し、プロファイルの定義に合わせて vNIC を構成します。

-

ハイパーバイザ バイパス アプローチ(図の VM 3):物理デバイスを直接仮想マシンにリンクします。このテクノロジーが仮想化ベンダーによって実装されるようになってくると、仮想マシンから物理デバイスに直接アクセスすることが可能になるため、ハイパーバイザ全体がバイパスされて、CPU オーバーヘッドが低下します。Cisco UCS M81KR 仮想インターフェイス カードによってプロビジョニングされる多数のデバイスと、Intel Virtualization Technology for Directed I/O を組み合わせることで、物理サーバ上で、各仮想マシンに 1 つ以上の NIC を割り当てることが可能になります。これは、将来実現される構成です。

仮想マシンのマイグレーションに伴う仮想リンクの移動

仮想マシンが物理サーバ間を移動する際のネットワーク レイヤの設定を容易にするために、Cisco UCS 6100 シリーズ ファブリック インターコネクトには VN-Link の機能が組み込まれています。ネットワーク リンクが仮想化され、仮想リンクを物理リンクに多対 1 で柔軟にマッピングすることができます。

物理サーバ間で仮想マシンが移動すると、VM 3 で説明したようなプロセスがハイパーバイザによって起動されます。このプロセスによって、移動先サーバ上の仮想マシンに必要なデバイスプロファイルが設定されます。サーバからサーバへのマイグレーションが完了した後も、仮想マシンは「同じデバイス」に接続されたままの状態であり、ID も変わりません。

仮想デバイスからのネットワーク リンクは物理スイッチ内の仮想ポートに接続されます(図 13 の青い点線)。仮想ポートの特性は物理ポートと同じですが、物理ポートへバインディングされるのは一時的なこと(ephemeral)であり、対応する仮想マシンが物理スイッチ ポート間で移動するとまた違う物理ポートとバインディングし直されます。また、仮想ポートのバインディング先がある物理ポートから別のポートへと移動すると、トラフィックフロー、ACL、QoS、帯域幅などの特性を管理する重要なネットワーク プロファイルもすべて自動的に移動します。

まとめ

次世代のデータセンター プラットフォームである Cisco® Unified Computing System は、総所有コスト(TCO)の削減とビジネス俊敏性の向上を目的として、サーバ、ネットワーク、ストレージ アクセス、および仮想化を緊密に統合して 1 つの包括的なシステムを作ります。このシステムでは、低遅延でロスレスの 10 Gbps ユニファイド ファブリックにエンタープライズ クラスの x86 アーキテクチャ サーバが統合されます。このシステムは複数のシャーシを統合し、拡張できるモジュラ型のプラットフォームであり、すべてのリソースを 1 つの統合された管理ドメインとして扱うことができます。

システムのアーキテクチャは、物理マシンと仮想マシンの両方のポータビリティを高めるように設計されており、サーバの ID、LAN と SAN のアドレッシング、I/O 構成、ファームウェア、およびネットワーク接続のプロファイルに従って、サーバおよびネットワークのリソースが動的にプロビジョニングされ、統合されます。ハードウェアの属性を定義するサービスプロファイルに従ってシステムを展開すると、動的でステートレスな環境が作られ、ビジネス要件の急激な変化にも対応できるようになります。新しいコンピューティングリソースのジャストインタイムでの展開や、従来型あるいは仮想化されたワークロードの移動が容易に、確実に行われるようになります。システムは、アベイラビリティ、セキュリティ、パフォーマンス、およびビジネス俊敏性を向上させる統合型設計となっており、次のような効果があります。

- IT スタッフの生産性およびビジネスの俊敏性の向上(仮想環境および非仮想環境の両方に対してジャストインタイム方式のプロビジョニングとモビリティがサポートされるため)

- プラットフォーム/サイト/組織レベルでの TCO の削減(インフラストラクチャが集約されるため)

- システムが緊密に統合され、全体が 1 つのシステムとして管理、メンテナンス、テストされる

- スケーラビリティ(最大 320 台の独立サーバと数千の仮想マシンに対応すると共に、要求に合わせて I/O 帯域幅を拡張することが可能)

- オープンな業界標準(業界をリードするパートナー企業のエコシステムによってサポートされる)

- 将来のデータセンターにおける計算能力、メモリ容量、および I/O 帯域幅の要件を満たすように規模を拡張できるシステム(新しいプロセッサや 40 ギガビット イーサネットなどの標準に合わせて成長可能)

関連情報

Cisco Unified Computing System の詳細については、http://www.cisco.com/jp/go/unifiedcomputing/ を参照してください。