MOP de Correção de Incompatibilidade de UUID Ultra-M - vEPC

Opções de download

Linguagem imparcial

O conjunto de documentação deste produto faz o possível para usar uma linguagem imparcial. Para os fins deste conjunto de documentação, a imparcialidade é definida como uma linguagem que não implica em discriminação baseada em idade, deficiência, gênero, identidade racial, identidade étnica, orientação sexual, status socioeconômico e interseccionalidade. Pode haver exceções na documentação devido à linguagem codificada nas interfaces de usuário do software do produto, linguagem usada com base na documentação de RFP ou linguagem usada por um produto de terceiros referenciado. Saiba mais sobre como a Cisco está usando a linguagem inclusiva.

Sobre esta tradução

A Cisco traduziu este documento com a ajuda de tecnologias de tradução automática e humana para oferecer conteúdo de suporte aos seus usuários no seu próprio idioma, independentemente da localização. Observe que mesmo a melhor tradução automática não será tão precisa quanto as realizadas por um tradutor profissional. A Cisco Systems, Inc. não se responsabiliza pela precisão destas traduções e recomenda que o documento original em inglês (link fornecido) seja sempre consultado.

Contents

Introduction

Este documento descreve as etapas necessárias para a correção da incompatibilidade do Universally Unique IDentifier (UUID) entre o Element Manager (EM) e as Funções de Rede Virtual (VNFs) do StarOS em uma configuração Ultra-M que hospeda VNFs do StarOS.

Informações de Apoio

A Ultra-M é uma solução de núcleo de pacotes móveis virtualizados, validada e predefinida, projetada para simplificar a implantação de VNFs.

A solução Ultra-M consiste nos seguintes tipos de máquina virtual (VM):

- TI automática

- Implantação automática

- Serviços de automação ultra-avançada (UAS)

- Gerenciador de Elementos (EM)

- Controlador de serviços elástico (ESC)

- Função de controle (CF)

- Função de sessão (SF)

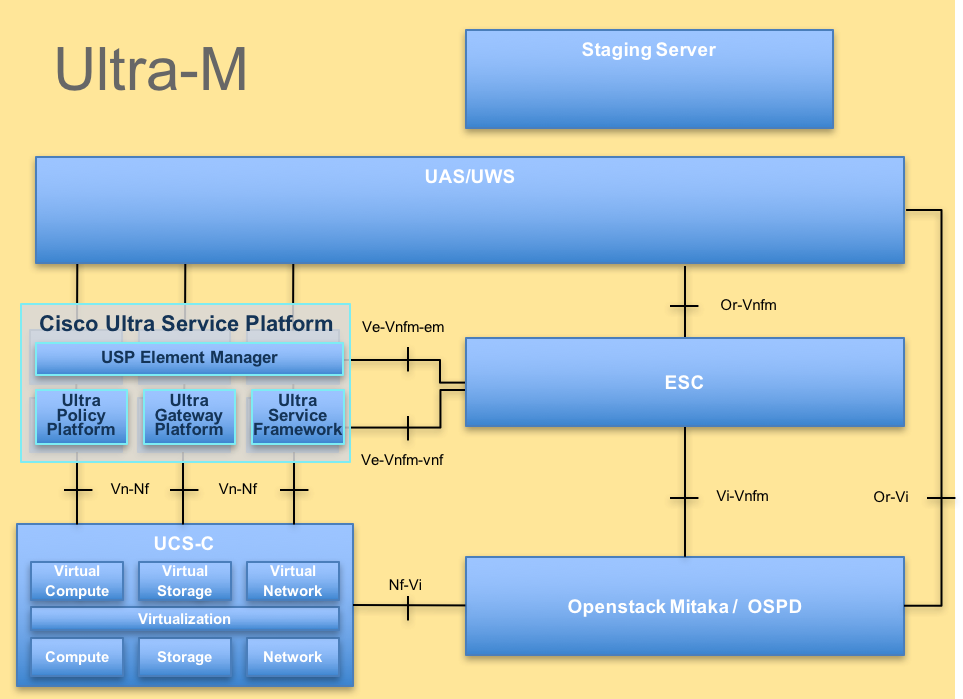

A arquitetura avançada do Ultra-M e os componentes envolvidos são descritos nesta imagem:

Arquitetura UltraM

Arquitetura UltraM

Note: A versão Ultra M 5.1.x é considerada para definir os procedimentos neste documento.

Abreviaturas

| VNF | Função de rede virtual |

| CF | Função de controle |

| SF | Função de serviço |

| ESC | Controlador de serviço elástico |

| MOP | Método de Procedimento |

| OSD | Discos de armazenamento de objetos |

| HDD | Unidade de disco rígido |

| SSD | Unidade de estado sólido |

| VIM | Gerente de infraestrutura virtual |

| VM | Máquina virtual |

| EM | Gerenciador de Elementos |

| UAS | Ultra Automation Services |

| UUID | Identificador Universalmente Exclusivo |

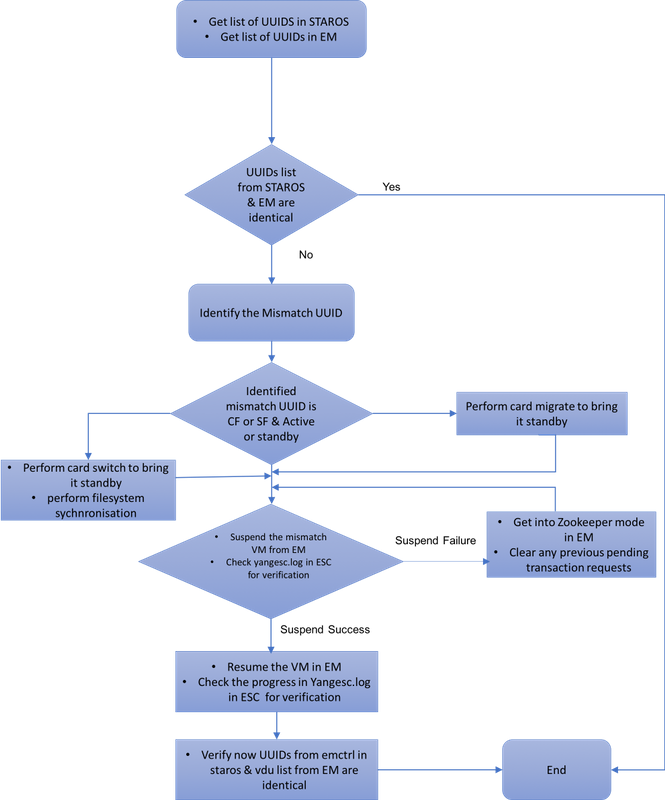

Fluxo de trabalho do ME

ID da implantação, UUID e sua relação no EM

Há três componentes principais - ESC, EM e StarOS VNF em uma configuração Ultra-M. EM age como proxy para as consultas ConfD e envia uma resposta em nome do VNF do StarOS. Cada um desses componentes é executado como uma VM e mantém as informações. Quando os dados/estado das VMs nesses três nós não correspondem, há um alarme de incompatibilidade de UUID no EM. O ESC faz uma chamada YANG para o EM para obter dados de Conferência. O ConfD tem informações de configuração e dados/estado operacional. O EM traduz as consultas que vêm do ESC e envia respostas conforme necessário.

Pré-verificações

Em EM

Verifique se EM está no modo HA e se mostra como mestre/escravo:

ubuntu@vnfd2deploymentem-1:~$ ncs --status | more

vsn: 4.1.1

SMP support: yes, using 2 threads

Using epoll: yes

available modules: backplane,netconf,cdb,cli,snmp,webui

running modules: backplane,netconf,cdb,cli,webui

status: started

cluster status:

mode: master

node id: 6-1528831279

connected slaves: 1

Faça login no EM e verifique se o cluster EM está íntegro:

ubuntu@vnfd2deploymentem-1:~$ ncs_cli -u admin -C

admin@scm# show ems

EM VNFM

ID SLA SCM PROXY

---------------------

5 up up up

9 up up up

ubuntu@vnfd2deploymentem-1:~$ ncs_cli -u admin -C

admin@scm# show ncs-state ha

ncs-state ha mode master

ncs-state ha node-id 9-1518035669

ncs-state ha connected-slave [ 5-1518043097 ]

Em ESC

Em ESC, valide se a conexão netconf com EM está estabelecida:

[admin@vnfm2-esc-0 esc-cli]$ netstat -an | grep 830

tcp 0 0 0.0.0.0:830 0.0.0.0:* LISTEN

tcp 0 0 172.18.181.6:830 172.18.181.11:39266 ESTABLISHED

tcp 0 0 172.18.181.6:830 172.18.181.11:39267 ESTABLISHED

tcp 0 0 :::830 :::* LISTEN

[admin@vnfm2-esc-0 esc-cli]$

No ESC, verifique se todas as VMs estão em estado ativo e se o serviço está ativo:

[admin@vnfm2-esc-0 esc-cli]$ ./esc_nc_cli get esc_datamodel | egrep "<vm_name>|<state>"

<state>IMAGE_ACTIVE_STATE</state>

<state>IMAGE_ACTIVE_STATE</state>

<state>IMAGE_ACTIVE_STATE</state>

<state>FLAVOR_ACTIVE_STATE</state>

<state>FLAVOR_ACTIVE_STATE</state>

<state>FLAVOR_ACTIVE_STATE</state>

<state>SERVICE_ACTIVE_STATE</state>

<vm_name>vnfd2-deployment_c1_0_13d5f181-0bd3-43e4-be2d-ada02636d870</vm_name>

<state>VM_ALIVE_STATE</state>

<vm_name>vnfd2-deployment_c4_0_9dd6e15b-8f72-43e7-94c0-924191d99555</vm_name>

<state>VM_ALIVE_STATE</state>

<vm_name>vnfd2-deployment_s2_0_b2cbf15a-3107-45c7-8edf-1afc5b787132</vm_name>

<state>VM_ALIVE_STATE</state>

<vm_name>vnfd2-deployment_s3_0_882cf1ed-fe7a-47a7-b833-dd3e284b3038</vm_name>

<state>VM_ALIVE_STATE</state>

<vm_name>vnfd2-deployment_s5_0_672bbb00-34f2-46e7-a756-52907e1d3b3d</vm_name>

<state>VM_ALIVE_STATE</state>

<vm_name>vnfd2-deployment_s6_0_6f30be77-6b9f-4da8-9577-e39c18f16dfb</vm_name>

<state>VM_ALIVE_STATE</state>

<state>SERVICE_ACTIVE_STATE</state>

<vm_name>vnfd2-deployment_vnfd2-_0_02d1510d-53dd-4a14-9e21-b3b367fef5b8</vm_name>

<state>VM_ALIVE_STATE</state>

<vm_name>vnfd2-deployment_vnfd2-_0_f17989e3-302a-4681-be46-f2ebf62b252a</vm_name>

<state>VM_ALIVE_STATE</state>

<vm_name>vnfd2-deployment_vnfd2-_0_f63241f3-2516-4fc4-92f3-06e45054dba0</vm_name>

<state>VM_ALIVE_STATE</state>

[admin@vnfm2-esc-0 esc-cli]$

No StarOS VNF

Verifique se o vnfm-proxy-agent está on-line:

[local]POD1-VNF2-PGW# show vnfm-proxy-agent status

Thursday June 21 07:25:02 UTC 2018

VNFM Proxy Agent Status:

State : online

Connected to : 172.18.180.3:2181

Bind Address : 172.18.180.13:38233

VNFM Proxy address count: 3

Verifique o status emctrl show alive:

[local]POD1-VNF2-PGW# show emctrl status

Thursday June 21 07:25:09 UTC 2018

emctrl status:

emctrl in state: ALIVE

Identificar a incompatibilidade de UUID

O UUID deve ser comparado entre o VNF do StarOS e o EM para identificar a incompatibilidade. Estes procedimentos listam as etapas a serem realizadas no StarOS VNF e EM para obter os UUIDs dos respectivos nós.

No StarOS, você pode obter o UUID da lista show emctrl vdu ou da saída show card hardware.

[local]POD1-VNF2-PGW# show emctrl vdu list

Thursday June 21 07:24:28 UTC 2018

Showing emctrl vdu

card[01]: name[CFC_01 ] uuid[33C779D2-E271-47AF-8AD5-6A982C79BA62]

card[02]: name[CFC_02 ] uuid[E75AE5EE-2236-4FFD-A0D4-054EC246D506]

card[03]: name[SFC_03 ] uuid[E1A6762D-4E84-4A86-A1B1-84772B3368DC]

card[04]: name[SFC_04 ] uuid[B283D43C-6E0C-42E8-87D4-A3AF15A61A83]

card[05]: name[SFC_05 ] uuid[CF0C63DF-D041-42E1-B541-6B15B0BF2F3E]

card[06]: name[SFC_06 ] uuid[65344D53-DE09-4B0B-89A6-85D5CFDB3A55]

Incomplete command

[local]POD1-VNF2-PGW# show card hardware | grep -i uuid

Thursday June 21 07:24:46 UTC 2018

UUID/Serial Number : 33C779D2-E271-47AF-8AD5-6A982C79BA62

UUID/Serial Number : E75AE5EE-2236-4FFD-A0D4-054EC246D506

UUID/Serial Number : E1A6762D-4E84-4A86-A1B1-84772B3368DC

UUID/Serial Number : B283D43C-6E0C-42E8-87D4-A3AF15A61A83

UUID/Serial Number : CF0C63DF-D041-42E1-B541-6B15B0BF2F3E

UUID/Serial Number : 65344D53-DE09-4B0B-89A6-85D5CFDB3A55

Liste os UUIDs no EM:

ubuntu@vnfd2deploymentem-1:~$ ncs_cli -u admin -C

admin@scm# show vdus vdu | select vnfci

CONSTITUENT MEMORY STORAGE

DEVICE DEVICE ELEMENT IS CPU UTILS USAGE

ID ID NAME GROUP GROUP INFRA INITIALIZED VIM ID UTILS BYTES BYTES

---------------------------------------------------------------------------------------------------------------------------------------------------------------------

control-function BOOT_generic_di-chasis_CF1_1 scm-cf-nc scm-cf-nc di-chasis true true 33c779d2-e271-47af-8ad5-6a982c79ba62 - - -

BOOT_generic_di-chasis_CF2_1 scm-cf-nc scm-cf-nc di-chasis true true e75ae5ee-2236-4ffd-a0d4-054ec246d506 - - -

session-function BOOT_generic_di-chasis_SF1_1 - - di-chasis true false e1a6762d-4e84-4a86-a1b1-84772b3368dc - - -

BOOT_generic_di-chasis_SF2_1 - - di-chasis true false b283d43c-6e0c-42e8-87d4-a3af15a61a83 - - -

BOOT_generic_di-chasis_SF3_1 - - di-chasis true false 828281f4-c0f4-4061-b324-26277d294b86 - - -

BOOT_generic_di-chasis_SF4_1 - - di-chasis true false 65344d53-de09-4b0b-89a6-85d5cfdb3a55 - - -

Nessa saída, você pode ver que a placa 5 tem UUID MISMATCH entre EM e StarOS:

[local]POD1-VNF2-PGW# show emctrl vdu list

Thursday June 21 07:24:28 UTC 2018

Showing emctrl vdu

.....

card[05]: name[SFC_05 ] uuid[CF0C63DF-D041-42E1-B541-6B15B0BF2F3E]

.....

admin@scm# show vdus vdu | select vnfci

CONSTITUENT MEMORY STORAGE

DEVICE DEVICE ELEMENT IS CPU UTILS USAGE

ID ID NAME GROUP GROUP INFRA INITIALIZED VIM ID UTILS BYTES BYTES

---------------------------------------------------------------------------------------------------------------------------------------------------------------------

session-function .......

BOOT_generic_di-chasis_SF3_1 - - di-chasis true false 828281f4-c0f4-4061-b324-26277d294b86 - - -

......

Note: Se várias placas tiverem uma incompatibilidade de UUID, assegure-se de mover para a outra somente depois de terminar com uma. Se você tentar várias placas ao mesmo tempo, é provável que você encontre um problema com a indexação de VM do ESC.

Recuperar o UUID

Se não houver correspondência de UUID no cartão CF , certifique-se de fazer a sincronização do sistema de arquivos:

[local]VNF2# filesystem synchronize all

Se a placa UUID não corresponder ao SF e estiver ativa, execute a migração da placa para colocá-la no estado de espera:

[local]VNF2# card migrate from 4 to 5

Se a placa UUID não corresponder ao CF e estiver ativa, execute a troca de placa para colocá-la no estado de espera:

[local]VNF2# card switch from 2 to 1

Suspenda a placa que tem a incompatibilidade de UUID do NCS CLI no EM:

ubuntu@vnfd2deploymentem-1:~$ ncs_cli -u admin -C

admin@scm# suspend-vnfci vdu session-function vnfci BOOT_generic_di-chasis_SF3_1

success true

Note: Em alguns cenários raros, a CLI suspend-vnfci do EM não inicia a atualização de serviço no ESC. Em EM, os logs (/var/log/em/vnfm-proxy/vnfm-proxy.log) mostram uma mensagem de erro que indica que o EM tem solicitações pendentes e que está ignorando a nova solicitação. Para corrigir esse problema, verifique o zookeeper do EM para ver as solicitações pendentes travadas e, em seguida, limpe-as manualmente. Consulte a última seção deste documento para executar esta ação, "Cancelando Solicitação Pendente no Zookeeper do EM (Opcional)".

Verifique em yangesc.log no ESC se a transação foi aceita e aguarde até que ela seja finalizada:

####################################################################

# ESC on vnfm2-esc-0.novalocal is in MASTER state.

####################################################################

[admin@vnfm2-esc-0 ~]$ cd /opt/cisco/esc/esc-confd/esc-cli

[admin@vnfm2-esc-0 esc-cli]$ tail -f /var/log/esc/yangesc.log

19:27:31,333 12-Jun-2018 INFO Type: SERVICE_ALIVE

19:27:31,333 12-Jun-2018 INFO Status: SUCCESS

19:27:31,333 12-Jun-2018 INFO Status Code: 200

19:27:31,333 12-Jun-2018 INFO Status Msg: Service group deployment completed successfully!

19:27:31,333 12-Jun-2018 INFO Tenant: core

19:27:31,333 12-Jun-2018 INFO Deployment ID: 9bcad337-d1f0-463c-8450-de7697b1e104

19:27:31,333 12-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

19:27:31,333 12-Jun-2018 INFO ===== SEND NOTIFICATION ENDS =====

07:29:49,510 21-Jun-2018 INFO ===== GET OPERATIONAL/INFO DATA =====

07:30:32,318 21-Jun-2018 INFO ===== GET OPERATIONAL/INFO DATA =====

07:36:25,083 21-Jun-2018 INFO ===== GET OPERATIONAL/INFO DATA =====

07:36:25,628 21-Jun-2018 INFO

07:36:25,628 21-Jun-2018 INFO ===== CONFD TRANSACTION STARTED =====

07:36:25,717 21-Jun-2018 INFO

07:36:25,717 21-Jun-2018 INFO ===== UPDATE SERVICE REQUEST RECEIVED (UNDER TENANT) =====

07:36:25,717 21-Jun-2018 INFO Tenant name: core

07:36:25,717 21-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

07:36:25,843 21-Jun-2018 INFO

07:36:25,843 21-Jun-2018 INFO ===== CONFD TRANSACTION ACCEPTED =====

07:37:04,535 21-Jun-2018 INFO

07:37:04,536 21-Jun-2018 INFO ===== SEND NOTIFICATION STARTS =====

07:37:04,536 21-Jun-2018 INFO Type: VM_UNDEPLOYED

07:37:04,536 21-Jun-2018 INFO Status: SUCCESS

07:37:04,536 21-Jun-2018 INFO Status Code: 200

07:37:04,536 21-Jun-2018 INFO Status Msg: VM Undeployed during deployment update, VM name: [vnfd2-deployment_s6_0_6f30be77-6b9f-4da8-9577-e39c18f16dfb]

07:37:04,536 21-Jun-2018 INFO Tenant: core

07:37:04,536 21-Jun-2018 INFO Deployment ID: 9bcad337-d1f0-463c-8450-de7697b1e104

07:37:04,536 21-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

07:37:04,536 21-Jun-2018 INFO VM group name: s6

07:37:04,537 21-Jun-2018 INFO User configs: 1

07:37:04,537 21-Jun-2018 INFO VM Source:

07:37:04,537 21-Jun-2018 INFO VM ID: cf0c63df-d041-42e1-b541-6b15b0bf2f3e

07:37:04,537 21-Jun-2018 INFO Host ID: 47853854d13d80e6d0212dabb0be2e12c12e431bf23d4e0260642594

07:37:04,537 21-Jun-2018 INFO Host Name: pod1-compute-9.localdomain

07:37:04,537 21-Jun-2018 INFO ===== SEND NOTIFICATION ENDS =====

07:37:04,550 21-Jun-2018 INFO

07:37:04,550 21-Jun-2018 INFO ===== SEND NOTIFICATION STARTS =====

07:37:04,550 21-Jun-2018 INFO Type: SERVICE_UPDATED

07:37:04,550 21-Jun-2018 INFO Status: SUCCESS

07:37:04,550 21-Jun-2018 INFO Status Code: 200

07:37:04,550 21-Jun-2018 INFO Status Msg: Service group update completed successfully

07:37:04,550 21-Jun-2018 INFO Tenant: core

07:37:04,550 21-Jun-2018 INFO Deployment ID: 9bcad337-d1f0-463c-8450-de7697b1e104

07:37:04,550 21-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

07:37:04,550 21-Jun-2018 INFO ===== SEND NOTIFICATION ENDS =====

07:41:55,912 21-Jun-2018 INFO ===== GET OPERATIONAL/INFO DATA =====

Depois que a VM for desimplantada e o serviço for atualizado, retome a placa que foi suspensa:

admin@scm# resume-vnfci vdu session-function vnfci BOOT_generic_di-chasis_SF3_1

success true

Confirme a partir do yangesc.log que a VM foi implantada novamente e se tornou ativa:

####################################################################

# ESC on vnfm2-esc-0.novalocal is in MASTER state.

####################################################################

[admin@vnfm2-esc-0 ~]$ cd /opt/cisco/esc/esc-confd/esc-cli

[admin@vnfm2-esc-0 esc-cli]$ tail -f /var/log/esc/yangesc.log

07:41:55,912 21-Jun-2018 INFO ===== GET OPERATIONAL/INFO DATA =====

07:41:56,412 21-Jun-2018 INFO

07:41:56,413 21-Jun-2018 INFO ===== CONFD TRANSACTION STARTED =====

07:41:56,513 21-Jun-2018 INFO

07:41:56,513 21-Jun-2018 INFO ===== UPDATE SERVICE REQUEST RECEIVED (UNDER TENANT) =====

07:41:56,513 21-Jun-2018 INFO Tenant name: core

07:41:56,513 21-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

07:41:56,612 21-Jun-2018 INFO

07:41:56,612 21-Jun-2018 INFO ===== CONFD TRANSACTION ACCEPTED =====

07:43:53,615 21-Jun-2018 INFO

07:43:53,615 21-Jun-2018 INFO ===== SEND NOTIFICATION STARTS =====

07:43:53,616 21-Jun-2018 INFO Type: VM_DEPLOYED

07:43:53,616 21-Jun-2018 INFO Status: SUCCESS

07:43:53,616 21-Jun-2018 INFO Status Code: 200

07:43:53,616 21-Jun-2018 INFO Status Msg: VM Deployed in a deployment update. VM name: [vnfd2-deployment_s6_0_23cc139b-a7ca-45fb-b005-733c98ccc299]

07:43:53,616 21-Jun-2018 INFO Tenant: core

07:43:53,616 21-Jun-2018 INFO Deployment ID: 9bcad337-d1f0-463c-8450-de7697b1e104

07:43:53,616 21-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

07:43:53,616 21-Jun-2018 INFO VM group name: s6

07:43:53,616 21-Jun-2018 INFO User configs: 1

07:43:53,616 21-Jun-2018 INFO VM Source:

07:43:53,616 21-Jun-2018 INFO VM ID: 637547ad-094e-4132-8613-b4d8502ec385

07:43:53,616 21-Jun-2018 INFO Host ID: 47853854d13d80e6d0212dabb0be2e12c12e431bf23d4e0260642594

07:43:53,616 21-Jun-2018 INFO Host Name: pod1-compute-9.localdomain

07:43:53,616 21-Jun-2018 INFO ===== SEND NOTIFICATION ENDS =====

07:44:20,170 21-Jun-2018 INFO

07:44:20,170 21-Jun-2018 INFO ===== SEND NOTIFICATION STARTS =====

07:44:20,170 21-Jun-2018 INFO Type: VM_ALIVE

07:44:20,170 21-Jun-2018 INFO Status: SUCCESS

07:44:20,170 21-Jun-2018 INFO Status Code: 200

07:44:20,170 21-Jun-2018 INFO Status Msg: VM_Alive event received during deployment update, VM ID: [vnfd2-deployment_s6_0_23cc139b-a7ca-45fb-b005-733c98ccc299]

07:44:20,170 21-Jun-2018 INFO Tenant: core

07:44:20,170 21-Jun-2018 INFO Deployment ID: 9bcad337-d1f0-463c-8450-de7697b1e104

07:44:20,170 21-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

07:44:20,170 21-Jun-2018 INFO VM group name: s6

07:44:20,170 21-Jun-2018 INFO User configs: 1

07:44:20,170 21-Jun-2018 INFO VM Source:

07:44:20,170 21-Jun-2018 INFO VM ID: 637547ad-094e-4132-8613-b4d8502ec385

07:44:20,170 21-Jun-2018 INFO Host ID: 47853854d13d80e6d0212dabb0be2e12c12e431bf23d4e0260642594

07:44:20,170 21-Jun-2018 INFO Host Name: pod1-compute-9.localdomain

07:44:20,170 21-Jun-2018 INFO ===== SEND NOTIFICATION ENDS =====

07:44:20,194 21-Jun-2018 INFO

07:44:20,194 21-Jun-2018 INFO ===== SEND NOTIFICATION STARTS =====

07:44:20,194 21-Jun-2018 INFO Type: SERVICE_UPDATED

07:44:20,194 21-Jun-2018 INFO Status: SUCCESS

07:44:20,194 21-Jun-2018 INFO Status Code: 200

07:44:20,194 21-Jun-2018 INFO Status Msg: Service group update completed successfully

07:44:20,194 21-Jun-2018 INFO Tenant: core

07:44:20,194 21-Jun-2018 INFO Deployment ID: 9bcad337-d1f0-463c-8450-de7697b1e104

07:44:20,194 21-Jun-2018 INFO Deployment name: vnfd2-deployment-1.0.0-1

07:44:20,194 21-Jun-2018 INFO ===== SEND NOTIFICATION ENDS =====

Compare UUID novamente do StarOS e EM para confirmar se a incompatibilidade foi corrigida:

admin@scm# show vdus vdu | select vnfci

CONSTITUENT MEMORY STORAGE

DEVICE DEVICE ELEMENT IS CPU UTILS USAGE

ID ID NAME GROUP GROUP INFRA INITIALIZED VIM ID UTILS BYTES BYTES

---------------------------------------------------------------------------------------------------------------------------------------------------------------------

control-function BOOT_generic_di-chasis_CF1_1 scm-cf-nc scm-cf-nc di-chasis true true 33c779d2-e271-47af-8ad5-6a982c79ba62 - - -

BOOT_generic_di-chasis_CF2_1 scm-cf-nc scm-cf-nc di-chasis true true e75ae5ee-2236-4ffd-a0d4-054ec246d506 - - -

session-function BOOT_generic_di-chasis_SF1_1 - - di-chasis true false e1a6762d-4e84-4a86-a1b1-84772b3368dc - - -

BOOT_generic_di-chasis_SF2_1 - - di-chasis true false b283d43c-6e0c-42e8-87d4-a3af15a61a83 - - -

BOOT_generic_di-chasis_SF3_1 - - di-chasis true false 637547ad-094e-4132-8613-b4d8502ec385 - - -

BOOT_generic_di-chasis_SF4_1 - - di-chasis true false 65344d53-de09-4b0b-89a6-85d5cfdb3a55 - - -

[local]POD1-VNF2-PGW# show emctrl vdu list

Thursday June 21 09:09:02 UTC 2018

Showing emctrl vdu

card[01]: name[CFC_01 ] uuid[33C779D2-E271-47AF-8AD5-6A982C79BA62]

card[02]: name[CFC_02 ] uuid[E75AE5EE-2236-4FFD-A0D4-054EC246D506]

card[03]: name[SFC_03 ] uuid[E1A6762D-4E84-4A86-A1B1-84772B3368DC]

card[04]: name[SFC_04 ] uuid[B283D43C-6E0C-42E8-87D4-A3AF15A61A83]

card[05]: name[session-function/BOOT_generic_di-chasis_SF3_1 ] uuid[637547AD-094E-4132-8613-B4D8502EC385]

card[06]: name[SFC_06 ] uuid[65344D53-DE09-4B0B-89A6-85D5CFDB3A55]

Incomplete command

[local]POD1-VNF2-PGW#

[local]POD1-VNF2-PGW#

[local]POD1-VNF2-PGW#

[local]POD1-VNF2-PGW# show card hardware | grep -i uuid

Thursday June 21 09:09:11 UTC 2018

UUID/Serial Number : 33C779D2-E271-47AF-8AD5-6A982C79BA62

UUID/Serial Number : E75AE5EE-2236-4FFD-A0D4-054EC246D506

UUID/Serial Number : E1A6762D-4E84-4A86-A1B1-84772B3368DC

UUID/Serial Number : B283D43C-6E0C-42E8-87D4-A3AF15A61A83

UUID/Serial Number : 637547AD-094E-4132-8613-B4D8502EC385

UUID/Serial Number : 65344D53-DE09-4B0B-89A6-85D5CFDB3A55

Limpar Solicitações Pendentes no Zookeeper do EM

Note: Isso é opcional.

Acessar o zookeeper:

ubuntu@ultramvnfm1em-0:~$ /opt/cisco/usp/packages/zookeeper/current/bin/zkCli.sh

<snip>

[zk: localhost:2181(CONNECTED) 0]

Solicitação de lista pendente:

[zk: localhost:2181(CONNECTED) 0] ls /request

Excluir todas as solicitações listadas:

[zk: localhost:2181(CONNECTED) 0] rmr /request/request00000000xx

Quando todas as solicitações pendentes forem limpas, reinicie a solicitação de suspensão novamente.

Colaborado por engenheiros da Cisco

- Partheeban RajagopalServiços avançados da Cisco

- Padmaraj RamanoudjamServiços avançados da Cisco

Contate a Cisco

- Abrir um caso de suporte

- (É necessário um Contrato de Serviço da Cisco)

Feedback

Feedback