Implementación de CPAR AAA VM

Opciones de descarga

-

ePub (2.3 MB)

Visualice en diferentes aplicaciones en iPhone, iPad, Android, Sony Reader o Windows Phone -

Mobi (Kindle) (2.4 MB)

Visualice en dispositivo Kindle o aplicación Kindle en múltiples dispositivos

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe los registradores de Cisco Prime Access (CPAR) Implementación de VM con autenticación, autorización y contabilidad (AAA). Este procedimiento se aplica a un entorno OpenStack con la versión de NEWTON en la que ESC no administra CPAR y CPAR se instala directamente en la máquina virtual (VM) implementada en OpenStack.

Colaboración de Karthikeyan Dachanamoorthy, Cisco Advanced Services.

Antecedentes

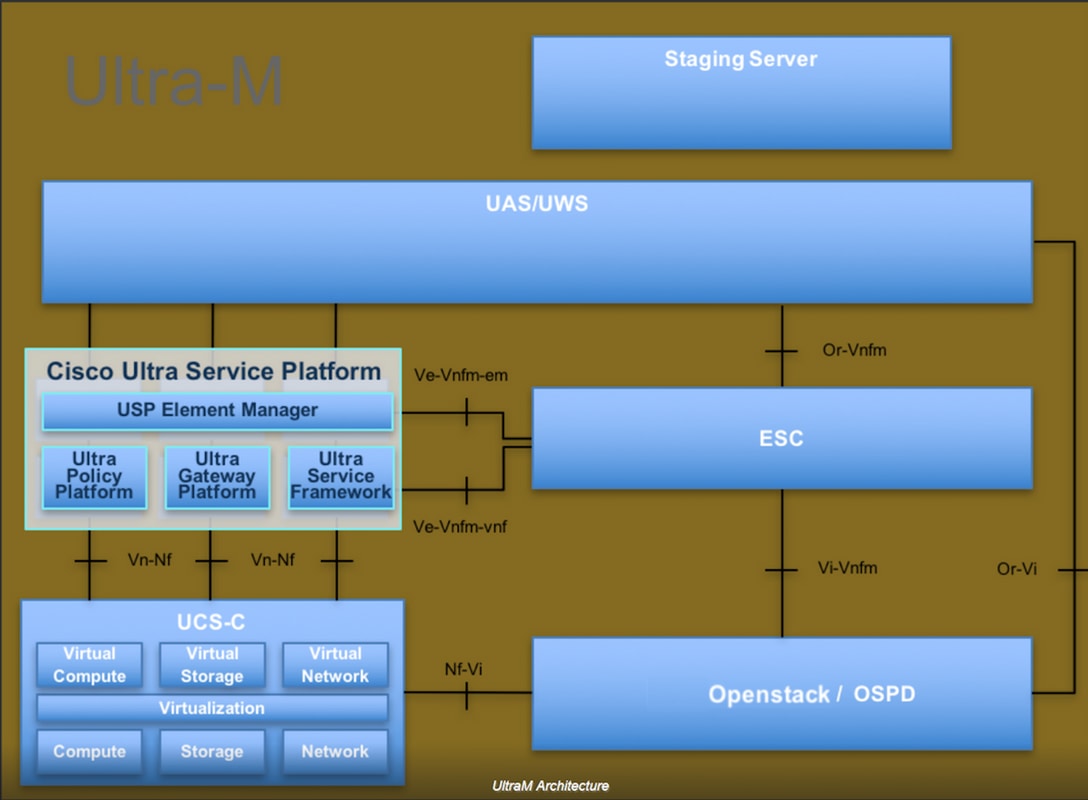

Ultra-M es una solución de núcleo de paquetes móviles virtualizados previamente empaquetada y validada que se ha diseñado para simplificar la implementación de VNF. OpenStack es el Virtualized Infrastructure Manager (VIM) para Ultra-M y consta de los siguientes tipos de nodos:

- Informática

- Disco de almacenamiento de objetos - Informática (OSD - Informática)

- Controlador

- Plataforma OpenStack - Director (OSPD)

La arquitectura de alto nivel de Ultra-M y los componentes implicados se muestran en esta imagen:

Este documento está dirigido al personal de Cisco que está familiarizado con la plataforma Ultra-M de Cisco y detalla los pasos que deben llevarse a cabo en OpenStack y Redhat OS.

Nota: Se considera la versión Ultra M 5.1.x para definir los procedimientos en este documento.

Procedimiento de implementación de instancia de VM de CPAR

Inicie sesión en la interfaz de Horizon.

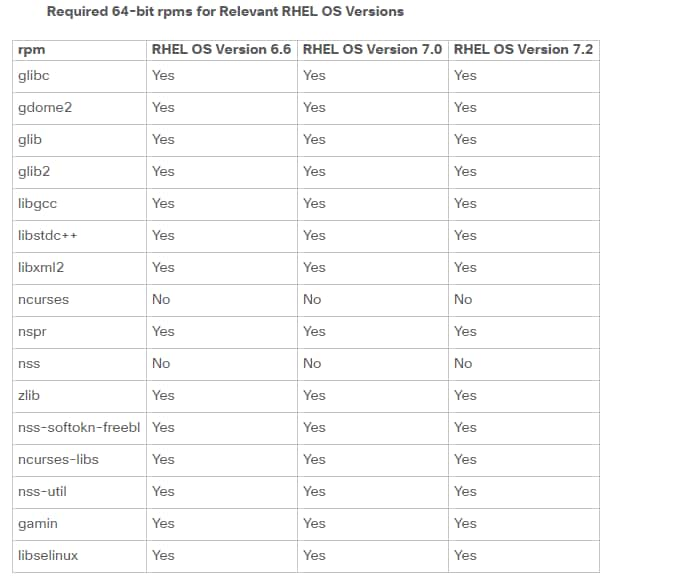

Asegúrese de que se hayan obtenido antes de comenzar con el procedimiento de implementación de instancias de VM.

- Conectividad de Secure Shell (SSH) con la máquina virtual o el servidor

- Actualizar el nombre de host y el mismo nombre de host debe estar allí en /etc/hosts

- La lista incluye los RPM necesarios para instalar la GUI de CPAR

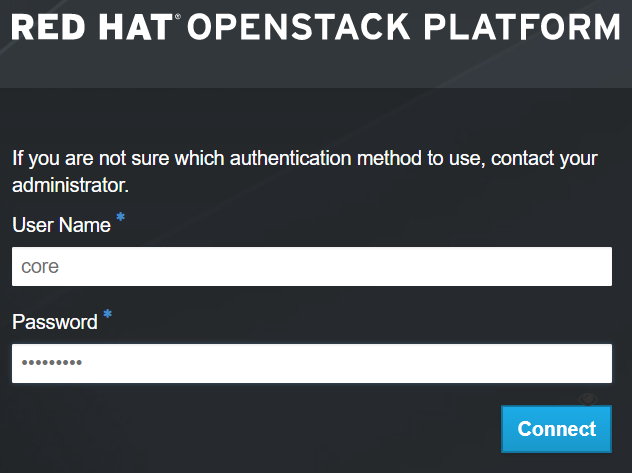

Paso 1. Abra cualquier explorador de Internet y una dirección IP correspondiente de la interfaz de Horizon.

Paso 2. Introduzca las credenciales de usuario adecuadas y haga clic en el botón Connect.

Cargar imagen RHEL en Horizon

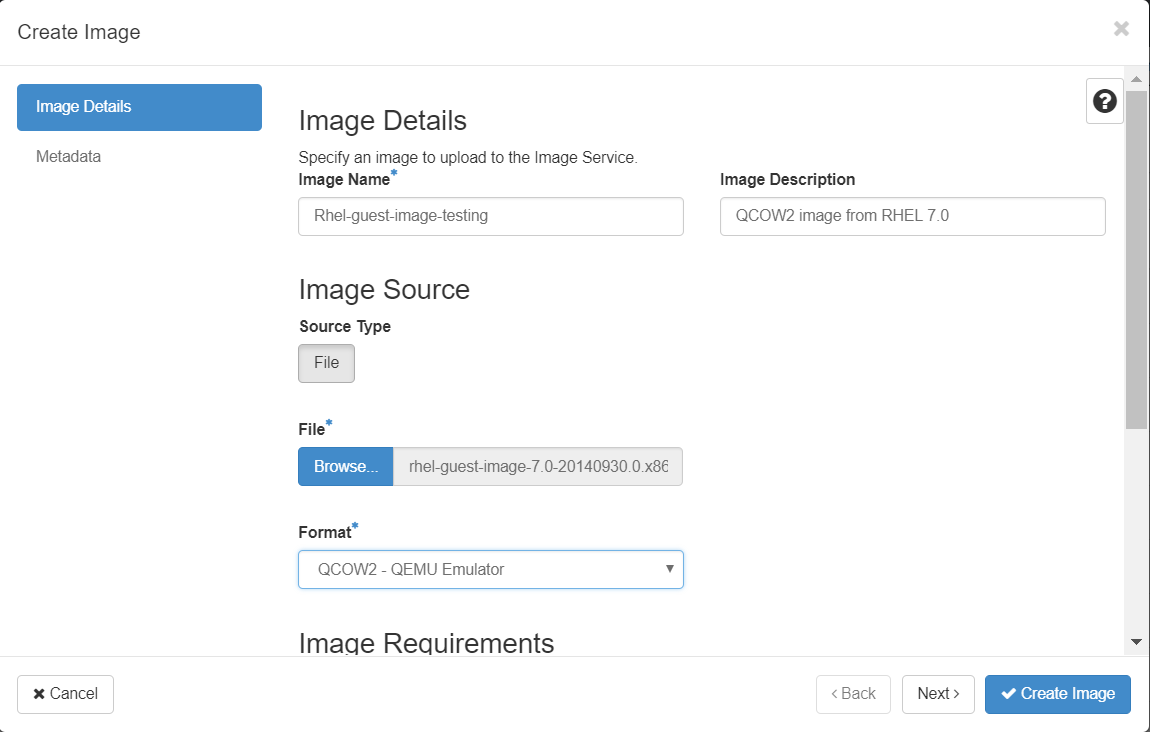

Paso 1. Navegue hasta Repositorio de contenido y descargue el archivo llamado rhel-image. Esta es una imagen personalizada de Red Hat QCOW2 para el proyecto CPAR AAA.

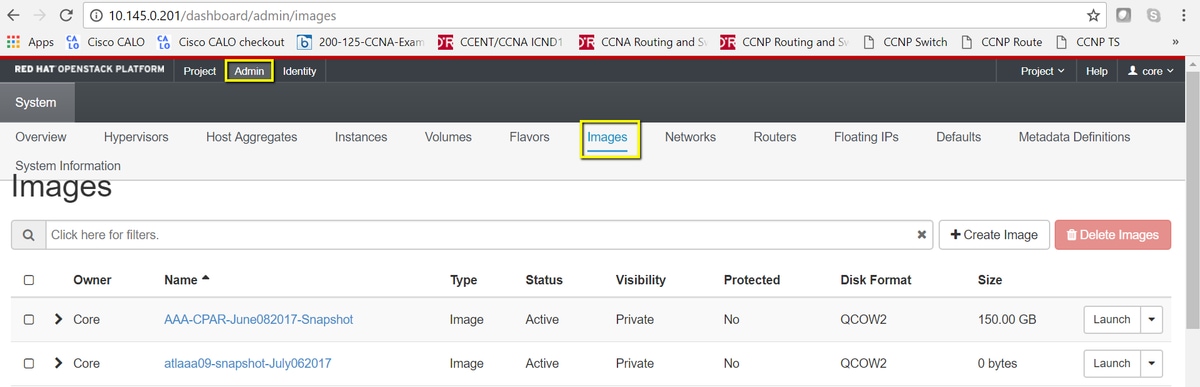

Paso 2. Vuelva a la pestaña Horizon y siga la ruta Admin > Images como se muestra en la imagen.

Paso 3. Haga clic en el botón Create Image. Rellene los archivos etiquetados como Nombre de imagen y Descripción de imagen, seleccione el archivo QCOW2 que se descargó anteriormente en el Paso 1. haciendo clic en la sección Browse at File y seleccione la opción QCOW2-QUEMU Emulator en la sección Format.

A continuación, haga clic en Create Image como se muestra en la imagen.

Crear un nuevo sabor

Los sabores representan la plantilla de recursos utilizada en la arquitectura de cada instancia.

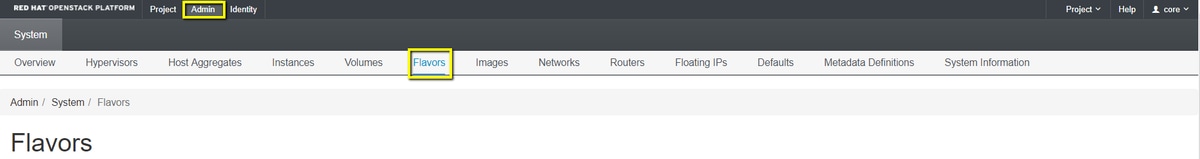

Paso 1. En el menú superior de Horizon, navegue hasta Admin > Flavors como se muestra en la imagen.

Figura 4 Sección de sabores del horizonte.

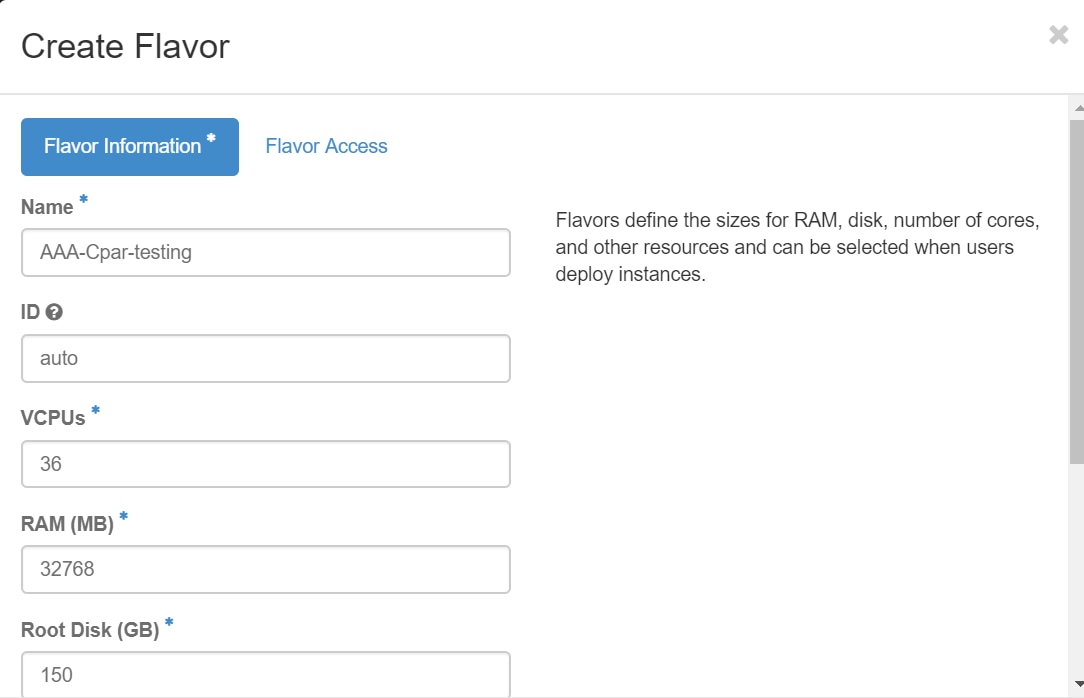

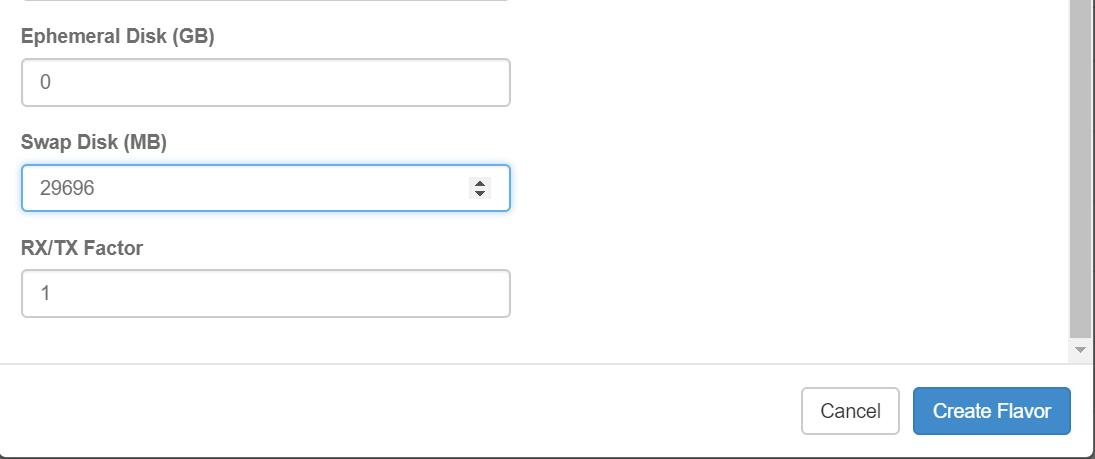

Paso 2. Haga clic en el botón Create Flavor.

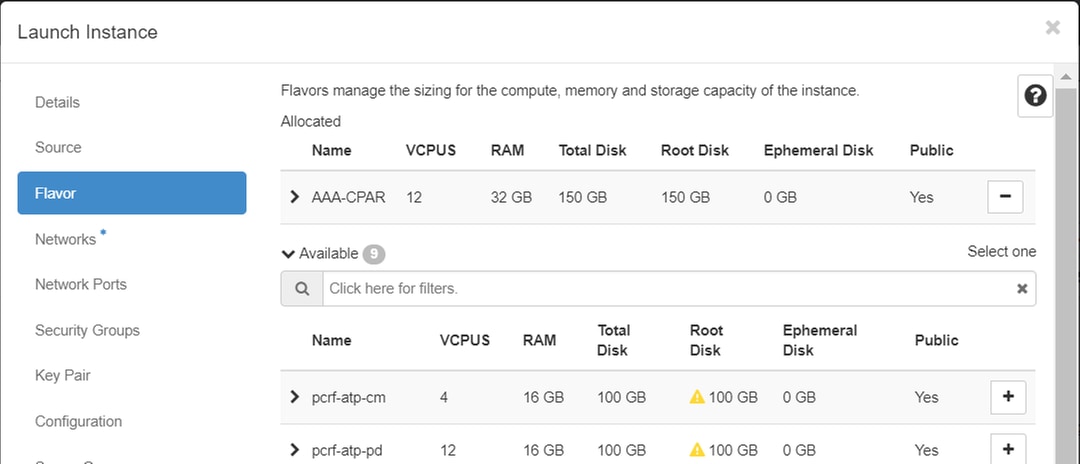

Paso 3. En la ventana Create Flavor, rellene la información de recursos correspondiente. Esta es la configuración utilizada para CPAR Flavor:

vCPUs 36

RAM (MB) 32768

Root Disk (GB) 150

Ephemeral Disk (GB) 0

Swap Disk (MB) 29696

RX/TX Factor 1

Paso 4. En la misma ventana, haga clic en Flavor Access y seleccione el proyecto donde se va a utilizar esta configuración de Flavor (es decir, Núcleo).

Paso 5. Haga clic en Create Flavor.

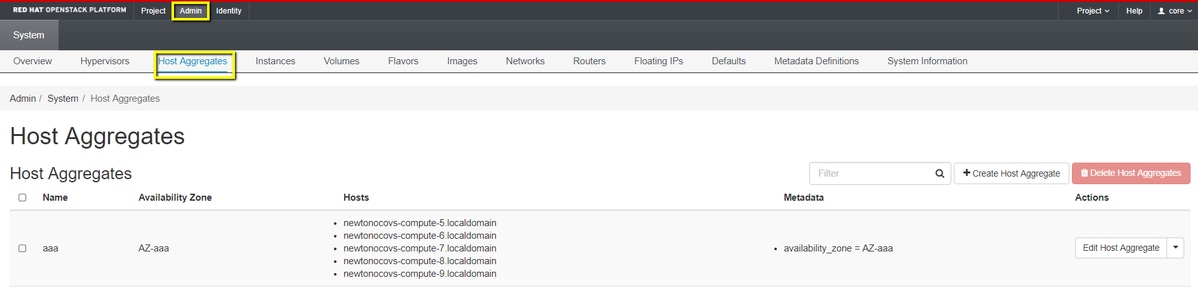

Creación de un Agregado de Host/Zona de Disponibilidad

Paso 1. En el menú superior de Horizon, navegue hasta Admin > Host Aggregates como se muestra en la imagen.

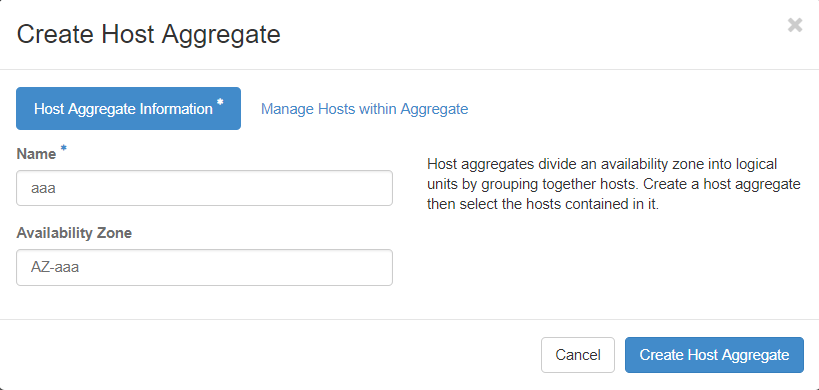

Paso 2. Haga clic en el botón Create Host Aggregate.

Paso 3. En la etiqueta Host Aggregate Information* rellene los campos Name y Availability Zone con la información correspondiente. Para el entorno de producción, esta información se utiliza actualmente como se muestra en la imagen:

- Nombre: aaa

- Zona de disponibilidad: AZ-aaa

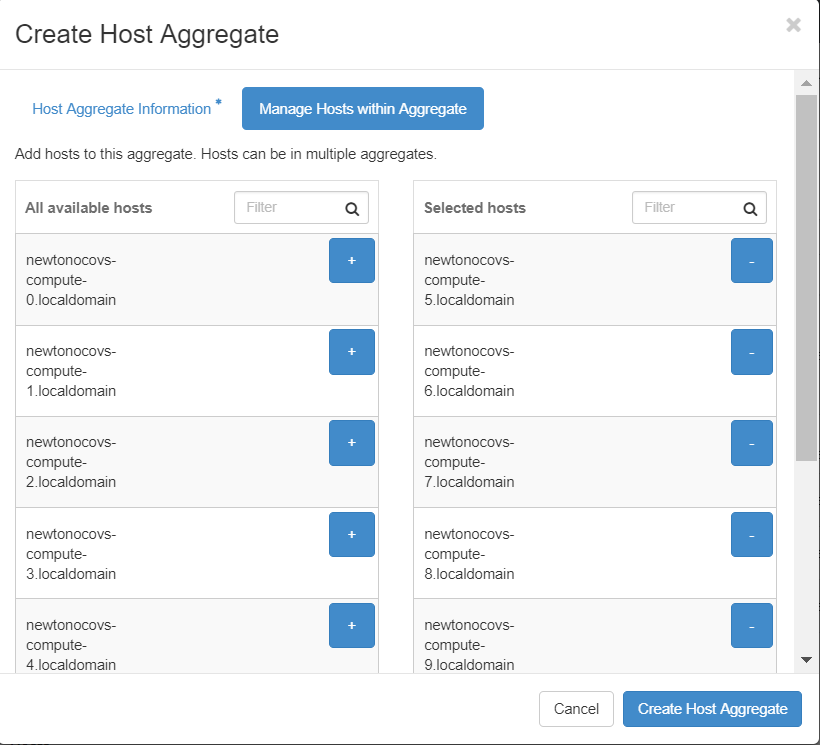

Paso 4. Haga clic en la pestaña Administrar hosts dentro del agregado y haga clic en el botón + para los hosts que se deben agregar a la nueva zona de disponibilidad.

Paso 4. Haga clic en la pestaña Administrar hosts dentro del agregado y haga clic en el botón + para los hosts que se deben agregar a la nueva zona de disponibilidad.

Paso 5. Por último, haga clic en el botón Create Host Aggregate.

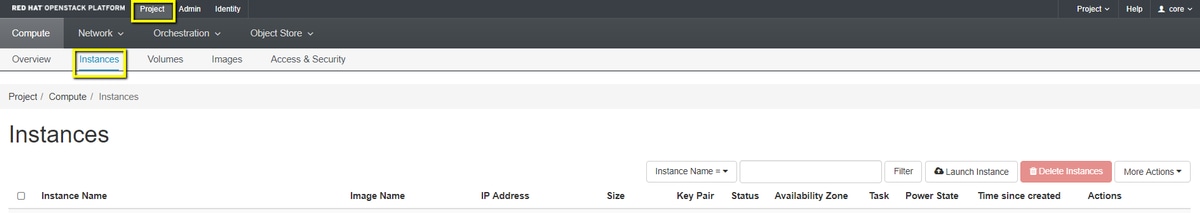

Iniciar una nueva instancia

Paso 1. En el menú superior de Horizon, navegue hasta Project > Instances como se muestra en la imagen.

Paso 2. Haga clic en el botón Iniciar instancia.

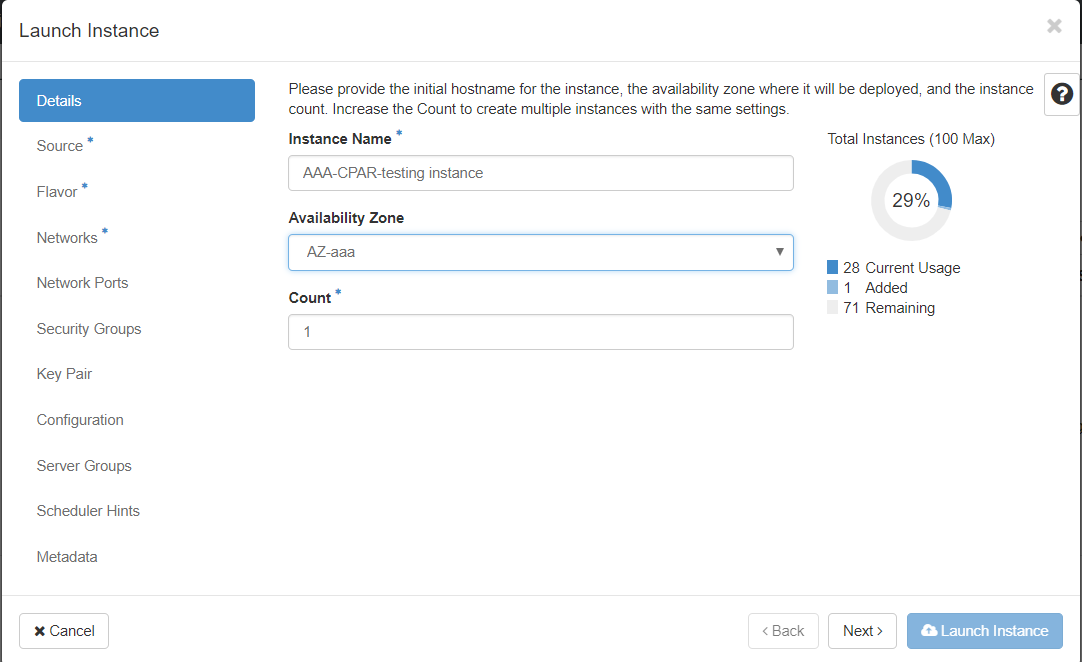

Paso 3. En la pestaña Details, ingrese un Nombre de instancia adecuado para la nueva máquina virtual, seleccione la Zona de disponibilidad correspondiente (es decir, AZ-aaa) y establezca Count en 1, como se muestra en la imagen.

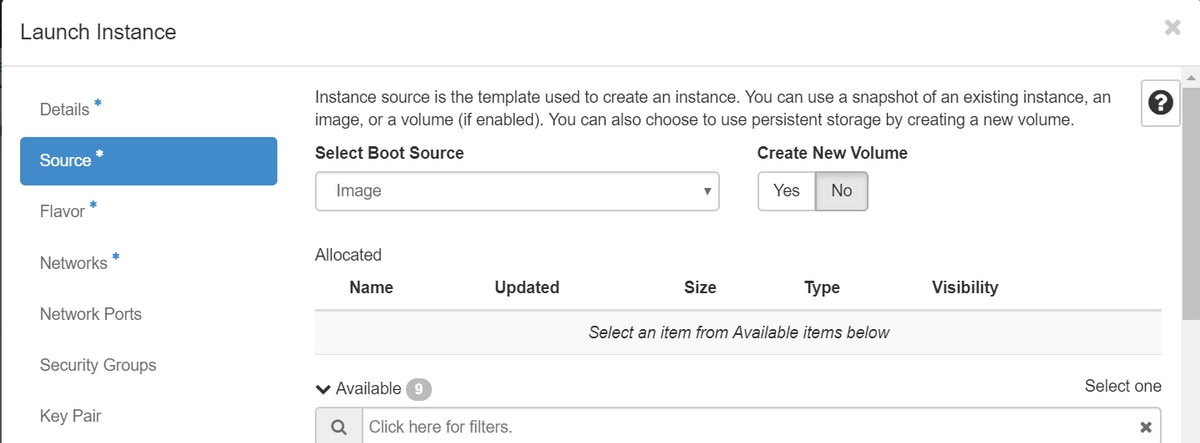

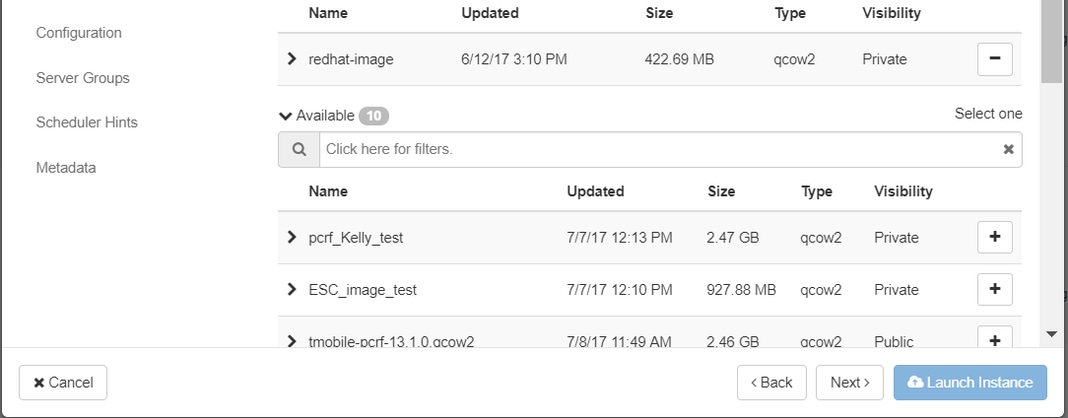

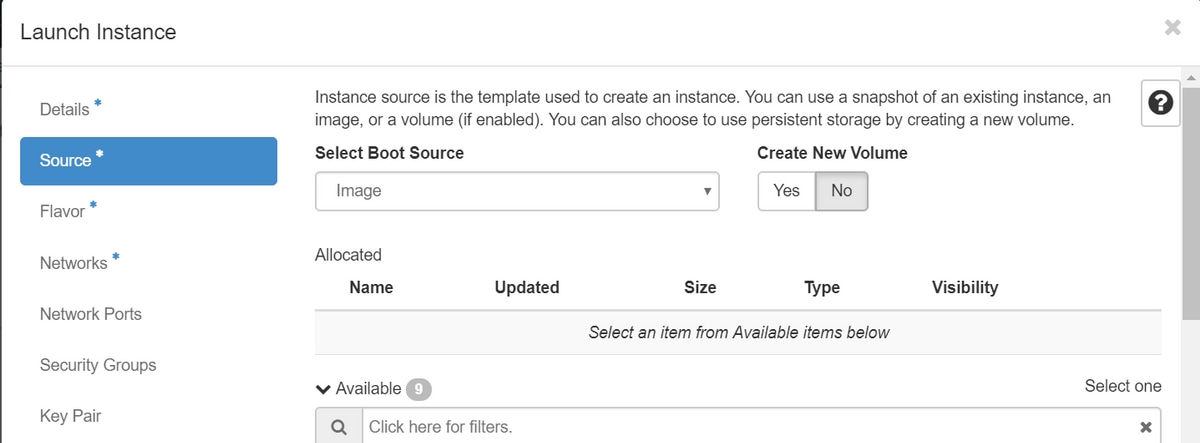

Paso 4. Haga clic en la pestaña Source y, a continuación, seleccione y ejecute uno de estos procedimientos:

1. Inicie una instancia basada en una imagen RHEL.

Establezca los parámetros de configuración de la siguiente manera:

- Seleccione Boot Source: Image

- Crear nuevo volumen: No

- Seleccione la imagen correspondiente del menú Disponible (es decir, redhat-image)

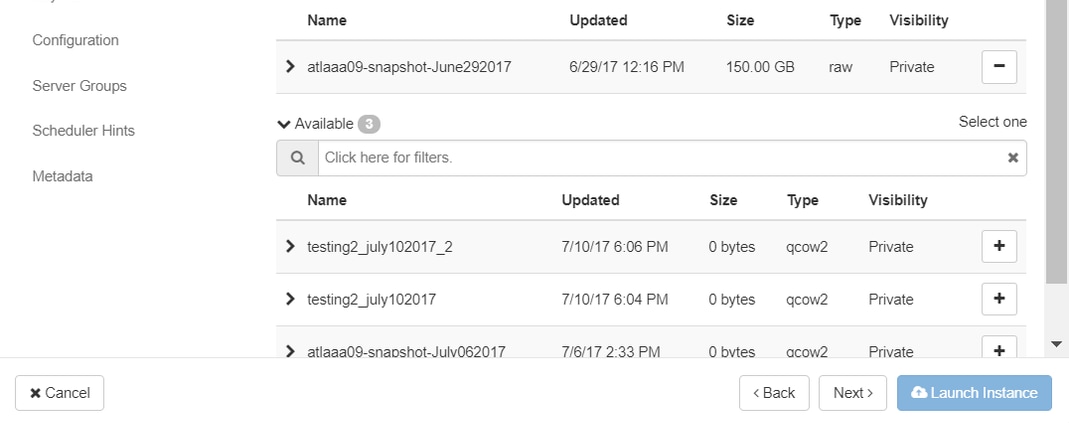

2. Inicie una instancia basada en una instantánea.

Establezca los parámetros de configuración de la siguiente manera:

- Seleccionar Origen de Arranque: Instantánea de Instancia

- Crear nuevo volumen: No

- Seleccione la instantánea correspondiente en el menú Disponible (es decir, aaa09-snapshot-June292017)

Paso 5. Haga clic en la pestaña Sabor y seleccione el Sabor creado en la sección Crear un Sabor Nuevo.

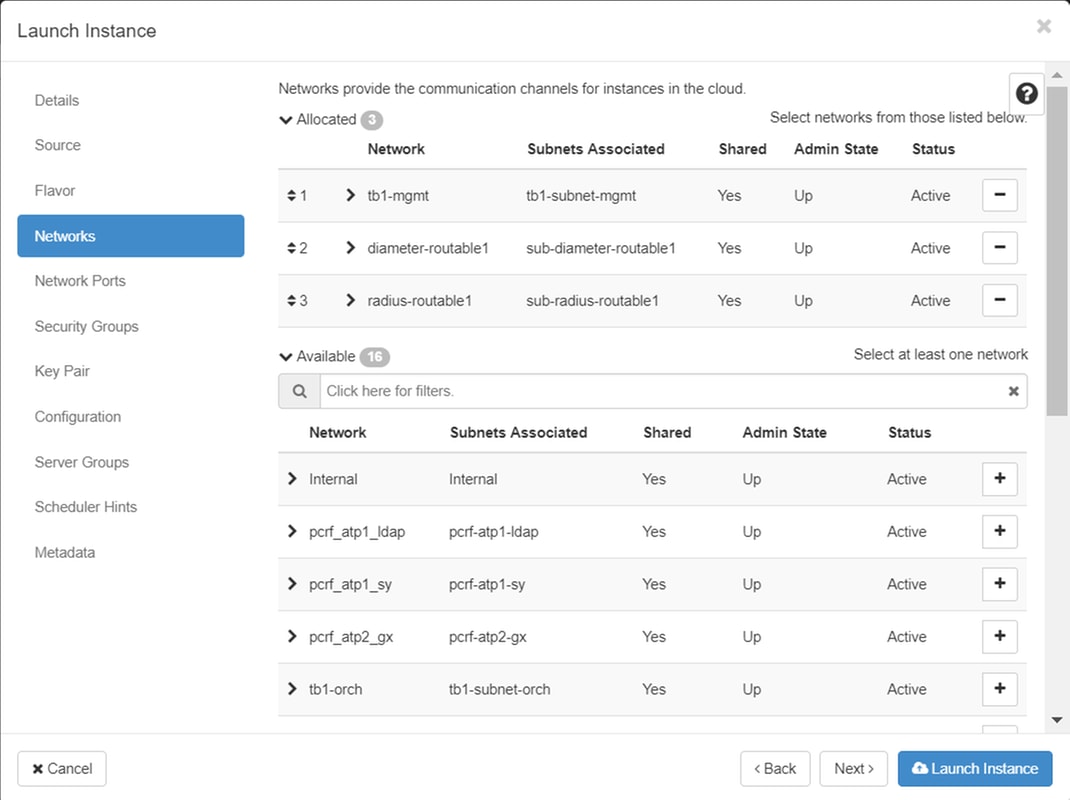

Paso 6. Haga clic en la pestaña Networks y seleccione las redes correspondientes que se utilizarán para cada interfaz Ethernet de la nueva instancia/VM. Esta configuración se está utilizando actualmente para el entorno de producción:

- eth0 = tb1-mgmt

- eth1 = diámetro enrutable1

- eth2 = radius-routable1

Paso 7. Finalmente, haga clic en el botón Iniciar Instancia para iniciar la implementación de la nueva instancia.

Creación y asignación de una dirección IP flotante

Una dirección IP flotante es una dirección enrutable, lo que significa que es accesible desde el exterior de la arquitectura Ultra M/OpenStack y que puede comunicarse con otros nodos de la red.

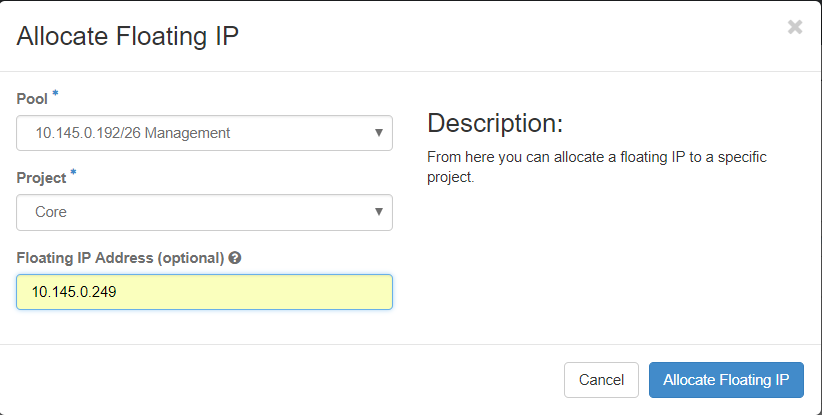

Paso 1. En el menú superior de Horizon, navegue hasta Admin > Floating IPs.

Paso 2. Haga clic en el botón Allocate IP to Project.

Paso 3. En la ventana Allocate Floating IP, seleccione el Pool del que pertenece la nueva IP flotante, el Project al que se va a asignar y la nueva Dirección IP flotante.

Por ejemplo:

Paso 4. Haga clic en el botón Asignar IP flotante.

Paso 5. En el menú superior de Horizonte, navegue hasta Proyecto > Instancias.

Paso 6. En la columna Acción, haga clic en la flecha que apunta hacia abajo en el botón Crear instantánea, debería aparecer un menú. Seleccione la opción Associate Floating IP.

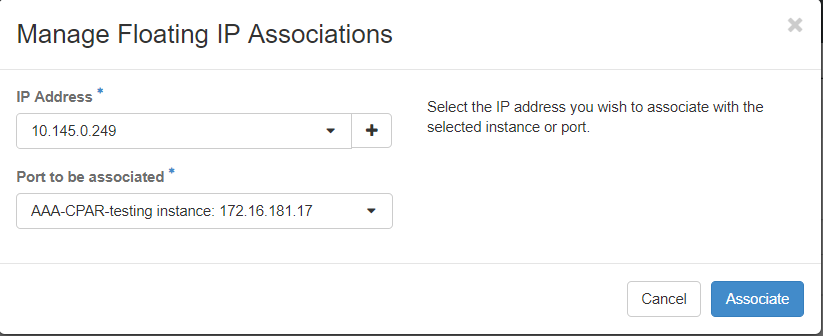

Paso 7. Seleccione la dirección IP flotante correspondiente que se utilizará en el campo IP Address y elija la interfaz de administración correspondiente (eth0) de la nueva instancia en la que se asignará esta IP flotante en el puerto que se asociará como se muestra en la imagen.

Paso 8. Por último, haga clic en el botón Asociar.

Activar SSH

Paso 1. En el menú superior de Horizonte, navegue hasta Proyecto > Instancias.

Paso 2. Haga clic en el nombre de la instancia/VM que se creó en la sección Iniciar una nueva instancia.

Paso 3. Haga clic en la pestaña Console. Esto mostrará la interfaz de línea de comandos de la máquina virtual.

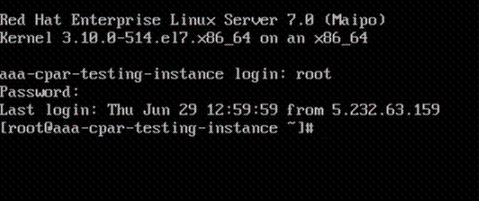

Paso 4. Una vez que se muestre la CLI, introduzca las credenciales de inicio de sesión adecuadas:

Nombre de usuario: xxxxx

Contraseña: xxxxx

Paso 5. En la CLI, ingrese el comando vi /etc/ssh/sshd_config para editar la configuración SSH.

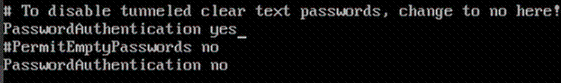

Paso 6. Una vez abierto el archivo de configuración SSH, presione I para editar el archivo. A continuación, busque la sección que se muestra aquí y cambie la primera línea de PasswordAuthentication no a PasswordAuthentication yes.

Paso 7. Presione ESC e ingrese :wq! para guardar los cambios del archivo sshd_config.

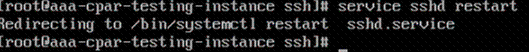

Paso 8. Ejecute el comando service sshd restart.

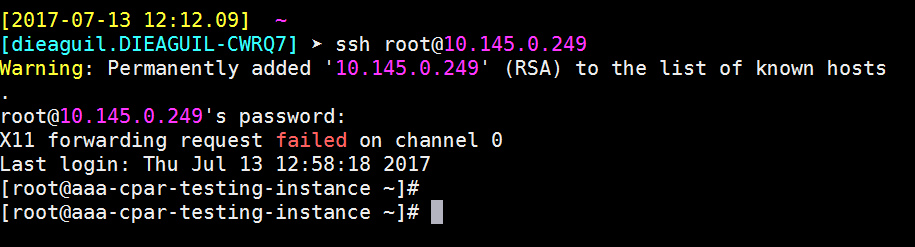

Paso 9. Para probar que los cambios de configuración de SSH se han aplicado correctamente, abra cualquier cliente SSH e intente establecer una conexión segura remota con la IP flotante asignada a la instancia (es decir, 10.145.0.249) y la raíz del usuario.

Establecer una Sesión SSH

Abra una sesión SSH con el uso de la dirección IP de la VM/servidor correspondiente donde se instalará la aplicación.

Cargar software y licencias de CPAR

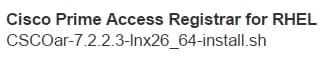

Paso 1. Descargue el script de instalación de la versión de CPAR correspondiente (CSCOar-x.x.x.x-lnx26_64-install.sh) desde la plataforma de software de Cisco: https://software.cisco.com/download/release.html?mdfid=286309432&flowid=&softwareid=284671441&release=7.2.2.3&relind=AVAILABLE&rellifecycle=&reltype=latest

Paso 2. Cargue el archivo CSCOar-x.x.x.x-lnx26_64-install.sh en el nuevo directorio VM/Server at /tmp.

Paso 3. Cargue los archivos de licencia correspondientes en el nuevo directorio VM/Server at /tmp.

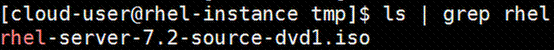

Cargar imagen de RHEL/CentOS

Cargue el archivo RHEL o CentOS .iso correspondiente en el directorio VM/server/tmp.

Crear repositorio de Yum

Yum es una herramienta de Linux que ayuda al usuario a instalar nuevos RPM con todas sus dependencias. Esta herramienta se utiliza en el momento de la instalación de los RPM obligatorios de CPAR y en el momento del procedimiento de actualización del núcleo.

Paso 1. Navegue hasta directory /mnt con el uso del comando cd/mnt y cree un nuevo directorio llamado disk1 y ejecute el comando mkdir disk1.

Paso 2. Navegue hasta el directorio /tmp con el comando cd /tmp donde se cargó previamente el archivo RHEL o CentOS .iso y siga los pasos que se mencionan en la sección 3.3.

Paso 3. Monte la imagen RHEL/CentOS en el directorio que se creó en el Paso 1. con el uso del comando mount -o loop <nombre del archivo iso> /mnt/disk1.

Paso 4. En /tmp, cree un nuevo directorio llamado repo con el uso del comando mkdir repo. A continuación, cambie los permisos de este directorio y ejecute el comando chmod -R o-w+r repo.

Paso 5. Navegue hasta el directorio Packages de la imagen RHEL/CentOS (montada en el Paso 3.) con el comando cd /mnt/disk1. Copie todos los archivos del directorio Packages en /tmp/repo con el comando cp -v * /tmp/repo.

Paso 6. Vuelva al directorio repo y ejecute cd /tmp/repo y utilice estos comandos:

rpm -Uhvdeltarpm-3.6-3.el7.x86_64.rpm

rpm-Uvh python-deltarpm-3.6-3.el7.x86_64.rpm

rpm -Uvh createrepo-0.9.9-26.el7.noarch.rpm

Estos comandos instalan los tres RPM requeridos para instalar y utilizar Yum. La versión de los RPM mencionados anteriormente puede ser diferente y depende de la versión de RHEL/CentOS. Si alguno de estos RPM no está incluido en el directorio /Packages, consulte el sitio web https://rpmfind.net desde donde se puede descargar.

Paso 7. Cree un nuevo repositorio RPM con el comando createrepo /tmp/repo.

Paso 8. Navegue hasta el directorio /etc/yum.repos.d/ con el comando cd /etc/yum.repos.d/. Cree un nuevo archivo llamado myrepo.repo que lo contenga con el comando vi myrepo.repo:

[local]

name=MyRepo

baseurl=file:///tmp/repo

enabled=1

gpgcheck=0

Presione I para habilitar el modo de inserción. Para guardar y cerrar, presione la tecla ESC y luego ingrese ":wq!" y presione Enter.

Instalar RPM necesarios de CPAR

Paso 1. Navegue hasta el directorio /tmp/repo con el comando cd /tmp/repo.

Paso 2. Instale los RPM necesarios de CPAR y ejecute estos comandos:

yum install bc-1.06.95-13.el7.x86_64.rpm

yum install jre-7u80-linux-x64.rpm

yum install sharutils-4.13.3-8.el7.x86_64.rpm

yum install unzip-6.0-16.el7.x86_64.rpm

Nota: La versión de los RPM puede ser diferente y depende de la versión de RHEL/CentOS. Si alguno de estos RPM no está incluido en el directorio /Packages, consulte el sitio web https://rpmfind.net donde se puede descargar. Para descargar Java SE 1.7 RPM, consulte http://www.oracle.com/technetwork/java/javase/downloads/java-archive-downloads-javase7-521261.html y descargue jre-7u80-linux-x64.rpm.

Actualización del núcleo a la versión 3.10.0-693.1.1.el7

Paso 1. Navegue hasta el directorio /tmp/repo con el comando cd /tmp/repo.

Paso 2. Instale kernel-3.10.0-514.el7.x86_64 RPM y ejecute el comando yum install kernel-3.10.0-693.1.1.el7.x86_64.rpm.

Paso 3. Reinicie la máquina virtual/servidor con el comando reboot.

Paso 4. Una vez que la máquina se inicie nuevamente, verifique que la versión del núcleo fue actualizada y ejecute el comando uname -r. El resultado debe ser 3.10.0-693.1.1.el7.x86_64.

Configuración de los parámetros de red

Modificar el nombre de host

Paso 1. Abra en modo de escritura el archivo /etc/hosts y ejecute el comando vi /etc/hosts.

Paso 2. Presione I para habilitar el modo de inserción y escribir la información de la red de host correspondiente y siga este formato:

<Diameter interface IP> <Host’s FQDN> <VM/Server’s hostname>

Por ejemplo: 10.178.7.37 aaa07.aaa.epc.mnc30.mcc10.3gppnetwork.org aaa07

Paso 3. Guarde los cambios y cierre el archivo. Para ello, presione la tecla ESC y, a continuación, escriba ":wq!" y presione Entrar.

Paso 4. Ejecute el comando hostnamectl set-hostname <FQDN del host>. Por ejemplo: hostnamectl set-hostname aaa.epc.mnc.mcc.3gppnetwork.org.

Paso 5. Reinicie el servicio de red con el comando service network restart.

Paso 6. Verifique que se aplicaron los cambios de nombre de host y ejecute los comandos: hostname -a, hostname -f, que deben mostrar el nombre de host de la VM/servidor y su FQDN.

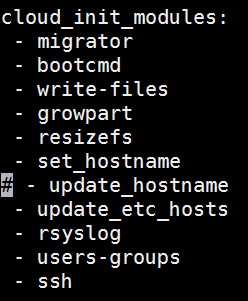

Paso 7. Abra /etc/cloud/cloud_config con el comando vi /etc/cloud/cloud_config e inserte un "#" delante de la línea "- update hostname". Esto es para evitar que el nombre de host cambie después de un reinicio. El archivo debe tener este aspecto:

Configuración de las interfaces de red

Paso 1. Navegue hasta directorio /etc/sysconfig/network-scripts con el uso de cd /etc/sysconfig/network-scripts.

Paso 2. Abra ifcfg-eth0 con el comando vi ifcfg-eth0. Ésta es la interfaz de administración; su configuración debería ser similar a la siguiente.

DEVICE="eth0"

BOOTPROTO="dhcp"

ONBOOT="yes"

TYPE="Ethernet"

USERCTL="yes"

PEERDNS="yes"

IPV6INIT="no"

PERSISTENT_DHCLIENT="1"

Realice las modificaciones necesarias y, a continuación, guarde y cierre el archivo presionando la tecla ESC e introduciendo: wq!.

Paso 3. Cree el archivo de configuración de red eth1 con el comando vi ifcfg-eth1. Esta es la interfaz de diámetro. Acceda al modo de inserción presionando I e ingrese esta configuración.

DEVICE="eth1"

BOOTPROTO="none"

ONBOOT="yes"

TYPE="Ethernet"

USERCTL="yes"

PEERDNS="yes"

IPV6INIT="no"

IPADDR= <eth1 IP>

PREFIX=28

PERSISTENT_DHCLIENT="1"

Modifique <eth1 IP> para la IP del diámetro correspondiente para esta instancia. Una vez que todo esté en su lugar, guarde y cierre el archivo.

Paso 4. Cree el archivo de configuración de red eth2 con el comando vi ifcfg-eth2. Esta es la interfaz de RADIUS. Ingrese para insertar el modo presionando I e ingrese esta configuración:

DEVICE="eth2"

BOOTPROTO="none"

ONBOOT="yes"

TYPE="Ethernet"

USERCTL="yes"

PEERDNS="yes"

IPV6INIT="no"

IPADDR= <eth2 IP>

PREFIX=28

PERSISTENT_DHCLIENT="1"

Modifique <eth2 IP> para la IP del radio correspondiente para esta instancia. Una vez que todo esté en su lugar, guarde y cierre el archivo.

Paso 5. Reinicie el servicio de red con el comando service network restart. Verifique que los cambios de configuración de red se aplicaron con el comando ifconfig. Cada interfaz de red debe tener una IP de acuerdo con su archivo de configuración de red (ifcfg-ethx). Si eth1 o eth2 no se inician automáticamente, ejecute el comando ifup ethx.

Instalar CPAR

Paso 1. Navegue hasta el directorio /tmp ejecutando el comando cd /tmp.

Paso 2. Cambie los permisos para el archivo ./CSCOar-x.x.x.x.-lnx26_64-install.sh con el comando chmod 775 ./CSCOar-x.x.x.x.-lnx26_64-install.sh.

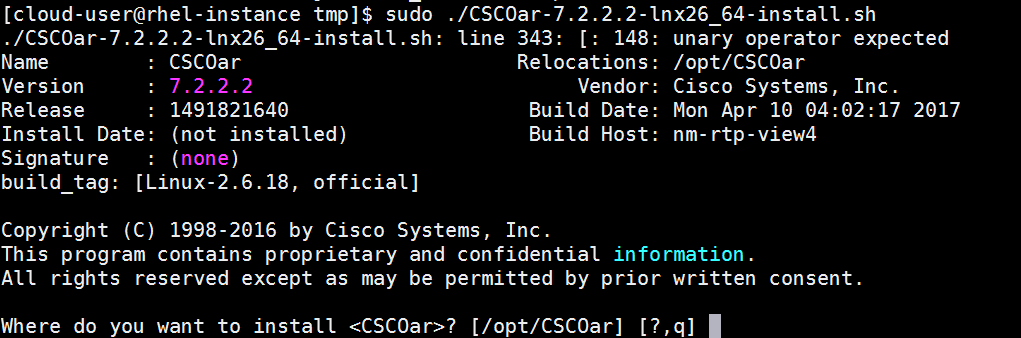

Paso 3. Inicie la secuencia de comandos de instalación con el comando ./CSCOar-x.x.x.x.-lnx26_64-install.sh.

Paso 4. Para la pregunta ¿Dónde desea instalar <CSCOar>? [/opt/CSCOar] [?,q], pulse Intro para seleccionar la ubicación predeterminada (/opt/CSCOar/).

Paso 5. Después de la pregunta ¿Dónde se encuentran los archivos de licencia de FLEXlm? [] [?,q] indique la ubicación de las licencias que deben ser /tmp.

Paso 6. Para la pregunta ¿Dónde está instalado el J2RE? [] [?,q] introduzca el directorio donde está instalado Java. Por ejemplo: /usr/java/jre1.8.0_144/.

Compruebe que ésta es la versión de Java correspondiente a la versión actual de CPAR.

Paso 7. Omita la entrada de Oracle pulsando Intro, ya que Oracle no se utiliza en este despliegue.

Paso 8. Omita el paso de funcionalidad SIGTRAN-M3UA presionando Enter. Esta función no es necesaria para esta implementación.

Paso 9. Para la pregunta ¿Desea que CPAR se ejecute como usuario no raíz? [n]: [y,n,?,q] presione Enter para utilizar la respuesta predeterminada que es n.

Paso 10. Para la pregunta ¿Desea instalar la configuración de ejemplo ahora? [n]: [y,n,?,q] presione Enter para utilizar la respuesta predeterminada que es n.

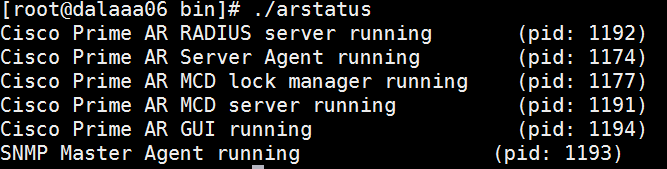

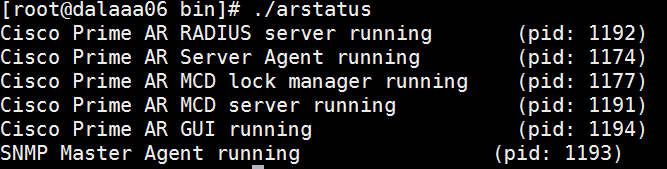

Paso 11. Espere a que finalice el proceso de instalación de CPAR y, a continuación, compruebe que todos los procesos de CPAR se están ejecutando. Navegue hasta directory /opt/CSCOar/bin y ejecute el comando ./arstatus. El resultado debe ser similar al siguiente:

Configurar SNMP

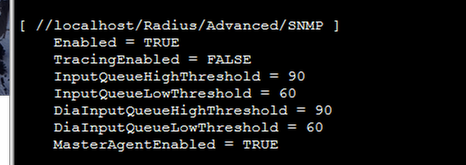

Establecer CPAR SNMP

Paso 1. Abra el archivo snmpd.conf con el comando /cisco-ar/ucd-snmp/share/snmp/snmpd.conf para incluir la comunidad SNMP, la comunidad de trampa y la dirección IP del receptor de trampa requeridos: inserte la línea trap2sink xxx.xxx.xxx.xxx cparaasnmp 162.

Paso 2. Ejecute el comando cd /opt/CSCOar/bin e inicie sesión en CPAR CLI con el comando ./aregcmd e ingrese las credenciales de administrador.

Paso 3. Muévase a /Radius/Advanced/SNMP y ejecute el comando set MasterAgentEnabled TRUE. Guarde los cambios con el comando save y salga de la CLI de CPAR emitiendo exit.

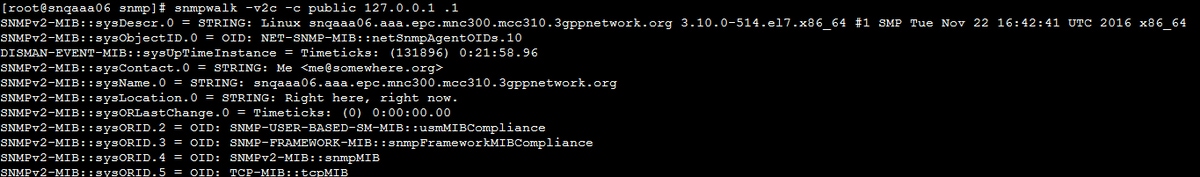

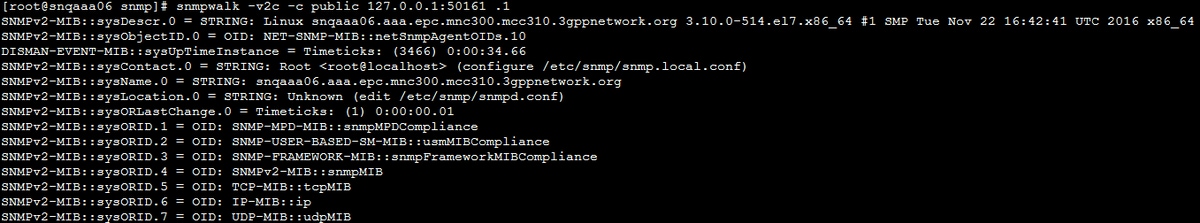

Paso 4. Verifique que los OID de CPAR estén disponibles mediante el comando snmpwalk -v2c -c public 127.0.0.1 .1.

Si el sistema operativo no reconoce el comando snmpwalk, navegue hasta /tmp/repo y ejecute yum install net-snmp-libs-5.5-49.el6.x86_64.rpm.

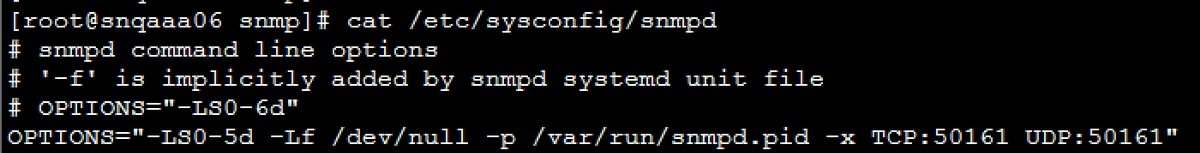

Establecer SNMP de SO

Paso 1. Edite el archivo /etc/sysconfig/snmpd para especificar el puerto 50161 para el receptor SNMP del sistema operativo; de lo contrario, se utilizará el puerto predeterminado 161, que actualmente utiliza el agente SNMP de CPAR.

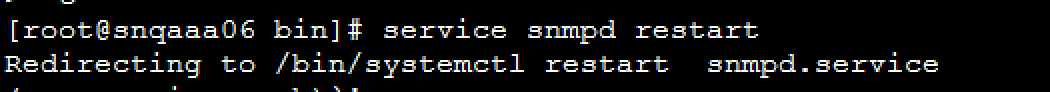

Paso 2. Reinicie el servicio SNMP con el comando service snmpd restart.

Paso 3. Valide que los OID del SO puedan ser consultados ejecutando el comando snmpwalk -v2c -c public 127.0.0.1:50161.1.

Configurar NTP

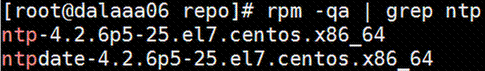

Paso 1. Verifique que los RPM de NTP ya estén instalados, ejecute el comando rpm -qa | grep ntp. El resultado debe ser similar a esta imagen.

Si los RPM no están instalados, navegue hasta el directorio /tmp/repo con el uso de cd /tmp/repo y ejecute los comandos:

yum install ntp-4.2.6p5-25.el7.centos.x86_64

yum install ntpdate-4.2.6p5-25.el7.centos.x86:64

Paso 2. Abra el archivo /etc/ntp.conf con el comando vi /etc/ntp.conf y agregue las IP correspondientes de los servidores NTP para esta VM/servidor.

Paso 3. Cierre el archivo ntp.conf y reinicie el servicio ntpd con el comando service ntpd restart.

Paso 4. Verifique que la máquina virtual/servidor esté conectada a los servidores NTP mediante el comando ntpq -p.

Procedimiento de copia de seguridad/restauración de la configuración de CPAR (opcional)

Nota: esta sección solo se debe ejecutar si se va a replicar una configuración CPAR existente en esta nueva VM/servidor. Este procedimiento sólo funciona en escenarios en los que se utiliza la misma versión de CPAR en las instancias de origen y destino.

Obtener el archivo de copia de seguridad de la configuración de CPAR de una instancia de CPAR existente

Paso 1. Abra una nueva sesión SSH con la VM correspondiente donde se obtendrá el archivo de respaldo con el uso de credenciales raíz.

Paso 2. Vaya al directorio /opt/CSCOar/bin con el comando cd /opt/CSCOar/bin.

Paso 3. Detenga los servicios CPAR y ejecute el comando ./arserver stop para hacerlo.

Paso 4. Verifique que el servicio CPAR fue detenido con el uso del comando ./arstatus, y busque el mensaje Cisco Prime Access Registrar Server Agent not running.

Paso 5. Para crear una nueva copia de seguridad, ejecute el comando ./mcdadmin -e /tmp/config.txt. Cuando se le solicite, introduzca las credenciales del administrador de CPAR.

Paso 6. Navegue hasta directory /tmp con el comando cd /tmp. El archivo config.txt es la copia de seguridad de esta configuración de instancia de CPAR.

Paso 7. Cargue el archivo config.txt en la nueva VM/servidor donde se restaurará la copia de seguridad. Utilice el comando scp config.txt root@<new VM/Server IP>:/tmp.

Paso 8. Vuelva al directorio /opt/CSCOar/bin con el comando cd /opt/CSCOar/bin y vuelva a activar CPAR con el comando ./arserver start.

Restauración del archivo de copia de seguridad de la configuración de CPAR en la nueva VM/servidor

Paso 1. En la nueva VM/Server, navegue hasta directory /tmp con el uso del comando cd/tmp y verifique que haya un archivo config.txt que se haya cargado en el Paso 7 de la sección Obtención del archivo de copia de seguridad de la configuración CPAR de una instancia CPAR existente. Si el archivo no está allí, consulte esa sección y verifique que el comando scp se haya ejecutado correctamente.

Paso 2. Navegue hasta el directorio /opt/CSCOar/bin con el comando cd /opt/CSCOar/bin y desactive el servicio CPAR ejecutando el comando ./arserver stop.

Paso 3. Para restaurar la copia de seguridad, ejecute el comando ./mcdadmin -coi /tmp/config.txt.

Paso 4. Vuelva a activar el servicio CPAR ejecutando el comando ./arserver start.

Paso 5. Finalmente, verifique el estado de CPAR con el uso del comando ./arstatus. El resultado debería verse así.

Historial de revisiones

| Revisión | Fecha de publicación | Comentarios |

|---|---|---|

1.0 |

28-Aug-2018

|

Versión inicial |

Con la colaboración de ingenieros de Cisco

- Karthikeyan DachanamoorthyCisco Advance Services

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios