Sustitución del servidor OSPD UCS 240M4 - CPAR

Opciones de descarga

-

ePub (777.2 KB)

Visualice en diferentes aplicaciones en iPhone, iPad, Android, Sony Reader o Windows Phone -

Mobi (Kindle) (456.1 KB)

Visualice en dispositivo Kindle o aplicación Kindle en múltiples dispositivos

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe los pasos necesarios para reemplazar un servidor defectuoso que aloja OpenStack Platform Director (OSPD) en una configuración Ultra-M. Este procedimiento se aplica a un entorno OpenStack con el uso de la versión NEWTON donde ESC no administra Cisco Prime Access Registrar (CPAR) y CPAR se instala directamente en la máquina virtual implementada en OpenStack.

Antecedentes

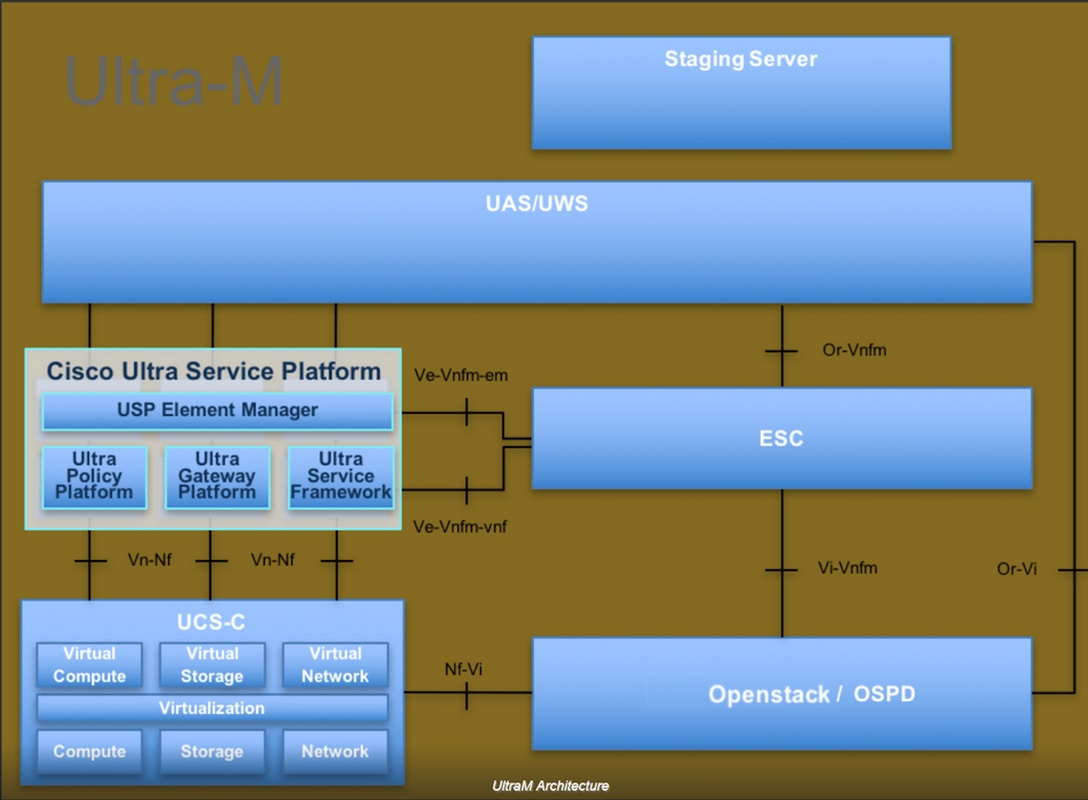

Ultra-M es una solución de núcleo de paquetes móviles virtualizada validada y empaquetada previamente diseñada para simplificar la implementación de VNF. OpenStack es el Virtualized Infrastructure Manager (VIM) para Ultra-M y consta de estos tipos de nodos:

- Informática

- Disco de almacenamiento de objetos - Compute (OSD - Compute)

- Controlador

- OSPD

La arquitectura de alto nivel de Ultra-M y los componentes involucrados se ilustran en esta imagen:

Este documento está dirigido al personal de Cisco que está familiarizado con la plataforma Cisco Ultra-M y detalla los pasos necesarios para llevarse a cabo en OpenStack y Redhat OS.

Nota: Se considera la versión Ultra M 5.1.x para definir los procedimientos en este documento.

Abreviaturas

| MOP | Método de procedimiento |

| OSD | Discos de almacenamiento de objetos |

| OSPD | Director de plataforma OpenStack |

| HDD | Unidad de disco duro |

| SSD | Unidad de estado sólido |

| VIM | Administrador de infraestructura virtual |

| VM | Máquina virtual |

| EM | Administrador de elementos |

| UAS | Servicios de ultra automatización |

| UUID | Identificador único universal |

Flujo de trabajo del MoP

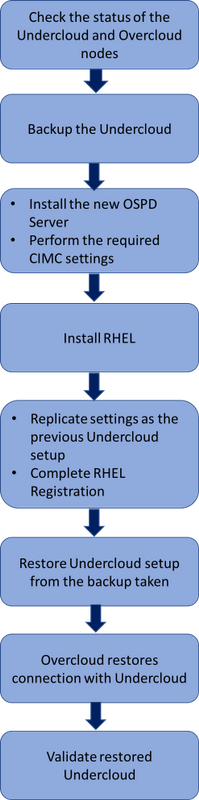

Flujo de trabajo de alto nivel del procedimiento de reemplazo

Flujo de trabajo de alto nivel del procedimiento de reemplazo

Prerequisites

Comprobación de estado

Antes de reemplazar un servidor OSPD, es importante verificar el estado actual del entorno de la plataforma Red Hat OpenStack y asegurarse de que esté sano para evitar complicaciones cuando el proceso de reemplazo esté activo.

1. Compruebe el estado de la pila OpenStack y la lista de nodos:

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack stack list --nested

[stack@director ~]$ ironic node-list

[stack@director ~]$ nova list

2. Compruebe si todos los servicios de la nube inferior están en estado cargado, activo y en ejecución desde el nodo OSP-D:

[stack@al03-pod2-ospd ~]$ systemctl list-units "openstack*" "neutron*" "openvswitch*"

UNIT LOAD ACTIVE SUB DESCRIPTION

neutron-dhcp-agent.service loaded active running OpenStack Neutron DHCP Agent

neutron-metadata-agent.service loaded active running OpenStack Neutron Metadata Agent

neutron-openvswitch-agent.service loaded active running OpenStack Neutron Open vSwitch Agent

neutron-server.service loaded active running OpenStack Neutron Server

openstack-aodh-evaluator.service loaded active running OpenStack Alarm evaluator service

openstack-aodh-listener.service loaded active running OpenStack Alarm listener service

openstack-aodh-notifier.service loaded active running OpenStack Alarm notifier service

openstack-ceilometer-central.service loaded active running OpenStack ceilometer central agent

openstack-ceilometer-collector.service loaded active running OpenStack ceilometer collection service

openstack-ceilometer-notification.service loaded active running OpenStack ceilometer notification agent

openstack-glance-api.service loaded active running OpenStack Image Service (code-named Glance) API server

openstack-glance-registry.service loaded active running OpenStack Image Service (code-named Glance) Registry server

openstack-heat-api-cfn.service loaded active running Openstack Heat CFN-compatible API Service

openstack-heat-api.service loaded active running OpenStack Heat API Service

openstack-heat-engine.service loaded active running Openstack Heat Engine Service

openstack-ironic-api.service loaded active running OpenStack Ironic API service

openstack-ironic-conductor.service loaded active running OpenStack Ironic Conductor service

openstack-ironic-inspector-dnsmasq.service loaded active running PXE boot dnsmasq service for Ironic Inspector

openstack-ironic-inspector.service loaded active running Hardware introspection service for OpenStack Ironic

openstack-mistral-api.service loaded active running Mistral API Server

openstack-mistral-engine.service loaded active running Mistral Engine Server

openstack-mistral-executor.service loaded active running Mistral Executor Server

openstack-nova-api.service loaded active running OpenStack Nova API Server

openstack-nova-cert.service loaded active running OpenStack Nova Cert Server

openstack-nova-compute.service loaded active running OpenStack Nova Compute Server

openstack-nova-conductor.service loaded active running OpenStack Nova Conductor Server

openstack-nova-scheduler.service loaded active running OpenStack Nova Scheduler Server

openstack-swift-account-reaper.service loaded active running OpenStack Object Storage (swift) - Account Reaper

openstack-swift-account.service loaded active running OpenStack Object Storage (swift) - Account Server

openstack-swift-container-updater.service loaded active running OpenStack Object Storage (swift) - Container Updater

openstack-swift-container.service loaded active running OpenStack Object Storage (swift) - Container Server

openstack-swift-object-updater.service loaded active running OpenStack Object Storage (swift) - Object Updater

openstack-swift-object.service loaded active running OpenStack Object Storage (swift) - Object Server

openstack-swift-proxy.service loaded active running OpenStack Object Storage (swift) - Proxy Server

openstack-zaqar.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server

openstack-zaqar@1.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server Instance 1

openvswitch.service loaded active exited Open vSwitch

LOAD = Reflects whether the unit definition was properly loaded.

ACTIVE = The high-level unit activation state, i.e. generalization of SUB.

SUB = The low-level unit activation state, values depend on unit type.

lines 1-43

lines 2-44 37 loaded units listed. Pass --all to see loaded but inactive units, too.

To show all installed unit files use 'systemctl list-unit-files'.

lines 4-46/46 (END) lines 4-46/46 (END) lines 4-46/46 (END) lines 4-46/46 (END) lines 4-46/46 (END)

Copia de seguridad

1. Confirme que dispone de suficiente espacio en disco antes de realizar el proceso de copia de seguridad. Se espera que este tarball sea de al menos 3,5 GB.

[stack@director ~]$ df -h

2. Ejecute estos comandos como usuario raíz para realizar una copia de seguridad de los datos del nodo bajo la nube en un archivo denominado undercloud-backup-[timestamp].tar.gz.

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql

[root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack

tar: Removing leading `/' from member names

Instalación del nuevo nodo OSPD

Instalación del servidor UCS

1. Los pasos para instalar un nuevo servidor UCS C240 M4 y los pasos iniciales de configuración se pueden consultar en la Guía de Instalación y Servicio del Servidor Cisco UCS C240 M4.

2. Después de la instalación del servidor, inserte los discos duros en sus ranuras respectivas como el servidor antiguo.

3. Inicie sesión en el servidor con el uso de la IP Cisco Integrated Management Controller (CIMC).

4. Realice la actualización del BIOS si el firmware no se ajusta a la versión recomendada utilizada anteriormente. Los pasos para la actualización del BIOS se indican a continuación: Guía de actualización del BIOS del servidor de montaje en bastidor Cisco UCS C-Series.

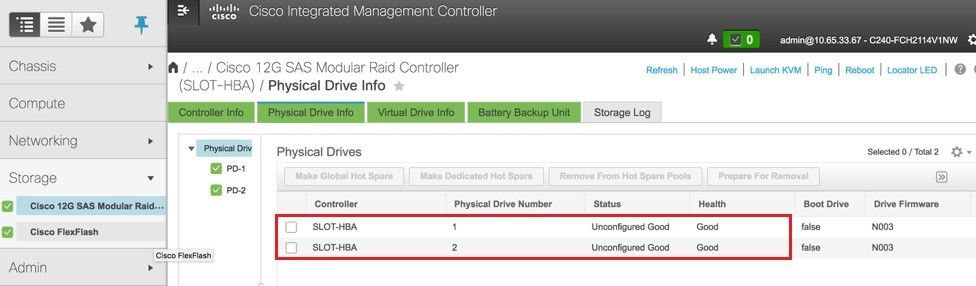

5. Verifique el estado de las unidades físicas. Debe ser Unconfigured Good. Vaya a Storage > Cisco 12G SAS Modular Raid Controller (SLOT-HBA) > Physical Drive Info como se muestra en la imagen.

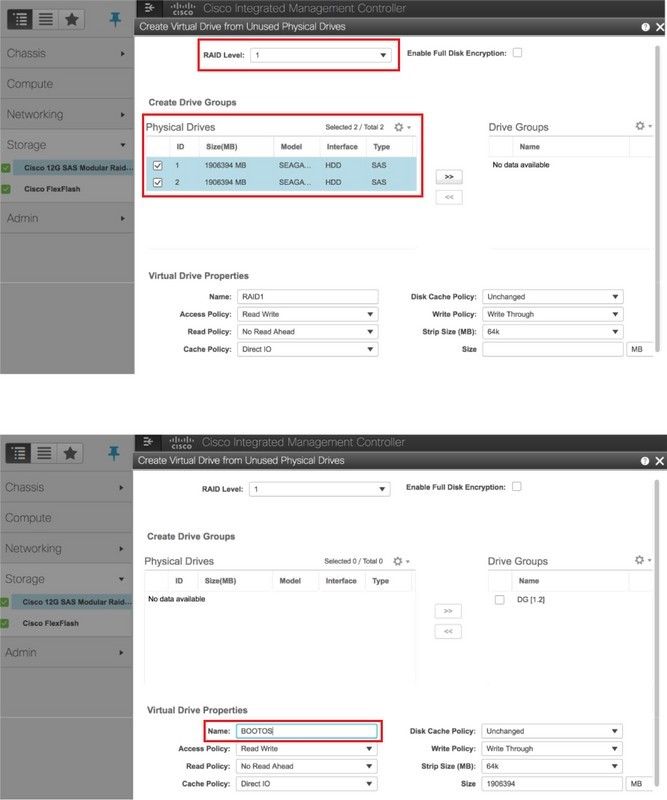

6. Cree una unidad virtual desde las unidades físicas con RAID Level 1. Vaya a Almacenamiento > Cisco 12G SAS Modular Raid Controller (SLOT-HBA) > Información del controlador > Crear unidad virtual desde unidades físicas no usadas como se muestra en la imagen.

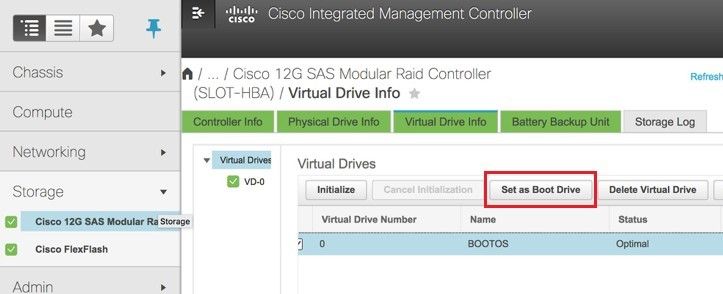

7. Seleccione el VD y configure Set as Boot Drive como se muestra en la imagen.

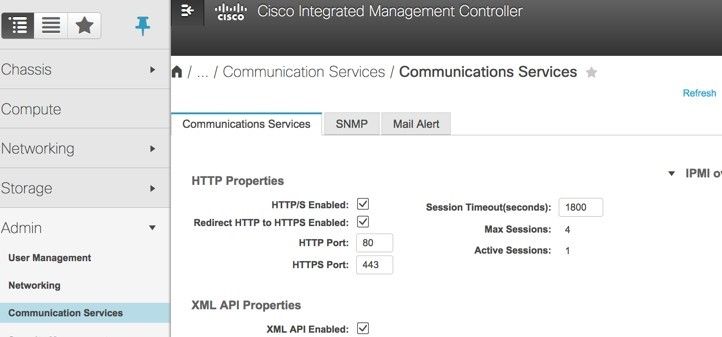

8. Habilite IPMI sobre LAN. Vaya a Admin > Communication Services > Communication Services como se muestra en la imagen.

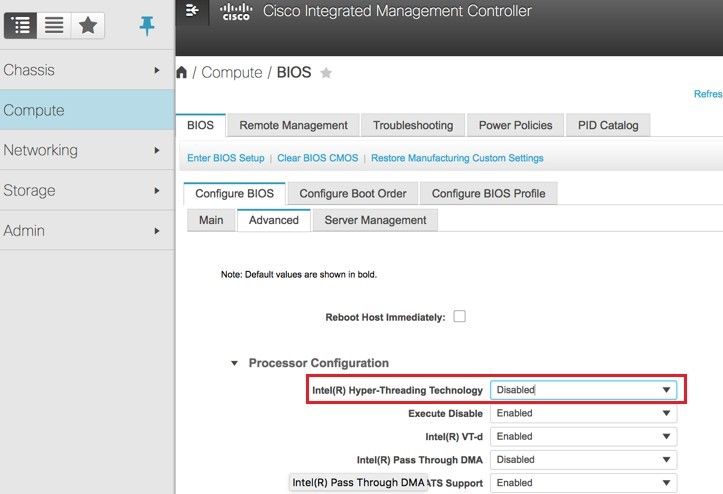

9. Desactive el hiper-hilo de discusión. Vaya a Compute > BIOS > Configure BIOS > Advanced > Processor Configuration como se muestra en la imagen.

Nota: La imagen que se muestra aquí y los pasos de configuración mencionados en esta sección se refieren a la versión de firmware 3.0(3e) y puede haber ligeras variaciones si trabaja en otras versiones.

Instalación de Redhat

Montaje de la imagen ISO de Red Hat

1. Inicie sesión en el servidor OSP-D.

2. Inicie la consola KVM.

3. Vaya a Virtual Media > Activate Virtual Devices. Acepte la sesión y active Recordar su configuración para futuras conexiones.

4. Vaya a Virtual Media > CD/DVD de mapay mapear la imagen ISO de Red Hat.

5. Vaya a Power > Restablecer el sistema (arranque en caliente) para para reiniciar el sistema.

6. Al reiniciar, pulse F6y seleccionevDVD1.22 asignado por Cisco vKVMy presione Enter.

Instalar RHEL

Nota : El procedimiento de esta sección representa una versión simplificada del proceso de instalación que identifica el número mínimo de parámetros que se deben configurar.

1. Seleccione la opción para instalar Red Hat Enterprise Linux para comenzar la instalación.

2. Vaya a Selección de software > Sólo instalación mínima.

3. Configure las interfaces de red (eno1 y eno2).

4. Haga clic en Red y nombre de host.

- Seleccione la interfaz que se utilizaría para la comunicación externa (eno1 o eno2)

- Haga clic en Configure (Configurar)

- Seleccione la ficha Configuración IPv4, seleccione Manualmethod y haga clic en Agregar

- Establezca estos parámetros como se utilizó anteriormente: Dirección, máscara de red, puerta de enlace, servidor DNS

5. Seleccione Fecha y hora y especifique su región y ciudad.

6. Habilite Network Time y configure los servidores NTP.

7. Seleccione Installation Destination (Destino de instalación) y utilice el sistema de archivos ext4 .

Nota: Elimine ‘/home/’ y reasigne la capacidad a la raíz '/'.

8. Desactivar Kdump

9. Establecer sólo la contraseña raíz

10. Iniciar la instalación

Restauración de la nube interna

Preparación de la instalación en la nube basada en la copia de seguridad

Una vez que la máquina se instala con RHEL 7.3 y se encuentra en estado limpio, vuelva a habilitar todas las suscripciones/repositorios necesarios para instalar y ejecutar director.

1. Configuración del nombre de host.

[root@director ~]$sudo hostnamectl set-hostname <FQDN_hostname>

[root@director ~]$sudo hostnamectl set-hostname --transient <FQDN_hostname>

2. Editar /etc/hosts archivo.

[root@director ~]$ vi /etc/hosts

<ospd_external_address> <server_hostname> <FQDN_hostname>

192.168.247.142 pod2-stack-ospd pod2-stack-ospd.cisco.com

3. Validar nombre de host.

[root@director ~]$ cat /etc/hostname

pod2-stack-ospd.cisco.com

4. Valide la configuración DNS.

[root@director ~]$ cat /etc/resolv.conf

#Generated by NetworkManager

nameserver <DNS_IP>

5. Modifique la interfaz nic de aprovisionamiento.

[root@director ~]$ cat /etc/sysconfig/network-scripts/ifcfg-eno1

DEVICE=eno1

ONBOOT=yes

HOTPLUG=no

NM_CONTROLLED=no

PEERDNS=no

DEVICETYPE=ovs

TYPE=OVSPort

OVS_BRIDGE=br-ctlplane

BOOTPROTO=none

MTU=1500

Complete el registro Redhat

1. Descargue este paquete para configurar el administrador de suscripciones para utilizar rh-satelite.

[root@director ~]$ rpm -Uvh http:///pub/katello-ca-consumer-latest.noarch.rpm

[root@director ~]$ subscription-manager config

2. Inscríbase con rh-satelite utilizando esta clave de activación para RHEL 7.3.

[root@director ~]$subscription-manager register --org="<ORG>" --activationkey="<KEY>"

3. Para ver la suscripción.

[root@director ~]$ subscription-manager list –consumed

4. Habilite los repositorios de la misma manera que los repos OSPD anteriores.

[root@director ~]$ sudo subscription-manager repos --disable=*

[root@director ~]$ subscription-manager repos --enable=rhel-7-server-rpms --enable=rhel-7-server-extras-rpms --enable=rh

el-7-server-openstack-10-rpms --enable=rhel-7-server-rh-common-rpms --enable=rhel-ha-for-rhel-7-server-rpm

5. Realice una actualización en su sistema para asegurarse de que dispone de los últimos paquetes básicos del sistema y reinicie el sistema.

[root@director ~]$sudo yum update -y

[root@director ~]$sudo reboot

Restauración de la nube insuficiente

Después de habilitar la suscripción, importe el archivo .tar bajo la nube "undercloud-backup-`date +%F`.tar.gz" en el nuevo directorio raíz del servidor OSP-D /root

1. Instale el servidor mariadb.

[root@director ~]$ yum install -y mariadb-server

2. Extraiga el archivo de configuración de MariaDB y la copia de seguridad de la base de datos. Realice esta operación como usuario raíz.

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/my.cnf.d/server.cnf

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz root/undercloud-all-databases.sql

3. Edite /etc/my.cnf.d/server.cnf y comente la entrada bind-address si está presente.

[root@tb3-ospd ~]# vi /etc/my.cnf.d/server.cnf

4. Inicie el servicio MariaDB y actualice temporalmente la configuración max_allowed_packet.

[root@director ~]$ systemctl start mariadb

[root@director ~]$ mysql -uroot -e"set global max_allowed_packet = 16777216;"

5. Limpie determinados permisos (para volver a crearlos más tarde).

[root@director ~]$ for i in ceilometer glance heat ironic keystone neutron nova;do mysql -e "drop user $i";done

[root@director ~]$ mysql -e 'flush privileges'

Nota: Si el servicio de techómetro se ha inhabilitado previamente en la configuración, ejecute el comando anterior eliminando el "ceilómetro".

6. Cree la cuenta de usuario apilado.

[root@director ~]$ sudo useradd stack

[root@director ~]$ sudo passwd stack << specify a password

[root@director ~]$ echo "stack ALL=(root) NOPASSWD:ALL" | sudo tee -a /etc/sudoers.d/stack

[root@director ~]$ sudo chmod 0440 /etc/sudoers.d/stack

7. Restaure el directorio de inicio del usuario de pila.

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz home/stack

8. Instale los paquetes base swift y glance y, a continuación, restaure sus datos.

[root@director ~]$ yum install -y openstack-glance openstack-swift

[root@director ~]$ tar --xattrs -xzC / -f undercloud-backup-$DATE.tar.gz srv/node var/lib/glance/images

9. Confirme que los datos pertenecen al usuario correcto.

[root@director ~]$ chown -R swift: /srv/node

[root@director ~]$ chown -R glance: /var/lib/glance/images

10. Restaure los certificados SSL bajo la nube (opcional, solo se realizará si la configuración utiliza certificados SSL).

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/instack-certs/undercloud.pem

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/ca-trust/source/anchors/ca.crt.pem

11. Vuelva a ejecutar la instalación bajo la nube como el usuario apilado, asegurándose de ejecutarla en el directorio de inicio del usuario stack:

[root@director ~]$ su - stack

[stack@director ~]$ sudo yum install -y python-tripleoclient

12. Confirme que el nombre de host esté configurado correctamente en /etc/hosts.

13. Vuelva a instalar la nube inferior.

[stack@director ~]$ openstack undercloud install

<snip>

#############################################################################

Undercloud install complete.

The file containing this installation's passwords is at

/home/stack/undercloud-passwords.conf.

There is also a stackrc file at /home/stack/stackrc.

These files are needed to interact with the OpenStack services, and must be

secured.

#############################################################################

Vuelva a conectar la nube subyacente restaurada a la nube excesiva

Tras completar los pasos anteriores, cabe esperar que la nube subyacente restablezca automáticamente su conexión a la nube excesiva. Los nodos continuarán sondeando Orquestación (calor) para las tareas pendientes, utilizando una simple solicitud HTTP emitida cada pocos segundos.

Validar la restauración completada

Utilice estos comandos para realizar una comprobación de estado de su entorno recién restaurado.

[root@director ~]$ su - stack

Last Log in: Tue Nov 28 21:27:50 EST 2017 from 192.182.255.20 on pts/0

[stack@director ~]$ source stackrc

[stack@director ~]$ nova list

+--------------------------------------+--------------------------+--------+------------+-------------+------------------------+

| ID | Name | Status | Task State | Power State | Networks |

+--------------------------------------+--------------------------+--------+------------+-------------+------------------------+

| 03f15071-21aa-4bcf-8fdd-acdbde305168 | pod2-stack-compute-0 | ACTIVE | - | Running | ctlplane=192.200.0.106 |

| 1f725ce3-948d-49e9-aed9-b99e73d82644 | pod2-stack-compute-1 | ACTIVE | - | Running | ctlplane=192.200.0.107 |

| fbc13c78-dc06-4ac9-a3c5-595ccc147adc | pod2-stack-compute-2 | ACTIVE | - | Running | ctlplane=192.200.0.119 |

| 3b94e0b1-47dc-4960-b3eb-d02ffe9ae693 | pod2-stack-compute-3 | ACTIVE | - | Running | ctlplane=192.200.0.112 |

| 5dbac94d-19b9-493e-a366-1e2e2e5e34c5 | pod2-stack-compute-4 | ACTIVE | - | Running | ctlplane=192.200.0.116 |

| b896c73f-d2c8-439c-bc02-7b0a2526dd70 | pod2-stack-controller-0 | ACTIVE | - | Running | ctlplane=192.200.0.113 |

| 2519ce67-d836-4e5f-a672-1a915df75c7c | pod2-stack-controller-1 | ACTIVE | - | Running | ctlplane=192.200.0.105 |

| e19b9625-5635-4a52-a369-44310f3e6a21 | pod2-stack-controller-2 | ACTIVE | - | Running | ctlplane=192.200.0.120 |

| 6810c884-1cb9-4321-9a07-192443920f1f | pod2-stack-osd-compute-0 | ACTIVE | - | Running | ctlplane=192.200.0.109 |

| 26d3f7b1-ba97-431f-aa6e-ba91661db45d | pod2-stack-osd-compute-1 | ACTIVE | - | Running | ctlplane=192.200.0.117 |

| 6e4a8aa9-4870-465a-a7e2-0932ff55e34b | pod2-stack-osd-compute-2 | ACTIVE | - | Running | ctlplane=192.200.0.103 |

+--------------------------------------+--------------------------+--------+------------+-------------+------------------------+

<snip>

[stack@director ~]$ ssh heat-admin@192.200.0.113

Last login: Fri Jul 6 09:02:41 2018 from 192.200.0.1

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod2-stack-controller-2 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

Last updated: Tue Jul 10 10:04:15 2018Last change: Fri Jul 6 09:03:35 2018 by root via crm_attribute on pod2-stack-controller-0

3 nodes and 19 resources configured

Online: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Full list of resources:

ip-11.120.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-192.200.0.110(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

ip-11.120.0.44(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

ip-11.118.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-10.225.247.214(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Master/Slave Set: redis-master [redis]

Masters: [ pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-0 pod2-stack-controller-1 ]

ip-11.119.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

openstack-cinder-volume(systemd:openstack-cinder-volume):Started pod2-stack-controller-1

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[heat-admin@pod2-stack-controller-0 ~]$ sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod2-stack-controller-0=11.118.0.10:6789/0,pod2-stack-controller-1=11.118.0.11:6789/0,pod2-stack-controller-2=11.118.0.12:6789/0}

election epoch 10, quorum 0,1,2 pod2-stack-controller-0,pod2-stack-controller-1,pod2-stack-controller-2

osdmap e81: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v23094282: 704 pgs, 6 pools, 809 GB data, 424 kobjects

2418 GB used, 10974 GB / 13393 GB avail

704 active+clean

client io 1841 kB/s wr, 0 op/s rd, 220 op/s wr

[heat-admin@pod2-stack-controller-0 ~]$ exit

logout

Connection to 192.200.0.113 closed.

Comprobación del funcionamiento del servicio de identidad (clave)

Este paso valida las operaciones de Identity Service consultando una lista de usuarios.

[stack@director ~]$ source stackerc

[stack@director~]$ openstack user list

+----------------------------------+------------------+

| ID | Name |

+----------------------------------+------------------+

| 4d93cc08ed314b87b4c6dce95c19558f | admin |

| c499bd1a65d94029804350e3bca19888 | aodh |

| d9b59136b2794ec1b9c18c4f7b95c674 | ceilometer |

| 4650cdca79b44f2b9d2426b7a9df9495 | glance |

| 4a6724a623f4463c971658462b505c8a | heat |

| e18ae9a5b7f14aefb9e93931dcec476e | ironic |

| 9831160669c44c10b04d6f78b7517a55 | ironic-inspector |

| 6a5d6f02b9a74dfb9f679eecfebb28e0 | mistral |

| 462c8ec91fb0485fbc7dfec6d4ecf480 | neutron |

| f3a66d84e39c47a0bdcd14d24bd72816 | nova |

| 1f16ea9035ab424a88d5f34681d3f893 | swift |

| ab4a1e5f62be4609b290c32dc93bfbce | zaqar |

| fac68a166f5f442284f7d06355369c53 | zaqar-websocket |

+----------------------------------+------------------+

[stack@director ~]$ source <overcloudrc>

[stack@director ~]$ openstack user list

+----------------------------------+------------+

| ID | Name |

+----------------------------------+------------+

| 7285a65e0c8c4447b10875d0e9c9da69 | admin |

| c7c78ac31ec24926b3eed79e7f5bd59e | neutron |

| 191c2a293beb48edb4d2c1160c9a0523 | heat |

| 1445a6ef2ae94b6f9365ffbc6b56a231 | gnocchi |

| fb8b006129554c6b8465310fcfc0ba8c | aodh |

| 5afcb816f93b4f20998c9edaf3b143a0 | nova |

| 37444af1295344809eca6058a782f871 | glance |

| e74d2d9e59f34ddfb4408a8beb88db7b | ceilometer |

| 9baab90178c141478ce7c0084e930f40 | cinder |

| 5a964c651c11402284eecb0e8f40ee33 | heat-cfn |

| 6d49ebae55da432580943d6080efcf90 | swift |

| 41a666fe64c64df593d73b4f467885be | core |

| ab004ba966bf4ddc92783fbb6045e48b | cpar |

| fce5b5c5dc7647ccbc2170b56a64db33 | cpardemo |

| 28ead2dab0ef486ba449b441715a3e04 | pcrf |

| 0aac4107e3d443dc93ca62c3928a1998 | pcrfdemo |

+----------------------------------+------------+

Carga de imágenes para la introducción de nodos futuros

1. Valide /httpboot todos estos archivos "inspector.ipxe, agent.kernel, agent.ramdisk", si no continúa con los siguientes pasos para actualizar en la imagen.

[stack@director ~]$ ls /httpboot

inspector.ipxe

[stack@director ~]$ source stackrc

[stack@director ~]$ cd images/

[stack@director images]$ openstack overcloud image upload --image-path /home/stack/images

Image "overcloud-full-vmlinuz" is up-to-date, skipping.

Image "overcloud-full-initrd" is up-to-date, skipping.

Image "overcloud-full" is up-to-date, skipping.

Image "bm-deploy-kernel" is up-to-date, skipping.

Image "bm-deploy-ramdisk" is up-to-date, skipping.

[stack@director images]$ ls /httpboot

agent.kernel agent.ramdisk inspector.ipxe

[stack@director images]$

Reinicio de cercado

El cercado estaría en estado detenido después de la recuperación de OSPD, el siguiente procedimiento permitiría el cercado.

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs property set stonith-enabled=true

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

[heat-admin@pod2-stack-controller-0 ~]$sudo pcs stonith show

Información Relacionada

Con la colaboración de ingenieros de Cisco

- Karthikeyan DachanamoorthyCisco Advanced Services

- Harshita BhardwajCisco Advanced Services

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios